Peranti teknologi

Peranti teknologi

AI

AI

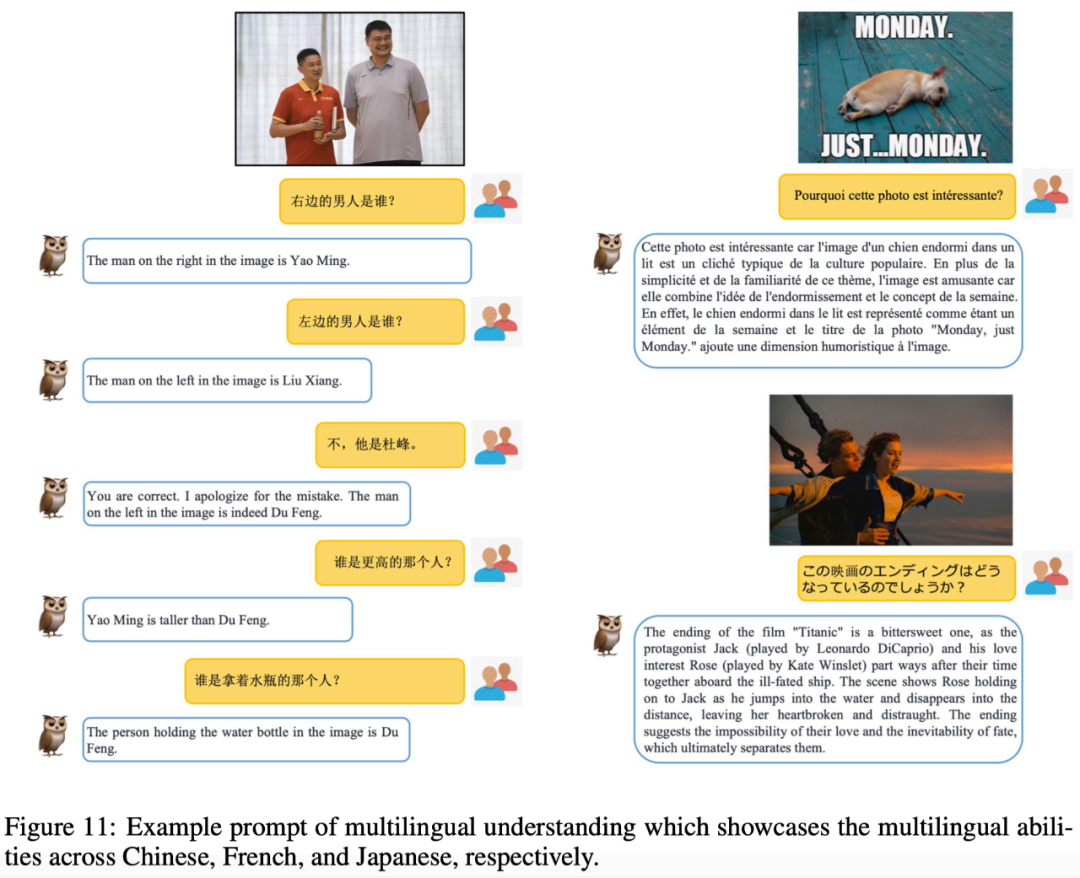

mPLUG-Owl DAMO Academy diperkenalkan: model besar berbilang modal modular, mengejar keupayaan berbilang modal GPT-4

mPLUG-Owl DAMO Academy diperkenalkan: model besar berbilang modal modular, mengejar keupayaan berbilang modal GPT-4

mPLUG-Owl DAMO Academy diperkenalkan: model besar berbilang modal modular, mengejar keupayaan berbilang modal GPT-4

Model besar teks tulen berada dalam tahap menaik, dan kerja model besar multimodal telah mula muncul dalam medan multimodal GPT-4, yang paling kuat di permukaan, mempunyai keupayaan multimodal untuk membaca imej, tetapi ia belum lagi terbuka kepada orang ramai untuk pengalaman, jadi komuniti penyelidik Hu mula menyelidik dan sumber terbuka ke arah ini. Tidak lama selepas kemunculan MiniGPT-4 dan LLaVA, Alibaba DAMO Academy melancarkan mPLUG-Owl, model besar berbilang modal berdasarkan pelaksanaan modular.

mPLUG-Owl ialah karya terbaharu siri mPLUG Alibaba Damo Academy Ia meneruskan idea latihan modular siri mPLUG dan menaik taraf LLM kepada model berbilang modal yang besar. Dalam siri kerja mPLUG, E2E-VLP, mPLUG dan mPLUG-2 sebelumnya telah diterima oleh ACL2021, EMNLP2022 dan ICML2023, antaranya, kerja mPLUG mendahului senarai VQA dengan hasil luar biasa.

Apa yang saya ingin perkenalkan hari ini ialah mPLUG-Owl Kerja ini bukan sahaja menunjukkan keupayaan pelbagai modal yang sangat baik melalui sejumlah besar kes, tetapi juga mencadangkan set ujian komprehensif untuk pemahaman arahan berkaitan penglihatan. buat pertama kalinya. OwlEval membandingkan model sedia ada melalui penilaian manual, termasuk LLaVA, MiniGPT-4, BLIP-2 dan MM-REACT berasaskan sistem. modal Prestasi cemerlang dalam keupayaan pemahaman perintah dinamik, keupayaan dialog berbilang pusingan, keupayaan penaakulan pengetahuan, dll. >Pautan kertas: https://arxiv.org/abs/2304.14178

Alamat pengalaman ModelScope:

https://modelscope cn/studios/damo/mPLUG-Owl/summary

Alamat pengalaman HuggingFace:

https://huggingface.co/spaces/MAGAer13/mPLUG-Owl

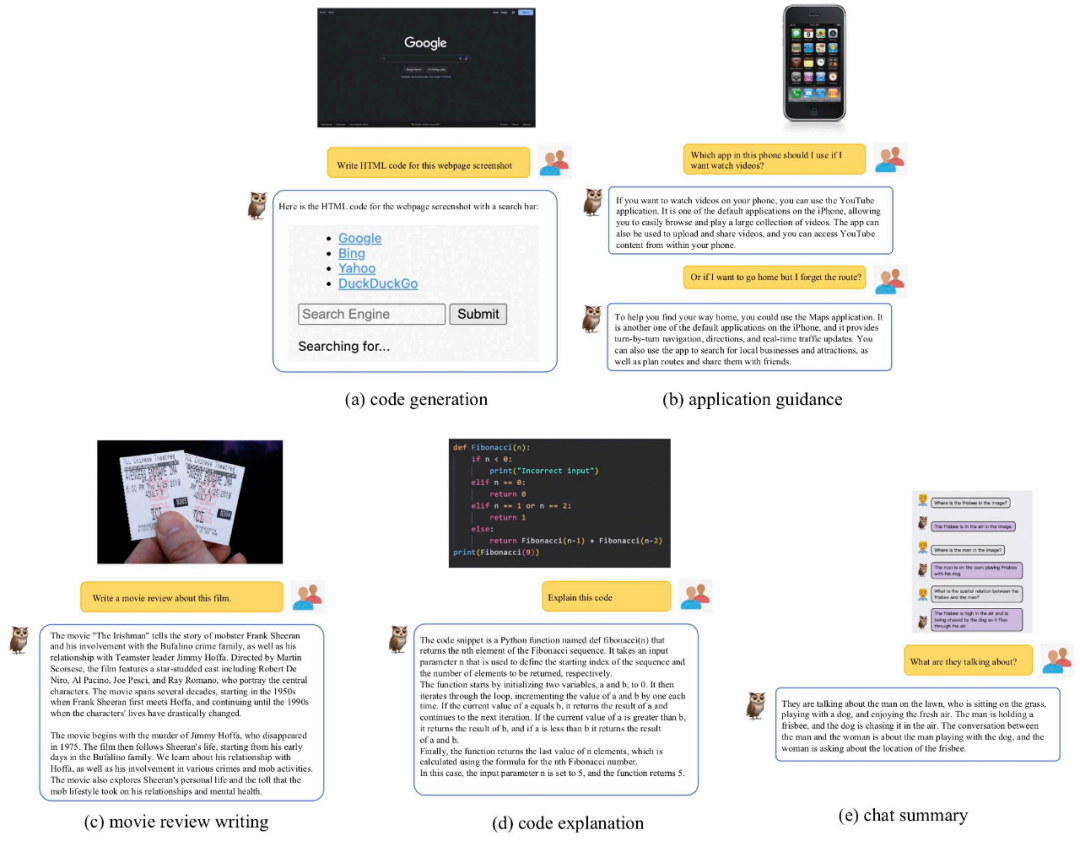

Berbilang -demonstrasi keupayaan modalKami menggabungkan mPLUG-Owl dengan sedia ada Bandingkan kerja untuk merasai kesan pelbagai mod mPLUG-Owl Perlu dinyatakan bahawa sampel ujian yang dinilai dalam kerja ini pada asasnya daripada kerja sedia ada, mengelakkan masalah petik ceri.

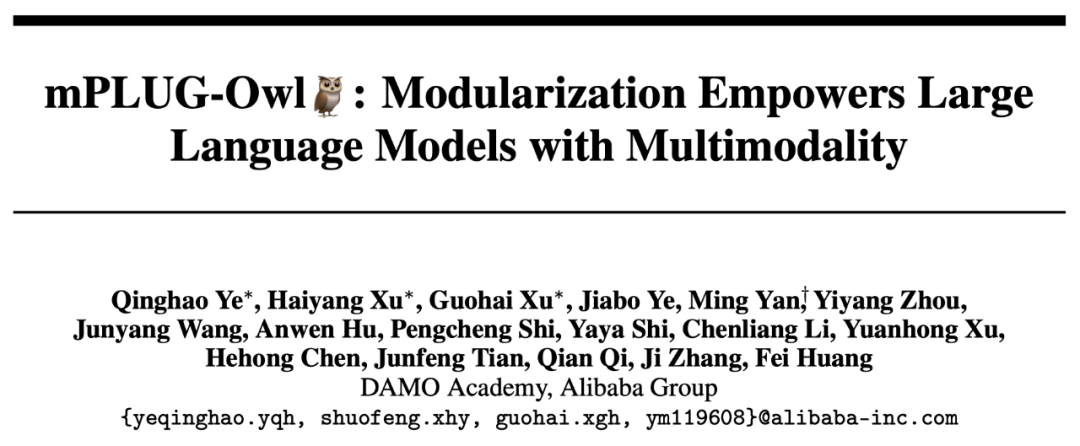

Rajah 6 di bawah menunjukkan keupayaan dialog pelbagai pusingan kuat mPLUG-Owl.

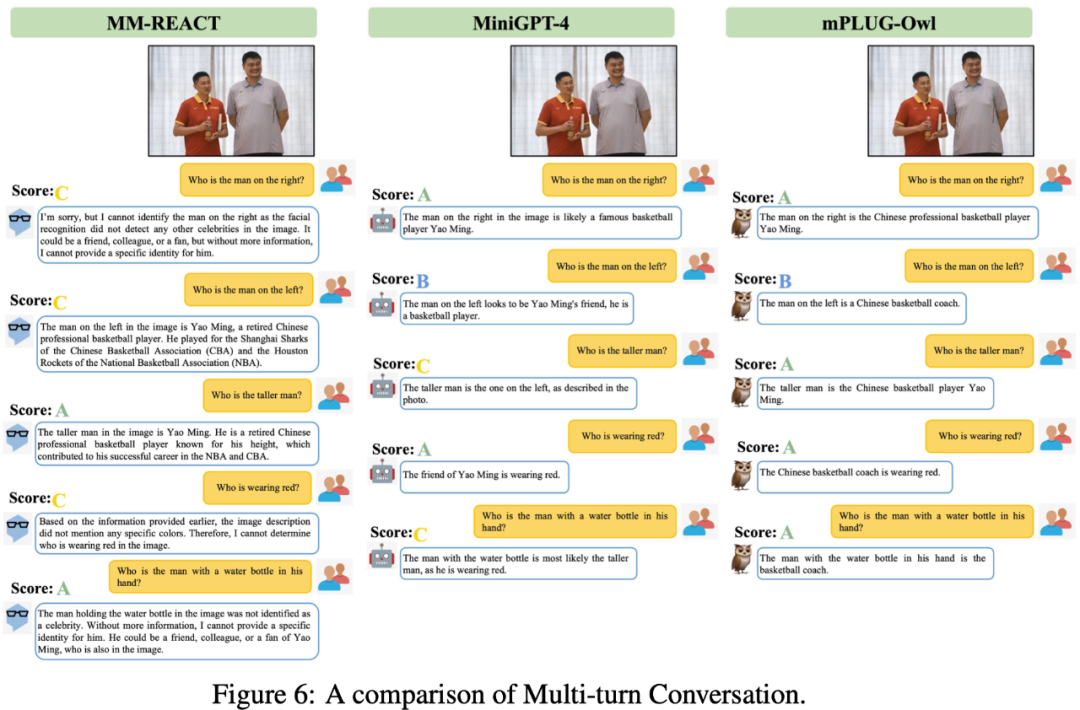

Seperti yang dapat dilihat daripada Rajah 7, mPLUG-Owl mempunyai keupayaan penaakulan yang kukuh.

Seperti yang ditunjukkan dalam Rajah 10, walaupun data korelasi berbilang graf tidak dilatih semasa fasa latihan, mPLUG-Owl telah menunjukkan keupayaan korelasi berbilang graf tertentu.

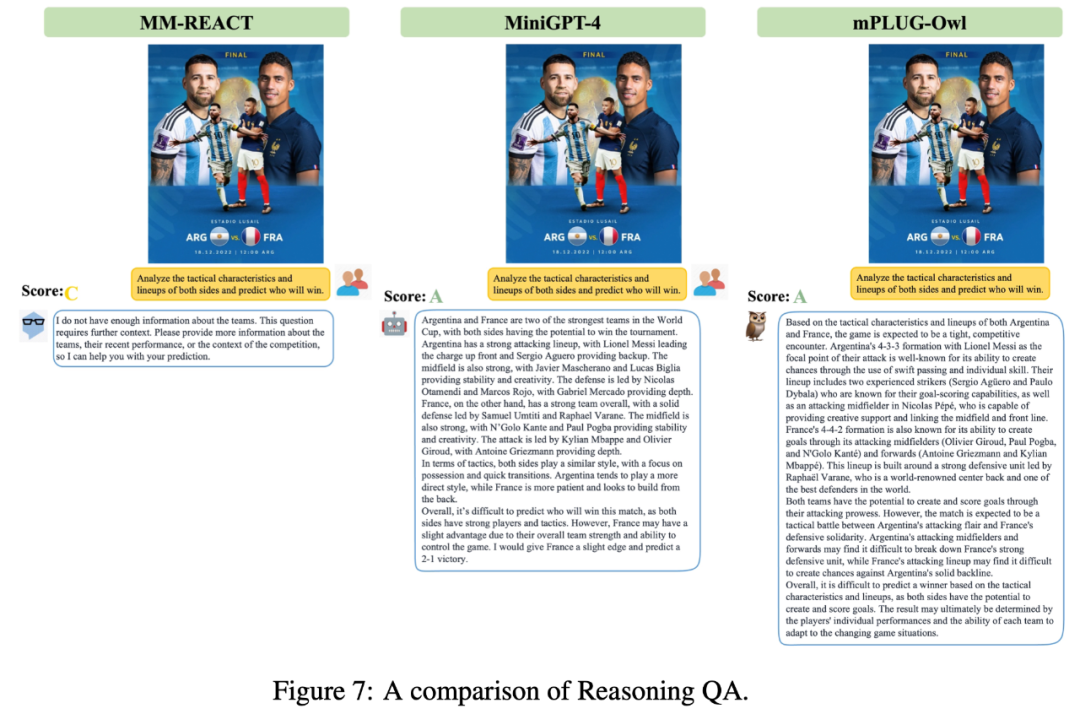

Seperti yang ditunjukkan dalam Rajah 11, walaupun mPLUG-Owl hanya menggunakan data Bahasa Inggeris dalam fasa latihan, ia menunjukkan Dibangunkan menarik keupayaan berbilang bahasa. Ini mungkin kerana model bahasa dalam mPLUG-Owl menggunakan LLaMA, mengakibatkan fenomena ini.

Walaupun mPLUG-Owl tidak dilatih pada data dokumen beranotasi, ia masih menunjukkan pengecaman teks dan pemahaman dokumen tertentu, keputusan ujian ditunjukkan dalam Rajah 12.

Pengenalan kaedah

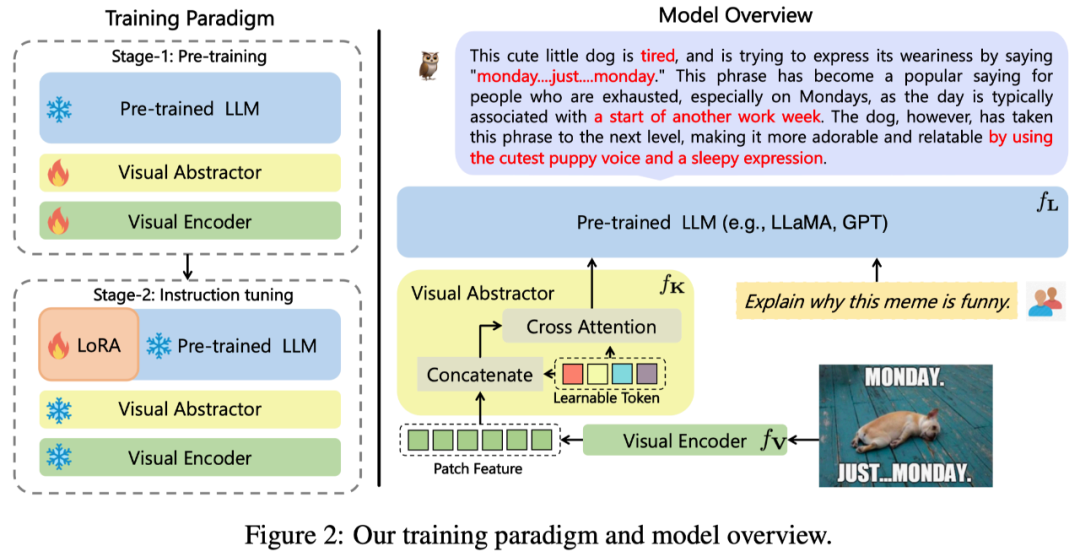

Seni bina keseluruhan mPLUG-Owl yang dicadangkan dalam kerja ini ditunjukkan dalam Rajah 2 Tunjukkan.

Struktur model: Ia terdiri daripada modul asas visual

(sumber terbuka ViT-L), modul abstraksi visual

dan model bahasa pra-latihan

( LLaMA-7B). Modul abstraksi visual meringkaskan ciri imej yang lebih panjang dan berbutir halus kepada sejumlah kecil Token yang boleh dipelajari, dengan itu mencapai pemodelan maklumat visual yang cekap. Token visual yang dijana dimasukkan ke dalam model bahasa bersama-sama dengan pertanyaan teks untuk menjana respons yang sepadan.

Latihan model: menggunakan kaedah latihan dua peringkat

Peringkat pertama: tujuan utama adalah terlebih dahulu Mempelajari pertentangan antara modaliti visual dan lisan. Berbeza daripada kerja sebelumnya, mPLUG-Owl mencadangkan bahawa membekukan modul asas visual akan mengehadkan keupayaan model untuk mengaitkan pengetahuan visual dan pengetahuan teks. Oleh itu, mPLUG-Owl hanya membekukan parameter LLM pada peringkat pertama dan menggunakan LAION-400M, COYO-700M, CC dan MSCOCO untuk melatih modul asas visual dan modul ringkasan visual.

Peringkat kedua: Meneruskan penemuan bahawa latihan campuran modaliti yang berbeza dalam mPLUG dan mPLUG-2 bermanfaat antara satu sama lain, Owl juga menggunakan latihan tulen dalam peringkat kedua pengajaran halus- latihan penalaan. Data arahan tekstual (52k daripada Alpaca+90k daripada Vicuna+50k daripada Baize) dan data arahan berbilang mod (150k daripada LLaVA). Melalui eksperimen ablasi yang terperinci, penulis mengesahkan faedah yang dibawa oleh pengenalan penalaan halus arahan teks tulen dalam aspek seperti pemahaman arahan. Pada peringkat kedua, parameter modul asas visual, modul ringkasan visual dan LLM asal dibekukan Merujuk kepada LoRA, hanya struktur penyesuai dengan sejumlah kecil parameter dimasukkan ke dalam LLM untuk penalaan halus arahan.

Hasil eksperimen

Perbandingan SOTA

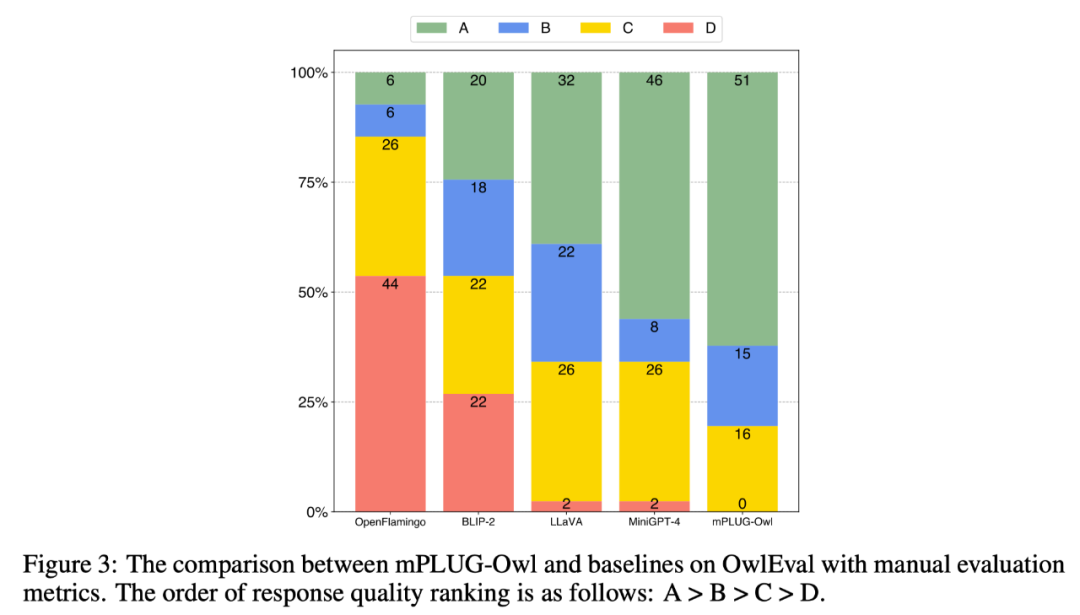

Untuk membandingkan keupayaan pelbagai mod bagi model yang berbeza, Kerja ini membina set penilaian arahan berbilang modal OwlEval. Memandangkan tiada penunjuk automatik yang sesuai pada masa ini, rujuk Self-Intruct untuk penilaian manual bagi jawapan model: A="Betul dan memuaskan" B="Sesetengah ketidaksempurnaan, tetapi boleh diterima"; arahan tetapi terdapat ralat yang jelas dalam respons"; D="Respons tidak relevan atau tidak betul sama sekali".

Hasil perbandingan ditunjukkan dalam Rajah 3 di bawah Eksperimen membuktikan bahawa Owl lebih baik daripada OpenFlamingo, BLIP-2, LLaVA dan MiniGPT-4 yang sedia ada dalam tugas tindak balas arahan berkaitan visual. .

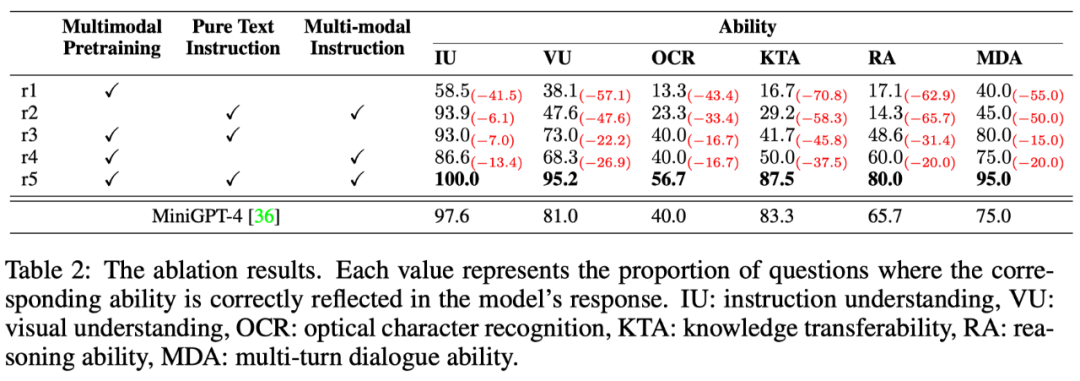

Perbandingan keupayaan berbilang dimensi

Tugas tindak balas perintah berbilang mod melibatkan pelbagai kebolehan, seperti pemahaman arahan, pemahaman visual, pemahaman teks pada gambar dan penaakulan. Untuk meneroka tahap keupayaan berbeza model dengan cara yang terperinci, artikel ini mentakrifkan 6 keupayaan utama dalam senario berbilang modal dan secara manual menganotasi setiap arahan ujian OwlEval dengan keperluan keupayaan yang berkaitan dan respons yang ditunjukkan dalam model. Apakah kebolehan yang telah diperolehi.

Keputusan ditunjukkan dalam Jadual 6 di bawah dalam bahagian eksperimen ini, penulis bukan sahaja menjalankan eksperimen ablasi Burung Hantu untuk mengesahkan keberkesanan strategi latihan dan denda arahan pelbagai mod. -penalaan data, tetapi juga Garis asas yang berprestasi terbaik dalam percubaan sebelumnya—MiniGPT4—dibandingkan, dan keputusan menunjukkan bahawa Owl lebih unggul daripada MiniGPT4 dalam semua aspek keupayaan.

Atas ialah kandungan terperinci mPLUG-Owl DAMO Academy diperkenalkan: model besar berbilang modal modular, mengejar keupayaan berbilang modal GPT-4. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1382

1382

52

52

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Perintah shutdown CentOS adalah penutupan, dan sintaks adalah tutup [pilihan] [maklumat]. Pilihan termasuk: -h menghentikan sistem dengan segera; -P mematikan kuasa selepas penutupan; -r mulakan semula; -T Waktu Menunggu. Masa boleh ditentukan sebagai segera (sekarang), minit (minit), atau masa tertentu (HH: mm). Maklumat tambahan boleh dipaparkan dalam mesej sistem.

Apakah kaedah sandaran untuk gitlab di centos

Apr 14, 2025 pm 05:33 PM

Apakah kaedah sandaran untuk gitlab di centos

Apr 14, 2025 pm 05:33 PM

Dasar sandaran dan pemulihan Gitlab di bawah sistem CentOS untuk memastikan keselamatan data dan pemulihan, Gitlab pada CentOS menyediakan pelbagai kaedah sandaran. Artikel ini akan memperkenalkan beberapa kaedah sandaran biasa, parameter konfigurasi dan proses pemulihan secara terperinci untuk membantu anda menubuhkan strategi sandaran dan pemulihan GitLab lengkap. 1. Backup Manual Gunakan Gitlab-Rakegitlab: Backup: Buat Perintah untuk Melaksanakan Backup Manual. Perintah ini menyokong maklumat utama seperti repositori Gitlab, pangkalan data, pengguna, kumpulan pengguna, kunci, dan kebenaran. Fail sandaran lalai disimpan dalam direktori/var/opt/gitlab/sandaran. Anda boleh mengubah suai /etc /gitlab

Cara Memeriksa Konfigurasi HDFS CentOS

Apr 14, 2025 pm 07:21 PM

Cara Memeriksa Konfigurasi HDFS CentOS

Apr 14, 2025 pm 07:21 PM

Panduan Lengkap untuk Memeriksa Konfigurasi HDFS Dalam Sistem CentOS Artikel ini akan membimbing anda bagaimana untuk memeriksa konfigurasi dan menjalankan status HDFS secara berkesan pada sistem CentOS. Langkah -langkah berikut akan membantu anda memahami sepenuhnya persediaan dan operasi HDFS. Sahkan Pembolehubah Alam Sekitar Hadoop: Pertama, pastikan pembolehubah persekitaran Hadoop ditetapkan dengan betul. Di terminal, laksanakan arahan berikut untuk mengesahkan bahawa Hadoop dipasang dan dikonfigurasi dengan betul: Hadoopversion Semak fail konfigurasi HDFS: Fail konfigurasi teras HDFS terletak di/etc/hadoop/conf/direktori, di mana core-site.xml dan hdfs-site.xml adalah kritikal. gunakan

Apakah kaedah penalaan prestasi zookeeper di CentOS

Apr 14, 2025 pm 03:18 PM

Apakah kaedah penalaan prestasi zookeeper di CentOS

Apr 14, 2025 pm 03:18 PM

Penalaan prestasi zookeeper pada centOs boleh bermula dari pelbagai aspek, termasuk konfigurasi perkakasan, pengoptimuman sistem operasi, pelarasan parameter konfigurasi, pemantauan dan penyelenggaraan, dan lain -lain. Memori yang cukup: memperuntukkan sumber memori yang cukup untuk zookeeper untuk mengelakkan cakera kerap membaca dan menulis. CPU multi-teras: Gunakan CPU multi-teras untuk memastikan bahawa zookeeper dapat memprosesnya selari.

Cara Melatih Model Pytorch di CentOs

Apr 14, 2025 pm 03:03 PM

Cara Melatih Model Pytorch di CentOs

Apr 14, 2025 pm 03:03 PM

Latihan yang cekap model pytorch pada sistem CentOS memerlukan langkah -langkah, dan artikel ini akan memberikan panduan terperinci. 1. Penyediaan Persekitaran: Pemasangan Python dan Ketergantungan: Sistem CentOS biasanya mempamerkan python, tetapi versi mungkin lebih tua. Adalah disyorkan untuk menggunakan YUM atau DNF untuk memasang Python 3 dan menaik taraf PIP: Sudoyumupdatepython3 (atau SudodnfupdatePython3), pip3install-upgradepip. CUDA dan CUDNN (Percepatan GPU): Jika anda menggunakan Nvidiagpu, anda perlu memasang Cudatool

Bagaimana sokongan GPU untuk Pytorch di CentOS

Apr 14, 2025 pm 06:48 PM

Bagaimana sokongan GPU untuk Pytorch di CentOS

Apr 14, 2025 pm 06:48 PM

Membolehkan pecutan GPU pytorch pada sistem CentOS memerlukan pemasangan cuda, cudnn dan GPU versi pytorch. Langkah-langkah berikut akan membimbing anda melalui proses: Pemasangan CUDA dan CUDNN Tentukan keserasian versi CUDA: Gunakan perintah NVIDIA-SMI untuk melihat versi CUDA yang disokong oleh kad grafik NVIDIA anda. Sebagai contoh, kad grafik MX450 anda boleh menyokong CUDA11.1 atau lebih tinggi. Muat turun dan pasang Cudatoolkit: Lawati laman web rasmi Nvidiacudatoolkit dan muat turun dan pasang versi yang sepadan mengikut versi CUDA tertinggi yang disokong oleh kad grafik anda. Pasang Perpustakaan Cudnn:

Penjelasan terperinci mengenai Prinsip Docker

Apr 14, 2025 pm 11:57 PM

Penjelasan terperinci mengenai Prinsip Docker

Apr 14, 2025 pm 11:57 PM

Docker menggunakan ciri -ciri kernel Linux untuk menyediakan persekitaran berjalan yang cekap dan terpencil. Prinsip kerjanya adalah seperti berikut: 1. Cermin digunakan sebagai templat baca sahaja, yang mengandungi semua yang anda perlukan untuk menjalankan aplikasi; 2. Sistem Fail Kesatuan (Unionfs) menyusun pelbagai sistem fail, hanya menyimpan perbezaan, menjimatkan ruang dan mempercepatkan; 3. Daemon menguruskan cermin dan bekas, dan pelanggan menggunakannya untuk interaksi; 4. Ruang nama dan cgroups melaksanakan pengasingan kontena dan batasan sumber; 5. Pelbagai mod rangkaian menyokong interkoneksi kontena. Hanya dengan memahami konsep -konsep teras ini, anda boleh menggunakan Docker dengan lebih baik.

Cara Memilih Versi PyTorch Di Bawah Centos

Apr 14, 2025 pm 02:51 PM

Cara Memilih Versi PyTorch Di Bawah Centos

Apr 14, 2025 pm 02:51 PM

Apabila memilih versi pytorch di bawah CentOS, faktor utama berikut perlu dipertimbangkan: 1. Keserasian versi CUDA Sokongan GPU: Jika anda mempunyai NVIDIA GPU dan ingin menggunakan pecutan GPU, anda perlu memilih pytorch yang menyokong versi CUDA yang sepadan. Anda boleh melihat versi CUDA yang disokong dengan menjalankan arahan NVIDIA-SMI. Versi CPU: Jika anda tidak mempunyai GPU atau tidak mahu menggunakan GPU, anda boleh memilih versi CPU PyTorch. 2. Pytorch versi python