Fahami apa itu pembelajaran mesin dalam satu artikel

Dunia dipenuhi dengan data – imej, video, hamparan, audio dan teks yang dijana oleh manusia dan komputer membanjiri internet, menenggelamkan kita dalam lautan maklumat.

Secara tradisinya, manusia menganalisis data untuk membuat keputusan yang lebih termaklum dan berusaha untuk melaraskan sistem untuk mengawal perubahan dalam corak data. Walau bagaimanapun, apabila jumlah maklumat masuk meningkat, keupayaan kami untuk memahaminya berkurangan, meninggalkan kami dengan cabaran berikut:

Bagaimanakah kami menggunakan semua data ini untuk memperoleh makna secara automatik dan bukannya manual?

Di sinilah pembelajaran mesin dimainkan. Artikel ini akan memperkenalkan:

- Apakah pembelajaran mesin

- Elemen utama algoritma pembelajaran mesin

- Cara pembelajaran mesin berfungsi

- 6 fakta sebenar Mesin Aplikasi Pembelajaran di Dunia

- Cabaran dan Had Pembelajaran Mesin

Ramalan ini dibuat oleh mesin mempelajari corak daripada set data yang dipanggil "data latihan", dan ia boleh memacu pembangunan teknologi selanjutnya untuk meningkatkan kehidupan orang ramai.

1 Apakah Pembelajaran Mesin

Pembelajaran mesin ialah konsep yang membolehkan komputer belajar secara automatik daripada contoh dan pengalaman serta meniru pembuatan keputusan manusia tanpa diprogramkan secara eksplisit.

Pembelajaran mesin ialah satu cabang kecerdasan buatan yang menggunakan algoritma dan teknik statistik untuk belajar daripada data dan memperoleh corak serta cerapan tersembunyi.

Sekarang, mari kita terokai selok-belok pembelajaran mesin dengan lebih mendalam.

2 Elemen Utama Algoritma Pembelajaran Mesin

Terdapat puluhan ribu algoritma dalam pembelajaran mesin, yang boleh dikumpulkan mengikut gaya pembelajaran atau sifat masalah yang sedang diselesaikan. Tetapi setiap algoritma pembelajaran mesin mengandungi komponen utama berikut:

- Data latihan – merujuk kepada teks, imej, video atau maklumat siri masa yang mana sistem pembelajaran mesin mesti belajar . Data latihan sering dilabelkan untuk menunjukkan sistem ML tentang "jawapan yang betul", seperti kotak sempadan di sekeliling muka dalam pengesan muka, atau prestasi stok masa hadapan dalam peramal stok.

- bermaksud - ia merujuk kepada perwakilan yang dikodkan bagi objek dalam data latihan, seperti wajah yang diwakili oleh ciri seperti "mata". Mengekodkan sesetengah model adalah lebih mudah daripada yang lain, dan inilah yang mendorong pemilihan model. Sebagai contoh, rangkaian saraf membentuk satu perwakilan, dan menyokong mesin vektor yang lain. Kebanyakan kaedah moden menggunakan rangkaian saraf.

- Penilaian - Ini adalah tentang cara kita menilai atau mengenal pasti satu model berbanding model yang lain. Kami biasanya memanggilnya fungsi utiliti, fungsi kehilangan atau fungsi pemarkahan. Purata ralat kuasa dua (keluaran model berbanding output data) atau kemungkinan (kebarangkalian anggaran model yang diberi data yang diperhatikan) adalah contoh fungsi penilaian yang berbeza.

- Pengoptimuman - Ini merujuk kepada cara mencari ruang yang mewakili model atau menambah baik label dalam data latihan untuk mendapatkan penilaian yang lebih baik. Pengoptimuman bermaksud mengemas kini parameter model untuk meminimumkan nilai fungsi kehilangan. Ia membantu model meningkatkan ketepatannya pada kadar yang lebih pantas.

Di atas ialah klasifikasi terperinci bagi empat komponen algoritma pembelajaran mesin.

Fungsi Sistem Pembelajaran Mesin

Deskriptif: Sistem mengumpul data sejarah, menyusunnya dan kemudian membentangkannya dengan cara yang mudah difahami.

Fokus utama adalah untuk memahami perkara yang sudah berlaku dalam perusahaan dan bukannya membuat inferens atau ramalan daripada penemuannya. Analitis deskriptif menggunakan alat matematik dan statistik mudah seperti aritmetik, purata dan peratusan berbanding pengiraan kompleks yang diperlukan untuk analitik ramalan dan preskriptif.

Analisis deskriptif terutamanya menganalisis dan menyimpulkan data sejarah, manakala analisis ramalan memfokuskan pada meramal dan memahami kemungkinan situasi masa depan.

Menganalisis corak dan aliran data masa lalu dengan melihat data sejarah boleh meramalkan perkara yang mungkin berlaku pada masa hadapan.

Analisis preskriptif memberitahu kita cara bertindak, manakala analisis deskriptif memberitahu kita apa yang berlaku pada masa lalu. Analitik ramalan memberitahu kita perkara yang mungkin berlaku pada masa hadapan dengan belajar daripada masa lalu. Tetapi apabila kita mendapat gambaran tentang apa yang mungkin berlaku, apakah yang perlu kita lakukan?

Ini adalah analisis normatif. Ia membantu sistem menggunakan pengetahuan lepas untuk membuat beberapa pengesyoran tentang tindakan yang boleh diambil oleh seseorang. Analitis preskriptif boleh memodelkan senario dan menyediakan laluan untuk mencapai hasil yang diinginkan.

3 Cara pembelajaran mesin berfungsi

Pembelajaran algoritma ML boleh dibahagikan kepada tiga bahagian utama.

Proses Membuat Keputusan

Model pembelajaran mesin direka bentuk untuk mempelajari corak daripada data dan menggunakan pengetahuan ini untuk membuat ramalan. Persoalannya ialah: Bagaimanakah model membuat ramalan?

Proses ini sangat asas - cari corak dalam data input (berlabel atau tidak berlabel) dan gunakannya untuk memperoleh hasil.

Fungsi ralat

Model pembelajaran mesin direka bentuk untuk membandingkan ramalan yang mereka buat berdasarkan kebenaran. Matlamatnya adalah untuk memahami sama ada ia belajar ke arah yang betul. Ini menentukan ketepatan model dan mencadangkan cara kami boleh menambah baik latihan model.

Proses Pengoptimuman Model

Matlamat utama model adalah untuk memperbaik ramalan, yang bermaksud mengurangkan perbezaan antara hasil yang diketahui dan anggaran model yang sepadan.

Model perlu menyesuaikan diri dengan lebih baik kepada sampel data latihan dengan sentiasa mengemas kini pemberat. Algoritma berfungsi dalam gelung, menilai dan mengoptimumkan keputusan, mengemas kini pemberat, sehingga nilai maksimum diperoleh mengenai ketepatan model.

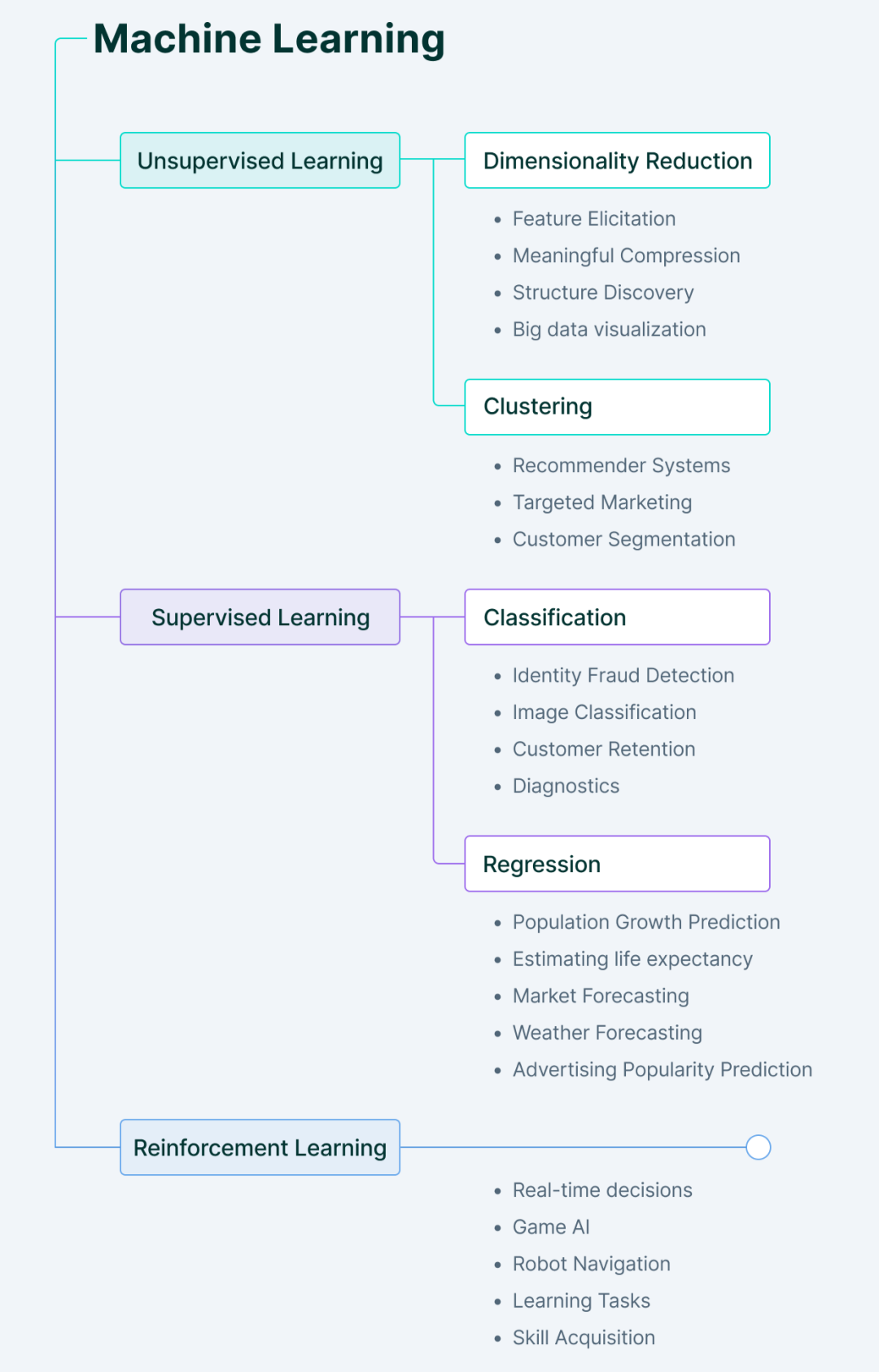

Jenis kaedah pembelajaran mesin

Pembelajaran mesin terutamanya merangkumi empat jenis.

1. Pembelajaran mesin diselia

Dalam pembelajaran diselia, seperti namanya, mesin belajar di bawah bimbingan.

Ini dilakukan dengan memberi komputer satu set data berlabel supaya mesin memahami apa input dan output yang sepatutnya. Di sini, manusia bertindak sebagai panduan, menyediakan model dengan data latihan berlabel (pasangan input-output) dari mana mesin mempelajari corak.

Setelah hubungan antara input dan output dipelajari daripada set data sebelumnya, mesin boleh meramalkan nilai output data baharu dengan mudah.

Di manakah kita boleh menggunakan pembelajaran diselia?

Jawapannya ialah: apabila kita tahu apa yang perlu dicari dalam data input dan apa yang kita mahu sebagai output.

Jenis utama masalah pembelajaran yang diselia termasuk masalah regresi dan klasifikasi.

2. Pembelajaran Mesin Tanpa Selia

Pembelajaran tanpa seliaan berfungsi betul-betul bertentangan dengan pembelajaran diselia.

Ia menggunakan data tidak berlabel - mesin perlu memahami data, mencari corak tersembunyi dan membuat ramalan dengan sewajarnya.

Di sini, mesin memberikan kita penemuan baharu selepas secara bebas memperoleh corak tersembunyi daripada data, tanpa manusia perlu menentukan perkara yang perlu dicari.

Jenis utama masalah pembelajaran tanpa penyeliaan termasuk pengkelompokan dan analisis peraturan persatuan.

3. Pembelajaran Peneguhan

Pembelajaran peneguhan melibatkan agen yang belajar untuk berkelakuan dalam persekitaran dengan melakukan tindakan.

Berdasarkan keputusan tindakan ini, ia memberikan maklum balas dan menyesuaikan perjalanan masa hadapan - untuk setiap tindakan yang baik, ejen mendapat maklum balas positif, dan untuk setiap tindakan buruk, ejen mendapat maklum balas atau hukuman negatif.

Pembelajaran pengukuhan belajar tanpa sebarang data berlabel. Oleh kerana tiada data berlabel, ejen hanya boleh belajar berdasarkan pengalamannya sendiri.

4. Pembelajaran separuh penyeliaan

Separuh penyeliaan ialah keadaan antara pembelajaran diselia dan tidak diselia.

Ia mengambil aspek positif daripada setiap pembelajaran, iaitu menggunakan set data berlabel yang lebih kecil untuk membimbing pengelasan dan melaksanakan pengekstrakan ciri tanpa pengawasan daripada set data tidak berlabel yang lebih besar.

Kelebihan utama menggunakan pembelajaran separa penyeliaan ialah keupayaannya untuk menyelesaikan masalah apabila data berlabel tidak mencukupi untuk melatih model, atau apabila data itu tidak boleh dilabelkan kerana manusia tidak tahu apa yang perlu dilihat kerana di dalamnya.

Empat 6 Aplikasi Pembelajaran Mesin Dunia Sebenar

Pembelajaran mesin adalah nadi hampir setiap syarikat teknologi hari ini, termasuk perniagaan seperti Google atau enjin carian Youtube.

Di bawah, kami telah meringkaskan beberapa contoh aplikasi sebenar pembelajaran mesin yang mungkin anda kenali:

Kereta pandu sendiri

Kenderaan menghadapi pelbagai situasi di jalan raya.

Untuk kereta pandu sendiri berprestasi lebih baik daripada manusia, mereka perlu belajar dan menyesuaikan diri dengan perubahan keadaan jalan dan tingkah laku kenderaan lain.

Kereta pandu sendiri mengumpul data tentang persekitarannya daripada penderia dan kamera, kemudian tafsirkannya dan bertindak balas dengan sewajarnya. Ia menggunakan pembelajaran diselia untuk mengenal pasti objek sekeliling, pembelajaran tanpa pengawasan untuk mengenal pasti corak dalam kenderaan lain, dan akhirnya mengambil tindakan sewajarnya dengan bantuan algoritma pengukuhan.

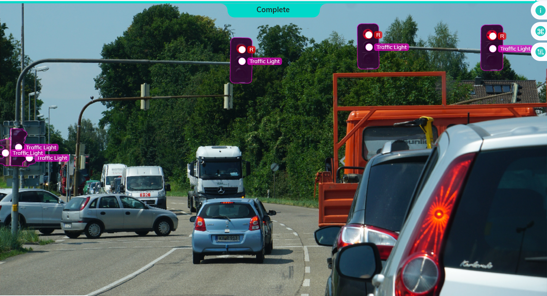

Analisis Imej dan Pengesanan Objek

Analisis imej digunakan untuk mengekstrak maklumat yang berbeza daripada imej.

Ia mempunyai aplikasi dalam bidang seperti memeriksa kecacatan pembuatan, menganalisis trafik kereta di bandar pintar atau enjin carian visual seperti Google Lens.

Idea utama ialah menggunakan teknik pembelajaran mendalam untuk mengekstrak ciri daripada imej dan kemudian menggunakan ciri ini pada pengesanan objek.

Customer Service Chatbots

Adalah perkara biasa hari ini untuk syarikat menggunakan AI chatbots untuk menyediakan sokongan dan jualan pelanggan. AI chatbots membantu perniagaan mengendalikan jumlah pertanyaan pelanggan yang tinggi dengan menyediakan sokongan 24/7, sekali gus mengurangkan kos sokongan dan menjana pendapatan tambahan serta pelanggan yang gembira.

Robotik AI menggunakan pemprosesan bahasa semula jadi (NLP) untuk memproses teks, mengekstrak kata kunci pertanyaan dan bertindak balas dengan sewajarnya.

Pengimejan dan Diagnostik Perubatan

Kebenarannya ialah: data pengimejan perubatan adalah sumber maklumat yang paling kaya dan paling kompleks.

Menganalisis beribu-ribu imej perubatan secara manual adalah tugas yang membosankan dan membuang masa yang berharga untuk ahli patologi yang boleh digunakan dengan lebih cekap.

Tetapi ini bukan sahaja tentang menjimatkan masa – ciri kecil seperti artifak atau nodul mungkin tidak dapat dilihat dengan mata kasar, menyebabkan kelewatan dalam diagnosis penyakit dan ramalan yang salah. Inilah sebabnya mengapa terdapat begitu banyak potensi menggunakan teknik pembelajaran mendalam yang melibatkan rangkaian saraf, yang boleh digunakan untuk mengekstrak ciri daripada imej.

Pengenalpastian Penipuan

Apabila sektor e-dagang berkembang, kita dapat melihat peningkatan dalam bilangan transaksi dalam talian dan kepelbagaian kaedah pembayaran yang tersedia. Malangnya, sesetengah orang mengambil kesempatan daripada keadaan ini. Penipu di dunia hari ini berkemahiran tinggi dan boleh menggunakan teknologi baharu dengan cepat.

Itulah sebabnya kami memerlukan sistem yang boleh menganalisis corak data, membuat ramalan yang tepat dan bertindak balas terhadap ancaman keselamatan siber dalam talian seperti percubaan log masuk palsu atau serangan pancingan data.

Sebagai contoh, sistem pencegahan penipuan boleh mengetahui sama ada pembelian adalah sah berdasarkan tempat anda membuat pembelian pada masa lalu atau berapa lama anda berada dalam talian. Begitu juga, mereka boleh mengesan jika seseorang cuba menyamar sebagai anda dalam talian atau melalui telefon.

Algoritma Pengesyoran

Kaitan algoritma pengesyoran ini adalah berdasarkan kajian data sejarah dan bergantung pada beberapa faktor, termasuk pilihan dan minat pengguna.

Syarikat seperti JD.com atau Douyin menggunakan sistem pengesyoran untuk memilih dan memaparkan kandungan atau produk yang berkaitan kepada pengguna/pembeli.

Lima Cabaran dan Had Pembelajaran Mesin

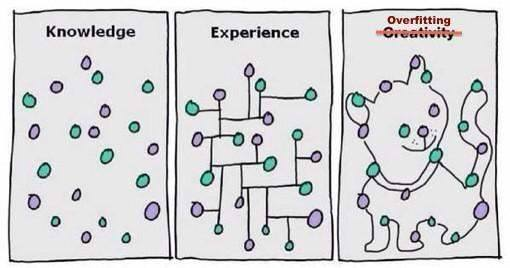

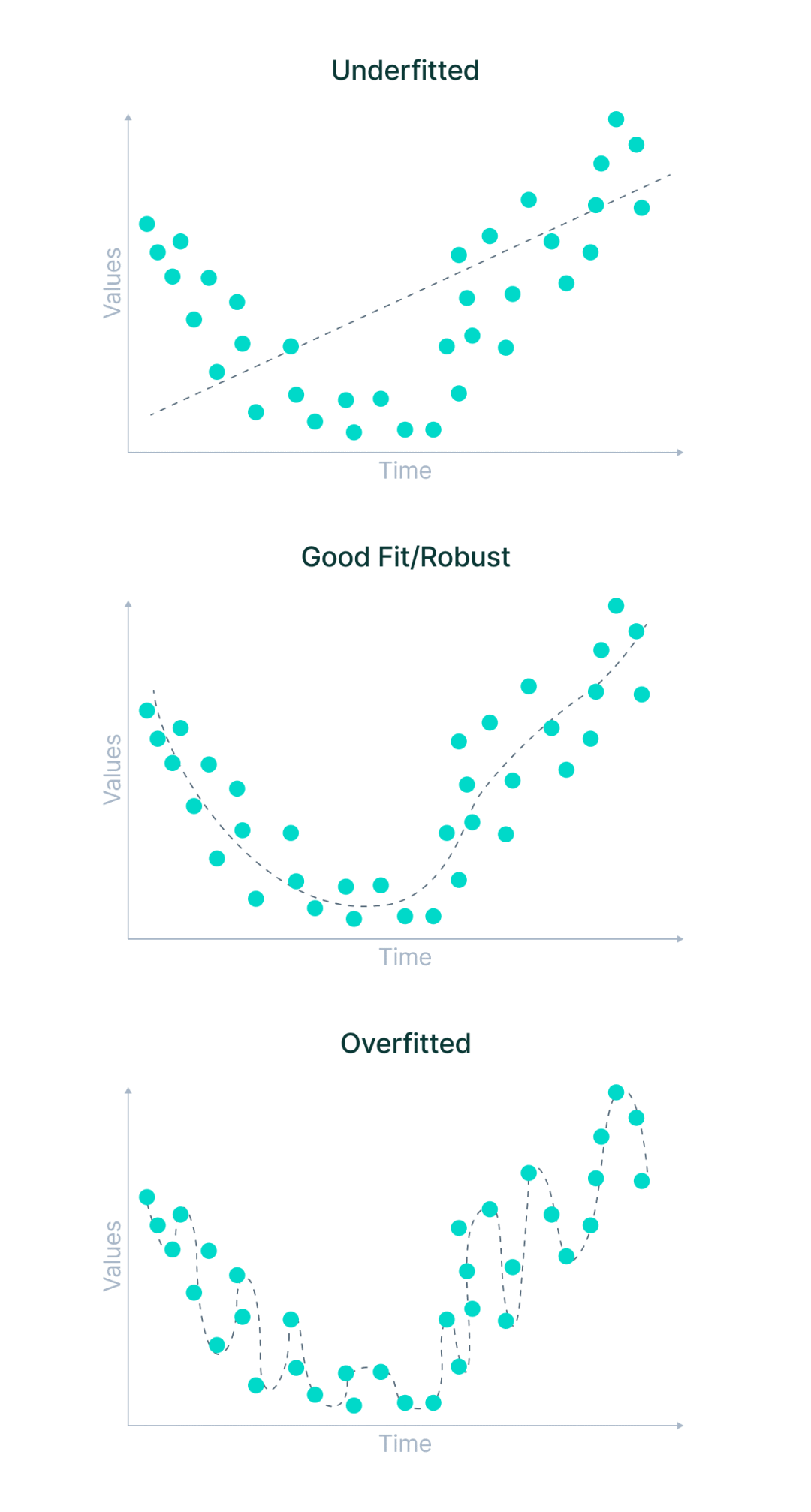

Underfitting dan Overfitting

Dalam kebanyakan kes, sebab prestasi lemah mana-mana algoritma pembelajaran mesin adalah Disebabkan oleh underfitting dan overfitting.

Mari kita pecahkan istilah ini dalam konteks melatih model pembelajaran mesin.

- Underfitting ialah senario di mana model pembelajaran mesin tidak dapat mempelajari hubungan antara pembolehubah dalam data mahupun meramal titik data baharu dengan betul. Dalam erti kata lain, sistem pembelajaran mesin tidak mengesan arah aliran merentas titik data.

- Pemasangan berlebihan berlaku apabila model pembelajaran mesin belajar terlalu banyak daripada data latihan, memberi perhatian kepada titik data yang sememangnya bising atau tidak berkaitan dengan julat set data. Ia cuba untuk menyesuaikan setiap titik pada lengkung dan oleh itu mengingati corak data.

Memandangkan model mempunyai sedikit fleksibiliti, ia tidak boleh meramal titik data baharu. Dalam erti kata lain, ia terlalu menumpukan pada contoh yang diberikan dan gagal untuk melihat gambaran yang lebih besar.

Apakah punca underfitting dan overfitting?

Kes yang lebih umum termasuk situasi di mana data yang digunakan untuk latihan tidak bersih dan mengandungi banyak bunyi bising atau nilai sampah, atau saiz data terlalu kecil. Walau bagaimanapun, terdapat beberapa sebab yang lebih spesifik.

Mari kita lihat perkara tersebut.

Underfitting mungkin berlaku kerana:

- Model telah dilatih dengan parameter yang salah dan data latihan tidak diperhatikan sepenuhnya

- Model terlalu mudah dan tidak mengingati ciri yang mencukupi

- Data latihan terlalu pelbagai atau kompleks

Pemasangan berlebihan boleh berlaku apabila:

- Model dilatih dengan parameter yang salah dan terlalu memerhati data latihan

- Model itu terlalu kompleks dan tidak terlatih terlebih dahulu pada data yang lebih pelbagai.

- Label data latihan terlalu ketat atau data asal terlalu seragam dan tidak mewakili pengedaran sebenar.

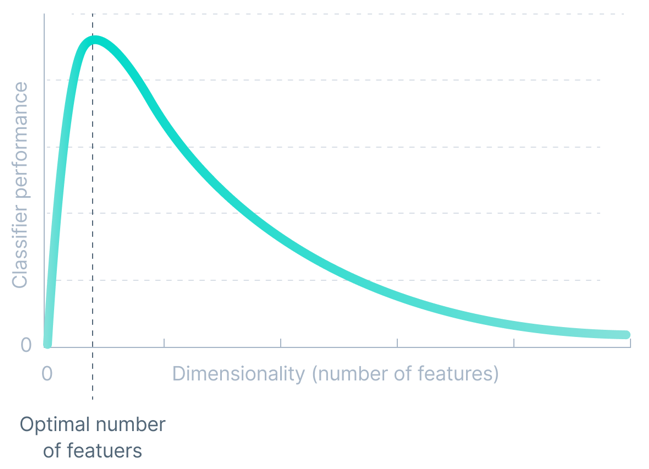

Dimensi

Ketepatan mana-mana model pembelajaran mesin adalah berkadar terus dengan dimensi set data. Tetapi ia hanya berfungsi sehingga ambang tertentu.

Dimensi set data merujuk kepada bilangan atribut/ciri yang terdapat dalam set data. Meningkatkan bilangan dimensi secara eksponen membawa kepada penambahan atribut tidak penting yang mengelirukan model, sekali gus mengurangkan ketepatan model pembelajaran mesin.

Kami memanggil kesukaran ini yang dikaitkan dengan melatih model pembelajaran mesin sebagai "kutukan dimensi".

Kualiti Data

Algoritma pembelajaran mesin sensitif kepada data latihan berkualiti rendah.

Kualiti data mungkin terjejas disebabkan oleh hingar dalam data yang disebabkan oleh data yang salah atau nilai yang hilang. Walaupun ralat yang agak kecil dalam data latihan boleh membawa kepada ralat berskala besar dalam output sistem.

Apabila algoritma berprestasi buruk, ia biasanya disebabkan oleh isu kualiti data seperti data kuantiti/skew/bising yang tidak mencukupi atau ciri yang tidak mencukupi untuk menerangkan data.

Oleh itu, sebelum melatih model pembelajaran mesin, pembersihan data selalunya diperlukan untuk mendapatkan data berkualiti tinggi.

Atas ialah kandungan terperinci Fahami apa itu pembelajaran mesin dalam satu artikel. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

Artikel ini akan membawa anda memahami SHAP: penjelasan model untuk pembelajaran mesin

Jun 01, 2024 am 10:58 AM

Artikel ini akan membawa anda memahami SHAP: penjelasan model untuk pembelajaran mesin

Jun 01, 2024 am 10:58 AM

Dalam bidang pembelajaran mesin dan sains data, kebolehtafsiran model sentiasa menjadi tumpuan penyelidik dan pengamal. Dengan aplikasi meluas model yang kompleks seperti kaedah pembelajaran mendalam dan ensemble, memahami proses membuat keputusan model menjadi sangat penting. AI|XAI yang boleh dijelaskan membantu membina kepercayaan dan keyakinan dalam model pembelajaran mesin dengan meningkatkan ketelusan model. Meningkatkan ketelusan model boleh dicapai melalui kaedah seperti penggunaan meluas pelbagai model yang kompleks, serta proses membuat keputusan yang digunakan untuk menerangkan model. Kaedah ini termasuk analisis kepentingan ciri, anggaran selang ramalan model, algoritma kebolehtafsiran tempatan, dsb. Analisis kepentingan ciri boleh menerangkan proses membuat keputusan model dengan menilai tahap pengaruh model ke atas ciri input. Anggaran selang ramalan model

Melaksanakan Algoritma Pembelajaran Mesin dalam C++: Cabaran dan Penyelesaian Biasa

Jun 03, 2024 pm 01:25 PM

Melaksanakan Algoritma Pembelajaran Mesin dalam C++: Cabaran dan Penyelesaian Biasa

Jun 03, 2024 pm 01:25 PM

Cabaran biasa yang dihadapi oleh algoritma pembelajaran mesin dalam C++ termasuk pengurusan memori, multi-threading, pengoptimuman prestasi dan kebolehselenggaraan. Penyelesaian termasuk menggunakan penunjuk pintar, perpustakaan benang moden, arahan SIMD dan perpustakaan pihak ketiga, serta mengikuti garis panduan gaya pengekodan dan menggunakan alat automasi. Kes praktikal menunjukkan cara menggunakan perpustakaan Eigen untuk melaksanakan algoritma regresi linear, mengurus memori dengan berkesan dan menggunakan operasi matriks berprestasi tinggi.

AI yang boleh dijelaskan: Menerangkan model AI/ML yang kompleks

Jun 03, 2024 pm 10:08 PM

AI yang boleh dijelaskan: Menerangkan model AI/ML yang kompleks

Jun 03, 2024 pm 10:08 PM

Penterjemah |. Disemak oleh Li Rui |. Chonglou Model kecerdasan buatan (AI) dan pembelajaran mesin (ML) semakin kompleks hari ini, dan output yang dihasilkan oleh model ini adalah kotak hitam – tidak dapat dijelaskan kepada pihak berkepentingan. AI Boleh Dijelaskan (XAI) bertujuan untuk menyelesaikan masalah ini dengan membolehkan pihak berkepentingan memahami cara model ini berfungsi, memastikan mereka memahami cara model ini sebenarnya membuat keputusan, dan memastikan ketelusan dalam sistem AI, Amanah dan akauntabiliti untuk menyelesaikan masalah ini. Artikel ini meneroka pelbagai teknik kecerdasan buatan (XAI) yang boleh dijelaskan untuk menggambarkan prinsip asasnya. Beberapa sebab mengapa AI boleh dijelaskan adalah penting Kepercayaan dan ketelusan: Untuk sistem AI diterima secara meluas dan dipercayai, pengguna perlu memahami cara keputusan dibuat

Algoritma pengesanan yang dipertingkatkan: untuk pengesanan sasaran dalam imej penderiaan jauh optik resolusi tinggi

Jun 06, 2024 pm 12:33 PM

Algoritma pengesanan yang dipertingkatkan: untuk pengesanan sasaran dalam imej penderiaan jauh optik resolusi tinggi

Jun 06, 2024 pm 12:33 PM

01Garis prospek Pada masa ini, sukar untuk mencapai keseimbangan yang sesuai antara kecekapan pengesanan dan hasil pengesanan. Kami telah membangunkan algoritma YOLOv5 yang dipertingkatkan untuk pengesanan sasaran dalam imej penderiaan jauh optik resolusi tinggi, menggunakan piramid ciri berbilang lapisan, strategi kepala pengesanan berbilang dan modul perhatian hibrid untuk meningkatkan kesan rangkaian pengesanan sasaran dalam imej penderiaan jauh optik. Menurut set data SIMD, peta algoritma baharu adalah 2.2% lebih baik daripada YOLOv5 dan 8.48% lebih baik daripada YOLOX, mencapai keseimbangan yang lebih baik antara hasil pengesanan dan kelajuan. 02 Latar Belakang & Motivasi Dengan perkembangan pesat teknologi penderiaan jauh, imej penderiaan jauh optik resolusi tinggi telah digunakan untuk menggambarkan banyak objek di permukaan bumi, termasuk pesawat, kereta, bangunan, dll. Pengesanan objek dalam tafsiran imej penderiaan jauh

Lima sekolah pembelajaran mesin yang anda tidak tahu

Jun 05, 2024 pm 08:51 PM

Lima sekolah pembelajaran mesin yang anda tidak tahu

Jun 05, 2024 pm 08:51 PM

Pembelajaran mesin ialah cabang penting kecerdasan buatan yang memberikan komputer keupayaan untuk belajar daripada data dan meningkatkan keupayaan mereka tanpa diprogramkan secara eksplisit. Pembelajaran mesin mempunyai pelbagai aplikasi dalam pelbagai bidang, daripada pengecaman imej dan pemprosesan bahasa semula jadi kepada sistem pengesyoran dan pengesanan penipuan, dan ia mengubah cara hidup kita. Terdapat banyak kaedah dan teori yang berbeza dalam bidang pembelajaran mesin, antaranya lima kaedah yang paling berpengaruh dipanggil "Lima Sekolah Pembelajaran Mesin". Lima sekolah utama ialah sekolah simbolik, sekolah sambungan, sekolah evolusi, sekolah Bayesian dan sekolah analogi. 1. Simbolisme, juga dikenali sebagai simbolisme, menekankan penggunaan simbol untuk penaakulan logik dan ekspresi pengetahuan. Aliran pemikiran ini percaya bahawa pembelajaran adalah proses penolakan terbalik, melalui sedia ada

Adakah Flash Attention stabil? Meta dan Harvard mendapati bahawa sisihan berat model mereka berubah-ubah mengikut urutan magnitud

May 30, 2024 pm 01:24 PM

Adakah Flash Attention stabil? Meta dan Harvard mendapati bahawa sisihan berat model mereka berubah-ubah mengikut urutan magnitud

May 30, 2024 pm 01:24 PM

MetaFAIR bekerjasama dengan Harvard untuk menyediakan rangka kerja penyelidikan baharu untuk mengoptimumkan bias data yang dijana apabila pembelajaran mesin berskala besar dilakukan. Adalah diketahui bahawa latihan model bahasa besar sering mengambil masa berbulan-bulan dan menggunakan ratusan atau bahkan ribuan GPU. Mengambil model LLaMA270B sebagai contoh, latihannya memerlukan sejumlah 1,720,320 jam GPU. Melatih model besar memberikan cabaran sistemik yang unik disebabkan oleh skala dan kerumitan beban kerja ini. Baru-baru ini, banyak institusi telah melaporkan ketidakstabilan dalam proses latihan apabila melatih model AI generatif SOTA Mereka biasanya muncul dalam bentuk lonjakan kerugian Contohnya, model PaLM Google mengalami sehingga 20 lonjakan kerugian semasa proses latihan. Bias berangka adalah punca ketidaktepatan latihan ini,

Pembelajaran Mesin dalam C++: Panduan untuk Melaksanakan Algoritma Pembelajaran Mesin Biasa dalam C++

Jun 03, 2024 pm 07:33 PM

Pembelajaran Mesin dalam C++: Panduan untuk Melaksanakan Algoritma Pembelajaran Mesin Biasa dalam C++

Jun 03, 2024 pm 07:33 PM

Dalam C++, pelaksanaan algoritma pembelajaran mesin termasuk: Regresi linear: digunakan untuk meramalkan pembolehubah berterusan Langkah-langkah termasuk memuatkan data, mengira berat dan berat sebelah, mengemas kini parameter dan ramalan. Regresi logistik: digunakan untuk meramalkan pembolehubah diskret Proses ini serupa dengan regresi linear, tetapi menggunakan fungsi sigmoid untuk ramalan. Mesin Vektor Sokongan: Algoritma klasifikasi dan regresi yang berkuasa yang melibatkan pengkomputeran vektor sokongan dan label ramalan.

Tinjauan tentang trend masa depan teknologi Golang dalam pembelajaran mesin

May 08, 2024 am 10:15 AM

Tinjauan tentang trend masa depan teknologi Golang dalam pembelajaran mesin

May 08, 2024 am 10:15 AM

Potensi aplikasi bahasa Go dalam bidang pembelajaran mesin adalah besar Kelebihannya ialah: Concurrency: Ia menyokong pengaturcaraan selari dan sesuai untuk operasi intensif pengiraan dalam tugas pembelajaran mesin. Kecekapan: Pengumpul sampah dan ciri bahasa memastikan kod itu cekap, walaupun semasa memproses set data yang besar. Kemudahan penggunaan: Sintaksnya ringkas, menjadikannya mudah untuk belajar dan menulis aplikasi pembelajaran mesin.