Peranti teknologi

Peranti teknologi

AI

AI

Penyelidikan tentang kemungkinan membina model bahasa visual daripada satu set perkataan

Penyelidikan tentang kemungkinan membina model bahasa visual daripada satu set perkataan

Penyelidikan tentang kemungkinan membina model bahasa visual daripada satu set perkataan

Penterjemah | Pada masa ini,

kecerdasan buatan pelbagai modtelah menjaditopik hangat yang dibincangkan di jalanan. Dengan keluaran GPT-4 baru-baru ini, kami melihat banyak kemungkinan aplikasi baharu dan teknologi masa hadapan yang tidak dapat dibayangkan hanya enam bulan lalu. Malah, model bahasa visual secara amnya berguna untuk banyak tugas yang berbeza. Sebagai contoh, anda boleh menggunakan CLIP

(Pra-latihan Bahasa-Imej Kontrastif,iaitu "Pra-latihan Bahasa-Imej Kontrastif", pautan: https://www.php.cn/link/b02d46e8a3d8d9fd6028f3f2c2495864Pengkelasan imej tangkapan sifar pada set data ghaibbiasa ; 🎜>Pada masa yang sama, model bahasa visual tidak sempurna dalam artikel ini dalam , kami mahu untuk meneroka batasan model ini, menyerlahkan di mana dan sebab model tersebut mungkin gagal Sebenarnya,

artikelini ialah penerangan ringkas/peringkat tinggi tentang kami yang baru diterbitkan kertas kerja Rancangan akan dalam bentuk kertas ICLR 2023 Lisan Diterbitkan artikel tentang kod sumber lengkap , cuma klik pada pautan https://www.php.cn/link/afb992000fcf79ef7a53fffde9c8e044 PengenalanApakah model bahasa visual Model bahasa visual mengeksploitasi hubungan antara data visual dan linguistik telah merevolusikan bidang dengan bekerjasama untuk melaksanakan pelbagai tugasan Walaupun banyak model bahasa visual telah diperkenalkan dalam kesusasteraan sedia ada, CLIP ( lwn. pra-latihan imej bahasa ) masih merupakan model yang paling terkenal dan digunakan secara meluas

Dengan membenamkan imej dan kapsyen dalam ruang vektor yang sama, model CLIP membenarkan<.> untuk melakukan

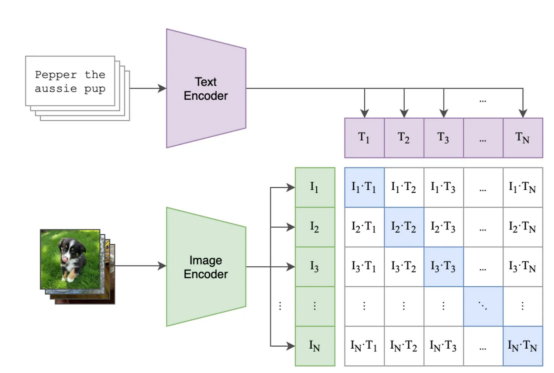

penaakulan rentas mod, membolehkan pengguna melaksanakan tugas seperti imej tangkapan sifar dengan ketepatan yang baik Tugasan seperti pengelasan dan perolehan teks-ke-imej Dan, model CLIP menggunakan kaedah pembelajaran kontrastif untuk mempelajari pembenaman imej dan kapsyen > Pembelajaran kontrastif membolehkan model CLIP belajar mengaitkan imej dengan kapsyen model CLIP dan lain-lain dengan meminimumkan jarak antara imej dalam perkongsian. ruang vektor. Hasil mengagumkan yang dicapai oleh model berasaskan kontras membuktikan bahawa pendekatan ini sangat berkesan digunakan dalam kumpulan perbandingan imej dan kapsyen, dan mengoptimumkan. model untuk memaksimumkan persamaan antara pembenaman pasangan teks imej yang sepadan dan mengurangkan persamaan antara pasangan teks imej lain dalam Persamaan kelompok. Rajah di bawah

menunjukkancontoh langkah batching dan latihan yang mungkin , Antaranya :

- Petak berwarna ungu mengandungi benaman untuk semua tajuk dan petak hijau mengandungi benaman untuk semua imej.

- Kuasa segi empat matriks mengandungi hasil darab titik semua benam imej dan semua benam teks dalam kelompok (dibaca sebagai "persamaan kosinus" kerana benam adalah dinormalkan).

- Segi empat sama biru mengandungi produk titik antara pasangan teks imej yang model mesti memaksimumkan persamaan, segi empat sama putih yang lain ialah persamaan yang ingin kita kurangkan (kerana setiap petak ini mengandungi persamaan dalam pasangan teks imej yang tidak sepadan, seperti imej kucing dan penerangan "kerusi vintaj saya" (kerusi vintaj saya).

Kontras pra-latihan dalam model CLIP (di mana, Petak biru ialah pasangan teks imej yang mana kami ingin mengoptimumkan persamaan )

Selepas latihan, anda seharusnya dapat menjana ruang vektor A yang bermakna untuk mengekod imej dan tajuk sepadan dengan tajuk (mis. cari "anjing di pantai" (anjing di pantai) dalam album foto percutian musim panas 2017), Atau cari label teks yang lebih serupa dengan imej yang diberikan (cth. anda mempunyai sekumpulan imej anjing dan kucing anda dan anda mahu dapat mengenal pasti yang mana). Model bahasa visual seperti CLIP telah menjadi alat yang berkuasa untuk menyelesaikan tugas kecerdasan buatan yang kompleks dengan menyepadukan maklumat visual dan linguistik Keupayaan mereka untuk membenamkan kedua-dua jenis data ini dalam ruang vektor yang dikongsi telah membawa kepada hasil yang tidak pernah berlaku sebelum ini dalam pelbagai jenis. aplikasi. Ketepatan dan Prestasi CemerlangBolehkah Model Bahasa Visual Memahami Bahasa? jawab soalan ini tentang sama ada atau sejauh mana model mendalam boleh memahami bahasa,

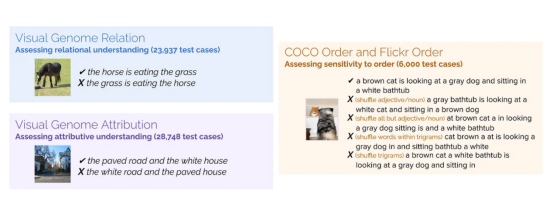

Pada masa ini terdapatdi sini, matlamat kami adalah untuk mengkaji model bahasa visual dan keupayaan sintesisnya 🎜>Kami mula-mula mencadangkan set data baharu untuk menguji pemahaman komponen; penanda aras baharu ini dipanggil ARO (Atribusi,

Perhubungan,dan Pesanan: Atribut) Seterusnya, kami meneroka sebab kehilangan kontras mungkin terhad dalam kes ini , kami mencadangkan penyelesaian yang mudah tetapi menjanjikan untuk masalah ini seperti CLIP (dan BLIP baru-baru ini Salesforce) lakukan untuk memahami bahasa? Kami telah mengumpulkan satu set gubahan berasaskan atribut untuk tajuk (cth. "pintu merah dan lelaki berdiri"

mengandungi dua set data): Set data berbeza yang kami buat termasuk Perhubungan, Atribusi dan Susunan. Untuk setiap set data, kami menunjukkan contoh imej dan tajuk yang berbeza. Antaranya,

hanya satu tajuk yang betul, dan model mesti mengenal pasti ini

ini

sebagai tajuk yang betul. AtributUji pemahaman atributHasilnya ialah: "jalan berturap dan rumah putih" (

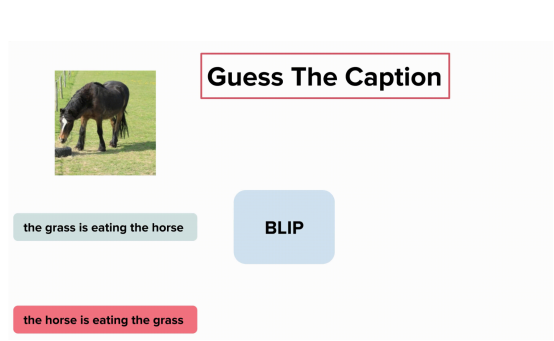

jalan berturap dan rumah putih- ) jalan putih dan rumah berturap” (白路和狠地的). Ujian hubungan pemahaman tentang hubungan Hasilnya : “kuda itu makan rumput" (kuda sedang makan rumput) dan "rumput sedang makan kuda" (

- Rumput sedang makan rumput). Akhir sekali, Order menguji fleksibiliti model selepas terganggu Keputusan : Kami merombak pengepala set data standard secara rawak (mis., MSCOCO). Bolehkah model bahasa visual mencari kapsyen yang betul untuk dipadankan dengan imej? Tugas itu nampak mudah, kita mahu model itu memahami perbezaan antara "kuda sedang makan rumput" dan "rumput itu makan rumput", bukan? Maksud saya, siapa yang pernah melihat rumput makan?

-

Nah, mungkin itu model BLIP, kerana ia tidak dapat memahami perbezaan antara "kuda itu makan rumput" dan "rumput itu makan rumput. ”:

Model BLIP tidak memahami perbezaan antara "rumput sedang makan rumput" dan "kuda sedang makan rumput" (di mana Mengandungi elemen daripada Set Data Genom Visual , Imej disediakan oleh pengarang )

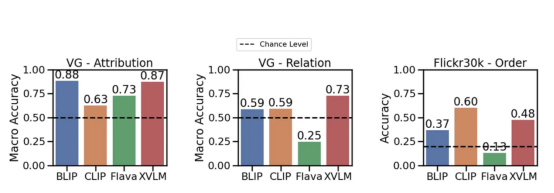

Sekarang , jom lihat eksperimenhasil:Beberapa model boleh melangkaui kemungkinan memahami perhubungan secara meluas (cth., makan——Makan). Walau bagaimanapun, KLIPModel berada dalam Atribut dan Perhubungan Aspek marginal adalah lebih tinggi sedikit daripada kemungkinan ini. Ini sebenarnya menunjukkan bahawa model bahasa visual masih bermasalah.

Model yang berbeza mempunyai atribut, perhubungan dan pesanan (Flick30k ) prestasi pada penanda aras. Yang menggunakan KLIP, BLIP dan model SoTA lain

Penilaian kehilangan semula dan kontrastif

Salah satu hasil utama kerja ini ialah kami mungkin memerlukan lebih daripada kehilangan kontrastif standard untuk mempelajari bahasa. Kenapa ini?

Mari kita mulakan dari awal: model bahasa visual sering dinilai dalam tugasan mendapatkan semula: ambil kapsyen dan cari imej yang dipetakan. Jika anda melihat set data yang digunakan untuk menilai model ini (mis., MSCOCO, Flickr30K), anda akan melihat bahawa ia selalunya mengandungi imej yang diterangkan dengan tajuk , yang Tajuk memerlukan pemahaman tentang gubahan (cth., "kucing oren di atas meja merah ": Kucing oren di atas meja merah). Jadi, jika tajuk adalah rumit, mengapa model tidak boleh mempelajari pemahaman gubahan?

[Penjelasan]Pendapatan semula pada set data ini tidak semestinya memerlukan pemahaman tentang komposisi.

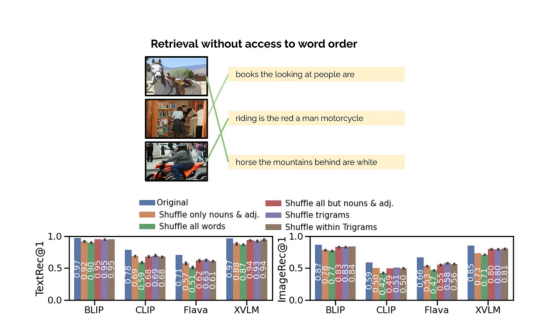

Kami cuba memahami masalah dengan lebih baik dan menguji prestasi model dalam mendapatkan semula apabila merombak susunan perkataan dalam tajuk. Bolehkah kita mencari imej yang betul untuk tajuk "buku yang dilihat orang" ? Jika jawapannya ya ; bermakna , tidak memerlukan maklumat arahan untuk mencari imej yang betul.

Tugas model ujian kami ialah mendapatkan semula menggunakan tajuk yang dikacau. Walaupun kita berebut kapsyen, model boleh mencari imej yang sepadan dengan betul (dan sebaliknya). Ini menunjukkan bahawa tugas mendapatkan semula mungkin terlalu mudah , Imej yang disediakan oleh pengarang.

Kami telah menguji proses shuffle yang berbeza dan hasilnya positif: walaupun dengan 🎜>Teknologi yang luar biasa, prestasi perolehan semula pada dasarnya tidak akan terjejas.

Mari kita katakan sekali lagi: model bahasa visual mencapai perolehan berprestasi tinggi pada set data ini, walaupun apabila maklumat arahan tidak boleh diakses. Model ini mungkin berkelakuan seperti satu timbunan perkataan, di mana susunan tidak penting: jika model tidak perlu memahami susunan perkataan untuk berprestasi baik dalam perolehan semula, jadi apakah yang sebenarnya kita ukur dalam perolehan semula?

Apa yang perlu saya lakukan?

Sekarang kita tahu ada masalah, kita mungkin mahu mencari penyelesaian. Cara paling mudah ialah: biarkan model CLIP memahami bahawa "kucing di atas meja" dan "meja di atas kucing" adalah berbeza.

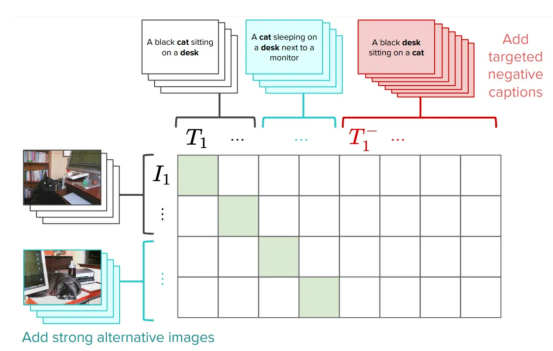

Malah, kami mencadangkan cara ialah penambahbaikan pada CLIP latihan dengan menambah negatif keras yang dibuat khusus untuk menyelesaikan masalah ini. Ini adalah penyelesaian yang sangat mudah dan cekap: ia memerlukan pengeditan yang sangat kecil kepada kehilangan CLIP asal tanpa menjejaskan prestasi keseluruhan (anda boleh membaca beberapa kaveat dalam kertas). Kami memanggil versi CLIP NegCLIP ini.

Pengenalan negatif keras dalam CLIP

model (Kami menambah imej dan teks keras negatif , Imej disediakan oleh pengarang)

Pada asasnya, kami meminta model NegCLIPuntuk meletakkan imej kucing hitam di atas meja" (hitam kucing duduk di atas meja)berhampiran ayat, tetapi jauh dari ayat" meja hitam duduk di atas kucing" ( meja hitam duduk di atas kucing). Perhatikan bahawa yang terakhir dijana secara automatik dengan menggunakan teg POS. Kesan daripada pembaikan ini ialah ia sebenarnya meningkatkan prestasi penanda aras ARO tanpa menjejaskan prestasi pengambilan semula atau prestasi tugasan hiliran seperti pengambilan semula dan klasifikasi. Lihat rajah di bawah untuk mendapatkan hasil pada penanda aras yang berbeza (lihat artikel ini

kertas sepadanuntuk butiran).

NegCLIP model dan CLIP model pada penanda aras berbeza. Antaranya, penanda aras biru ialah penanda aras yang kami perkenalkan, dan penanda aras hijau datang daripada rangkaiandokumentasi( Imej disediakan oleh pengarang )

Seperti yang anda lihat, terdapat peningkatan yang besar di sini berbanding garis dasar ARO, Terdapat juga penambahbaikan marginal atau prestasi serupa pada tugas hiliran lain.

Pengaturcaraan

Mert( Pengarang utama kertas kerja) telah melakukan kerja yang hebat mencipta perpustakaan kecil untuk menguji model bahasa visual. Anda boleh menggunakan kodnya untuk meniru hasil kami atau bereksperimen dengan model baharu. Ia hanya memerlukan beberapa baris

untuk memuat turun set data dan mula berjalanP bahasa ython :

Selain itu, kami melaksanakan model NegCLIPimport clip from dataset_zoo import VG_Relation, VG_Attribution model, image_preprocess = clip.load("ViT-B/32", device="cuda") root_dir="/path/to/aro/datasets" #把 download设置为True将把数据集下载到路径`root_dir`——如果不存在的话 #对于VG-R和VG-A,这将是1GB大小的压缩zip文件——它是GQA的一个子集 vgr_dataset = VG_Relation(image_preprocess=preprocess, download=True, root_dir=root_dir) vga_dataset = VG_Attribution(image_preprocess=preprocess, download=True, root_dir=root_dir) #可以对数据集作任何处理。数据集中的每一项具有类似如下的形式: # item = {"image_options": [image], "caption_options": [false_caption, true_caption]}Salin selepas log masuk(Ia sebenarnya salinan OpenCLIP yang dikemas kini), dan alamat muat turun kod lengkapnya ialah https://github.com/vinid/neg_clip. KesimpulanRingkasnya,

Model Bahasa VisualPada masa iniTerdapat banyak perkara yang boleh dilakukan . Seterusnya, Kami tidak sabar untuk melihat model masa depan seperti GPT4 boleh lakukan! Pengenalan PenterjemahZhu Xianzhong, editor komuniti 51CTO, blogger pakar 51CTO, pensyarah, guru komputer di sebuah universiti di Weifang, pengaturcaraan bebas komuniti Seorang veteran.

Tajuk asal:

Model Bahasa Visi Anda Mungkin Sebekas Kata , Pengarang: Federico Bianchi

Atas ialah kandungan terperinci Penyelidikan tentang kemungkinan membina model bahasa visual daripada satu set perkataan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1386

1386

52

52

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Laman web ini melaporkan pada 27 Jun bahawa Jianying ialah perisian penyuntingan video yang dibangunkan oleh FaceMeng Technology, anak syarikat ByteDance Ia bergantung pada platform Douyin dan pada asasnya menghasilkan kandungan video pendek untuk pengguna platform tersebut Windows , MacOS dan sistem pengendalian lain. Jianying secara rasmi mengumumkan peningkatan sistem keahliannya dan melancarkan SVIP baharu, yang merangkumi pelbagai teknologi hitam AI, seperti terjemahan pintar, penonjolan pintar, pembungkusan pintar, sintesis manusia digital, dsb. Dari segi harga, yuran bulanan untuk keratan SVIP ialah 79 yuan, yuran tahunan ialah 599 yuan (nota di laman web ini: bersamaan dengan 49.9 yuan sebulan), langganan bulanan berterusan ialah 59 yuan sebulan, dan langganan tahunan berterusan ialah 499 yuan setahun (bersamaan dengan 41.6 yuan sebulan) . Di samping itu, pegawai yang dipotong juga menyatakan bahawa untuk meningkatkan pengalaman pengguna, mereka yang telah melanggan VIP asal

Pembantu pengekodan AI yang ditambah konteks menggunakan Rag dan Sem-Rag

Jun 10, 2024 am 11:08 AM

Pembantu pengekodan AI yang ditambah konteks menggunakan Rag dan Sem-Rag

Jun 10, 2024 am 11:08 AM

Tingkatkan produktiviti, kecekapan dan ketepatan pembangun dengan menggabungkan penjanaan dipertingkatkan semula dan memori semantik ke dalam pembantu pengekodan AI. Diterjemah daripada EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, pengarang JanakiramMSV. Walaupun pembantu pengaturcaraan AI asas secara semulajadi membantu, mereka sering gagal memberikan cadangan kod yang paling relevan dan betul kerana mereka bergantung pada pemahaman umum bahasa perisian dan corak penulisan perisian yang paling biasa. Kod yang dijana oleh pembantu pengekodan ini sesuai untuk menyelesaikan masalah yang mereka bertanggungjawab untuk menyelesaikannya, tetapi selalunya tidak mematuhi piawaian pengekodan, konvensyen dan gaya pasukan individu. Ini selalunya menghasilkan cadangan yang perlu diubah suai atau diperhalusi agar kod itu diterima ke dalam aplikasi

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Model Bahasa Besar (LLM) dilatih pada pangkalan data teks yang besar, di mana mereka memperoleh sejumlah besar pengetahuan dunia sebenar. Pengetahuan ini dibenamkan ke dalam parameter mereka dan kemudiannya boleh digunakan apabila diperlukan. Pengetahuan tentang model ini "diperbaharui" pada akhir latihan. Pada akhir pra-latihan, model sebenarnya berhenti belajar. Selaraskan atau perhalusi model untuk mempelajari cara memanfaatkan pengetahuan ini dan bertindak balas dengan lebih semula jadi kepada soalan pengguna. Tetapi kadangkala pengetahuan model tidak mencukupi, dan walaupun model boleh mengakses kandungan luaran melalui RAG, ia dianggap berfaedah untuk menyesuaikan model kepada domain baharu melalui penalaan halus. Penalaan halus ini dilakukan menggunakan input daripada anotasi manusia atau ciptaan LLM lain, di mana model menemui pengetahuan dunia sebenar tambahan dan menyepadukannya

Tujuh Soalan Temuduga Teknikal GenAI & LLM yang Cool

Jun 07, 2024 am 10:06 AM

Tujuh Soalan Temuduga Teknikal GenAI & LLM yang Cool

Jun 07, 2024 am 10:06 AM

Untuk mengetahui lebih lanjut tentang AIGC, sila layari: 51CTOAI.x Komuniti https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou berbeza daripada bank soalan tradisional yang boleh dilihat di mana-mana sahaja di Internet memerlukan pemikiran di luar kotak. Model Bahasa Besar (LLM) semakin penting dalam bidang sains data, kecerdasan buatan generatif (GenAI) dan kecerdasan buatan. Algoritma kompleks ini meningkatkan kemahiran manusia dan memacu kecekapan dan inovasi dalam banyak industri, menjadi kunci kepada syarikat untuk kekal berdaya saing. LLM mempunyai pelbagai aplikasi Ia boleh digunakan dalam bidang seperti pemprosesan bahasa semula jadi, penjanaan teks, pengecaman pertuturan dan sistem pengesyoran. Dengan belajar daripada sejumlah besar data, LLM dapat menjana teks

Lima sekolah pembelajaran mesin yang anda tidak tahu

Jun 05, 2024 pm 08:51 PM

Lima sekolah pembelajaran mesin yang anda tidak tahu

Jun 05, 2024 pm 08:51 PM

Pembelajaran mesin ialah cabang penting kecerdasan buatan yang memberikan komputer keupayaan untuk belajar daripada data dan meningkatkan keupayaan mereka tanpa diprogramkan secara eksplisit. Pembelajaran mesin mempunyai pelbagai aplikasi dalam pelbagai bidang, daripada pengecaman imej dan pemprosesan bahasa semula jadi kepada sistem pengesyoran dan pengesanan penipuan, dan ia mengubah cara hidup kita. Terdapat banyak kaedah dan teori yang berbeza dalam bidang pembelajaran mesin, antaranya lima kaedah yang paling berpengaruh dipanggil "Lima Sekolah Pembelajaran Mesin". Lima sekolah utama ialah sekolah simbolik, sekolah sambungan, sekolah evolusi, sekolah Bayesian dan sekolah analogi. 1. Simbolisme, juga dikenali sebagai simbolisme, menekankan penggunaan simbol untuk penaakulan logik dan ekspresi pengetahuan. Aliran pemikiran ini percaya bahawa pembelajaran adalah proses penolakan terbalik, melalui sedia ada

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Editor |ScienceAI Question Answering (QA) set data memainkan peranan penting dalam mempromosikan penyelidikan pemprosesan bahasa semula jadi (NLP). Set data QA berkualiti tinggi bukan sahaja boleh digunakan untuk memperhalusi model, tetapi juga menilai dengan berkesan keupayaan model bahasa besar (LLM), terutamanya keupayaan untuk memahami dan menaakul tentang pengetahuan saintifik. Walaupun pada masa ini terdapat banyak set data QA saintifik yang meliputi bidang perubatan, kimia, biologi dan bidang lain, set data ini masih mempunyai beberapa kekurangan. Pertama, borang data adalah agak mudah, kebanyakannya adalah soalan aneka pilihan. Ia mudah dinilai, tetapi mengehadkan julat pemilihan jawapan model dan tidak dapat menguji sepenuhnya keupayaan model untuk menjawab soalan saintifik. Sebaliknya, Soal Jawab terbuka

Prestasi SOTA, kaedah AI ramalan pertalian protein-ligan pelbagai mod Xiamen, menggabungkan maklumat permukaan molekul buat kali pertama

Jul 17, 2024 pm 06:37 PM

Prestasi SOTA, kaedah AI ramalan pertalian protein-ligan pelbagai mod Xiamen, menggabungkan maklumat permukaan molekul buat kali pertama

Jul 17, 2024 pm 06:37 PM

Editor |. KX Dalam bidang penyelidikan dan pembangunan ubat, meramalkan pertalian pengikatan protein dan ligan dengan tepat dan berkesan adalah penting untuk pemeriksaan dan pengoptimuman ubat. Walau bagaimanapun, kajian semasa tidak mengambil kira peranan penting maklumat permukaan molekul dalam interaksi protein-ligan. Berdasarkan ini, penyelidik dari Universiti Xiamen mencadangkan rangka kerja pengekstrakan ciri berbilang mod (MFE) novel, yang buat pertama kalinya menggabungkan maklumat mengenai permukaan protein, struktur dan jujukan 3D, dan menggunakan mekanisme perhatian silang untuk membandingkan ciri modaliti yang berbeza penjajaran. Keputusan eksperimen menunjukkan bahawa kaedah ini mencapai prestasi terkini dalam meramalkan pertalian mengikat protein-ligan. Tambahan pula, kajian ablasi menunjukkan keberkesanan dan keperluan maklumat permukaan protein dan penjajaran ciri multimodal dalam rangka kerja ini. Penyelidikan berkaitan bermula dengan "S

SK Hynix akan memaparkan produk berkaitan AI baharu pada 6 Ogos: HBM3E 12 lapisan, NAND 321 tinggi, dsb.

Aug 01, 2024 pm 09:40 PM

SK Hynix akan memaparkan produk berkaitan AI baharu pada 6 Ogos: HBM3E 12 lapisan, NAND 321 tinggi, dsb.

Aug 01, 2024 pm 09:40 PM

Menurut berita dari laman web ini pada 1 Ogos, SK Hynix mengeluarkan catatan blog hari ini (1 Ogos), mengumumkan bahawa ia akan menghadiri Global Semiconductor Memory Summit FMS2024 yang akan diadakan di Santa Clara, California, Amerika Syarikat dari 6 hingga 8 Ogos, mempamerkan banyak produk penjanaan teknologi baru. Pengenalan kepada Sidang Kemuncak Memori dan Penyimpanan Masa Depan (FutureMemoryandStorage), dahulunya Sidang Kemuncak Memori Flash (FlashMemorySummit) terutamanya untuk pembekal NAND, dalam konteks peningkatan perhatian kepada teknologi kecerdasan buatan, tahun ini dinamakan semula sebagai Sidang Kemuncak Memori dan Penyimpanan Masa Depan (FutureMemoryandStorage) kepada jemput vendor DRAM dan storan serta ramai lagi pemain. Produk baharu SK hynix dilancarkan tahun lepas