Model pembahagian video dari Universiti Sains dan Teknologi Selatan ini boleh menjejaki apa sahaja dalam video.

Bukan sahaja boleh "menonton", tetapi ia juga boleh "memotong". Ia juga mudah untuk mengeluarkan individu daripada video.

Dari segi operasi, satu-satunya perkara yang anda perlu lakukan ialah beberapa klik tetikus.

Artis kesan khas itu nampaknya telah menemui penyelamat selepas melihat berita itu, dengan terus terang mengatakan bahawa produk ini akan mengubah peraturan permainan dalam industri CGI.

Model ini dipanggil TAM (Track Anything Model Adakah ia serupa dengan nama model pembahagian imej Meta SAM?

Sesungguhnya, TAM memanjangkan SAM ke medan video, menerangi pepohon kemahiran penjejakan objek dinamik.

Model segmentasi video sebenarnya bukanlah teknologi baharu, tetapi model segmentasi tradisional tidak meringankan kerja manusia.

Data latihan yang digunakan oleh model ini semuanya memerlukan anotasi manual, malah perlu dimulakan dengan parameter topeng objek tertentu sebelum digunakan.

Kemunculan SAM menyediakan prasyarat untuk menyelesaikan masalah ini - sekurang-kurangnya data permulaan tidak lagi memerlukan pemerolehan manual.

Sudah tentu, TAM tidak menggunakan bingkai demi bingkai SAM dan kemudian menindihnya Hubungan spatio-temporal yang sepadan juga perlu dibina.

Pasukan menyepadukan SAM dengan modul memori yang dipanggil XMem.

Anda hanya perlu menggunakan SAM untuk menjana parameter awal dalam bingkai pertama, dan XMem boleh membimbing proses penjejakan seterusnya.

Terdapat banyak sasaran untuk dijejaki, seperti Festival Qingming Sepanjang Sungai:

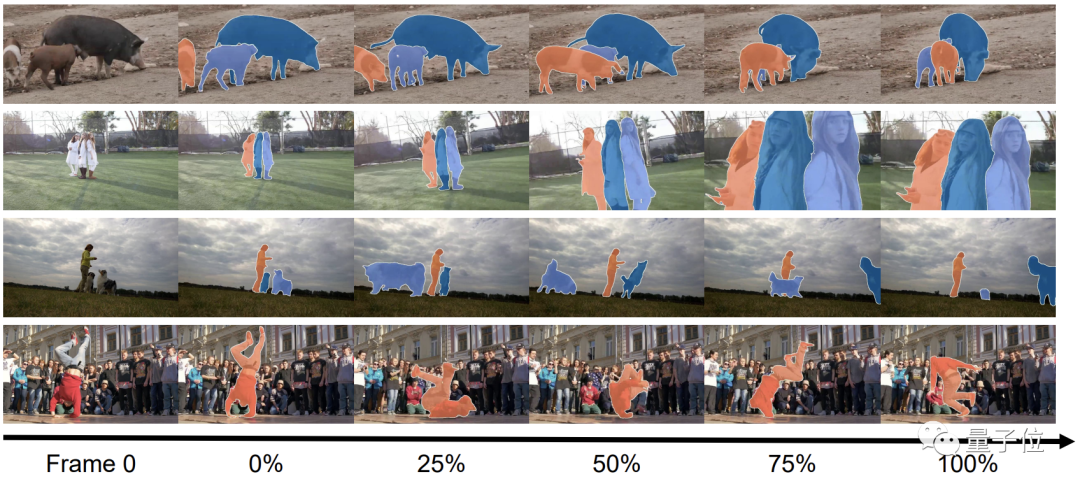

Walaupun adegan berubah, ia tidak akan menjejaskan prestasi daripada TAM:

Kami mengalaminya dan mendapati TAM menggunakan antara muka pengguna interaktif, yang sangat mudah dan mesra untuk dikendalikan.

Dari segi kuasa keras, kesan penjejakan TAM memang bagus:

Namun, ketepatan fungsi penyingkiran dalam beberapa butiran perlu dipertingkatkan.

Seperti yang dinyatakan di atas, TAM adalah berdasarkan SAM dan menggabungkan keupayaan ingatan untuk mewujudkan persatuan spatio-temporal .

Secara khusus, langkah pertama adalah untuk memulakan model dengan bantuan keupayaan pembahagian imej statik SAM.

Dengan hanya satu klik, SAM boleh menjana parameter topeng awal objek sasaran, menggantikan proses permulaan kompleks dalam model segmentasi tradisional.

Dengan parameter awal, pasukan boleh menyerahkannya kepada XMem untuk latihan intervensi separa manual, sekali gus mengurangkan beban kerja manusia.

Semasa proses ini, beberapa hasil ramalan manual akan digunakan untuk membandingkan dengan output XMem.

Dalam proses sebenar, seiring dengan berlalunya masa, ia menjadi semakin sukar untuk XMem untuk mendapatkan hasil segmentasi yang tepat.

Apabila perbezaan antara keputusan dan jangkaan terlalu besar, langkah pembahagian semula akan dimasukkan, dan langkah ini masih diselesaikan oleh SAM.

Selepas pengoptimuman semula SAM, kebanyakan hasil keluaran adalah agak tepat, tetapi sesetengahnya masih memerlukan pelarasan manual.

Proses latihan TAM adalah lebih kurang seperti ini, dan kemahiran penyingkiran objek yang dinyatakan pada permulaan dibentuk dengan menggabungkan TAM dengan E2FGVI.

E2FGVI sendiri juga merupakan alat penghapusan elemen video Dengan sokongan pembahagian tepat TAM, kerjanya lebih disasarkan.

Untuk menguji TAM, pasukan menilainya menggunakan set data DAVIS-16 dan DAVIS-17.

Perasaan intuitif masih sangat baik, dan ia sememangnya benar daripada data.

Walaupun TAM tidak memerlukan tetapan manual parameter topeng, dua penunjuk J (persamaan serantau) dan F (ketepatan sempadan) adalah sangat hampir dengan model manual.

Malah prestasi pada set data DAVIS-2017 adalah lebih baik sedikit daripada STM.

Antara kaedah permulaan lain, prestasi SiamMask tidak boleh dibandingkan dengan TAM sama sekali;

Walaupun kaedah lain yang dipanggil MiVOS berprestasi lebih baik daripada TAM, ia telah berkembang selama 8 pusingan...

TAM adalah daripada Makmal Kecerdasan Visual dan Persepsi (VIP) Universiti Sains dan Teknologi Selatan.

Arahan penyelidikan makmal ini termasuk pembelajaran berbilang model teks-imej-bunyi, persepsi berbilang model, pembelajaran pengukuhan dan pengesanan kecacatan visual.

Pada masa ini, pasukan telah menerbitkan lebih daripada 30 kertas kerja dan memperoleh 5 paten.

Ketua pasukan ialah Profesor Madya Zheng Feng dari Universiti Sains dan Teknologi Selatan Beliau berkelulusan kedoktoran dari Universiti Sheffield di UK. Beliau telah bekerja untuk Institut Pengajian Lanjutan Akademi Cina Sains, Tencent Youtu dan institusi lain Beliau memasuki Universiti Sains dan Teknologi Selatan pada 2018 dan dinaikkan pangkat sebagai Profesor Madya.

Alamat kertas:

https://arxiv.org/abs/2304.11968

Halaman GitHub:

https://github.com/gaomingqi/Track-Anything

Pautan rujukan:

https://twitter.com/bilawalsidhu/status/1650710123399233536 ?s=20

Atas ialah kandungan terperinci Teknologi Hitam Sains dan Teknologi Selatan: Hapuskan watak video dengan satu klik, penyelamat artis kesan khas ada di sini!. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Apa yang perlu dilakukan dengan kad video

Apa yang perlu dilakukan dengan kad video

Bagaimana untuk memuat turun video dari Douyin

Bagaimana untuk memuat turun video dari Douyin

Kedudukan sepuluh pertukaran mata wang digital teratas

Kedudukan sepuluh pertukaran mata wang digital teratas

Bagaimana untuk menaikkan seorang ahli bomba kecil pada Douyin

Bagaimana untuk menaikkan seorang ahli bomba kecil pada Douyin

pengaturcaraan berbilang benang java

pengaturcaraan berbilang benang java

Apakah kaedah analisis data?

Apakah kaedah analisis data?

Bagaimana untuk membuka kunci sekatan kebenaran android

Bagaimana untuk membuka kunci sekatan kebenaran android

Perbezaan antara rawak dan pseudo-rawak

Perbezaan antara rawak dan pseudo-rawak