pembangunan bahagian belakang

pembangunan bahagian belakang

Tutorial Python

Tutorial Python

Bagaimana untuk melaksanakan algoritma klasifikasi pokok keputusan dalam python

Bagaimana untuk melaksanakan algoritma klasifikasi pokok keputusan dalam python

Bagaimana untuk melaksanakan algoritma klasifikasi pokok keputusan dalam python

Pra-maklumat

1. Pokok keputusan

Ayat yang ditulis semula: Dalam pembelajaran diselia, algoritma pengelasan yang biasa digunakan ialah pepohon keputusan, yang berdasarkan kumpulan sampel, setiap sampel mengandungi set atribut dan hasil pengelasan yang sepadan. Menggunakan sampel ini untuk pembelajaran, algoritma boleh menghasilkan pepohon keputusan yang boleh mengklasifikasikan data baharu dengan betul

2. Data sampel

Andaikan terdapat 14 pengguna sedia ada, dan atribut peribadi mereka Data pada sama ada untuk membeli produk tertentu adalah seperti berikut:

| 编号 | 年龄 | 收入范围 | 工作性质 | 信用评级 | 购买决策 |

|---|---|---|---|---|---|

| 01 | 高 | 不稳定 | 较差 | 否 | |

| 02 | 高 | 不稳定 | 好 | 否 | |

| 03 | 30-40 | 高 | 不稳定 | 较差 | 是 |

| 04 | >40 | 中等 | 不稳定 | 较差 | 是 |

| 05 | >40 | 低 | 稳定 | 较差 | 是 |

| 06 | >40 | 低 | 稳定 | 好 | 否 |

| 07 | 30-40 | 低 | 稳定 | 好 | 是 |

| 08 | 中等 | 不稳定 | 较差 | 否 | |

| 09 | 低 | 稳定 | 较差 | 是 | |

| 10 | >40 | 中等 | 稳定 | 较差 | 是 |

| 11 | 中等 | 稳定 | 好 | 是 | |

| 12 | 30-40 | 中等 | 不稳定 | 好 | 是 |

| 13 | 30-40 | 高 | 稳定 | 较差 | 是 |

| 14 | >40 | 中等 | 不稳定 | 好 | 否 |

Algoritma pengelasan pokok tertentu

1 Bina set data

Untuk memudahkan pemprosesan, data simulasi ditukar kepada data senarai berangka mengikut peraturan berikut:

Umur: < ;30 diberikan nilai 0; 30-40 diberikan nilai 1; ialah 2

Sifat kerja: tidak stabil 0; stabil ialah 1

Penilaian kredit: buruk ialah 0; baik ialah 1

#创建数据集

def createdataset():

dataSet=[[0,2,0,0,'N'],

[0,2,0,1,'N'],

[1,2,0,0,'Y'],

[2,1,0,0,'Y'],

[2,0,1,0,'Y'],

[2,0,1,1,'N'],

[1,0,1,1,'Y'],

[0,1,0,0,'N'],

[0,0,1,0,'Y'],

[2,1,1,0,'Y'],

[0,1,1,1,'Y'],

[1,1,0,1,'Y'],

[1,2,1,0,'Y'],

[2,1,0,1,'N'],]

labels=['age','income','job','credit']

return dataSet,labelsPanggil fungsi untuk mendapatkan data:

ds1,lab = createdataset() print(ds1) print(lab)

[‘umur’, ‘pendapatan’, ‘pekerjaan’, ‘kredit’]2. Entropi maklumat set data

Entropi maklumat, juga dikenali sebagai entropi Shannon, ialah jangkaan pembolehubah rawak. Mengukur tahap ketidakpastian maklumat. Semakin besar entropi maklumat, semakin sukar untuk mengetahui maklumat tersebut. Memproses maklumat adalah untuk menjelaskan maklumat, iaitu proses pengurangan entropi.

def calcShannonEnt(dataSet):

numEntries = len(dataSet)

labelCounts = {}

for featVec in dataSet:

currentLabel = featVec[-1]

if currentLabel not in labelCounts.keys():

labelCounts[currentLabel] = 0

labelCounts[currentLabel] += 1

shannonEnt = 0.0

for key in labelCounts:

prob = float(labelCounts[key])/numEntries

shannonEnt -= prob*log(prob,2)

return shannonEntContoh entropi maklumat data:

shan = calcShannonEnt(ds1) print(shan)

3 Kurangkan sumbangan set sampel X entropi. Lebih besar perolehan maklumat, lebih sesuai untuk mengelaskan X.

def chooseBestFeatureToSplit(dataSet):

numFeatures = len(dataSet[0])-1

baseEntropy = calcShannonEnt(dataSet)

bestInfoGain = 0.0;bestFeature = -1

for i in range(numFeatures):

featList = [example[i] for example in dataSet]

uniqueVals = set(featList)

newEntroy = 0.0

for value in uniqueVals:

subDataSet = splitDataSet(dataSet, i, value)

prop = len(subDataSet)/float(len(dataSet))

newEntroy += prop * calcShannonEnt(subDataSet)

infoGain = baseEntropy - newEntroy

if(infoGain > bestInfoGain):

bestInfoGain = infoGain

bestFeature = i

return bestFeatureKod di atas melaksanakan algoritma pembelajaran pokok keputusan ID3 berdasarkan perolehan entropi maklumat. Prinsip logik terasnya ialah: pilih setiap atribut dalam set atribut secara bergilir-gilir, dan bahagikan set sampel kepada beberapa subset mengikut nilai atribut ini, hitung entropi maklumat bagi subset ini, dan perbezaan antaranya dan entropi maklumat; sampel ialah Keuntungan entropi maklumat bagi pembahagian oleh atribut ini, cari atribut yang sepadan dengan keuntungan terbesar antara semua keuntungan, yang merupakan atribut yang digunakan untuk membahagikan set sampel.

Kira atribut sampel pecahan terbaik bagi sampel, dan hasilnya dipaparkan dalam lajur 0, iaitu atribut umur:

col = chooseBestFeatureToSplit(ds1) col

4. Keputusan pembinaan Fungsi pokokdigunakan untuk mengendalikan situasi berikut: apabila pokok keputusan ideal akhir harus mencapai bahagian bawah di sepanjang cawangan keputusan, semua sampel harus mempunyai hasil pengelasan yang sama. Walau bagaimanapun, dalam sampel sebenar, tidak dapat dielakkan bahawa semua atribut adalah konsisten tetapi keputusan pengelasan adalah berbeza Dalam kes ini,def majorityCnt(classList): classCount = {} for vote in classList: if vote not in classCount.keys():classCount[vote] = 0 classCount[vote] += 1 sortedClassCount = sorted(classList.iteritems(),key=operator.itemgetter(1),reverse=True)#利用operator操作键值排序字典 return sortedClassCount[0][0] #创建树的函数 def createTree(dataSet,labels): classList = [example[-1] for example in dataSet] if classList.count(classList[0]) == len(classList): return classList[0] if len(dataSet[0]) == 1: return majorityCnt(classList) bestFeat = chooseBestFeatureToSplit(dataSet) bestFeatLabel = labels[bestFeat] myTree = {bestFeatLabel:{}} del(labels[bestFeat]) featValues = [example[bestFeat] for example in dataSet] uniqueVals = set(featValues) for value in uniqueVals: subLabels = labels[:] myTree[bestFeatLabel][value] = createTree(splitDataSet(dataSet, bestFeat, value), subLabels) return myTreeSalin selepas log masuk

melaraskan label pengelasan sampel tersebut kepada hasil pengelasan dengan kejadian yang paling banyak.

majorityCnt ialah fungsi tugas teras, yang secara berurutan memanggil algoritma perolehan entropi maklumat ID3 untuk pemprosesan pengiraan pada semua atribut, dan akhirnya menghasilkan pepohon keputusan. majorityCnt

createTreeBina pepohon keputusan menggunakan data sampel:

Tree = createTree(ds1, lab)

print("样本数据决策树:")

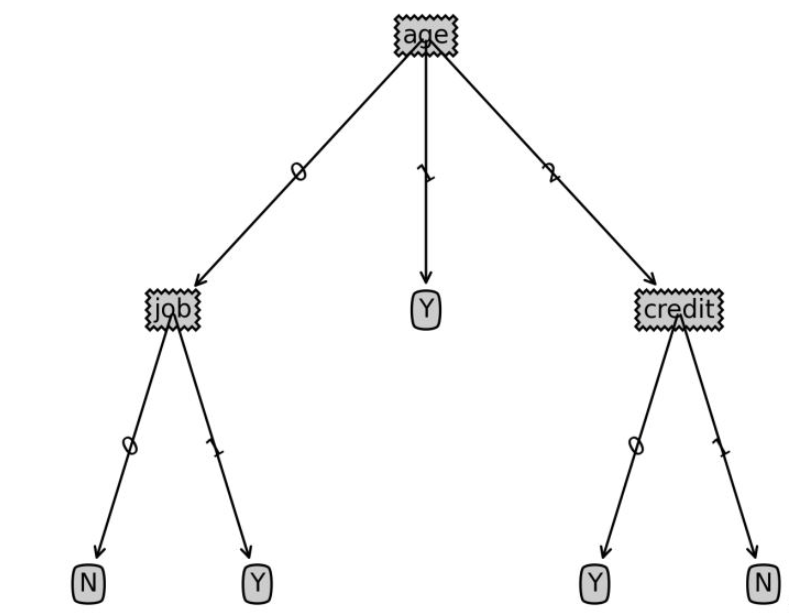

print(Tree){‘umur&rsquo ;: {0: {‘pekerjaan’: {0: ‘N’, 1: ‘Y’}},

1: ‘Y’,2: {‘kredit’: { 0: ‘Y’, 1: ‘N’}}}}6 Pengkelasan sampel ujian

Berikan pengguna baharu Maklumat untuk menentukan sama ada dia akan membeli produk tertentu:

Berikan pengguna baharu Maklumat untuk menentukan sama ada dia akan membeli produk tertentu:

def classify(inputtree,featlabels,testvec):

firststr = list(inputtree.keys())[0]

seconddict = inputtree[firststr]

featindex = featlabels.index(firststr)

for key in seconddict.keys():

if testvec[featindex]==key:

if type(seconddict[key]).__name__=='dict':

classlabel=classify(seconddict[key],featlabels,testvec)

else:

classlabel=seconddict[key]

return classlabelSalin selepas log masuklabels=['age','income','job','credit']

tsvec=[0,0,1,1]

print('result:',classify(Tree,labels,tsvec))

tsvec1=[0,2,0,1]

print('result1:',classify(Tree,labels,tsvec1))

Salin selepas log masuk

def classify(inputtree,featlabels,testvec):

firststr = list(inputtree.keys())[0]

seconddict = inputtree[firststr]

featindex = featlabels.index(firststr)

for key in seconddict.keys():

if testvec[featindex]==key:

if type(seconddict[key]).__name__=='dict':

classlabel=classify(seconddict[key],featlabels,testvec)

else:

classlabel=seconddict[key]

return classlabellabels=['age','income','job','credit'] tsvec=[0,0,1,1] print('result:',classify(Tree,labels,tsvec)) tsvec1=[0,2,0,1] print('result1:',classify(Tree,labels,tsvec1))

hasil: Y

hasil1: N| 年龄 | 收入范围 | 工作性质 | 信用评级 |

|---|---|---|---|

| <30 | 低 | 稳定 | 好 |

| <30 | 高 | 不稳定 | 好 |

Maklumat siaran: melukis pokok keputusan kod

Kod berikut digunakan untuk melukis grafik pepohon keputusan, bukan fokus algoritma pepohon keputusan Jika anda berminat, anda boleh merujuknya untuk mempelajari

import matplotlib.pyplot as plt

decisionNode = dict(box, fc="0.8")

leafNode = dict(box, fc="0.8")

arrow_args = dict(arrow)

#获取叶节点的数目

def getNumLeafs(myTree):

numLeafs = 0

firstStr = list(myTree.keys())[0]

secondDict = myTree[firstStr]

for key in secondDict.keys():

if type(secondDict[key]).__name__=='dict':#测试节点的数据是否为字典,以此判断是否为叶节点

numLeafs += getNumLeafs(secondDict[key])

else: numLeafs +=1

return numLeafs

#获取树的层数

def getTreeDepth(myTree):

maxDepth = 0

firstStr = list(myTree.keys())[0]

secondDict = myTree[firstStr]

for key in secondDict.keys():

if type(secondDict[key]).__name__=='dict':#测试节点的数据是否为字典,以此判断是否为叶节点

thisDepth = 1 + getTreeDepth(secondDict[key])

else: thisDepth = 1

if thisDepth > maxDepth: maxDepth = thisDepth

return maxDepth

#绘制节点

def plotNode(nodeTxt, centerPt, parentPt, nodeType):

createPlot.ax1.annotate(nodeTxt, xy=parentPt, xycoords='axes fraction',

xytext=centerPt, textcoords='axes fraction',

va="center", ha="center", bbox=nodeType, arrowprops=arrow_args )

#绘制连接线

def plotMidText(cntrPt, parentPt, txtString):

xMid = (parentPt[0]-cntrPt[0])/2.0 + cntrPt[0]

yMid = (parentPt[1]-cntrPt[1])/2.0 + cntrPt[1]

createPlot.ax1.text(xMid, yMid, txtString, va="center", ha="center", rotation=30)

#绘制树结构

def plotTree(myTree, parentPt, nodeTxt):#if the first key tells you what feat was split on

numLeafs = getNumLeafs(myTree) #this determines the x width of this tree

depth = getTreeDepth(myTree)

firstStr = list(myTree.keys())[0] #the text label for this node should be this

cntrPt = (plotTree.xOff + (1.0 + float(numLeafs))/2.0/plotTree.totalW, plotTree.yOff)

plotMidText(cntrPt, parentPt, nodeTxt)

plotNode(firstStr, cntrPt, parentPt, decisionNode)

secondDict = myTree[firstStr]

plotTree.yOff = plotTree.yOff - 1.0/plotTree.totalD

for key in secondDict.keys():

if type(secondDict[key]).__name__=='dict':#test to see if the nodes are dictonaires, if not they are leaf nodes

plotTree(secondDict[key],cntrPt,str(key)) #recursion

else: #it's a leaf node print the leaf node

plotTree.xOff = plotTree.xOff + 1.0/plotTree.totalW

plotNode(secondDict[key], (plotTree.xOff, plotTree.yOff), cntrPt, leafNode)

plotMidText((plotTree.xOff, plotTree.yOff), cntrPt, str(key))

plotTree.yOff = plotTree.yOff + 1.0/plotTree.totalD

#创建决策树图形

def createPlot(inTree):

fig = plt.figure(1, facecolor='white')

fig.clf()

axprops = dict(xticks=[], yticks=[])

createPlot.ax1 = plt.subplot(111, frameon=False, **axprops) #no ticks

#createPlot.ax1 = plt.subplot(111, frameon=False) #ticks for demo puropses

plotTree.totalW = float(getNumLeafs(inTree))

plotTree.totalD = float(getTreeDepth(inTree))

plotTree.xOff = -0.5/plotTree.totalW; plotTree.yOff = 1.0;

plotTree(inTree, (0.5,1.0), '')

plt.savefig('决策树.png',dpi=300,bbox_inches='tight')

plt.show()Atas ialah kandungan terperinci Bagaimana untuk melaksanakan algoritma klasifikasi pokok keputusan dalam python. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1369

1369

52

52

Apakah fungsi jumlah bahasa C?

Apr 03, 2025 pm 02:21 PM

Apakah fungsi jumlah bahasa C?

Apr 03, 2025 pm 02:21 PM

Tiada fungsi jumlah terbina dalam dalam bahasa C, jadi ia perlu ditulis sendiri. Jumlah boleh dicapai dengan melintasi unsur -unsur array dan terkumpul: Versi gelung: SUM dikira menggunakan panjang gelung dan panjang. Versi Pointer: Gunakan petunjuk untuk menunjuk kepada unsur-unsur array, dan penjumlahan yang cekap dicapai melalui penunjuk diri sendiri. Secara dinamik memperuntukkan versi Array: Perlawanan secara dinamik dan uruskan memori sendiri, memastikan memori yang diperuntukkan dibebaskan untuk mengelakkan kebocoran ingatan.

Adakah distinctidistinguish berkaitan?

Apr 03, 2025 pm 10:30 PM

Adakah distinctidistinguish berkaitan?

Apr 03, 2025 pm 10:30 PM

Walaupun berbeza dan berbeza berkaitan dengan perbezaan, ia digunakan secara berbeza: berbeza (kata sifat) menggambarkan keunikan perkara itu sendiri dan digunakan untuk menekankan perbezaan antara perkara; Berbeza (kata kerja) mewakili tingkah laku atau keupayaan perbezaan, dan digunakan untuk menggambarkan proses diskriminasi. Dalam pengaturcaraan, berbeza sering digunakan untuk mewakili keunikan unsur -unsur dalam koleksi, seperti operasi deduplikasi; Berbeza dicerminkan dalam reka bentuk algoritma atau fungsi, seperti membezakan ganjil dan bahkan nombor. Apabila mengoptimumkan, operasi yang berbeza harus memilih algoritma dan struktur data yang sesuai, sementara operasi yang berbeza harus mengoptimumkan perbezaan antara kecekapan logik dan memberi perhatian untuk menulis kod yang jelas dan mudah dibaca.

Siapa yang dibayar lebih banyak Python atau JavaScript?

Apr 04, 2025 am 12:09 AM

Siapa yang dibayar lebih banyak Python atau JavaScript?

Apr 04, 2025 am 12:09 AM

Tidak ada gaji mutlak untuk pemaju Python dan JavaScript, bergantung kepada kemahiran dan keperluan industri. 1. Python boleh dibayar lebih banyak dalam sains data dan pembelajaran mesin. 2. JavaScript mempunyai permintaan yang besar dalam perkembangan depan dan stack penuh, dan gajinya juga cukup besar. 3. Faktor mempengaruhi termasuk pengalaman, lokasi geografi, saiz syarikat dan kemahiran khusus.

Bagaimana memahami! X dalam c?

Apr 03, 2025 pm 02:33 PM

Bagaimana memahami! X dalam c?

Apr 03, 2025 pm 02:33 PM

! X Memahami! X adalah bukan operator logik dalam bahasa C. Ia booleans nilai x, iaitu, perubahan benar kepada perubahan palsu, palsu kepada benar. Tetapi sedar bahawa kebenaran dan kepalsuan dalam C diwakili oleh nilai berangka dan bukannya jenis Boolean, bukan sifar dianggap sebagai benar, dan hanya 0 dianggap sebagai palsu. Oleh itu ,! X memperkatakan nombor negatif sama seperti nombor positif dan dianggap benar.

Apakah jumlah maksud dalam bahasa C?

Apr 03, 2025 pm 02:36 PM

Apakah jumlah maksud dalam bahasa C?

Apr 03, 2025 pm 02:36 PM

Tiada fungsi jumlah terbina dalam dalam C untuk jumlah, tetapi ia boleh dilaksanakan dengan: menggunakan gelung untuk mengumpul unsur-unsur satu demi satu; menggunakan penunjuk untuk mengakses dan mengumpul unsur -unsur satu demi satu; Untuk jumlah data yang besar, pertimbangkan pengiraan selari.

Adakah pengeluaran halaman H5 memerlukan penyelenggaraan berterusan?

Apr 05, 2025 pm 11:27 PM

Adakah pengeluaran halaman H5 memerlukan penyelenggaraan berterusan?

Apr 05, 2025 pm 11:27 PM

Halaman H5 perlu dikekalkan secara berterusan, kerana faktor -faktor seperti kelemahan kod, keserasian pelayar, pengoptimuman prestasi, kemas kini keselamatan dan peningkatan pengalaman pengguna. Kaedah penyelenggaraan yang berkesan termasuk mewujudkan sistem ujian lengkap, menggunakan alat kawalan versi, kerap memantau prestasi halaman, mengumpul maklum balas pengguna dan merumuskan pelan penyelenggaraan.

Bagaimana untuk mendapatkan data aplikasi masa nyata dan data penonton di halaman kerja 58.com?

Apr 05, 2025 am 08:06 AM

Bagaimana untuk mendapatkan data aplikasi masa nyata dan data penonton di halaman kerja 58.com?

Apr 05, 2025 am 08:06 AM

Bagaimana untuk mendapatkan data dinamik 58.com halaman kerja semasa merangkak? Semasa merangkak halaman kerja 58.com menggunakan alat crawler, anda mungkin menghadapi ...

Salin dan tampal kod cinta salinan dan tampal kod cinta secara percuma

Apr 04, 2025 am 06:48 AM

Salin dan tampal kod cinta salinan dan tampal kod cinta secara percuma

Apr 04, 2025 am 06:48 AM

Menyalin dan menampal kod itu tidak mustahil, tetapi ia harus dirawat dengan berhati -hati. Ketergantungan seperti persekitaran, perpustakaan, versi, dan lain -lain dalam kod mungkin tidak sepadan dengan projek semasa, mengakibatkan kesilapan atau hasil yang tidak dapat diramalkan. Pastikan untuk memastikan konteksnya konsisten, termasuk laluan fail, perpustakaan bergantung, dan versi Python. Di samping itu, apabila menyalin dan menampal kod untuk perpustakaan tertentu, anda mungkin perlu memasang perpustakaan dan kebergantungannya. Kesalahan biasa termasuk kesilapan laluan, konflik versi, dan gaya kod yang tidak konsisten. Pengoptimuman prestasi perlu direka semula atau direkodkan mengikut tujuan asal dan kekangan Kod. Adalah penting untuk memahami dan debug kod yang disalin, dan jangan menyalin dan tampal secara membuta tuli.