Peranti teknologi

Peranti teknologi

AI

AI

Inferens LLM adalah 3 kali lebih cepat! Microsoft mengeluarkan LLM Accelerator: menggunakan teks rujukan untuk mencapai pecutan tanpa kerugian

Inferens LLM adalah 3 kali lebih cepat! Microsoft mengeluarkan LLM Accelerator: menggunakan teks rujukan untuk mencapai pecutan tanpa kerugian

Inferens LLM adalah 3 kali lebih cepat! Microsoft mengeluarkan LLM Accelerator: menggunakan teks rujukan untuk mencapai pecutan tanpa kerugian

Dengan perkembangan pesat teknologi kecerdasan buatan, produk dan teknologi baharu seperti ChatGPT, New Bing dan GPT-4 telah dikeluarkan satu demi satu model besar Asas akan memainkan peranan yang semakin penting dalam banyak aplikasi.

Kebanyakan model bahasa besar semasa ialah model autoregresif. Autoregression bermaksud model sering menggunakan output perkataan demi perkataan semasa mengeluarkan, iaitu apabila mengeluarkan setiap perkataan, model perlu menggunakan perkataan output sebelum ini sebagai input. Mod autoregresif ini biasanya mengehadkan penggunaan penuh pemecut selari semasa output.

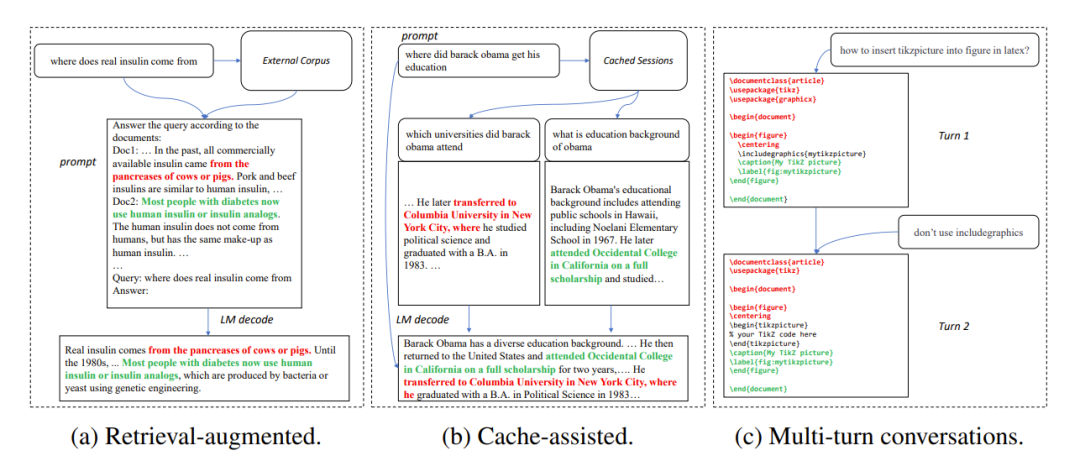

Dalam banyak senario aplikasi, output model besar selalunya sangat serupa dengan beberapa teks rujukan, seperti dalam tiga senario biasa berikut:

1. Mendapatkan semula generasi dipertingkatkan

Apabila aplikasi mendapatkan semula seperti New Bing bertindak balas kepada input pengguna, mereka akan mengembalikan beberapa maklumat yang berkaitan dengan input pengguna Maklumat yang berkaitan kemudian digunakan untuk meringkaskan maklumat yang diambil menggunakan model bahasa, dan kemudian menjawab input pengguna. Dalam senario ini, output model selalunya mengandungi sejumlah besar serpihan teks daripada hasil carian.

2. Gunakan penjanaan cache

Dalam proses penggunaan model bahasa secara besar-besaran, input sejarah dan kehendak output dicache. Apabila memproses input baharu, aplikasi mendapatkan semula mencari input yang serupa dalam cache. Oleh itu, output model selalunya hampir sama dengan output yang sepadan dalam cache.

3. Penjanaan dalam perbualan berbilang pusingan

Apabila menggunakan aplikasi seperti ChatGPT, pengguna cenderung menggunakan model berdasarkan Keluaran berulang kali meminta pengubahsuaian. Dalam senario dialog berbilang pusingan ini, keluaran berbilang model selalunya hanya mempunyai sedikit perubahan dan tahap pengulangan yang tinggi.

Rajah 1: Senario biasa di mana output model besar adalah serupa dengan teks rujukan

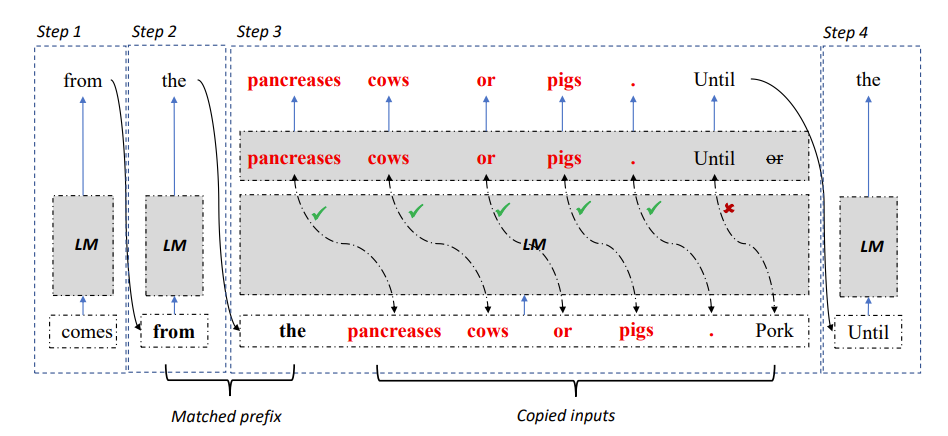

Berdasarkan pemerhatian di atas, penyelidik menggunakan kebolehulangan teks rujukan dan output model sebagai fokus untuk menembusi kesesakan autoregresif, dengan harapan dapat meningkatkan penggunaan pemecut selari, mempercepatkan inferens model bahasa yang besar, dan kemudian Kaedah LLM Accelerator dicadangkan yang menggunakan pengulangan output dan teks rujukan untuk mengeluarkan berbilang perkataan dalam satu langkah.

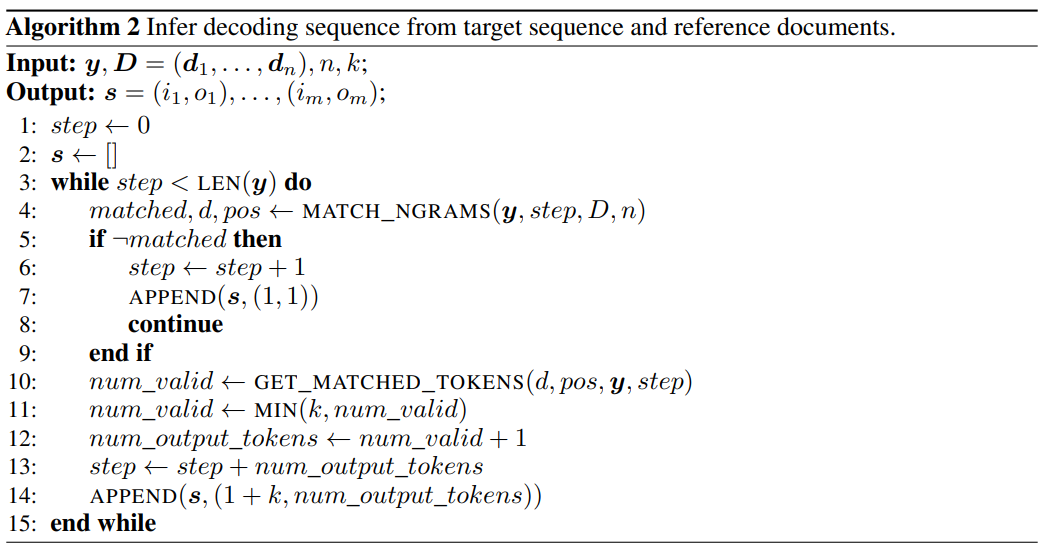

Rajah 2: Algoritma penyahkodan LLM Accelerator

Khususnya, pada setiap langkah penyahkodan, biarkan model memadankan hasil output sedia ada dengan teks rujukan jika teks rujukan didapati konsisten dengan output sedia ada, maka model mungkin akan menangguhkan teks rujukan sedia ada dan meneruskan. kepada output.

Oleh itu, penyelidik menambah perkataan seterusnya bagi teks rujukan sebagai input kepada model, supaya satu langkah penyahkodan boleh mengeluarkan berbilang perkataan.

Untuk memastikan input dan output adalah tepat, penyelidik membandingkan lagi perkataan output oleh model dengan perkataan input daripada dokumen rujukan. Jika kedua-duanya tidak konsisten, hasil input dan output yang salah akan dibuang.

Kaedah di atas boleh memastikan bahawa hasil penyahkodan adalah konsisten sepenuhnya dengan kaedah garis dasar, dan boleh meningkatkan bilangan perkataan keluaran dalam setiap langkah penyahkodan, dengan itu mencapai pecutan tanpa kehilangan inferens model besar .

LLM Accelerator tidak memerlukan model tambahan tambahan, mudah digunakan dan boleh digunakan dengan mudah dalam pelbagai senario aplikasi.

Pautan kertas: https://arxiv.org/pdf/2304.04487.pdf

Projek Pautan: https://github.com/microsoft/LMOps

Menggunakan LLM Accelerator, terdapat dua hiperparameter yang perlu dilaraskan.

Pertama, bilangan perkataan yang sepadan antara output yang diperlukan untuk mencetuskan mekanisme pemadanan dan teks rujukan: semakin lama bilangan perkataan yang sepadan, semakin tepat ia, yang dapat memastikan perkataan disalin daripada teks rujukan adalah output yang betul, mengurangkan ketidaktepatan pencetus dan pengiraan yang diperlukan;

Yang kedua ialah bilangan perkataan yang disalin setiap kali: semakin banyak perkataan yang disalin, semakin besar potensi pecutan, tetapi ia juga boleh menyebabkan lebih banyak keluaran yang salah akan dibuang, yang membazirkan sumber pengkomputeran . Penyelidik telah menemui melalui eksperimen bahawa strategi yang lebih agresif (memadankan pencetus perkataan tunggal, menyalin 15 hingga 20 perkataan pada satu masa) selalunya boleh mencapai nisbah pecutan yang lebih baik.

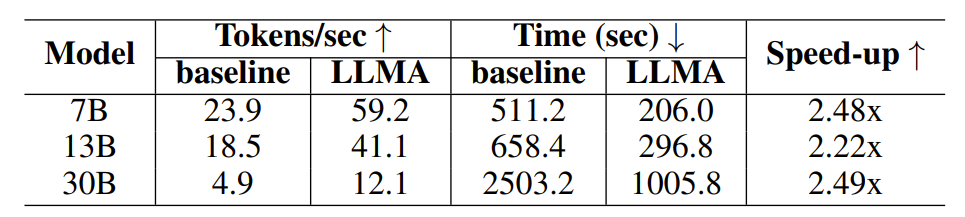

Untuk mengesahkan keberkesanan LLM Accelerator, penyelidik menjalankan eksperimen tentang peningkatan perolehan dan penjanaan bantuan cache, menggunakan set data perolehan perenggan MS-MARCO untuk membina sampel eksperimen.

Dalam percubaan peningkatan perolehan semula, penyelidik menggunakan model perolehan semula untuk mengembalikan 10 dokumen paling berkaitan bagi setiap pertanyaan, dan kemudian menyambungkannya ke dalam pertanyaan sebagai input model, menggunakan ini 10 dokumen sebagai teks Rujukan.

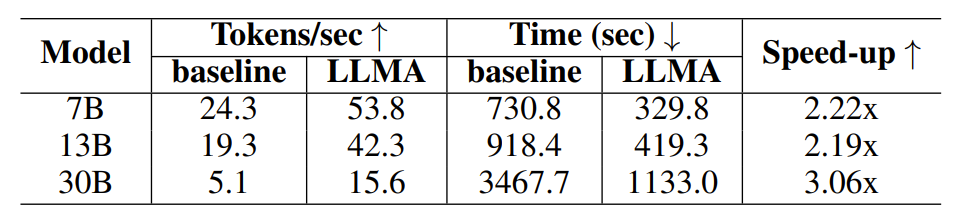

Dalam percubaan penjanaan dibantu cache, setiap pertanyaan menjana empat pertanyaan serupa, dan kemudian menggunakan model untuk mengeluarkan pertanyaan yang sepadan sebagai teks rujukan.

Jadual 1: Perbandingan masa di bawah pengambilan semula senario penjanaan dipertingkat

Jadual 2: Perbandingan masa dalam senario penjanaan menggunakan cache

Para penyelidik menggunakan output model Davinci-003 yang diperoleh melalui antara muka OpenAI sebagai output sasaran untuk mendapatkan output berkualiti tinggi. Selepas mendapat input, output dan teks rujukan yang diperlukan, penyelidik menjalankan eksperimen ke atas model bahasa LLaMA sumber terbuka.

Memandangkan output model LLaMA tidak konsisten dengan keluaran Davinci-003, penyelidik menggunakan kaedah penyahkodan berorientasikan matlamat untuk menguji nisbah kelajuan di bawah output ideal (Davinci-003 hasil model).

Para penyelidik menggunakan Algoritma 2 untuk mendapatkan langkah penyahkodan yang diperlukan untuk menjana output sasaran semasa penyahkodan tamak, dan memaksa model LLaMA untuk menyahkod mengikut langkah penyahkodan yang diperolehi.

Rajah 3: Menggunakan Algoritma 2 untuk mendapatkan langkah penyahkodan yang diperlukan untuk menjana output sasaran semasa penyahkodan tamak

Untuk model dengan saiz parameter 7B dan 13B, penyelidik menjalankan eksperimen pada GPU NVIDIA V100 32G tunggal untuk model dengan saiz parameter 30B, penyelidik menjalankan eksperimen pada empat GPU yang serupa Menjalankan eksperimen pada. Semua eksperimen menggunakan nombor titik terapung separuh ketepatan, penyahkodan ialah penyahkodan tamak, dan saiz kelompok ialah 1.

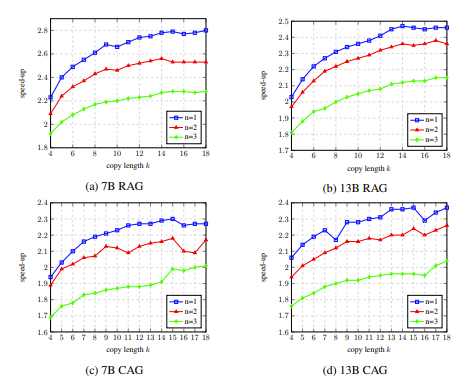

Hasil eksperimen menunjukkan bahawa LLM Accelerator telah mencapai dua hingga tiga kali ganda prestasi dalam saiz model yang berbeza (7B, 13B, 30B) dan senario aplikasi yang berbeza (peningkatan pengambilan semula, bantuan cache) Nisbah kelajuan .

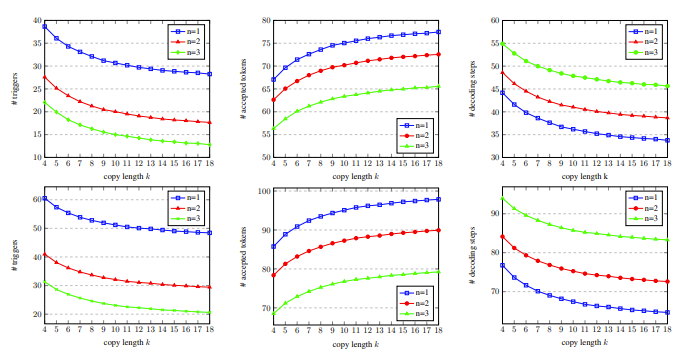

Analisis eksperimen selanjutnya mendapati bahawa LLM Accelerator boleh mengurangkan langkah penyahkodan yang diperlukan dengan ketara, dan nisbah kelajuan dikaitkan secara positif dengan nisbah pengurangan langkah penyahkodan.

Di satu pihak, langkah penyahkodan yang lebih sedikit bermakna setiap langkah penyahkodan menjana lebih banyak perkataan keluaran, yang boleh meningkatkan kecekapan pengiraan pengiraan GPU, sebaliknya, untuk aplikasi yang memerlukan berbilang -keselarian kad Model 30B bermakna penyegerakan berbilang kad yang kurang, menghasilkan peningkatan kelajuan yang lebih pantas.

Dalam eksperimen ablasi, hasil analisis hiperparameter LLM Accelertator pada set pembangunan menunjukkan bahawa apabila memadankan satu perkataan (iaitu, mencetuskan mekanisme penyalinan), 15 hingga 20 disalin pada satu masa Nisbah kelajuan boleh mencapai maksimum apabila menggunakan perkataan (ditunjukkan dalam Rajah 4).

Dalam Rajah 5 kita dapat melihat bahawa bilangan perkataan yang sepadan ialah 1, yang boleh mencetuskan mekanisme penyalinan lebih banyak, dan apabila panjang salinan meningkat, perkataan output yang diterima oleh setiap langkah penyahkodan meningkat, dan langkah penyahkodan menurun, Dengan itu mencapai nisbah pecutan yang lebih tinggi.

Rajah 4: Dalam eksperimen ablasi, keputusan analisis hiperparameter LLM Accelerator pada pembangunan set

Rajah 5: Pada set pembangunan, dengan bilangan perkataan yang sepadan n dan salin perkataan Data statistik langkah penyahkodan k

LLM Accelertator ialah sebahagian daripada siri kerja Microsoft Research Asia Natural Language Computing Group pada pecutan model bahasa besar Pada masa hadapan, penyelidik akan meneruskan isu berkaitan untuk penerokaan yang lebih mendalam.

Atas ialah kandungan terperinci Inferens LLM adalah 3 kali lebih cepat! Microsoft mengeluarkan LLM Accelerator: menggunakan teks rujukan untuk mencapai pecutan tanpa kerugian. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1385

1385

52

52

Alamat masuk versi antarabangsa Microsoft bing (pintu masuk enjin carian bing)

Mar 14, 2024 pm 01:37 PM

Alamat masuk versi antarabangsa Microsoft bing (pintu masuk enjin carian bing)

Mar 14, 2024 pm 01:37 PM

Bing ialah enjin carian dalam talian yang dilancarkan oleh Microsoft Fungsi carian sangat berkuasa dan mempunyai dua pintu masuk: versi domestik dan versi antarabangsa. Di manakah pintu masuk ke dua versi ini? Bagaimana untuk mengakses versi antarabangsa? Mari kita lihat butiran di bawah. Pintu masuk laman web versi Cina Bing: https://cn.bing.com/ Pintu masuk laman web versi antarabangsa Bing: https://global.bing.com/ Bagaimana untuk mengakses versi antarabangsa Bing? 1. Mula-mula masukkan URL untuk membuka Bing: https://www.bing.com/ 2. Anda boleh melihat bahawa terdapat pilihan untuk versi domestik dan antarabangsa Kami hanya perlu memilih versi antarabangsa dan masukkan kata kunci.

Microsoft mengeluarkan kemas kini kumulatif Win11 Ogos: meningkatkan keselamatan, mengoptimumkan skrin kunci, dsb.

Aug 14, 2024 am 10:39 AM

Microsoft mengeluarkan kemas kini kumulatif Win11 Ogos: meningkatkan keselamatan, mengoptimumkan skrin kunci, dsb.

Aug 14, 2024 am 10:39 AM

Menurut berita dari tapak ini pada 14 Ogos, semasa hari acara August Patch Tuesday hari ini, Microsoft mengeluarkan kemas kini kumulatif untuk sistem Windows 11, termasuk kemas kini KB5041585 untuk 22H2 dan 23H2, dan kemas kini KB5041592 untuk 21H2. Selepas peralatan yang disebutkan di atas dipasang dengan kemas kini kumulatif Ogos, perubahan nombor versi yang dilampirkan pada tapak ini adalah seperti berikut: Selepas pemasangan peralatan 21H2, nombor versi meningkat kepada Build22000.314722H2 Selepas pemasangan peralatan, nombor versi meningkat kepada Build22621.403723H2 Selepas pemasangan peralatan, nombor versi meningkat kepada Build22631.4037 Kandungan utama kemas kini KB5041585 untuk Windows 1121H2 adalah seperti berikut: Penambahbaikan.

Peningkatan Microsoft Edge: Fungsi penjimatan kata laluan automatik diharamkan? ! Pengguna terkejut!

Apr 19, 2024 am 08:13 AM

Peningkatan Microsoft Edge: Fungsi penjimatan kata laluan automatik diharamkan? ! Pengguna terkejut!

Apr 19, 2024 am 08:13 AM

Berita pada 18 April: Baru-baru ini, beberapa pengguna pelayar Microsoft Edge menggunakan saluran Canary melaporkan bahawa selepas menaik taraf kepada versi terkini, mereka mendapati bahawa pilihan untuk menyimpan kata laluan secara automatik telah dilumpuhkan. Selepas penyiasatan, didapati bahawa ini adalah pelarasan kecil selepas naik taraf penyemak imbas, bukannya pembatalan fungsi. Sebelum menggunakan penyemak imbas Edge untuk mengakses laman web, pengguna melaporkan bahawa penyemak imbas akan muncul tetingkap bertanya sama ada mereka mahu menyimpan kata laluan log masuk untuk tapak web tersebut. Selepas memilih untuk menyimpan, Edge secara automatik akan mengisi akaun dan kata laluan yang disimpan apabila anda log masuk seterusnya, memberikan pengguna kemudahan yang hebat. Tetapi kemas kini terkini menyerupai tweak, menukar tetapan lalai. Pengguna perlu memilih untuk menyimpan kata laluan dan kemudian menghidupkan pengisian automatik akaun yang disimpan dan kata laluan dalam tetapan.

Pop timbul skrin penuh Microsoft menggesa pengguna Windows 10 untuk menyegerakan dan menaik taraf kepada Windows 11

Jun 06, 2024 am 11:35 AM

Pop timbul skrin penuh Microsoft menggesa pengguna Windows 10 untuk menyegerakan dan menaik taraf kepada Windows 11

Jun 06, 2024 am 11:35 AM

Menurut berita pada 3 Jun, Microsoft sedang aktif menghantar pemberitahuan skrin penuh kepada semua pengguna Windows 10 untuk menggalakkan mereka menaik taraf kepada sistem pengendalian Windows 11. Langkah ini melibatkan peranti yang konfigurasi perkakasannya tidak menyokong sistem baharu. Sejak 2015, Windows 10 telah menduduki hampir 70% bahagian pasaran, dengan kukuh mengukuhkan penguasaannya sebagai sistem pengendalian Windows. Walau bagaimanapun, bahagian pasaran jauh melebihi bahagian pasaran 82%, dan bahagian pasaran jauh melebihi Windows 11, yang akan dikeluarkan pada 2021. Walaupun Windows 11 telah dilancarkan selama hampir tiga tahun, penembusan pasarannya masih perlahan. Microsoft telah mengumumkan bahawa ia akan menamatkan sokongan teknikal untuk Windows 10 selepas 14 Oktober 2025 untuk memberi tumpuan lebih kepada

Fungsi Microsoft Win11 untuk memampatkan fail 7z dan TAR telah diturunkan daripada versi 24H2 kepada 23H2/22H2

Apr 28, 2024 am 09:19 AM

Fungsi Microsoft Win11 untuk memampatkan fail 7z dan TAR telah diturunkan daripada versi 24H2 kepada 23H2/22H2

Apr 28, 2024 am 09:19 AM

Menurut berita dari laman web ini pada 27 April, Microsoft mengeluarkan kemas kini versi pratonton Windows 11 Build 26100 ke saluran Canary dan Dev awal bulan ini, yang dijangka menjadi calon versi RTM bagi kemas kini Windows 1124H2. Perubahan utama dalam versi baharu ialah peneroka fail, penyepaduan Copilot, penyuntingan metadata fail PNG, penciptaan fail termampat TAR dan 7z, dsb. @PhantomOfEarth mendapati bahawa Microsoft telah menurunkan beberapa fungsi versi 24H2 (Germanium) kepada versi 23H2/22H2 (Nikel), seperti mencipta fail mampat TAR dan 7z. Seperti yang ditunjukkan dalam rajah, Windows 11 akan menyokong penciptaan asli TAR

Kemas kini pelayar Microsoft Edge: Menambah fungsi 'zum dalam imej' untuk meningkatkan pengalaman pengguna

Mar 21, 2024 pm 01:40 PM

Kemas kini pelayar Microsoft Edge: Menambah fungsi 'zum dalam imej' untuk meningkatkan pengalaman pengguna

Mar 21, 2024 pm 01:40 PM

Menurut berita pada 21 Mac, Microsoft baru-baru ini mengemas kini pelayar Microsoft Edge dan menambah fungsi "besarkan imej" praktikal. Kini, apabila menggunakan pelayar Edge, pengguna boleh mencari ciri baharu ini dengan mudah dalam menu pop timbul dengan hanya mengklik kanan pada imej. Apa yang lebih mudah ialah pengguna juga boleh menuding kursor pada imej dan kemudian klik dua kali kekunci Ctrl untuk menggunakan fungsi mengezum masuk dengan cepat pada imej. Mengikut pemahaman editor, pelayar Microsoft Edge yang baru dikeluarkan telah diuji untuk ciri-ciri baru dalam saluran Canary. Versi pelayar yang stabil juga secara rasminya telah melancarkan fungsi "besarkan imej" praktikal, memberikan pengguna pengalaman menyemak imbas imej yang lebih mudah. Media sains dan teknologi asing turut memberi perhatian kepada perkara ini

Microsoft merancang untuk menghapuskan NTLM secara berperingkat dalam Windows 11 pada separuh kedua 2024 dan beralih sepenuhnya kepada pengesahan Kerberos

Jun 09, 2024 pm 04:17 PM

Microsoft merancang untuk menghapuskan NTLM secara berperingkat dalam Windows 11 pada separuh kedua 2024 dan beralih sepenuhnya kepada pengesahan Kerberos

Jun 09, 2024 pm 04:17 PM

Pada separuh kedua 2024, Blog Keselamatan Microsoft rasmi menerbitkan mesej sebagai respons kepada panggilan daripada komuniti keselamatan. Syarikat itu merancang untuk menghapuskan protokol pengesahan Pengurus NTLAN (NTLM) dalam Windows 11, dikeluarkan pada separuh kedua 2024, untuk meningkatkan keselamatan. Menurut penjelasan sebelum ini, Microsoft telah pun membuat langkah serupa sebelum ini. Pada 12 Oktober tahun lepas, Microsoft mencadangkan pelan peralihan dalam siaran akhbar rasmi yang bertujuan untuk menghapuskan kaedah pengesahan NTLM secara berperingkat dan mendorong lebih banyak perusahaan dan pengguna beralih kepada Kerberos. Untuk membantu perusahaan yang mungkin mengalami masalah dengan aplikasi dan perkhidmatan berwayar tegar selepas mematikan pengesahan NTLM, Microsoft menyediakan IAKerb dan

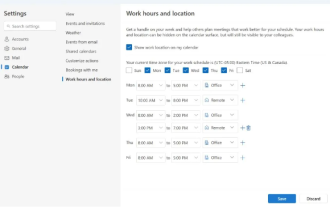

Microsoft melancarkan versi baharu Outlook untuk Windows: peningkatan komprehensif fungsi kalendar

Apr 27, 2024 pm 03:44 PM

Microsoft melancarkan versi baharu Outlook untuk Windows: peningkatan komprehensif fungsi kalendar

Apr 27, 2024 pm 03:44 PM

Dalam berita pada 27 April, Microsoft mengumumkan bahawa ia tidak lama lagi akan mengeluarkan ujian versi baharu klien Outlook untuk Windows. Kemas kini ini tertumpu terutamanya pada mengoptimumkan fungsi kalendar, bertujuan untuk meningkatkan kecekapan kerja pengguna dan memudahkan lagi aliran kerja harian. Penambahbaikan versi baharu klien Outlook untuk Windows terletak pada fungsi pengurusan kalendarnya yang lebih berkuasa. Kini, pengguna boleh berkongsi maklumat masa kerja dan lokasi peribadi dengan lebih mudah, menjadikan perancangan mesyuarat lebih cekap. Selain itu, Outlook juga telah menambah tetapan mesra pengguna, membolehkan pengguna menetapkan mesyuarat untuk tamat awal secara automatik atau bermula kemudian, memberikan pengguna lebih fleksibiliti, sama ada mereka ingin menukar bilik mesyuarat, berehat atau menikmati secawan kopi . mengikut