Peranti teknologi

Peranti teknologi

AI

AI

Mengenal pasti 'penipuan ChatGPT', kesannya mengatasi OpenAI: Universiti Peking dan pengesan janaan AI Huawei ada di sini

Mengenal pasti 'penipuan ChatGPT', kesannya mengatasi OpenAI: Universiti Peking dan pengesan janaan AI Huawei ada di sini

Mengenal pasti 'penipuan ChatGPT', kesannya mengatasi OpenAI: Universiti Peking dan pengesan janaan AI Huawei ada di sini

Dengan kemajuan berterusan model generatif besar, korpus yang mereka hasilkan secara beransur-ansur menghampiri manusia. Walaupun model besar membebaskan tangan kerani yang tidak terkira banyaknya, keupayaan kuat mereka untuk memalsukan yang palsu juga telah digunakan oleh beberapa penjenayah, menyebabkan beberapa siri masalah sosial:

Daripada Universiti Peking, Penyelidik Huawei telah mencadangkan pengesan teks yang boleh dipercayai untuk mengenal pasti pelbagai korpora yang dijana AI. Mengikut ciri berbeza teks panjang dan pendek, kaedah latihan pengesan teks yang dijana AI berbilang skala berdasarkan pembelajaran PU dicadangkan. Dengan menambah baik proses latihan pengesan, peningkatan besar dalam keupayaan pengesanan pada korpus ChatGPT panjang dan pendek boleh dicapai di bawah keadaan yang sama, menyelesaikan titik kesakitan ketepatan rendah pengecaman teks pendek oleh pengesan semasa.

- Alamat kertas: https://arxiv.org/abs/2305.18149

- Alamat kod (MindSpore): https://github.com/mindspore-lab/mindone/tree/master/examples/detect_chatgpt

- Alamat kod (PyTorch) :https://github.com/YuchuanTian/AIGC_text_detector

Pengenalan

Dengan Memandangkan kesan penjanaan model bahasa besar menjadi semakin realistik, pelbagai industri memerlukan pengesan teks janaan AI yang boleh dipercayai dengan segera. Walau bagaimanapun, industri yang berbeza mempunyai keperluan yang berbeza untuk korpus pengesanan Sebagai contoh, dalam akademik, secara amnya perlu untuk mengesan teks akademik yang besar dan lengkap pada platform sosial, berita palsu yang agak pendek dan berpecah-belah perlu dikesan. Walau bagaimanapun, pengesan sedia ada selalunya tidak dapat memenuhi pelbagai keperluan. Sebagai contoh, sesetengah pengesan teks AI arus perdana umumnya mempunyai keupayaan ramalan yang lemah untuk korpus yang lebih pendek.

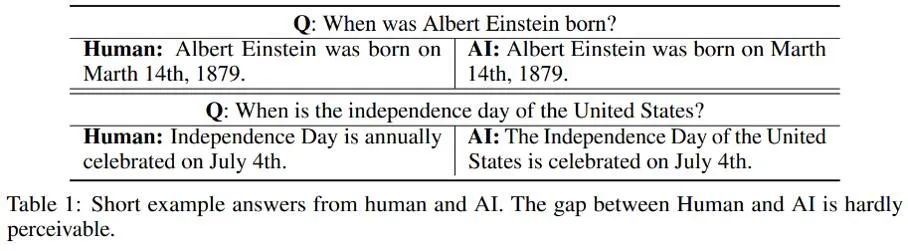

Berkenaan kesan pengesanan berbeza korpus dengan panjang yang berbeza, penulis memerhatikan bahawa mungkin terdapat beberapa "ketidakpastian" dalam atribusi teks yang dijana AI yang lebih pendek atau lebih terang, disebabkan oleh Beberapa ayat pendek yang dihasilkan oleh AI juga sering digunakan oleh manusia, jadi sukar untuk menentukan sama ada teks pendek yang dihasilkan oleh AI berasal daripada manusia atau AI. Berikut adalah beberapa contoh orang dan AI masing-masing menjawab soalan yang sama:

Seperti yang dapat dilihat daripada contoh ini, ia adalah sangat Sukar untuk mengenal pasti jawapan ringkas yang dijana oleh AI: perbezaan antara jenis korpus ini dan manusia adalah terlalu kecil, dan sukar untuk menilai dengan tegas sifat-sifatnya yang sebenar. Oleh itu, adalah tidak wajar untuk hanya menganotasi teks pendek sebagai manusia/AI dan melakukan pengesanan teks mengikut masalah pengelasan binari tradisional.

Untuk menangani masalah ini, kajian ini mengubah bahagian pengesanan klasifikasi binari manusia/AI kepada masalah pembelajaran PU (Positif-Tidak Berlabel) separa, iaitu, dalam ayat yang lebih pendek, manusia Bahasa ialah kelas positif (Positif) dan bahasa mesin ialah kelas tidak berlabel (Tidak Berlabel), dengan itu meningkatkan fungsi kehilangan latihan. Peningkatan ini dengan ketara meningkatkan prestasi pengelasan pengesan pada pelbagai korpora.

Butiran algoritma

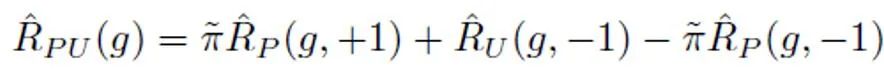

Di bawah tetapan pembelajaran PU tradisional, model klasifikasi binari hanya boleh belajar berdasarkan sampel latihan positif dan sampel latihan tidak berlabel. Kaedah pembelajaran PU yang biasa digunakan adalah untuk menganggarkan kerugian klasifikasi binari yang sepadan dengan sampel negatif dengan merumuskan kehilangan PU:

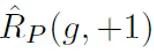

Antaranya,  mewakili kerugian klasifikasi binari yang dikira oleh sampel positif dan label positif

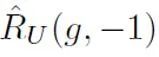

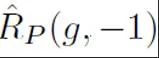

mewakili kerugian klasifikasi binari yang dikira oleh sampel positif dan label positif  mewakili kerugian yang dikira dengan mengandaikan semua sampel tidak berlabel; label negatif ialah, sampel positif adalah dalam semua Anggaran bahagian sampel PU. Dalam pembelajaran PU tradisional, sebelumnya biasanya ditetapkan kepada hiperparameter tetap. Walau bagaimanapun, dalam senario pengesanan teks, pengesan perlu memproses pelbagai teks dengan panjang yang berbeza, anggaran nisbah sampel positif antara semua sampel PU yang sama panjang dengan sampel juga berbeza. Oleh itu, kajian ini menambah baik PU Loss dan mencadangkan fungsi kehilangan PU (MPU) berskala sensitif panjang.

mewakili kerugian yang dikira dengan mengandaikan semua sampel tidak berlabel; label negatif ialah, sampel positif adalah dalam semua Anggaran bahagian sampel PU. Dalam pembelajaran PU tradisional, sebelumnya biasanya ditetapkan kepada hiperparameter tetap. Walau bagaimanapun, dalam senario pengesanan teks, pengesan perlu memproses pelbagai teks dengan panjang yang berbeza, anggaran nisbah sampel positif antara semua sampel PU yang sama panjang dengan sampel juga berbeza. Oleh itu, kajian ini menambah baik PU Loss dan mencadangkan fungsi kehilangan PU (MPU) berskala sensitif panjang.

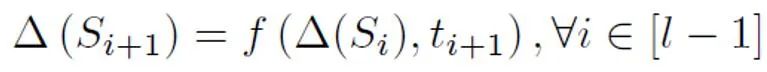

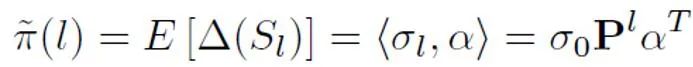

Secara khusus, kajian ini mencadangkan model gelung abstrak untuk memodelkan pengesanan teks yang lebih pendek. Apabila model NLP tradisional memproses jujukan, mereka biasanya mempunyai struktur rantai Markov, seperti RNN, LSTM, dsb. Proses model kitaran jenis ini biasanya boleh difahami sebagai proses berulang secara beransur-ansur, iaitu, ramalan setiap keluaran token diperoleh dengan mengubah dan menggabungkan hasil ramalan token sebelumnya dan urutan sebelumnya dengan hasil ramalan ini. token. Iaitu, proses berikut:

Secara khusus, kajian ini mencadangkan model gelung abstrak untuk memodelkan pengesanan teks yang lebih pendek. Apabila model NLP tradisional memproses jujukan, mereka biasanya mempunyai struktur rantai Markov, seperti RNN, LSTM, dsb. Proses model kitaran jenis ini biasanya boleh difahami sebagai proses berulang secara beransur-ansur, iaitu, ramalan setiap keluaran token diperoleh dengan mengubah dan menggabungkan hasil ramalan token sebelumnya dan urutan sebelumnya dengan hasil ramalan ini. token. Iaitu, proses berikut:

Untuk menganggarkan kebarangkalian terdahulu berdasarkan model abstrak ini, adalah perlu untuk menganggap bahawa output modelnya ialah ayat tertentu adalah positif Keyakinan kelas (Positif) ialah kebarangkalian sampel itu dinilai untuk dituturkan oleh seseorang. Diandaikan bahawa saiz sumbangan setiap token ialah perkadaran songsang bagi panjang token ayat, ia adalah positif, iaitu, tidak berlabel, dan kebarangkalian untuk tidak dilabel adalah jauh lebih besar daripada kebarangkalian untuk menjadi positif. Kerana apabila perbendaharaan kata model besar secara beransur-ansur menghampiri manusia, kebanyakan perkataan akan muncul dalam kedua-dua AI dan korpora manusia. Berdasarkan model yang dipermudahkan ini dan kebarangkalian token positif yang ditetapkan, anggaran akhir terakhir diperoleh dengan mencari jumlah jangkaan keyakinan output model di bawah keadaan input yang berbeza.

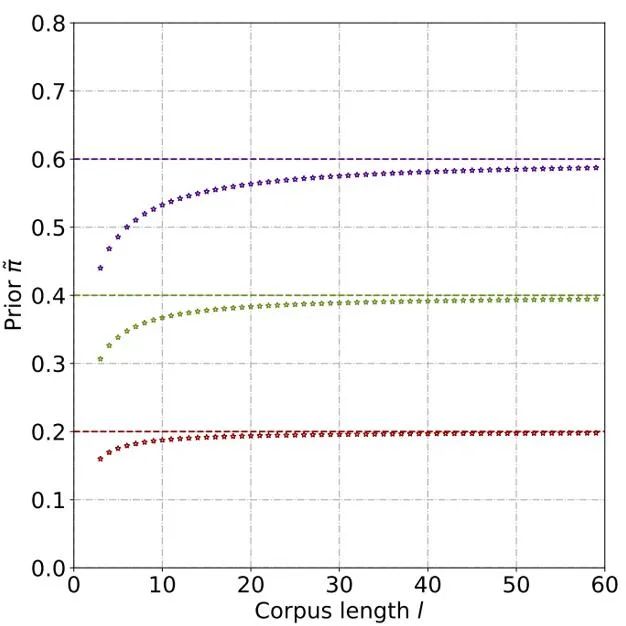

Melalui derivasi dan eksperimen teori, dianggarkan bahawa kebarangkalian terdahulu meningkat apabila panjang teks bertambah, dan akhirnya menjadi stabil. Fenomena ini juga dijangka, kerana apabila teks menjadi lebih panjang, pengesan boleh menangkap lebih banyak maklumat, dan "ketidakpastian sumber" teks secara beransur-ansur menjadi lemah:

Selepas itu, bagi setiap sampel positif, kehilangan PU dikira berdasarkan sebelumnya unik yang diperoleh daripada panjang sampelnya. Akhir sekali, memandangkan teks yang lebih pendek hanya mempunyai beberapa "ketidakpastian" (iaitu, teks yang lebih pendek juga akan mengandungi ciri teks sesetengah orang atau AI), kehilangan binari dan kehilangan MPU boleh ditimbang dan ditambah sebagai matlamat pengoptimuman akhir:

Selain itu, perlu diingatkan bahawa kehilangan MPU menyesuaikan diri dengan korpus latihan pelbagai panjang. Jika data latihan sedia ada jelas homogen dan kebanyakan korpus terdiri daripada teks yang panjang dan panjang, kaedah MPU tidak dapat melaksanakan keberkesanannya sepenuhnya. Bagi menjadikan panjang korpus latihan lebih pelbagai, kajian ini turut memperkenalkan modul multi-skala pada peringkat ayat. Modul ini secara rawak merangkumi beberapa ayat dalam korpus latihan dan menyusun semula ayat yang tinggal sambil mengekalkan susunan asal. Selepas operasi berbilang skala korpus latihan, teks latihan telah diperkaya panjangnya, dengan itu menggunakan sepenuhnya pembelajaran PU untuk latihan pengesan teks AI.

Hasil eksperimen

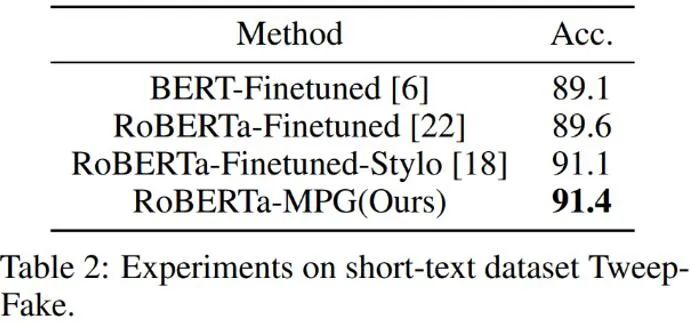

Seperti yang ditunjukkan dalam jadual di atas, pengarang mula-mula mengujinya pada set data korpus terjana AI yang lebih pendek Tweep -Palsu Kesan kehilangan MPU. Korpus dalam set data ini semuanya adalah segmen yang agak pendek di Twitter. Penulis juga menggantikan kehilangan dua kategori tradisional dengan matlamat pengoptimuman yang mengandungi kehilangan MPU berdasarkan penalaan halus model bahasa tradisional. Pengesan model bahasa yang dipertingkatkan adalah lebih berkesan dan mengatasi algoritma garis dasar yang lain.

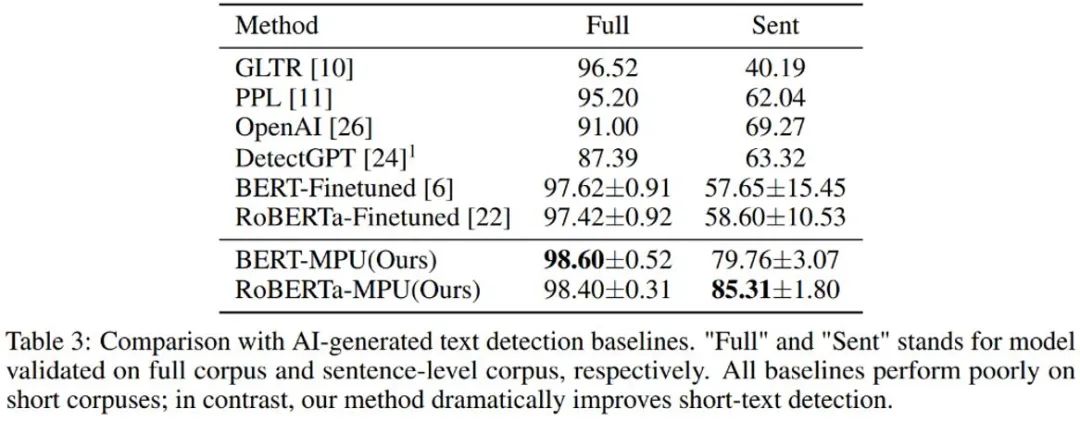

Pengarang juga mengesan teks yang dijana oleh chatGPT, dan pengesan model bahasa yang diperoleh selepas penalaan halus tradisional berkesan pada ayat pendek Prestasi adalah lemah; pengesan yang dilatih oleh kaedah MPU di bawah keadaan yang sama berprestasi baik pada ayat pendek, dan pada masa yang sama boleh mencapai peningkatan kesan yang besar pada korpus lengkap. mengatasi algoritma OpenAI dan DetectGPT.

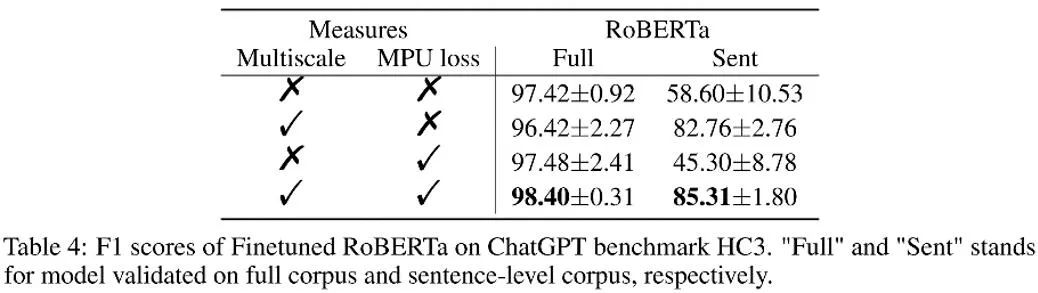

Seperti yang ditunjukkan dalam jadual di atas, penulis memerhatikan keuntungan kesan yang dibawa oleh setiap bahagian dalam eksperimen ablasi. Kehilangan MPU meningkatkan kesan pengelasan bahan panjang dan pendek.

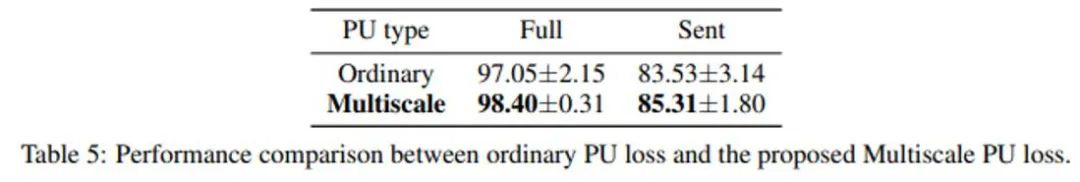

Pengarang juga membandingkan PU tradisional dan PU Berbilang Skala (MPU). Dapat dilihat daripada jadual di atas bahawa kesan MPU adalah lebih baik dan boleh menyesuaikan diri dengan tugas pengesanan teks pelbagai skala AI.

Ringkasan

Penulis menyelesaikan masalah pengesan teks untuk pengecaman ayat pendek dengan mencadangkan penyelesaian berdasarkan pembelajaran PU berskala Dengan percambahan model generasi AIGC pada masa hadapan , pengesanan jenis kandungan ini akan menjadi semakin penting. Penyelidikan ini telah mengambil langkah yang kukuh ke hadapan dalam isu pengesanan teks AI Diharapkan terdapat lebih banyak penyelidikan serupa pada masa hadapan untuk mengawal kandungan AIGC dengan lebih baik dan mencegah penyalahgunaan kandungan yang dihasilkan oleh AI.

Atas ialah kandungan terperinci Mengenal pasti 'penipuan ChatGPT', kesannya mengatasi OpenAI: Universiti Peking dan pengesan janaan AI Huawei ada di sini. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1393

1393

52

52

1205

1205

24

24

Platform Perdagangan Web3 Ranking_Web3 Global Exchanges Top Ten Ringkasan

Apr 21, 2025 am 10:45 AM

Platform Perdagangan Web3 Ranking_Web3 Global Exchanges Top Ten Ringkasan

Apr 21, 2025 am 10:45 AM

Binance adalah tuan rumah ekosistem perdagangan aset digital global, dan ciri -cirinya termasuk: 1. Jumlah dagangan harian purata melebihi $ 150 bilion, menyokong 500 pasangan perdagangan, yang meliputi 98% mata wang arus perdana; 2. Matriks inovasi meliputi pasaran Derivatif, susun atur Web3 dan sistem pendidikan; 3. Kelebihan teknikal adalah enjin yang sepadan dengan milisaat, dengan jumlah pemprosesan puncak sebanyak 1.4 juta transaksi sesaat; 4. Kemajuan pematuhan memegang lesen 15 negara dan menetapkan entiti yang mematuhi di Eropah dan Amerika Syarikat.

Cara mengelakkan kerugian selepas peningkatan ETH

Apr 21, 2025 am 10:03 AM

Cara mengelakkan kerugian selepas peningkatan ETH

Apr 21, 2025 am 10:03 AM

Selepas peningkatan ETH, orang baru harus mengamalkan strategi berikut untuk mengelakkan kerugian: 1. Lakukan kerja rumah mereka dan memahami pengetahuan asas dan meningkatkan kandungan ETH; 2. Posisi kawalan, menguji perairan dalam jumlah yang kecil dan mempelbagaikan pelaburan; 3. Buat pelan dagangan, jelaskan matlamat dan tetapkan titik kehilangan berhenti; 4. Profil secara rasional dan elakkan membuat keputusan emosi; 5. Pilih platform perdagangan formal dan boleh dipercayai; 6. Pertimbangkan jangka panjang untuk mengelakkan kesan turun naik jangka pendek.

Platform Pertukaran Cryptocurrency Top 10 senarai pertukaran mata wang digital terbesar di dunia

Apr 21, 2025 pm 07:15 PM

Platform Pertukaran Cryptocurrency Top 10 senarai pertukaran mata wang digital terbesar di dunia

Apr 21, 2025 pm 07:15 PM

Pertukaran memainkan peranan penting dalam pasaran cryptocurrency hari ini. Mereka bukan sahaja platform untuk pelabur untuk berdagang, tetapi juga sumber kecairan pasaran dan penemuan harga. Pertukaran mata wang maya terbesar di dunia di kalangan sepuluh teratas, dan pertukaran ini bukan sahaja jauh ke hadapan dalam jumlah dagangan, tetapi juga mempunyai kelebihan mereka sendiri dalam pengalaman pengguna, perkhidmatan keselamatan dan inovatif. Pertukaran yang atas senarai biasanya mempunyai pangkalan pengguna yang besar dan pengaruh pasaran yang luas, dan jumlah dagangan dan jenis aset mereka sering sukar dicapai oleh bursa lain.

Apakah yang dimaksudkan dengan transaksi rantaian rantaian? Apakah urus niaga salib?

Apr 21, 2025 pm 11:39 PM

Apakah yang dimaksudkan dengan transaksi rantaian rantaian? Apakah urus niaga salib?

Apr 21, 2025 pm 11:39 PM

Pertukaran yang menyokong urus niaga rantaian: 1. Binance, 2. Uniswap, 3 Sushiswap, 4. Kewangan Curve, 5. Thorchain, 6. 1 inci Pertukaran, 7.

Apakah sepuluh platform teratas dalam bulatan pertukaran mata wang?

Apr 21, 2025 pm 12:21 PM

Apakah sepuluh platform teratas dalam bulatan pertukaran mata wang?

Apr 21, 2025 pm 12:21 PM

Pertukaran teratas termasuk: 1. Binance, jumlah dagangan terbesar di dunia, menyokong 600 mata wang, dan yuran pengendalian tempat adalah 0.1%; 2. Okx, platform seimbang, menyokong 708 pasangan dagangan, dan yuran pengendalian kontrak kekal adalah 0.05%; 3. Gate.io, meliputi 2700 mata wang kecil, dan yuran pengendalian tempat ialah 0.1%-0.3%; 4. Coinbase, penanda aras pematuhan AS, yuran pengendalian tempat adalah 0.5%; 5. Kraken, keselamatan tertinggi, dan audit rizab tetap.

Kedudukan pertukaran leverage dalam lingkaran mata wang Cadangan terkini sepuluh pertukaran leverage dalam lingkaran mata wang

Apr 21, 2025 pm 11:24 PM

Kedudukan pertukaran leverage dalam lingkaran mata wang Cadangan terkini sepuluh pertukaran leverage dalam lingkaran mata wang

Apr 21, 2025 pm 11:24 PM

Platform yang mempunyai prestasi cemerlang dalam perdagangan, keselamatan dan pengalaman pengguna yang dimanfaatkan pada tahun 2025 adalah: 1. Okx, sesuai untuk peniaga frekuensi tinggi, menyediakan sehingga 100 kali leverage; 2. Binance, sesuai untuk peniaga berbilang mata wang di seluruh dunia, memberikan 125 kali leverage tinggi; 3. Gate.io, sesuai untuk pemain derivatif profesional, menyediakan 100 kali leverage; 4. Bitget, sesuai untuk orang baru dan peniaga sosial, menyediakan sehingga 100 kali leverage; 5. Kraken, sesuai untuk pelabur mantap, menyediakan 5 kali leverage; 6. Bybit, sesuai untuk penjelajah altcoin, menyediakan 20 kali leverage; 7. Kucoin, sesuai untuk peniaga kos rendah, menyediakan 10 kali leverage; 8. Bitfinex, sesuai untuk bermain senior

Mengapa kenaikan atau kejatuhan harga mata wang maya? Mengapa kenaikan atau kejatuhan harga mata wang maya?

Apr 21, 2025 am 08:57 AM

Mengapa kenaikan atau kejatuhan harga mata wang maya? Mengapa kenaikan atau kejatuhan harga mata wang maya?

Apr 21, 2025 am 08:57 AM

Faktor kenaikan harga mata wang maya termasuk: 1. Peningkatan permintaan pasaran, 2. Menurunkan bekalan, 3. Berita positif yang dirangsang, 4. Sentimen pasaran optimis, 5. Persekitaran makroekonomi; Faktor penurunan termasuk: 1. Mengurangkan permintaan pasaran, 2. Peningkatan bekalan, 3.

'Black Monday Sell' adalah hari yang sukar untuk industri cryptocurrency

Apr 21, 2025 pm 02:48 PM

'Black Monday Sell' adalah hari yang sukar untuk industri cryptocurrency

Apr 21, 2025 pm 02:48 PM

Jatuh di pasaran cryptocurrency telah menyebabkan panik di kalangan pelabur, dan Dogecoin (Doge) telah menjadi salah satu kawasan terkena paling sukar. Harganya jatuh dengan ketara, dan jumlah nilai kunci kewangan yang terdesentralisasi (DEFI) (TVL) juga menyaksikan penurunan yang ketara. Gelombang jualan "Black Monday" menyapu pasaran cryptocurrency, dan Dogecoin adalah yang pertama dipukul. Defitvlnya jatuh ke tahap 2023, dan harga mata wang jatuh 23.78% pada bulan lalu. Defitvl Dogecoin jatuh ke tahap rendah $ 2.72 juta, terutamanya disebabkan oleh penurunan 26.37% dalam indeks nilai SOSO. Platform defi utama lain, seperti DAO dan Thorchain yang membosankan, TVL juga menurun sebanyak 24.04% dan 20.