$ sudo firewall-cmd --permanent --add-service=high-availability$ sudo firewall-cmd --reload

Operasi dan penyelenggaraan

Operasi dan penyelenggaraan

Keselamatan

Keselamatan

Bagaimana untuk menyediakan kluster Apache (HTTP) ketersediaan tinggi pada RHEL 9/8

Bagaimana untuk menyediakan kluster Apache (HTTP) ketersediaan tinggi pada RHEL 9/8

Bagaimana untuk menyediakan kluster Apache (HTTP) ketersediaan tinggi pada RHEL 9/8

Pacemaker ialah perisian kluster ketersediaan tinggi yang sesuai untuk sistem pengendalian seperti Linux. Perentak jantung dikenali sebagai "pengurus sumber kluster" dan menyediakan ketersediaan maksimum sumber kluster dengan kegagalan sumber antara nod kluster. Perentak jantung menggunakan Corosync untuk degupan jantung dan komunikasi dalaman antara komponen kelompok Corosync juga bertanggungjawab untuk mengundi dalam kelompok (Kuorum).

Prasyarat

Sebelum kami bermula, pastikan anda mempunyai yang berikut:

- Dua pelayan RHEL 9/8

- Langganan Red Hat atau setempat repositori yang dikonfigurasikan

- akses SSH ke kedua-dua pelayan

- kebenaran root atau sudo

- Sambungan Internet

Butiran makmal:

- Pelayan 1: node1.example.com (192.168.1.6)

- Pelayan 2: node2.exaple.com (192.168. 1.7) VIP: 192.168.1.81

- Cakera Dikongsi: (2GB)

/dev/sdb Tanpa berlengah lagi, mari selami langkahnya.

1. Kemas kini fail /etc/hosts

Tambahkan entri berikut dalam fail

pada kedua-dua nod:192.168.1.6node1.example.com192.168.1.7node2.example.com

/etc/hosts2 Perentak jantungPacemaker dan pakej perisian lain yang diperlukan tidak tersedia dalam repositori pakej lalai RHEL 9/8. Oleh itu, kita mesti mendayakan gudang yang sangat tersedia. Jalankan arahan pengurus langganan berikut pada kedua-dua nod.

Untuk pelayan RHEL 9:

$ sudo subscription-manager repos --enable=rhel-9-for-x86_64-highavailability-rpms

Untuk pelayan RHEL 8:

$ sudo subscription-manager repos --enable=rhel-8-for-x86_64-highavailability-rpms

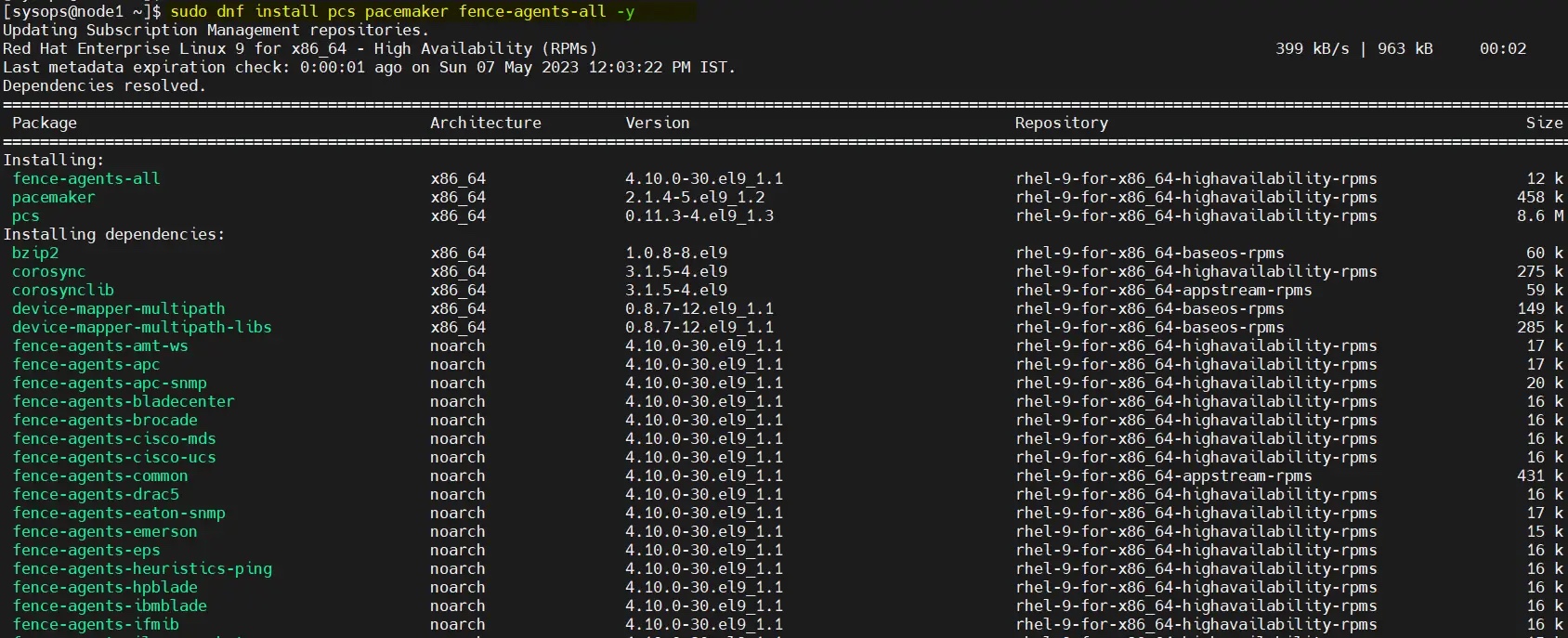

Selepas mendayakan repositori, jalankan arahan untuk memasang pakej

pada kedua-dua nod:

$ sudo dnf install pcs pacemaker fence-agents-all -y

pacemaker Cara menyediakan gugusan Apache (HTTP) berketersediaan tinggi pada RHEL 9/8

Cara menyediakan gugusan Apache (HTTP) berketersediaan tinggi pada RHEL 9/8

3 🎜>

Untuk Untuk membenarkan port ketersediaan tinggi dalam tembok api, sila jalankan arahan berikut pada setiap nod:$ sudo firewall-cmd --permanent --add-service=high-availability$ sudo firewall-cmd --reload

Salin selepas log masuk

4 Tetapkan kata laluan untuk pengguna hacluster dan mulakan perkhidmatan pcsd Pada kedua-dua pelayan ia adalah $ sudo firewall-cmd --permanent --add-service=high-availability$ sudo firewall-cmd --reload

Pengguna menetapkan kata laluan dan menjalankan perintah

berikut:$ echo "<Enter-Password>" | sudo passwd --stdin hacluster

haclusterLaksanakan arahan berikut untuk memulakan dan mendayakan perkhidmatan kluster pada dua pelayan: echo$ sudo systemctl start pcsd.service$ sudo systemctl enable pcsd.service

untuk mengesahkan kedua-dua nod, jalankan arahan berikut dari mana-mana nod. Dalam kes saya, saya menjalankannya pada

:$ sudo pcs host auth node1.example.com node2.example.com

pcs mengesahkan menggunakan pengguna node1. hacluster

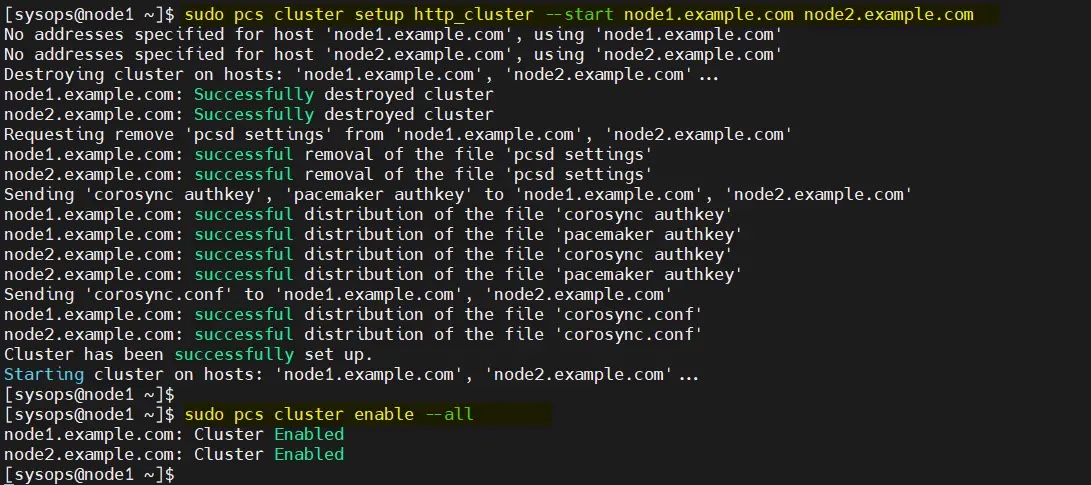

Gunakan perintah  berikut untuk menambah dua nod pada kluster Nama kluster yang saya gunakan di sini ialah

berikut untuk menambah dua nod pada kluster Nama kluster yang saya gunakan di sini ialah

sahaja: pcs cluster setup

$ sudo pcs cluster setup http_cluster --start node1.example.com node2.example.com$ sudo pcs cluster enable --all

http_clusterKeluaran kedua-dua arahan kelihatan seperti ini: node1

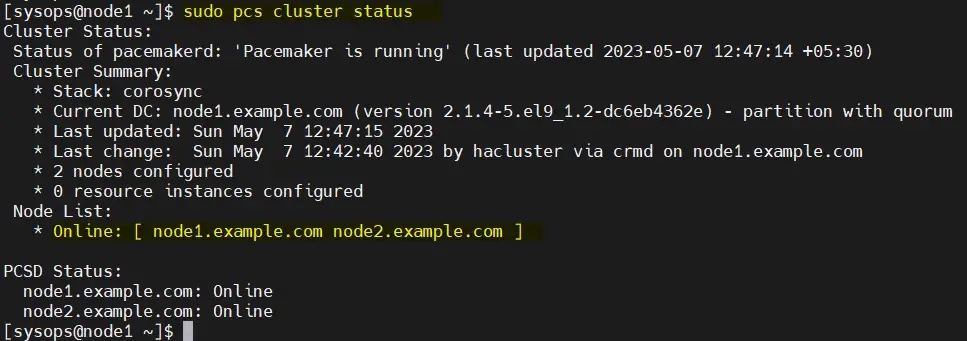

从任何节点验证初始集群状态:

$ sudo pcs cluster status

注意:在我们的实验室中,我们没有任何防护设备,因此我们将其禁用。但在生产环境中,强烈建议配置防护。

$ sudo pcs property set stonith-enabled=false$ sudo pcs property set no-quorum-policy=ignore

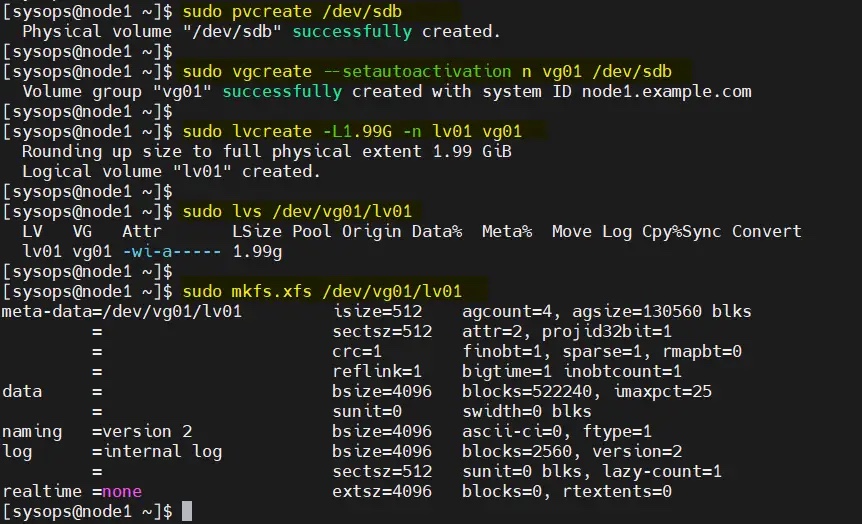

6、为集群配置共享卷

在服务器上,挂载了一个大小为 2GB 的共享磁盘(/dev/sdb)。因此,我们将其配置为 LVM 卷并将其格式化为 XFS 文件系统。

在开始创建 LVM 卷之前,编辑两个节点上的 /etc/lvm/lvm.conf 文件。

将参数 #system_id_source = "none" 更改为 system_id_source = "uname":

$ sudo sed -i 's/# system_id_source = "none"/ system_id_source = "uname"/g' /etc/lvm/lvm.conf

在 node1 上依次执行以下一组命令创建 LVM 卷:

$ sudo pvcreate /dev/sdb$ sudo vgcreate --setautoactivation n vg01 /dev/sdb$ sudo lvcreate -L1.99G -n lv01 vg01$ sudo lvs /dev/vg01/lv01$ sudo mkfs.xfs /dev/vg01/lv01

将共享设备添加到集群第二个节点(node2.example.com)上的 LVM 设备文件中,仅在 node2 上运行以下命令:

[sysops@node2 ~]$ sudo lvmdevices --adddev /dev/sdb

7、安装和配置 Apache Web 服务器(httpd)

在两台服务器上安装 Apache web 服务器(httpd),运行以下 dnf 命令:

$ sudo dnf install -y httpd wget

并允许防火墙中的 Apache 端口,在两台服务器上运行以下 firewall-cmd 命令:

$ sudo firewall-cmd --permanent --zone=public --add-service=http$ sudo firewall-cmd --permanent --zone=public --add-service=https$ sudo firewall-cmd --reload

在两个节点上创建 status.conf 文件,以便 Apache 资源代理获取 Apache 的状态:

$ sudo bash -c 'cat <<-END > /etc/httpd/conf.d/status.conf<Location /server-status>SetHandler server-statusRequire local</Location>END'$

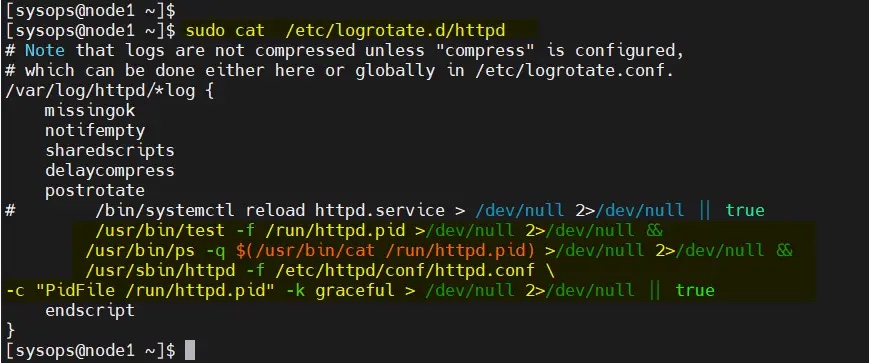

修改两个节点上的 /etc/logrotate.d/httpd:

替换下面的行

/bin/systemctl reload httpd.service > /dev/null 2>/dev/null || true

为

/usr/bin/test -f /run/httpd.pid >/dev/null 2>/dev/null &&/usr/bin/ps -q $(/usr/bin/cat /run/httpd.pid) >/dev/null 2>/dev/null &&/usr/sbin/httpd -f /etc/httpd/conf/httpd.conf \-c "PidFile /run/httpd.pid" -k graceful > /dev/null 2>/dev/null || true

保存并退出文件。

8、为 Apache 创建一个示例网页

仅在 node1 上执行以下命令:

$ sudo lvchange -ay vg01/lv01$ sudo mount /dev/vg01/lv01 /var/www/$ sudo mkdir /var/www/html$ sudo mkdir /var/www/cgi-bin$ sudo mkdir /var/www/error$ sudo bash -c ' cat <<-END >/var/www/html/index.html<html><body>High Availability Apache Cluster - Test Page </body></html>END'$$ sudo umount /var/www

注意:如果启用了 SElinux,则在两台服务器上运行以下命令:

$ sudo restorecon -R /var/www

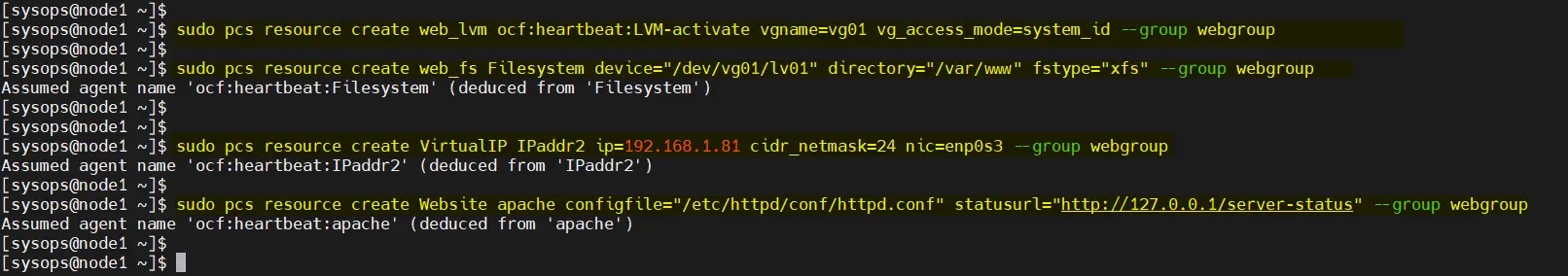

9、创建集群资源和资源组

为集群定义资源组和集群资源。在我的例子中,我们使用 webgroup 作为资源组。

-

web_lvm是共享 LVM 卷的资源名称(/dev/vg01/lv01) -

web_fs是将挂载在/var/www上的文件系统资源的名称 -

VirtualIP是网卡enp0s3的 VIP(IPadd2)资源 -

Website是 Apache 配置文件的资源。

从任何节点执行以下命令集。

$ sudo pcs resource create web_lvm ocf:heartbeat:LVM-activate vgname=vg01 vg_access_mode=system_id --group webgroup$ sudo pcs resource create web_fs Filesystem device="/dev/vg01/lv01" directory="/var/www" fstype="xfs" --group webgroup$ sudo pcs resource create VirtualIP IPaddr2 ip=192.168.1.81 cidr_netmask=24 nic=enp0s3 --group webgroup$ sudo pcs resource create Website apache configfile="/etc/httpd/conf/httpd.conf" statusurl="http://127.0.0.1/server-status" --group webgroup

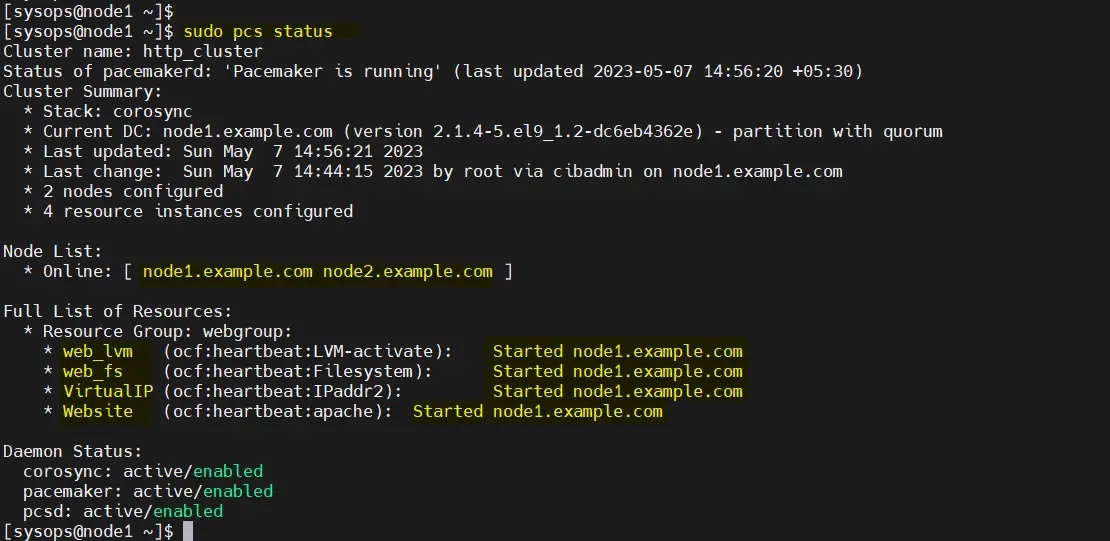

现在验证集群资源状态,运行:

$ sudo pcs status

很好,上面的输出显示所有资源都在 node1 上启动。

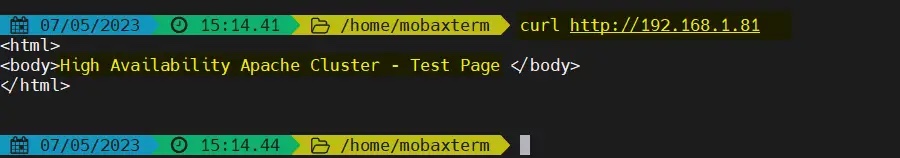

10、测试 Apache 集群

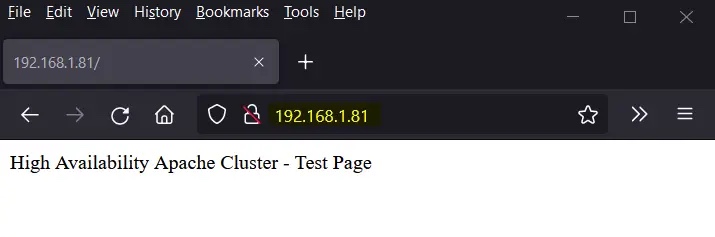

尝试使用 VIP(192.168.1.81)访问网页。

使用 curl 命令或网络浏览器访问网页:

$ curl http://192.168.1.81

或者

完美!以上输出确认我们能够访问我们高可用 Apache 集群的网页。

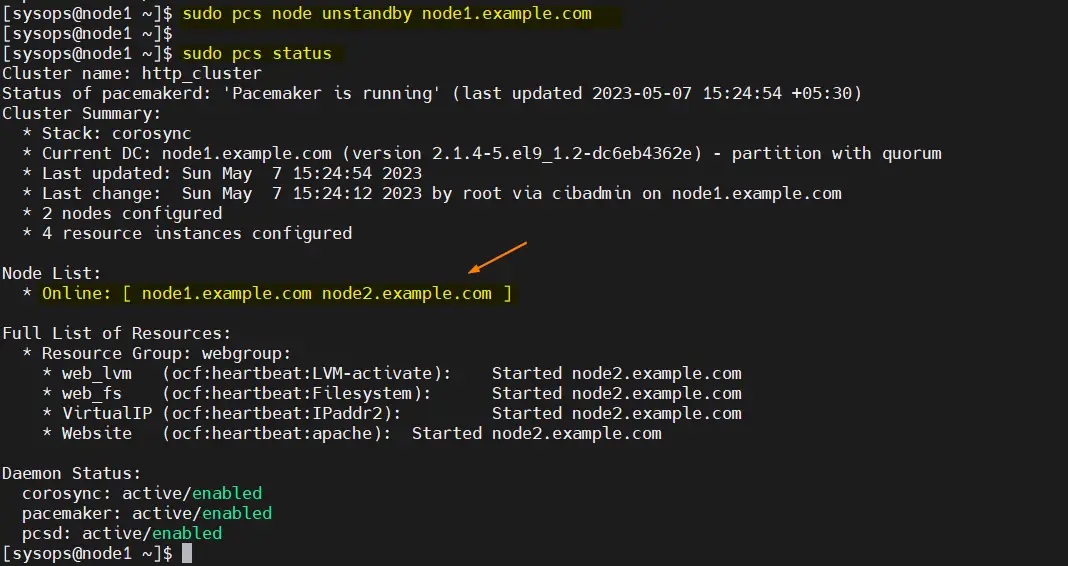

让我们尝试将集群资源从 node1 移动到 node2,运行:

$ sudo pcs node standby node1.example.com$ sudo pcs status

完美,以上输出确认集群资源已从 node1 迁移到 node2。

要从备用节点(node1.example.com)中删除节点,运行以下命令:

$ sudo pcs node unstandby node1.example.com

Atas ialah kandungan terperinci Bagaimana untuk menyediakan kluster Apache (HTTP) ketersediaan tinggi pada RHEL 9/8. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1386

1386

52

52

Cara menetapkan direktori CGI di Apache

Apr 13, 2025 pm 01:18 PM

Cara menetapkan direktori CGI di Apache

Apr 13, 2025 pm 01:18 PM

Untuk menubuhkan direktori CGI di Apache, anda perlu melakukan langkah-langkah berikut: Buat direktori CGI seperti "CGI-Bin", dan memberikan kebenaran menulis Apache. Tambah blok arahan "Scriptalias" dalam fail konfigurasi Apache untuk memetakan direktori CGI ke url "/cgi". Mulakan semula Apache.

Cara menetapkan pengekodan aksara di sisi pelayan untuk menyelesaikan meja bootstrap yang dihiasi

Apr 07, 2025 pm 12:00 PM

Cara menetapkan pengekodan aksara di sisi pelayan untuk menyelesaikan meja bootstrap yang dihiasi

Apr 07, 2025 pm 12:00 PM

Untuk menetapkan pengekodan aksara di sisi pelayan untuk menyelesaikan jadual bootstrap yang dihiasi, anda perlu mengikuti langkah -langkah berikut: periksa pengekodan aksara pelayan; Edit fail konfigurasi pelayan; Tetapkan pengekodan watak ke UTF-8; simpan dan mulakan semula pelayan; Sahkan pengekodan.

Cara Memulakan Apache

Apr 13, 2025 pm 01:06 PM

Cara Memulakan Apache

Apr 13, 2025 pm 01:06 PM

Langkah-langkah untuk memulakan Apache adalah seperti berikut: Pasang Apache (perintah: sudo apt-get pemasangan apache2 atau muat turun dari laman web rasmi) Mula Apache (linux: Sudo Systemctl Mula Apache2; Windows: Klik kanan "Apache2.4" Perkhidmatan dan pilih "Mula") Boot secara automatik (Pilihan, Linux: Sudo Systemctl

Cara memeriksa konfigurasi OpenSSL Debian

Apr 12, 2025 pm 11:57 PM

Cara memeriksa konfigurasi OpenSSL Debian

Apr 12, 2025 pm 11:57 PM

Artikel ini memperkenalkan beberapa kaedah untuk memeriksa konfigurasi OpenSSL sistem Debian untuk membantu anda dengan cepat memahami status keselamatan sistem. 1. Sahkan versi OpenSSL terlebih dahulu, sahkan sama ada OpenSSL telah dipasang dan maklumat versi. Masukkan arahan berikut di terminal: Jika OpenSslversion tidak dipasang, sistem akan meminta ralat. 2. Lihat fail konfigurasi. Fail konfigurasi utama OpenSSL biasanya terletak di /etc/ssl/openssl.cnf. Anda boleh menggunakan editor teks (seperti nano) untuk melihat: Sudonano/etc/ssl/openssl.cnf Fail ini mengandungi maklumat konfigurasi penting seperti kunci, laluan sijil, dan algoritma penyulitan. 3. Menggunakan OPE

Cara memadam lebih daripada nama pelayan Apache

Apr 13, 2025 pm 01:09 PM

Cara memadam lebih daripada nama pelayan Apache

Apr 13, 2025 pm 01:09 PM

Untuk memadam arahan Serverve Name tambahan dari Apache, anda boleh mengambil langkah -langkah berikut: Kenal pasti dan padamkan Arahan ServerName tambahan. Mulakan semula Apache untuk membuat perubahan berkuatkuasa. Semak fail konfigurasi untuk mengesahkan perubahan. Uji pelayan untuk memastikan masalah diselesaikan.

Cara Menggunakan Log Debian Apache Untuk Meningkatkan Prestasi Laman Web

Apr 12, 2025 pm 11:36 PM

Cara Menggunakan Log Debian Apache Untuk Meningkatkan Prestasi Laman Web

Apr 12, 2025 pm 11:36 PM

Artikel ini akan menerangkan bagaimana untuk meningkatkan prestasi laman web dengan menganalisis log Apache di bawah sistem Debian. 1. Asas Analisis Log Apache Log merekodkan maklumat terperinci semua permintaan HTTP, termasuk alamat IP, timestamp, url permintaan, kaedah HTTP dan kod tindak balas. Dalam sistem Debian, log ini biasanya terletak di direktori/var/log/apache2/access.log dan /var/log/apache2/error.log. Memahami struktur log adalah langkah pertama dalam analisis yang berkesan. 2. Alat Analisis Log Anda boleh menggunakan pelbagai alat untuk menganalisis log Apache: Alat baris arahan: grep, awk, sed dan alat baris arahan lain.

Cara menyambung ke pangkalan data Apache

Apr 13, 2025 pm 01:03 PM

Cara menyambung ke pangkalan data Apache

Apr 13, 2025 pm 01:03 PM

Apache menyambung ke pangkalan data memerlukan langkah -langkah berikut: Pasang pemacu pangkalan data. Konfigurasikan fail web.xml untuk membuat kolam sambungan. Buat sumber data JDBC dan tentukan tetapan sambungan. Gunakan API JDBC untuk mengakses pangkalan data dari kod Java, termasuk mendapatkan sambungan, membuat kenyataan, parameter mengikat, melaksanakan pertanyaan atau kemas kini, dan hasil pemprosesan.

Cara melihat versi Apache anda

Apr 13, 2025 pm 01:15 PM

Cara melihat versi Apache anda

Apr 13, 2025 pm 01:15 PM

Terdapat 3 cara untuk melihat versi pada pelayan Apache: melalui baris arahan (Apachectl -v atau Apache2CTL -V), periksa halaman status pelayan (http: // & lt; IP pelayan atau nama domain & gt;/pelayan -status), atau lihat fail konfigurasi Apache (Serverversion: Apache/& lt;