Peranti teknologi

Peranti teknologi

AI

AI

5 juta token raksasa, baca keseluruhan 'Harry Potter' sekali gus! Lebih daripada 1000 kali lebih lama daripada ChatGPT

5 juta token raksasa, baca keseluruhan 'Harry Potter' sekali gus! Lebih daripada 1000 kali lebih lama daripada ChatGPT

5 juta token raksasa, baca keseluruhan 'Harry Potter' sekali gus! Lebih daripada 1000 kali lebih lama daripada ChatGPT

Memori yang lemah ialah titik kesakitan utama model bahasa berskala besar semasa Contohnya, ChatGPT hanya boleh memasukkan 4096 token (kira-kira 3000 perkataan saya sering lupa apa yang saya katakan sebelum ini, dan memang begitu tidak cukup untuk membaca cerpen.

Tetingkap input pendek juga mengehadkan senario aplikasi model bahasa Contohnya, apabila meringkaskan kertas saintifik (kira-kira 10,000 patah perkataan), artikel itu perlu dibahagikan secara manual adalah input ke dalam model, maklumat yang berkaitan antara bab yang berbeza hilang.

Walaupun GPT-4 menyokong sehingga 32,000 token dan Claude yang dinaik taraf menyokong sehingga 100,000 token, mereka hanya boleh mengurangkan masalah kapasiti otak yang tidak mencukupi.

Baru-baru ini pasukan keusahawanan Magic mengumumkan bahawa ia tidak lama lagi akan mengeluarkan model LTM-1, yang boleh menyokong sehingga 5 juta token Ia adalah kira-kira 500,000 baris kod atau 5,000 fail, iaitu 50 kali lebih tinggi daripada Claude pada asasnya boleh menampung kebanyakan keperluan storan Ini benar-benar perubahan kuantitatif.

Senario aplikasi utama LTM-1 ialah pelengkapan kod, contohnya, ia boleh menjana cadangan kod yang lebih panjang dan lebih kompleks.

Anda juga boleh menggunakan semula dan mensintesis maklumat merentas berbilang fail.

Berita buruknya ialah Magic, pembangun LTM-1, tidak mengeluarkan prinsip teknikal khusus, tetapi hanya mengatakan bahawa ia mereka bentuk kaedah baharu Rangkaian Memori Jangka Panjang (LTM Net).

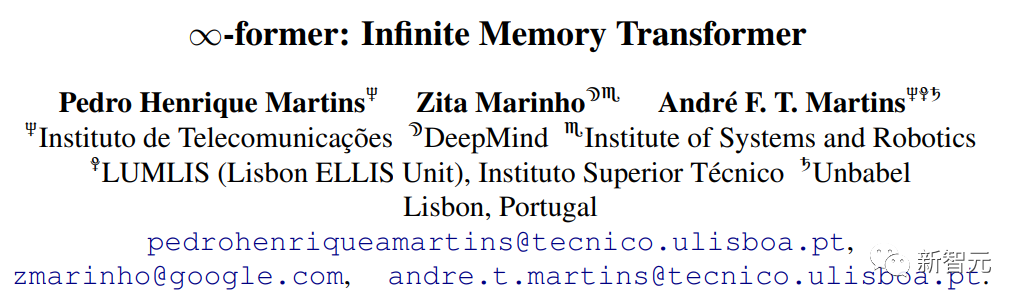

Tetapi terdapat juga berita baik pada September 2021, penyelidik dari DeepMind dan institusi lain mencadangkan model yang dipanggil ∞-bekas, yang merangkumi ingatan jangka panjang (ingatan jangka panjang (LTM). ) mekanisme, yang secara teorinya membenarkan model Transformer mempunyai memori yang tidak terhingga, tetapi pada masa ini tidak jelas sama ada kedua-duanya adalah teknologi yang sama atau versi yang lebih baik.

Pautan kertas: https://arxiv.org/pdf/2109.00301.pdf

Pasukan pembangunan menyatakan bahawa walaupun LTM Nets boleh melihat lebih banyak konteks daripada GPT, bilangan parameter model LTM-1 jauh lebih kecil daripada model sota semasa, jadi ia lebih pintar . Rendah, tetapi terus meningkatkan saiz model akan meningkatkan prestasi LTM Nets.

Pada masa ini LTM-1 telah membuka aplikasi ujian alfa.

Pautan aplikasi: https://www.php. cn/link/bbfb937a66597d9646ad992009aee405

Magic, pembangun LTM-1, diasaskan pada 2022. Ia terutamanya membangunkan produk yang serupa dengan GitHub jurutera menulis dan menyemak, menyahpepijat dan mengubah suai kod, matlamatnya adalah untuk mencipta rakan sekerja AI untuk pengaturcara yang kelebihan daya saing utamanya ialah model boleh membaca kod yang lebih panjang.

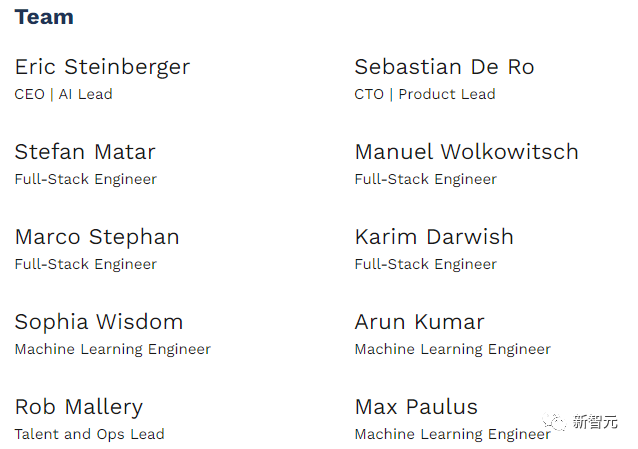

Magic komited untuk manfaat awam, dan misinya adalah untuk membina dan menggunakan sistem AGI dengan selamat yang melebihi keupayaan manusia Ia kini merupakan syarikat permulaan dengan hanya 10 orang.

Pada Februari tahun ini, Magic menerima AS$23 juta dalam pembiayaan Siri A yang diketuai oleh CapitalG, anak syarikat Alphabet. Pelabur juga Termasuk Nat Friedman, bekas Ketua Pegawai Eksekutif GitHub dan pengeluar bersama Copilot, jumlah pembiayaan syarikat kini mencecah AS$28 juta.

Eric Steinberger, Ketua Pegawai Eksekutif dan pengasas bersama Magic, lulus dari Universiti Cambridge dengan ijazah sarjana muda dalam sains komputer dan telah melakukan penyelidikan pembelajaran mesin di FAIR.

Sebelum mengasaskan Magic, Steinberger juga mengasaskan ClimateScience untuk membantu kanak-kanak di seluruh dunia mengetahui tentang kesan perubahan iklim.

Pengubah ingatan tak terhingga

Reka bentuk mekanisme perhatian dalam Transformer, komponen teras model bahasa, akan menyebabkan kerumitan masa meningkat setiap kali panjang daripada jujukan input meningkat.

Walaupun sudah terdapat beberapa varian mekanisme perhatian, seperti perhatian yang jarang, dll. untuk mengurangkan kerumitan algoritma, kerumitannya masih berkaitan dengan panjang input dan tidak boleh berkembang tidak terhingga.

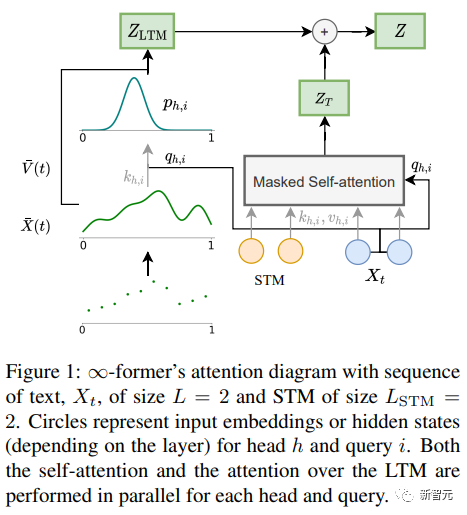

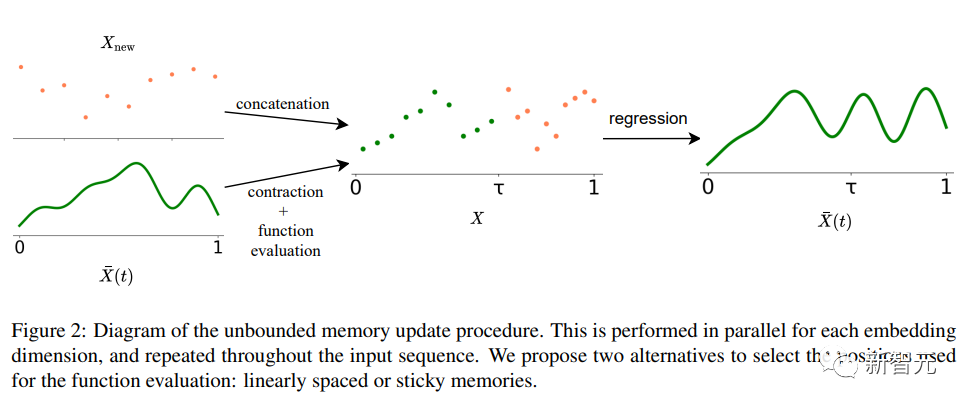

∞-bekas Kunci kepada model Transformer ingatan jangka panjang (LTM) yang boleh memanjangkan urutan input kepada infiniti ialah rangka kerja perhatian spatial berterusan yang mengurangkan kebutiran perwakilan Meningkatkan bilangan unit maklumat ingatan (fungsi asas).

Dalam rangka kerja, jujukan input diwakili sebagai "isyarat berterusan", mewakili N fungsi asas jejari ( RBF ), dengan cara ini, kerumitan perhatian ∞-bekas dikurangkan kepada O(L^2 + L × N), manakala kerumitan perhatian Transformer asal ialah O(L×(L+L_LTM)) , di mana L dan L_LTM sepadan dengan saiz input Transformer dan panjang ingatan jangka panjang masing-masing.

Kaedah perwakilan ini mempunyai dua kelebihan utama:

1 Konteks boleh diwakili oleh fungsi asas N yang lebih kecil daripada nombor daripada token, mengurangkan Kos pengiraan perhatian dikurangkan;

Sudah tentu, tiada makan tengah hari percuma, dan harganya ialah pengurangan resolusi: apabila menggunakan nombor yang lebih kecil fungsi asas, Boleh mengakibatkan pengurangan ketepatan apabila mewakili urutan input sebagai isyarat berterusan.

Sudah tentu, tiada makan tengah hari percuma, dan harganya ialah pengurangan resolusi: apabila menggunakan nombor yang lebih kecil fungsi asas, Boleh mengakibatkan pengurangan ketepatan apabila mewakili urutan input sebagai isyarat berterusan.

Untuk mengurangkan masalah pengurangan resolusi, penyelidik memperkenalkan konsep "kenangan melekit", yang mengaitkan ruang yang lebih besar dalam isyarat LTM kepada kawasan memori yang lebih kerap diakses , mencipta konsep "kekal " dalam LTM, yang membolehkan model menangkap latar belakang jangka panjang dengan lebih baik tanpa kehilangan maklumat yang relevan, dan juga diilhamkan oleh potensi jangka panjang dan keplastikan otak.

Bahagian eksperimen

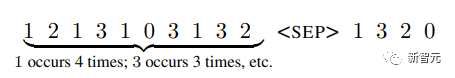

Untuk mengesahkan sama ada ∞-bekas boleh memodelkan konteks yang panjang, penyelidik pertama Eksperimen adalah dijalankan pada tugas sintesis menyusun token mengikut kekerapan dalam urutan yang panjang; kemudian eksperimen dijalankan ke atas pemodelan bahasa dan penjanaan dialog berasaskan dokumen dengan menyempurnakan model bahasa yang telah dilatih.

Isih

Input terdiri daripada token yang disampel mengikut taburan kebarangkalian ( tidak diketahui oleh sistem), matlamatnya adalah untuk menjana token mengikut urutan penurunan kekerapan dalam jujukan

mengikut urutan untuk mengkaji sama ada memori jangka panjang digunakan dengan berkesan, dan Transformer Sama ada ranking dilakukan hanya dengan memodelkan teg terkini, penyelidik mereka bentuk taburan kebarangkalian tag untuk berubah dari semasa ke semasa.

mengikut urutan untuk mengkaji sama ada memori jangka panjang digunakan dengan berkesan, dan Transformer Sama ada ranking dilakukan hanya dengan memodelkan teg terkini, penyelidik mereka bentuk taburan kebarangkalian tag untuk berubah dari semasa ke semasa.

Terdapat 20 token dalam perbendaharaan kata Eksperimen telah dijalankan dengan urutan panjang masing-masing 4,000, 8,000 dan 16,000 dan pengubah mampatan digunakan sebagai model garis dasar.

Hasil eksperimen dapat dilihat bahawa dalam kes panjang jujukan pendek (4,000), Transformer-XL mencapai ketepatan lebih tinggi sedikit daripada model lain tetapi apabila panjang jujukan meningkat, ketepatannya juga menurun dengan cepat, tetapi Untuk ∞-dahulu, penurunan ini tidak jelas, menunjukkan bahawa ia mempunyai lebih banyak kelebihan apabila memodelkan jujukan panjang.

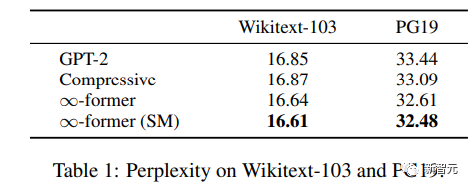

Pemodelan Bahasa

Untuk memahami sama ada ingatan jangka panjang boleh digunakan untuk melanjutkan pra-latihan Untuk model bahasa, penyelidik memperhalusi GPT-2 kecil pada subset Wikitext103 dan PG-19, termasuk kira-kira 200 juta token.

Hasil eksperimen dapat dilihat bahawa ∞-bekas dapat mengurangkan kekeliruan Wikitext-103 dan PG19, dan ∞ - Peningkatan yang diperoleh oleh bekas adalah lebih besar pada set data PG19 kerana buku lebih bergantung pada ingatan jangka panjang berbanding artikel Wikipedia.

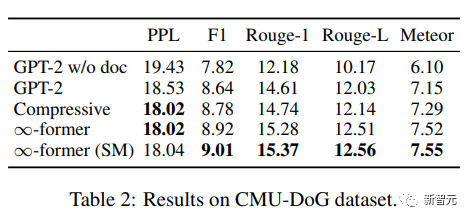

Dialog berasaskan dokumen

Dalam penjanaan dialog berasaskan dokumen, kecuali Sebagai tambahan kepada sejarah perbualan, model juga boleh mendapatkan dokumen tentang topik perbualan.

Dalam set data CMU Document Grounded Conversation (CMU-DoG), perbualan adalah mengenai filem dan ringkasan filem diberikan sebagai dokumen tambahan memandangkan perbualan itu mengandungi pelbagai berbeza Dalam wacana berterusan, dokumen tambahan dibahagikan kepada bahagian.

Untuk menilai kegunaan ingatan jangka panjang, penyelidik menjadikan tugasan lebih mencabar dengan hanya memberikan model akses kepada fail sebelum perbualan bermula.

Selepas menala halus GPT-2 kecil, untuk membolehkan model menyimpan keseluruhan dokumen dalam ingatan, LTM berterusan (∞-bekas) dengan fungsi asas N=512 adalah digunakan untuk memanjangkan GPT -2.

Untuk menilai kesan model, gunakan kebingungan, skor F1, Rouge-1 dan Rouge-L serta penunjuk Meteor.

Daripada keputusan, ∞-bekas dan mampatan Transformer boleh menjana korpus yang lebih baik, walaupun kekeliruan antara kedua-dua Darjah pada asasnya adalah sama, tetapi ∞-bekas mencapai skor yang lebih baik pada penunjuk lain.

Atas ialah kandungan terperinci 5 juta token raksasa, baca keseluruhan 'Harry Potter' sekali gus! Lebih daripada 1000 kali lebih lama daripada ChatGPT. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

phpmyadmin mencipta jadual data

Apr 10, 2025 pm 11:00 PM

phpmyadmin mencipta jadual data

Apr 10, 2025 pm 11:00 PM

Untuk membuat jadual data menggunakan phpmyadmin, langkah -langkah berikut adalah penting: Sambungkan ke pangkalan data dan klik tab baru. Namakan jadual dan pilih enjin penyimpanan (disyorkan innoDB). Tambah butiran lajur dengan mengklik butang Tambah Lajur, termasuk nama lajur, jenis data, sama ada untuk membenarkan nilai null, dan sifat lain. Pilih satu atau lebih lajur sebagai kunci utama. Klik butang Simpan untuk membuat jadual dan lajur.

Cara Membuat Pangkalan Data Oracle Cara Membuat Pangkalan Data Oracle

Apr 11, 2025 pm 02:33 PM

Cara Membuat Pangkalan Data Oracle Cara Membuat Pangkalan Data Oracle

Apr 11, 2025 pm 02:33 PM

Mewujudkan pangkalan data Oracle tidak mudah, anda perlu memahami mekanisme asas. 1. Anda perlu memahami konsep pangkalan data dan Oracle DBMS; 2. Menguasai konsep teras seperti SID, CDB (pangkalan data kontena), PDB (pangkalan data pluggable); 3. Gunakan SQL*Plus untuk membuat CDB, dan kemudian buat PDB, anda perlu menentukan parameter seperti saiz, bilangan fail data, dan laluan; 4. Aplikasi lanjutan perlu menyesuaikan set aksara, memori dan parameter lain, dan melakukan penalaan prestasi; 5. Beri perhatian kepada ruang cakera, keizinan dan parameter, dan terus memantau dan mengoptimumkan prestasi pangkalan data. Hanya dengan menguasai ia dengan mahir memerlukan amalan yang berterusan, anda boleh benar -benar memahami penciptaan dan pengurusan pangkalan data Oracle.

Cara Membuat Pangkalan Data Oracle Cara Membuat Pangkalan Data Oracle

Apr 11, 2025 pm 02:36 PM

Cara Membuat Pangkalan Data Oracle Cara Membuat Pangkalan Data Oracle

Apr 11, 2025 pm 02:36 PM

Untuk membuat pangkalan data Oracle, kaedah biasa adalah menggunakan alat grafik DBCA. Langkah -langkah adalah seperti berikut: 1. Gunakan alat DBCA untuk menetapkan DBName untuk menentukan nama pangkalan data; 2. Tetapkan SYSPASSWORD dan SYSTEMPASSWORD kepada kata laluan yang kuat; 3. Tetapkan aksara dan NationalCharacterset ke Al32utf8; 4. Tetapkan MemorySize dan Tablespacesize untuk menyesuaikan mengikut keperluan sebenar; 5. Tentukan laluan logfile. Kaedah lanjutan dibuat secara manual menggunakan arahan SQL, tetapi lebih kompleks dan terdedah kepada kesilapan. Perhatikan kekuatan kata laluan, pemilihan set aksara, saiz dan memori meja makan

Cara Menulis Penyataan Pangkalan Data Oracle

Apr 11, 2025 pm 02:42 PM

Cara Menulis Penyataan Pangkalan Data Oracle

Apr 11, 2025 pm 02:42 PM

Inti dari pernyataan Oracle SQL adalah pilih, masukkan, mengemas kini dan memadam, serta aplikasi fleksibel dari pelbagai klausa. Adalah penting untuk memahami mekanisme pelaksanaan di sebalik pernyataan, seperti pengoptimuman indeks. Penggunaan lanjutan termasuk subqueries, pertanyaan sambungan, fungsi analisis, dan PL/SQL. Kesilapan umum termasuk kesilapan sintaks, isu prestasi, dan isu konsistensi data. Amalan terbaik pengoptimuman prestasi melibatkan menggunakan indeks yang sesuai, mengelakkan pilih *, mengoptimumkan di mana klausa, dan menggunakan pembolehubah terikat. Menguasai Oracle SQL memerlukan amalan, termasuk penulisan kod, debugging, berfikir dan memahami mekanisme asas.

Cara Menambah, Ubah Suai dan Padam Panduan Operasi Lapangan Jadual MySQL Data

Apr 11, 2025 pm 05:42 PM

Cara Menambah, Ubah Suai dan Padam Panduan Operasi Lapangan Jadual MySQL Data

Apr 11, 2025 pm 05:42 PM

Panduan Operasi Lapangan di MySQL: Tambah, mengubah suai, dan memadam medan. Tambahkan medan: alter table table_name tambah column_name data_type [not null] [default default_value] [primary kekunci] [AUTO_INCREMENT] Modify Field: Alter Table Table_Name Ubah suai column_name data_type [not null] [default default_value] [Kunci Utama]

Apakah kekangan integriti jadual pangkalan data Oracle?

Apr 11, 2025 pm 03:42 PM

Apakah kekangan integriti jadual pangkalan data Oracle?

Apr 11, 2025 pm 03:42 PM

Kekangan integriti pangkalan data Oracle dapat memastikan ketepatan data, termasuk: tidak null: nilai null dilarang; Unik: Keunikan menjamin, membolehkan nilai null tunggal; Kunci utama: kekangan utama utama, menguatkan unik, dan melarang nilai null; Kunci asing: Mengekalkan hubungan antara jadual, kunci asing merujuk kepada kunci utama jadual utama; Semak: Hadkan nilai lajur mengikut syarat.

Penjelasan terperinci mengenai contoh pertanyaan bersarang dalam pangkalan data MySQL

Apr 11, 2025 pm 05:48 PM

Penjelasan terperinci mengenai contoh pertanyaan bersarang dalam pangkalan data MySQL

Apr 11, 2025 pm 05:48 PM

Pertanyaan bersarang adalah cara untuk memasukkan pertanyaan lain dalam satu pertanyaan. Mereka digunakan terutamanya untuk mendapatkan data yang memenuhi syarat kompleks, mengaitkan pelbagai jadual, dan mengira nilai ringkasan atau maklumat statistik. Contohnya termasuk mencari pekerja di atas gaji purata, mencari pesanan untuk kategori tertentu, dan mengira jumlah jumlah pesanan bagi setiap produk. Apabila menulis pertanyaan bersarang, anda perlu mengikuti: Tulis subqueries, tulis hasilnya kepada pertanyaan luar (dirujuk dengan alias atau sebagai klausa), dan mengoptimumkan prestasi pertanyaan (menggunakan indeks).

Apa yang dilakukan Oracle

Apr 11, 2025 pm 06:06 PM

Apa yang dilakukan Oracle

Apr 11, 2025 pm 06:06 PM

Oracle adalah syarikat perisian Sistem Pengurusan Pangkalan Data (DBMS) terbesar di dunia. Produk utamanya termasuk fungsi berikut: Sistem Pengurusan Pengurusan Pangkalan Data Relasi (Oracle Database) Alat Pembangunan (Oracle Apex, Oracle Visual Builder) Middleware (Oracle Weblogic Server, Oracle SOA Suite) Analisis Awan (Oracle Cloud Infrastructure)