Peranti teknologi

Peranti teknologi

AI

AI

Pukul LLaMA? Kedudukan 'Falcon' yang paling berkuasa dalam sejarah diragui, Fu Yao secara peribadi menguji 7 baris kod, dan LeCun memajukannya untuk menyukai

Pukul LLaMA? Kedudukan 'Falcon' yang paling berkuasa dalam sejarah diragui, Fu Yao secara peribadi menguji 7 baris kod, dan LeCun memajukannya untuk menyukai

Pukul LLaMA? Kedudukan 'Falcon' yang paling berkuasa dalam sejarah diragui, Fu Yao secara peribadi menguji 7 baris kod, dan LeCun memajukannya untuk menyukai

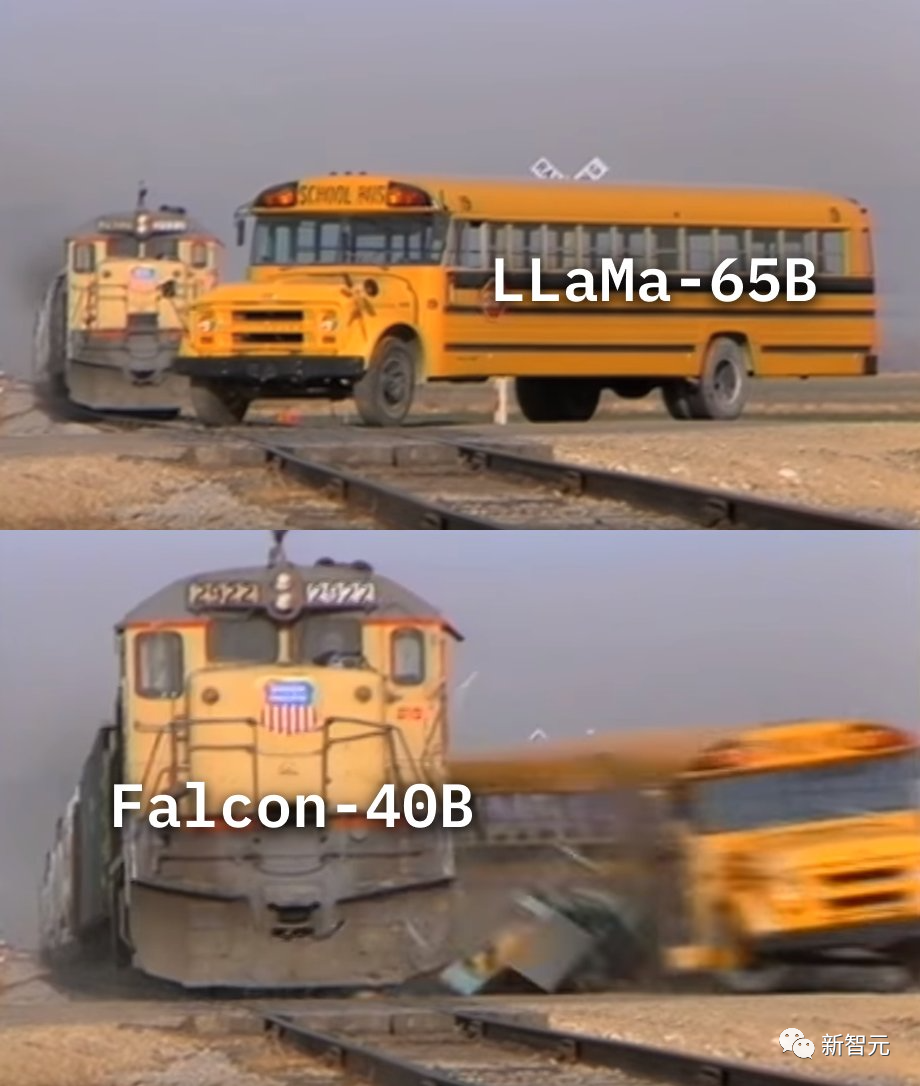

Beberapa masa lalu, Falcon yang masih muda telah menghancurkan LLaMA dalam kedudukan LLM, menyebabkan gelombang dalam seluruh komuniti.

Tetapi, adakah Falcon benar-benar lebih baik daripada LLaMA?

Jawapan ringkas: Mungkin tidak.

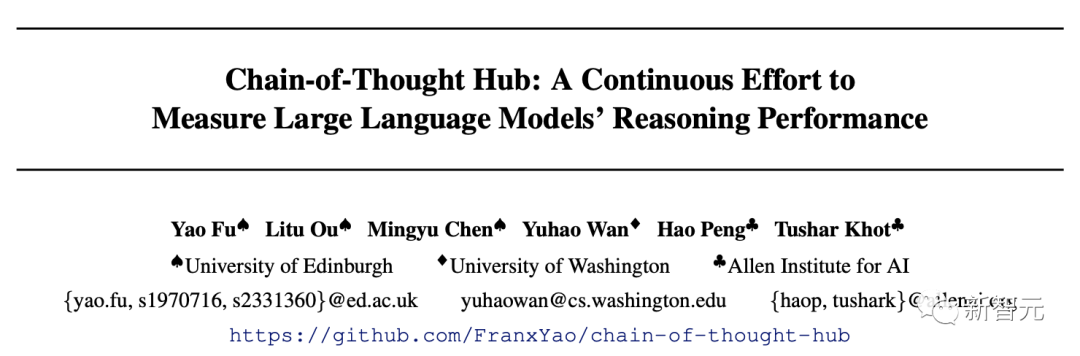

Pasukan Fu Yao menjalankan penilaian model yang lebih mendalam:

"Kami Penilaian LLaMA 65B telah diterbitkan semula pada MMLU dan mencapai skor 61.4, yang hampir dengan skor rasmi (63.4), jauh lebih tinggi daripada skornya pada Papan Pendahulu LLM Terbuka (48.8), dan jauh lebih tinggi daripada Falcon ( 52.7).”

Tiada kejuruteraan pantas yang mewah, tiada penyahkodan yang mewah, semuanya adalah tetapan lalai.

Pada masa ini, kod dan kaedah ujian telah didedahkan kepada umum di Github.

Terdapat keraguan tentang Falcons mengatasi LLaMA, LeCun menyatakan pendiriannya, masalah skrip ujian...

LLaMA adalah benar· Kekuatan

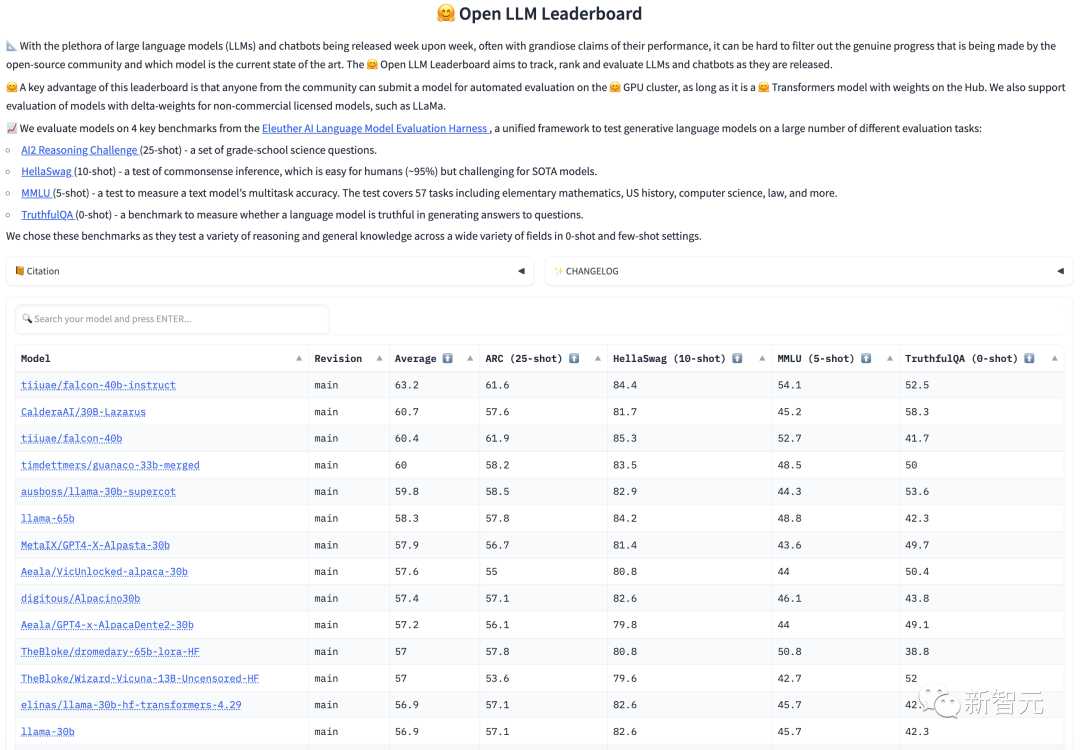

Pada masa ini dalam ranking OpenLLM, Falcon menduduki tempat pertama, mengatasi LLaMA, dan sangat disyorkan oleh penyelidik termasuk Thomas Wolf.

Namun, sesetengah orang mempunyai keraguan mereka.

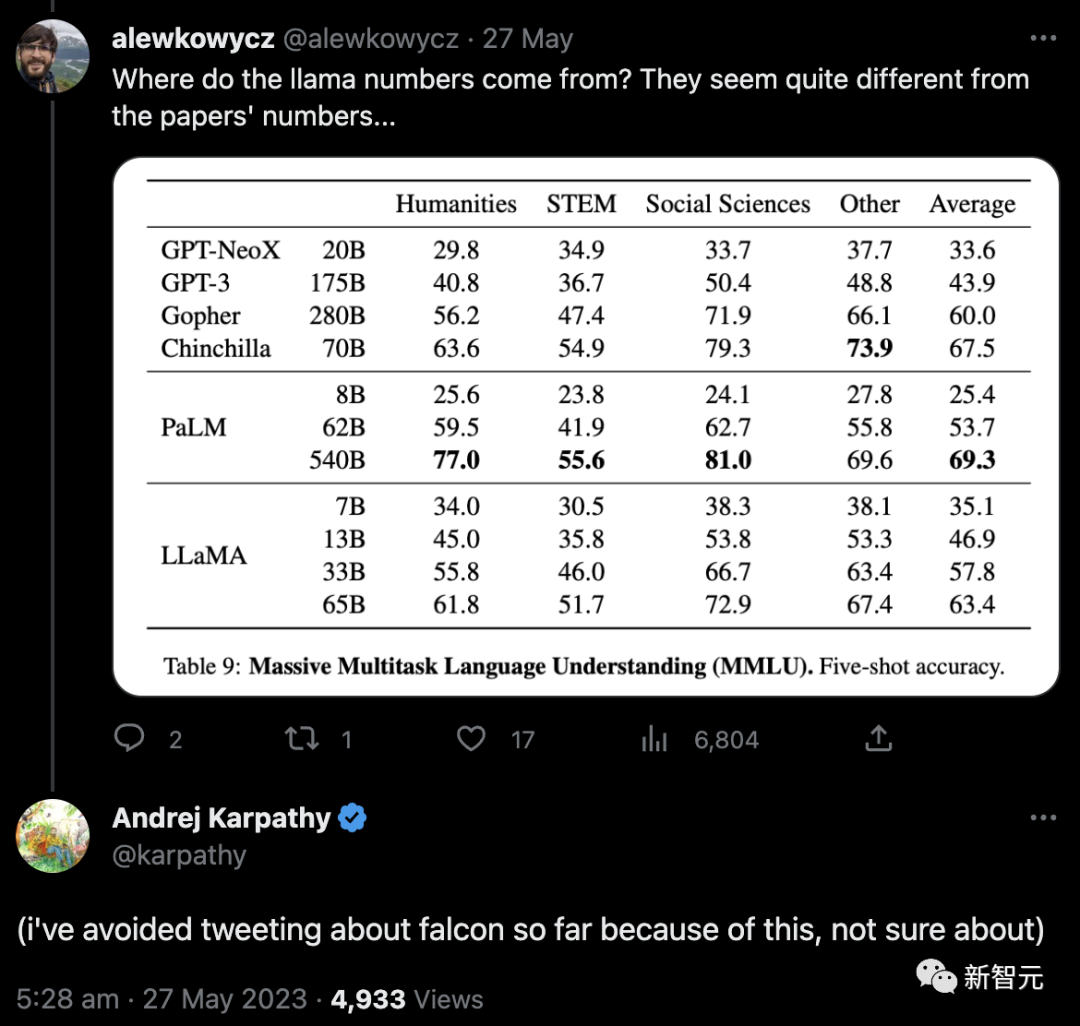

Pertama, netizen mempersoalkan dari mana datangnya nombor LLaMA ini nampaknya tidak konsisten dengan nombor dalam kertas...

Seterusnya, saintis OpenAI Andrej Karpathy turut menyatakan kebimbangan tentang sebab skor LLaMA 65B pada kedudukan LLM Terbuka jauh lebih rendah daripada kedudukan rasmi (48.8 berbanding 63.4).

Dan siaran, setakat ini saya telah mengelak daripada tweet tentang Falcons kerana ini, tidak pasti.

Untuk menjelaskan masalah ini, Fu Yao dan ahli pasukan memutuskan untuk menjalankan ujian awam pada LLaMA 65B, dan keputusannya ialah 61.4 mata.

Dalam ujian, penyelidik tidak menggunakan sebarang mekanisme khas, dan LLaMA 65B dapat mencapai skor ini.

Hasil ini hanya membuktikan bahawa jika anda mahu model mencapai tahap yang hampir dengan GPT-3.5, sebaiknya gunakan RLHF pada LLaMA 65B.

Berdasarkan penemuan kertas kerja Chain-of-Thought Hub yang diterbitkan baru-baru ini oleh pasukan Fu Yao.

Sudah tentu, Fu Yao berkata bahawa penilaian mereka tidak bertujuan untuk menimbulkan pertikaian antara LLaMA dan Falcon Lagipun, ini adalah sumber terbuka yang hebat projek. Model telah memberikan sumbangan besar kepada bidang ini!

Selain itu, Falcon mempunyai lesen yang lebih mudah, yang juga memberikan potensi pembangunan yang hebat.

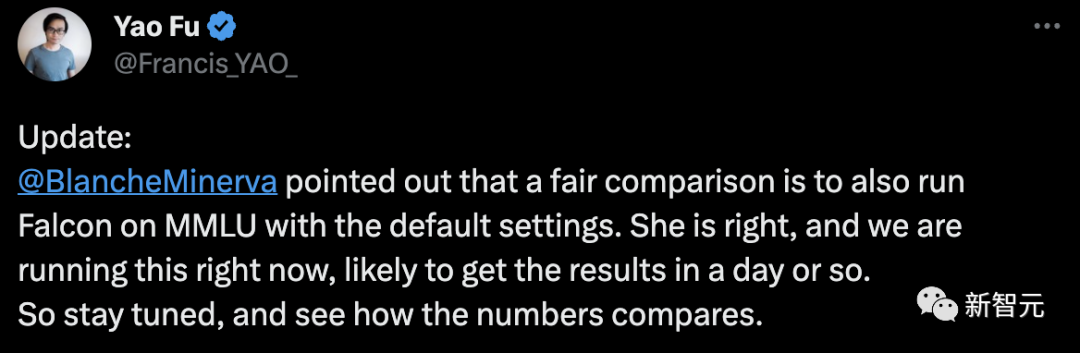

Untuk ulasan terbaharu ini, netizen BlancheMinerva menegaskan bahawa perbandingan yang adil adalah untuk menjalankan Falcon pada MMLU di bawah tetapan lalai.

Sehubungan itu, Fu Yao berkata bahawa ini adalah betul dan kerja sedang dijalankan dan hasilnya dijangka tersedia dalam satu hari.

Tidak kira apa keputusan akhir, anda mesti tahu bahawa gunung GPT-4 adalah matlamat yang sangat ingin dicapai oleh komuniti sumber terbuka kejar.

Masalah ranking OpenLLM

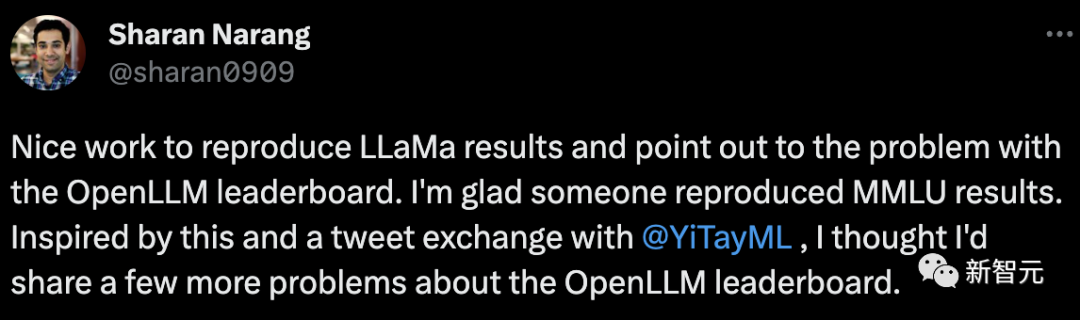

Penyelidik dari Meta memuji Fu Yao kerana menghasilkan semula keputusan LLaMa dengan baik dan menunjukkan masalah ranking OpenLLM.

Pada masa yang sama, beliau turut berkongsi beberapa soalan mengenai kedudukan OpenLLM.

Pertama, keputusan MMLU: Keputusan MMLU LLaMa 65B ialah 15 mata pada papan pendahulu, tetapi adalah sama untuk model 7B. Terdapat juga jurang prestasi kecil antara model 13B dan 30B.

OpenLLM benar-benar perlu melihat perkara ini sebelum mengumumkan model mana yang terbaik.

Tanda aras: Bagaimanakah penanda aras ini dipilih?

Pukulan ARC 25 dan pukulan Hellaswag 10 nampaknya tidak begitu relevan dengan LLM. Adalah lebih baik jika beberapa penanda aras generatif boleh dimasukkan. Walaupun tanda aras generatif mempunyai hadnya, ia masih boleh berguna.

Skor Purata Tunggal: Ia sentiasa menarik untuk mengurangkan keputusan kepada skor tunggal dan skor purata adalah paling mudah.

Tetapi dalam kes ini, adakah purata 4 penanda aras benar-benar berguna? Adakah mendapat 1 mata di MMLU sama dengan mendapat 1 mata di HellaSwag?

Dalam dunia lelaran pesat LLM, pasti ada nilai dalam membangunkan senarai kedudukan sedemikian.

Dan Lucas Beyer, seorang penyelidik dari Google, turut menyatakan pendapatnya,

Gila Ya, Penyelidik NLP mempunyai pemahaman yang berbeza tentang penanda aras yang sama, sekali gus membawa kepada keputusan yang sama sekali berbeza. Pada masa yang sama, setiap kali salah seorang rakan sekerja saya melaksanakan metrik, saya segera bertanya kepada mereka sama ada mereka benar-benar menyemak pengeluaran semula kod rasmi yang sempurna, dan jika tidak, buang keputusan mereka.

Selain itu, dia berkata setakat yang saya tahu, tanpa mengira model, ia sebenarnya tidak mengeluarkan semula hasil penanda aras asal.

Netizen bergema bahawa ini adalah realiti penanda aras LLM...

Falcon - sumber terbuka, tersedia secara komersil, prestasi yang kukuh

Bercakap tentang Falcon, ia sebenarnya bernilai semakan yang baik.

Menurut LeCun, dalam era model besar, sumber terbuka adalah yang paling penting.

Selepas kod LLaMA Meta dibocorkan, pembangun dari semua lapisan masyarakat mula bersemangat untuk mencubanya.

Falcon ialah senjata menakjubkan yang dibangunkan oleh Institut Inovasi Teknologi (TII) di Abu Dhabi, Emiriah Arab Bersatu.

Dari segi prestasi ketika pertama kali dikeluarkan, Falcon menunjukkan prestasi yang lebih baik daripada LLaMA.

Pada masa ini, "Falcon" mempunyai tiga versi - 1B, 7B dan 40B.

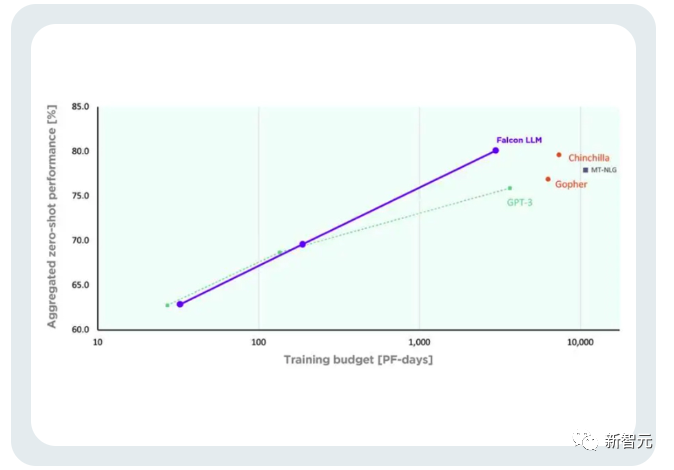

TII berkata Falcon ialah model bahasa sumber terbuka paling berkuasa setakat ini. Versi terbesarnya, Falcon 40B, mempunyai 40 bilion parameter, yang masih sedikit lebih kecil dalam skala daripada LLaMA, yang mempunyai 65 bilion parameter.

Walau bagaimanapun, TII sebelum ini telah menyatakan bahawa walaupun saiznya kecil, Falcon mempunyai prestasi yang hebat.

Faisal Al Bannai, Setiausaha Agung Majlis Penyelidikan Teknologi Lanjutan (ATRC), percaya bahawa pengeluaran "Falcon" akan memecahkan jalan untuk mendapatkan LLM dan membolehkan penyelidik dan usahawan mencadangkan penyelesaian terbaik.

Dua versi FalconLM, Falcon 40B Instruct dan Falcon 40B, berada di antara dua teratas dalam ranking OpenLLM Hugging Face, manakala LLaMA Meta Terletak di tempat ketiga.

Masalah dengan kedudukan yang disebutkan di atas adalah betul-betul ini.

Walaupun kertas "Falcon" belum lagi dikeluarkan secara terbuka, Falcon 40B telah dilatih secara meluas mengenai set data rangkaian token 1 trilion yang disaring dengan teliti.

Penyelidik telah mendedahkan bahawa "Falcon" sangat mementingkan kepentingan mencapai prestasi tinggi pada data berskala besar semasa proses latihan.

Apa yang kita semua tahu ialah LLM sangat sensitif terhadap kualiti data latihan, itulah sebabnya penyelidik menghabiskan banyak usaha untuk membina sistem yang boleh melakukan pemprosesan yang cekap pada puluhan beribu-ribu saluran paip data teras CPU.

Tujuannya adalah untuk mengekstrak kandungan berkualiti tinggi daripada Internet berdasarkan penapisan dan penyahduplikasian.

Pada masa ini, TII telah mengeluarkan set data rangkaian yang diperhalusi, iaitu set data yang ditapis dan dinyahduplikasi dengan teliti. Amalan telah membuktikan bahawa ia sangat berkesan.

Model yang dilatih menggunakan set data ini sahaja boleh setanding dengan LLM lain, atau bahkan mengatasinya dalam prestasi. Ini menunjukkan kualiti dan pengaruh "Falcon" yang sangat baik.

Selain itu, model Falcon juga mempunyai keupayaan berbilang bahasa.

Ia memahami bahasa Inggeris, Jerman, Sepanyol dan Perancis, dan beberapa bahasa Eropah kecil seperti Belanda, Itali, Romania, Portugis, Czech, Poland dan Sweden yang saya juga tahu banyak tentang ia.

Falcon 40B ialah model sumber terbuka kedua selepas keluaran model H2O.ai.

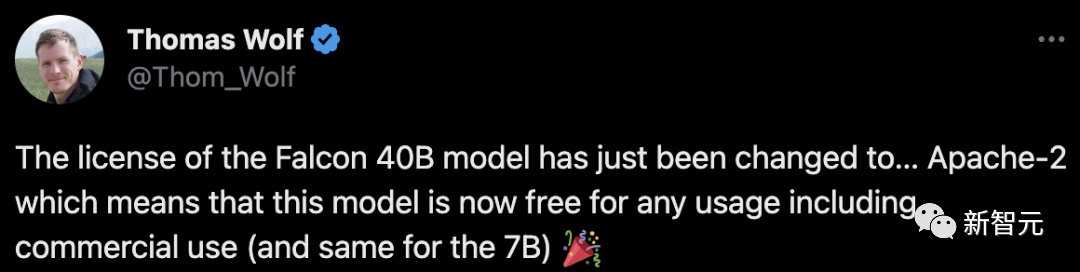

Selain itu, terdapat satu lagi perkara yang sangat penting - Falcon kini merupakan satu-satunya model sumber terbuka yang boleh digunakan secara percuma secara komersial.

Pada awalnya, TII menghendaki bahawa jika Falcon digunakan untuk tujuan komersial dan menjana lebih daripada $1 juta dalam pendapatan boleh diagihkan, 10% "cukai penggunaan" akan dikenakan.

Tetapi tidak mengambil masa lama untuk taikun Timur Tengah yang kaya untuk menarik balik sekatan ini.

Sekurang-kurangnya buat masa ini, semua penggunaan komersial dan penalaan halus Falcon adalah percuma.

Orang kaya berkata bahawa mereka tidak perlu menjana wang melalui model ini buat masa ini.

Selain itu, TII juga meminta rancangan pengkomersilan dari seluruh dunia.

Untuk penyelesaian penyelidikan saintifik dan pengkomersilan yang berpotensi, mereka juga akan menyediakan lebih banyak "sokongan kuasa pengkomputeran latihan" atau menyediakan peluang pengkomersilan selanjutnya.

Ini bermaksud: Selagi projek itu bagus, model itu percuma! Kuasa pengkomputeran yang mencukupi! Jika anda tidak mempunyai wang yang mencukupi, kami masih boleh mengumpulnya untuk anda!

Untuk pemula, ini hanyalah "penyelesaian sehenti untuk keusahawanan model besar AI" daripada taikun Timur Tengah.

Menurut pasukan pembangunan, aspek penting kelebihan daya saing FalconLM ialah pemilihan data latihan.

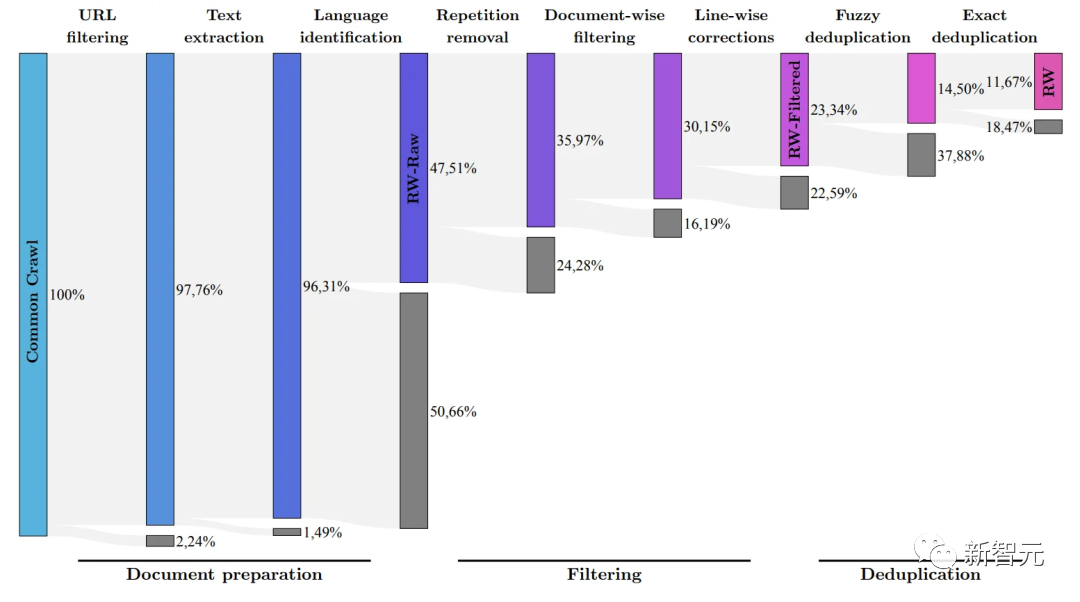

Pasukan penyelidik membangunkan proses untuk mengekstrak data berkualiti tinggi daripada set data rangkak awam dan mengalih keluar data pendua.

Selepas pembersihan menyeluruh kandungan berlebihan dan pendua, 5 trilion token telah dikekalkan - cukup untuk melatih model bahasa yang berkuasa.

40B Falcon LM menggunakan 1 trilion token untuk latihan, dan versi 7B model menggunakan 1.5 trilion token untuk latihan.

(Pasukan penyelidik bertujuan untuk menapis hanya data mentah berkualiti tinggi daripada Common Crawl menggunakan set data RefinedWeb)

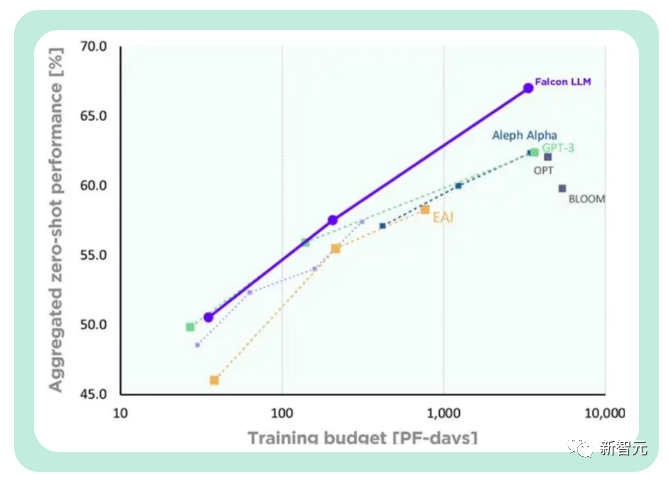

Selain itu, kos latihan Falcon secara relatifnya lebih terkawal.

TII menyatakan bahawa berbanding dengan GPT-3, Falcon mencapai peningkatan prestasi yang ketara sambil menggunakan hanya 75% daripada belanjawan pengkomputeran latihan.

Dan ia hanya memerlukan 20% daripada masa pengiraan semasa inferens, yang telah berjaya dilaksanakan Penggunaan yang cekap bagi sumber pengkomputeran.

Atas ialah kandungan terperinci Pukul LLaMA? Kedudukan 'Falcon' yang paling berkuasa dalam sejarah diragui, Fu Yao secara peribadi menguji 7 baris kod, dan LeCun memajukannya untuk menyukai. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

Model MoE sumber terbuka paling berkuasa di dunia ada di sini, dengan keupayaan bahasa Cina setanding dengan GPT-4, dan harganya hanya hampir satu peratus daripada GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Model MoE sumber terbuka paling berkuasa di dunia ada di sini, dengan keupayaan bahasa Cina setanding dengan GPT-4, dan harganya hanya hampir satu peratus daripada GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Bayangkan model kecerdasan buatan yang bukan sahaja mempunyai keupayaan untuk mengatasi pengkomputeran tradisional, tetapi juga mencapai prestasi yang lebih cekap pada kos yang lebih rendah. Ini bukan fiksyen sains, DeepSeek-V2[1], model MoE sumber terbuka paling berkuasa di dunia ada di sini. DeepSeek-V2 ialah gabungan model bahasa pakar (MoE) yang berkuasa dengan ciri-ciri latihan ekonomi dan inferens yang cekap. Ia terdiri daripada 236B parameter, 21B daripadanya digunakan untuk mengaktifkan setiap penanda. Berbanding dengan DeepSeek67B, DeepSeek-V2 mempunyai prestasi yang lebih kukuh, sambil menjimatkan 42.5% kos latihan, mengurangkan cache KV sebanyak 93.3% dan meningkatkan daya pemprosesan penjanaan maksimum kepada 5.76 kali. DeepSeek ialah sebuah syarikat yang meneroka kecerdasan buatan am

Apr 09, 2024 am 11:52 AM

Apr 09, 2024 am 11:52 AM

AI memang mengubah matematik. Baru-baru ini, Tao Zhexuan, yang telah mengambil perhatian terhadap isu ini, telah memajukan keluaran terbaru "Buletin Persatuan Matematik Amerika" (Buletin Persatuan Matematik Amerika). Memfokuskan pada topik "Adakah mesin akan mengubah matematik?", ramai ahli matematik menyatakan pendapat mereka Seluruh proses itu penuh dengan percikan api, tegar dan menarik. Penulis mempunyai barisan yang kuat, termasuk pemenang Fields Medal Akshay Venkatesh, ahli matematik China Zheng Lejun, saintis komputer NYU Ernest Davis dan ramai lagi sarjana terkenal dalam industri. Dunia AI telah berubah secara mendadak Anda tahu, banyak artikel ini telah dihantar setahun yang lalu.

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas secara rasmi memasuki era robot elektrik! Semalam, Atlas hidraulik hanya "menangis" menarik diri daripada peringkat sejarah Hari ini, Boston Dynamics mengumumkan bahawa Atlas elektrik sedang berfungsi. Nampaknya dalam bidang robot humanoid komersial, Boston Dynamics berazam untuk bersaing dengan Tesla. Selepas video baharu itu dikeluarkan, ia telah pun ditonton oleh lebih sejuta orang dalam masa sepuluh jam sahaja. Orang lama pergi dan peranan baru muncul. Ini adalah keperluan sejarah. Tidak dinafikan bahawa tahun ini adalah tahun letupan robot humanoid. Netizen mengulas: Kemajuan robot telah menjadikan majlis pembukaan tahun ini kelihatan seperti manusia, dan tahap kebebasan adalah jauh lebih besar daripada manusia Tetapi adakah ini benar-benar bukan filem seram? Pada permulaan video, Atlas berbaring dengan tenang di atas tanah, seolah-olah terlentang. Apa yang berikut adalah rahang-jatuh

KAN, yang menggantikan MLP, telah diperluaskan kepada konvolusi oleh projek sumber terbuka

Jun 01, 2024 pm 10:03 PM

KAN, yang menggantikan MLP, telah diperluaskan kepada konvolusi oleh projek sumber terbuka

Jun 01, 2024 pm 10:03 PM

Awal bulan ini, penyelidik dari MIT dan institusi lain mencadangkan alternatif yang sangat menjanjikan kepada MLP - KAN. KAN mengatasi MLP dari segi ketepatan dan kebolehtafsiran. Dan ia boleh mengatasi prestasi MLP berjalan dengan bilangan parameter yang lebih besar dengan bilangan parameter yang sangat kecil. Sebagai contoh, penulis menyatakan bahawa mereka menggunakan KAN untuk menghasilkan semula keputusan DeepMind dengan rangkaian yang lebih kecil dan tahap automasi yang lebih tinggi. Khususnya, MLP DeepMind mempunyai kira-kira 300,000 parameter, manakala KAN hanya mempunyai kira-kira 200 parameter. KAN mempunyai asas matematik yang kukuh seperti MLP berdasarkan teorem penghampiran universal, manakala KAN berdasarkan teorem perwakilan Kolmogorov-Arnold. Seperti yang ditunjukkan dalam rajah di bawah, KAN telah

Google gembira: prestasi JAX mengatasi Pytorch dan TensorFlow! Ia mungkin menjadi pilihan terpantas untuk latihan inferens GPU

Apr 01, 2024 pm 07:46 PM

Google gembira: prestasi JAX mengatasi Pytorch dan TensorFlow! Ia mungkin menjadi pilihan terpantas untuk latihan inferens GPU

Apr 01, 2024 pm 07:46 PM

Prestasi JAX, yang dipromosikan oleh Google, telah mengatasi Pytorch dan TensorFlow dalam ujian penanda aras baru-baru ini, menduduki tempat pertama dalam 7 penunjuk. Dan ujian tidak dilakukan pada TPU dengan prestasi JAX terbaik. Walaupun dalam kalangan pembangun, Pytorch masih lebih popular daripada Tensorflow. Tetapi pada masa hadapan, mungkin lebih banyak model besar akan dilatih dan dijalankan berdasarkan platform JAX. Model Baru-baru ini, pasukan Keras menanda aras tiga hujung belakang (TensorFlow, JAX, PyTorch) dengan pelaksanaan PyTorch asli dan Keras2 dengan TensorFlow. Pertama, mereka memilih satu set arus perdana

Robot Tesla bekerja di kilang, Musk: Tahap kebebasan tangan akan mencapai 22 tahun ini!

May 06, 2024 pm 04:13 PM

Robot Tesla bekerja di kilang, Musk: Tahap kebebasan tangan akan mencapai 22 tahun ini!

May 06, 2024 pm 04:13 PM

Video terbaru robot Tesla Optimus dikeluarkan, dan ia sudah boleh berfungsi di kilang. Pada kelajuan biasa, ia mengisih bateri (bateri 4680 Tesla) seperti ini: Pegawai itu juga mengeluarkan rupanya pada kelajuan 20x - pada "stesen kerja" kecil, memilih dan memilih dan memilih: Kali ini ia dikeluarkan Salah satu sorotan video itu ialah Optimus menyelesaikan kerja ini di kilang, sepenuhnya secara autonomi, tanpa campur tangan manusia sepanjang proses. Dan dari perspektif Optimus, ia juga boleh mengambil dan meletakkan bateri yang bengkok, memfokuskan pada pembetulan ralat automatik: Berkenaan tangan Optimus, saintis NVIDIA Jim Fan memberikan penilaian yang tinggi: Tangan Optimus adalah robot lima jari di dunia paling cerdik. Tangannya bukan sahaja boleh disentuh

FisheyeDetNet: algoritma pengesanan sasaran pertama berdasarkan kamera fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: algoritma pengesanan sasaran pertama berdasarkan kamera fisheye

Apr 26, 2024 am 11:37 AM

Pengesanan objek ialah masalah yang agak matang dalam sistem pemanduan autonomi, antaranya pengesanan pejalan kaki adalah salah satu algoritma terawal untuk digunakan. Penyelidikan yang sangat komprehensif telah dijalankan dalam kebanyakan kertas kerja. Walau bagaimanapun, persepsi jarak menggunakan kamera fisheye untuk pandangan sekeliling agak kurang dikaji. Disebabkan herotan jejari yang besar, perwakilan kotak sempadan standard sukar dilaksanakan dalam kamera fisheye. Untuk mengurangkan perihalan di atas, kami meneroka kotak sempadan lanjutan, elips dan reka bentuk poligon am ke dalam perwakilan kutub/sudut dan mentakrifkan metrik mIOU pembahagian contoh untuk menganalisis perwakilan ini. Model fisheyeDetNet yang dicadangkan dengan bentuk poligon mengatasi model lain dan pada masa yang sama mencapai 49.5% mAP pada set data kamera fisheye Valeo untuk pemanduan autonomi

DualBEV: mengatasi BEVFormer dan BEVDet4D dengan ketara, buka buku!

Mar 21, 2024 pm 05:21 PM

DualBEV: mengatasi BEVFormer dan BEVDet4D dengan ketara, buka buku!

Mar 21, 2024 pm 05:21 PM

Kertas kerja ini meneroka masalah mengesan objek dengan tepat dari sudut pandangan yang berbeza (seperti perspektif dan pandangan mata burung) dalam pemanduan autonomi, terutamanya cara mengubah ciri dari perspektif (PV) kepada ruang pandangan mata burung (BEV) dengan berkesan dilaksanakan melalui modul Transformasi Visual (VT). Kaedah sedia ada secara amnya dibahagikan kepada dua strategi: penukaran 2D kepada 3D dan 3D kepada 2D. Kaedah 2D-ke-3D meningkatkan ciri 2D yang padat dengan meramalkan kebarangkalian kedalaman, tetapi ketidakpastian yang wujud dalam ramalan kedalaman, terutamanya di kawasan yang jauh, mungkin menimbulkan ketidaktepatan. Manakala kaedah 3D ke 2D biasanya menggunakan pertanyaan 3D untuk mencuba ciri 2D dan mempelajari berat perhatian bagi kesesuaian antara ciri 3D dan 2D melalui Transformer, yang meningkatkan masa pengiraan dan penggunaan.