Peranti teknologi

Peranti teknologi

AI

AI

DeepMind melancarkan algoritma pengisihan yang mengejutkan, dan perpustakaan C++ sedang sibuk mengemas kini!

DeepMind melancarkan algoritma pengisihan yang mengejutkan, dan perpustakaan C++ sedang sibuk mengemas kini!

DeepMind melancarkan algoritma pengisihan yang mengejutkan, dan perpustakaan C++ sedang sibuk mengemas kini!

Klik untuk mengambil bahagian dalam soal selidik tinjauan kandungan laman web 51CTO

Disusun | Wang Ruiping, Yan Zheng

AlphaGo mempunyai seorang lagi "adik lelaki" yang menyertai!

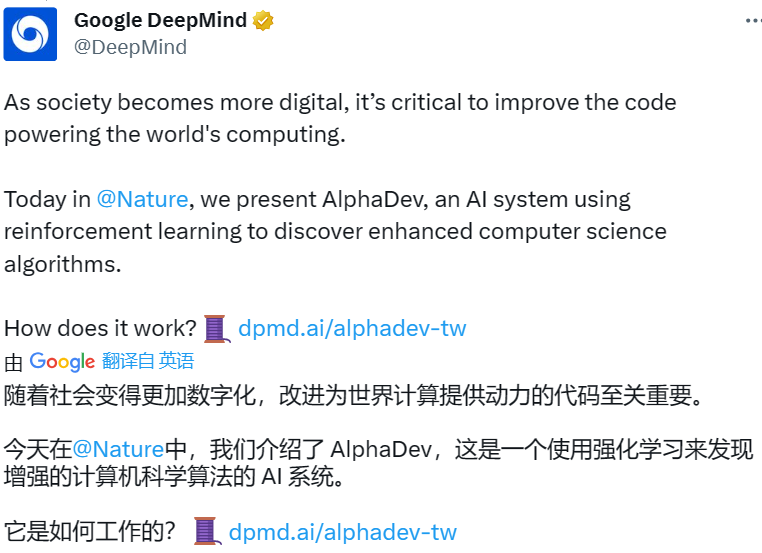

Google DeepMind "melancarkan" siri Alpha ke dalam algoritma pengisihan dan melancarkan AlphaDev.

Ia seperti "kaedah rahsia pembangunan". Dengan menggunakan AI pembelajaran pengukuhan untuk menemui algoritma pengisihan dan algoritma pencincangan, ia secara paksa mempercepatkan algoritma yang direka oleh pengaturcara manusia sebanyak kira-kira 70% dan 30% masing-masing.

Sebaik sahaja hasil penyelidikan dikeluarkan, mereka serta-merta menyalakan bulatan perisian! Tiba-tiba, kelajuan berjalan berjuta-juta perisian di seluruh dunia melonjak, secara langsung mengatasi pencapaian saintis dan jurutera selama beberapa dekad, dan perpustakaan C++ standard LLVM yang tidak dikemas kini dalam sepuluh tahun telah dikemas kini.

(Sumber: Nature)

Ini juga merupakan teknologi mengganggu yang dilancarkan selepas penggabungan dua jabatan AI Google. Kertas kerja itu diterbitkan dalam Nature di bawah tajuk "Algoritma pengisihan lebih pantas ditemui menggunakan pembelajaran pengukuhan mendalam". Pengarang pertama kertas itu ialah Daniel Mankowitz, seorang saintis komputer di DeepMind.

1. Evolusi: Asal-usul algoritma pengisihan

Isih ialah kaedah menyusun banyak item dalam susunan tertentu, contohnya, tiga huruf dalam susunan abjad, daripada terbesar hingga terkecil Jujukan lima nombor atau mengisih pangkalan data yang mengandungi berjuta-juta rekod.

Kaedah pesanan boleh dikesan kembali ke abad kedua hingga ketiga dan masih berkembang. Pada mulanya, para ulama menyusun secara manual beribu-ribu buku di rak Perpustakaan Iskandariah mengikut susunan abjad.

Selepas Revolusi Perindustrian, mesin pengisih sendiri—mesin penjadual yang menyimpan maklumat pada kad tebuk—dicipta untuk mengumpul hasil Banci A.S. 1890.

Pada tahun 1950-an, komputer komersial mula meningkat, dan algoritma pengisihan segera dihasilkan. Masukkan beberapa nombor yang tidak diisih ke dalam algoritma pengisihan dan ia akan menghasilkan urutan nombor yang diisih.

Banyak teknik dan algoritma pengisihan yang berbeza masih digunakan dalam pangkalan kod di mana-mana untuk memproses sejumlah besar data.

Selepas berdekad-dekad penyelidikan dan pembangunan, kecekapan algoritma pengisihan ini telah terus dipertingkatkan dan diiktiraf oleh saintis komputer dan pengaturcara. Walau bagaimanapun, cabaran besar kekal untuk penambahbaikan selanjutnya.

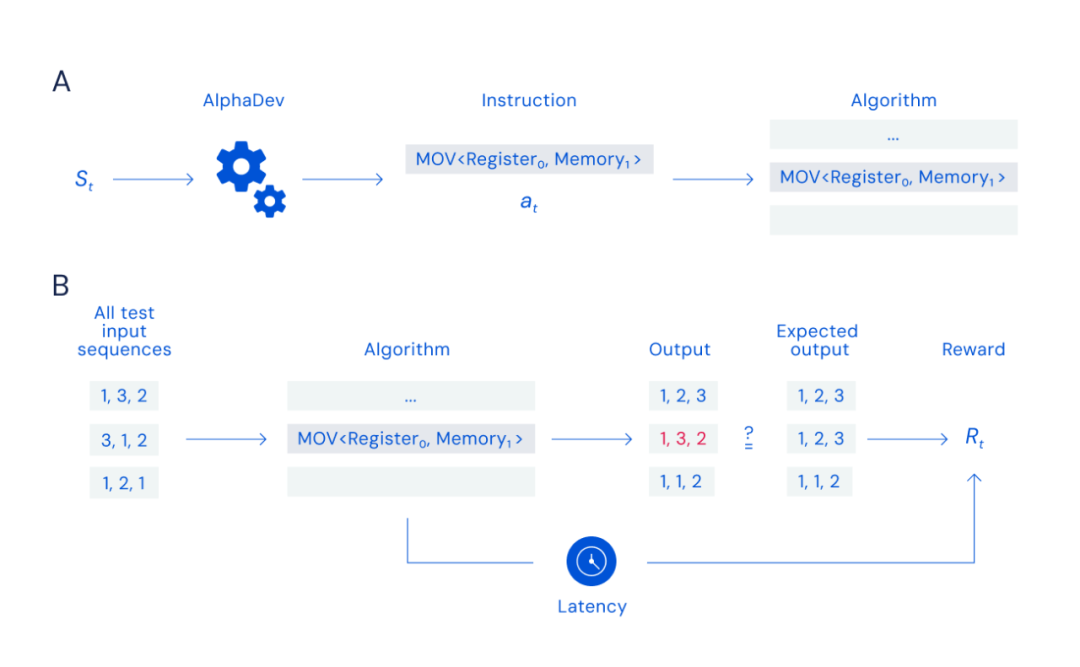

2. Sorotan: Bagaimana untuk menggunakan AlphaDev untuk menjana algoritma pengisihan baharu?

Para penyelidik pada asalnya menggunakan AlphaDev untuk menjana algoritma baharu dengan matlamat untuk menyelesaikan tugasan yang diberikan dengan cekap.

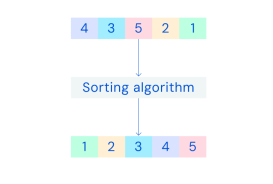

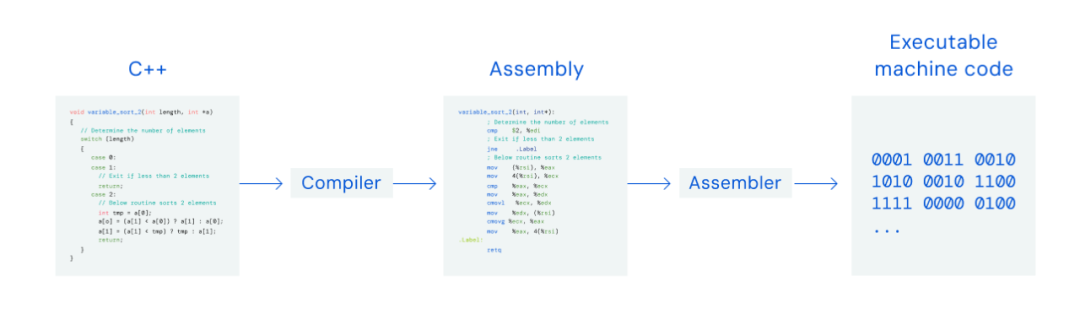

AlphaDev telah membina algoritma baharu sepenuhnya dan tidak dibangunkan berdasarkan algoritma sebelumnya, jadi ia boleh dianggap sebagai asal. Dalam proses itu, ia menggunakan bahasa perantaraan kod pemasangan. AlphaDev menjadikannya lebih mudah untuk mencipta algoritma yang cekap kerana bahasa itu lebih dekat dengan arahan binari komputer.

Khususnya, AlphaDev menjana arahan setiap kali dan kemudian menguji sama ada output adalah betul Ia juga menetapkan keperluan dalam model untuk menjana algoritma terpendek.

Apabila diminta untuk mereka bentuk semula algoritma pengisihan, AlphaDev secara rawak menjana algoritma pengisihan baharu yang 70% lebih pantas daripada algoritma sedia ada dan boleh mengisih lima data pada masa yang sama. Ia juga 1.7% lebih pantas daripada algoritma terbaik apabila mengisih 250,000 data.

Inovasi ini akan memberi impak yang besar pada algoritma global, kerana algoritma pengisihan digunakan secara meluas oleh pelbagai perisian biasa. DeepMind telah membuka sumbernya dan menyepadukannya ke dalam perpustakaan standard Libc++.

Menurut penyelidik DeepMind: “Disebabkan bilangan kombinasi arahan yang banyak, proses penyelidikan yang kelihatan mudah adalah amat sukar.”

3 >

Tambahan pula, AlphaDev ialah model yang lebih maju yang direka bentuk berdasarkan struktur AlphaZero. AlphaZero sebelum ini merupakan model pembelajaran pengukuhan DeepMind dan telah mengalahkan juara dunia dalam Go, catur dan permainan catur lain. Melalui percubaan ini, model baharu AlphaDev menggunakan kelebihan uniknya dalam beralih daripada bermain permainan kepada menyelesaikan masalah saintifik, dan daripada simulasi percubaan kepada aplikasi dunia sebenar. Penyelidik mensimulasikan pengisihan sebagai "permainan pemasangan" pemain tunggal untuk melatih AlphaDev menemui algoritma baharu. Semasa setiap giliran permainan, AlphaDev memerhati algoritma yang dijana dan maklumat yang terkandung dalam CPU, dan kemudian memilih arahan untuk ditambahkan pada algoritma untuk membuat setiap langkah. Makalah tersebut menyebut bahawa permainan pemasangan adalah sangat sukar kerana AlphaDev mesti berupaya mencari dengan cekap melalui sejumlah besar kombinasi arahan yang mungkin untuk mendapatkan algoritma yang boleh diisih.Bilangan kombinasi arahan adalah serupa dengan bilangan zarah dalam alam semesta atau bilangan kemungkinan gabungan pergerakan dalam catur (10120 permainan) dan Go (10700 permainan akan membatalkan keseluruhan algoritma).

Model kemudian mengeluarkan algoritma dan membandingkannya dengan output yang dijangkakan, memberi ganjaran kepada ejen berdasarkan ketepatan dan kependaman algoritma.

Apabila membina algoritma, setiap kali arahan dimasukkan, AlphaDev menyemak ketepatan dengan membandingkan algoritma keluaran dengan hasil yang dijangkakan (untuk algoritma pengisihan, ini bermakna selepas memasukkan nombor tidak tertib, ia boleh mengeluarkan disusun dengan betul nombor).

Model memberi ganjaran kepada AlphaDev kerana mengisih nombor dengan betul dan cekap. Akhirnya AlphaDev memenangi pertandingan dengan menemui program yang lebih tepat dan lebih pantas.

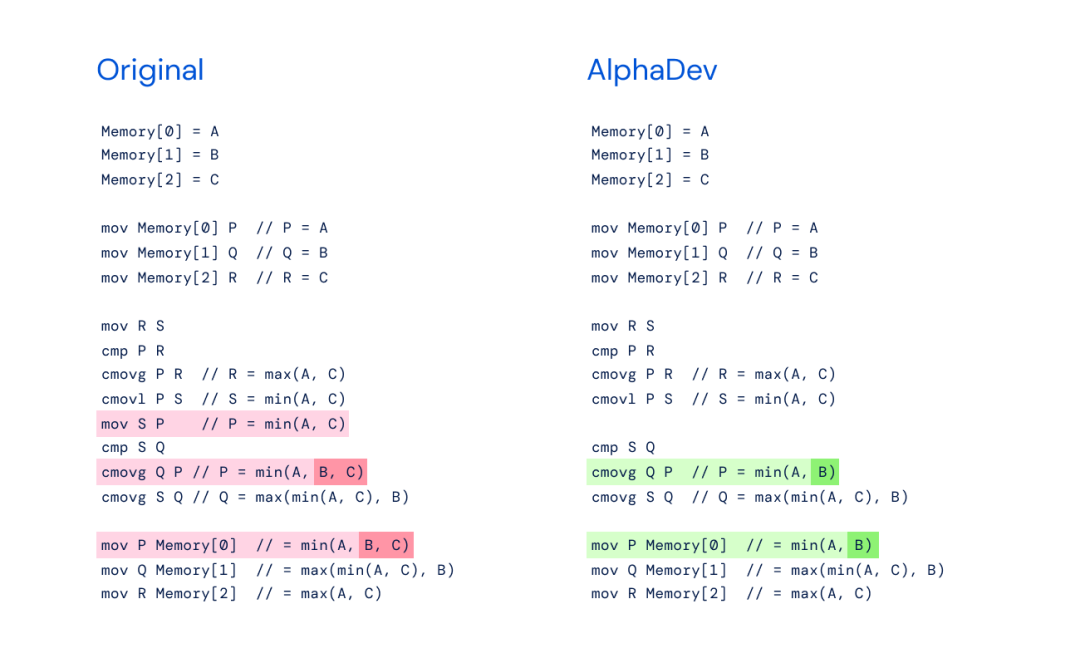

4. Inovasi algoritma: swap move dan salin urutan arahan

AlphaDev bukan sahaja menjana algoritma yang lebih pantas, tetapi juga menginovasi dua urutan arahan.

Secara khusus, algoritma pengisihan yang dihasilkannya termasuk dua urutan arahan baharu: swap move dan copy move, dan satu arahan akan disimpan setiap kali ia digunakan. Para penyelidik memanggilnya "pergerakan pertukaran dan penyalinan AlphaDev."

Kaedah novel ini mengingatkan kepada "Langkah 37" AlphaGo - permainan catur "counter-intuitif" yang mengejutkan penonton dan mencipta kegagalan Tangan pemain catur legenda.

Dengan menukar langkah dan menyalin urutan arahan pergerakan, AlphaDev melangkau satu langkah, melengkapkan matlamat dengan cara yang kelihatan seperti kesilapan tetapi sebenarnya adalah jalan pintas. Ini bermakna AlphaDev mempunyai keupayaan untuk menemui penyelesaian awal dan cuba memperbaik algoritma sains komputer.

5 Ujian: Promosikan dan perbaiki algoritma pencincangan

Selepas menemui algoritma pengisihan yang lebih pantas, penyelidik cuba menerapkannya pada algoritma sains komputer yang lain - promosi dan penambahbaikan algoritma pencincangan.

Algoritma cincang ialah algoritma asas dalam pengkomputeran dan digunakan untuk mendapatkan semula, menyimpan dan memampatkan data. Sama seperti pustakawan menggunakan sistem klasifikasi untuk mencari buku tertentu, algoritma pencincangan membantu pengguna mengetahui perkara yang mereka cari dan tempat untuk mencarinya.

Algoritma ini dapat mengambil data untuk kunci tertentu (cth., nama pengguna "Jane Doe") dan mengisih cincang - menukar data mentah kepada rentetan unik (cth., 1234ghty).

Komputer menggunakan cincang ini untuk mendapatkan semula data yang berkaitan dengan kunci dengan cepat, dan bukannya mencari semua data.

Penyelidik menggunakan AlphaDev pada salah satu algoritma pencincangan yang paling biasa digunakan dalam struktur data dalam usaha untuk menemui algoritma yang lebih pantas. Apabila digunakan pada julat 9-16 bait fungsi cincang, AlphaDev menghasilkan algoritma yang 30% lebih pantas.

Awal tahun ini, algoritma pencincangan baharu yang dihasilkan oleh AlphaDev telah dikeluarkan ke dalam pustaka Abseil sumber terbuka, menjadikannya tersedia kepada berjuta-juta pembangun di seluruh dunia Dianggarkan ia kini digunakan oleh berpuluh-puluh ribu setiap orang hari.

6. Momentum pengumpulan: mengambil langkah pertama dalam membangunkan AGI

Dengan mengoptimumkan "algoritma pengisihan dan pencincang", AlphaDev telah menunjukkan keupayaan untuk menjana algoritma baharu praktikal yang berbeza.

Ini juga merupakan langkah pertama AlphaDev ke arah membangunkan alatan kecerdasan buatan umum (AGI) yang serupa juga boleh membantu mengoptimumkan keseluruhan ekosistem pengkomputeran dan menyelesaikan masalah lain yang memberi manfaat kepada masyarakat.

Walaupun mengoptimumkan algoritma dalam ruang arahan pemasangan peringkat rendah sangat berkuasa, ia juga mempunyai had. Pada masa ini, pasukan sedang mengkaji keupayaan AlphaDev untuk mengoptimumkan algoritma dalam bahasa peringkat tinggi (seperti C++), yang akan lebih bermanfaat kepada pembangun.

Ringkasnya, penemuan baharu ini diharapkan dapat memberi inspirasi kepada pembangun untuk mencipta teknologi dan kaedah baharu, seterusnya mengoptimumkan algoritma asas dan mencipta ekosistem pengkomputeran yang lebih kukuh dan mampan.

7. Sumber terbuka: satu kejayaan penting dalam kod pengoptimuman AI

Sebelum ini, algoritma pengisihan telah digunakan bertrilion kali setiap hari. Dengan pertumbuhan keperluan pengkomputeran, orang ramai mempunyai keperluan prestasi yang lebih tinggi dan lebih tinggi untuk algoritma. Walaupun jurutera manusia telah menemui algoritma pengisihan yang berbeza, selepas beberapa dekad pengoptimuman, adalah sukar untuk membuat penemuan dan tidak dapat memenuhi permintaan yang semakin meningkat.

Hari ini, AlphaDev telah menemui algoritma pengisihan yang lebih pantas untuk mengisih data.

Algoritma kedudukan baharu boleh digunakan untuk menentukan kedudukan hasil carian dalam talian dan siaran sosial, serta memproses data pada komputer dan telefon mudah alih.

Adalah wajar diraikan bahawa algoritma pengisihan baharu telah bersumberkan terbuka dalam pustaka C++ utama. Ia kini digunakan oleh berjuta-juta pembangun dan syarikat di seluruh dunia untuk pengkomputeran awan, beli-belah dalam talian, pengurusan rantaian bekalan dan banyak lagi.

Ringkasnya, menggunakan alat kecerdasan buatan untuk mengoptimumkan algoritma akan mengubah sepenuhnya cara pengaturcaraan tradisional. Ini adalah kali pertama dalam lebih daripada sepuluh tahun perpustakaan pengisihan telah diubah, dan kali pertama algoritma yang direka bentuk oleh model pembelajaran pengukuhan telah ditambahkan pada perpustakaan pengisihan Oleh itu, ia telah menjadi kejayaan penting dalam menggunakan kecerdasan buatan untuk mengoptimumkan kod.

8. Pengguna: Mungkin ini hanya gimik

Pengguna mempunyai pendapat yang bercampur-campur tentang hasil penyelidikan Kebanyakan suara di Twitter memuji:

Atas ialah kandungan terperinci DeepMind melancarkan algoritma pengisihan yang mengejutkan, dan perpustakaan C++ sedang sibuk mengemas kini!. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1382

1382

52

52

CLIP-BEVFormer: Selia secara eksplisit struktur BEVFormer untuk meningkatkan prestasi pengesanan ekor panjang

Mar 26, 2024 pm 12:41 PM

CLIP-BEVFormer: Selia secara eksplisit struktur BEVFormer untuk meningkatkan prestasi pengesanan ekor panjang

Mar 26, 2024 pm 12:41 PM

Ditulis di atas & pemahaman peribadi penulis: Pada masa ini, dalam keseluruhan sistem pemanduan autonomi, modul persepsi memainkan peranan penting Hanya selepas kenderaan pemanduan autonomi yang memandu di jalan raya memperoleh keputusan persepsi yang tepat melalui modul persepsi boleh Peraturan hiliran dan. modul kawalan dalam sistem pemanduan autonomi membuat pertimbangan dan keputusan tingkah laku yang tepat pada masanya dan betul. Pada masa ini, kereta dengan fungsi pemanduan autonomi biasanya dilengkapi dengan pelbagai penderia maklumat data termasuk penderia kamera pandangan sekeliling, penderia lidar dan penderia radar gelombang milimeter untuk mengumpul maklumat dalam modaliti yang berbeza untuk mencapai tugas persepsi yang tepat. Algoritma persepsi BEV berdasarkan penglihatan tulen digemari oleh industri kerana kos perkakasannya yang rendah dan penggunaan mudah, dan hasil keluarannya boleh digunakan dengan mudah untuk pelbagai tugas hiliran.

Melaksanakan Algoritma Pembelajaran Mesin dalam C++: Cabaran dan Penyelesaian Biasa

Jun 03, 2024 pm 01:25 PM

Melaksanakan Algoritma Pembelajaran Mesin dalam C++: Cabaran dan Penyelesaian Biasa

Jun 03, 2024 pm 01:25 PM

Cabaran biasa yang dihadapi oleh algoritma pembelajaran mesin dalam C++ termasuk pengurusan memori, multi-threading, pengoptimuman prestasi dan kebolehselenggaraan. Penyelesaian termasuk menggunakan penunjuk pintar, perpustakaan benang moden, arahan SIMD dan perpustakaan pihak ketiga, serta mengikuti garis panduan gaya pengekodan dan menggunakan alat automasi. Kes praktikal menunjukkan cara menggunakan perpustakaan Eigen untuk melaksanakan algoritma regresi linear, mengurus memori dengan berkesan dan menggunakan operasi matriks berprestasi tinggi.

Terokai prinsip asas dan pemilihan algoritma bagi fungsi isihan C++

Apr 02, 2024 pm 05:36 PM

Terokai prinsip asas dan pemilihan algoritma bagi fungsi isihan C++

Apr 02, 2024 pm 05:36 PM

Lapisan bawah fungsi C++ sort menggunakan isihan gabungan, kerumitannya ialah O(nlogn), dan menyediakan pilihan algoritma pengisihan yang berbeza, termasuk isihan pantas, isihan timbunan dan isihan stabil.

Bolehkah kecerdasan buatan meramalkan jenayah? Terokai keupayaan CrimeGPT

Mar 22, 2024 pm 10:10 PM

Bolehkah kecerdasan buatan meramalkan jenayah? Terokai keupayaan CrimeGPT

Mar 22, 2024 pm 10:10 PM

Konvergensi kecerdasan buatan (AI) dan penguatkuasaan undang-undang membuka kemungkinan baharu untuk pencegahan dan pengesanan jenayah. Keupayaan ramalan kecerdasan buatan digunakan secara meluas dalam sistem seperti CrimeGPT (Teknologi Ramalan Jenayah) untuk meramal aktiviti jenayah. Artikel ini meneroka potensi kecerdasan buatan dalam ramalan jenayah, aplikasi semasanya, cabaran yang dihadapinya dan kemungkinan implikasi etika teknologi tersebut. Kecerdasan Buatan dan Ramalan Jenayah: Asas CrimeGPT menggunakan algoritma pembelajaran mesin untuk menganalisis set data yang besar, mengenal pasti corak yang boleh meramalkan di mana dan bila jenayah mungkin berlaku. Set data ini termasuk statistik jenayah sejarah, maklumat demografi, penunjuk ekonomi, corak cuaca dan banyak lagi. Dengan mengenal pasti trend yang mungkin terlepas oleh penganalisis manusia, kecerdasan buatan boleh memperkasakan agensi penguatkuasaan undang-undang

Algoritma pengesanan yang dipertingkatkan: untuk pengesanan sasaran dalam imej penderiaan jauh optik resolusi tinggi

Jun 06, 2024 pm 12:33 PM

Algoritma pengesanan yang dipertingkatkan: untuk pengesanan sasaran dalam imej penderiaan jauh optik resolusi tinggi

Jun 06, 2024 pm 12:33 PM

01Garis prospek Pada masa ini, sukar untuk mencapai keseimbangan yang sesuai antara kecekapan pengesanan dan hasil pengesanan. Kami telah membangunkan algoritma YOLOv5 yang dipertingkatkan untuk pengesanan sasaran dalam imej penderiaan jauh optik resolusi tinggi, menggunakan piramid ciri berbilang lapisan, strategi kepala pengesanan berbilang dan modul perhatian hibrid untuk meningkatkan kesan rangkaian pengesanan sasaran dalam imej penderiaan jauh optik. Menurut set data SIMD, peta algoritma baharu adalah 2.2% lebih baik daripada YOLOv5 dan 8.48% lebih baik daripada YOLOX, mencapai keseimbangan yang lebih baik antara hasil pengesanan dan kelajuan. 02 Latar Belakang & Motivasi Dengan perkembangan pesat teknologi penderiaan jauh, imej penderiaan jauh optik resolusi tinggi telah digunakan untuk menggambarkan banyak objek di permukaan bumi, termasuk pesawat, kereta, bangunan, dll. Pengesanan objek dalam tafsiran imej penderiaan jauh

Amalkan dan fikirkan platform model besar berbilang modal Jiuzhang Yunji DataCanvas

Oct 20, 2023 am 08:45 AM

Amalkan dan fikirkan platform model besar berbilang modal Jiuzhang Yunji DataCanvas

Oct 20, 2023 am 08:45 AM

1. Perkembangan sejarah model besar pelbagai mod Gambar di atas adalah bengkel kecerdasan buatan pertama yang diadakan di Kolej Dartmouth di Amerika Syarikat pada tahun 1956. Persidangan ini juga dianggap telah memulakan pembangunan kecerdasan buatan perintis logik simbolik (kecuali ahli neurobiologi Peter Milner di tengah-tengah barisan hadapan). Walau bagaimanapun, teori logik simbolik ini tidak dapat direalisasikan untuk masa yang lama, malah memulakan musim sejuk AI pertama pada 1980-an dan 1990-an. Sehingga pelaksanaan model bahasa besar baru-baru ini, kami mendapati bahawa rangkaian saraf benar-benar membawa pemikiran logik ini. Kerja ahli neurobiologi Peter Milner memberi inspirasi kepada pembangunan rangkaian saraf tiruan yang seterusnya, dan atas sebab inilah dia dijemput untuk mengambil bahagian. dalam projek ini.

Aplikasi algoritma dalam pembinaan 58 platform potret

May 09, 2024 am 09:01 AM

Aplikasi algoritma dalam pembinaan 58 platform potret

May 09, 2024 am 09:01 AM

1. Latar Belakang Pembinaan 58 Portrait Platform Pertama sekali, saya ingin berkongsi dengan anda latar belakang pembinaan 58 Portrait Platform. 1. Pemikiran tradisional platform pemprofilan tradisional tidak lagi mencukupi Membina platform pemprofilan pengguna bergantung pada keupayaan pemodelan gudang data untuk menyepadukan data daripada pelbagai barisan perniagaan untuk membina potret pengguna yang tepat untuk memahami tingkah laku, minat pengguna dan keperluan, dan menyediakan keupayaan sampingan, akhirnya, ia juga perlu mempunyai keupayaan platform data untuk menyimpan, bertanya dan berkongsi data profil pengguna dan menyediakan perkhidmatan profil dengan cekap. Perbezaan utama antara platform pemprofilan perniagaan binaan sendiri dan platform pemprofilan pejabat pertengahan ialah platform pemprofilan binaan sendiri menyediakan satu barisan perniagaan dan boleh disesuaikan atas permintaan platform pertengahan pejabat berkhidmat berbilang barisan perniagaan, mempunyai kompleks pemodelan, dan menyediakan lebih banyak keupayaan umum. 2.58 Potret pengguna latar belakang pembinaan potret di platform tengah 58

Tambah SOTA dalam masa nyata dan meroket! FastOcc: Inferens yang lebih pantas dan algoritma Occ mesra penggunaan sudah tersedia!

Mar 14, 2024 pm 11:50 PM

Tambah SOTA dalam masa nyata dan meroket! FastOcc: Inferens yang lebih pantas dan algoritma Occ mesra penggunaan sudah tersedia!

Mar 14, 2024 pm 11:50 PM

Ditulis di atas & Pemahaman peribadi penulis ialah dalam sistem pemanduan autonomi, tugas persepsi adalah komponen penting dalam keseluruhan sistem pemanduan autonomi. Matlamat utama tugas persepsi adalah untuk membolehkan kenderaan autonomi memahami dan melihat elemen persekitaran sekeliling, seperti kenderaan yang memandu di jalan raya, pejalan kaki di tepi jalan, halangan yang dihadapi semasa memandu, tanda lalu lintas di jalan raya, dan sebagainya, dengan itu membantu hiliran. modul Membuat keputusan dan tindakan yang betul dan munasabah. Kenderaan dengan keupayaan pemanduan autonomi biasanya dilengkapi dengan pelbagai jenis penderia pengumpulan maklumat, seperti penderia kamera pandangan sekeliling, penderia lidar, penderia radar gelombang milimeter, dsb., untuk memastikan kenderaan autonomi itu dapat melihat dan memahami persekitaran sekeliling dengan tepat. elemen , membolehkan kenderaan autonomi membuat keputusan yang betul semasa pemanduan autonomi. kepala