Peranti teknologi

Peranti teknologi

AI

AI

Karya baharu Tian Yuandong: Membuka lapisan pertama kotak hitam Transformer, mekanisme perhatiannya tidak begitu misteri

Karya baharu Tian Yuandong: Membuka lapisan pertama kotak hitam Transformer, mekanisme perhatiannya tidak begitu misteri

Karya baharu Tian Yuandong: Membuka lapisan pertama kotak hitam Transformer, mekanisme perhatiannya tidak begitu misteri

Seni bina Transformer telah merentasi banyak bidang termasuk pemprosesan bahasa semula jadi, penglihatan komputer, pertuturan, pelbagai mod, dsb. Walau bagaimanapun, pada masa ini hanya hasil percubaan yang menakjubkan, dan penyelidikan yang berkaitan tentang prinsip kerja Transformer masih sangat terhad.

Misteri terbesar ialah mengapa Transformer boleh memunculkan perwakilan yang cekap daripada dinamik latihan kecerunan dengan hanya bergantung pada "kehilangan ramalan mudah"?

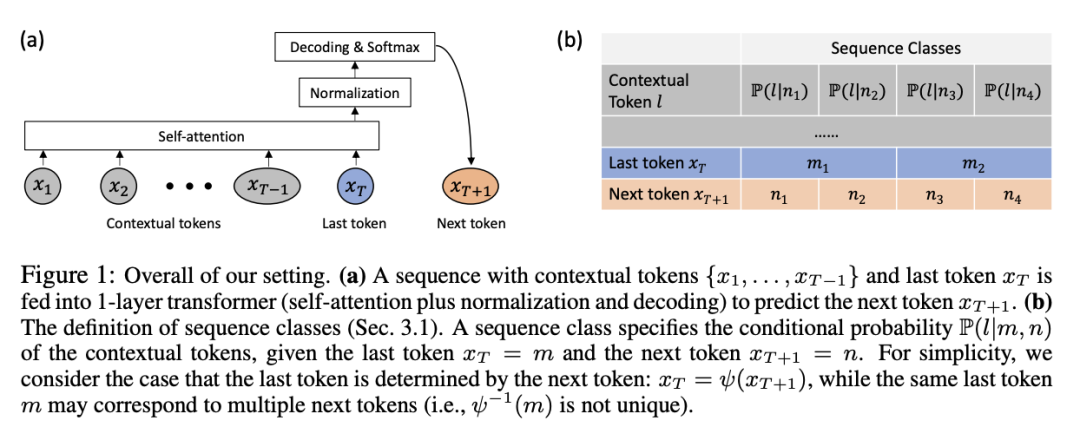

Baru-baru ini Dr. Tian Yuandong mengumumkan hasil penyelidikan terkini pasukannya Dengan cara yang teliti secara matematik, beliau menganalisis prestasi Transformer 1 lapisan (lapisan perhatian diri ditambah dekoder. lapisan) dalam tugasan ramalan token seterusnya dinamik latihan SGD pada.

Pautan kertas: https://arxiv.org/abs/2305.16380

Kertas ini membuka kotak hitam tentang cara lapisan perhatian kendiri menggabungkan dinamik token input dan mendedahkan sifat bias induktif yang berpotensi.

Secara khusus, dengan andaian bahawa tiada pengekodan kedudukan, urutan input yang panjang, dan lapisan penyahkod belajar lebih cepat daripada lapisan perhatian diri, para penyelidik membuktikan bahawa perhatian diri adalah Algoritma pengimbasan diskriminatif :

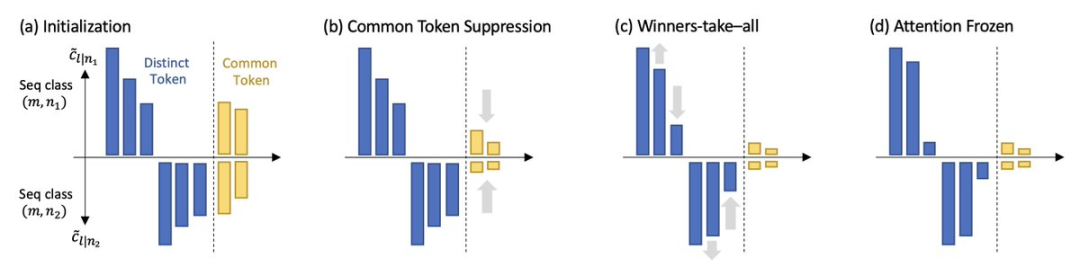

Bermula dari perhatian seragam (perhatian seragam), untuk token seterusnya yang spesifik untuk diramalkan, model secara beransur-ansur memberi perhatian kepada token kunci yang berbeza, dan kurang memberi perhatian kepada token biasa yang muncul dalam berbilang tetingkap token seterusnya

Untuk token yang berbeza, model akan mengurangkan berat perhatian secara beransur-ansur, mengikuti latihan Urutan kejadian bersama antara pekat token kunci dan token pertanyaan dari rendah ke tinggi.

Apa yang menarik ialah proses ini tidak membawa kepada pemenang-ambil-semua, tetapi diperlahankan oleh perubahan fasa yang dikawal oleh kadar pembelajaran dua lapisan, dan akhirnya menjadi ( hampir) gabungan token tetap Dinamik ini juga disahkan pada data sintetik dan dunia sebenar.

Dr. Tian Yuandong ialah penyelidik dan pengurus penyelidikan di Institut Penyelidikan Kecerdasan Buatan Meta dan peneraju projek Go AI adalah pembelajaran pengukuhan yang mendalam dan aplikasinya dalam permainan , serta analisis teori model pembelajaran mendalam. Beliau menerima ijazah sarjana muda dan sarjana dari Universiti Shanghai Jiao Tong pada 2005 dan 2008, dan ijazah kedoktorannya dari Institut Robotik Universiti Carnegie Mellon di Amerika Syarikat pada 2013.

Memenangi 2013 International Conference on Computer Vision (ICCV) Marr Prize Honorable Mentions (Marr Prize Honorable Mentions) dan ICML2021 Outstanding Paper Honorable Mention Award.

Selepas menamatkan pengajian dalam Ph.D., beliau menerbitkan satu siri "Ringkasan Kedoktoran Lima Tahun", meliputi aspek seperti pemilihan hala tuju penyelidikan, pengumpulan bacaan, pengurusan masa, sikap kerja , pendapatan dan pembangunan kerjaya yang mampan Ringkasan pemikiran dan pengalaman mengenai kerjaya kedoktoran.

Mendedahkan Transformer 1-layer

Model pra-latihan berdasarkan seni bina Transformer biasanya hanya termasuk tugas penyeliaan yang sangat mudah, seperti meramal perkataan seterusnya, mengisi kosong, dsb., tetapi ia boleh Menyediakan perwakilan yang sangat kaya untuk tugas hiliran adalah membingungkan.

Walaupun kerja terdahulu telah membuktikan bahawa Transformer pada asasnya adalah penghampir universal, model pembelajaran mesin yang biasa digunakan sebelum ini, seperti kNN, kernel SVM, dan perceptron berbilang lapisan dsb. sebenarnya adalah penghampir universal Teori ini tidak dapat menjelaskan jurang yang besar dalam prestasi antara kedua-dua jenis model ini.

Penyelidik percaya bahawa adalah penting untuk memahami dinamik latihan Transformer, iaitu, dalam Semasa latihan, anda boleh belajar bagaimana parameter berubah dari semasa ke semasa.

Artikel pertama kali menggunakan definisi matematik yang ketat untuk menerangkan secara rasmi dinamik latihan SGD bagi Transformer pengekodan kedudukan tanpa lapisan pada ramalan token seterusnya (paradigma latihan yang biasa digunakan untuk siri GPT model).

Pengubah 1 lapisan mengandungi lapisan perhatian kendiri softmax dan lapisan penyahkod yang meramalkan token seterusnya. Bukti 1. Bias Kekerapan

2. Bias DiskriminasiModel memberi lebih perhatian kepada yang akan diramalkan seterusnya Satu-satunya token unik yang muncul dalam token seterusnya, dan kehilangan minat terhadap token biasa yang muncul dalam berbilang token seterusnya.

Dua ciri ini menunjukkan bahawa perhatian diri secara tersirat menjalankan algoritma pengimbasan diskriminatif dan mempunyai bias induktif, iaitu, ia berat sebelah terhadap token kunci Unik yang sering berlaku bersama token pertanyaan

Tambahan pula, walaupun lapisan perhatian diri cenderung menjadi lebih jarang semasa latihan, seperti yang dicadangkan oleh bias frekuensi, model Oleh kerana peralihan fasa dalam dinamik latihan, ia tidak runtuh menjadi satu. panas.

Peringkat akhir pembelajaran tidak menumpu kepada mana-mana titik pelana dengan kecerunan sifar, sebaliknya memasuki perubahan perhatian Perlahan rantau (iaitu logaritma dari semasa ke semasa), dengan pembekuan parameter dan dipelajari.

Hasil penyelidikan selanjutnya menunjukkan bahawa permulaan peralihan fasa dikawal oleh kadar pembelajaran: kadar pembelajaran yang besar akan menghasilkan corak perhatian yang jarang, manakala di bawah kadar pembelajaran perhatian kendiri yang tetap , kadar pembelajaran penyahkod yang besar membawa kepada peralihan fasa yang lebih pantas dan corak perhatian yang padat.

Para penyelidik menamakan dinamik SGD yang ditemui dalam imbasan dan snap kerja mereka:

Perhatian diri difokuskan pada token utama, iaitu, token berbeza yang sering muncul pada masa yang sama dengan token ramalan seterusnya berkurangan;

peringkat snap: Perhatian hampir dibekukan dan gabungan token telah ditetapkan.

Fenomena ini juga telah disahkan dalam eksperimen data dunia sebenar yang mudah, menggunakan SGD yang dilatih di WikiText1 Memerhati diri yang paling rendah -lapisan perhatian pada lapisan dan Transformer 3-layer, kita dapati bahawa walaupun kadar pembelajaran kekal malar sepanjang proses latihan, perhatian akan membeku pada masa tertentu semasa proses latihan dan menjadi jarang.

Atas ialah kandungan terperinci Karya baharu Tian Yuandong: Membuka lapisan pertama kotak hitam Transformer, mekanisme perhatiannya tidak begitu misteri. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1374

1374

52

52

Kaedah apa yang digunakan untuk menukar rentetan ke dalam objek dalam vue.js?

Apr 07, 2025 pm 09:39 PM

Kaedah apa yang digunakan untuk menukar rentetan ke dalam objek dalam vue.js?

Apr 07, 2025 pm 09:39 PM

Apabila menukar rentetan ke objek dalam vue.js, json.parse () lebih disukai untuk rentetan json standard. Untuk rentetan JSON yang tidak standard, rentetan boleh diproses dengan menggunakan ungkapan biasa dan mengurangkan kaedah mengikut format atau url yang dikodkan. Pilih kaedah yang sesuai mengikut format rentetan dan perhatikan isu keselamatan dan pengekodan untuk mengelakkan pepijat.

Geospatial Laravel: Pengoptimuman peta interaktif dan sejumlah besar data

Apr 08, 2025 pm 12:24 PM

Geospatial Laravel: Pengoptimuman peta interaktif dan sejumlah besar data

Apr 08, 2025 pm 12:24 PM

Cecair memproses 7 juta rekod dan membuat peta interaktif dengan teknologi geospatial. Artikel ini meneroka cara memproses lebih dari 7 juta rekod menggunakan Laravel dan MySQL dan mengubahnya menjadi visualisasi peta interaktif. Keperluan Projek Cabaran Awal: Ekstrak Wawasan berharga menggunakan 7 juta rekod dalam pangkalan data MySQL. Ramai orang mula -mula mempertimbangkan bahasa pengaturcaraan, tetapi mengabaikan pangkalan data itu sendiri: Bolehkah ia memenuhi keperluan? Adakah penghijrahan data atau pelarasan struktur diperlukan? Bolehkah MySQL menahan beban data yang besar? Analisis awal: Penapis utama dan sifat perlu dikenalpasti. Selepas analisis, didapati bahawa hanya beberapa atribut yang berkaitan dengan penyelesaiannya. Kami mengesahkan kemungkinan penapis dan menetapkan beberapa sekatan untuk mengoptimumkan carian. Carian Peta Berdasarkan Bandar

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Terdapat banyak sebab mengapa permulaan MySQL gagal, dan ia boleh didiagnosis dengan memeriksa log ralat. Penyebab umum termasuk konflik pelabuhan (periksa penghunian pelabuhan dan ubah suai konfigurasi), isu kebenaran (periksa keizinan pengguna yang menjalankan perkhidmatan), ralat fail konfigurasi (periksa tetapan parameter), rasuah direktori data (memulihkan data atau membina semula ruang meja), isu ruang jadual InnoDB (semak fail ibdata1) Apabila menyelesaikan masalah, anda harus menganalisisnya berdasarkan log ralat, cari punca utama masalah, dan mengembangkan tabiat sandaran data secara teratur untuk mencegah dan menyelesaikan masalah.

Vue.js Bagaimana untuk menukar pelbagai jenis rentetan ke dalam pelbagai objek?

Apr 07, 2025 pm 09:36 PM

Vue.js Bagaimana untuk menukar pelbagai jenis rentetan ke dalam pelbagai objek?

Apr 07, 2025 pm 09:36 PM

Ringkasan: Terdapat kaedah berikut untuk menukar array rentetan vue.js ke dalam tatasusunan objek: Kaedah asas: Gunakan fungsi peta yang sesuai dengan data yang diformat biasa. Permainan lanjutan: Menggunakan ungkapan biasa boleh mengendalikan format yang kompleks, tetapi mereka perlu ditulis dengan teliti dan dipertimbangkan. Pengoptimuman Prestasi: Memandangkan banyak data, operasi tak segerak atau perpustakaan pemprosesan data yang cekap boleh digunakan. Amalan Terbaik: Gaya Kod Jelas, Gunakan nama dan komen pembolehubah yang bermakna untuk memastikan kod ringkas.

Cara menetapkan masa tamat vue axios

Apr 07, 2025 pm 10:03 PM

Cara menetapkan masa tamat vue axios

Apr 07, 2025 pm 10:03 PM

Untuk menetapkan masa untuk Vue Axios, kita boleh membuat contoh Axios dan menentukan pilihan masa tamat: dalam tetapan global: vue.prototype. $ Axios = axios.create ({timeout: 5000}); Dalam satu permintaan: ini. $ axios.get ('/api/pengguna', {timeout: 10000}).

Cara Menggunakan MySQL Selepas Pemasangan

Apr 08, 2025 am 11:48 AM

Cara Menggunakan MySQL Selepas Pemasangan

Apr 08, 2025 am 11:48 AM

Artikel ini memperkenalkan operasi pangkalan data MySQL. Pertama, anda perlu memasang klien MySQL, seperti MySqlworkbench atau Command Line Client. 1. Gunakan perintah MySQL-Uroot-P untuk menyambung ke pelayan dan log masuk dengan kata laluan akaun root; 2. Gunakan CreateTatabase untuk membuat pangkalan data, dan gunakan Pilih pangkalan data; 3. Gunakan createtable untuk membuat jadual, menentukan medan dan jenis data; 4. Gunakan InsertInto untuk memasukkan data, data pertanyaan, kemas kini data dengan kemas kini, dan padam data dengan padam. Hanya dengan menguasai langkah -langkah ini, belajar menangani masalah biasa dan mengoptimumkan prestasi pangkalan data anda boleh menggunakan MySQL dengan cekap.

Jurutera Backend Senior Remote (Platform) memerlukan kalangan

Apr 08, 2025 pm 12:27 PM

Jurutera Backend Senior Remote (Platform) memerlukan kalangan

Apr 08, 2025 pm 12:27 PM

Jurutera Backend Senior Remote Company Kekosongan Syarikat: Lokasi Lokasi: Jauh Pejabat Jauh Jenis: Gaji sepenuh masa: $ 130,000- $ 140,000 Penerangan Pekerjaan Mengambil bahagian dalam penyelidikan dan pembangunan aplikasi mudah alih Circle dan ciri-ciri berkaitan API awam yang meliputi keseluruhan kitaran hayat pembangunan perisian. Tanggungjawab utama kerja pembangunan secara bebas berdasarkan rubyonrails dan bekerjasama dengan pasukan react/redux/relay front-end. Membina fungsi teras dan penambahbaikan untuk aplikasi web dan bekerjasama rapat dengan pereka dan kepimpinan sepanjang proses reka bentuk berfungsi. Menggalakkan proses pembangunan positif dan mengutamakan kelajuan lelaran. Memerlukan lebih daripada 6 tahun backend aplikasi web kompleks

Cara mengoptimumkan prestasi pangkalan data selepas pemasangan MySQL

Apr 08, 2025 am 11:36 AM

Cara mengoptimumkan prestasi pangkalan data selepas pemasangan MySQL

Apr 08, 2025 am 11:36 AM

Pengoptimuman prestasi MySQL perlu bermula dari tiga aspek: konfigurasi pemasangan, pengindeksan dan pengoptimuman pertanyaan, pemantauan dan penalaan. 1. Selepas pemasangan, anda perlu menyesuaikan fail my.cnf mengikut konfigurasi pelayan, seperti parameter innodb_buffer_pool_size, dan tutup query_cache_size; 2. Buat indeks yang sesuai untuk mengelakkan indeks yang berlebihan, dan mengoptimumkan pernyataan pertanyaan, seperti menggunakan perintah menjelaskan untuk menganalisis pelan pelaksanaan; 3. Gunakan alat pemantauan MySQL sendiri (ShowProcessList, ShowStatus) untuk memantau kesihatan pangkalan data, dan kerap membuat semula dan mengatur pangkalan data. Hanya dengan terus mengoptimumkan langkah -langkah ini, prestasi pangkalan data MySQL diperbaiki.