Peranti teknologi

Peranti teknologi

AI

AI

Ulang Tahun ke-6 Transformer: Malah NeurIPS Oral tidak diperoleh pada masa itu, tetapi 8 pengarang telah mengasaskan beberapa unicorn AI

Ulang Tahun ke-6 Transformer: Malah NeurIPS Oral tidak diperoleh pada masa itu, tetapi 8 pengarang telah mengasaskan beberapa unicorn AI

Ulang Tahun ke-6 Transformer: Malah NeurIPS Oral tidak diperoleh pada masa itu, tetapi 8 pengarang telah mengasaskan beberapa unicorn AI

Dari ChatGPT kepada teknologi lukisan AI, gelombang penemuan terbaru dalam bidang kecerdasan buatan mungkin berkat Transformer.

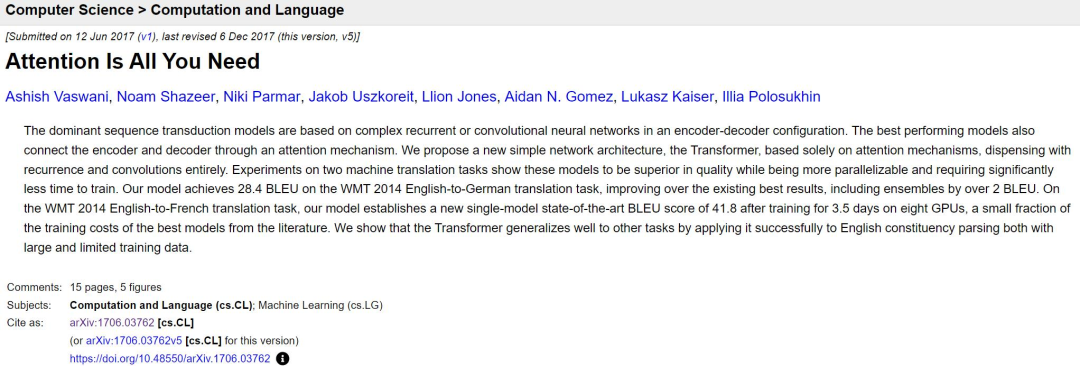

Hari ini adalah ulang tahun keenam penyerahan kertas transformer yang terkenal.

Pautan kertas: https://arxiv.org/abs/1706.03762

Enam tahun lalu, sebuah kertas dengan nama yang agak dibesar-besarkan telah dimuat naik ke platform kertas pracetak arXiv Ayat "xx is All You Need" berulang kali diulang oleh pembangun dalam medan AI. , malah telah menjadi trend dalam tajuk kertas, dan Transformer tidak lagi bermaksud Transformers, ia kini mewakili teknologi paling canggih dalam bidang AI.

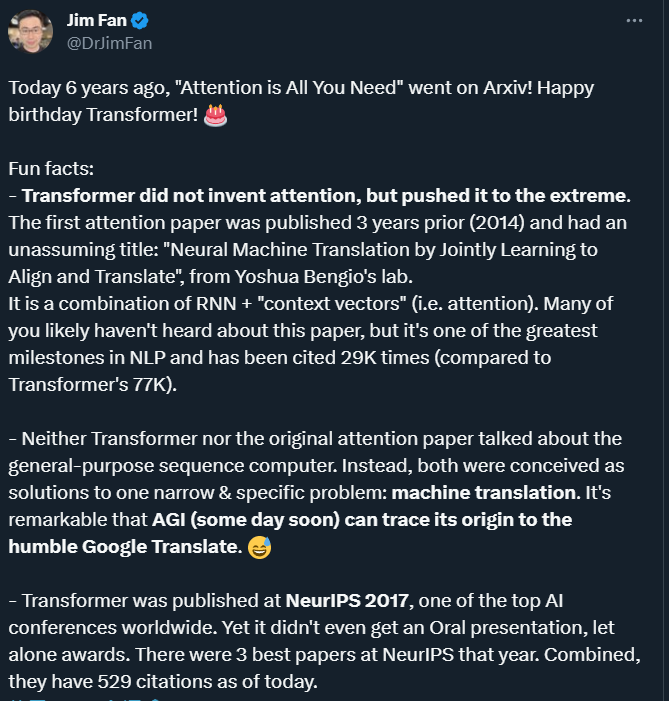

Enam tahun kemudian, melihat kembali kertas ini, kita boleh menemui banyak aspek yang menarik atau kurang diketahui, seperti yang diringkaskan oleh saintis NVIDIA AI Jim Fan.

"mekanisme perhatian" bukanlah seperti yang dicadangkan oleh pengarang Transformer

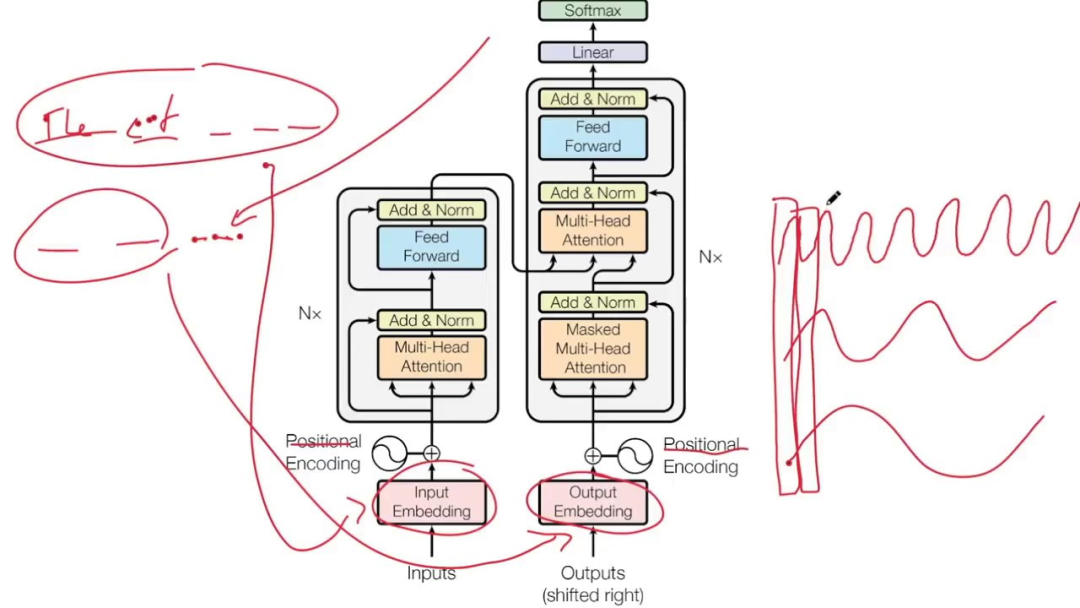

Model Transformer meninggalkan tradisi Unit CNN dan RNN, keseluruhan struktur rangkaian sepenuhnya terdiri daripada mekanisme perhatian.

Walaupun nama kertas Transformer ialah "Attention is All You Need", dan kami terus memuji mekanisme perhatian kerananya, sila ambil perhatian fakta menarik: ia bukan Transformer's penyelidik Penyelidik mencipta perhatian, tetapi mereka menolak mekanisme ini secara melampau.

Mekanisme Perhatian telah dicadangkan pada 2014 oleh pasukan yang diketuai oleh perintis pembelajaran mendalam Yoshua Bengio:

"Penterjemahan Mesin Neural oleh Bersama Belajar Menjajarkan dan Terjemah", tajuknya agak mudah.

Dalam kertas kerja ICLR 2015 ini, Bengio et al mencadangkan gabungan RNN + "vektor konteks" (iaitu perhatian). Walaupun ia adalah salah satu pencapaian terbesar dalam bidang NLP, ia adalah kurang terkenal daripada transformer kertas kerja pasukan Bengio telah disebut 29,000 kali setakat ini, dan Transformer mempunyai 77,000 kali.

Mekanisme perhatian AI secara semula jadi dimodelkan mengikut perhatian visual manusia. Otak manusia mempunyai keupayaan semula jadi: apabila kita melihat gambar, kita mula-mula mengimbas gambar dengan cepat dan kemudian fokus pada kawasan sasaran yang perlu difokuskan.

Jika anda tidak melepaskan sebarang maklumat tempatan, anda pasti akan melakukan banyak kerja sia-sia, yang tidak kondusif untuk terus hidup. Begitu juga, memperkenalkan mekanisme serupa ke dalam rangkaian pembelajaran mendalam boleh memudahkan model dan mempercepatkan pengiraan. Pada dasarnya, Perhatian adalah untuk menapis sejumlah kecil maklumat penting daripada sejumlah besar maklumat, dan fokus pada maklumat penting ini, sambil mengabaikan kebanyakan maklumat yang tidak penting.

Dalam beberapa tahun kebelakangan ini, mekanisme perhatian telah digunakan secara meluas dalam pelbagai bidang pembelajaran mendalam, seperti untuk menangkap medan penerimaan pada imej ke arah penglihatan komputer, atau untuk mengesan token utama dalam NLP atau ciri. Sebilangan besar eksperimen telah membuktikan bahawa model dengan mekanisme perhatian telah mencapai peningkatan prestasi yang ketara dalam tugasan seperti pengelasan imej, pembahagian, penjejakan dan peningkatan, serta pengecaman bahasa semula jadi, pemahaman, menjawab soalan dan terjemahan.

Model Transformer yang memperkenalkan mekanisme perhatian boleh dianggap sebagai komputer jujukan tujuan umum Mekanisme perhatian membenarkan model untuk menetapkan tugasan yang berbeza berdasarkan korelasi kedudukan yang berbeza dalam jujukan semasa memproses jujukan input. . Berat perhatian membolehkan Transformer menangkap kebergantungan jarak jauh dan maklumat kontekstual, dengan itu meningkatkan kesan pemprosesan jujukan.

Tetapi pada masa itu, Transformer mahupun kertas perhatian asal tidak bercakap tentang komputer jujukan universal. Sebaliknya, pengarang melihatnya sebagai mekanisme untuk menyelesaikan masalah yang sempit dan khusus—terjemahan mesin. Oleh itu, pada masa hadapan, apabila kita mengesan asal usul AGI, kita mungkin dapat mengesannya kembali kepada Terjemahan Google yang "rendah hati".

Walaupun ia diterima oleh NeurIPS 2017, ia tidak mendapat Oral

Transformer Walaupun kertas kerja ini sangat berpengaruh sekarang, ia bukanlah AI teratas dalam dunia pada tahun itu Pada persidangan NeurIPS 2017, saya tidak mendapat Lisan, apatah lagi anugerah. Persidangan menerima sejumlah 3240 kertas kerja pada tahun itu, di mana 678 telah dipilih sebagai kertas persidangan The Transformer adalah salah satu kertas kerja yang diterima. . Tesis, anugerah Ujian masa, Transformer tidak layak untuk anugerah itu.

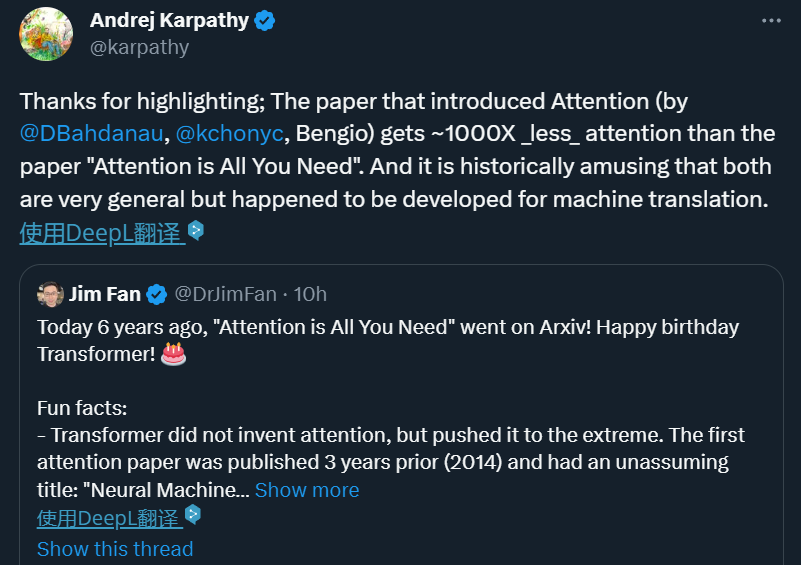

Walaupun terlepas anugerah kertas NeurIPS 2017, pengaruh Transformer jelas kepada semua.

Jim Fan mengulas: Bukan salah hakim bahawa sukar bagi orang ramai untuk menyedari kepentingan kajian yang berpengaruh sebelum ia menjadi berpengaruh. Walau bagaimanapun, terdapat juga kertas kerja yang cukup bertuah untuk ditemui dengan segera Contohnya, ResNet yang dicadangkan oleh He Yuming dan lain-lain memenangi kertas kerja terbaik CVPR 2016. Penyelidikan ini layak dan telah diiktiraf dengan betul oleh persidangan AI teratas. Tetapi pada masa ini pada tahun 2017, penyelidik yang sangat bijak mungkin tidak dapat meramalkan perubahan yang dibawa oleh LLM sekarang Sama seperti pada tahun 1980-an, beberapa orang dapat meramalkan tsunami yang disebabkan oleh pembelajaran mendalam sejak 2012.

Lapan pengarang, masing-masing mempunyai kehidupan yang indah

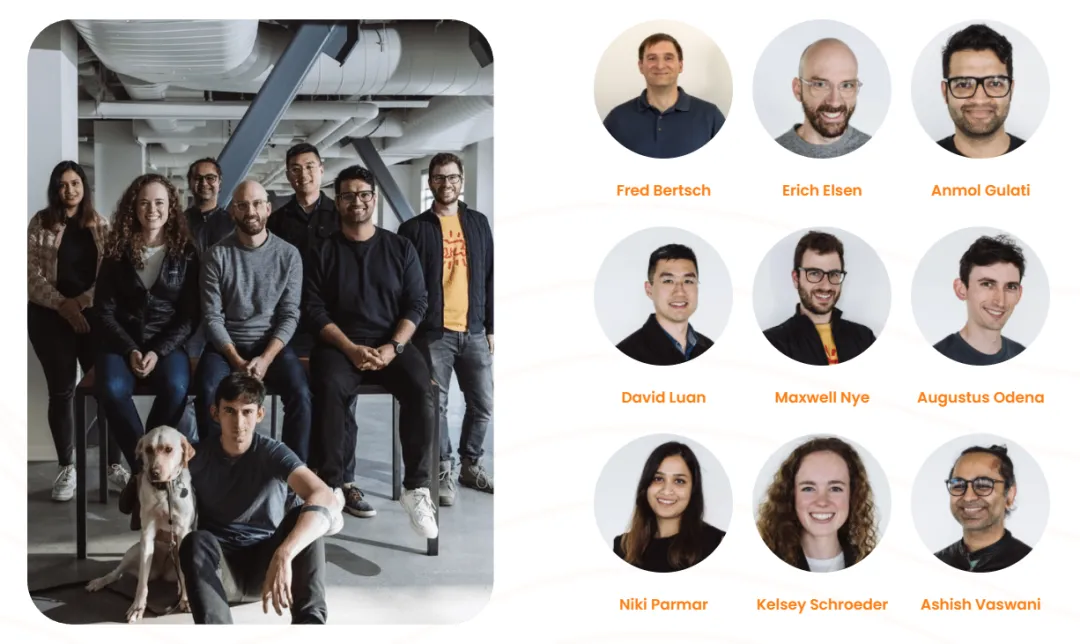

Terdapat 8 pengarang kertas ini pada masa itu. Mereka berasal dari Google dan Universiti Toronto , kebanyakan mereka Pengarang kertas kerja semuanya telah meninggalkan institusi asal mereka.

Pada 26 April 2022, sebuah syarikat bernama "Adept" telah ditubuhkan secara rasmi. Terdapat 9 pengasas bersama, termasuk Ashish Vaswani, dua daripada pengarang karya Transformer Parmar.

Ashish Vaswani Memperoleh PhD dari University of Southern California, di mana beliau belajar di bawah bimbingan sarjana Cina David Chiang dan Liang Huang Beliau terutamanya mempelajari aplikasi awal pembelajaran mendalam moden dalam pemodelan bahasa. Pada 2016, beliau menyertai Google Brain dan mengetuai penyelidikan Transformer sebelum meninggalkan Google pada 2021.

Niki Parmar Tamat pengajian dari University of Southern California dengan ijazah sarjana dan menyertai Google pada 2016. Semasa di sana, dia membangunkan beberapa model Soal Jawab dan persamaan teks yang berjaya untuk carian dan iklan Google. Dia mengetuai kerja awal memperluaskan model Transformer ke dalam bidang seperti penjanaan imej, penglihatan komputer dan banyak lagi. Pada 2021, dia juga meninggalkan Google.

Selepas pergi, kedua-dua mereka mengasaskan Adept dan masing-masing berkhidmat sebagai ketua saintis (Ashish Vaswani) dan ketua pegawai teknologi (Niki Parmar). Visi Adept adalah untuk mencipta AI yang dipanggil "rakan sepasukan kecerdasan buatan" yang dilatih untuk menggunakan pelbagai alat perisian dan API yang berbeza.

Pada Mac 2023, Adept mengumumkan penyelesaian pembiayaan Siri B AS$350 juta, penilaian syarikat melebihi AS$1 bilion, menjadikannya unicorn. Walau bagaimanapun, pada masa Adept mengumpul dana secara terbuka, Niki Parmar dan Ashish Vaswani telah meninggalkan Adept dan mengasaskan syarikat AI baharu mereka sendiri. Bagaimanapun, syarikat baharu ini masih sulit dan kami tidak dapat mendapatkan maklumat terperinci tentang syarikat tersebut.

Pengarang kertas lain Noam Shazeer ialah salah seorang pekerja awal Google yang paling penting. Beliau menyertai Google pada penghujung tahun 2000 sehingga beliau akhirnya meninggalkan dunia pada tahun 2021, dan kemudian menjadi Ketua Pegawai Eksekutif syarikat permulaan yang dipanggil "Character.AI".

Selain Noam Shazeer, pengasas Character.AI ialah Daniel De Freitas, kedua-duanya daripada pasukan LaMDA Google. Sebelum ini, mereka membina LaMDA, model bahasa yang menyokong program perbualan di Google.

Pada bulan Mac tahun ini, Character.AI mengumumkan penyelesaian pembiayaan AS$150 juta dan penilaiannya mencecah AS$1 bilion Ia adalah salah satu daripada beberapa syarikat permulaan yang berpotensi untuk bersaing dengan OpenAI, organisasi yang memiliki ChatGPT , juga merupakan syarikat yang jarang berkembang menjadi unicorn dalam masa 16 bulan sahaja. Aplikasinya, Character.AI, ialah chatbot model bahasa saraf yang boleh menjana respons teks seperti manusia dan terlibat dalam perbualan kontekstual.

Character.AI telah dikeluarkan di Apple App Store dan Google Play Store pada 23 Mei 2023, dan telah dimuat turun lebih daripada 1.7 juta kali pada minggu pertamanya. Pada Mei 2023, perkhidmatan itu menambah langganan berbayar $9.99 sebulan yang dipanggil c.ai+, yang membenarkan akses sembang keutamaan pengguna, masa respons yang lebih pantas dan akses awal kepada ciri baharu, antara faedah lain.

Aidan N. Gomez meninggalkan Google seawal 2019, kemudian bekerja sebagai penyelidik di FOR.ai, dan kini pengasas bersama dan Ketua Pegawai Eksekutif Cohere.

Cohere ialah permulaan AI generatif yang diasaskan pada 2019. Perniagaan terasnya termasuk menyediakan model NLP dan membantu perusahaan meningkatkan interaksi manusia-komputer. Tiga pengasas ialah Ivan Zhang, Nick Frosst dan Aidan Gomez, antaranya Gomez dan Frosst adalah bekas ahli pasukan Google Brain. Pada November 2021, Google Cloud mengumumkan bahawa mereka akan bekerjasama dengan Cohere, dengan Google Cloud menggunakan infrastruktur teguhnya untuk menggerakkan platform Cohere dan Cohere menggunakan TPU Cloud untuk membangun dan menggunakan produknya.

Perlu diingat bahawa Cohere baru sahaja menerima AS$270 juta dalam pembiayaan Siri C, menjadi unicorn dengan permodalan pasaran sebanyak AS$2.2 bilion.

Łukasz KaiserMeninggalkan Google pada 2021 untuk bekerja di Google I telah bekerja selama 7 tahun 9 bulan, dan kini saya seorang penyelidik di OpenAI. Semasa bekerja sebagai saintis penyelidikan di Google, beliau mengambil bahagian dalam reka bentuk model saraf SOTA untuk penterjemahan mesin, penghuraian dan tugasan algoritma dan penjanaan yang lain. Beliau ialah pengarang bersama sistem TensorFlow dan perpustakaan Tensor2Tensor.

Jakob Uszkoreit meninggalkan Google pada 2021 untuk bekerja di Google It bertahan selama 13 tahun, dan kemudian menyertai Inceptive sebagai pengasas bersama. Inceptive ialah syarikat farmaseutikal AI khusus untuk menggunakan pembelajaran mendalam untuk mereka bentuk ubat RNA.

Semasa bekerja di Google, Jakob Uszkoreit mengambil bahagian dalam membentuk pasukan pemahaman bahasa Google Assistant, dan juga bekerja pada Terjemahan Google pada masa awal.

Illia Polosukhin meninggalkan Google pada 2017 dan kini NEAR Co -pengasas dan CTO .AI (sebuah syarikat teknologi asas blockchain).

Satu-satunya yang masih ada di Google ialah Llion Jones, ini tahun Ini adalah tahun ke-9 beliau di Google.

Kini, 6 tahun telah berlalu sejak penerbitan karya "Attention Is All You Need", dan yang asal pengarang telah Pilih untuk pergi, ada yang memilih untuk kekal di Google, walau apa pun, pengaruh Transformer berterusan.

Atas ialah kandungan terperinci Ulang Tahun ke-6 Transformer: Malah NeurIPS Oral tidak diperoleh pada masa itu, tetapi 8 pengarang telah mengasaskan beberapa unicorn AI. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1380

1380

52

52

Petua Konfigurasi Firewall Pelayan Mel Debian

Apr 13, 2025 am 11:42 AM

Petua Konfigurasi Firewall Pelayan Mel Debian

Apr 13, 2025 am 11:42 AM

Mengkonfigurasi firewall pelayan Mail Debian adalah langkah penting dalam memastikan keselamatan pelayan. Berikut adalah beberapa kaedah konfigurasi firewall yang biasa digunakan, termasuk penggunaan iptables dan firewalld. Gunakan iptables untuk mengkonfigurasi firewall untuk memasang iptables (jika belum dipasang): sudoapt-getupdateudoapt-getinstalliplesview peraturan iptables semasa: konfigurasi sudoiptable-l

Bagaimana Debian Readdir Bersepadu Dengan Alat Lain

Apr 13, 2025 am 09:42 AM

Bagaimana Debian Readdir Bersepadu Dengan Alat Lain

Apr 13, 2025 am 09:42 AM

Fungsi Readdir dalam sistem Debian adalah panggilan sistem yang digunakan untuk membaca kandungan direktori dan sering digunakan dalam pengaturcaraan C. Artikel ini akan menerangkan cara mengintegrasikan Readdir dengan alat lain untuk meningkatkan fungsinya. Kaedah 1: Menggabungkan Program Bahasa C dan Pipeline Pertama, tulis program C untuk memanggil fungsi Readdir dan output hasilnya:#termasuk#termasuk#includeintMain (intargc, char*argv []) {dir*dir; structdirent*entry; if (argc! = 2) {

Cara Melaksanakan Penyortiran Fail oleh Debian Readdir

Apr 13, 2025 am 09:06 AM

Cara Melaksanakan Penyortiran Fail oleh Debian Readdir

Apr 13, 2025 am 09:06 AM

Dalam sistem Debian, fungsi Readdir digunakan untuk membaca kandungan direktori, tetapi urutan yang dikembalikannya tidak ditentukan sebelumnya. Untuk menyusun fail dalam direktori, anda perlu membaca semua fail terlebih dahulu, dan kemudian menyusunnya menggunakan fungsi QSORT. Kod berikut menunjukkan cara menyusun fail direktori menggunakan ReadDir dan QSORT dalam sistem Debian:#termasuk#termasuk#termasuk#termasuk // fungsi perbandingan adat, yang digunakan untuk qSortintCompare (Constvoid*A, Constvoid*b) {Returnstrcmp (*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(

Kaedah pemasangan sijil SSL Server Server Debian

Apr 13, 2025 am 11:39 AM

Kaedah pemasangan sijil SSL Server Server Debian

Apr 13, 2025 am 11:39 AM

Langkah -langkah untuk memasang sijil SSL pada pelayan mel Debian adalah seperti berikut: 1. Pasang OpenSSL Toolkit terlebih dahulu, pastikan bahawa OpenSSL Toolkit telah dipasang pada sistem anda. Jika tidak dipasang, anda boleh menggunakan arahan berikut untuk memasang: sudoapt-getupdateudoapt-getinstallopenssl2. Menjana permintaan kunci dan sijil peribadi seterusnya, gunakan OpenSSL untuk menjana kunci peribadi RSA 2048-bit dan permintaan sijil (CSR): Membuka

Cara Melakukan Pengesahan Tandatangan Digital dengan Debian Openssl

Apr 13, 2025 am 11:09 AM

Cara Melakukan Pengesahan Tandatangan Digital dengan Debian Openssl

Apr 13, 2025 am 11:09 AM

Menggunakan OpenSSL untuk Pengesahan Tandatangan Digital pada Sistem Debian, anda boleh mengikuti langkah -langkah berikut: Penyediaan untuk memasang OpenSSL: Pastikan sistem Debian anda telah dipasang. Jika tidak dipasang, anda boleh menggunakan arahan berikut untuk memasangnya: sudoaptdateudoaptininstallopenssl untuk mendapatkan kunci awam: Pengesahan tandatangan digital memerlukan kunci awam penandatangan. Biasanya, kunci awam akan disediakan dalam bentuk fail, seperti public_key.pe

Bagaimana Debian OpenSSL Menghalang Serangan Man-dalam-Middle

Apr 13, 2025 am 10:30 AM

Bagaimana Debian OpenSSL Menghalang Serangan Man-dalam-Middle

Apr 13, 2025 am 10:30 AM

Dalam sistem Debian, OpenSSL adalah perpustakaan penting untuk pengurusan penyulitan, penyahsulitan dan sijil. Untuk mengelakkan serangan lelaki-dalam-pertengahan (MITM), langkah-langkah berikut boleh diambil: Gunakan HTTPS: Pastikan semua permintaan rangkaian menggunakan protokol HTTPS dan bukannya HTTP. HTTPS menggunakan TLS (Protokol Keselamatan Lapisan Pengangkutan) untuk menyulitkan data komunikasi untuk memastikan data tidak dicuri atau diganggu semasa penghantaran. Sahkan Sijil Pelayan: Sahkan secara manual Sijil Pelayan pada klien untuk memastikan ia boleh dipercayai. Pelayan boleh disahkan secara manual melalui kaedah perwakilan urlSession

Cara Melakukan Pengurusan Log Debian Hadoop

Apr 13, 2025 am 10:45 AM

Cara Melakukan Pengurusan Log Debian Hadoop

Apr 13, 2025 am 10:45 AM

Menguruskan Log Hadoop pada Debian, anda boleh mengikuti langkah-langkah berikut dan amalan terbaik: Agregasi log membolehkan pengagregatan log: tetapkan benang.log-agregasi-enable untuk benar dalam fail benang-site.xml untuk membolehkan pengagregatan log. Konfigurasikan dasar pengekalan log: tetapkan yarn.log-aggregasi.Retain-seconds Untuk menentukan masa pengekalan log, seperti 172800 saat (2 hari). Nyatakan Laluan Penyimpanan Log: Melalui Benang

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Perintah shutdown CentOS adalah penutupan, dan sintaks adalah tutup [pilihan] [maklumat]. Pilihan termasuk: -h menghentikan sistem dengan segera; -P mematikan kuasa selepas penutupan; -r mulakan semula; -T Waktu Menunggu. Masa boleh ditentukan sebagai segera (sekarang), minit (minit), atau masa tertentu (HH: mm). Maklumat tambahan boleh dipaparkan dalam mesej sistem.