Peranti teknologi

Peranti teknologi

AI

AI

'Kesilapan' ini sebenarnya bukan satu kesilapan: mulakan dengan empat kertas klasik untuk memahami apa yang 'salah' dengan gambar rajah seni bina Transformer

'Kesilapan' ini sebenarnya bukan satu kesilapan: mulakan dengan empat kertas klasik untuk memahami apa yang 'salah' dengan gambar rajah seni bina Transformer

'Kesilapan' ini sebenarnya bukan satu kesilapan: mulakan dengan empat kertas klasik untuk memahami apa yang 'salah' dengan gambar rajah seni bina Transformer

Beberapa masa lalu, tweet yang menunjukkan ketidakkonsistenan antara gambar rajah seni bina Transformer dan kod dalam kertas kerja pasukan Google Brain "Perhatian Adalah Semua yang Anda Perlukan" mencetuskan banyak perbincangan.

Sesetengah orang berpendapat bahawa penemuan Sebastian adalah kesilapan yang jujur, tetapi ia juga pelik. Lagipun, memandangkan populariti kertas Transformer, ketidakkonsistenan ini sepatutnya disebut seribu kali.

Sebastian Raschka berkata sebagai respons kepada komen netizen bahawa kod "paling asli" memang konsisten dengan gambar rajah seni bina, tetapi versi kod yang diserahkan pada 2017 telah diubah suai, tetapi seni binanya tidak dikemas kini pada masa yang sama. Ini juga punca perbincangan "tidak konsisten".

Seterusnya, Sebastian menerbitkan artikel mengenai Ahead of AI secara khusus menerangkan sebab gambar rajah seni bina Transformer yang asal tidak konsisten dengan kod, dan memetik beberapa kertas untuk menerangkan secara ringkas perkembangan dan perubahan Transformer.

Berikut ialah teks asal artikel tersebut, mari kita lihat tentang maksud artikel tersebut:

Pada masa yang sama, adalah penting untuk memastikan senarai itu ringkas dan padat supaya semua orang dapat mencapai kelajuan dalam tempoh masa yang munasabah. Terdapat juga beberapa kertas yang mengandungi banyak maklumat dan mungkin perlu disertakan.

Saya ingin berkongsi empat kertas kerja yang berguna untuk memahami Transformer dari perspektif sejarah. Walaupun saya hanya menambahnya terus pada artikel Memahami Model Bahasa Besar, saya juga berkongsinya secara berasingan dalam artikel ini supaya ia lebih mudah ditemui oleh mereka yang telah membaca Memahami Model Bahasa Besar sebelum ini.

On Layer Normalization in the Transformer Architecture (2020)

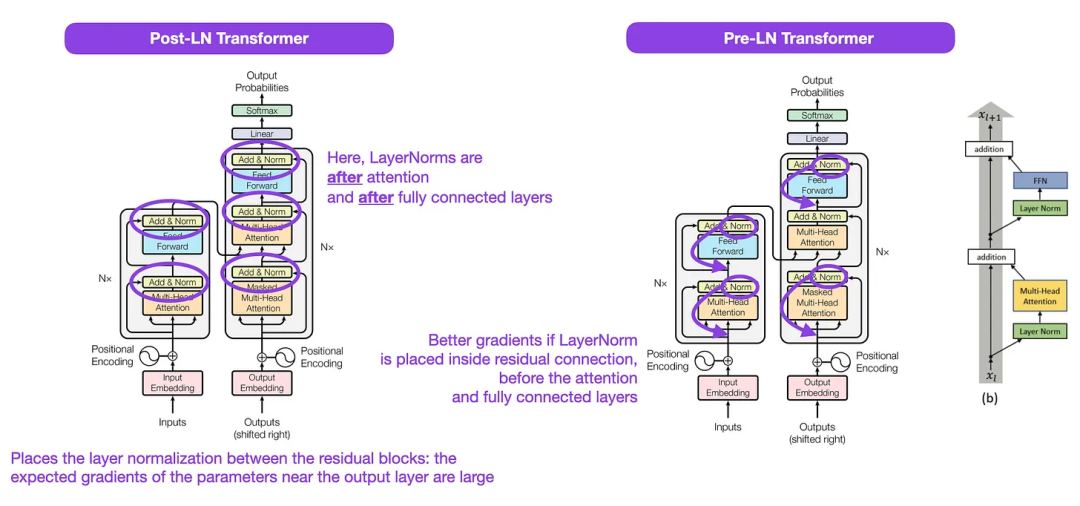

Walaupun imej asal Transformer dalam gambar di bawah (kiri) (https://arxiv.org/abs/1706.03762) ialah ringkasan berguna seni bina penyahkod pengekod asal, tetapi terdapat sedikit perbezaan dalam rajah. Sebagai contoh, ia melakukan normalisasi lapisan antara blok baki, yang tidak sepadan dengan pelaksanaan kod rasmi (dikemas kini) yang disertakan dengan kertas Transformer asal. Varian yang ditunjukkan di bawah (tengah) dipanggil Transformer Pasca-LN.

Penormalan lapisan dalam kertas seni bina Transformer menunjukkan bahawa Pra-LN berfungsi dengan lebih baik dan boleh menyelesaikan masalah kecerunan seperti yang ditunjukkan di bawah. Banyak seni bina menggunakan pendekatan ini dalam amalan, tetapi ia boleh membawa kepada pecahan dalam perwakilan.

Jadi, sementara masih ada perbincangan mengenai penggunaan Pasca-LN atau Pra-LN, terdapat juga kertas kerja baharu yang mencadangkan untuk memohon kedua-duanya bersama-sama: "ResiDual: Transformer with Dual Residual Connections" (https://arxiv.org/abs/2304.14802), tetapi sama ada ia berguna dalam amalan masih belum diketahui.

Ilustrasi: Sumber https://arxiv.org/abs/1706.03762 ( Kiri & Center) dan https://arxiv.org/abs/2002.04745 (kanan)

Ilustrasi: Sumber https://arxiv.org/abs/1706.03762 ( Kiri & Center) dan https://arxiv.org/abs/2002.04745 (kanan)

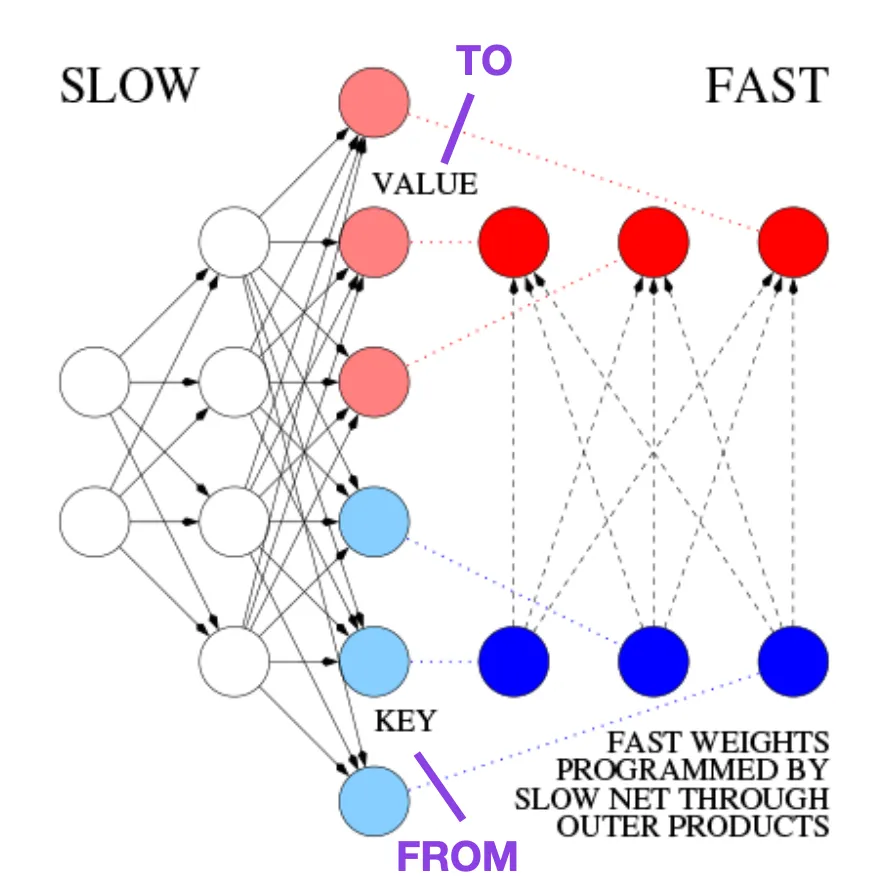

Belajar Mengawal Kenangan Berat Pantas: Alternatif kepada Rangkaian Neural Berulang Dinamik (1991)

Artikel ini disyorkan untuk mereka yang berminat dengan berita-berita sejarah dan kaedah awal yang pada asasnya serupa dengan Transformer moden.

Sebagai contoh, pada tahun 1991, 25 tahun sebelum kertas Transformer, Juergen Schmidhuber mencadangkan alternatif kepada rangkaian saraf berulang (https://www.semanticscholar.org/paper/Learning-to-Control- Fast-Weight -Memories%3A-An-to-Schmidhuber/bc22e87a26d020215afe91c751e5bdaddd8e4922), dipanggil Fast Weight Programmers (FWP). Satu lagi rangkaian saraf yang mencapai perubahan berat yang pantas ialah rangkaian saraf suapan yang terlibat dalam kaedah FWP yang belajar secara perlahan menggunakan algoritma penurunan kecerunan.

Blog ini (https://people.idsia.ch//~juergen/fast-weight-programmer-1991-transformer.html#sec2) membandingkannya dengan Transformer moden The analogi adalah seperti berikut:

Dalam terminologi Transformer hari ini, FROM dan TO dipanggil kunci dan nilai masing-masing. Input yang digunakan rangkaian pantas dipanggil pertanyaan. Pada asasnya, pertanyaan dikendalikan oleh matriks berat pantas, iaitu jumlah produk luar kunci dan nilai (mengabaikan penormalan dan unjuran). Kita boleh menggunakan produk luar tambahan atau produk tensor pesanan kedua untuk mencapai kawalan aktif boleh dibezakan hujung ke hujung terhadap perubahan pantas dalam pemberat kerana semua operasi kedua-dua rangkaian menyokong pembezaan. Semasa pemprosesan jujukan, keturunan kecerunan boleh digunakan untuk menyesuaikan rangkaian pantas dengan cepat kepada masalah rangkaian perlahan. Ini secara matematik bersamaan dengan (kecuali untuk normalisasi) apa yang dikenali sebagai Transformer dengan perhatian kendiri linear (atau Transformer linear).

Seperti yang dinyatakan dalam petikan di atas, pendekatan ini kini dikenali sebagai Linear Transformer atau Transformer dengan linearized self-attention. Ia datang daripada makalah "Transformers are RNNs: Fast Autoregressive Transformers with Linear Attention" (https://arxiv.org/abs/2006.16236) dan "Rethinking Attention with Performers" (https://arxiv. org/abs/2009.14794) .

Pada tahun 2021, makalah "Linear Transformers Are Secretly Fast Weight Programmers" (https://arxiv.org/abs/2102.11174) dengan jelas menunjukkan bahawa perhatian diri linear dan Persamaan 1990-an antara pengaturcara berat pantas.

Sumber imej: https://people.idsia.ch// ~juergen/fast-weight-programmer-1991-transformer.html#sec2

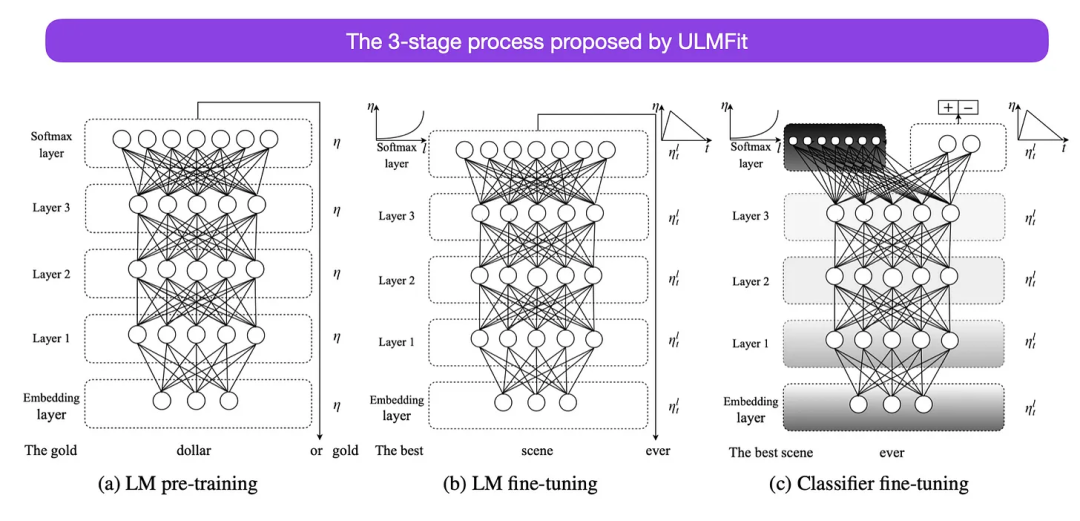

Penalaan Halus Model Bahasa Universal untuk Klasifikasi Teks (2018)

Ini adalah satu lagi kertas kerja yang sangat menarik dari perspektif sejarah. Ia ditulis setahun selepas keluaran asal Attention Is All You Need, dan tidak melibatkan transformer, sebaliknya memfokuskan pada rangkaian saraf berulang, tetapi ia masih berbaloi untuk ditonton. Kerana ia secara berkesan mencadangkan model bahasa pra-latihan dan tugas hiliran pembelajaran pemindahan. Walaupun pembelajaran pemindahan sudah mantap dalam penglihatan komputer, ia masih belum menjadi popular dalam bidang pemprosesan bahasa semula jadi (NLP). ULMFit (https://arxiv.org/abs/1801.06146) ialah salah satu kertas kerja pertama yang menunjukkan bahawa model bahasa pra-latihan boleh menghasilkan hasil SOTA pada banyak tugas NLP apabila diperhalusi pada tugas tertentu.

Proses penalaan model bahasa yang dicadangkan oleh ULMFit dibahagikan kepada tiga peringkat:

- 1 Model korpus;

- 2. Perhalusi model bahasa yang telah dilatih berdasarkan data khusus tugasan supaya dapat menyesuaikan diri dengan gaya dan perbendaharaan kata tertentu;

- 3. Perhalusi pengelas pada data khusus tugas untuk mengelakkan pelupaan bencana dengan menyahbekukan lapisan secara beransur-ansur.

Kaedah melatih model bahasa pada korpus besar dan kemudian memperhalusinya pada tugas hiliran adalah berdasarkan model Transformer dan model asas (seperti BERT, GPT - 2/3/4, RoBERTa, dsb.).

Walau bagaimanapun, sebagai bahagian penting ULMFiT, penyahbekuan progresif biasanya tidak dilakukan dalam amalan, kerana seni bina Transformer biasanya memperhalusi semua lapisan sekaligus.

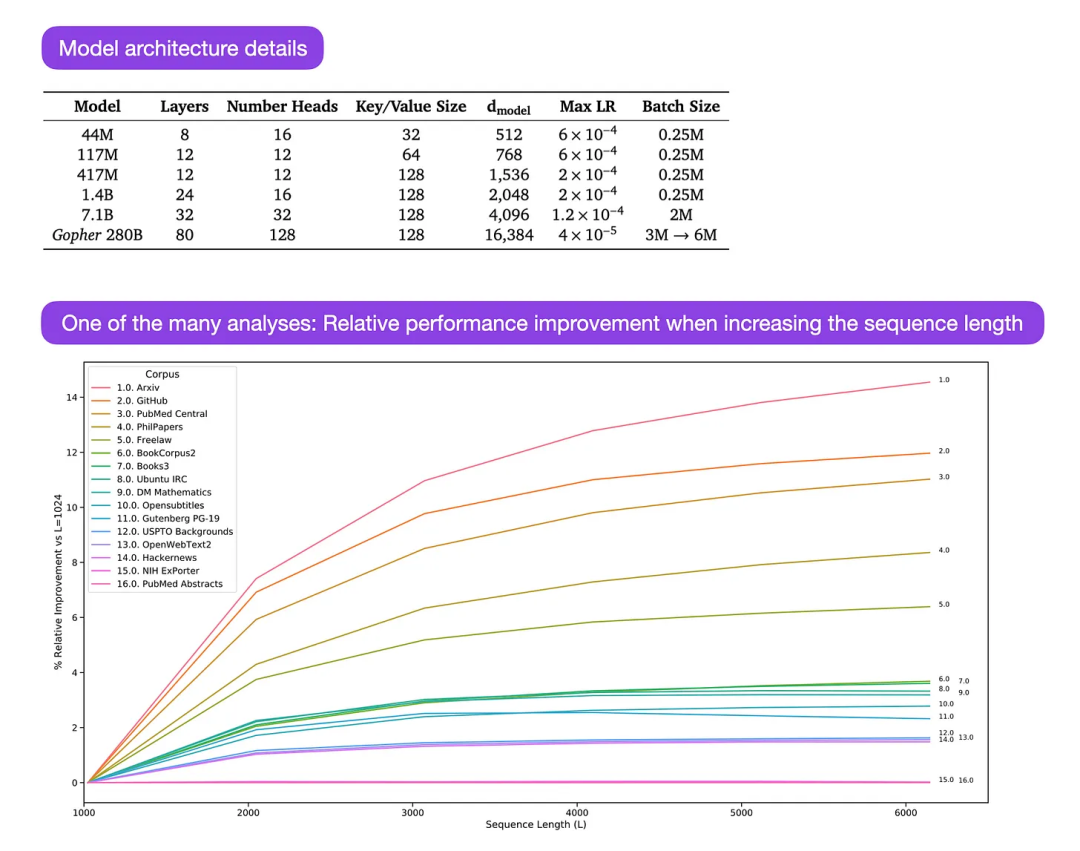

Gopher ialah kertas kerja yang sangat bagus (https://arxiv.org/abs/2112.11446) yang merangkumi analisis yang meluas untuk memahami latihan LLM. Para penyelidik melatih model parameter 80-lapisan, 280 bilion pada 300 bilion token. Ini termasuk beberapa pengubahsuaian seni bina yang menarik, seperti menggunakan RMSNorm (root mean square normalization) dan bukannya LayerNorm (layer normalization). Kedua-dua LayerNorm dan RMSNorm adalah lebih baik daripada BatchNorm kerana ia tidak terhad kepada saiz kelompok dan tidak memerlukan penyegerakan, yang merupakan kelebihan dalam tetapan teragih dengan saiz kelompok yang lebih kecil. RMSNorm biasanya dianggap menstabilkan latihan dalam seni bina yang lebih mendalam.

Selain daripada berita-berita menarik di atas, fokus utama artikel ini adalah untuk menganalisis analisis prestasi tugasan pada skala yang berbeza. Penilaian ke atas 152 tugasan yang berbeza menunjukkan bahawa peningkatan saiz model adalah paling berfaedah untuk tugasan seperti kefahaman, semakan fakta dan mengenal pasti bahasa toksik, manakala pengembangan seni bina kurang berfaedah untuk tugasan yang berkaitan dengan penaakulan logik dan matematik.

Kapsyen imej: Sumber https://arxiv.org/abs/2112.11446

Atas ialah kandungan terperinci 'Kesilapan' ini sebenarnya bukan satu kesilapan: mulakan dengan empat kertas klasik untuk memahami apa yang 'salah' dengan gambar rajah seni bina Transformer. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1376

1376

52

52

Geospatial Laravel: Pengoptimuman peta interaktif dan sejumlah besar data

Apr 08, 2025 pm 12:24 PM

Geospatial Laravel: Pengoptimuman peta interaktif dan sejumlah besar data

Apr 08, 2025 pm 12:24 PM

Cecair memproses 7 juta rekod dan membuat peta interaktif dengan teknologi geospatial. Artikel ini meneroka cara memproses lebih dari 7 juta rekod menggunakan Laravel dan MySQL dan mengubahnya menjadi visualisasi peta interaktif. Keperluan Projek Cabaran Awal: Ekstrak Wawasan berharga menggunakan 7 juta rekod dalam pangkalan data MySQL. Ramai orang mula -mula mempertimbangkan bahasa pengaturcaraan, tetapi mengabaikan pangkalan data itu sendiri: Bolehkah ia memenuhi keperluan? Adakah penghijrahan data atau pelarasan struktur diperlukan? Bolehkah MySQL menahan beban data yang besar? Analisis awal: Penapis utama dan sifat perlu dikenalpasti. Selepas analisis, didapati bahawa hanya beberapa atribut yang berkaitan dengan penyelesaiannya. Kami mengesahkan kemungkinan penapis dan menetapkan beberapa sekatan untuk mengoptimumkan carian. Carian Peta Berdasarkan Bandar

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Terdapat banyak sebab mengapa permulaan MySQL gagal, dan ia boleh didiagnosis dengan memeriksa log ralat. Penyebab umum termasuk konflik pelabuhan (periksa penghunian pelabuhan dan ubah suai konfigurasi), isu kebenaran (periksa keizinan pengguna yang menjalankan perkhidmatan), ralat fail konfigurasi (periksa tetapan parameter), rasuah direktori data (memulihkan data atau membina semula ruang meja), isu ruang jadual InnoDB (semak fail ibdata1) Apabila menyelesaikan masalah, anda harus menganalisisnya berdasarkan log ralat, cari punca utama masalah, dan mengembangkan tabiat sandaran data secara teratur untuk mencegah dan menyelesaikan masalah.

Cara Menggunakan MySQL Selepas Pemasangan

Apr 08, 2025 am 11:48 AM

Cara Menggunakan MySQL Selepas Pemasangan

Apr 08, 2025 am 11:48 AM

Artikel ini memperkenalkan operasi pangkalan data MySQL. Pertama, anda perlu memasang klien MySQL, seperti MySqlworkbench atau Command Line Client. 1. Gunakan perintah MySQL-Uroot-P untuk menyambung ke pelayan dan log masuk dengan kata laluan akaun root; 2. Gunakan CreateTatabase untuk membuat pangkalan data, dan gunakan Pilih pangkalan data; 3. Gunakan createtable untuk membuat jadual, menentukan medan dan jenis data; 4. Gunakan InsertInto untuk memasukkan data, data pertanyaan, kemas kini data dengan kemas kini, dan padam data dengan padam. Hanya dengan menguasai langkah -langkah ini, belajar menangani masalah biasa dan mengoptimumkan prestasi pangkalan data anda boleh menggunakan MySQL dengan cekap.

Memahami sifat asid: tiang pangkalan data yang boleh dipercayai

Apr 08, 2025 pm 06:33 PM

Memahami sifat asid: tiang pangkalan data yang boleh dipercayai

Apr 08, 2025 pm 06:33 PM

Penjelasan terperinci mengenai atribut asid asid pangkalan data adalah satu set peraturan untuk memastikan kebolehpercayaan dan konsistensi urus niaga pangkalan data. Mereka menentukan bagaimana sistem pangkalan data mengendalikan urus niaga, dan memastikan integriti dan ketepatan data walaupun dalam hal kemalangan sistem, gangguan kuasa, atau pelbagai pengguna akses serentak. Gambaran keseluruhan atribut asid Atomicity: Transaksi dianggap sebagai unit yang tidak dapat dipisahkan. Mana -mana bahagian gagal, keseluruhan transaksi dilancarkan kembali, dan pangkalan data tidak mengekalkan sebarang perubahan. Sebagai contoh, jika pemindahan bank ditolak dari satu akaun tetapi tidak meningkat kepada yang lain, keseluruhan operasi dibatalkan. Begintransaction; UpdateAcCountSsetBalance = Balance-100Wh

Jurutera Backend Senior Remote (Platform) memerlukan kalangan

Apr 08, 2025 pm 12:27 PM

Jurutera Backend Senior Remote (Platform) memerlukan kalangan

Apr 08, 2025 pm 12:27 PM

Jurutera Backend Senior Remote Company Kekosongan Syarikat: Lokasi Lokasi: Jauh Pejabat Jauh Jenis: Gaji sepenuh masa: $ 130,000- $ 140,000 Penerangan Pekerjaan Mengambil bahagian dalam penyelidikan dan pembangunan aplikasi mudah alih Circle dan ciri-ciri berkaitan API awam yang meliputi keseluruhan kitaran hayat pembangunan perisian. Tanggungjawab utama kerja pembangunan secara bebas berdasarkan rubyonrails dan bekerjasama dengan pasukan react/redux/relay front-end. Membina fungsi teras dan penambahbaikan untuk aplikasi web dan bekerjasama rapat dengan pereka dan kepimpinan sepanjang proses reka bentuk berfungsi. Menggalakkan proses pembangunan positif dan mengutamakan kelajuan lelaran. Memerlukan lebih daripada 6 tahun backend aplikasi web kompleks

Bolehkah mysql kembali json

Apr 08, 2025 pm 03:09 PM

Bolehkah mysql kembali json

Apr 08, 2025 pm 03:09 PM

MySQL boleh mengembalikan data JSON. Fungsi JSON_EXTRACT mengekstrak nilai medan. Untuk pertanyaan yang kompleks, pertimbangkan untuk menggunakan klausa WHERE untuk menapis data JSON, tetapi perhatikan kesan prestasinya. Sokongan MySQL untuk JSON sentiasa meningkat, dan disyorkan untuk memberi perhatian kepada versi dan ciri terkini.

Mysql tidak dapat dipasang setelah memuat turun

Apr 08, 2025 am 11:24 AM

Mysql tidak dapat dipasang setelah memuat turun

Apr 08, 2025 am 11:24 AM

Sebab utama kegagalan pemasangan MySQL adalah: 1. Isu kebenaran, anda perlu menjalankan sebagai pentadbir atau menggunakan perintah sudo; 2. Ketergantungan hilang, dan anda perlu memasang pakej pembangunan yang relevan; 3. Konflik pelabuhan, anda perlu menutup program yang menduduki port 3306 atau mengubah suai fail konfigurasi; 4. Pakej pemasangan adalah korup, anda perlu memuat turun dan mengesahkan integriti; 5. Pembolehubah persekitaran dikonfigurasikan dengan salah, dan pembolehubah persekitaran mesti dikonfigurasi dengan betul mengikut sistem operasi. Selesaikan masalah ini dan periksa dengan teliti setiap langkah untuk berjaya memasang MySQL.

Klausa had SQL Master: Kawal bilangan baris dalam pertanyaan

Apr 08, 2025 pm 07:00 PM

Klausa had SQL Master: Kawal bilangan baris dalam pertanyaan

Apr 08, 2025 pm 07:00 PM

Klausa SQLLIMIT: Kawal bilangan baris dalam hasil pertanyaan. Klausa had dalam SQL digunakan untuk mengehadkan bilangan baris yang dikembalikan oleh pertanyaan. Ini sangat berguna apabila memproses set data yang besar, paparan paginat dan data ujian, dan dapat meningkatkan kecekapan pertanyaan dengan berkesan. Sintaks Asas Sintaks: SelectColumn1, Column2, ... FROMTABLE_NAMELIMITNUMBER_OF_ROWS; Number_of_rows: Tentukan bilangan baris yang dikembalikan. Sintaks dengan Offset: SelectColumn1, Column2, ... Fromtable_namelimitoffset, Number_of_rows; Offset: Langkau