Peranti teknologi

Peranti teknologi

AI

AI

Hasil penyelidikan baharu daripada pasukan Yann LeCun: Kejuruteraan songsang pembelajaran penyeliaan kendiri, ternyata pengelompokan dilaksanakan seperti ini

Hasil penyelidikan baharu daripada pasukan Yann LeCun: Kejuruteraan songsang pembelajaran penyeliaan kendiri, ternyata pengelompokan dilaksanakan seperti ini

Hasil penyelidikan baharu daripada pasukan Yann LeCun: Kejuruteraan songsang pembelajaran penyeliaan kendiri, ternyata pengelompokan dilaksanakan seperti ini

Pembelajaran penyeliaan kendiri (SSL) telah mencapai kemajuan yang besar dalam beberapa tahun kebelakangan ini dan hampir mencapai tahap kaedah pembelajaran terselia pada banyak tugas hiliran. Walau bagaimanapun, disebabkan kerumitan model dan kekurangan set data latihan beranotasi, sukar untuk memahami perwakilan yang dipelajari dan mekanisme kerja asasnya. Tambahan pula, tugasan dalih yang digunakan dalam pembelajaran penyeliaan kendiri selalunya tidak berkaitan secara langsung dengan tugas hiliran tertentu, yang meningkatkan lagi kerumitan mentafsir perwakilan yang dipelajari. Dalam klasifikasi yang diselia, struktur perwakilan yang dipelajari selalunya sangat mudah.

Berbanding dengan tugas pengelasan tradisional (matlamatnya adalah untuk mengelaskan sampel dengan tepat ke dalam kategori tertentu), matlamat algoritma SSL moden biasanya untuk meminimumkan fungsi kehilangan yang mengandungi dua komponen utama: Pertama, Kelompokkan sampel yang dipertingkatkan (kekangan invarian), dan yang kedua adalah untuk mengelakkan keruntuhan perwakilan (kekangan penyelarasan). Sebagai contoh, untuk sampel yang sama selepas peningkatan yang berbeza, matlamat kaedah pembelajaran kontrastif adalah untuk menjadikan keputusan klasifikasi sampel ini sama, dan pada masa yang sama dapat membezakan sampel yang berbeza selepas peningkatan. Sebaliknya, kaedah bukan kontrastif menggunakan regularizer untuk mengelakkan keruntuhan perwakilan.

Pembelajaran kendiri boleh menggunakan tugas tambahan (dalih) data tanpa pengawasan untuk melombong maklumat penyeliaannya sendiri, dan melatih rangkaian melalui maklumat penyeliaan yang dibina ini, supaya ia boleh belajar ke hiliran Perwakilan bahawa tugas itu berharga. Baru-baru ini, beberapa penyelidik, termasuk pemenang Anugerah Turing Yann LeCun, mengeluarkan kajian yang mendakwa mempunyai pembelajaran penyeliaan kendiri rekaan terbalik, membolehkan kami memahami tingkah laku dalaman proses latihannya.

Alamat kertas: https://arxiv.org/abs/2305.15614v2

Kertas kerja ini menyediakan analisis mendalam tentang pembelajaran perwakilan menggunakan SLL melalui satu siri eksperimen yang direka dengan teliti untuk membantu orang ramai memahami proses pengelompokan semasa latihan. Secara khusus, kami mendedahkan bahawa sampel ditambah mempamerkan gelagat yang sangat berkelompok, yang membentuk centroid di sekitar pembenaman makna sampel ditambah yang berkongsi imej yang sama. Lebih tidak disangka-sangka, para penyelidik memerhatikan bahawa sampel berkelompok berdasarkan label semantik walaupun tanpa adanya maklumat yang jelas tentang tugas sasaran. Ini menunjukkan keupayaan SSL untuk mengumpulkan sampel berdasarkan persamaan semantik.

Tetapan Masalah

Memandangkan pembelajaran penyeliaan kendiri (SSL) sering digunakan untuk pra-latihan untuk menyediakan model untuk menyesuaikan diri dengan tugas hiliran, ini membawa satu kunci soalan: Apakah kesan latihan SSL terhadap perwakilan yang dipelajari? Secara khususnya, bagaimanakah SSL berfungsi di bawah hud semasa latihan, dan apakah kategori yang boleh dipelajari oleh fungsi perwakilan ini?

Untuk menyiasat isu ini, penyelidik melatih rangkaian SSL pada berbilang tetapan dan menganalisis tingkah laku mereka menggunakan teknik yang berbeza.

Data dan penambahan: Semua percubaan yang disebut dalam artikel ini menggunakan set data pengelasan imej CIFAR100. Untuk melatih model, para penyelidik menggunakan protokol peningkatan imej yang dicadangkan dalam SimCLR. Setiap sesi latihan SSL dilaksanakan selama 1000 zaman, menggunakan pengoptimum SGD dengan momentum.

Seni bina tulang belakang: Semua eksperimen menggunakan seni bina RES-L-H sebagai tulang belakang, ditambah dengan dua lapisan kepala unjuran multi-layer perceptron (MLP).

Penyelidikan linear: Untuk menilai keberkesanan mengekstrak fungsi diskret tertentu (cth. kategori) daripada fungsi perwakilan, kaedah yang digunakan di sini ialah probing linear. Ini memerlukan latihan pengelas linear (juga dipanggil probe linear) berdasarkan perwakilan ini, yang memerlukan beberapa sampel latihan.

Klasifikasi peringkat sampel: Untuk menilai kebolehpisahan peringkat sampel, penyelidik mencipta set data baharu khusus.

di mana set data latihan mengandungi 500 imej rawak daripada set latihan CIFAR-100. Setiap imej mewakili kategori tertentu dan dipertingkatkan dalam 100 cara berbeza. Oleh itu, set data latihan mengandungi sejumlah 50,000 sampel 500 kategori. Set ujian masih menggunakan 500 imej ini, tetapi menggunakan 20 peningkatan berbeza, semuanya daripada pengedaran yang sama. Oleh itu, keputusan dalam set ujian terdiri daripada 10,000 sampel. Untuk mengukur ketepatan linear atau NCC (pusat kelas terdekat/pusat kelas terdekat) bagi fungsi perwakilan yang diberikan pada peringkat sampel, kaedah yang digunakan di sini ialah menggunakan data latihan terlebih dahulu untuk mengira pengelas yang berkaitan, dan kemudian mengiranya pada set ujian yang sepadan Nilaikan ketepatannya.

Mendedahkan proses pengelompokan pembelajaran penyeliaan kendiri

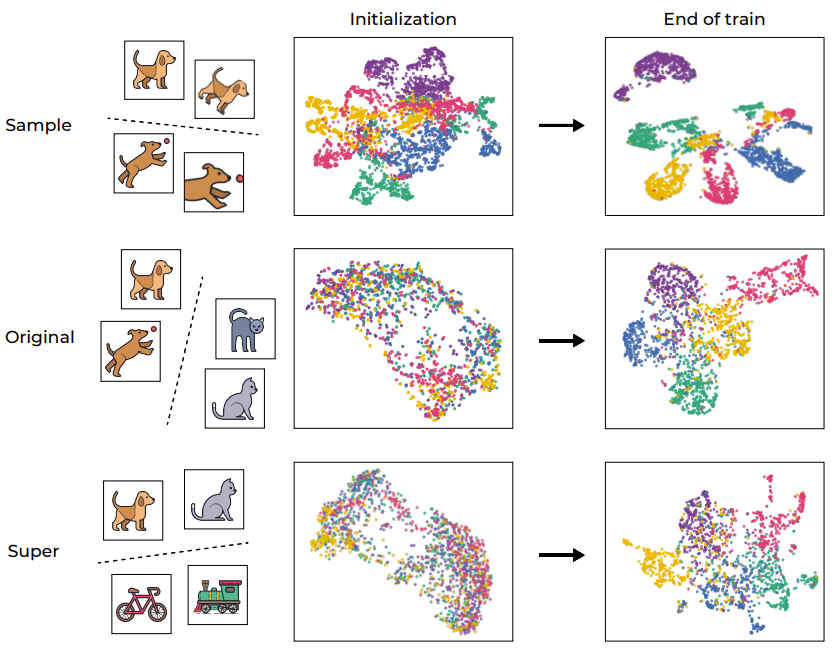

Proses pengelompokan sentiasa memainkan peranan penting dalam membantu menganalisis model pembelajaran mendalam. Untuk memahami latihan SSL secara intuitif, Rajah 1 menggambarkan ruang pembenaman sampel latihan rangkaian melalui UMAP, yang merangkumi situasi sebelum dan selepas latihan dan dibahagikan kepada tahap yang berbeza.

Rajah 1: Pengelompokan semantik yang disebabkan oleh latihan SSL

Seperti yang dijangkakan, proses latihan berjaya mengelompokkan sampel pada tahap sampel, memetakan peningkatan yang berbeza bagi imej yang sama (seperti yang ditunjukkan dalam baris pertama Rajah Tunjukkan). Keputusan ini tidak dijangka memandangkan fungsi objektif itu sendiri menggalakkan tingkah laku ini (melalui istilah kehilangan invarian). Walau bagaimanapun, lebih ketara, proses latihan ini juga berkelompok berdasarkan "kategori semantik" asal bagi set data CIFAR-100 standard, walaupun terdapat kekurangan label semasa proses latihan. Menariknya, tahap yang lebih tinggi (superkategori) juga boleh dikelompokkan dengan berkesan. Contoh ini menunjukkan bahawa walaupun proses latihan secara langsung menggalakkan pengelompokan pada peringkat sampel, perwakilan data yang dilatih oleh SSL juga dikelompokkan mengikut kategori semantik pada tahap yang berbeza.

Untuk mengukur lagi proses pengelompokan ini, para penyelidik menggunakan VICReg untuk melatih RES-10-250. Para penyelidik mengukur ketepatan latihan NCC, kedua-duanya pada peringkat sampel dan berdasarkan kategori asal. Perlu diingat bahawa perwakilan terlatih SSL mempamerkan keruntuhan saraf pada tahap sampel (ketepatan latihan NCC hampir 1.0), tetapi pengelompokan dari segi kategori semantik juga penting (kira-kira 1.0 pada sasaran asal) 0.41).

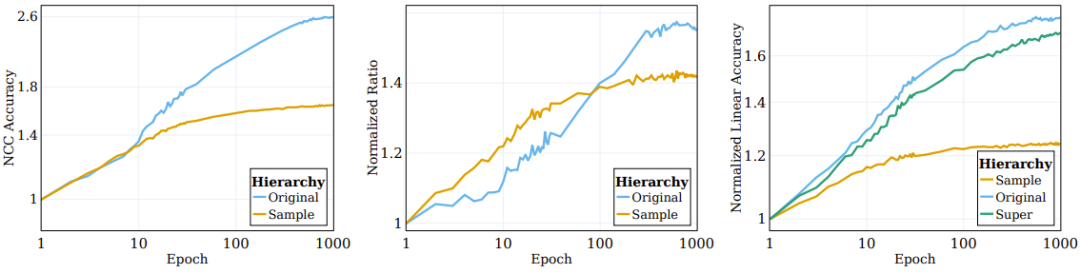

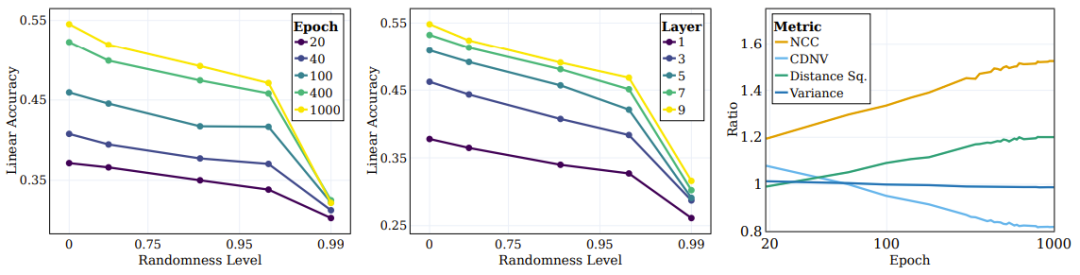

Seperti yang ditunjukkan dalam gambar kiri Rajah 2, kebanyakan proses pengelompokan yang melibatkan penambahan (di mana rangkaian dilatih secara langsung) berlaku pada peringkat awal proses latihan dan kemudian datang terhenti; manakala dalam semantik Pengelompokan mengikut kategori (tidak dinyatakan dalam objektif latihan) akan terus bertambah baik semasa latihan.

Rajah 2: Algoritma SSL mengelompokkan data mengikut pasangan sasaran semantik

Penyelidik terdahulu telah memerhatikan bahawa pembenaman peringkat atas sampel latihan yang diselia akan bertumpu secara beransur-ansur ke arah struktur seperti centroid. Untuk lebih memahami sifat pengelompokan fungsi perwakilan terlatih SSL, kami menyiasat situasi yang sama semasa SSL. Pengelas NCCnya ialah pengelas linear dan tidak berprestasi lebih baik daripada pengelas linear terbaik. Pengelasan data boleh dikaji pada tahap kebutiran yang berbeza dengan menilai ketepatan pengelas NCC berbanding dengan pengelas linear yang dilatih pada data yang sama. Panel tengah Rajah 2 menunjukkan evolusi nisbah ini merentas kategori peringkat sampel dan kategori sasaran asal, dengan nilai dinormalkan kepada nilai yang dimulakan. Apabila latihan SSL diteruskan, jurang antara ketepatan NCC dan ketepatan linear menjadi lebih kecil, menunjukkan bahawa sampel ditambah secara beransur-ansur meningkatkan tahap pengelompokan berdasarkan identiti sampel dan sifat semantik mereka.

Tambahan pula, angka tersebut juga menggambarkan bahawa nisbah peringkat sampel pada mulanya lebih tinggi, menunjukkan bahawa sampel yang ditambah dikelompokkan mengikut identiti mereka sehingga ia menumpu kepada centroid (NCC tepat Nisbah ketepatan dan ketepatan linear ialah ≥ 0.9 pada 100 zaman). Walau bagaimanapun, apabila latihan berterusan, nisbah peringkat sampel menjadi tepu, manakala nisbah peringkat kelas terus berkembang dan menumpu kepada sekitar 0.75. Ini menunjukkan bahawa sampel yang dipertingkatkan terlebih dahulu akan dikelompokkan mengikut identiti sampel, dan selepas pelaksanaan, ia akan dikelompokkan mengikut kategori semantik peringkat tinggi.

Mampatan maklumat tersirat dalam latihan SSL

Jika pemampatan boleh dilakukan dengan berkesan, representasi yang bermanfaat dan berguna boleh diperolehi. Walau bagaimanapun, sama ada pemampatan sedemikian berlaku semasa latihan SSL masih menjadi topik yang telah dipelajari oleh beberapa orang.

Untuk memahami perkara ini, penyelidik menggunakan Mutual Information Neural Estimation (MINE), kaedah yang boleh menganggarkan hubungan antara input dan perwakilan terbenam yang sepadan semasa latihan. Metrik ini boleh digunakan untuk mengukur tahap kerumitan perwakilan dengan berkesan dengan menunjukkan berapa banyak maklumat (bilangan bit) yang dikodkan.

Panel tengah Rajah 3 melaporkan purata maklumat bersama yang dikira pada 5 benih permulaan MINE yang berbeza. Seperti yang ditunjukkan dalam rajah, terdapat pemampatan yang ketara semasa proses latihan, menghasilkan perwakilan latihan yang sangat padat.

Carta di sebelah kiri menunjukkan regularisasi dan invarian model latihan SSL semasa proses latihan Perubahan dalam kehilangan dan ketepatan ujian lineariti sasaran asal. (Pusat) Pemampatan maklumat bersama antara input dan perwakilan semasa latihan. (Kanan) Latihan SSL mempelajari perwakilan kelompok.

Peranan kehilangan regularisasi

Fungsi objektif mengandungi dua item: invarian dan Regularisasi. Fungsi utama istilah invarian adalah untuk mengukuhkan persamaan antara perwakilan yang dipertingkatkan secara berbeza bagi sampel yang sama. Matlamat istilah penyelarasan adalah untuk membantu mencegah keruntuhan perwakilan.

Untuk meneroka peranan komponen ini dalam proses pengelompokan, penyelidik menguraikan fungsi objektif kepada istilah invarian dan istilah regularisasi dan memerhati tingkah laku mereka semasa proses latihan. Keputusan perbandingan ditunjukkan dalam panel kiri Rajah 3, di mana evolusi istilah kehilangan pada sasaran semantik asal dan ketepatan ujian linear diberikan. Bertentangan dengan kepercayaan popular, istilah kehilangan invarian tidak bertambah baik dengan ketara semasa latihan. Sebaliknya, peningkatan dalam kerugian (dan ketepatan semantik hiliran) dicapai dengan mengurangkan kerugian regularisasi.

Boleh disimpulkan bahawa kebanyakan proses latihan SSL adalah untuk meningkatkan ketepatan semantik dan pengelompokan perwakilan yang dipelajari, bukannya ketepatan pengelasan peringkat sampel dan jenis pengelompokan.

Pada asasnya, dapatan di sini menunjukkan bahawa walaupun matlamat langsung pembelajaran penyeliaan kendiri ialah pengelasan peringkat sampel, kebanyakan masa latihan sebenarnya dibelanjakan pada tahap kategori semantik yang berbeza berkelompok. Pemerhatian ini menunjukkan keupayaan kaedah SSL untuk menjana perwakilan bermakna secara semantik melalui pengelompokan, yang juga membolehkan kami memahami mekanisme asasnya.

Perbandingan pembelajaran diselia dan pengelompokan SSL

Pengkelas rangkaian dalam selalunya berdasarkan kategori sampel latihan. Mereka dikelompokkan kepada centroid individu. Walau bagaimanapun, agar fungsi yang dipelajari benar-benar berkelompok, sifat ini mesti masih sah untuk sampel ujian ini adalah kesan yang kami jangkakan, tetapi kesannya akan menjadi lebih teruk.

Persoalan yang menarik di sini: sejauh manakah SSL boleh melakukan pengelompokan berdasarkan kategori semantik sampel berbanding pengelompokan melalui pembelajaran diselia? Panel kanan Rajah 3 melaporkan nisbah ketepatan latihan dan ujian NCC pada penghujung latihan untuk senario yang berbeza (dengan dan tanpa pembelajaran diselia yang dipertingkatkan dan SSL).

Walaupun ketepatan latihan NCC pengelas diselia ialah 1.0, yang jauh lebih tinggi daripada ketepatan latihan NCC model terlatih SSL, ketepatan ujian NCC model SSL adalah sedikit. ketepatan ujian NCC yang lebih tinggi untuk model yang diselia. Ini menunjukkan bahawa gelagat pengelompokan kedua-dua model mengikut kategori semantik adalah serupa pada tahap tertentu. Menariknya, menggunakan sampel tambahan untuk melatih model yang diselia mengurangkan sedikit ketepatan latihan NCC, tetapi meningkatkan ketepatan ujian NCC dengan ketara.

Meneroka kesan pembelajaran kategori semantik dan rawak

Kategori semantik mentakrifkan hubungan antara input dan sasaran berdasarkan corak intrinsik input. Sebaliknya, jika anda memetakan input kepada sasaran rawak, anda akan melihat kekurangan corak yang boleh dilihat, yang menyebabkan hubungan antara input dan sasaran kelihatan sewenang-wenangnya.

Para penyelidik juga meneroka kesan rawak ke atas kecekapan sasaran yang diperlukan untuk pembelajaran model. Untuk melakukan ini, mereka membina satu siri sistem sasaran dengan pelbagai peringkat rawak dan kemudian mengkaji kesan rawak pada perwakilan yang dipelajari. Mereka melatih pengelas rangkaian saraf pada set data yang sama yang digunakan untuk pengelasan dan kemudian menggunakan ramalan sasarannya dari zaman yang berbeza sebagai sasaran dengan darjah rawak yang berbeza. Pada zaman 0, rangkaian adalah rawak sepenuhnya dan mendapat label deterministik tetapi nampaknya sewenang-wenangnya. Semasa latihan diteruskan, kerawak fungsinya berkurangan, dan akhirnya sasaran diperoleh yang sejajar dengan sasaran kebenaran tanah (yang boleh dianggap sebagai bukan rawak sepenuhnya). Tahap rawak dinormalisasi di sini untuk berjulat daripada 0 (tidak sama sekali rawak, pada akhir latihan) hingga 1 (rawak sepenuhnya, pada permulaan).

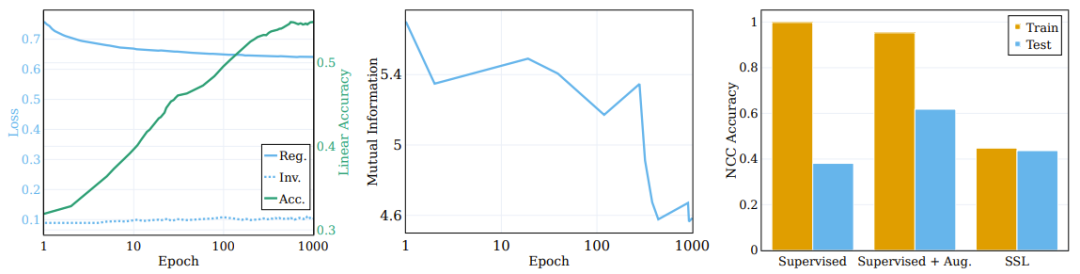

Rajah 4 Graf kiri menunjukkan ketepatan ujian linear untuk sasaran rawak yang berbeza. Setiap baris sepadan dengan ketepatan peringkat latihan SSL yang berbeza dengan darjah rawak yang berbeza. Ia boleh dilihat bahawa semasa latihan, model akan lebih cekap menangkap kategori yang lebih dekat dengan sasaran "semantik" (rawak rendah), sambil tidak menunjukkan peningkatan prestasi yang ketara pada sasaran rawak tinggi.

Rajah 4: SSL secara berterusan mempelajari sasaran semantik dan bukannya sasaran rawak

Isu utama dalam pembelajaran mendalam ialah memahami peranan dan kesan lapisan perantaraan dalam mengklasifikasikan jenis kategori yang berbeza. Sebagai contoh, adakah lapisan berbeza akan mempelajari jenis kategori yang berbeza? Penyelidik juga telah meneroka isu ini dengan menilai ketepatan ujian linear bagi perwakilan lapisan yang berbeza pada akhir latihan pada tahap rawak sasaran yang berbeza. Seperti yang ditunjukkan dalam panel tengah Rajah 4, ketepatan ujian linear terus bertambah baik apabila rawak berkurangan, dengan lapisan yang lebih dalam menunjukkan prestasi yang lebih baik merentas semua jenis kategori, dan jurang prestasi menjadi lebih besar untuk klasifikasi yang hampir dengan kategori semantik.

Para penyelidik juga menggunakan beberapa metrik lain untuk menilai kualiti pengelompokan: ketepatan NCC, CDNV, purata varians setiap kelas dan purata jarak kuasa dua antara min kelas. Untuk mengukur bagaimana perwakilan bertambah baik dengan latihan, penyelidik mengira nisbah metrik ini untuk sasaran semantik dan rawak. Panel kanan Rajah 4 menggambarkan nisbah ini, yang menunjukkan bahawa perwakilan lebih mengutamakan pengelompokan data berdasarkan matlamat semantik dan bukannya matlamat rawak. Menariknya, seseorang boleh melihat bahawa CDNV (varian dibahagikan dengan jarak kuasa dua) berkurangan hanya dengan penurunan jarak kuasa dua. Nisbah varians agak stabil semasa latihan. Ini menggalakkan jarak yang lebih besar antara kluster, fenomena yang telah ditunjukkan membawa kepada peningkatan prestasi.

Memahami hierarki kategori dan lapisan perantaraan

Penyelidikan terdahulu telah membuktikan bahawa dalam pembelajaran diselia, lapisan perantaraan secara beransur-ansur menangkap ciri pada tahap abstraksi yang berbeza. Lapisan awal cenderung kepada ciri peringkat rendah, manakala lapisan yang lebih dalam menangkap lebih banyak ciri abstrak. Seterusnya, penyelidik meneroka sama ada rangkaian SSL boleh mempelajari atribut hierarki pada tahap yang lebih tinggi dan tahap yang lebih baik dikaitkan dengan atribut ini.

Dalam percubaan, mereka mengira ketepatan ujian linear pada tiga tahap: tahap sampel, 100 kategori asal dan 20 kategori super. Panel kanan Rajah 2 memberikan kuantiti yang dikira untuk tiga set kategori yang berbeza ini. Dapat diperhatikan bahawa semasa proses latihan, peningkatan prestasi pada peringkat kategori asal dan kategori super adalah lebih ketara daripada peringkat sampel.

Yang berikut ialah gelagat lapisan perantaraan model terlatih SSL dan keupayaannya untuk menangkap objektif pada tahap yang berbeza. Panel kiri dan tengah Rajah 5 memberikan ketepatan ujian linear pada semua lapisan perantaraan pada peringkat latihan yang berbeza, di mana sasaran asal dan sasaran super diukur. Panel kanan Rajah 5 memberikan nisbah antara superkategori dan kategori asal. Rajah 5: SSL boleh berkesan dalam keseluruhan lapisan tengah Pelajari kategori semantik

Para penyelidik membuat beberapa kesimpulan berdasarkan keputusan ini. Pertama, dapat diperhatikan bahawa apabila lapisan semakin dalam, kesan pengelompokan akan terus bertambah baik. Tambahan pula, sama seperti kes pembelajaran yang diselia, penyelidik mendapati bahawa ketepatan linear setiap lapisan rangkaian bertambah baik semasa latihan SSL. Terutama, mereka mendapati bahawa lapisan akhir bukanlah lapisan optimum untuk kelas asal. Beberapa penyelidikan SSL baru-baru ini menunjukkan bahawa tugas hiliran boleh memberi kesan tinggi kepada prestasi algoritma yang berbeza. Kerja kami memanjangkan pemerhatian ini dan mencadangkan bahawa bahagian rangkaian yang berlainan mungkin sesuai untuk tugas hiliran dan tahap tugas yang berbeza. Menurut panel kanan Rajah 5, dapat dilihat bahawa dalam lapisan rangkaian yang lebih dalam, ketepatan kategori super bertambah baik daripada kategori asal.

Atas ialah kandungan terperinci Hasil penyelidikan baharu daripada pasukan Yann LeCun: Kejuruteraan songsang pembelajaran penyeliaan kendiri, ternyata pengelompokan dilaksanakan seperti ini. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

Menyelam mendalam ke dalam model, data dan rangka kerja: tinjauan menyeluruh 54 halaman model bahasa besar yang cekap

Jan 14, 2024 pm 07:48 PM

Menyelam mendalam ke dalam model, data dan rangka kerja: tinjauan menyeluruh 54 halaman model bahasa besar yang cekap

Jan 14, 2024 pm 07:48 PM

Model bahasa berskala besar (LLM) telah menunjukkan keupayaan yang menarik dalam banyak tugas penting, termasuk pemahaman bahasa semula jadi, penjanaan bahasa dan penaakulan yang kompleks, dan telah memberi kesan yang mendalam kepada masyarakat. Walau bagaimanapun, keupayaan cemerlang ini memerlukan sumber latihan yang ketara (ditunjukkan di sebelah kiri) dan masa inferens yang panjang (ditunjukkan di sebelah kanan). Oleh itu, penyelidik perlu membangunkan cara teknikal yang berkesan untuk menyelesaikan masalah kecekapan mereka. Di samping itu, seperti yang dapat dilihat dari sebelah kanan rajah, beberapa LLM (Model Bahasa) yang cekap seperti Mistral-7B telah berjaya digunakan dalam reka bentuk dan penggunaan LLM. LLM yang cekap ini boleh mengurangkan memori inferens dengan ketara sambil mengekalkan ketepatan yang serupa dengan LLaMA1-33B

Gabungan hebat model penyebaran + resolusi super, teknologi di sebalik penjana imej Google Imagen

Apr 10, 2023 am 10:21 AM

Gabungan hebat model penyebaran + resolusi super, teknologi di sebalik penjana imej Google Imagen

Apr 10, 2023 am 10:21 AM

Dalam beberapa tahun kebelakangan ini, pembelajaran multimodal telah mendapat banyak perhatian, terutamanya dalam dua arah sintesis teks-imej dan pembelajaran kontrastif imej-teks. Sesetengah model AI telah menarik perhatian umum kerana aplikasinya dalam penjanaan dan penyuntingan imej kreatif, seperti model imej teks DALL・E dan DALL-E 2 yang dilancarkan oleh OpenAI, dan GauGAN dan GauGAN2 NVIDIA. Tidak ketinggalan, Google mengeluarkan model teks-ke-imej sendiri Imagen pada penghujung Mei, yang nampaknya memperluaskan lagi sempadan penjanaan imej bersyarat kapsyen. Memandangkan hanya perihalan adegan, Imagen boleh menghasilkan kualiti tinggi, resolusi tinggi

Menghancurkan H100, GPU generasi seterusnya Nvidia didedahkan! Reka bentuk modul berbilang cip 3nm pertama, diperkenalkan pada 2024

Sep 30, 2023 pm 12:49 PM

Menghancurkan H100, GPU generasi seterusnya Nvidia didedahkan! Reka bentuk modul berbilang cip 3nm pertama, diperkenalkan pada 2024

Sep 30, 2023 pm 12:49 PM

Proses 3nm, prestasi melepasi H100! Baru-baru ini, media asing DigiTimes mengumumkan bahawa Nvidia sedang membangunkan GPU generasi akan datang, B100, dengan nama kod "Blackwell" Dikatakan bahawa sebagai produk untuk aplikasi kecerdasan buatan (AI) dan pengkomputeran berprestasi tinggi (HPC). , B100 akan menggunakan proses proses 3nm TSMC, serta reka bentuk modul berbilang cip (MCM) yang lebih kompleks, dan akan muncul pada suku keempat 2024. Bagi Nvidia, yang memonopoli lebih daripada 80% pasaran GPU kecerdasan buatan, ia boleh menggunakan B100 untuk menyerang semasa seterika panas dan seterusnya menyerang pencabar seperti AMD dan Intel dalam gelombang penggunaan AI ini. Menurut anggaran NVIDIA, menjelang 2027, nilai output medan ini dijangka mencapai lebih kurang

Semakan paling komprehensif tentang model besar multimodal ada di sini! 7 penyelidik Microsoft bekerjasama bersungguh-sungguh, 5 tema utama, 119 halaman dokumen

Sep 25, 2023 pm 04:49 PM

Semakan paling komprehensif tentang model besar multimodal ada di sini! 7 penyelidik Microsoft bekerjasama bersungguh-sungguh, 5 tema utama, 119 halaman dokumen

Sep 25, 2023 pm 04:49 PM

Kajian yang paling komprehensif tentang model besar berbilang mod ada di sini! Ditulis oleh 7 penyelidik Cina di Microsoft, ia mempunyai 119 halaman - ia bermula daripada dua jenis arahan penyelidikan model besar berbilang modal yang telah selesai dan masih berada di barisan hadapan, dan meringkaskan secara komprehensif lima topik penyelidikan khusus: pemahaman visual dan penjanaan visual Ejen berbilang modal model besar berbilang modal yang disokong oleh model visual bersatu LLM memfokuskan pada fenomena: model asas berbilang modal telah beralih daripada khusus kepada universal. Ps. Inilah sebabnya penulis melukis secara langsung imej Doraemon pada permulaan kertas. Siapa yang patut membaca ulasan (laporan) ini? Dalam kata-kata asal Microsoft: Selagi anda berminat untuk mempelajari pengetahuan asas dan kemajuan terkini model asas pelbagai mod, sama ada anda seorang penyelidik profesional atau pelajar, kandungan ini sangat sesuai untuk anda berkumpul.

Kertas skor sempurna VPR 2024! Meta mencadangkan EfficientSAM: cepat belah semuanya!

Mar 02, 2024 am 10:10 AM

Kertas skor sempurna VPR 2024! Meta mencadangkan EfficientSAM: cepat belah semuanya!

Mar 02, 2024 am 10:10 AM

Kerja EfficientSAM ini telah dimasukkan ke dalam CVPR2024 dengan skor sempurna 5/5/5! Penulis berkongsi hasilnya di media sosial, seperti yang ditunjukkan dalam gambar di bawah: Pemenang Anugerah LeCun Turing juga sangat mengesyorkan karya ini! Dalam penyelidikan baru-baru ini, penyelidik Meta telah mencadangkan kaedah baharu yang dipertingkatkan, iaitu pra-latihan imej topeng (SAMI) menggunakan SAM. Kaedah ini menggabungkan teknologi pra-latihan MAE dan model SAM untuk mencapai pengekod ViT pra-latihan berkualiti tinggi. Melalui SAMI, penyelidik cuba meningkatkan prestasi dan kecekapan model dan menyediakan penyelesaian yang lebih baik untuk tugas penglihatan. Cadangan kaedah ini membawa idea dan peluang baharu untuk meneroka dan mengembangkan lagi bidang visi komputer dan pembelajaran mendalam. dengan menggabungkan berbeza

Penyesuai I2V daripada komuniti SD: tiada konfigurasi diperlukan, pasang dan main, serasi sempurna dengan pemalam video Tusheng

Jan 15, 2024 pm 07:48 PM

Penyesuai I2V daripada komuniti SD: tiada konfigurasi diperlukan, pasang dan main, serasi sempurna dengan pemalam video Tusheng

Jan 15, 2024 pm 07:48 PM

Tugas penjanaan imej-ke-video (I2V) merupakan satu cabaran dalam bidang penglihatan komputer yang bertujuan untuk menukar imej statik kepada video dinamik. Kesukaran tugas ini adalah untuk mengekstrak dan menjana maklumat dinamik dalam dimensi temporal daripada imej tunggal sambil mengekalkan keaslian dan keselarasan visual kandungan imej. Kaedah I2V sedia ada selalunya memerlukan seni bina model yang kompleks dan sejumlah besar data latihan untuk mencapai matlamat ini. Baru-baru ini, hasil penyelidikan baharu "I2V-Adapter: AGeneralImage-to-VideoAdapter for VideoDiffusionModels" yang diketuai oleh Kuaishou telah dikeluarkan. Kajian ini memperkenalkan kaedah penukaran imej-ke-video yang inovatif dan mencadangkan modul penyesuai ringan, i.e.

Hadiah Boltzmann 2022 diumumkan: Pengasas Hopfield Network memenangi anugerah

Aug 13, 2023 pm 08:49 PM

Hadiah Boltzmann 2022 diumumkan: Pengasas Hopfield Network memenangi anugerah

Aug 13, 2023 pm 08:49 PM

Dua saintis yang telah memenangi Hadiah Boltzmann 2022 telah diumumkan Anugerah ini ditubuhkan oleh Jawatankuasa IUPAP mengenai Fizik Statistik (C3) untuk mengiktiraf para penyelidik yang telah mencapai pencapaian cemerlang dalam bidang fizik statistik. Pemenang mestilah seorang saintis yang belum pernah memenangi Hadiah Boltzmann atau Hadiah Nobel. Anugerah ini bermula pada tahun 1975 dan dianugerahkan setiap tiga tahun untuk memperingati Ludwig Boltzmann, pengasas fizik statistik Deepak Dharistheoriginalstatement. model kritikal, pertumbuhan antara muka, gangguan

Bintang semakin meningkat AI Google bertukar kepada Pika: generasi video Lumiere, berfungsi sebagai saintis pengasas

Feb 26, 2024 am 09:37 AM

Bintang semakin meningkat AI Google bertukar kepada Pika: generasi video Lumiere, berfungsi sebagai saintis pengasas

Feb 26, 2024 am 09:37 AM

Penjanaan video sedang berkembang pesat, dan Pika telah mengalu-alukan seorang jeneral yang hebat - penyelidik Google Omer Bar-Tal, yang berkhidmat sebagai saintis pengasas Pika. Sebulan yang lalu, Google mengeluarkan model penjanaan video Lumiere sebagai pengarang bersama, dan kesannya sangat mengagumkan. Pada masa itu, netizen berkata: Google menyertai pertempuran penjanaan video, dan terdapat satu lagi rancangan yang bagus untuk ditonton. Sesetengah orang dalam industri, termasuk Ketua Pegawai Eksekutif StabilityAI dan bekas rakan sekerja daripada Google, menghantar berkat mereka. Karya pertama Lumiere, Omer Bar-Tal, yang baru menamatkan pengajian dengan ijazah sarjana, lulus dari Jabatan Matematik dan Sains Komputer di Universiti Tel Aviv pada 2021, dan kemudian pergi ke Institut Sains Weizmann untuk belajar untuk ijazah sarjana dalam komputer sains, terutamanya memberi tumpuan kepada penyelidikan dalam bidang sintesis imej dan video. Hasil tesis beliau telah diterbitkan berkali-kali