Peranti teknologi

Peranti teknologi

AI

AI

Tidak perlu melabel data, 'pemahaman 3D' memasuki era pra-latihan pelbagai modal! Siri ULIP adalah sumber terbuka sepenuhnya dan menyegarkan SOTA

Tidak perlu melabel data, 'pemahaman 3D' memasuki era pra-latihan pelbagai modal! Siri ULIP adalah sumber terbuka sepenuhnya dan menyegarkan SOTA

Tidak perlu melabel data, 'pemahaman 3D' memasuki era pra-latihan pelbagai modal! Siri ULIP adalah sumber terbuka sepenuhnya dan menyegarkan SOTA

Kaedah pra-latihan berbilang mod juga telah membawa kepada pembangunan pembelajaran perwakilan 3D dengan menjajarkan bentuk 3D, gambar 2D dan huraian bahasa yang sepadan.

Walau bagaimanapun, rangka kerja pra-latihan pelbagai mod yang sedia ada kurang berskala dalam kaedah pengumpulan data , yang sangat mengehadkan potensi pembelajaran pelbagai mod, antaranya paling Halangan utama terletak pada skalabiliti dan kelengkapan modaliti bahasa.

Baru-baru ini, Salesforce AI bergabung tenaga dengan Universiti Stanford dan Universiti Texas di Austin untuk mengeluarkan projek ULIP (CVP R2023) dan ULIP-2, yang menerajui lembaran baharu dalam 3D persefahaman.

Pautan kertas: https://arxiv.org/pdf/2212.05171.pdf

Pautan kertas: https://arxiv.org/pdf/2305.08275.pdf

Pautan kod: https: //github.com/salesforce/ULIP

Para penyelidik mengambil pendekatan unik dengan melatih pra-latihan model menggunakan awan titik 3D, imej dan teks, menjajarkannya ke A unified ruang ciri. Pendekatan ini mencapai keputusan terkini dalam tugas pengelasan 3D dan membuka kemungkinan baharu untuk tugas merentas domain seperti pengambilan imej-ke-3D.

Dan ULIP-2 menjadikan pra-latihan berbilang modal ini boleh dilakukan tanpa sebarang anotasi manual, dengan itu boleh berskala pada skala besar.

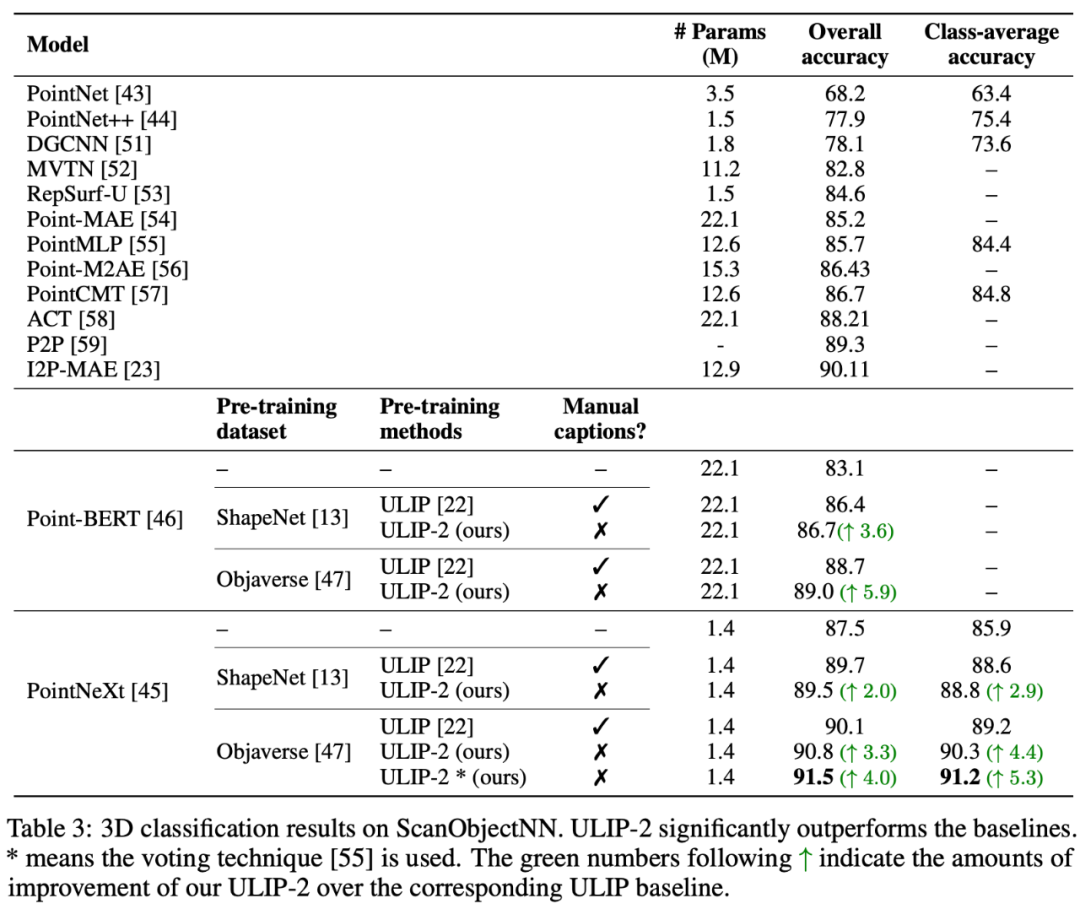

ULIP-2 telah mencapai peningkatan prestasi yang ketara dalam klasifikasi tangkapan sifar hiliran ModelNet40, mencapai ketepatan tertinggi 74.0% pada penanda aras ScanObjectNN dunia sebenar, hanya 1.4 juta sahaja digunakan Ketepatan keseluruhan 91.5% dicapai dengan hanya satu parameter, menandakan kejayaan dalam pembelajaran perwakilan 3D multimodal berskala tanpa memerlukan anotasi 3D manusia.

Gambar rajah skema rangka kerja pra-latihan untuk menjajarkan ketiga-tiga ciri ini (3D, imej , teks)

Kod dan set data tri-modal berskala besar yang dikeluarkan ("ULIP - Objaverse Triplets" dan "ULIP - ShapeNet Triplets") telah menjadi sumber terbuka .

Latar BelakangPemahaman 3D ialah bahagian penting dalam bidang kecerdasan buatan, yang membolehkan mesin melihat dan berinteraksi dalam ruang tiga dimensi seperti manusia. Keupayaan ini mempunyai aplikasi penting dalam bidang seperti kenderaan autonomi, robotik, realiti maya dan realiti tambahan.

Walau bagaimanapun, pemahaman 3D telah menghadapi cabaran besar disebabkan oleh kerumitan pemprosesan dan tafsiran data 3D, serta kos mengumpul dan menganotasi data 3D.

ULIP

Rangka kerja pra-latihan trimodal dan tugas hilirannya

ULIP (sudah diterima oleh CVPR2023) menggunakan pendekatan unik untuk pralatih model menggunakan awan titik 3D, imej dan teks, menjajarkannya ke dalam ruang perwakilan bersatu .

Pendekatan ini mencapai hasil terkini dalam tugas pengelasan 3D dan membuka kemungkinan baharu untuk tugas merentas domain seperti pengambilan semula imej-ke-3D.

Kunci kejayaan ULIP ialah penggunaan pengekod imej dan teks yang diprajajarkan, seperti CLIP, yang dilatih terlebih dahulu pada sebilangan besar pasangan teks imej.

Pengekod ini menjajarkan ciri tiga modaliti ke dalam ruang perwakilan bersatu, membolehkan model memahami dan mengelaskan objek 3D dengan lebih berkesan.

Pembelajaran perwakilan 3D yang dipertingkatkan ini bukan sahaja meningkatkan pemahaman model tentang data 3D, tetapi juga mendayakan aplikasi rentas mod seperti pengelasan 3D tangkapan sifar dan perolehan semula imej-ke-3D kerana pengekod 3D memperoleh konteks Multimodal.

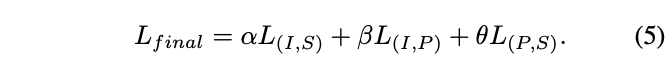

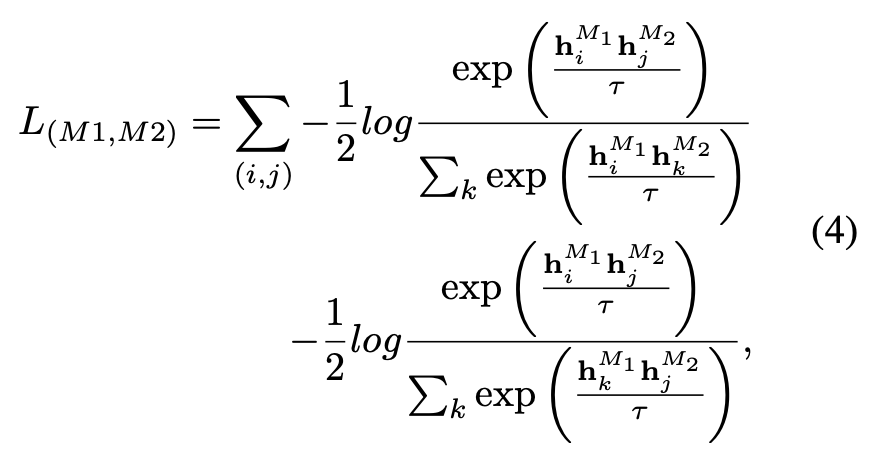

Fungsi kehilangan pra-latihan ULIP adalah seperti berikut:

Dalam tetapan lalai ULIP, α ditetapkan kepada 0, β dan θ ditetapkan kepada 1, dan fungsi kehilangan pembelajaran kontrastif antara setiap dua mod ditakrifkan seperti berikut, di mana M1 dan M2 merujuk kepada mana-mana dua mod antara tiga mod:

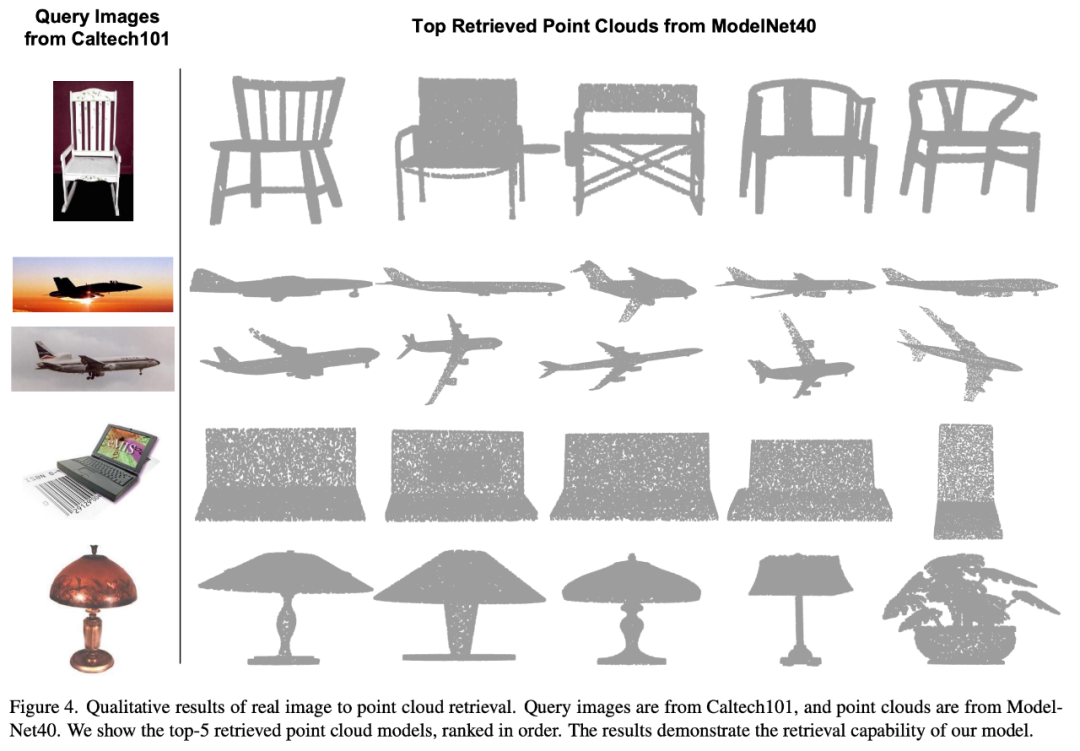

ULIP juga menjalankan eksperimen untuk mendapatkan semula daripada imej kepada 3D, dan hasilnya adalah seperti berikut:

Hasil percubaan menunjukkan bahawa model pra-latihan ULIP telah dapat mempelajari ciri berbilang modal yang bermakna antara imej dan awan titik 3D.

Anehnya, berbanding model 3D yang diperoleh semula yang lain, model 3D yang diperoleh semula pertama mempunyai rupa yang paling hampir dengan imej pertanyaan.

Contohnya, apabila kita menggunakan imej daripada jenis pesawat yang berbeza (pejuang dan pesawat) untuk mendapatkan semula (baris kedua dan ketiga), awan titik 3D terdekat yang diambil kekal Perbezaan halus dalam imej pertanyaan adalah terpelihara.

ULIP-2

Berikut ialah objek 3D yang menjana teks berbilang sudut huraian Contoh. Kami mula-mula menjadikan objek 3D kepada imej 2D daripada satu set paparan, dan kemudian menggunakan model berbilang modal yang besar untuk menjana penerangan bagi semua imej yang dijana

ULIP-2 dalam ULIP Pada asasnya, gunakan model berbilang modal berskala besar untuk menjana penerangan bahasa sepadan yang menyeluruh untuk objek 3D, dengan itu mengumpul data pra-latihan berbilang mod berskala tanpa sebarang anotasi manual, menjadikan proses pra-latihan dan model terlatih lebih cekap dan dipertingkatkan kebolehsuaiannya.

Kaedah ULIP-2 termasuk menjana huraian bahasa berbilang sudut dan berbeza untuk setiap objek 3D, dan kemudian menggunakan penerangan ini untuk melatih model, supaya objek 3D, imej 2D, dan huraian bahasa boleh Penjajaran ruang ciri adalah konsisten.

Rangka kerja ini membolehkan penciptaan set data tri-modal yang besar tanpa anotasi manual, dengan itu menggunakan sepenuhnya potensi pra-latihan berbilang modal.

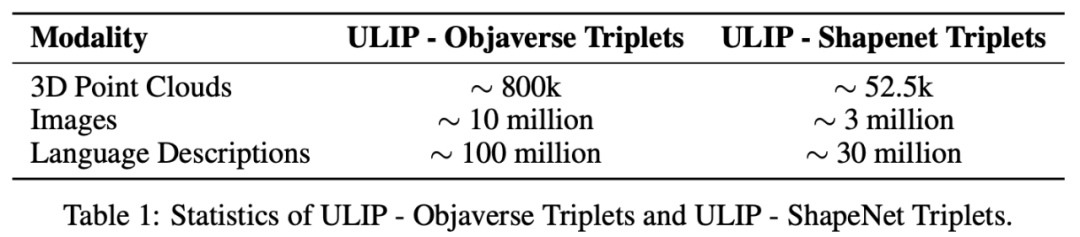

ULIP-2 juga mengeluarkan set data tiga mod berskala besar yang dijana: "ULIP - Objaverse Triplets" dan "ULIP - ShapeNet Triplets".

Sesetengah data statistik bagi dua set data tri-modal

Hasil eksperimen

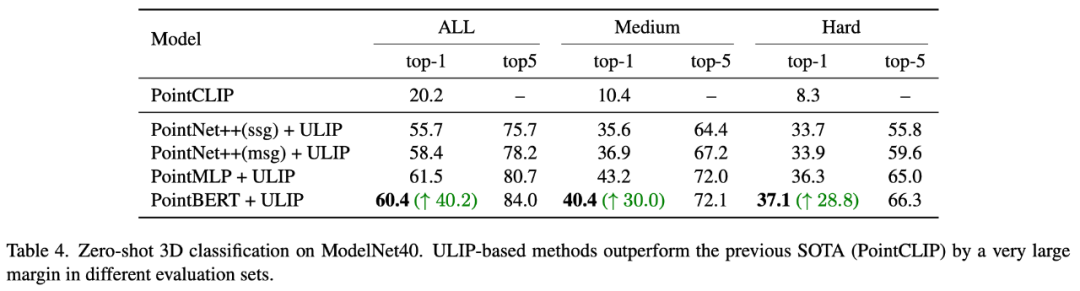

Siri ULIP telah mencapai hasil yang menakjubkan dalam tugasan hiliran berbilang mod dan eksperimen penalaan halus pada ekspresi 3D, khususnya, pra-latihan dalam ULIP-2 boleh dicapai tanpa sebarang anotasi manual.

ULIP-2 mencapai peningkatan yang ketara (74.0% ketepatan 1 teratas) dalam tugas pengelasan sifar pukulan hiliran ModelNet40 dalam penanda aras ScanObjectNN dunia sebenar, ia mencapai ketepatan keseluruhan sebanyak 91.5% dicapai dengan hanya 1.4M parameter, menandakan kejayaan dalam pembelajaran perwakilan 3D berbilang mod berskala tanpa memerlukan anotasi 3D manual.

Eksperimen Ablasi

Kedua-dua kertas kerja menjalankan eksperimen ablasi terperinci.

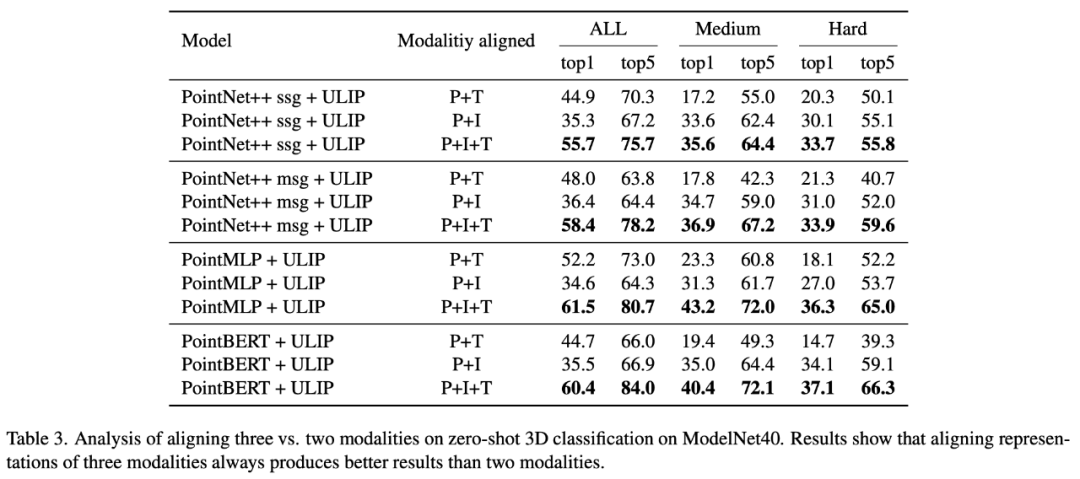

Dalam "ULIP: Mempelajari Perwakilan Bersatu Bahasa, Imej dan Awan Titik untuk Pemahaman 3D", memandangkan rangka kerja pra-latihan ULIP melibatkan penyertaan tiga modaliti, pengarang menggunakan eksperimen untuk meneroka sama ada ia adakah lebih baik untuk menjajarkan dua daripada mod atau menjajarkan ketiga-tiga mod Hasil percubaan adalah seperti berikut:

Seperti yang dapat dilihat daripada keputusan eksperimen, Dalam tulang belakang 3D yang berbeza, menjajarkan tiga modaliti adalah lebih baik daripada menjajarkan hanya dua modaliti, yang juga membuktikan rasionaliti rangka kerja pra-latihan ULIP.

Dalam "ULIP-2: Ke Arah Pra-latihan Multimodal Boleh Skala untuk Pemahaman 3D", penulis meneroka kesan model multimodal berskala besar yang berbeza pada rangka kerja pra-latihan adalah seperti berikut:

Hasil eksperimen dapat dilihat bahawa kesan pra-latihan rangka kerja ULIP-2 boleh dinaik taraf dengan penggunaan besar -model berbilang modal berskala Dan promosi mempunyai tahap pertumbuhan tertentu.

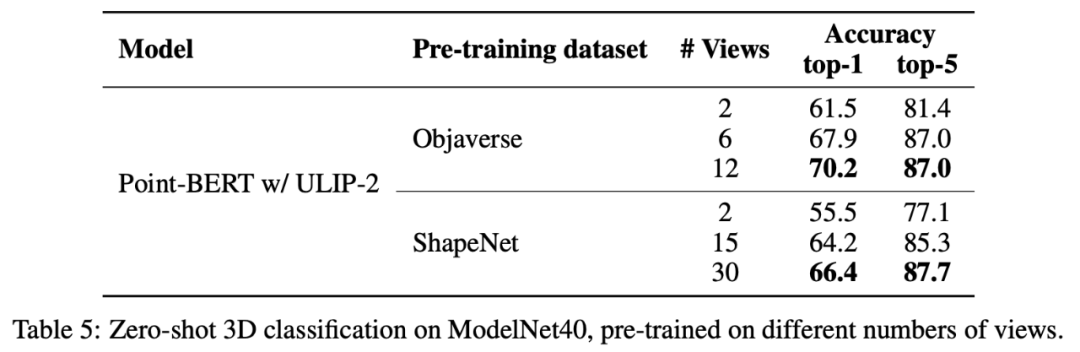

Dalam ULIP-2, penulis juga meneroka cara menggunakan bilangan paparan yang berbeza untuk menjana set data tri-modal akan mempengaruhi prestasi pra-latihan keseluruhan Hasil percubaan adalah seperti berikut :

Keputusan eksperimen menunjukkan bahawa apabila bilangan tontonan yang digunakan meningkat, kesan klasifikasi sifar tangkapan model pra-latihan juga akan bertambah.

Ini juga menyokong perkara dalam ULIP-2 bahawa huraian bahasa yang lebih komprehensif dan pelbagai akan memberi kesan positif pada pra-latihan pelbagai mod.

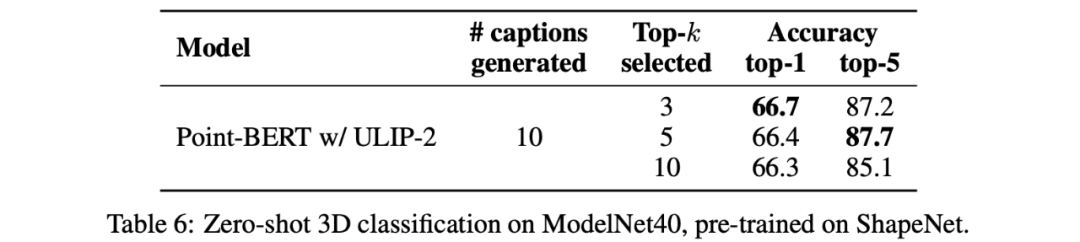

Di samping itu, ULIP-2 turut meneroka kesan penerangan bahasa bagi pelbagai jenis topk yang disusun mengikut CLIP pada pra-latihan berbilang modal Keputusan eksperimen adalah seperti berikut:

Hasil percubaan menunjukkan bahawa rangka kerja ULIP-2 mempunyai tahap keteguhan tertentu kepada topk yang berbeza digunakan sebagai tetapan lalai dalam kertas.

Kesimpulan

Projek ULIP (CVPR2023) dan ULIP-2 yang dikeluarkan bersama oleh Salesforce AI, Stanford University dan University of Texas di Austin sedang mengubah bidang Pemahaman 3D.

ULIP menjajarkan modaliti yang berbeza ke dalam ruang bersatu, mempertingkatkan pembelajaran ciri 3D dan mendayakan aplikasi rentas mod.

ULIP-2 telah dibangunkan lagi untuk menjana penerangan bahasa keseluruhan untuk objek 3D, mencipta dan membuka sumber sejumlah besar set data tiga mod, dan proses ini tidak memerlukan anotasi manual .

Projek ini menetapkan penanda aras baharu dalam pemahaman 3D, membuka jalan untuk masa depan di mana mesin benar-benar memahami dunia tiga dimensi kita.

Pasukan

Salesforce AI:

Le Xue (蛛乐), Mingfei Gao (高明飞), Chen Xing (Xingchen), Ning Yu (Yu Ning), Shu Zhang (张捍), Junnan Li (李君男), Caiming Xiong (Xiong Caiming), Ran Xu (Xu Ran), Juan Carlos niebles, Silvio Savarese.

Stanford University:

Prof. Silvio Savarese, Prof. Juan Carlos Niebles, Prof. Jiajun Wu(Wu Jiajun).

UT Austin:

Prof.

Atas ialah kandungan terperinci Tidak perlu melabel data, 'pemahaman 3D' memasuki era pra-latihan pelbagai modal! Siri ULIP adalah sumber terbuka sepenuhnya dan menyegarkan SOTA. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1376

1376

52

52

Mengapakah Gaussian Splatting begitu popular dalam pemanduan autonomi sehingga NeRF mula ditinggalkan?

Jan 17, 2024 pm 02:57 PM

Mengapakah Gaussian Splatting begitu popular dalam pemanduan autonomi sehingga NeRF mula ditinggalkan?

Jan 17, 2024 pm 02:57 PM

Ditulis di atas & pemahaman peribadi pengarang Gaussiansplatting tiga dimensi (3DGS) ialah teknologi transformatif yang telah muncul dalam bidang medan sinaran eksplisit dan grafik komputer dalam beberapa tahun kebelakangan ini. Kaedah inovatif ini dicirikan oleh penggunaan berjuta-juta Gaussians 3D, yang sangat berbeza daripada kaedah medan sinaran saraf (NeRF), yang terutamanya menggunakan model berasaskan koordinat tersirat untuk memetakan koordinat spatial kepada nilai piksel. Dengan perwakilan adegan yang eksplisit dan algoritma pemaparan yang boleh dibezakan, 3DGS bukan sahaja menjamin keupayaan pemaparan masa nyata, tetapi juga memperkenalkan tahap kawalan dan pengeditan adegan yang tidak pernah berlaku sebelum ini. Ini meletakkan 3DGS sebagai penukar permainan yang berpotensi untuk pembinaan semula dan perwakilan 3D generasi akan datang. Untuk tujuan ini, kami menyediakan gambaran keseluruhan sistematik tentang perkembangan dan kebimbangan terkini dalam bidang 3DGS buat kali pertama.

Ketahui tentang emoji Fasih 3D dalam Microsoft Teams

Apr 24, 2023 pm 10:28 PM

Ketahui tentang emoji Fasih 3D dalam Microsoft Teams

Apr 24, 2023 pm 10:28 PM

Anda mesti ingat, terutamanya jika anda adalah pengguna Teams, bahawa Microsoft telah menambah kumpulan baharu emoji 3DFluent pada apl persidangan video tertumpu kerjanya. Selepas Microsoft mengumumkan emoji 3D untuk Pasukan dan Windows tahun lepas, proses itu sebenarnya telah melihat lebih daripada 1,800 emoji sedia ada dikemas kini untuk platform. Idea besar ini dan pelancaran kemas kini emoji 3DFluent untuk Pasukan pertama kali dipromosikan melalui catatan blog rasmi. Kemas kini Pasukan Terkini membawa FluentEmojis ke aplikasi Microsoft mengatakan 1,800 emoji yang dikemas kini akan tersedia kepada kami setiap hari

Pilih kamera atau lidar? Kajian terbaru tentang mencapai pengesanan objek 3D yang mantap

Jan 26, 2024 am 11:18 AM

Pilih kamera atau lidar? Kajian terbaru tentang mencapai pengesanan objek 3D yang mantap

Jan 26, 2024 am 11:18 AM

0. Ditulis di hadapan&& Pemahaman peribadi bahawa sistem pemanduan autonomi bergantung pada persepsi lanjutan, membuat keputusan dan teknologi kawalan, dengan menggunakan pelbagai penderia (seperti kamera, lidar, radar, dll.) untuk melihat persekitaran sekeliling dan menggunakan algoritma dan model untuk analisis masa nyata dan membuat keputusan. Ini membolehkan kenderaan mengenali papan tanda jalan, mengesan dan menjejaki kenderaan lain, meramalkan tingkah laku pejalan kaki, dsb., dengan itu selamat beroperasi dan menyesuaikan diri dengan persekitaran trafik yang kompleks. Teknologi ini kini menarik perhatian meluas dan dianggap sebagai kawasan pembangunan penting dalam pengangkutan masa depan satu. Tetapi apa yang menyukarkan pemanduan autonomi ialah memikirkan cara membuat kereta itu memahami perkara yang berlaku di sekelilingnya. Ini memerlukan algoritma pengesanan objek tiga dimensi dalam sistem pemanduan autonomi boleh melihat dan menerangkan dengan tepat objek dalam persekitaran sekeliling, termasuk lokasinya,

CLIP-BEVFormer: Selia secara eksplisit struktur BEVFormer untuk meningkatkan prestasi pengesanan ekor panjang

Mar 26, 2024 pm 12:41 PM

CLIP-BEVFormer: Selia secara eksplisit struktur BEVFormer untuk meningkatkan prestasi pengesanan ekor panjang

Mar 26, 2024 pm 12:41 PM

Ditulis di atas & pemahaman peribadi penulis: Pada masa ini, dalam keseluruhan sistem pemanduan autonomi, modul persepsi memainkan peranan penting Hanya selepas kenderaan pemanduan autonomi yang memandu di jalan raya memperoleh keputusan persepsi yang tepat melalui modul persepsi boleh Peraturan hiliran dan. modul kawalan dalam sistem pemanduan autonomi membuat pertimbangan dan keputusan tingkah laku yang tepat pada masanya dan betul. Pada masa ini, kereta dengan fungsi pemanduan autonomi biasanya dilengkapi dengan pelbagai penderia maklumat data termasuk penderia kamera pandangan sekeliling, penderia lidar dan penderia radar gelombang milimeter untuk mengumpul maklumat dalam modaliti yang berbeza untuk mencapai tugas persepsi yang tepat. Algoritma persepsi BEV berdasarkan penglihatan tulen digemari oleh industri kerana kos perkakasannya yang rendah dan penggunaan mudah, dan hasil keluarannya boleh digunakan dengan mudah untuk pelbagai tugas hiliran.

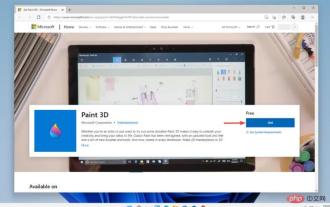

Cat 3D dalam Windows 11: Muat Turun, Pemasangan dan Panduan Penggunaan

Apr 26, 2023 am 11:28 AM

Cat 3D dalam Windows 11: Muat Turun, Pemasangan dan Panduan Penggunaan

Apr 26, 2023 am 11:28 AM

Apabila gosip mula tersebar bahawa Windows 11 baharu sedang dibangunkan, setiap pengguna Microsoft ingin tahu bagaimana rupa sistem pengendalian baharu itu dan apa yang akan dibawanya. Selepas spekulasi, Windows 11 ada di sini. Sistem pengendalian datang dengan reka bentuk baharu dan perubahan fungsi. Selain beberapa tambahan, ia disertakan dengan penamatan dan pengalihan keluar ciri. Salah satu ciri yang tidak wujud dalam Windows 11 ialah Paint3D. Walaupun ia masih menawarkan Paint klasik, yang bagus untuk laci, doodle dan doodle, ia meninggalkan Paint3D, yang menawarkan ciri tambahan yang sesuai untuk pencipta 3D. Jika anda mencari beberapa ciri tambahan, kami mengesyorkan Autodesk Maya sebagai perisian reka bentuk 3D terbaik. suka

Dapatkan isteri 3D maya dalam masa 30 saat dengan satu kad! Teks kepada 3D menjana manusia digital berketepatan tinggi dengan butiran liang yang jelas, menyambung dengan lancar dengan Maya, Unity dan alat pengeluaran lain

May 23, 2023 pm 02:34 PM

Dapatkan isteri 3D maya dalam masa 30 saat dengan satu kad! Teks kepada 3D menjana manusia digital berketepatan tinggi dengan butiran liang yang jelas, menyambung dengan lancar dengan Maya, Unity dan alat pengeluaran lain

May 23, 2023 pm 02:34 PM

ChatGPT telah menyuntik satu dos darah ayam ke dalam industri AI, dan segala-galanya yang dahulunya tidak dapat dibayangkan telah menjadi amalan asas hari ini. Text-to-3D, yang terus maju, dianggap sebagai tempat liputan seterusnya dalam medan AIGC selepas Difusi (imej) dan GPT (teks), dan telah mendapat perhatian yang tidak pernah berlaku sebelum ini. Tidak, produk yang dipanggil ChatAvatar telah dimasukkan ke dalam beta awam sederhana, dengan cepat memperoleh lebih 700,000 tontonan dan perhatian, dan telah dipaparkan di Spacesoftheweek. △ChatAvatar juga akan menyokong teknologi Imageto3D yang menjana aksara bergaya 3D daripada lukisan asal perspektif tunggal/berbilang perspektif Model 3D yang dihasilkan oleh versi beta semasa telah mendapat perhatian meluas.

'Mesin yang paling penting tidak pernah dibina', Alan Turing dan Mesin Turing

Jun 25, 2023 pm 07:42 PM

'Mesin yang paling penting tidak pernah dibina', Alan Turing dan Mesin Turing

Jun 25, 2023 pm 07:42 PM

Pengkomputeran ialah konsep biasa yang kebanyakan kita fahami secara intuitif. Mari kita ambil fungsi f(x)=x+3 sebagai contoh Apabila x ialah 3, f(3)=3+3. Jawapannya ialah 6, sangat mudah. Jelas sekali, fungsi ini boleh dikira. Tetapi sesetengah fungsi tidak semudah itu, dan menentukan sama ada ia boleh dikira bukanlah perkara remeh, bermakna ia mungkin tidak pernah membawa kepada jawapan muktamad. Pada tahun 1928, ahli matematik Jerman David Hilbert dan Wilhelm Ackermann mencadangkan masalah yang dipanggil Entscheidungsproblem (iaitu "masalah keputusan"). Lama kelamaan, soalan yang mereka ajukan akan membawa kepada kemungkinan

Yang terbaru dari Universiti Oxford! Mickey: Padanan imej 2D dalam SOTA 3D! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Yang terbaru dari Universiti Oxford! Mickey: Padanan imej 2D dalam SOTA 3D! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Pautan projek ditulis di hadapan: https://nianticlabs.github.io/mickey/ Memandangkan dua gambar, pose kamera di antara mereka boleh dianggarkan dengan mewujudkan kesesuaian antara gambar. Biasanya, surat-menyurat ini adalah 2D hingga 2D, dan anggaran pose kami adalah skala-tak tentu. Sesetengah aplikasi, seperti realiti tambahan segera pada bila-bila masa, di mana-mana sahaja, memerlukan anggaran pose metrik skala, jadi mereka bergantung pada penganggar kedalaman luaran untuk memulihkan skala. Makalah ini mencadangkan MicKey, proses pemadanan titik utama yang mampu meramalkan korespondensi metrik dalam ruang kamera 3D. Dengan mempelajari padanan koordinat 3D merentas imej, kami dapat membuat kesimpulan relatif metrik