pembangunan bahagian belakang

pembangunan bahagian belakang

Tutorial Python

Tutorial Python

Amalan scrapy: merangkak dan menganalisis data daripada forum permainan

Amalan scrapy: merangkak dan menganalisis data daripada forum permainan

Amalan scrapy: merangkak dan menganalisis data daripada forum permainan

Dalam beberapa tahun kebelakangan ini, penggunaan Python untuk perlombongan dan analisis data telah menjadi semakin biasa. Scrapy ialah alat yang popular dalam hal mengikis data tapak web. Dalam artikel ini, kami akan memperkenalkan cara menggunakan Scrapy untuk merangkak data daripada forum permainan untuk analisis data seterusnya.

1 Pilih sasaran

Pertama, kita perlu memilih tapak web sasaran. Di sini, kami memilih forum permainan.

Seperti yang ditunjukkan dalam gambar di bawah, forum ini mengandungi pelbagai sumber, seperti panduan permainan, muat turun permainan, komunikasi pemain, dsb.

Matlamat kami adalah untuk mendapatkan tajuk siaran, pengarang, masa penerbitan, bilangan balasan dan maklumat lain untuk analisis data seterusnya.

2. Buat projek Scrapy

Sebelum mula merangkak data, kita perlu mencipta projek Scrapy. Pada baris arahan, masukkan arahan berikut:

scrapy startproject forum_spider

Ini akan mencipta projek baharu yang dipanggil "forum_spider".

3. Konfigurasikan tetapan Scrapy

Dalam fail settings.py, kami perlu mengkonfigurasi beberapa tetapan untuk memastikan Scrapy berjaya merangkak data yang diperlukan daripada tapak web forum. Berikut ialah beberapa tetapan yang biasa digunakan:

BOT_NAME = 'forum_spider' SPIDER_MODULES = ['forum_spider.spiders'] NEWSPIDER_MODULE = 'forum_spider.spiders' ROBOTSTXT_OBEY = False # 忽略robots.txt文件 DOWNLOAD_DELAY = 1 # 下载延迟 COOKIES_ENABLED = False # 关闭cookies

4. Menulis Spider

Dalam Scrapy, Spider ialah kelas yang digunakan untuk melaksanakan kerja sebenar (iaitu merangkak tapak web). Kita perlu menentukan labah-labah untuk mendapatkan data yang diperlukan daripada forum.

Kami boleh menggunakan Scrapy’s Shell untuk menguji dan nyahpepijat Labah-labah kami. Pada baris arahan, masukkan arahan berikut:

scrapy shell "https://forum.example.com"

Ini akan membuka shell Python interaktif dengan forum sasaran.

Dalam shell, kita boleh menggunakan arahan berikut untuk menguji Pemilih yang diperlukan:

response.xpath("xpath_expression").extract()Di sini, "xpath_expression" sepatutnya merupakan ungkapan XPath yang digunakan untuk memilih data yang diperlukan.

Sebagai contoh, kod berikut digunakan untuk mendapatkan semua urutan dalam forum:

response.xpath("//td[contains(@id, 'td_threadtitle_')]").extract()Selepas kami menentukan ungkapan XPath, kami boleh mencipta Spider.

Dalam folder labah-labah, kami mencipta fail baharu yang dipanggil "forum_spider.py". Berikut ialah kod untuk Spider:

import scrapy

class ForumSpider(scrapy.Spider):

name = "forum"

start_urls = [

"https://forum.example.com"

]

def parse(self, response):

for thread in response.xpath("//td[contains(@id, 'td_threadtitle_')]"):

yield {

'title': thread.xpath("a[@class='s xst']/text()").extract_first(),

'author': thread.xpath("a[@class='xw1']/text()").extract_first(),

'date': thread.xpath("em/span/@title").extract_first(),

'replies': thread.xpath("a[@class='xi2']/text()").extract_first()

}Dalam kod di atas, kami mula-mula mentakrifkan nama Spider sebagai "forum" dan menetapkan URL permulaan. Kemudian, kami menentukan kaedah parse() untuk mengendalikan respons halaman forum.

Dalam kaedah parse(), kami menggunakan ungkapan XPath untuk memilih data yang kami perlukan. Seterusnya, kami menggunakan pernyataan hasil untuk menjana data ke dalam kamus Python dan mengembalikannya. Ini bermakna Spider kami akan merangkak semua benang dalam halaman utama forum satu demi satu dan mengekstrak data yang diperlukan.

5. Run Spider

Sebelum melaksanakan Spider, kita perlu memastikan bahawa Scrapy telah dikonfigurasikan dengan betul. Kami boleh menguji sama ada labah-labah berfungsi dengan betul menggunakan arahan berikut:

scrapy crawl forum

Ini akan memulakan labah-labah kami dan mengeluarkan data yang ditangkap dalam konsol.

6. Analisis Data

Selepas kami berjaya merangkak data, kami boleh menggunakan beberapa perpustakaan Python (seperti Pandas dan Matplotlib) untuk menganalisis dan menggambarkan data.

Kami boleh menyimpan data yang dirangkak dahulu sebagai fail CSV untuk analisis dan pemprosesan data yang lebih mudah.

import pandas as pd

df = pd.read_csv("forum_data.csv")

print(df.head())Ini akan memaparkan lima baris pertama data dalam fail CSV.

Kami boleh menggunakan perpustakaan seperti Pandas dan Matplotlib untuk melaksanakan analisis statistik dan visualisasi data.

Berikut ialah contoh mudah di mana kami mengisih data dengan masa menyiarkan dan memplot jumlah bilangan siaran.

import matplotlib.pyplot as plt

import pandas as pd

df = pd.read_csv("forum_data.csv")

df['date'] = pd.to_datetime(df['date']) #将时间字符串转化为时间对象

df['month'] = df['date'].dt.month

grouped = df.groupby('month')

counts = grouped.size()

counts.plot(kind='bar')

plt.title('Number of Threads by Month')

plt.xlabel('Month')

plt.ylabel('Count')

plt.show()Dalam kod di atas, kami menukar masa keluaran menjadi objek Python Datetime dan mengumpulkan data mengikut bulan. Kami kemudian menggunakan Matplotlib untuk mencipta histogram untuk menunjukkan bilangan siaran setiap bulan.

7. Ringkasan

Artikel ini memperkenalkan cara menggunakan Scrapy untuk merangkak data daripada forum permainan dan menunjukkan cara menggunakan pustaka Pandas dan Matplotlib Python untuk analisis dan visualisasi data. Alat ini adalah perpustakaan Python yang sangat popular dalam bidang analisis data dan boleh digunakan untuk meneroka dan menggambarkan data tapak web.

Atas ialah kandungan terperinci Amalan scrapy: merangkak dan menganalisis data daripada forum permainan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1386

1386

52

52

Baca fail CSV dan lakukan analisis data menggunakan panda

Jan 09, 2024 am 09:26 AM

Baca fail CSV dan lakukan analisis data menggunakan panda

Jan 09, 2024 am 09:26 AM

Pandas ialah alat analisis data yang berkuasa yang boleh membaca dan memproses pelbagai jenis fail data dengan mudah. Antaranya, fail CSV ialah salah satu daripada format fail data yang paling biasa dan biasa digunakan. Artikel ini akan memperkenalkan cara menggunakan Panda untuk membaca fail CSV dan melakukan analisis data serta memberikan contoh kod khusus. 1. Import perpustakaan yang diperlukan Mula-mula, kita perlu mengimport perpustakaan Pandas dan perpustakaan lain yang berkaitan yang mungkin diperlukan, seperti yang ditunjukkan di bawah: importpandasaspd 2. Baca fail CSV menggunakan Pan

Pengenalan kepada kaedah analisis data

Jan 08, 2024 am 10:22 AM

Pengenalan kepada kaedah analisis data

Jan 08, 2024 am 10:22 AM

Kaedah analisis data biasa: 1. Kaedah analisis perbandingan 3. Kaedah analisis silang 5. Kaedah analisis sebab dan akibat , Kaedah analisis komponen utama 9. Kaedah analisis serakan 10. Kaedah analisis matriks. Pengenalan terperinci: 1. Kaedah analisis perbandingan: Analisis perbandingan dua atau lebih data untuk mencari perbezaan dan corak 2. Kaedah analisis struktur: Kaedah analisis perbandingan antara setiap bahagian keseluruhan dan keseluruhan; , dsb.

11 pengedaran asas yang saintis data menggunakan 95% masa

Dec 15, 2023 am 08:21 AM

11 pengedaran asas yang saintis data menggunakan 95% masa

Dec 15, 2023 am 08:21 AM

Berikutan inventori terakhir "11 Saintis Data Carta Asas Menggunakan 95% Masa", hari ini kami akan membawakan kepada anda 11 pengedaran asas yang digunakan oleh saintis data 95% daripada masa. Menguasai pengedaran ini membantu kami memahami sifat data dengan lebih mendalam dan membuat inferens dan ramalan yang lebih tepat semasa analisis data dan membuat keputusan. 1. Taburan Normal Taburan Normal, juga dikenali sebagai Taburan Gaussian, ialah taburan kebarangkalian berterusan. Ia mempunyai lengkung berbentuk loceng simetri dengan min (μ) sebagai pusat dan sisihan piawai (σ) sebagai lebar. Taburan normal mempunyai nilai aplikasi penting dalam banyak bidang seperti statistik, teori kebarangkalian, dan kejuruteraan.

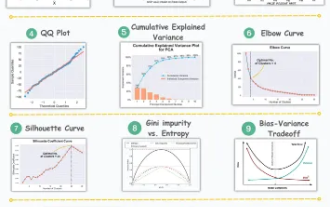

11 Visualisasi Lanjutan untuk Analisis Data dan Pembelajaran Mesin

Oct 25, 2023 am 08:13 AM

11 Visualisasi Lanjutan untuk Analisis Data dan Pembelajaran Mesin

Oct 25, 2023 am 08:13 AM

Visualisasi ialah alat yang berkuasa untuk menyampaikan corak dan hubungan data yang kompleks dengan cara yang intuitif dan mudah difahami. Mereka memainkan peranan penting dalam analisis data, memberikan cerapan yang selalunya sukar untuk dibezakan daripada data mentah atau perwakilan berangka tradisional. Visualisasi adalah penting untuk memahami corak dan perhubungan data yang kompleks, dan kami akan memperkenalkan 11 carta paling penting dan mesti diketahui yang membantu mendedahkan maklumat dalam data dan menjadikan data kompleks lebih mudah difahami dan bermakna. 1. KSPlotKSPlot digunakan untuk menilai perbezaan taburan. Idea teras adalah untuk mengukur jarak maksimum antara fungsi pengedaran kumulatif (CDF) dua pengedaran. Semakin kecil jarak maksimum, semakin besar kemungkinan mereka tergolong dalam pengedaran yang sama. Oleh itu, ia terutamanya ditafsirkan sebagai "sistem" untuk menentukan perbezaan pengedaran.

Pembelajaran mesin dan analisis data menggunakan bahasa Go

Nov 30, 2023 am 08:44 AM

Pembelajaran mesin dan analisis data menggunakan bahasa Go

Nov 30, 2023 am 08:44 AM

Dalam masyarakat pintar hari ini, pembelajaran mesin dan analisis data merupakan alat yang sangat diperlukan yang boleh membantu orang ramai memahami dan menggunakan sejumlah besar data dengan lebih baik. Dalam bidang ini, bahasa Go juga telah menjadi bahasa pengaturcaraan yang telah menarik perhatian ramai. Artikel ini memperkenalkan cara menggunakan bahasa Go untuk pembelajaran mesin dan analisis data. 1. Ekosistem pembelajaran mesin bahasa Go tidak sekaya Python dan R. Walau bagaimanapun, apabila semakin ramai orang mula menggunakannya, beberapa perpustakaan dan rangka kerja pembelajaran mesin

Cara menggunakan antara muka ECharts dan php untuk melaksanakan analisis data dan ramalan carta statistik

Dec 17, 2023 am 10:26 AM

Cara menggunakan antara muka ECharts dan php untuk melaksanakan analisis data dan ramalan carta statistik

Dec 17, 2023 am 10:26 AM

Cara menggunakan antara muka ECharts dan PHP untuk melaksanakan analisis data dan ramalan carta statistik Analisis dan ramalan data memainkan peranan penting dalam pelbagai bidang. Ia boleh membantu kami memahami arah aliran dan corak data dan menyediakan rujukan untuk keputusan masa hadapan. ECharts ialah perpustakaan visualisasi data sumber terbuka yang menyediakan komponen carta yang kaya dan fleksibel yang boleh memuatkan dan memproses data secara dinamik dengan menggunakan antara muka PHP. Artikel ini akan memperkenalkan kaedah pelaksanaan analisis data carta statistik dan ramalan berdasarkan ECharts dan antara muka php, dan menyediakan

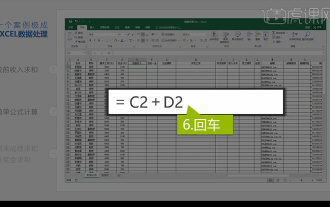

Analisis data Excel bersepadu

Mar 21, 2024 am 08:21 AM

Analisis data Excel bersepadu

Mar 21, 2024 am 08:21 AM

1. Dalam pelajaran ini, kami akan menerangkan analisis data Excel bersepadu Kami akan melengkapkannya melalui kes Buka bahan kursus dan klik pada sel E2 untuk memasukkan formula. 2. Kami kemudian memilih sel E53 untuk mengira semua data berikut. 3. Kemudian kita klik pada sel F2, dan kemudian kita masukkan formula untuk mengiranya Begitu juga, menyeret ke bawah boleh mengira nilai yang kita mahu. 4. Kami memilih sel G2, klik tab Data, klik Pengesahan Data, pilih dan sahkan. 5. Mari kita gunakan kaedah yang sama untuk mengisi secara automatik sel di bawah yang perlu dikira. 6. Seterusnya, kami mengira gaji sebenar dan pilih sel H2 untuk memasukkan formula. 7. Kemudian kita klik pada menu drop-down nilai untuk klik pada nombor lain.

Apakah tapak web analisis data yang disyorkan?

Mar 13, 2024 pm 05:44 PM

Apakah tapak web analisis data yang disyorkan?

Mar 13, 2024 pm 05:44 PM

Disyorkan: 1. Forum Analisis Data Perniagaan 2. Forum Ekonomi Kongres Rakyat - Bidang Ekonometrik dan Statistik 4. Forum Pembelajaran dan Pertukaran Data; Analisis data 8. Institut Penyelidikan Perlombongan Data;