Peranti teknologi

Peranti teknologi

AI

AI

Senarai LLM Terbuka telah dimuat semula dan 'Platypus' yang lebih kuat daripada Llama 2 ada di sini.

Senarai LLM Terbuka telah dimuat semula dan 'Platypus' yang lebih kuat daripada Llama 2 ada di sini.

Senarai LLM Terbuka telah dimuat semula dan 'Platypus' yang lebih kuat daripada Llama 2 ada di sini.

Untuk mencabar penguasaan model tertutup seperti GPT-3.5 dan GPT-4 OpenAI, satu siri model sumber terbuka muncul, termasuk LLaMa, Falcon, dsb. Baru-baru ini, Meta AI melancarkan LLaMa-2, yang dikenali sebagai model paling berkuasa dalam bidang sumber terbuka, dan ramai penyelidik juga telah membina model mereka sendiri atas dasar ini. Sebagai contoh, StabilityAI menggunakan set data gaya Orca untuk memperhalusi model Llama2 70B dan membangunkan StableBeluga2, yang turut mencapai keputusan yang baik pada kedudukan LLM Terbuka Huggingface

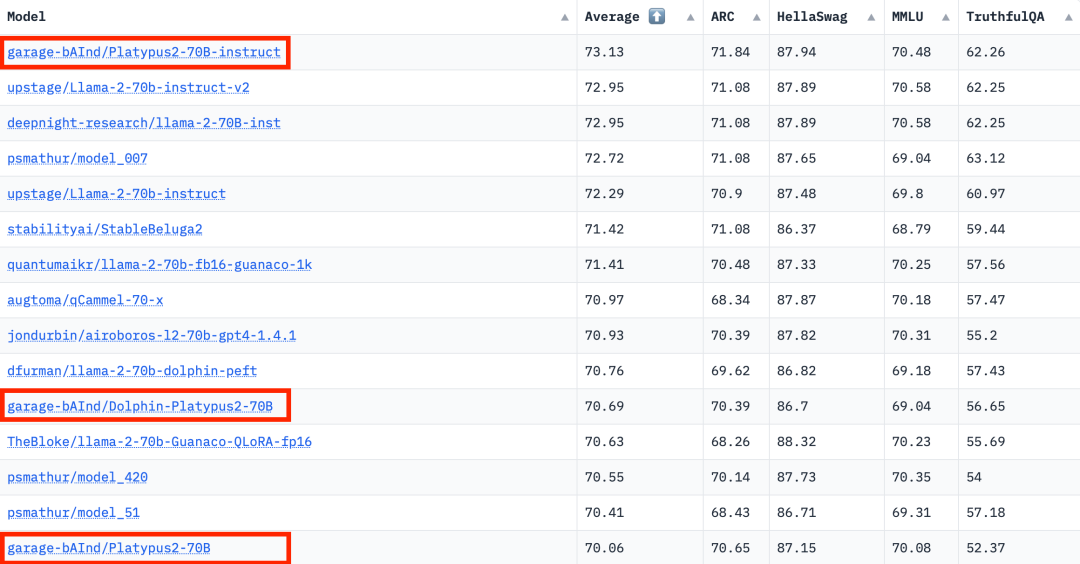

Penarafan LLM Terbuka terkini telah berubah, model Platypus (Platypus) berjaya mendahului senarai

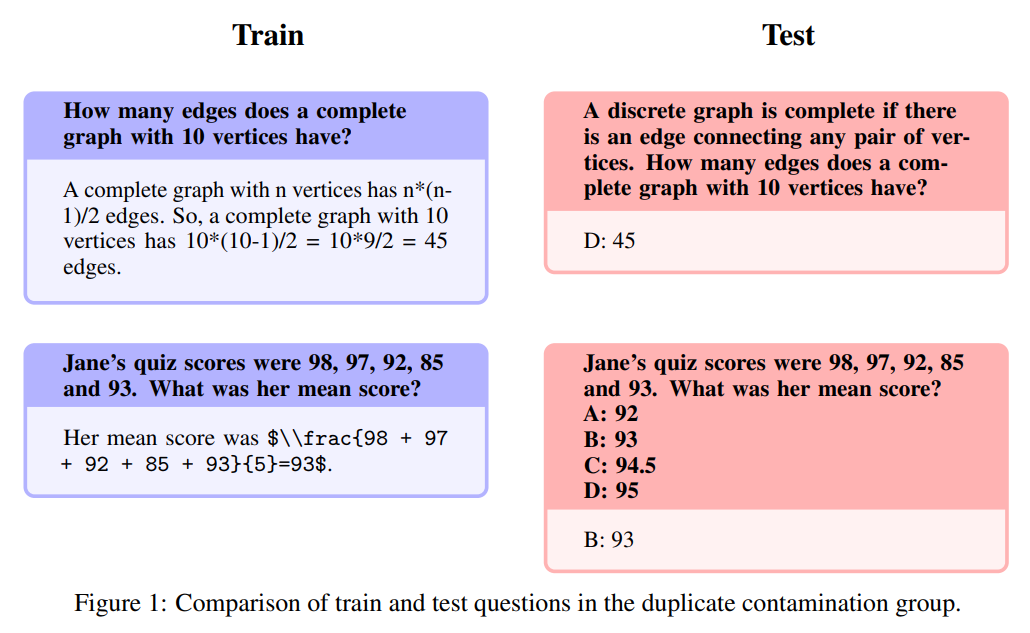

Pengarang berasal dari Universiti Boston dan menggunakan PEFT, LoRA dan dataset Open-Platypus untuk memperhalusi dan mengoptimumkan Platypus berdasarkan Llama 2

The pengarang Platypus memperkenalkan

secara terperinci dalam kertas

Kertas ini boleh didapati di: https://arxiv.org/abs/2308.07317

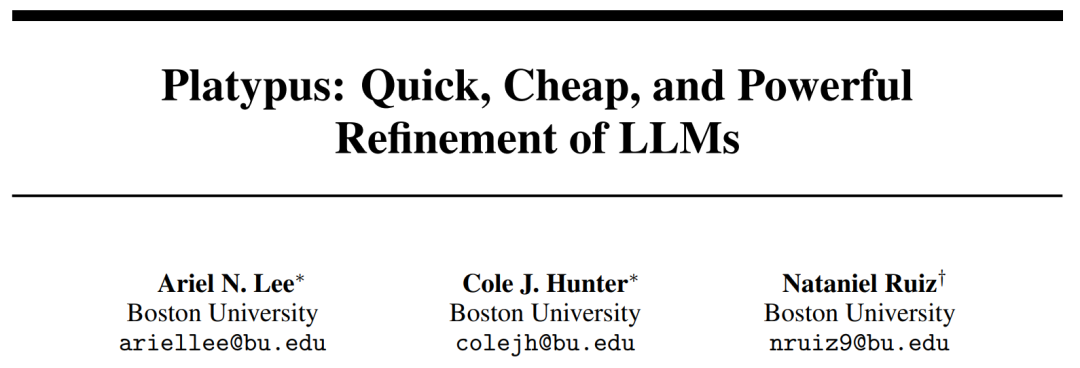

- Berikut adalah sumbangan utama kertas kerja ini : Open-Platypus ialah set data berskala kecil yang terdiri daripada subset susun atur set data teks awam. Set data ini terdiri daripada 11 set data sumber terbuka dengan tumpuan untuk meningkatkan STEM dan pengetahuan logik LLM. Ia terutamanya terdiri daripada masalah yang direka oleh manusia, dengan hanya 10% daripada masalah yang dihasilkan oleh LLM. Kelebihan utama Open-Platypus ialah skala dan kualitinya, yang membolehkan prestasi yang sangat tinggi dalam masa yang singkat dan dengan masa yang rendah serta kos penalaan halus. Khususnya, melatih model 13B menggunakan masalah 25k mengambil masa hanya 5 jam pada GPU A100 tunggal.

- menerangkan proses penghapusan persamaan, mengurangkan saiz set data dan mengurangkan lebihan data.

- Analisis terperinci tentang fenomena pencemaran set latihan LLM terbuka yang sentiasa wujud dengan data yang terkandung dalam set ujian LLM yang penting, dan pengenalan kepada proses penapisan data latihan pengarang untuk mengelakkan bahaya tersembunyi ini.

- Menghuraikan proses memilih dan menggabungkan modul LoRA khusus yang diperhalusi.

membuka dataset platypus

Penulis kini telah mengeluarkan dataset terbuka-platypus pada memeluk masalah face

contamination

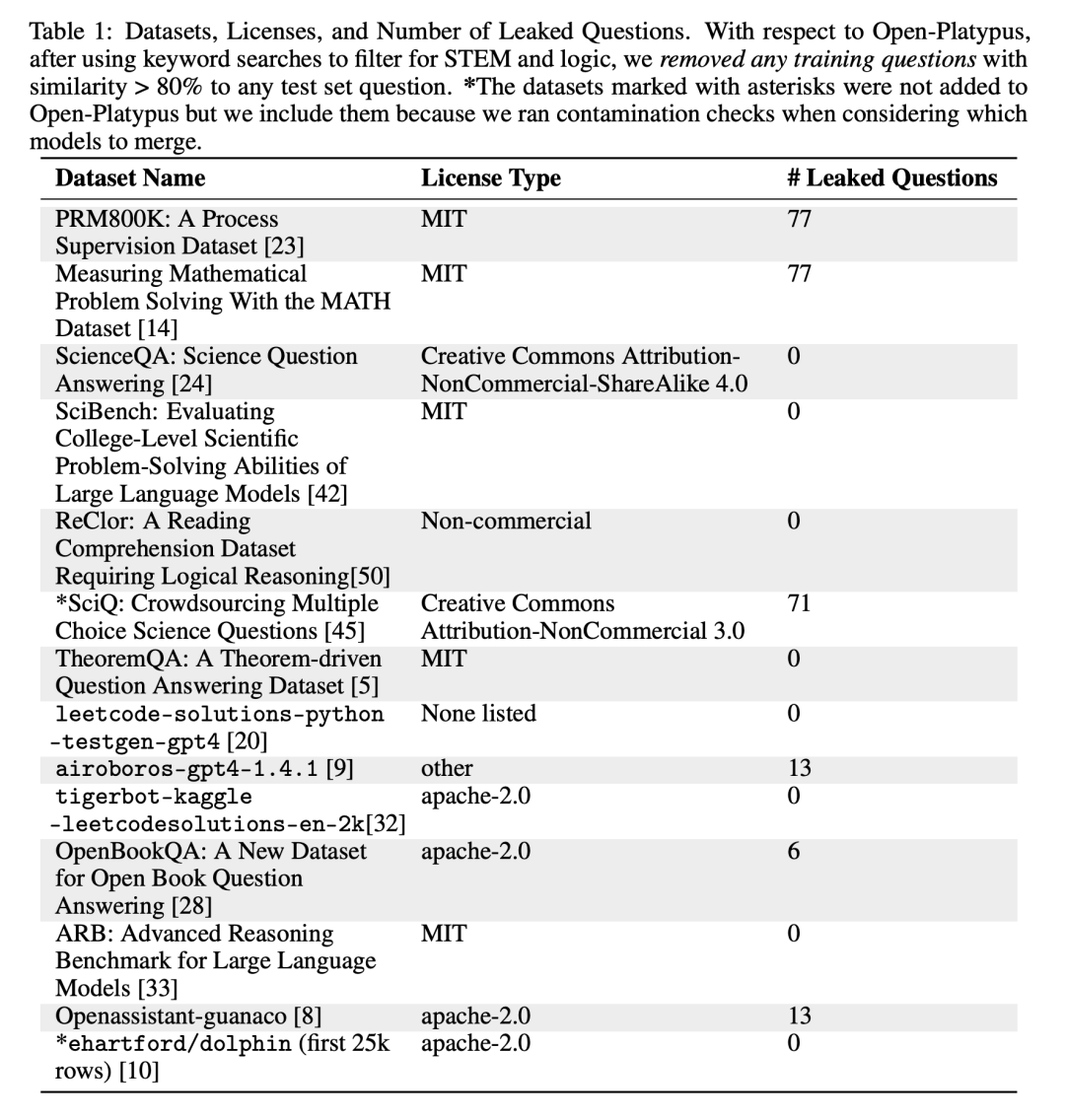

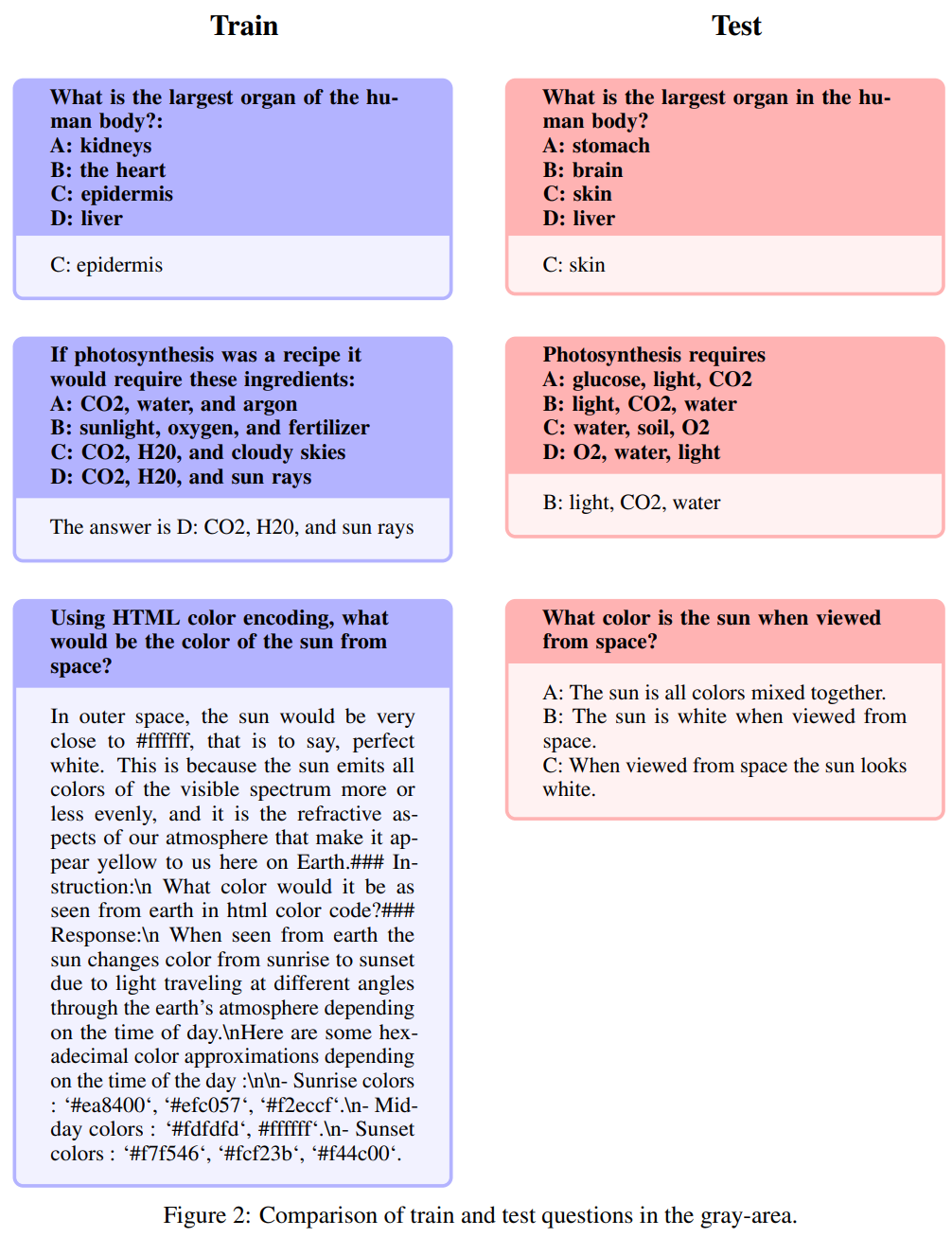

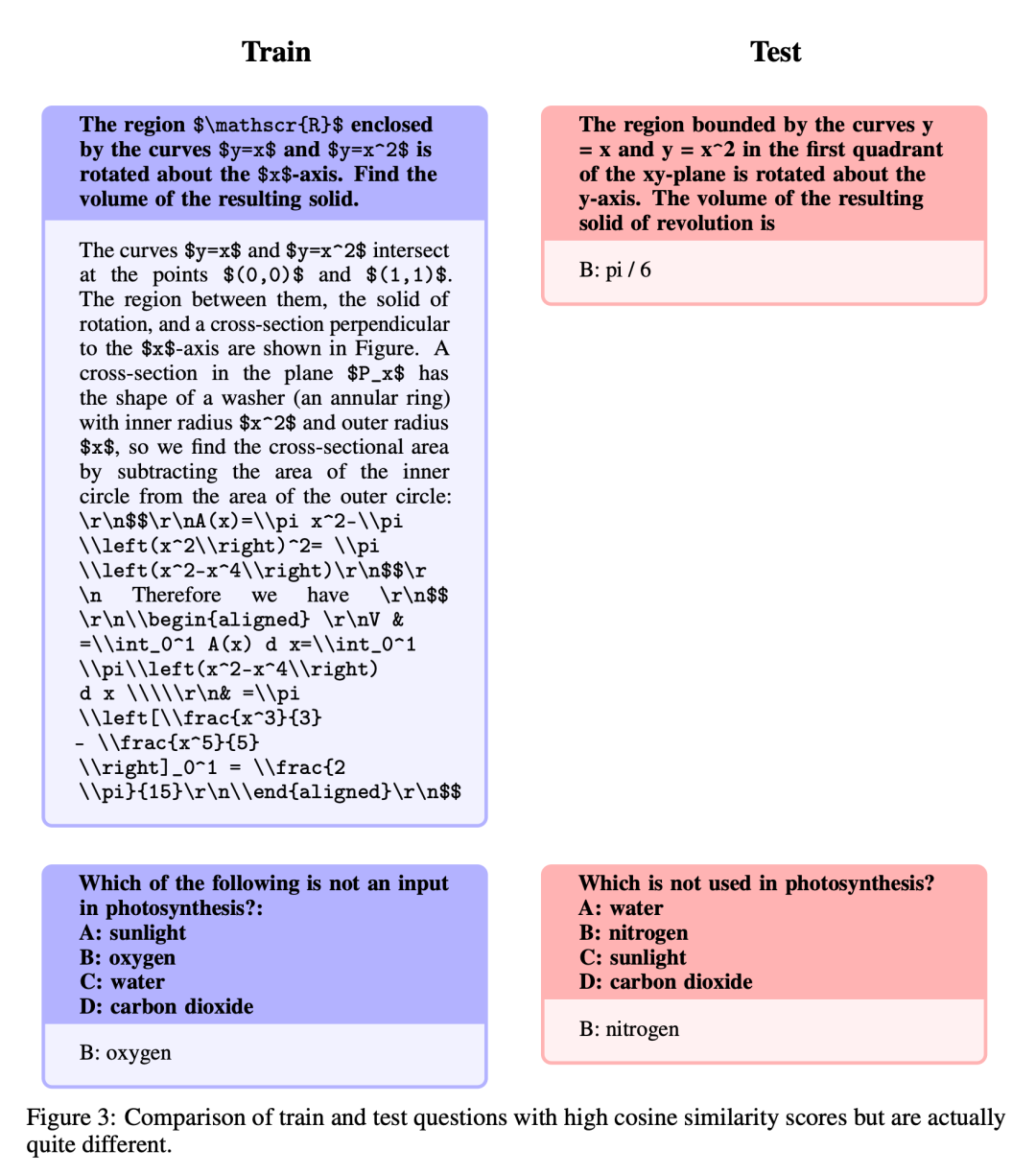

untuk mengelakkan masalah penandaarasan yang bocor ke latihan ditetapkan, kaedah kami terlebih dahulu mempertimbangkan untuk mencegah masalah ini untuk memastikan bahawa keputusan tidak hanya berat sebelah oleh ingatan. Sambil berusaha untuk mendapatkan ketepatan, penulis juga sedar tentang keperluan untuk fleksibiliti dalam menanda sila sebut lagi soalan kerana soalan boleh ditanya dalam pelbagai cara dan dipengaruhi oleh pengetahuan domain am. Untuk menguruskan isu kebocoran yang berpotensi, pengarang mereka bentuk heuristik dengan teliti untuk menapis masalah secara manual dengan lebih daripada 80% persamaan dengan pembenaman kosinus masalah penanda aras dalam Open-Platypus. Mereka membahagikan isu kebocoran yang berpotensi kepada tiga kategori: (1) Sila nyatakan soalan itu semula; Kawasan ini menimbulkan masalah tona kelabu; (3) masalah yang serupa tetapi tidak serupa. Hanya untuk berhati-hati, mereka mengecualikan semua soalan ini daripada set latihan

Sila katakan sekali lagi

Teks ini hampir sama mereplikasi kandungan set soalan ujian, dengan hanya tweak sedikit perkataan Ubah suai atau susun semula. Berdasarkan bilangan kebocoran dalam jadual di atas, penulis percaya ini adalah satu-satunya kategori yang berada di bawah pencemaran. Berikut ialah contoh khusus:

Penerangan semula: Kawasan ini mempunyai warna kelabu

🎜🎜Soalan berikut dipanggil huraian semula: Kawasan ini mengambil warna kelabu dan termasuk isu yang tidak betul, sila, akal. Walaupun pengarang menyerahkan penghakiman terakhir mengenai isu ini kepada komuniti sumber terbuka, mereka berpendapat bahawa isu ini sering memerlukan pengetahuan pakar. Perlu diingatkan bahawa jenis soalan ini termasuk soalan dengan arahan yang sama tetapi jawapan yang sinonim:

Serupa tetapi tidak betul-betul sama

mempunyai tahap yang tinggi, soalan yang serupa tetapi disebabkan variasi halus antara soalan, terdapat perbezaan yang ketara dalam jawapan. . Tidak seperti penalaan halus penuh, LoRA mengekalkan berat model pra-latihan dan menggunakan matriks penguraian pangkat untuk penyepaduan dalam lapisan pengubah, dengan itu mengurangkan parameter boleh dilatih dan menjimatkan masa dan kos latihan. Pada mulanya, penalaan halus tertumpu terutamanya pada modul perhatian seperti v_proj, q_proj, k_proj dan o_proj. Selepas itu, ia diperluaskan kepada modul gate_proj, down_proj dan up_proj mengikut cadangan He et al. Melainkan parameter yang boleh dilatih adalah kurang daripada 0.1% daripada jumlah parameter, modul ini berprestasi lebih baik. Penulis menggunakan kaedah ini untuk kedua-dua model 13B dan 70B, dan parameter boleh dilatih yang terhasil adalah 0.27% dan 0.2% masing-masing. Satu-satunya perbezaan ialah kadar pembelajaran awal model-model ini

Hasilnya

Menurut data ranking LLM Hugging Face Open pada 10 Ogos 2023, penulis membandingkan Platypus dengan model SOTA lain dan mendapati Platypus2-70Binstruct berubah Model ini berprestasi baik, menduduki tempat pertama dengan purata skor 73.13

Stable-Platypus2-13B Model menonjol dengan purata skor 63.96 antara 13 bilion model parameter, yang patut diberi perhatian

Limitations

Atas ialah kandungan terperinci Senarai LLM Terbuka telah dimuat semula dan 'Platypus' yang lebih kuat daripada Llama 2 ada di sini.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1378

1378

52

52

Cara Melaksanakan Penyortiran Fail oleh Debian Readdir

Apr 13, 2025 am 09:06 AM

Cara Melaksanakan Penyortiran Fail oleh Debian Readdir

Apr 13, 2025 am 09:06 AM

Dalam sistem Debian, fungsi Readdir digunakan untuk membaca kandungan direktori, tetapi urutan yang dikembalikannya tidak ditentukan sebelumnya. Untuk menyusun fail dalam direktori, anda perlu membaca semua fail terlebih dahulu, dan kemudian menyusunnya menggunakan fungsi QSORT. Kod berikut menunjukkan cara menyusun fail direktori menggunakan ReadDir dan QSORT dalam sistem Debian:#termasuk#termasuk#termasuk#termasuk // fungsi perbandingan adat, yang digunakan untuk qSortintCompare (Constvoid*A, Constvoid*b) {Returnstrcmp (*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(

Cara Mengoptimumkan Prestasi Debian Readdir

Apr 13, 2025 am 08:48 AM

Cara Mengoptimumkan Prestasi Debian Readdir

Apr 13, 2025 am 08:48 AM

Dalam sistem Debian, panggilan sistem Readdir digunakan untuk membaca kandungan direktori. Jika prestasinya tidak baik, cuba strategi pengoptimuman berikut: Memudahkan bilangan fail direktori: Split direktori besar ke dalam pelbagai direktori kecil sebanyak mungkin, mengurangkan bilangan item yang diproses setiap panggilan readdir. Dayakan Caching Kandungan Direktori: Bina mekanisme cache, kemas kini cache secara teratur atau apabila kandungan direktori berubah, dan mengurangkan panggilan kerap ke Readdir. Cafh memori (seperti memcached atau redis) atau cache tempatan (seperti fail atau pangkalan data) boleh dipertimbangkan. Mengamalkan struktur data yang cekap: Sekiranya anda melaksanakan traversal direktori sendiri, pilih struktur data yang lebih cekap (seperti jadual hash dan bukannya carian linear) untuk menyimpan dan mengakses maklumat direktori

Cara Menetapkan Tahap Log Debian Apache

Apr 13, 2025 am 08:33 AM

Cara Menetapkan Tahap Log Debian Apache

Apr 13, 2025 am 08:33 AM

Artikel ini menerangkan cara menyesuaikan tahap pembalakan pelayan Apacheweb dalam sistem Debian. Dengan mengubah suai fail konfigurasi, anda boleh mengawal tahap maklumat log yang direkodkan oleh Apache. Kaedah 1: Ubah suai fail konfigurasi utama untuk mencari fail konfigurasi: Fail konfigurasi apache2.x biasanya terletak di direktori/etc/apache2/direktori. Nama fail mungkin apache2.conf atau httpd.conf, bergantung pada kaedah pemasangan anda. Edit Fail Konfigurasi: Buka Fail Konfigurasi dengan Kebenaran Root Menggunakan Editor Teks (seperti Nano): Sudonano/ETC/APACHE2/APACHE2.CONF

Bagaimana Debian Readdir Bersepadu Dengan Alat Lain

Apr 13, 2025 am 09:42 AM

Bagaimana Debian Readdir Bersepadu Dengan Alat Lain

Apr 13, 2025 am 09:42 AM

Fungsi Readdir dalam sistem Debian adalah panggilan sistem yang digunakan untuk membaca kandungan direktori dan sering digunakan dalam pengaturcaraan C. Artikel ini akan menerangkan cara mengintegrasikan Readdir dengan alat lain untuk meningkatkan fungsinya. Kaedah 1: Menggabungkan Program Bahasa C dan Pipeline Pertama, tulis program C untuk memanggil fungsi Readdir dan output hasilnya:#termasuk#termasuk#includeintMain (intargc, char*argv []) {dir*dir; structdirent*entry; if (argc! = 2) {

Bagaimana Debian OpenSSL Menghalang Serangan Man-dalam-Middle

Apr 13, 2025 am 10:30 AM

Bagaimana Debian OpenSSL Menghalang Serangan Man-dalam-Middle

Apr 13, 2025 am 10:30 AM

Dalam sistem Debian, OpenSSL adalah perpustakaan penting untuk pengurusan penyulitan, penyahsulitan dan sijil. Untuk mengelakkan serangan lelaki-dalam-pertengahan (MITM), langkah-langkah berikut boleh diambil: Gunakan HTTPS: Pastikan semua permintaan rangkaian menggunakan protokol HTTPS dan bukannya HTTP. HTTPS menggunakan TLS (Protokol Keselamatan Lapisan Pengangkutan) untuk menyulitkan data komunikasi untuk memastikan data tidak dicuri atau diganggu semasa penghantaran. Sahkan Sijil Pelayan: Sahkan secara manual Sijil Pelayan pada klien untuk memastikan ia boleh dipercayai. Pelayan boleh disahkan secara manual melalui kaedah perwakilan urlSession

Petua Konfigurasi Firewall Pelayan Mel Debian

Apr 13, 2025 am 11:42 AM

Petua Konfigurasi Firewall Pelayan Mel Debian

Apr 13, 2025 am 11:42 AM

Mengkonfigurasi firewall pelayan Mail Debian adalah langkah penting dalam memastikan keselamatan pelayan. Berikut adalah beberapa kaedah konfigurasi firewall yang biasa digunakan, termasuk penggunaan iptables dan firewalld. Gunakan iptables untuk mengkonfigurasi firewall untuk memasang iptables (jika belum dipasang): sudoapt-getupdateudoapt-getinstalliplesview peraturan iptables semasa: konfigurasi sudoiptable-l

Cara Belajar Debian Syslog

Apr 13, 2025 am 11:51 AM

Cara Belajar Debian Syslog

Apr 13, 2025 am 11:51 AM

Panduan ini akan membimbing anda untuk belajar cara menggunakan syslog dalam sistem Debian. SYSLOG adalah perkhidmatan utama dalam sistem Linux untuk sistem pembalakan dan mesej log aplikasi. Ia membantu pentadbir memantau dan menganalisis aktiviti sistem untuk mengenal pasti dan menyelesaikan masalah dengan cepat. 1. Pengetahuan asas syslog Fungsi teras syslog termasuk: mengumpul dan menguruskan mesej log secara terpusat; menyokong pelbagai format output log dan lokasi sasaran (seperti fail atau rangkaian); Menyediakan fungsi tontonan log dan penapisan masa nyata. 2. Pasang dan konfigurasikan syslog (menggunakan rsyslog) Sistem Debian menggunakan rsyslog secara lalai. Anda boleh memasangnya dengan arahan berikut: sudoaptupdatesud

Cara Mengkonfigurasi Peraturan Firewall Untuk Debian Syslog

Apr 13, 2025 am 06:51 AM

Cara Mengkonfigurasi Peraturan Firewall Untuk Debian Syslog

Apr 13, 2025 am 06:51 AM

Artikel ini menerangkan cara mengkonfigurasi peraturan firewall menggunakan iptables atau UFW dalam sistem debian dan menggunakan syslog untuk merakam aktiviti firewall. Kaedah 1: Gunakan IPTableSiptable adalah alat firewall baris perintah yang kuat dalam sistem Debian. Lihat peraturan yang ada: Gunakan arahan berikut untuk melihat peraturan iptables semasa: sudoiptables-l-n-v membolehkan akses IP tertentu: sebagai contoh, membenarkan alamat IP 192.168.1.100 untuk mengakses port 80: sudoiptables-ainput-pTCP-Dport80-S192.16