Peranti teknologi

Peranti teknologi

AI

AI

Tajuk Baharu: Mendedahkan Mengapa Model Besar Lambat: Arah Baharu untuk Algoritma Minda Manusia

Tajuk Baharu: Mendedahkan Mengapa Model Besar Lambat: Arah Baharu untuk Algoritma Minda Manusia

Tajuk Baharu: Mendedahkan Mengapa Model Besar Lambat: Arah Baharu untuk Algoritma Minda Manusia

Pengkaji AI sering mengabaikan gerak hati manusia, tetapi sebenarnya kita sendiri tidak memahami sepenuhnya kehalusannya. Baru-baru ini, pasukan penyelidik dari Virginia Tech dan Microsoft mencadangkan Algoritma Pemikiran (AoT) yang menggabungkan keupayaan intuitif dengan kaedah algoritma untuk bukan sahaja menjamin prestasi LLM tetapi juga sangat menjimatkan kos

Model Bahasa Besar Perkembangan baru-baru ini sangat pesat. , dan ia telah menunjukkan kebolehan luar biasa yang luar biasa dalam menyelesaikan masalah umum, menjana kod dan mengikut arahan

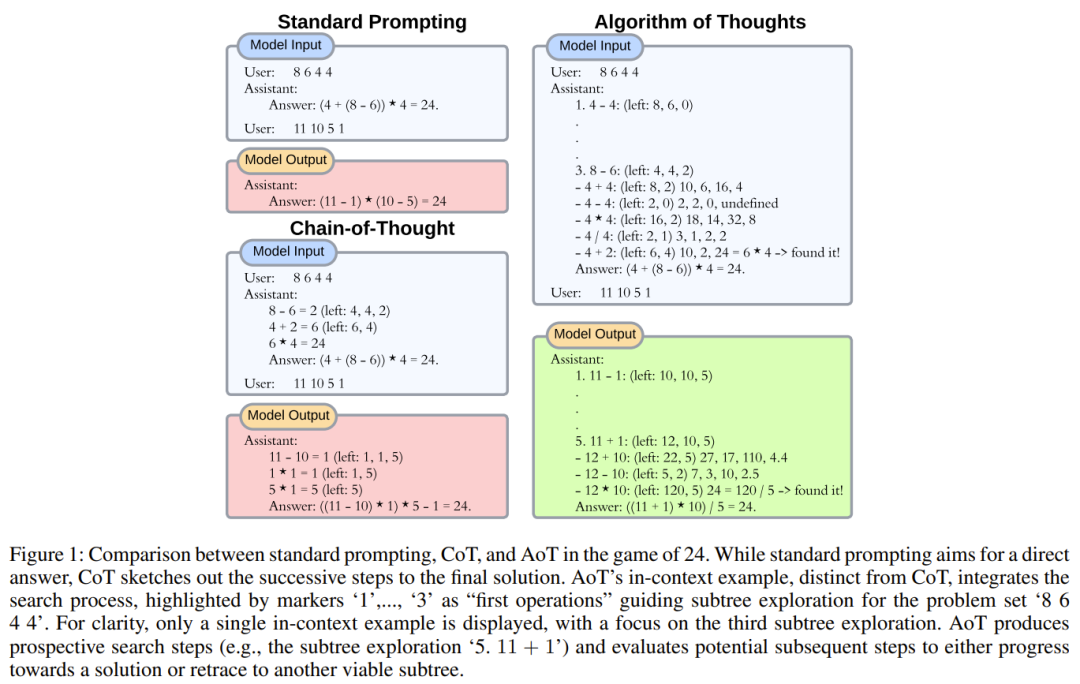

Walaupun model awal bergantung pada strategi jawapan langsung, penyelidikan semasa telah bergerak ke arah Laluan penaakulan linear, yang dilakukan dengan menguraikan masalah kepada subtugas untuk temui penyelesaian, atau menggunakan mekanisme luaran untuk menukar penjanaan token dengan mengubah suai konteks.

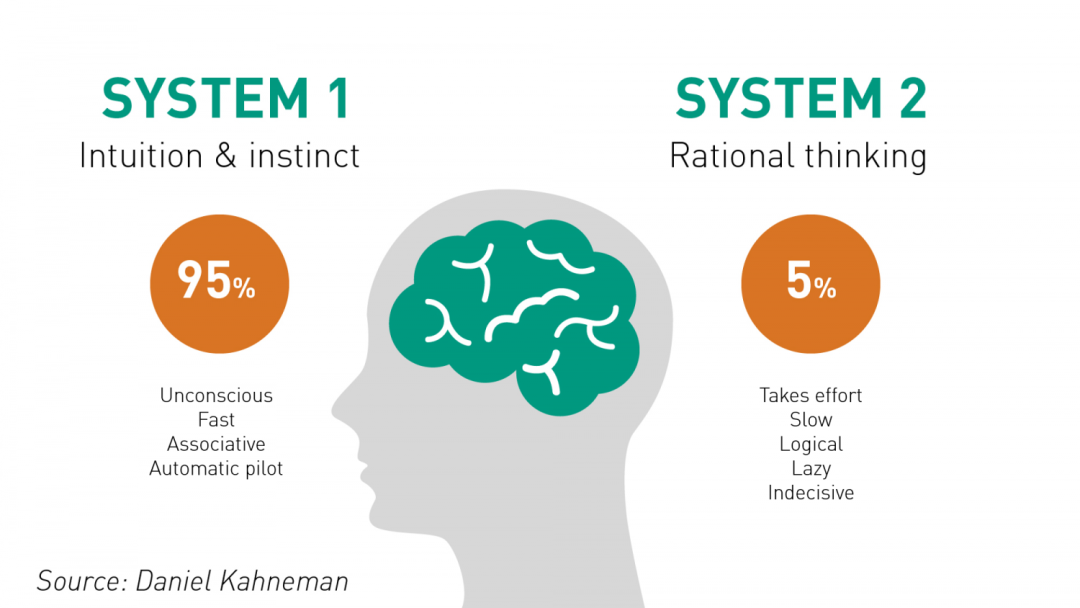

Sama seperti kognisi manusia, strategi LLM awal seolah-olah meniru Sistem 1 serta-merta (tindak balas pantas), dicirikan oleh membuat keputusan yang impulsif. Sebaliknya, kaedah yang lebih baharu seperti Chain of Thoughts (CoT) dan least-to-most prompting (L2M) mencerminkan sifat introspektif Sistem 2 (pemikiran perlahan). Perlu diingat bahawa keupayaan penaakulan aritmetik LLM boleh dipertingkatkan dengan menyepadukan langkah-langkah penaakulan pertengahan.

Namun, jika tugas itu memerlukan perancangan yang lebih mendalam dan penerokaan mental yang lebih luas, maka batasan kaedah ini menjadi jelas. Walaupun CoT yang menggabungkan ketekalan diri (CoT-SC) boleh menggunakan berbilang output LLM untuk mencapai keputusan konsensus, kekurangan penilaian terperinci boleh membawa model ke arah yang salah. The Tree of Thinking (ToT) yang muncul pada tahun 2023 adalah penyelesaian yang perlu diberi perhatian. Satu LLM digunakan untuk menjana idea, dan LLM lain digunakan untuk menilai kebaikan idea tersebut, diikuti dengan kitaran "jeda-nilai-teruskan". Proses berulang berdasarkan carian pokok ini jelas berkesan, terutamanya untuk tugasan dengan kesinambungan yang panjang. Para penyelidik percaya perkembangan ini ialah penggunaan alat luaran untuk meningkatkan LLM, sama seperti cara manusia menggunakan alat untuk memintas batasan memori kerja mereka sendiri.

Sebaliknya, kaedah LLM yang dipertingkatkan juga mempunyai beberapa kelemahan. Masalah yang jelas ialah bilangan pertanyaan dan keperluan pengiraan akan meningkat dengan ketara. Setiap pertanyaan kepada API LLM dalam talian seperti GPT-4 menimbulkan overhed yang ketara dan mengakibatkan peningkatan kependaman, yang amat penting untuk aplikasi masa nyata. Kependaman terkumpul pertanyaan ini boleh mengurangkan kecekapan keseluruhan senario. Dari segi infrastruktur, interaksi berterusan memberi tekanan pada sistem, yang berpotensi mengehadkan lebar jalur dan mengurangkan ketersediaan model. Di samping itu, kesan terhadap alam sekitar tidak boleh diabaikan. Pertanyaan yang kerap akan meningkatkan penggunaan tenaga pusat data yang sudah intensif tenaga dan seterusnya meningkatkan jejak karbon

Matlamat pengoptimuman penyelidik adalah untuk mengurangkan kos semasa dengan ketara manakala mengekalkan prestasi yang mencukupi. Bilangan pertanyaan yang digunakan oleh kaedah inferens berbilang pertanyaan. Pengoptimuman sedemikian boleh membolehkan model mengendalikan tugas yang memerlukan penggunaan pengetahuan dunia yang mahir, dan membimbing orang ramai menggunakan sumber AI dengan lebih bertanggungjawab dan cekap

Dengan memikirkan tentang evolusi LLM daripada Sistem 1 kepada Sistem 2, kita dapat melihat satu kunci Faktor yang muncul: Algoritma. Algoritma adalah berkaedah dan menyediakan cara untuk orang ramai meneroka ruang masalah, merangka strategi dan membina penyelesaian. Walaupun banyak kesusasteraan arus perdana menganggap algoritma sebagai alat luaran LLM, memandangkan keupayaan pengulangan generatif yang wujud dalam LLM, bolehkah kita membimbing logik lelaran ini dan menghayati algoritma ke dalam LLM?

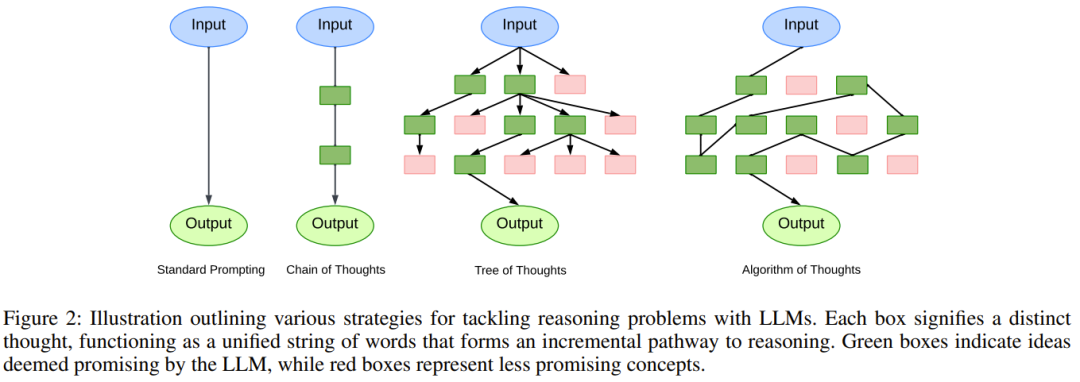

Sebuah pasukan penyelidik dari Virginia Tech dan Microsoft telah mengumpulkan kecanggihan penaakulan manusia dan ketepatan kaedah kaedah algoritma, bertujuan untuk meningkatkan keupayaan penaakulan dalam LLM dengan menggabungkan dua aspek

Menurut penyelidikan sedia ada, manusia secara naluriah menggunakan pengalaman lalu apabila menyelesaikan masalah yang kompleks untuk memastikan mereka berfikir secara holistik dan bukannya menumpukan pada satu perincian secara sempit. Julat penjanaan LLM hanya dihadkan oleh had tokennya, dan nampaknya ditakdirkan untuk menembusi halangan ingatan kerja manusia

Diilhamkan oleh pemerhatian ini, penyelidik mula meneroka sama ada LLM boleh digunakan untuk mencapai cara hierarki yang serupa pemikiran. Dengan merujuk kepada langkah perantaraan sebelumnya untuk menolak pilihan yang tidak boleh dilaksanakan - semuanya dilakukan dalam kitaran penjanaan LLM. Manusia pandai dalam gerak hati, manakala algoritma pandai dalam penerokaan yang teratur dan sistematik. Teknologi semasa seperti CoT cenderung untuk mengelakkan potensi sinergi ini dan terlalu fokus pada ketepatan LLM di tapak. Dengan memanfaatkan keupayaan rekursif LLM, para penyelidik membina pendekatan hibrid manusia-algoritma. Pendekatan ini dicapai melalui penggunaan contoh algoritma yang menangkap intipati penerokaan - daripada calon awal kepada penyelesaian yang terbukti

Berdasarkan pemerhatian ini, penyelidik mencadangkan Algoritma Pemikiran (AoT).

Kandungan yang perlu ditulis semula ialah: Kertas: https://arxiv.org/pdf/2308.10379.pdf

rom

rom

dijangka akan melahirkan paradigma baharu pembelajaran kontekstual. Daripada menggunakan model pembelajaran tradisional yang diselia iaitu [soalan, jawapan] atau [soalan, langkah-langkah seterusnya untuk mendapatkan jawapan], pendekatan baharu ini menggunakan model baharu [soalan, proses carian, jawapan]. Sememangnya, apabila LLM diarahkan untuk menggunakan algoritma, kami biasanya mengharapkan LLM hanya meniru pemikiran berulang algoritma tersebut. Walau bagaimanapun, apa yang menarik ialah LLM mempunyai keupayaan untuk menyuntik "intuisi" sendiri, malah menjadikan cariannya lebih cekap daripada algoritma itu sendiri.

Algoritma Pemikiran

Para penyelidik mengatakan bahawa teras strategi penyelidikan mereka ialah pengiktirafan terhadap kelemahan utama paradigma pembelajaran kontekstual semasa. Walaupun CoT boleh meningkatkan ketekalan sambungan pemikiran, masalah kadangkala berlaku, membawa kepada langkah perantaraan yang salah

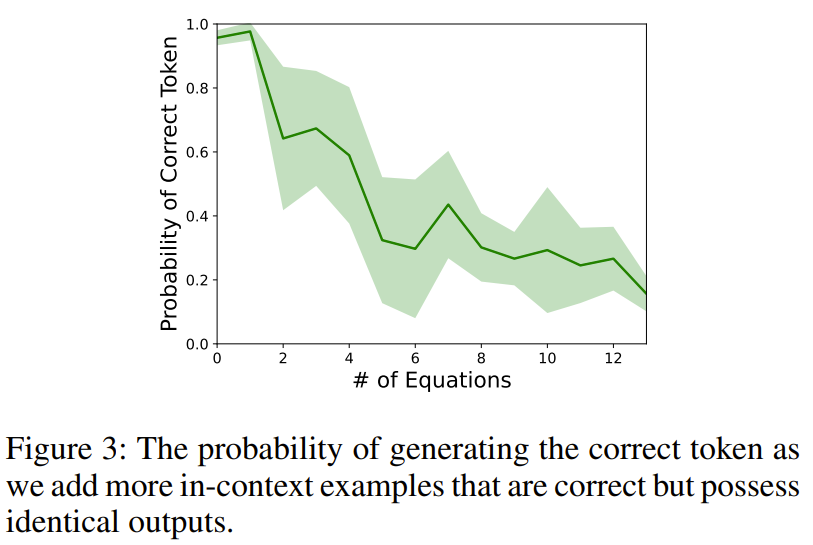

Untuk menggambarkan fenomena ini, penyelidik mereka satu eksperimen. Apabila menanyakan teks-davinci-003 dengan tugasan aritmetik (seperti 11 − 2 =), penyelidik akan menambah berbilang persamaan kontekstual yang akan menghasilkan output yang sama (seperti 15 − 5 = 10, 8 + 2 = 10).

Selepas penyiasatan, didapati ketepatan keputusan menjunam, menunjukkan bahawa hanya memberikan penaakulan yang betul dalam konteks secara tidak sengaja boleh membahayakan kemahiran aritmetik asas LLM

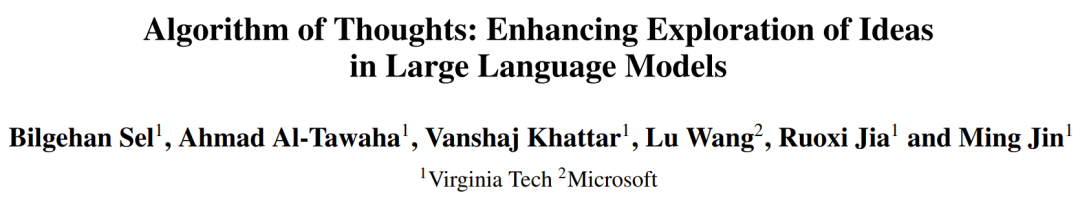

Untuk mengurangkan kecondongan ini. mungkin penyelesaian yang berdaya maju, tetapi ini mungkin sedikit mengubah pengedaran output. Hanya menambah beberapa percubaan yang tidak berjaya (seperti carian rawak) mungkin secara tidak sengaja menggalakkan model untuk mencuba lagi tanpa benar-benar menyelesaikan masalah. Memahami sifat sebenar tingkah laku algoritma (di mana carian gagal dan pemulihan berikutnya adalah penting, serta belajar daripada percubaan ini), cara penyelidik menggabungkan contoh kontekstual adalah dengan mengikuti corak algoritma carian, terutamanya carian mendalam-pertama (DFS) dan Breadth First Search (BFS). Rajah 1 memberi contoh.

Fokus utama kertas ini ialah kelas tugasan yang serupa dengan masalah pencarian pokok

Untuk jenis tugasan ini, adalah perlu untuk memecahkan masalah utama dan membina penyelesaian yang boleh dilaksanakan untuk setiap bahagian. Kami kemudiannya perlu memutuskan sama ada untuk menerima pakai atau meninggalkan laluan tertentu, dan mungkin memilih untuk menilai semula laluan yang berpotensi lebih besar

Pendekatan penyelidik adalah untuk memanfaatkan keupayaan lelaran LLM untuk menyelesaikan dalam soalan pertanyaan imbasan generatif bersatu untuk setiap subset. Dengan mengehadkan kepada hanya satu atau dua interaksi LLM, pendekatan ini secara semula jadi boleh menyepadukan cerapan daripada calon kontekstual terdahulu dan menyelesaikan masalah kompleks yang memerlukan penerokaan mendalam tentang domain penyelesaian. Para penyelidik juga memberikan pandangan tentang saiz minda dan jenis contoh kontekstual yang perlu diberikan kepada LLM untuk meningkatkan kecekapan token. Komponen utama algoritma carian pokok dan perwakilannya dalam rangka kerja baharu akan diperkenalkan di bawah

1. Uraikan kepada sub-masalah.

Memandangkan masalah, membina pepohon carian yang menerangkan laluan penaakulan yang boleh dilaksanakan sudah menjadi tugas yang sukar walaupun tanpa melihat aspek penyelesaian masalah yang sebenar. Sebarang penguraian mesti mempertimbangkan bukan sahaja perkaitan antara subtugas, tetapi juga kemudahan menyelesaikan setiap masalah.Ambil penambahan berbilang digit yang mudah sebagai contoh: Walaupun komputer adalah cekap untuk menukar nilai berangka kepada nombor binari, manusia biasanya mendapati nombor perpuluhan lebih intuitif. Tambahan pula, walaupun submasalah adalah sama, kaedah pelaksanaan mungkin berbeza. Intuisi boleh mencari jalan pintas antara langkah kepada penyelesaian, dan tanpa gerak hati, langkah yang lebih terperinci mungkin diperlukan. 🎜🎜

Untuk mencipta gesaan yang betul (iaitu contoh algoritma kontekstual), kehalusan ini sangat penting dan ia menentukan bilangan minimum token yang diperlukan untuk LLM mencapai prestasi yang boleh dipercayai. Ini bukan sahaja memenuhi kekangan LLM pada konteks, tetapi juga penting untuk keupayaan LLM untuk menyelesaikan masalah yang bergema dengan konteksnya menggunakan jumlah token yang sama.

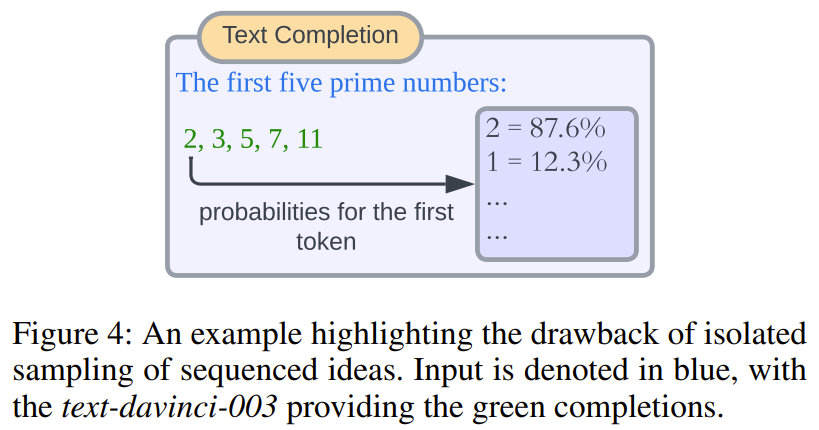

2. Cadangkan penyelesaian kepada sub-soalan. Salah satu kaedah arus perdana semasa melibatkan pensampelan terus kebarangkalian keluaran token LLM. Walaupun kaedah ini berkesan untuk jawapan sekali sahaja (dengan had tertentu), kaedah ini juga tidak dapat menangani beberapa senario, seperti apabila urutan sampel perlu disepadukan ke dalam gesaan berikutnya atau dinilai dalam gesaan berikutnya. Untuk meminimumkan pertanyaan model, penyelidik menggunakan proses penciptaan penyelesaian tanpa henti. Iaitu, secara langsung dan berterusan menjana penyelesaian kepada submasalah utama tanpa sebarang jeda generasi.

Kandungan yang ditulis semula: Kaedah ini mempunyai banyak kelebihan. Pertama, semua jawapan yang dijana adalah dalam konteks kongsi yang sama, menghapuskan keperluan untuk menjana pertanyaan model yang berasingan untuk setiap jawapan untuk penilaian. Kedua, walaupun ia mungkin kelihatan berlawanan dengan intuisi pada mulanya, penanda terpencil atau kebarangkalian kumpulan penanda mungkin tidak selalu membawa kepada pilihan yang bermakna. Rajah 4 menunjukkan skema mudah

3. Seperti yang dinyatakan di atas, teknik sedia ada bergantung pada pembayang tambahan untuk mengenal pasti potensi nod pokok untuk membantu membuat keputusan tentang arah penerokaan. Pemerhatian kami mencadangkan bahawa LLM sememangnya cenderung untuk mengutamakan calon yang menjanjikan jika mereka boleh dirangkumkan dalam contoh kontekstual. Ini mengurangkan keperluan untuk kejuruteraan segera yang kompleks dan membolehkan penyepaduan heuristik yang canggih, sama ada ia adalah intuitif atau didorong oleh pengetahuan. Begitu juga, kaedah baharu tidak termasuk gesaan terputus-putus, yang membolehkan penilaian segera kebolehlaksanaan calon dalam hasil yang dijana yang sama.

4. Undur ke nod yang lebih baik. Memutuskan nod yang akan diterokai seterusnya (termasuk menjejak ke belakang ke nod sebelumnya) pada asasnya bergantung pada algoritma carian pepohon yang dipilih. Walaupun penyelidikan terdahulu telah menggunakan kaedah luaran seperti mekanisme pengekodan untuk proses carian, ini akan mengehadkan daya tarikannya yang lebih luas dan memerlukan penyesuaian tambahan. Reka bentuk baru yang dicadangkan dalam kertas ini terutamanya menggunakan kaedah DFS yang ditambah dengan pemangkasan. Matlamatnya adalah untuk mengekalkan kedekatan antara nod anak dengan nod induk yang sama, sekali gus menggalakkan LLM mengutamakan ciri tempatan berbanding ciri jauh. Selain itu, penyelidik juga mencadangkan penunjuk prestasi kaedah AoT berasaskan BFS. Para penyelidik mengatakan bahawa keperluan untuk mekanisme penyesuaian tambahan boleh dihapuskan dengan memanfaatkan keupayaan sedia ada model untuk mendapatkan cerapan daripada contoh kontekstual.

Eksperimen

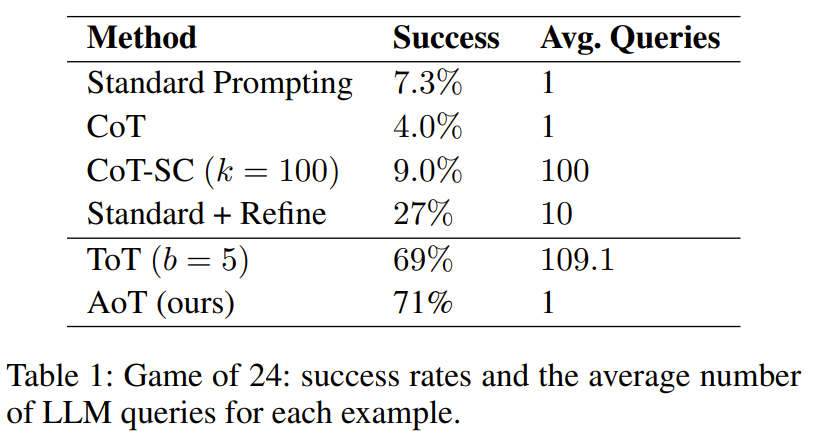

Para penyelidik menjalankan eksperimen ke atas permainan perkataan mini 24 mata dan 5x5. Keputusan menunjukkan bahawa kaedah AoT mengatasi kaedah segera tunggal (seperti kaedah standard, CoT, CoT-SC) dalam prestasi, dan juga setanding dengan kaedah yang menggunakan mekanisme luaran (seperti ToT)

Ia boleh dilihat dengan jelas daripada Jadual 1 Didapati kaedah carian pokok menggunakan LLM adalah jauh lebih baik daripada kaedah reka bentuk segera standard yang menggabungkan CoT/CoT-SC

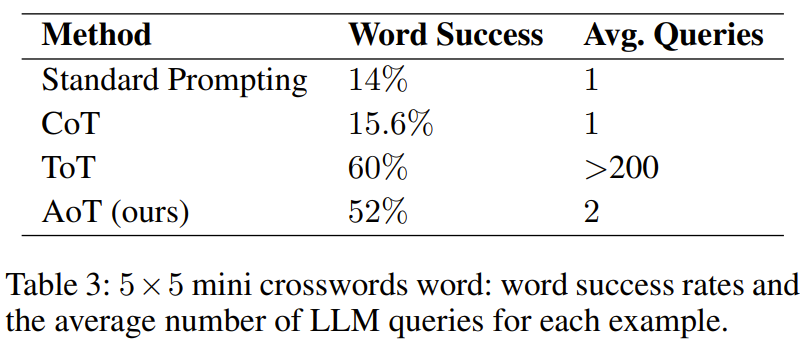

Dalam tugasan pengisian perkataan mini, Jadual 3 menunjukkan keberkesanan AoT dan kadar kejayaan pengisian perkataannya Melangkaui kaedah sebelumnya menggunakan pelbagai teknik dorongan

Walau bagaimanapun, ia lebih teruk daripada ToT. Pemerhatian penting ialah volum pertanyaan yang digunakan oleh ToT adalah besar, melebihi AoT sebanyak lebih daripada seratus kali. Faktor lain yang menjadikan AoT lebih rendah daripada ToT ialah keupayaan menjejak ke belakang yang wujud dalam contoh algoritma tidak diaktifkan sepenuhnya. Jika keupayaan ini boleh dibuka sepenuhnya, ia akan menghasilkan fasa penjanaan yang jauh lebih panjang. Sebaliknya, ToT mempunyai kelebihan menggunakan memori luaran untuk menjejak ke belakang.

Bincangkan

Bolehkah AoT mencapai kejayaan berdasarkan meniru DFS?

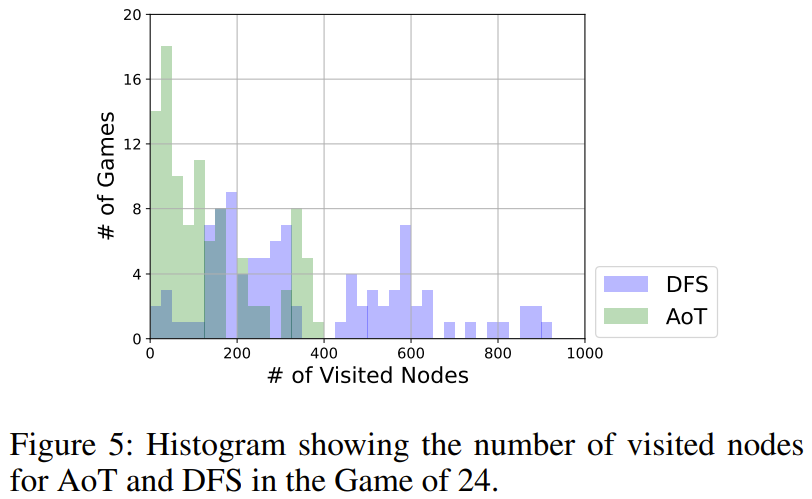

Seperti yang ditunjukkan dalam Rajah 5, AoT menggunakan lebih sedikit nod secara keseluruhan daripada versi DFS. DFS menggunakan strategi bersatu dalam memilih subpokok untuk diterokai, manakala LLM AoT menyepadukan heuristik yang wujud. Penguatan algoritma asas ini mencerminkan kelebihan keupayaan penaakulan rekursif LLM

Bagaimanakah pilihan algoritma mempengaruhi prestasi AoT?

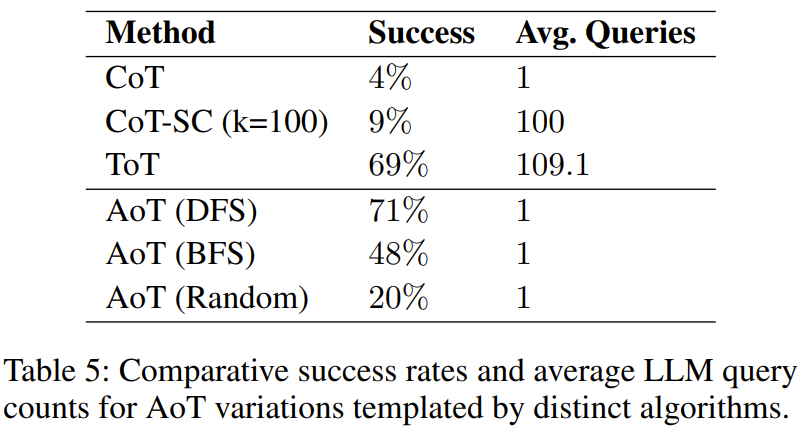

Ditemui dalam eksperimen, Jadual 5 menunjukkan bahawa ketiga-tiga varian AoT lebih unggul daripada CoT untuk satu pertanyaan

Keputusan ini seperti yang dijangkakan kerana ia mencari tanpa mengira algoritma Dan menyemak semula kemungkinan ralat - sama ada melalui percubaan rawak dalam varian carian rawak, atau melalui penjejakan ke belakang dalam konfigurasi carian mendalam-dahulu (DFS) atau carian luas-dahulu (BFS). Perlu diingat bahawa kecekapan carian berstruktur, versi DFS AoT dan versi BFS AoT, kedua-duanya lebih baik daripada versi rawak AoT, yang menyerlahkan kelebihan cerapan algoritma dalam penemuan penyelesaian. Walau bagaimanapun, versi BFS AoT ketinggalan daripada versi DFS AoT. Dengan menganalisis lebih lanjut kesilapan versi BFS AoT, penyelidik mendapati bahawa berbanding dengan versi DFS AoT, versi BFS AoT lebih sukar untuk mengenal pasti operasi terbaik

Apabila melaraskan tingkah laku AoT, kita perlu untuk memberi perhatian kepada contoh algoritma Bilangan langkah carian

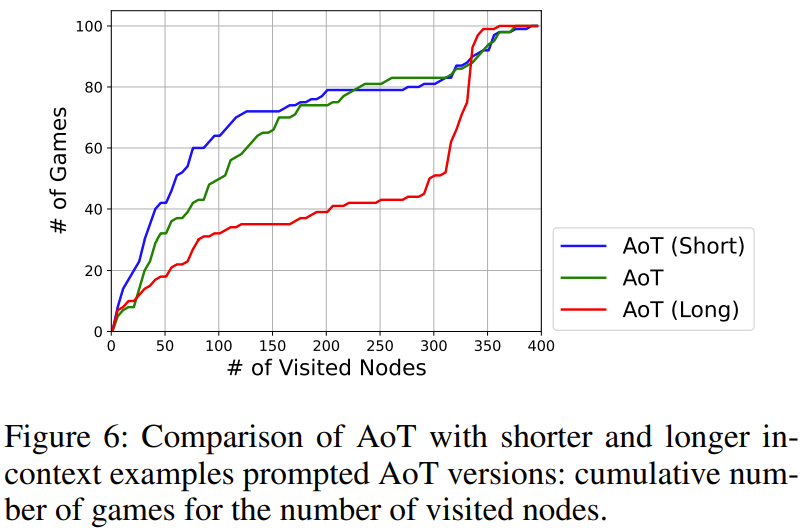

ditunjukkan dalam Rajah 6. Kesan daripada jumlah langkah carian ditunjukkan dalam Rajah 6. Antaranya, AoT (panjang) dan AoT (pendek) masing-masing mewakili versi yang lebih panjang dan lebih pendek berbanding dengan hasil asal AoT yang dijana

Hasil penyelidikan menunjukkan bahawa langkah carian akan menghasilkan bias tersirat dalam kelajuan carian LLM . Adalah penting untuk ambil perhatian bahawa walaupun mengambil langkah yang salah, adalah penting untuk menekankan penerokaan arah yang berpotensi

Atas ialah kandungan terperinci Tajuk Baharu: Mendedahkan Mengapa Model Besar Lambat: Arah Baharu untuk Algoritma Minda Manusia. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1393

1393

52

52

37

37

110

110

Gunakan ddrescue untuk memulihkan data pada Linux

Mar 20, 2024 pm 01:37 PM

Gunakan ddrescue untuk memulihkan data pada Linux

Mar 20, 2024 pm 01:37 PM

DDREASE ialah alat untuk memulihkan data daripada fail atau peranti sekat seperti cakera keras, SSD, cakera RAM, CD, DVD dan peranti storan USB. Ia menyalin data dari satu peranti blok ke peranti lain, meninggalkan blok data yang rosak dan hanya memindahkan blok data yang baik. ddreasue ialah alat pemulihan yang berkuasa yang automatik sepenuhnya kerana ia tidak memerlukan sebarang gangguan semasa operasi pemulihan. Selain itu, terima kasih kepada fail peta ddasue, ia boleh dihentikan dan disambung semula pada bila-bila masa. Ciri-ciri utama lain DDREASE adalah seperti berikut: Ia tidak menimpa data yang dipulihkan tetapi mengisi jurang sekiranya pemulihan berulang. Walau bagaimanapun, ia boleh dipotong jika alat itu diarahkan untuk melakukannya secara eksplisit. Pulihkan data daripada berbilang fail atau blok kepada satu

Sumber terbuka! Di luar ZoeDepth! DepthFM: Anggaran kedalaman monokular yang cepat dan tepat!

Apr 03, 2024 pm 12:04 PM

Sumber terbuka! Di luar ZoeDepth! DepthFM: Anggaran kedalaman monokular yang cepat dan tepat!

Apr 03, 2024 pm 12:04 PM

0. Apakah fungsi artikel ini? Kami mencadangkan DepthFM: model anggaran kedalaman monokular generatif yang serba boleh dan pantas. Sebagai tambahan kepada tugas anggaran kedalaman tradisional, DepthFM juga menunjukkan keupayaan terkini dalam tugas hiliran seperti mengecat kedalaman. DepthFM cekap dan boleh mensintesis peta kedalaman dalam beberapa langkah inferens. Mari kita baca karya ini bersama-sama ~ 1. Tajuk maklumat kertas: DepthFM: FastMonocularDepthEstimationwithFlowMatching Pengarang: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Google gembira: prestasi JAX mengatasi Pytorch dan TensorFlow! Ia mungkin menjadi pilihan terpantas untuk latihan inferens GPU

Apr 01, 2024 pm 07:46 PM

Google gembira: prestasi JAX mengatasi Pytorch dan TensorFlow! Ia mungkin menjadi pilihan terpantas untuk latihan inferens GPU

Apr 01, 2024 pm 07:46 PM

Prestasi JAX, yang dipromosikan oleh Google, telah mengatasi Pytorch dan TensorFlow dalam ujian penanda aras baru-baru ini, menduduki tempat pertama dalam 7 penunjuk. Dan ujian tidak dilakukan pada TPU dengan prestasi JAX terbaik. Walaupun dalam kalangan pembangun, Pytorch masih lebih popular daripada Tensorflow. Tetapi pada masa hadapan, mungkin lebih banyak model besar akan dilatih dan dijalankan berdasarkan platform JAX. Model Baru-baru ini, pasukan Keras menanda aras tiga hujung belakang (TensorFlow, JAX, PyTorch) dengan pelaksanaan PyTorch asli dan Keras2 dengan TensorFlow. Pertama, mereka memilih satu set arus perdana

Kelajuan Internet Data Selular Perlahan pada iPhone: Pembetulan

May 03, 2024 pm 09:01 PM

Kelajuan Internet Data Selular Perlahan pada iPhone: Pembetulan

May 03, 2024 pm 09:01 PM

Menghadapi ketinggalan, sambungan data mudah alih perlahan pada iPhone? Biasanya, kekuatan internet selular pada telefon anda bergantung pada beberapa faktor seperti rantau, jenis rangkaian selular, jenis perayauan, dsb. Terdapat beberapa perkara yang boleh anda lakukan untuk mendapatkan sambungan Internet selular yang lebih pantas dan boleh dipercayai. Betulkan 1 – Paksa Mulakan Semula iPhone Kadangkala, paksa memulakan semula peranti anda hanya menetapkan semula banyak perkara, termasuk sambungan selular. Langkah 1 – Hanya tekan kekunci naikkan kelantangan sekali dan lepaskan. Seterusnya, tekan kekunci Turun Kelantangan dan lepaskannya semula. Langkah 2 - Bahagian seterusnya proses adalah untuk menahan butang di sebelah kanan. Biarkan iPhone selesai dimulakan semula. Dayakan data selular dan semak kelajuan rangkaian. Semak semula Betulkan 2 – Tukar mod data Walaupun 5G menawarkan kelajuan rangkaian yang lebih baik, ia berfungsi lebih baik apabila isyarat lemah

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas secara rasmi memasuki era robot elektrik! Semalam, Atlas hidraulik hanya "menangis" menarik diri daripada peringkat sejarah Hari ini, Boston Dynamics mengumumkan bahawa Atlas elektrik sedang berfungsi. Nampaknya dalam bidang robot humanoid komersial, Boston Dynamics berazam untuk bersaing dengan Tesla. Selepas video baharu itu dikeluarkan, ia telah pun ditonton oleh lebih sejuta orang dalam masa sepuluh jam sahaja. Orang lama pergi dan peranan baru muncul. Ini adalah keperluan sejarah. Tidak dinafikan bahawa tahun ini adalah tahun letupan robot humanoid. Netizen mengulas: Kemajuan robot telah menjadikan majlis pembukaan tahun ini kelihatan seperti manusia, dan tahap kebebasan adalah jauh lebih besar daripada manusia Tetapi adakah ini benar-benar bukan filem seram? Pada permulaan video, Atlas berbaring dengan tenang di atas tanah, seolah-olah terlentang. Apa yang berikut adalah rahang-jatuh

Daya hidup kecerdasan super membangkitkan! Tetapi dengan kedatangan AI yang mengemas kini sendiri, ibu tidak perlu lagi bimbang tentang kesesakan data

Apr 29, 2024 pm 06:55 PM

Daya hidup kecerdasan super membangkitkan! Tetapi dengan kedatangan AI yang mengemas kini sendiri, ibu tidak perlu lagi bimbang tentang kesesakan data

Apr 29, 2024 pm 06:55 PM

Saya menangis hingga mati. Dunia sedang membina model besar. Data di Internet tidak mencukupi. Model latihan kelihatan seperti "The Hunger Games", dan penyelidik AI di seluruh dunia bimbang tentang cara memberi makan data ini kepada pemakan yang rakus. Masalah ini amat ketara dalam tugas berbilang modal. Pada masa mereka mengalami kerugian, pasukan pemula dari Jabatan Universiti Renmin China menggunakan model baharu mereka sendiri untuk menjadi yang pertama di China untuk menjadikan "suapan data yang dijana model itu sendiri" menjadi kenyataan. Selain itu, ia merupakan pendekatan serampang dua mata dari segi pemahaman dan sisi penjanaan Kedua-dua pihak boleh menjana data baharu berbilang modal yang berkualiti tinggi dan memberikan maklum balas data kepada model itu sendiri. Apakah model? Awaker 1.0, model berbilang modal besar yang baru sahaja muncul di Forum Zhongguancun. Siapa pasukan itu? Enjin Sophon. Diasaskan oleh Gao Yizhao, pelajar kedoktoran di Sekolah Kecerdasan Buatan Hillhouse Universiti Renmin.

Robot Tesla bekerja di kilang, Musk: Tahap kebebasan tangan akan mencapai 22 tahun ini!

May 06, 2024 pm 04:13 PM

Robot Tesla bekerja di kilang, Musk: Tahap kebebasan tangan akan mencapai 22 tahun ini!

May 06, 2024 pm 04:13 PM

Video terbaru robot Tesla Optimus dikeluarkan, dan ia sudah boleh berfungsi di kilang. Pada kelajuan biasa, ia mengisih bateri (bateri 4680 Tesla) seperti ini: Pegawai itu juga mengeluarkan rupanya pada kelajuan 20x - pada "stesen kerja" kecil, memilih dan memilih dan memilih: Kali ini ia dikeluarkan Salah satu sorotan video itu ialah Optimus menyelesaikan kerja ini di kilang, sepenuhnya secara autonomi, tanpa campur tangan manusia sepanjang proses. Dan dari perspektif Optimus, ia juga boleh mengambil dan meletakkan bateri yang bengkok, memfokuskan pada pembetulan ralat automatik: Berkenaan tangan Optimus, saintis NVIDIA Jim Fan memberikan penilaian yang tinggi: Tangan Optimus adalah robot lima jari di dunia paling cerdik. Tangannya bukan sahaja boleh disentuh

Versi Kuaishou Sora 'Ke Ling' dibuka untuk ujian: menghasilkan video lebih 120-an, memahami fizik dengan lebih baik dan boleh memodelkan pergerakan kompleks dengan tepat

Jun 11, 2024 am 09:51 AM

Versi Kuaishou Sora 'Ke Ling' dibuka untuk ujian: menghasilkan video lebih 120-an, memahami fizik dengan lebih baik dan boleh memodelkan pergerakan kompleks dengan tepat

Jun 11, 2024 am 09:51 AM

Apa? Adakah Zootopia dibawa menjadi realiti oleh AI domestik? Didedahkan bersama-sama dengan video itu ialah model penjanaan video domestik berskala besar baharu yang dipanggil "Keling". Sora menggunakan laluan teknikal yang serupa dan menggabungkan beberapa inovasi teknologi yang dibangunkan sendiri untuk menghasilkan video yang bukan sahaja mempunyai pergerakan yang besar dan munasabah, tetapi juga mensimulasikan ciri-ciri dunia fizikal dan mempunyai keupayaan gabungan konsep dan imaginasi yang kuat. Mengikut data, Keling menyokong penjanaan video ultra panjang sehingga 2 minit pada 30fps, dengan resolusi sehingga 1080p dan menyokong berbilang nisbah aspek. Satu lagi perkara penting ialah Keling bukanlah demo atau demonstrasi hasil video yang dikeluarkan oleh makmal, tetapi aplikasi peringkat produk yang dilancarkan oleh Kuaishou, pemain terkemuka dalam bidang video pendek. Selain itu, tumpuan utama adalah untuk menjadi pragmatik, bukan untuk menulis cek kosong, dan pergi ke dalam talian sebaik sahaja ia dikeluarkan Model besar Ke Ling telah pun dikeluarkan di Kuaiying.