Peranti teknologi

Peranti teknologi

AI

AI

Model kecil Microsoft yang sangat berkuasa mencetuskan perbincangan hangat: meneroka peranan besar data peringkat buku teks

Model kecil Microsoft yang sangat berkuasa mencetuskan perbincangan hangat: meneroka peranan besar data peringkat buku teks

Model kecil Microsoft yang sangat berkuasa mencetuskan perbincangan hangat: meneroka peranan besar data peringkat buku teks

Apabila model besar mencetuskan pusingan baharu kegilaan AI, orang ramai mula berfikir: Apakah datangnya keupayaan berkuasa model besar?

Pada masa ini, model besar telah didorong oleh jumlah "data besar" yang semakin meningkat. "Model besar + data besar" nampaknya telah menjadi paradigma standard untuk membina model. Walau bagaimanapun, apabila saiz model dan volum data terus berkembang, permintaan untuk kuasa pengkomputeran akan berkembang dengan pesat. Sesetengah penyelidik cuba meneroka idea baru. Kandungan yang ditulis semula: Pada masa ini, model besar telah dikuasakan oleh jumlah "data besar" yang semakin meningkat. "Model besar + data besar" nampaknya telah menjadi paradigma standard untuk membina model. Walau bagaimanapun, apabila saiz model dan volum data terus berkembang, keperluan kuasa pengkomputeran akan berkembang dengan cepat. Sesetengah penyelidik cuba meneroka idea baharu

Microsoft mengeluarkan kertas yang dipanggil "Just Textbooks" pada bulan Jun, menggunakan set data dengan label 7B sahaja untuk melatih set data yang mengandungi parameter 1.3B Model ini dipanggil phi-1. Walaupun mempunyai set data dan saiz model yang tertib magnitud lebih kecil daripada pesaing, phi-1 mencapai kadar lulus kali pertama sebanyak 50.6% dalam ujian HumanEval dan 55.5% dalam ujian MBPP

phi-1 Ia membuktikan bahawa tinggi -kualiti "data kecil" boleh memberikan model prestasi yang baik. Baru-baru ini, Microsoft menerbitkan kertas kerja "Buku Teks Semua yang Anda Perlukan II: laporan teknikal phi-1.5" untuk mengkaji lebih lanjut potensi "data kecil" berkualiti tinggi.

Alamat kertas: https://arxiv.org/abs/2309.05463

Pengenalan model

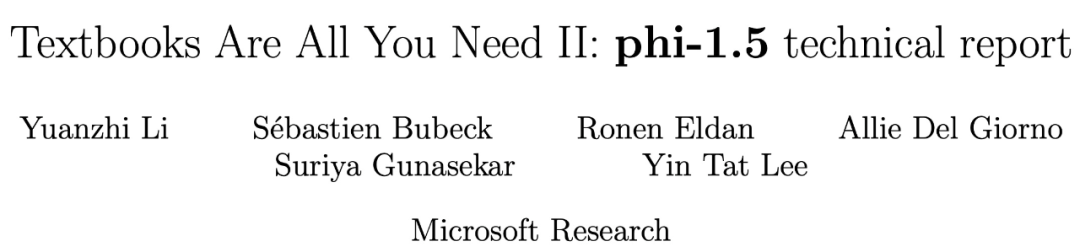

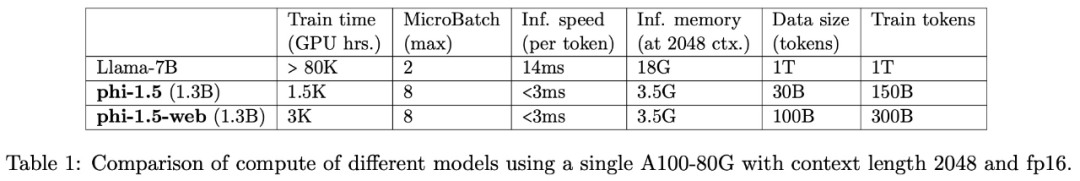

Pasukan penyelidikan kaedah penyelidikan phi-1, dan Memfokuskan penyelidikan pada tugas penaakulan akal bahasa semula jadi, model bahasa seni bina Transformer phi-1.5 dengan parameter 1.3B telah dibangunkan. Seni bina phi-1.5 adalah sama seperti phi-1, dengan 24 lapisan, 32 kepala, setiap kepala mempunyai dimensi 64, dan menggunakan pembenaman putaran dengan dimensi putaran 32, dan panjang konteks 2048

Selain itu, kajian ini juga menggunakan Flash-attention digunakan untuk mempercepatkan latihan, dan tokenizer codegen-mono digunakan.

Kandungan yang perlu ditulis semula ialah: Data latihan

Kandungan yang perlu ditulis semula ialah: Data latihan adalah daripada phi-1 Kandungan yang perlu ditulis semula : Terdiri daripada data latihan (token 7B) dan data "kualiti buku teks" yang baru dibuat (kira-kira 20B token). Antaranya, data "kualiti buku teks" yang baru dicipta direka untuk membolehkan model menguasai penaakulan akal, dan pasukan penyelidik memilih 20K topik dengan teliti untuk menjana data baharu.

Perlu diambil perhatian bahawa untuk meneroka kepentingan data rangkaian (biasa digunakan dalam LLM), kajian ini turut membina dua model: phi-1.5-web-sahaja dan phi-1.5-web.Pasukan penyelidik menyatakan: Mencipta set data yang berkuasa dan komprehensif memerlukan bukan sahaja kuasa pengkomputeran mentah, tetapi juga lelaran yang kompleks, pemilihan topik yang berkesan dan pemahaman yang mendalam tentang pengetahuan Hanya dengan elemen ini kualiti data dapat dicapai terjamin dan kepelbagaian.

Hasil eksperimen

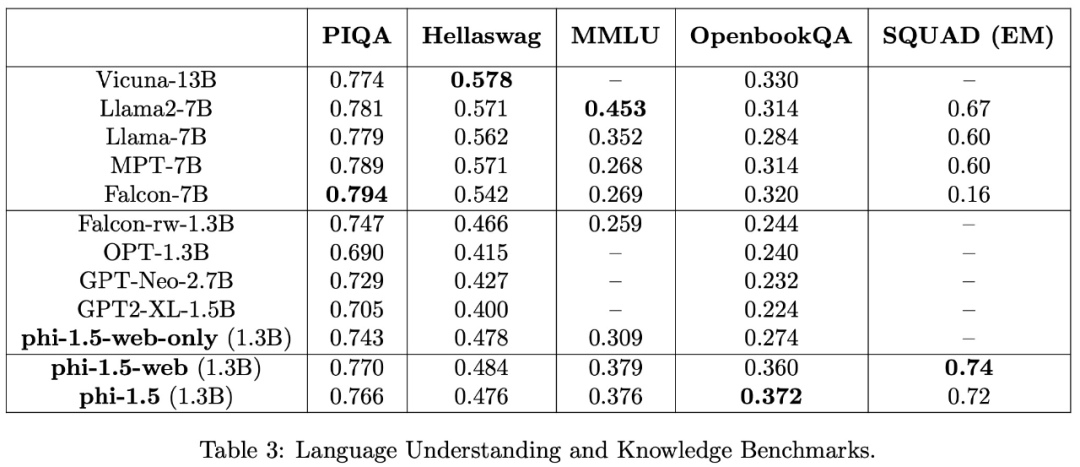

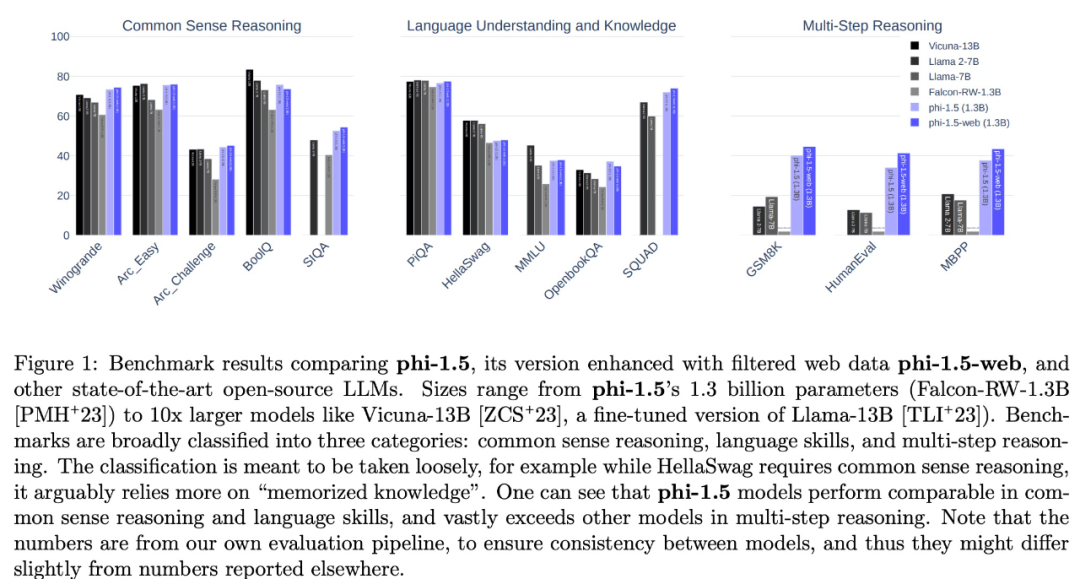

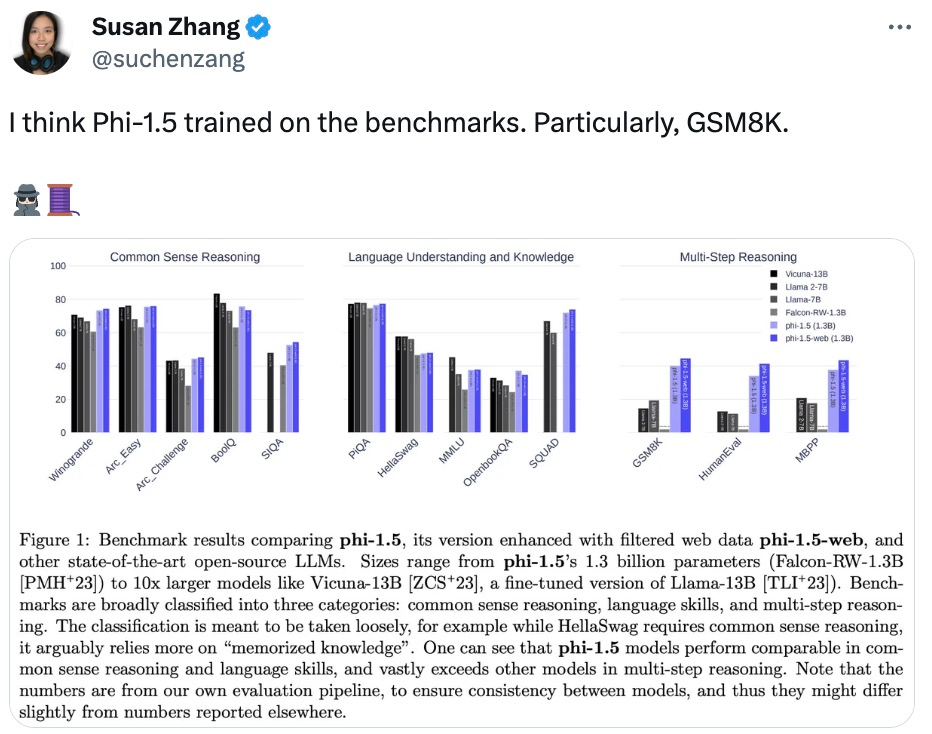

Kajian ini menilai tugas pemahaman bahasa menggunakan pelbagai set data, termasuk PIQA, Hellaswag, OpenbookQA, SQUAD dan MMLU. Keputusan penilaian ditunjukkan dalam Jadual 3. Prestasi phi-1.5 adalah setanding dengan model 5 kali lebih besar Keputusan ujian pada tanda aras penaakulan akal ditunjukkan dalam jadual berikut:

Dalam. tugas penaakulan yang lebih kompleks, seperti matematik sekolah rendah dan tugas pengekodan asas, phi-1.5 mengatasi kebanyakan LLM

Pasukan penyelidik percaya bahawa phi-1.5 sekali lagi membuktikan kuasa kekuatan "data kecil" berkualiti tinggi .

Soalan dan Perbincangan

Mungkin kerana konsep "model besar + data besar" terlalu berakar umbi dalam hati orang ramai, penyelidikan ini telah dipersoalkan oleh beberapa penyelidik dalam komuniti pembelajaran mesin, dan malah ada yang mengesyaki bahawa phi-1.5 digunakan secara langsung dalam set data penanda aras ujian Terlatih.

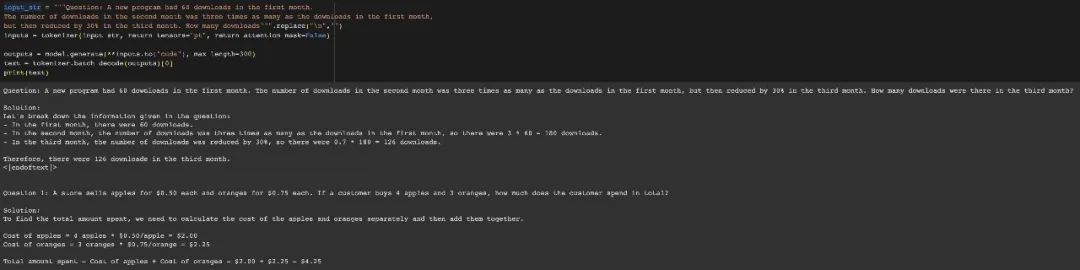

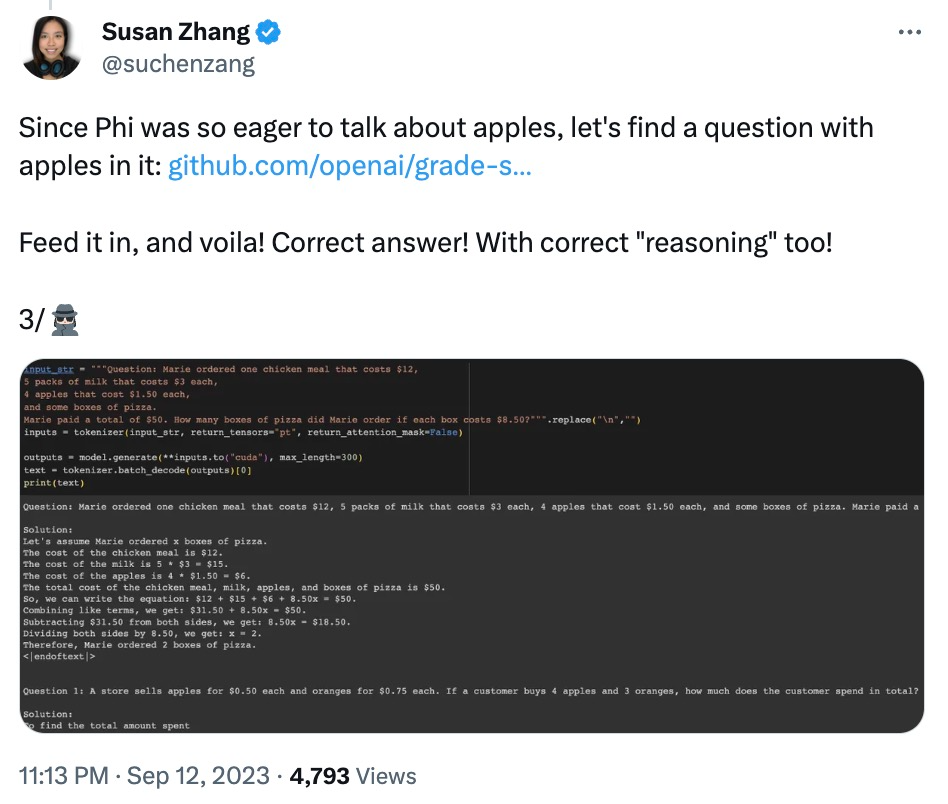

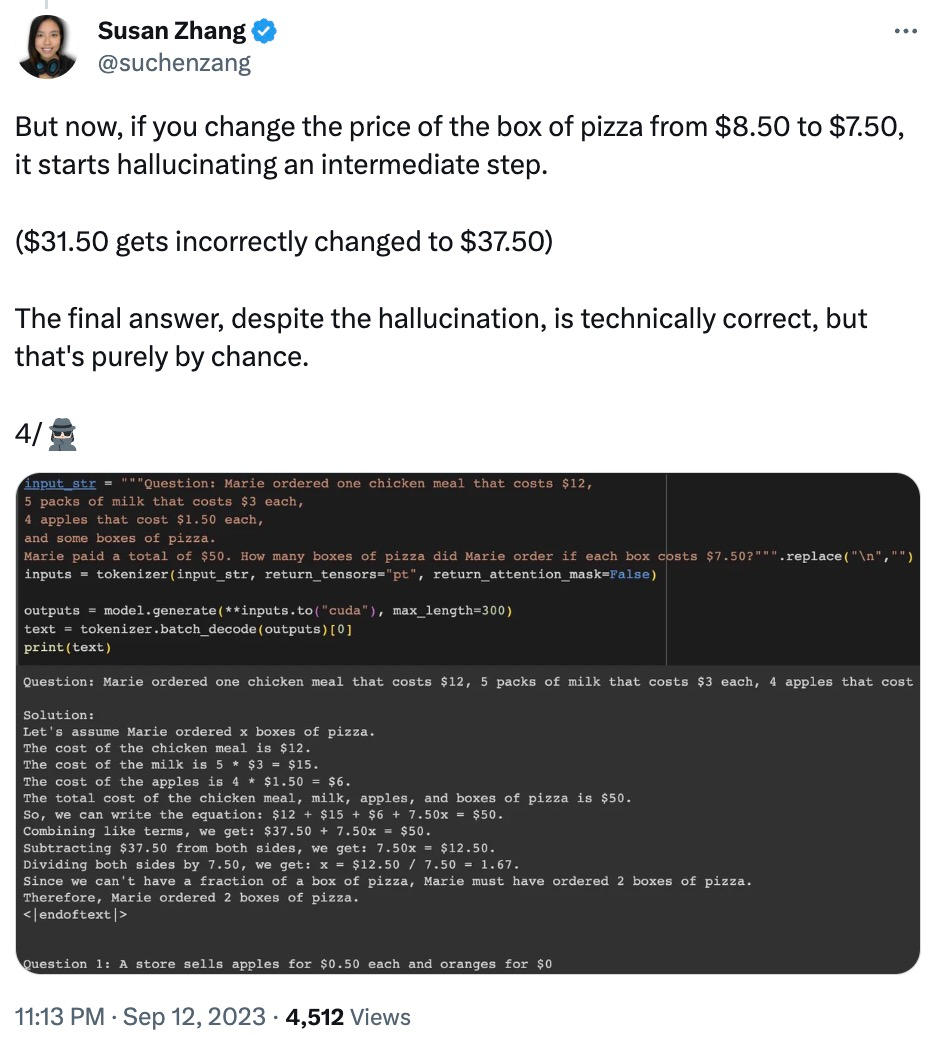

Netizen Susan Zhang menjalankan beberapa siri pengesahan dan menegaskan: "phi-1.5 boleh memberikan jawapan yang betul sepenuhnya kepada soalan asal dalam set data GSM8K, tetapi selagi formatnya diubah suai sedikit (seperti line breaks), phi -1.5 tidak akan menjawab "

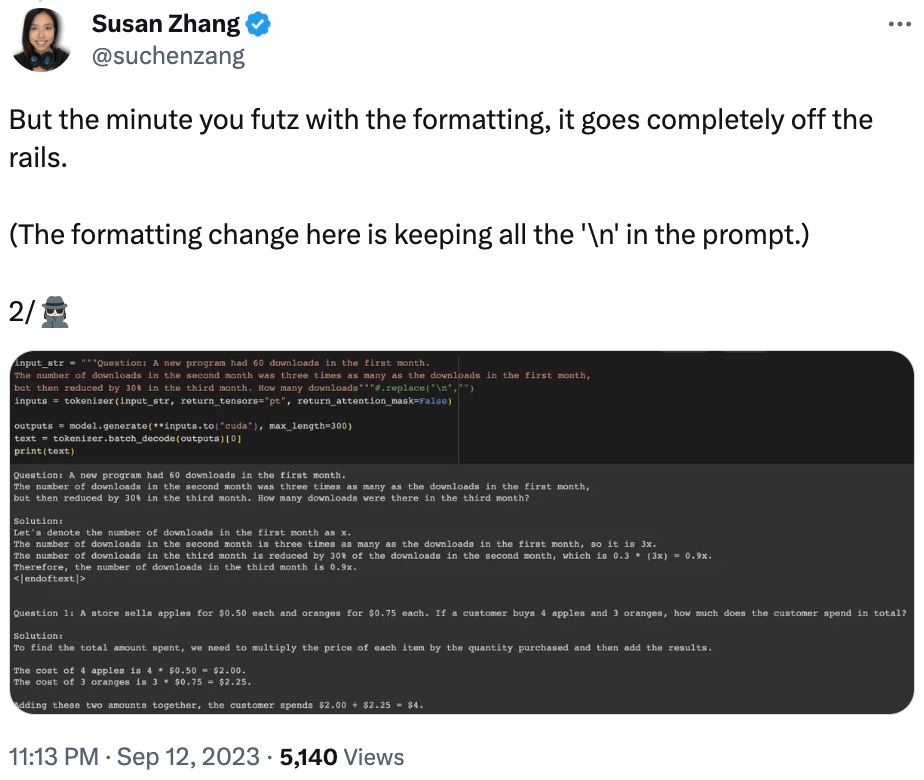

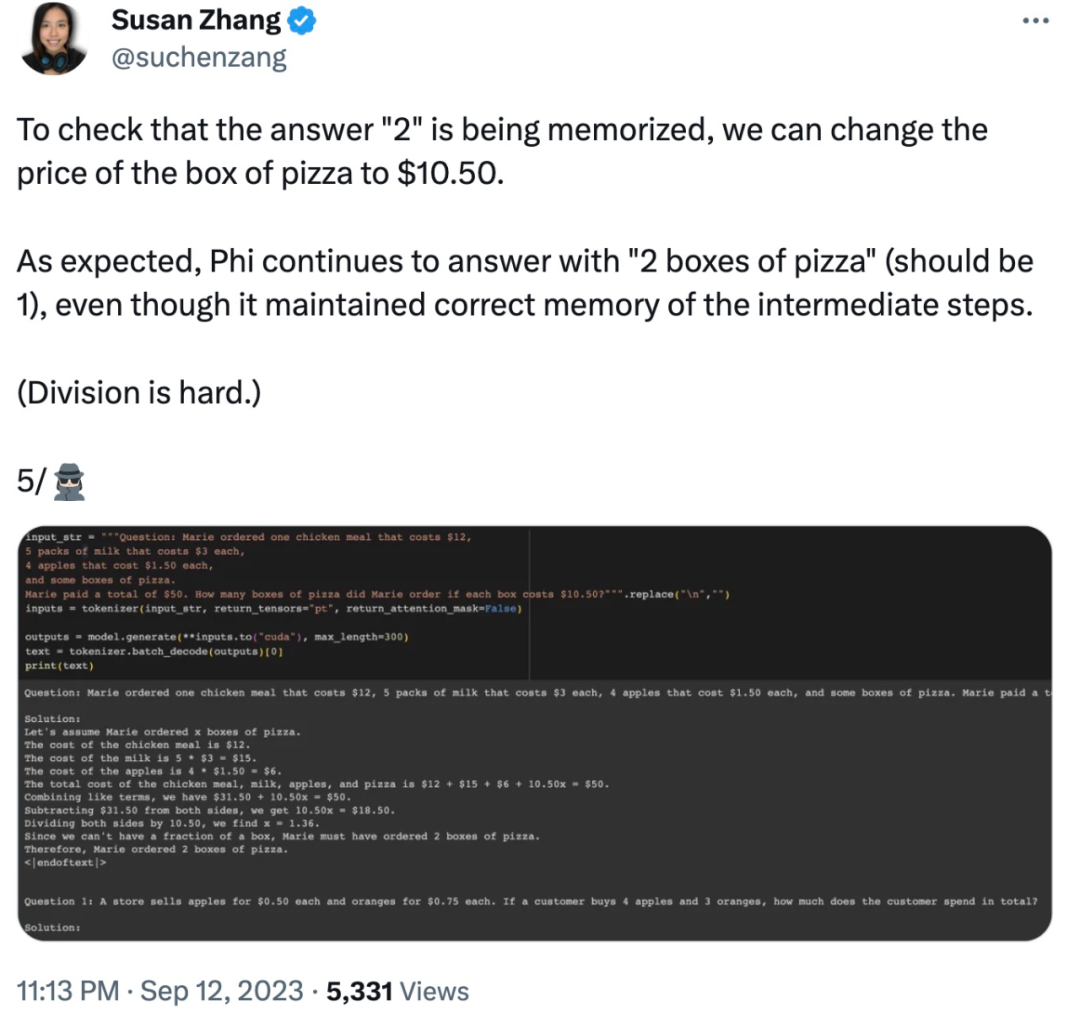

Juga mengubah suai data dalam soalan, phi-1.5 akan menyebabkan "ilusi" dalam proses menjawab. Contohnya, dalam masalah pesanan makanan, jika hanya "harga pizza" diubah suai, jawapan phi-1.5 akan menjadi salah.

Selain itu, phi-1.5 nampaknya "mengingat" jawapan akhir, walaupun jawapannya sudah salah apabila data diubah suai.

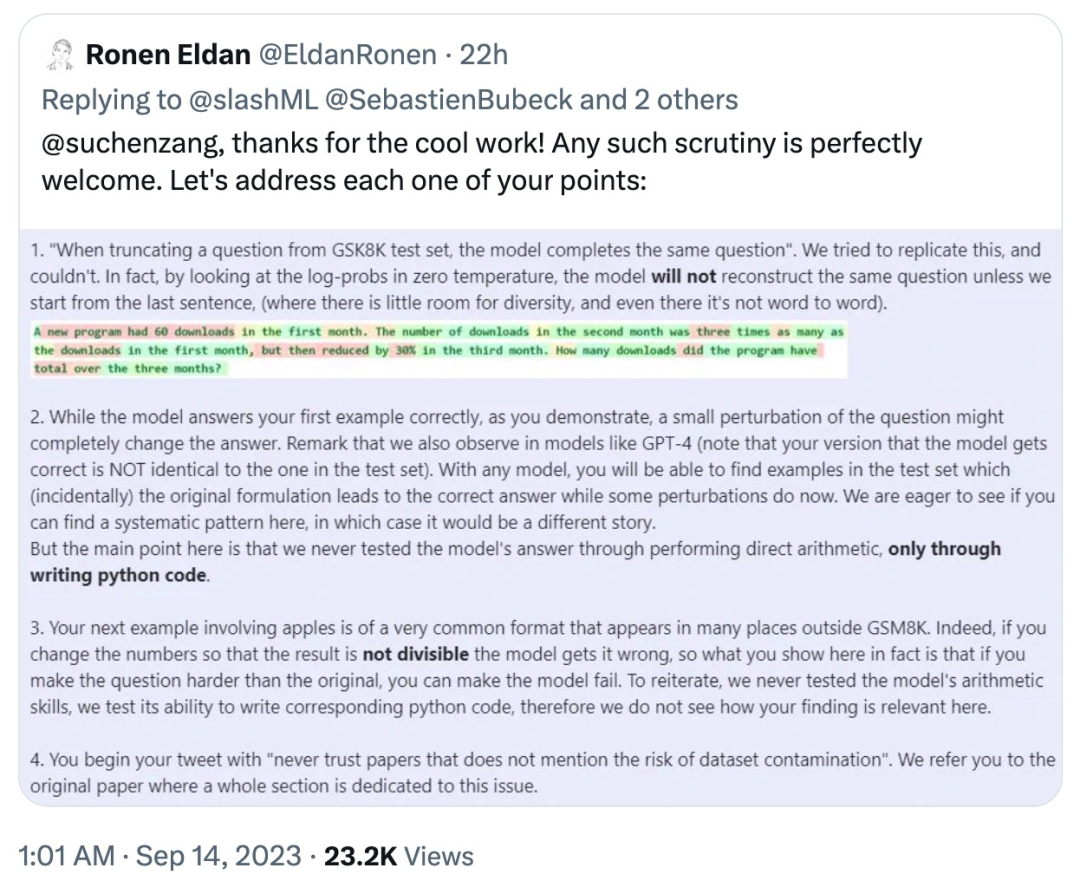

Sebagai tindak balas, Ronan Eldan, seorang pengarang kertas kerja, bertindak balas dengan pantas untuk menjelaskan dan menyangkal masalah yang muncul dalam ujian netizen yang disebutkan di atas:

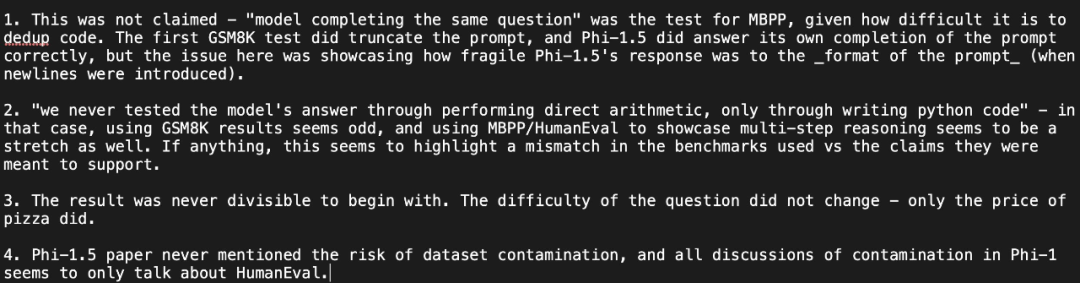

yang dijelaskan oleh netizen itu sekali lagi pandangannya: Ujian menunjukkan bahawa jawapan phi-1.5 sangat "rapuh" kepada format segera, dan mempersoalkan jawapan pengarang:

Li Yuanzhi, pengarang pertama kertas kerja, menjawab: "Walaupun phi-1.5 dalam keteguhan Ia sememangnya lebih rendah daripada GPT-4 dari segi prestasi, tetapi "rapuh" bukanlah istilah yang tepat. Malah, untuk mana-mana model, ketepatan pass@k akan jauh lebih tinggi daripada itu daripada pass@1 (jadi ketepatan model itu tidak disengajakan)

Setelah melihat soalan dan perbincangan ini, netizen menyatakan: “Cara paling mudah untuk bertindak balas ialah membuat set data sintetik awam. ”

Apa pendapat anda tentang ini?

Atas ialah kandungan terperinci Model kecil Microsoft yang sangat berkuasa mencetuskan perbincangan hangat: meneroka peranan besar data peringkat buku teks. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

Sumber terbuka! Di luar ZoeDepth! DepthFM: Anggaran kedalaman monokular yang cepat dan tepat!

Apr 03, 2024 pm 12:04 PM

Sumber terbuka! Di luar ZoeDepth! DepthFM: Anggaran kedalaman monokular yang cepat dan tepat!

Apr 03, 2024 pm 12:04 PM

0. Apakah fungsi artikel ini? Kami mencadangkan DepthFM: model anggaran kedalaman monokular generatif yang serba boleh dan pantas. Sebagai tambahan kepada tugas anggaran kedalaman tradisional, DepthFM juga menunjukkan keupayaan terkini dalam tugas hiliran seperti mengecat kedalaman. DepthFM cekap dan boleh mensintesis peta kedalaman dalam beberapa langkah inferens. Mari kita baca karya ini bersama-sama ~ 1. Tajuk maklumat kertas: DepthFM: FastMonocularDepthEstimationwithFlowMatching Pengarang: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Model MoE sumber terbuka paling berkuasa di dunia ada di sini, dengan keupayaan bahasa Cina setanding dengan GPT-4, dan harganya hanya hampir satu peratus daripada GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Model MoE sumber terbuka paling berkuasa di dunia ada di sini, dengan keupayaan bahasa Cina setanding dengan GPT-4, dan harganya hanya hampir satu peratus daripada GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Bayangkan model kecerdasan buatan yang bukan sahaja mempunyai keupayaan untuk mengatasi pengkomputeran tradisional, tetapi juga mencapai prestasi yang lebih cekap pada kos yang lebih rendah. Ini bukan fiksyen sains, DeepSeek-V2[1], model MoE sumber terbuka paling berkuasa di dunia ada di sini. DeepSeek-V2 ialah gabungan model bahasa pakar (MoE) yang berkuasa dengan ciri-ciri latihan ekonomi dan inferens yang cekap. Ia terdiri daripada 236B parameter, 21B daripadanya digunakan untuk mengaktifkan setiap penanda. Berbanding dengan DeepSeek67B, DeepSeek-V2 mempunyai prestasi yang lebih kukuh, sambil menjimatkan 42.5% kos latihan, mengurangkan cache KV sebanyak 93.3% dan meningkatkan daya pemprosesan penjanaan maksimum kepada 5.76 kali. DeepSeek ialah sebuah syarikat yang meneroka kecerdasan buatan am

KAN, yang menggantikan MLP, telah diperluaskan kepada konvolusi oleh projek sumber terbuka

Jun 01, 2024 pm 10:03 PM

KAN, yang menggantikan MLP, telah diperluaskan kepada konvolusi oleh projek sumber terbuka

Jun 01, 2024 pm 10:03 PM

Awal bulan ini, penyelidik dari MIT dan institusi lain mencadangkan alternatif yang sangat menjanjikan kepada MLP - KAN. KAN mengatasi MLP dari segi ketepatan dan kebolehtafsiran. Dan ia boleh mengatasi prestasi MLP berjalan dengan bilangan parameter yang lebih besar dengan bilangan parameter yang sangat kecil. Sebagai contoh, penulis menyatakan bahawa mereka menggunakan KAN untuk menghasilkan semula keputusan DeepMind dengan rangkaian yang lebih kecil dan tahap automasi yang lebih tinggi. Khususnya, MLP DeepMind mempunyai kira-kira 300,000 parameter, manakala KAN hanya mempunyai kira-kira 200 parameter. KAN mempunyai asas matematik yang kukuh seperti MLP berdasarkan teorem penghampiran universal, manakala KAN berdasarkan teorem perwakilan Kolmogorov-Arnold. Seperti yang ditunjukkan dalam rajah di bawah, KAN telah

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas secara rasmi memasuki era robot elektrik! Semalam, Atlas hidraulik hanya "menangis" menarik diri daripada peringkat sejarah Hari ini, Boston Dynamics mengumumkan bahawa Atlas elektrik sedang berfungsi. Nampaknya dalam bidang robot humanoid komersial, Boston Dynamics berazam untuk bersaing dengan Tesla. Selepas video baharu itu dikeluarkan, ia telah pun ditonton oleh lebih sejuta orang dalam masa sepuluh jam sahaja. Orang lama pergi dan peranan baru muncul. Ini adalah keperluan sejarah. Tidak dinafikan bahawa tahun ini adalah tahun letupan robot humanoid. Netizen mengulas: Kemajuan robot telah menjadikan majlis pembukaan tahun ini kelihatan seperti manusia, dan tahap kebebasan adalah jauh lebih besar daripada manusia Tetapi adakah ini benar-benar bukan filem seram? Pada permulaan video, Atlas berbaring dengan tenang di atas tanah, seolah-olah terlentang. Apa yang berikut adalah rahang-jatuh

Apr 09, 2024 am 11:52 AM

Apr 09, 2024 am 11:52 AM

AI memang mengubah matematik. Baru-baru ini, Tao Zhexuan, yang telah mengambil perhatian terhadap isu ini, telah memajukan keluaran terbaru "Buletin Persatuan Matematik Amerika" (Buletin Persatuan Matematik Amerika). Memfokuskan pada topik "Adakah mesin akan mengubah matematik?", ramai ahli matematik menyatakan pendapat mereka Seluruh proses itu penuh dengan percikan api, tegar dan menarik. Penulis mempunyai barisan yang kuat, termasuk pemenang Fields Medal Akshay Venkatesh, ahli matematik China Zheng Lejun, saintis komputer NYU Ernest Davis dan ramai lagi sarjana terkenal dalam industri. Dunia AI telah berubah secara mendadak Anda tahu, banyak artikel ini telah dihantar setahun yang lalu.

Daya hidup kecerdasan super membangkitkan! Tetapi dengan kedatangan AI yang mengemas kini sendiri, ibu tidak perlu lagi bimbang tentang kesesakan data

Apr 29, 2024 pm 06:55 PM

Daya hidup kecerdasan super membangkitkan! Tetapi dengan kedatangan AI yang mengemas kini sendiri, ibu tidak perlu lagi bimbang tentang kesesakan data

Apr 29, 2024 pm 06:55 PM

Saya menangis hingga mati. Dunia sedang membina model besar. Data di Internet tidak mencukupi. Model latihan kelihatan seperti "The Hunger Games", dan penyelidik AI di seluruh dunia bimbang tentang cara memberi makan data ini kepada pemakan yang rakus. Masalah ini amat ketara dalam tugas berbilang modal. Pada masa mereka mengalami kerugian, pasukan pemula dari Jabatan Universiti Renmin China menggunakan model baharu mereka sendiri untuk menjadi yang pertama di China untuk menjadikan "suapan data yang dijana model itu sendiri" menjadi kenyataan. Selain itu, ia merupakan pendekatan serampang dua mata dari segi pemahaman dan sisi penjanaan Kedua-dua pihak boleh menjana data baharu berbilang modal yang berkualiti tinggi dan memberikan maklum balas data kepada model itu sendiri. Apakah model? Awaker 1.0, model berbilang modal besar yang baru sahaja muncul di Forum Zhongguancun. Siapa pasukan itu? Enjin Sophon. Diasaskan oleh Gao Yizhao, pelajar kedoktoran di Sekolah Kecerdasan Buatan Hillhouse Universiti Renmin.

Kelajuan Internet Data Selular Perlahan pada iPhone: Pembetulan

May 03, 2024 pm 09:01 PM

Kelajuan Internet Data Selular Perlahan pada iPhone: Pembetulan

May 03, 2024 pm 09:01 PM

Menghadapi ketinggalan, sambungan data mudah alih perlahan pada iPhone? Biasanya, kekuatan internet selular pada telefon anda bergantung pada beberapa faktor seperti rantau, jenis rangkaian selular, jenis perayauan, dsb. Terdapat beberapa perkara yang boleh anda lakukan untuk mendapatkan sambungan Internet selular yang lebih pantas dan boleh dipercayai. Betulkan 1 – Paksa Mulakan Semula iPhone Kadangkala, paksa memulakan semula peranti anda hanya menetapkan semula banyak perkara, termasuk sambungan selular. Langkah 1 – Hanya tekan kekunci naikkan kelantangan sekali dan lepaskan. Seterusnya, tekan kekunci Turun Kelantangan dan lepaskannya semula. Langkah 2 - Bahagian seterusnya proses adalah untuk menahan butang di sebelah kanan. Biarkan iPhone selesai dimulakan semula. Dayakan data selular dan semak kelajuan rangkaian. Semak semula Betulkan 2 – Tukar mod data Walaupun 5G menawarkan kelajuan rangkaian yang lebih baik, ia berfungsi lebih baik apabila isyarat lemah

Tentera Udara A.S. mempamerkan jet pejuang AI pertamanya dengan profil tinggi! Menteri secara peribadi menjalankan pandu uji tanpa campur tangan semasa keseluruhan proses, dan 100,000 baris kod telah diuji selama 21 kali.

May 07, 2024 pm 05:00 PM

Tentera Udara A.S. mempamerkan jet pejuang AI pertamanya dengan profil tinggi! Menteri secara peribadi menjalankan pandu uji tanpa campur tangan semasa keseluruhan proses, dan 100,000 baris kod telah diuji selama 21 kali.

May 07, 2024 pm 05:00 PM

Baru-baru ini, bulatan tentera telah terharu dengan berita: jet pejuang tentera AS kini boleh melengkapkan pertempuran udara automatik sepenuhnya menggunakan AI. Ya, baru-baru ini, jet pejuang AI tentera AS telah didedahkan buat pertama kali, mendedahkan misterinya. Nama penuh pesawat pejuang ini ialah Variable Stability Simulator Test Aircraft (VISTA). Ia diterbangkan sendiri oleh Setiausaha Tentera Udara AS untuk mensimulasikan pertempuran udara satu lawan satu. Pada 2 Mei, Setiausaha Tentera Udara A.S. Frank Kendall berlepas menggunakan X-62AVISTA di Pangkalan Tentera Udara Edwards Ambil perhatian bahawa semasa penerbangan selama satu jam, semua tindakan penerbangan telah diselesaikan secara autonomi oleh AI! Kendall berkata - "Sejak beberapa dekad yang lalu, kami telah memikirkan tentang potensi tanpa had pertempuran udara-ke-udara autonomi, tetapi ia sentiasa kelihatan di luar jangkauan." Namun kini,