Teknologi ringkasan automatik telah mencapai kemajuan besar dalam beberapa tahun kebelakangan ini, terutamanya disebabkan oleh anjakan paradigma - daripada penalaan halus diselia pada set data berlabel kepada menggunakan model bahasa besar (LLM) untuk petunjuk sifar tangkapan, seperti GPT- 4. Gesaan yang direka dengan teliti membolehkan kawalan halus ke atas panjang ringkasan, topik, gaya dan ciri lain tanpa latihan tambahan

Tetapi satu aspek sering diabaikan: ketumpatan maklumat ringkasan. Secara teorinya, sebagai pemampatan teks lain, ringkasan harus lebih padat, iaitu, mengandungi lebih banyak maklumat, daripada fail sumber. Memandangkan kependaman tinggi penyahkodan LLM, adalah penting untuk merangkumi lebih banyak maklumat dengan lebih sedikit perkataan, terutamanya untuk aplikasi masa nyata.

Walau bagaimanapun, ketumpatan maklumat adalah soalan terbuka: jika abstrak mengandungi butiran yang tidak mencukupi, ia bersamaan dengan tiada maklumat jika ia mengandungi terlalu banyak maklumat tanpa menambah jumlah panjang, ia akan menjadi sukar untuk difahami. Untuk menyampaikan lebih banyak maklumat dalam belanjawan perbendaharaan kata tetap, adalah perlu untuk menggabungkan abstraksi, pemampatan dan gabungan

Dalam kajian baru-baru ini, penyelidik dari Salesforce, MIT dan institusi lain mencuba Had ini ditentukan oleh keutamaan untuk satu set ringkasan yang semakin padat yang dihasilkan oleh GPT-4. Kaedah ini memberikan banyak inspirasi untuk meningkatkan "kebolehan ekspresi" model bahasa besar seperti GPT-4.

Pautan kertas: https://arxiv.org/pdf/2309.04269.pdf

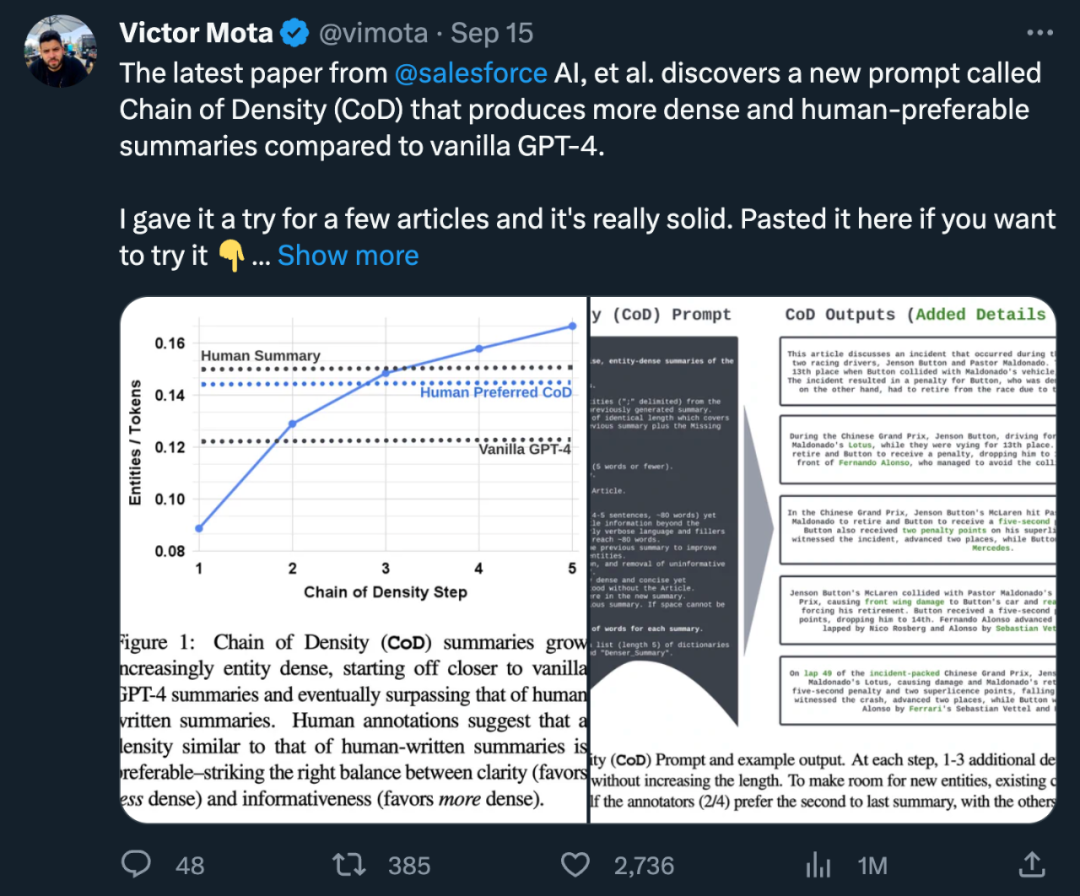

Alamat set data: https://huggingface.co/datasets/griffin/chain_of_Sysic details , pendekatan mereka menggunakan purata bilangan entiti setiap teg sebagai proksi untuk ketumpatan, menghasilkan ringkasan awal yang jarang entiti. Kemudian, tanpa meningkatkan jumlah panjang (jumlah panjang ialah 5 kali ringkasan asal), secara berulang mengenal pasti dan menggabungkan 1-3 entiti yang hilang dalam ringkasan sebelumnya, supaya nisbah entiti kepada teg dalam setiap ringkasan adalah lebih tinggi daripada ringkasan Sebelumnya. Melalui analisis data keutamaan manusia, penulis akhirnya mengenal pasti satu bentuk ringkasan yang hampir sama padat dengan ringkasan tulisan manusia dan lebih padat daripada ringkasan yang dihasilkan oleh gesaan GPT-4 biasa

Sumbangan keseluruhan kajian termasuk:

. -antara kemakluman (memihak kepada lebih banyak entiti) dan kejelasan (memihak kepada lebih sedikit entiti);Ringkasan GPT-4 sumber terbuka, anotasi dan set 5000 ringkasan CoD tanpa nota, untuk penilaian atau penyempurnaan.

Dalam Rajah 2, Prompt ditunjukkan dan contoh output. Pengarang tidak menyatakan secara eksplisit jenis entiti, tetapi mentakrifkan entiti yang hilang sebagai:

Dalam Rajah 2, Prompt ditunjukkan dan contoh output. Pengarang tidak menyatakan secara eksplisit jenis entiti, tetapi mentakrifkan entiti yang hilang sebagai:

Spesifik: deskriptif tetapi ringkas (5 perkataan atau kurang); Novel: Tidak muncul dalam abstrak sebelum ini;

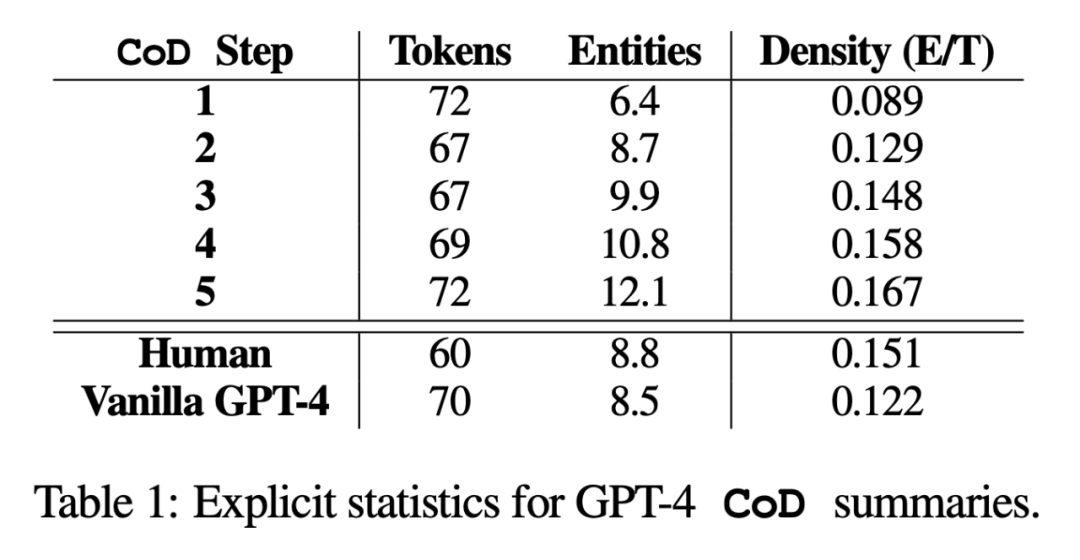

Kandungan yang ditulis semula adalah seperti berikut: Menurut statistik, dengan mengalih keluar perkataan yang tidak diperlukan dalam abstrak yang panjang, purata panjang langkah kedua telah dikurangkan sebanyak 5 token (daripada 72 kepada 67). Ketumpatan entiti awal ialah 0.089, iaitu lebih rendah daripada manusia dan vanila GPT-4 (0.151 dan 0.122), dan selepas 5 langkah ketumpatan, ia akhirnya meningkat kepada 0.167

.statistik tidak langsung

.statistik tidak langsung

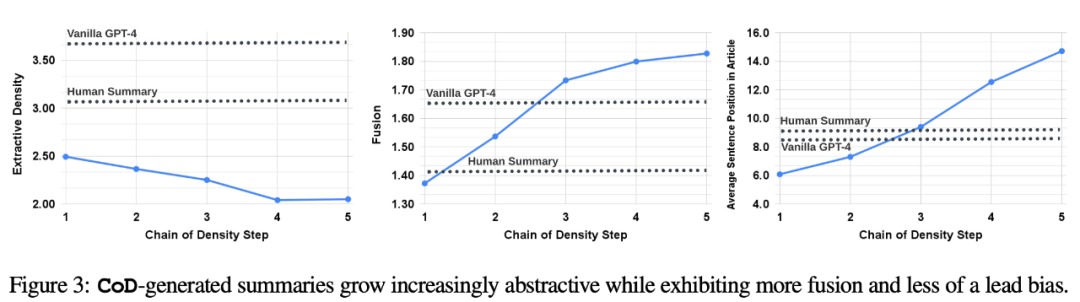

Tahap abstraksi harus meningkat dengan setiap langkah CoD, kerana abstrak berulang kali ditulis semula untuk memberi ruang kepada setiap entiti tambahan. Penulis mengukur abstraksi menggunakan ketumpatan pengekstrakan: panjang persegi purata serpihan yang diekstrak (Grusky et al., 2018). Begitu juga, gabungan konsep harus meningkat secara monoton apabila entiti ditambahkan pada ringkasan panjang tetap. Penulis menyatakan tahap integrasi dengan purata bilangan ayat sumber yang sejajar dengan setiap ayat ringkasan. Untuk penjajaran, penulis menggunakan kaedah keuntungan relatif ROUGE (Zhou et al., 2018), yang menjajarkan ayat sumber dengan ayat sasaran sehingga keuntungan ROUGE relatif ayat tambahan tidak lagi positif. Mereka juga menjangkakan pengedaran kandungan, atau kedudukan dalam artikel dari mana kandungan ringkasan datang, akan berubah.

Secara khusus, penulis meramalkan bahawa ringkasan Call of Duty (CoD) pada mulanya akan menunjukkan "berat sebelah bootstrapping" yang kuat, iaitu, lebih banyak entiti akan diperkenalkan pada permulaan artikel. Walau bagaimanapun, apabila artikel itu berkembang, bias panduan ini secara beransur-ansur menjadi lemah dan entiti mula diperkenalkan dari tengah dan akhir artikel. Untuk mengukur ini, kami menggunakan hasil penjajaran dalam gabungan dan mengukur purata pangkat ayat semua ayat sumber yang diselaraskan

Rajah 3 mengesahkan hipotesis ini: apabila langkah menulis semula meningkat, begitu juga keabstrakan Apabila ketumpatan pengekstrakan meningkat (menurunkan ketumpatan pengekstrakan di sebelah kiri), kadar gabungan meningkat (imej tengah), dan abstrak mula menggabungkan kandungan dari tengah dan akhir artikel (imej kanan). Menariknya, semua ringkasan CoD adalah lebih abstrak berbanding dengan ringkasan tulisan manusia dan ringkasan garis dasar

Untuk lebih memahami pertukaran ringkasan CoD, penulis berasaskan manusia menjalankan kajian penilaian berasaskan penarafan menggunakan GPT-4

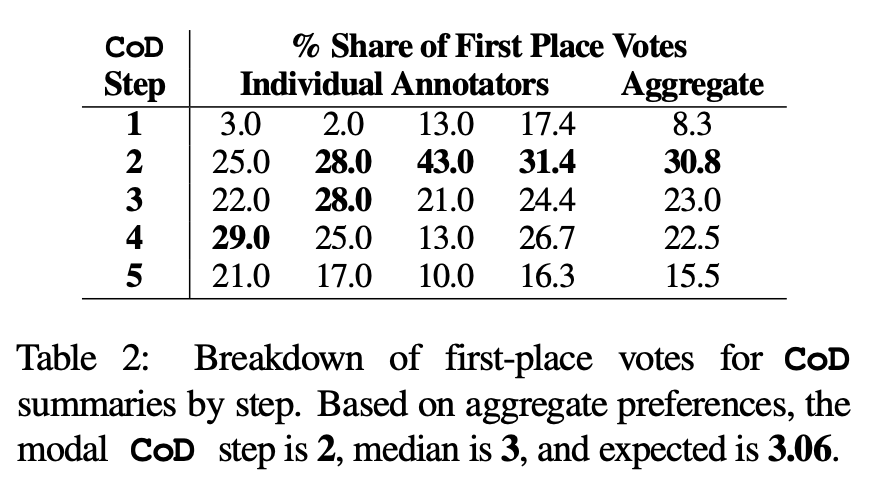

Keutamaan manusia. Khususnya, untuk 100 artikel yang sama (5 langkah *100 = 500 abstrak kesemuanya), pengarang secara rawak menunjukkan abstrak dan artikel CoD "yang dibuat semula" kepada empat pengarang pertama kertas kerja. Setiap annotator memberikan ringkasan kegemaran mereka berdasarkan definisi Stiennon et al. (2020) tentang "ringkasan yang baik." Jadual 2 melaporkan undian tempat pertama setiap annotator dalam peringkat CoD, serta ringkasan setiap annotator. Secara keseluruhannya, 61% daripada abstrak tempat pertama (23.0+22.5+15.5) melibatkan ≥3 langkah pemekatan. Nombor median langkah CoD pilihan adalah di tengah (3), dengan jangkaan nombor langkah 3.06.

Berdasarkan kepadatan purata ringkasan Langkah 3, secara kasar boleh disimpulkan bahawa kepadatan entiti pilihan semua calon CoD ialah ∼ 0.15. Seperti yang dapat dilihat dalam Jadual 1, ketumpatan ini konsisten dengan ringkasan tulisan manusia (0.151) tetapi jauh lebih tinggi daripada ringkasan yang ditulis dengan gesaan GPT-4 biasa (0.122).

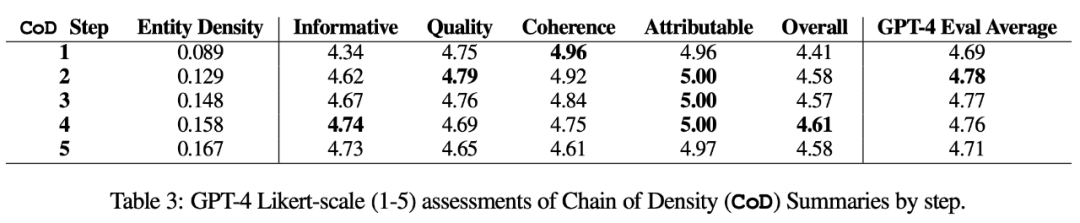

Pengukuran automatik. Sebagai tambahan kepada penilaian manusia (di bawah), pengarang menggunakan GPT-4 untuk menjaringkan ringkasan CoD (1-5 mata) sepanjang 5 dimensi: kemakluman, kualiti, koheren, kebolehatributan dan keseluruhan. Seperti yang ditunjukkan dalam Jadual 3, ketumpatan berkorelasi dengan kemakluman, tetapi sehingga had, dengan skor memuncak pada langkah 4 (4.74).

Daripada purata skor setiap dimensi, langkah pertama dan terakhir CoD mempunyai skor terendah, manakala tiga langkah tengah mempunyai skor hampir (masing-masing 4.78, 4.77 dan 4.76).

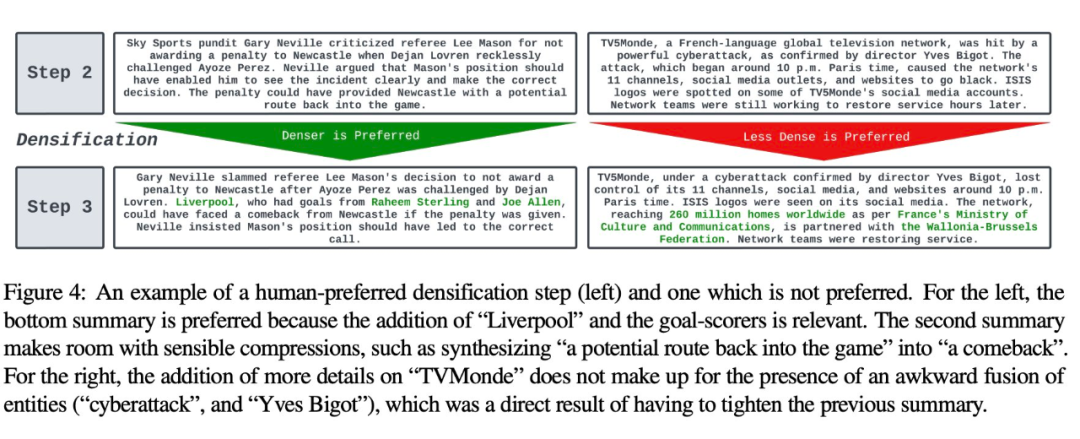

Analisis kualitatif. Terdapat pertukaran yang jelas antara koheren/kebolehbacaan dan kemakluman abstrak. Rajah 4 menunjukkan dua langkah CoD: ringkasan satu langkah dipertingkatkan dengan butiran lanjut, manakala ringkasan langkah yang satu lagi terjejas. Secara keseluruhan, ringkasan CoD perantaraan mampu mencapai keseimbangan ini, tetapi pertukaran ini masih perlu ditakrifkan dan dikuantifikasi dengan tepat dalam kerja masa hadapan

Untuk butiran lanjut tentang kertas, sila rujuk kertas asal.

Atas ialah kandungan terperinci 'Sedikit perkataan, jumlah maklumat yang banyak', Salesforce dan penyelidik MIT mengajar GPT-4 'semakan', set data telah menjadi sumber terbuka. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Bagaimana untuk mengikat data dalam senarai lungsur

Bagaimana untuk mengikat data dalam senarai lungsur

Bagaimana untuk memulihkan fail yang dikosongkan daripada Recycle Bin

Bagaimana untuk memulihkan fail yang dikosongkan daripada Recycle Bin

Apakah teras sistem pangkalan data?

Apakah teras sistem pangkalan data?

Apa yang perlu dilakukan jika penggunaan CPU terlalu tinggi

Apa yang perlu dilakukan jika penggunaan CPU terlalu tinggi

penggunaan fungsi setproperty

penggunaan fungsi setproperty

ungkapan biasa js

ungkapan biasa js

Bagaimana untuk memulihkan fail yang dipadam pada komputer

Bagaimana untuk memulihkan fail yang dipadam pada komputer

Berapakah nilai satu Bitcoin dalam RMB?

Berapakah nilai satu Bitcoin dalam RMB?