Peranti teknologi

Peranti teknologi

AI

AI

Google DeepMind: Menggabungkan model besar dengan pembelajaran pengukuhan untuk mencipta otak pintar bagi robot untuk melihat dunia

Google DeepMind: Menggabungkan model besar dengan pembelajaran pengukuhan untuk mencipta otak pintar bagi robot untuk melihat dunia

Google DeepMind: Menggabungkan model besar dengan pembelajaran pengukuhan untuk mencipta otak pintar bagi robot untuk melihat dunia

Apabila membangunkan kaedah pembelajaran robot, jika kita boleh menyepadukan set data yang besar dan pelbagai serta menggunakan model ekspresif yang berkuasa (seperti Transformer), kita boleh mengharapkan untuk membangunkan strategi yang mempunyai keupayaan generalisasi dan boleh digunakan secara meluas Robot boleh belajar mengendalikan pelbagai tugas yang berbeza dengan sangat baik. Contohnya, strategi ini membolehkan robot mengikuti arahan bahasa semula jadi, melakukan tingkah laku berbilang peringkat, menyesuaikan diri dengan pelbagai persekitaran dan matlamat, dan juga digunakan pada bentuk robot yang berbeza.

Walau bagaimanapun, model berkuasa yang baru-baru ini muncul dalam bidang pembelajaran robot semuanya dilatih menggunakan kaedah pembelajaran yang diselia. Oleh itu, prestasi strategi yang dihasilkan adalah terhad kepada sejauh mana penunjuk perasaan manusia boleh menyediakan data demonstrasi berkualiti tinggi. Terdapat dua sebab untuk sekatan ini.

- Pertama, kami mahu sistem robotik lebih mahir daripada teleoperator manusia, memanfaatkan potensi penuh perkakasan untuk menyelesaikan tugas dengan cepat, lancar dan boleh dipercayai.

- Kedua, kami berharap sistem robot akan lebih baik dalam mengumpul pengalaman secara automatik, dan bukannya bergantung sepenuhnya pada demonstrasi berkualiti tinggi.

Secara prinsipnya, pembelajaran pengukuhan dapat memberikan kedua-dua kebolehan ini pada masa yang sama.

Terdapat beberapa perkembangan yang memberangsangkan baru-baru ini, menunjukkan bahawa pembelajaran pengukuhan robot berskala besar boleh berjaya dalam pelbagai senario aplikasi, seperti keupayaan merebut dan menyusun robot, mempelajari tugas yang berbeza dengan ganjaran yang ditentukan oleh manusia, dan pembelajaran berbilang -Dasar tugasan, dasar berasaskan matlamat pembelajaran dan navigasi robot. Walau bagaimanapun, penyelidikan menunjukkan bahawa jika pembelajaran pengukuhan digunakan untuk melatih model berkuasa seperti Transformer, adalah lebih sukar untuk membuat instantiat berskala besar dengan cekap

Google DeepMind baru-baru ini mencadangkan Q-Transformer, yang bertujuan untuk mengubah model berdasarkan pelbagai real- data dunia Menggabungkan pembelajaran robot berskala besar dengan seni bina dasar moden berdasarkan Transformer yang berkuasa

- Kertas: https://q-transformer.github.io/assets/q-transformer.pdf

- Projek: https://q-transformer.github.io/

Walaupun pada dasarnya, menggunakan Transformer secara langsung untuk menggantikan seni bina sedia ada seperti ResNets atau konvolusi rangkaian yang lebih kecil) , tetapi mereka bentuk skema yang boleh menggunakan seni bina ini dengan berkesan adalah sangat sukar. Model besar hanya boleh berkesan jika mereka boleh menggunakan set data berskala besar dan pelbagai - model berskala kecil, skop sempit tidak memerlukan dan mendapat manfaat daripada keupayaan ini

Walaupun penyelidikan terdahulu telah menggunakan data simulasi untuk mencipta set data sedemikian , tetapi data yang paling representatif datang dari dunia nyata.

Oleh itu, DeepMind menyatakan bahawa fokus kajian ini adalah untuk menggunakan Transformer melalui pembelajaran tetulang luar talian dan mengintegrasikan set data besar yang dikumpul sebelum ini

Kaedah pembelajaran tetulang luar talian adalah menggunakan data sedia ada untuk latihan, dan matlamatnya. adalah untuk Menghasilkan strategi yang paling berkesan untuk set data yang diberikan. Sudah tentu, set data ini juga boleh dipertingkatkan dengan data tambahan yang dikumpul secara automatik, tetapi proses latihan diasingkan daripada proses pengumpulan data, yang menyediakan aliran kerja tambahan untuk aplikasi robotik berskala besar

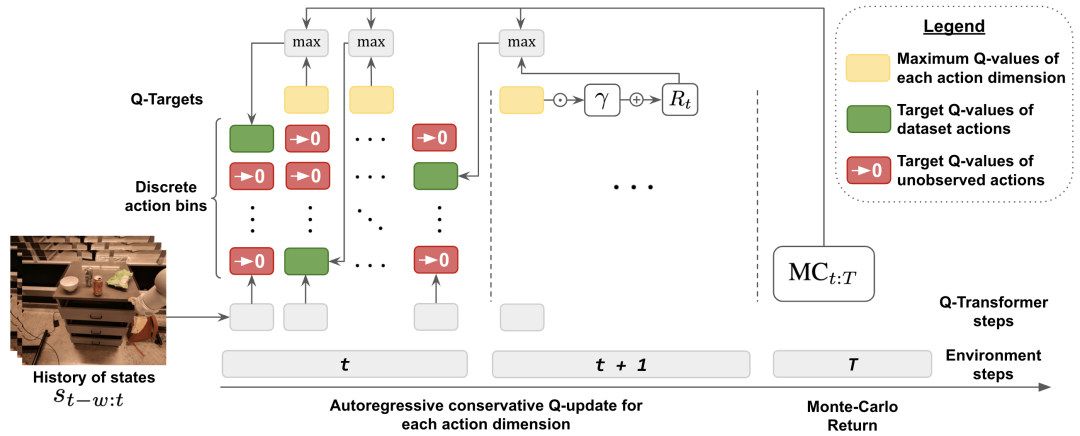

dilaksanakan menggunakan model Transformer Dalam pembelajaran pengukuhan , satu lagi masalah besar ialah mereka bentuk sistem pembelajaran pengukuhan yang boleh melatih model sedemikian dengan berkesan. Kaedah pembelajaran peneguhan luar talian yang berkesan sering melakukan anggaran fungsi Q melalui kemas kini perbezaan masa. Memandangkan Transformer memodelkan jujukan token diskret, masalah anggaran fungsi Q boleh ditukar kepada masalah pemodelan jujukan token diskret, dan fungsi kehilangan yang sesuai boleh direka bentuk untuk setiap token dalam jujukan.

Kaedah yang diguna pakai oleh DeepMind ialah skim pendiskretan mengikut dimensi Ini adalah untuk mengelakkan letupan eksponen asas tindakan. Secara khusus, setiap dimensi ruang tindakan dianggap sebagai langkah masa bebas dalam pembelajaran pengukuhan. Tong sampah yang berbeza dalam pendiskretan sepadan dengan tindakan yang berbeza. Skim pendiskretan mengikut dimensi ini membolehkan kami menggunakan kaedah pembelajaran Q tindakan diskret yang mudah dengan pengatur tetap konservatif untuk mengendalikan situasi transformasi pengedaran

DeepMind mencadangkan pengatur tetap khusus yang bertujuan untuk Meminimumkan nilai tindakan yang tidak digunakan. Kajian telah menunjukkan bahawa kaedah ini berkesan boleh mempelajari julat sempit data seperti demo, dan juga boleh mempelajari julat data yang lebih luas dengan hingar penerokaan

Akhir sekali, mereka juga menggunakan mekanisme kemas kini hibrid yang menggabungkan Monte Carlo dan regresi n-langkah dengan sandaran perbezaan temporal. Hasil kajian menunjukkan pendekatan ini dapat meningkatkan prestasi kaedah pembelajaran tetulang luar talian berasaskan Transformer terhadap masalah pembelajaran robot berskala besar.

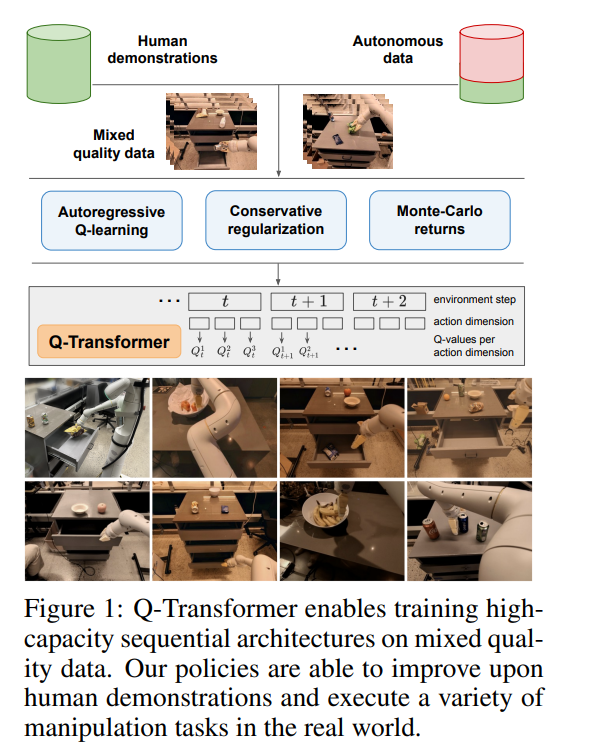

Sumbangan utama penyelidikan ini ialah Q-Transformer, iaitu kaedah pembelajaran pengukuhan luar talian robot berdasarkan seni bina Transformer. Q-Transformer menandakan nilai Q mengikut dimensi dan telah berjaya digunakan pada set data robotik berskala besar dan pelbagai, termasuk data dunia sebenar. Rajah 1 menunjukkan komponen Q-Transformer

DeepMind menjalankan penilaian eksperimen, termasuk eksperimen simulasi dan eksperimen dunia sebenar berskala besar, bertujuan untuk perbandingan yang ketat dan pengesahan praktikal. Antaranya, kami menggunakan strategi berbilang tugas berasaskan teks berskala besar untuk pembelajaran dan mengesahkan keberkesanan Q-Transformer

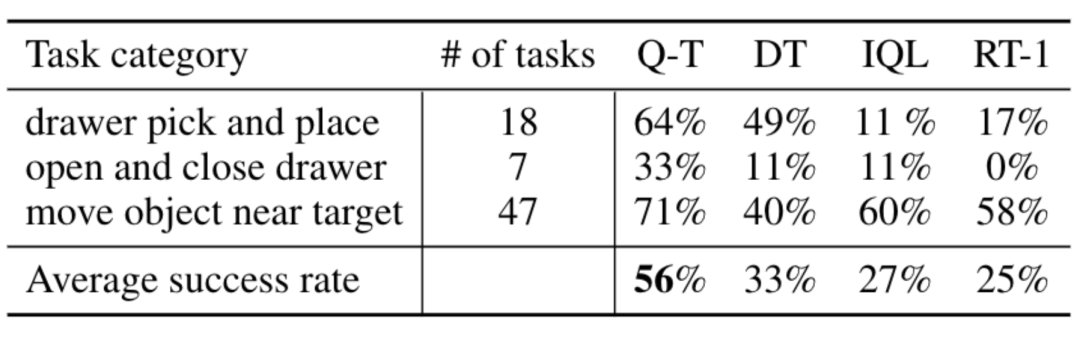

Dalam eksperimen dunia sebenar, set data yang mereka gunakan mengandungi 38,000 demonstrasi yang berjaya dan 20,000 A senario pengumpulan automatik gagal. Data telah dikumpulkan oleh 13 robot pada lebih daripada 700 tugas. Q-Transformer mengatasi prestasi seni bina yang dicadangkan sebelum ini untuk pembelajaran pengukuhan robot berskala besar, serta model berasaskan Transformer seperti Pengubah Keputusan yang dicadangkan sebelum ini.

Tinjauan keseluruhan kaedah

Untuk menggunakan Transformer untuk pembelajaran Q, pendekatan yang diambil oleh DeepMind adalah untuk mendiskrisikan dan memproses secara autoregresif ruang tindakan

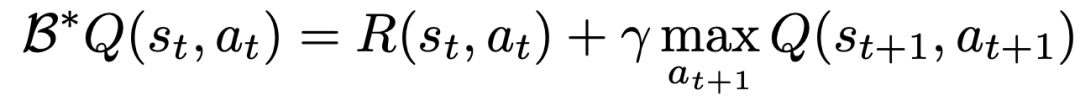

Untuk mempelajari fungsi Q menggunakan pembelajaran TD, adalah berdasarkan peraturan kemas kini Bell Mann

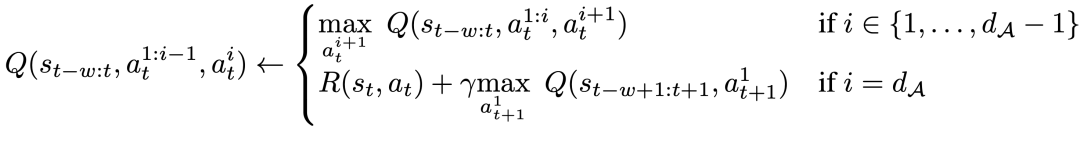

Para penyelidik mengubah suai kemas kini Bellman supaya ia boleh dilakukan untuk setiap dimensi tindakan dengan menukar MDP asal masalah kepada setiap dimensi tindakan yang dianggap sebagai Q Belajar satu langkah -demi-langkah MDP.

Khususnya, untuk dimensi tindakan tertentu d_A, peraturan kemas kini Bellman baharu boleh dinyatakan sebagai:

Ini bermakna bagi setiap dimensi tindakan perantaraan, diberikan keadaan yang sama memaksimumkan dimensi tindakan seterusnya, dan untuk dimensi tindakan terakhir, gunakan dimensi tindakan pertama bagi keadaan seterusnya. Penguraian ini memastikan bahawa pemaksimuman dalam kemas kini Bellman kekal boleh dikendalikan, di samping memastikan bahawa masalah MDP asal masih boleh diselesaikan.

Untuk mengambil kira perubahan pengedaran semasa pembelajaran luar talian, DeepMind turut memperkenalkan teknik penyelarasan mudah, yang meminimumkan nilai tindakan yang tidak kelihatan.

Untuk mempercepatkan pembelajaran, mereka juga menggunakan kaedah Monte Carlo return. Pendekatan ini bukan sahaja menggunakan return-to-go untuk episod (episod) tertentu, tetapi juga menggunakan pulangan n-step yang boleh melangkau dimensi maksimum

Keputusan eksperimen

Dalam eksperimen, DeepMind menilai Q-Transformer, meliputi pelbagai tugas dunia sebenar. Pada masa yang sama, mereka juga mengehadkan data kepada hanya 100 tunjuk cara manusia bagi setiap tugas

Dalam tunjuk cara, selain daripada tunjuk cara, mereka juga menambah coretan peristiwa kegagalan yang dikumpul secara automatik untuk mencipta set data . Set data ini mengandungi 38,000 contoh positif daripada demo dan 20,000 contoh negatif yang dikumpulkan secara automatik

Berbanding dengan kaedah asas seperti RT-1, IQL, dan Decision Transformer (DT), Q-Transformer boleh menggunakan serpihan acara automatik secara berkesan untuk meningkatkan keupayaannya menggunakan kemahiran mulai dari Pick up dan place dengan ketara. item dalam laci, gerakkan objek berhampiran sasaran, dan buka dan tutup laci.

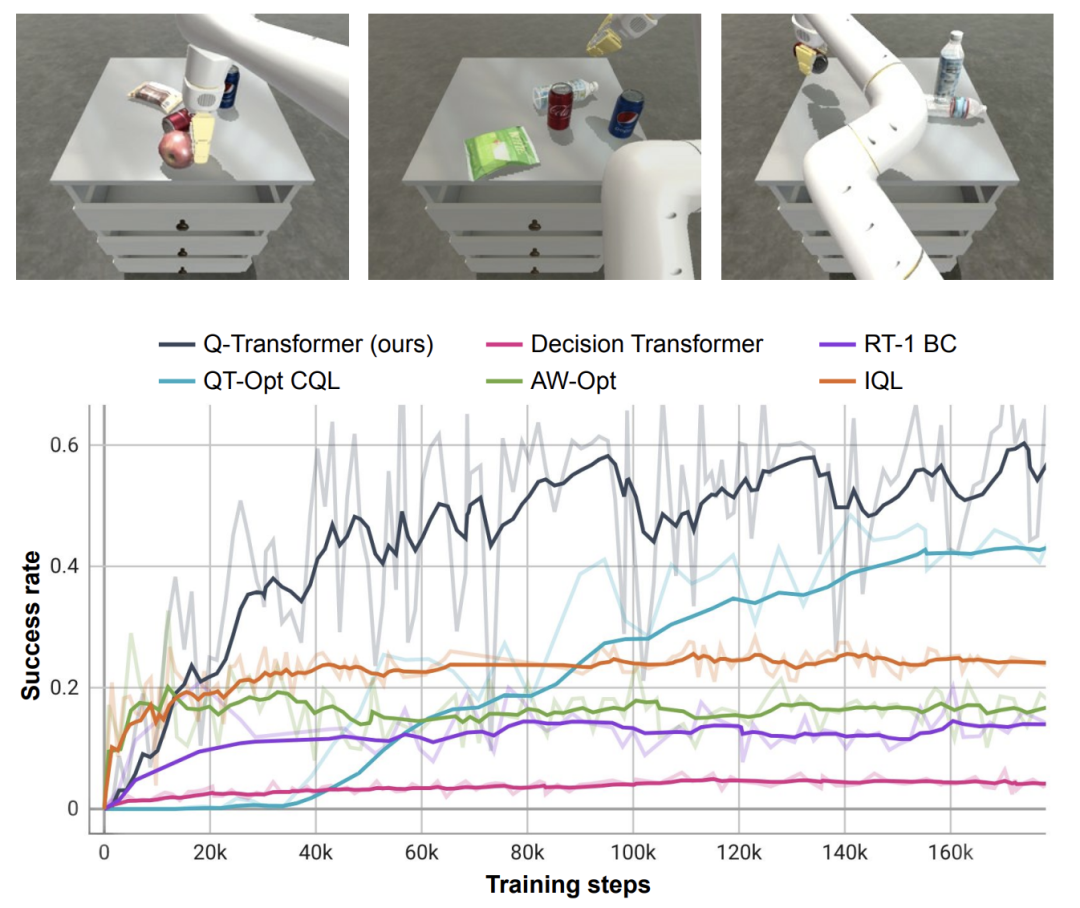

Para penyelidik juga menguji kaedah yang baru dicadangkan pada tugasan mendapatkan semula objek simulasi yang sukar - dalam tugasan ini, hanya kira-kira 8% Data adalah contoh positif, dan selebihnya adalah contoh negatif yang penuh dengan bunyi bising.

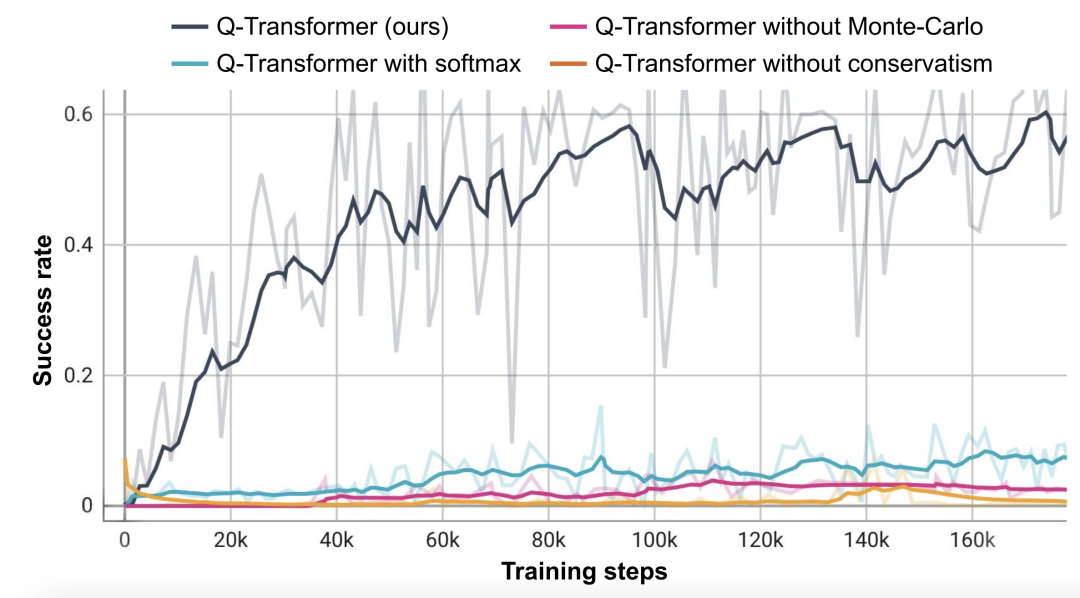

Dalam tugasan ini, kaedah Q-learning seperti QT-Opt, IQL, AW-Opt dan Q-Transformer biasanya berprestasi lebih baik kerana mereka mampu memanfaatkan pengaturcaraan dinamik. Untuk mempelajari strategi dan menggunakan contoh negatif untuk mengoptimumkan Tugasan, para penyelidik menjalankan eksperimen ablasi dan mendapati kedua-dua regularizer konservatif dan pulangan MC adalah penting untuk mengekalkan prestasi. Prestasi adalah lebih teruk jika anda beralih kepada penyelaras Softmax, kerana ini mengehadkan dasar terlalu banyak kepada pengedaran data. Ini menunjukkan bahawa regularizer yang dipilih oleh DeepMind di sini boleh mengatasi tugas ini dengan lebih baik.

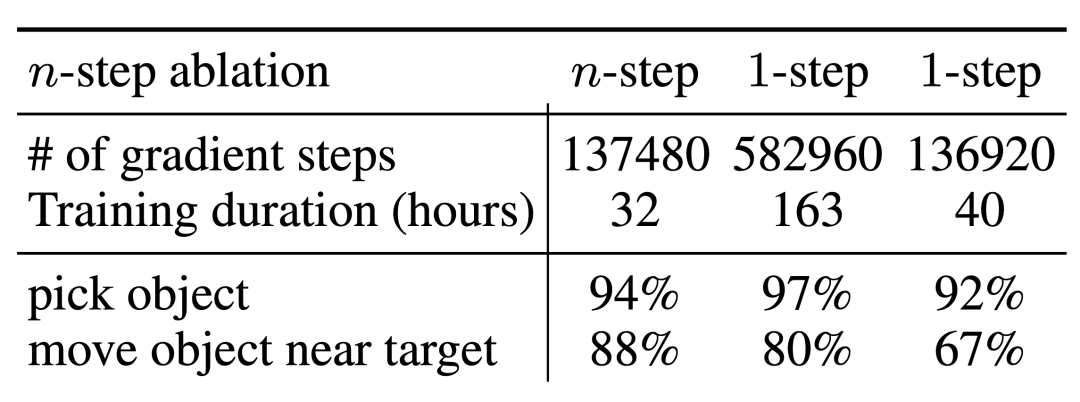

Eksperimen ablasi mereka untuk n-langkah pengembalian mendapati bahawa berat sebelah, tetapi pendekatan ini boleh mencapai prestasi tinggi yang setara dalam langkah kecerunan yang jauh lebih sedikit, dengan berkesan mengendalikan banyak masalah 🎜 #

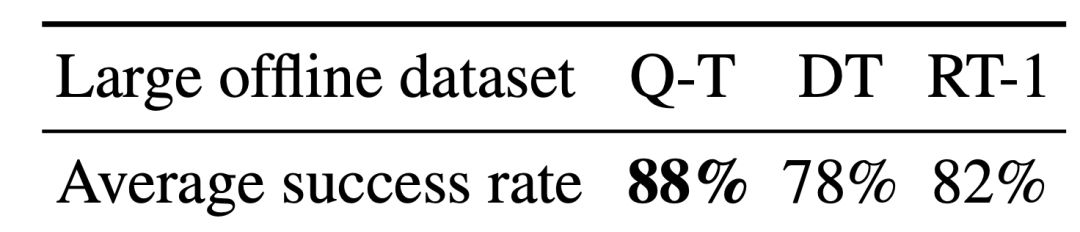

Para penyelidik juga cuba menjalankan Q-Transformer pada set data yang lebih besar. Mereka mengembangkan bilangan contoh positif kepada 115,000 dan bilangan contoh negatif kepada 185,000, menghasilkan set data yang mengandungi 300,000 klip acara. Menggunakan set data yang besar ini, Q-Transformer masih boleh belajar dan melakukan lebih baik daripada penanda aras RT-1 BC 🎜# Akhirnya, mereka menggabungkan fungsi Q yang dilatih oleh Q-Transformer sebagai kemampuan model dengan perancang bahasa, serupa dengan SayCan

Akhirnya, mereka menggabungkan fungsi Q yang dilatih oleh Q-Transformer sebagai kemampuan model dengan perancang bahasa, serupa dengan SayCan

#🎜🎜 Kesan Transformer #Q-🎜 anggaran kemampuan adalah disebabkan oleh fungsi Q sebelumnya yang dilatih menggunakan QT-Opt jika sekali lagi Melabelkan semula tugas yang tidak disampel sebagai contoh negatif tugas semasa semasa latihan boleh menjadi lebih baik. Memandangkan Q-Transformer tidak memerlukan latihan sim-to-real yang digunakan oleh latihan QT-Opt, lebih mudah untuk menggunakan Q-Transformer jika simulasi yang sesuai tidak ada.

Sila baca teks asal untuk butiran lanjut# 🎜🎜##🎜 🎜#

Atas ialah kandungan terperinci Google DeepMind: Menggabungkan model besar dengan pembelajaran pengukuhan untuk mencipta otak pintar bagi robot untuk melihat dunia. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1376

1376

52

52

Geospatial Laravel: Pengoptimuman peta interaktif dan sejumlah besar data

Apr 08, 2025 pm 12:24 PM

Geospatial Laravel: Pengoptimuman peta interaktif dan sejumlah besar data

Apr 08, 2025 pm 12:24 PM

Cecair memproses 7 juta rekod dan membuat peta interaktif dengan teknologi geospatial. Artikel ini meneroka cara memproses lebih dari 7 juta rekod menggunakan Laravel dan MySQL dan mengubahnya menjadi visualisasi peta interaktif. Keperluan Projek Cabaran Awal: Ekstrak Wawasan berharga menggunakan 7 juta rekod dalam pangkalan data MySQL. Ramai orang mula -mula mempertimbangkan bahasa pengaturcaraan, tetapi mengabaikan pangkalan data itu sendiri: Bolehkah ia memenuhi keperluan? Adakah penghijrahan data atau pelarasan struktur diperlukan? Bolehkah MySQL menahan beban data yang besar? Analisis awal: Penapis utama dan sifat perlu dikenalpasti. Selepas analisis, didapati bahawa hanya beberapa atribut yang berkaitan dengan penyelesaiannya. Kami mengesahkan kemungkinan penapis dan menetapkan beberapa sekatan untuk mengoptimumkan carian. Carian Peta Berdasarkan Bandar

Cara menetapkan masa tamat vue axios

Apr 07, 2025 pm 10:03 PM

Cara menetapkan masa tamat vue axios

Apr 07, 2025 pm 10:03 PM

Untuk menetapkan masa untuk Vue Axios, kita boleh membuat contoh Axios dan menentukan pilihan masa tamat: dalam tetapan global: vue.prototype. $ Axios = axios.create ({timeout: 5000}); Dalam satu permintaan: ini. $ axios.get ('/api/pengguna', {timeout: 10000}).

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Terdapat banyak sebab mengapa permulaan MySQL gagal, dan ia boleh didiagnosis dengan memeriksa log ralat. Penyebab umum termasuk konflik pelabuhan (periksa penghunian pelabuhan dan ubah suai konfigurasi), isu kebenaran (periksa keizinan pengguna yang menjalankan perkhidmatan), ralat fail konfigurasi (periksa tetapan parameter), rasuah direktori data (memulihkan data atau membina semula ruang meja), isu ruang jadual InnoDB (semak fail ibdata1) Apabila menyelesaikan masalah, anda harus menganalisisnya berdasarkan log ralat, cari punca utama masalah, dan mengembangkan tabiat sandaran data secara teratur untuk mencegah dan menyelesaikan masalah.

Cara Menggunakan MySQL Selepas Pemasangan

Apr 08, 2025 am 11:48 AM

Cara Menggunakan MySQL Selepas Pemasangan

Apr 08, 2025 am 11:48 AM

Artikel ini memperkenalkan operasi pangkalan data MySQL. Pertama, anda perlu memasang klien MySQL, seperti MySqlworkbench atau Command Line Client. 1. Gunakan perintah MySQL-Uroot-P untuk menyambung ke pelayan dan log masuk dengan kata laluan akaun root; 2. Gunakan CreateTatabase untuk membuat pangkalan data, dan gunakan Pilih pangkalan data; 3. Gunakan createtable untuk membuat jadual, menentukan medan dan jenis data; 4. Gunakan InsertInto untuk memasukkan data, data pertanyaan, kemas kini data dengan kemas kini, dan padam data dengan padam. Hanya dengan menguasai langkah -langkah ini, belajar menangani masalah biasa dan mengoptimumkan prestasi pangkalan data anda boleh menggunakan MySQL dengan cekap.

Jurutera Backend Senior Remote (Platform) memerlukan kalangan

Apr 08, 2025 pm 12:27 PM

Jurutera Backend Senior Remote (Platform) memerlukan kalangan

Apr 08, 2025 pm 12:27 PM

Jurutera Backend Senior Remote Company Kekosongan Syarikat: Lokasi Lokasi: Jauh Pejabat Jauh Jenis: Gaji sepenuh masa: $ 130,000- $ 140,000 Penerangan Pekerjaan Mengambil bahagian dalam penyelidikan dan pembangunan aplikasi mudah alih Circle dan ciri-ciri berkaitan API awam yang meliputi keseluruhan kitaran hayat pembangunan perisian. Tanggungjawab utama kerja pembangunan secara bebas berdasarkan rubyonrails dan bekerjasama dengan pasukan react/redux/relay front-end. Membina fungsi teras dan penambahbaikan untuk aplikasi web dan bekerjasama rapat dengan pereka dan kepimpinan sepanjang proses reka bentuk berfungsi. Menggalakkan proses pembangunan positif dan mengutamakan kelajuan lelaran. Memerlukan lebih daripada 6 tahun backend aplikasi web kompleks

Bolehkah mysql kembali json

Apr 08, 2025 pm 03:09 PM

Bolehkah mysql kembali json

Apr 08, 2025 pm 03:09 PM

MySQL boleh mengembalikan data JSON. Fungsi JSON_EXTRACT mengekstrak nilai medan. Untuk pertanyaan yang kompleks, pertimbangkan untuk menggunakan klausa WHERE untuk menapis data JSON, tetapi perhatikan kesan prestasinya. Sokongan MySQL untuk JSON sentiasa meningkat, dan disyorkan untuk memberi perhatian kepada versi dan ciri terkini.

Memahami sifat asid: tiang pangkalan data yang boleh dipercayai

Apr 08, 2025 pm 06:33 PM

Memahami sifat asid: tiang pangkalan data yang boleh dipercayai

Apr 08, 2025 pm 06:33 PM

Penjelasan terperinci mengenai atribut asid asid pangkalan data adalah satu set peraturan untuk memastikan kebolehpercayaan dan konsistensi urus niaga pangkalan data. Mereka menentukan bagaimana sistem pangkalan data mengendalikan urus niaga, dan memastikan integriti dan ketepatan data walaupun dalam hal kemalangan sistem, gangguan kuasa, atau pelbagai pengguna akses serentak. Gambaran keseluruhan atribut asid Atomicity: Transaksi dianggap sebagai unit yang tidak dapat dipisahkan. Mana -mana bahagian gagal, keseluruhan transaksi dilancarkan kembali, dan pangkalan data tidak mengekalkan sebarang perubahan. Sebagai contoh, jika pemindahan bank ditolak dari satu akaun tetapi tidak meningkat kepada yang lain, keseluruhan operasi dibatalkan. Begintransaction; UpdateAcCountSsetBalance = Balance-100Wh

Kunci utama MySQL boleh menjadi batal

Apr 08, 2025 pm 03:03 PM

Kunci utama MySQL boleh menjadi batal

Apr 08, 2025 pm 03:03 PM

Kunci utama MySQL tidak boleh kosong kerana kunci utama adalah atribut utama yang secara unik mengenal pasti setiap baris dalam pangkalan data. Jika kunci utama boleh kosong, rekod tidak dapat dikenal pasti secara unik, yang akan membawa kepada kekeliruan data. Apabila menggunakan lajur integer sendiri atau UUIDs sebagai kunci utama, anda harus mempertimbangkan faktor-faktor seperti kecekapan dan penghunian ruang dan memilih penyelesaian yang sesuai.