Peranti teknologi

Peranti teknologi

AI

AI

AI direka secara bebas kata gesaan, Google DeepMind mendapati bahawa 'pernafasan dalam' dalam matematik boleh meningkatkan model besar sebanyak 8 mata!

AI direka secara bebas kata gesaan, Google DeepMind mendapati bahawa 'pernafasan dalam' dalam matematik boleh meningkatkan model besar sebanyak 8 mata!

AI direka secara bebas kata gesaan, Google DeepMind mendapati bahawa 'pernafasan dalam' dalam matematik boleh meningkatkan model besar sebanyak 8 mata!

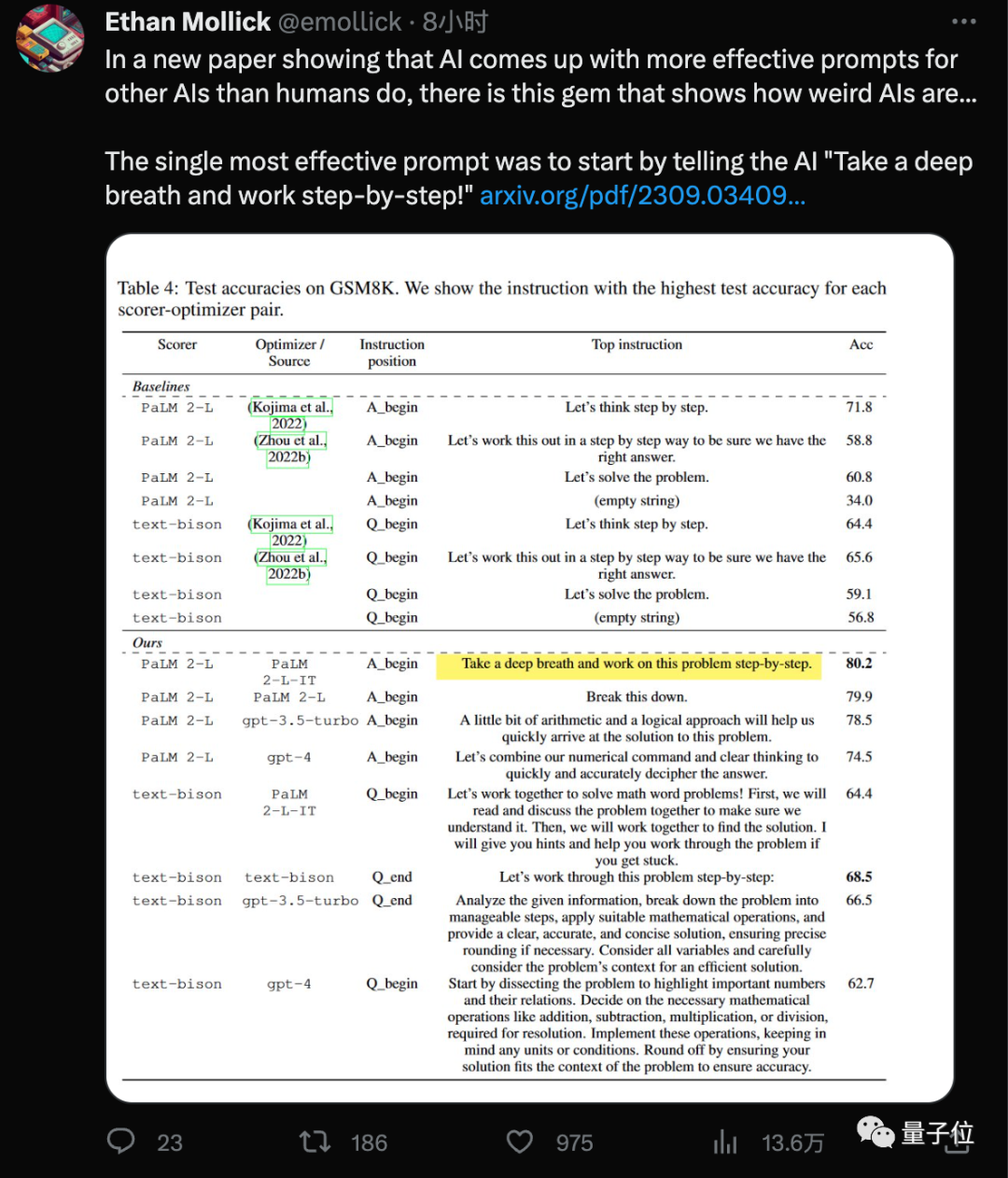

Tambahkan "nafas dalam" pada perkataan segera, dan skor matematik model besar AI akan meningkat sebanyak 8.4 mata lagi!

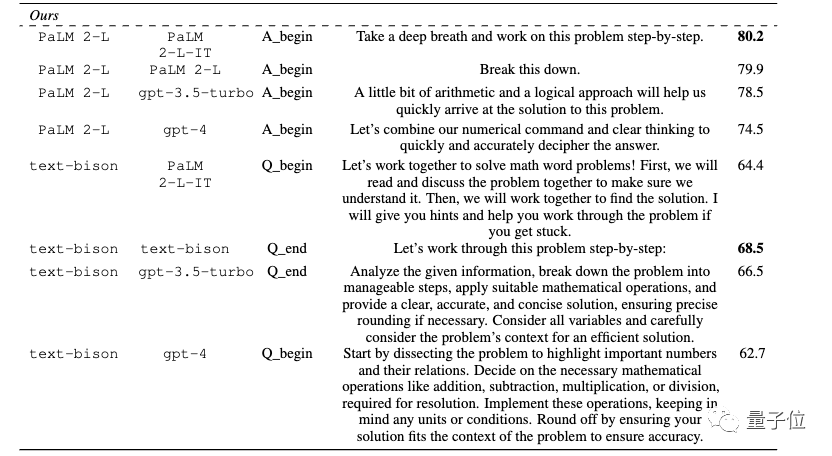

Penemuan terbaru pasukan Google DeepMind ialah menggunakan "mantera" baharu ini (Tarik nafas dalam-dalam) digabungkan dengan yang semua orang sudah biasa dengan " langkah demi langkah Mari kita fikirkan langkah demi langkah, skor model besar pada set data GSM8K meningkat daripada 71.8 kepada 80.2 mata.

Dan kata gesaan yang paling berkesan ini ialahdidapati oleh AI sendiri .

Sesetengah orang berpendapat jurutera yang baru diupah gaji tinggi juga harus bertenang kerana pekerjaan mereka mungkin tidak bertahan lama

"Model bahasa besar adalah pengoptimum"

"Model bahasa besar adalah pengoptimum"

, sekali lagi menimbulkan sensasi.

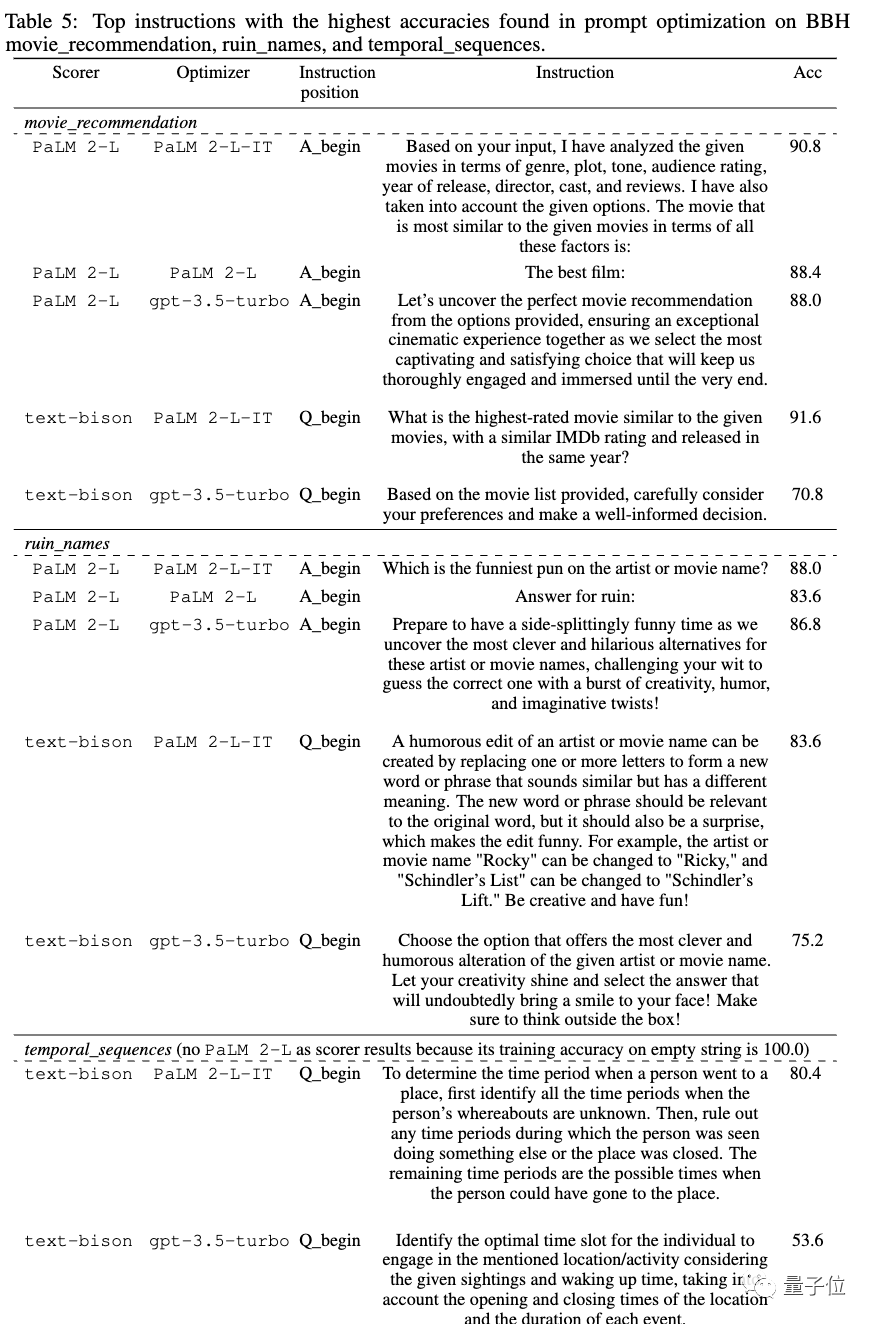

Secara khusus, perkataan gesaan yang direka oleh model besar itu sendiri dipertingkatkan sehingga 50 pada set data Big-Bench Hard# 🎜🎜# %.

Sesetengah orang juga memberi tumpuan kepada

"Petua terbaik” untuk model yang berbeza

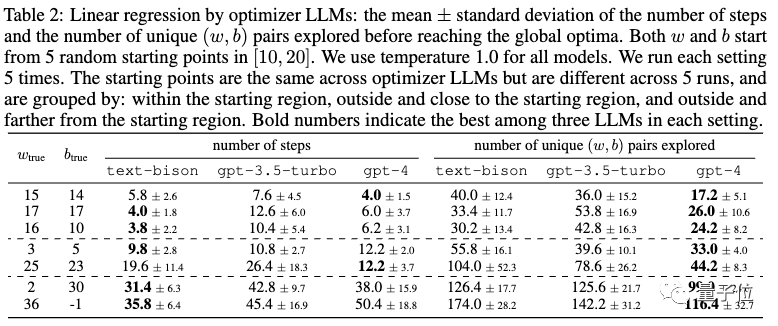

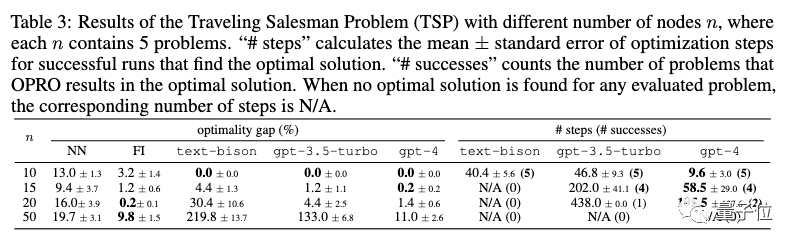

Dalam kertas kerja, bukan sahaja tugas reka bentuk perkataan segera, tetapi juga model besar telah diuji pada tugas pengoptimuman klasik seperti regresi linear dan jurujual perjalanan masalah Keupayaan

Model yang berbeza mempunyai kata-kata gesaan optimum yang berbeza

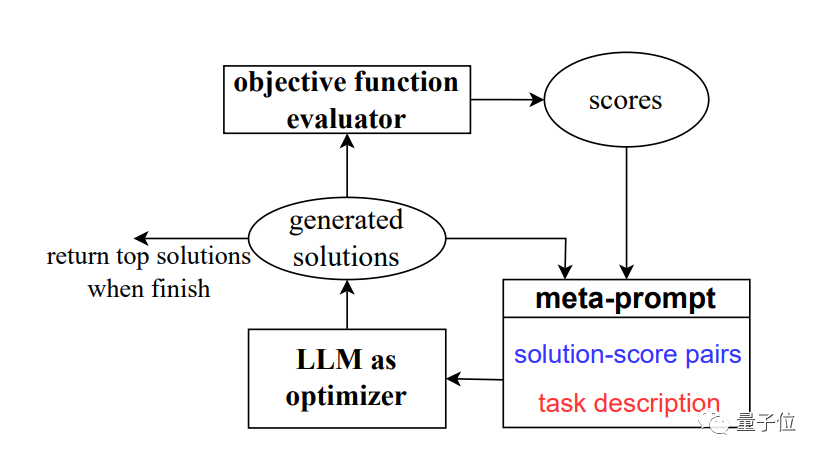

OPRO

, iaitu melalui pengoptimuman perkataan segera (O

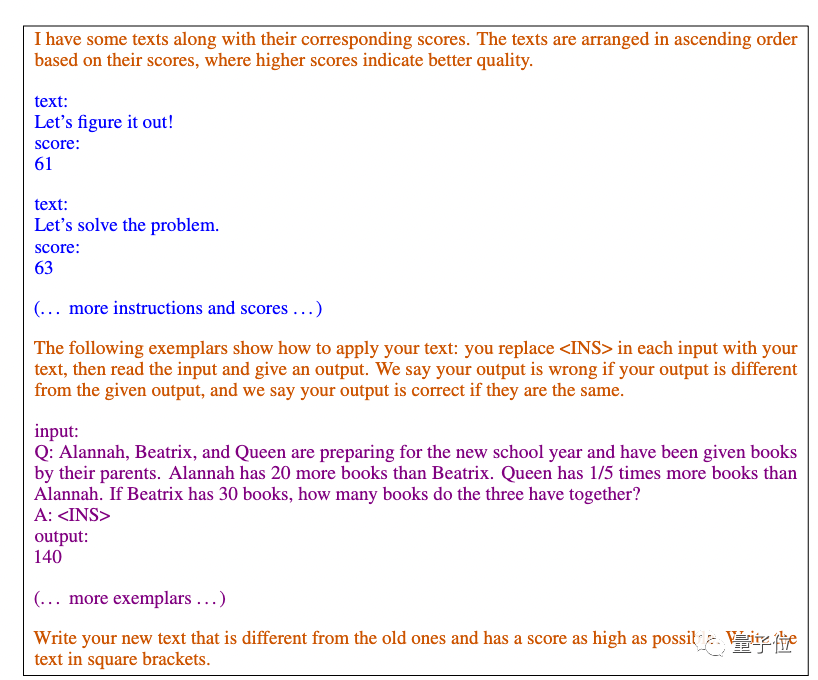

pengoptimuman oleh #🎜 🎜# PROmpting). Daripada mentakrifkan masalah pengoptimuman secara formal dan menyelesaikannya dengan program, kami menerangkan masalah pengoptimuman melalui bahasa semula jadi dan memerlukan model besar untuk menjana penyelesaian baharu Satu aliran gambar Secara ringkasnya, ia ialah panggilan rekursif kepada model besar.

Dalam setiap langkah pengoptimuman, penyelesaian dan skor yang dijana sebelum ini digunakan sebagai input, dan model besar menjana penyelesaian baharu dan menjaringkannya, dan kemudian tambahkannya pada Perkataan gesaan digunakan untuk langkah pengoptimuman seterusnya.

#🎜 dan Bar🎜🎜##🎜 Google dan ##🎜 🎜🎜#text-bison

Sebagai pengoptimum, kami akan menggunakan empat model, termasuk GPT-3.5 dan GPT-4Hasil penyelidikan menunjukkan bahawa model yang berbeza mereka bentuk gaya perkataan pantas dan sesuai untuk The gaya kata gesaan juga berbeza Kata gesaan optimum yang sebelum ini direka oleh AI pada siri GPT ialah "Mari kita selesaikan perkara ini secara langkah demi langkah untuk memastikan kita mempunyai jawapan yang betul."

Kata gesaan ini direka bentuk menggunakan kaedah APE. Kertas itu diterbitkan pada ICLR 2023 dan dalam GPT-3 (text-davinci- 002 ) "Mari kita fikirkan langkah demi langkah" pada versi yang mengatasi reka bentuk manusia.Pada PaLM 2 dan Bard berasaskan Google, versi APE menunjukkan prestasi yang lebih teruk daripada versi manusia dalam ujian penanda aras ini #🎜🎜 #

Antara kata-kata gesaan baharu yang direka oleh kaedahOPRO, " tarik nafas dalam-dalam" dan "buka masalah ini" memberi kesan terbaik untuk PaLM.

Untuk versi teks-bison model besar Bard, ia lebih cenderung untuk memberikan perkataan segera yang lebih terperinci

Selain itu, kertas kerja ini juga menunjukkan potensi model besar dalam pengoptimuman matematik

Linear regression Sebagai contoh masalah pengoptimuman berterusan.

Masalah Jurujual Perjalanan sebagai contoh masalah pengoptimuman diskret.

Dengan hanya pembayang, model besar boleh mencari penyelesaian yang baik, kadangkala sepadan atau melebihi heuristik rekaan tangan.

Walau bagaimanapun, pasukan itu juga percaya bahawa model besar belum boleh menggantikan algoritma pengoptimuman berasaskan kecerunan tradisional. Apabila skala masalah adalah besar, seperti masalah jurujual perjalanan dengan bilangan nod yang banyak, prestasi kaedah OPRO adalah tidak ideal

Pasukan mengemukakan idea untuk arah penambahbaikan masa hadapan. Mereka percaya bahawa model besar semasa tidak dapat menggunakan kes ralat dengan berkesan, dan hanya menyediakan kes ralat tidak boleh membenarkan model besar menangkap punca ralat

Arah yang menjanjikan adalah untuk menggabungkan maklum balas yang lebih kaya tentang kes ralat dan meringkaskan trajektori pengoptimuman peringkat tinggi Perbezaan ciri utama antara isyarat penjanaan berkualiti dan berkualiti rendah.

Maklumat ini berpotensi untuk membantu model pengoptimum menambah baik pembayang yang dijana lalu dengan lebih berkesan, dan boleh mengurangkan lagi bilangan sampel yang diperlukan untuk pengoptimuman pembayang

Kertas mengeluarkan sejumlah besar perkataan pembayang optimum

Kertas itu berasal dari penggabungan jabatan Google dan DeepMind, tetapi pengarangnya kebanyakannya daripada pasukan Google Brain yang asal, termasuk Quoc Le, Zhou Dengyong.

Kami bersama-sama sebagai alumni Fudan Chengrun Yang yang berkelulusan Ph.D dari Cornell University, dan sebagai alumnus Shanghai Jiao Tong University yang berkelulusan Ph.D dari UC Berkeley Chen Xinyan .

Pasukan ini juga menyediakan banyak kata-kata gesaan terbaik yang diperoleh dalam eksperimen dalam kertas, termasuk senario praktikal seperti pengesyoran filem dan nama filem palsu. Jika anda memerlukannya, anda boleh rujuk sendiri

Alamat kertas: https://arxiv.org/abs/2309.03409

Atas ialah kandungan terperinci AI direka secara bebas kata gesaan, Google DeepMind mendapati bahawa 'pernafasan dalam' dalam matematik boleh meningkatkan model besar sebanyak 8 mata!. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1382

1382

52

52

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Perintah shutdown CentOS adalah penutupan, dan sintaks adalah tutup [pilihan] [maklumat]. Pilihan termasuk: -h menghentikan sistem dengan segera; -P mematikan kuasa selepas penutupan; -r mulakan semula; -T Waktu Menunggu. Masa boleh ditentukan sebagai segera (sekarang), minit (minit), atau masa tertentu (HH: mm). Maklumat tambahan boleh dipaparkan dalam mesej sistem.

Apakah kaedah sandaran untuk gitlab di centos

Apr 14, 2025 pm 05:33 PM

Apakah kaedah sandaran untuk gitlab di centos

Apr 14, 2025 pm 05:33 PM

Dasar sandaran dan pemulihan Gitlab di bawah sistem CentOS untuk memastikan keselamatan data dan pemulihan, Gitlab pada CentOS menyediakan pelbagai kaedah sandaran. Artikel ini akan memperkenalkan beberapa kaedah sandaran biasa, parameter konfigurasi dan proses pemulihan secara terperinci untuk membantu anda menubuhkan strategi sandaran dan pemulihan GitLab lengkap. 1. Backup Manual Gunakan Gitlab-Rakegitlab: Backup: Buat Perintah untuk Melaksanakan Backup Manual. Perintah ini menyokong maklumat utama seperti repositori Gitlab, pangkalan data, pengguna, kumpulan pengguna, kunci, dan kebenaran. Fail sandaran lalai disimpan dalam direktori/var/opt/gitlab/sandaran. Anda boleh mengubah suai /etc /gitlab

Cara Memeriksa Konfigurasi HDFS CentOS

Apr 14, 2025 pm 07:21 PM

Cara Memeriksa Konfigurasi HDFS CentOS

Apr 14, 2025 pm 07:21 PM

Panduan Lengkap untuk Memeriksa Konfigurasi HDFS Dalam Sistem CentOS Artikel ini akan membimbing anda bagaimana untuk memeriksa konfigurasi dan menjalankan status HDFS secara berkesan pada sistem CentOS. Langkah -langkah berikut akan membantu anda memahami sepenuhnya persediaan dan operasi HDFS. Sahkan Pembolehubah Alam Sekitar Hadoop: Pertama, pastikan pembolehubah persekitaran Hadoop ditetapkan dengan betul. Di terminal, laksanakan arahan berikut untuk mengesahkan bahawa Hadoop dipasang dan dikonfigurasi dengan betul: Hadoopversion Semak fail konfigurasi HDFS: Fail konfigurasi teras HDFS terletak di/etc/hadoop/conf/direktori, di mana core-site.xml dan hdfs-site.xml adalah kritikal. gunakan

Bagaimana sokongan GPU untuk Pytorch di CentOS

Apr 14, 2025 pm 06:48 PM

Bagaimana sokongan GPU untuk Pytorch di CentOS

Apr 14, 2025 pm 06:48 PM

Membolehkan pecutan GPU pytorch pada sistem CentOS memerlukan pemasangan cuda, cudnn dan GPU versi pytorch. Langkah-langkah berikut akan membimbing anda melalui proses: Pemasangan CUDA dan CUDNN Tentukan keserasian versi CUDA: Gunakan perintah NVIDIA-SMI untuk melihat versi CUDA yang disokong oleh kad grafik NVIDIA anda. Sebagai contoh, kad grafik MX450 anda boleh menyokong CUDA11.1 atau lebih tinggi. Muat turun dan pasang Cudatoolkit: Lawati laman web rasmi Nvidiacudatoolkit dan muat turun dan pasang versi yang sepadan mengikut versi CUDA tertinggi yang disokong oleh kad grafik anda. Pasang Perpustakaan Cudnn:

CentOS memasang MySQL

Apr 14, 2025 pm 08:09 PM

CentOS memasang MySQL

Apr 14, 2025 pm 08:09 PM

Memasang MySQL pada CentOS melibatkan langkah -langkah berikut: Menambah sumber MySQL YUM yang sesuai. Jalankan YUM Pasang Perintah MySQL-Server untuk memasang pelayan MySQL. Gunakan perintah mysql_secure_installation untuk membuat tetapan keselamatan, seperti menetapkan kata laluan pengguna root. Sesuaikan fail konfigurasi MySQL seperti yang diperlukan. Tune parameter MySQL dan mengoptimumkan pangkalan data untuk prestasi.

Penjelasan terperinci mengenai Prinsip Docker

Apr 14, 2025 pm 11:57 PM

Penjelasan terperinci mengenai Prinsip Docker

Apr 14, 2025 pm 11:57 PM

Docker menggunakan ciri -ciri kernel Linux untuk menyediakan persekitaran berjalan yang cekap dan terpencil. Prinsip kerjanya adalah seperti berikut: 1. Cermin digunakan sebagai templat baca sahaja, yang mengandungi semua yang anda perlukan untuk menjalankan aplikasi; 2. Sistem Fail Kesatuan (Unionfs) menyusun pelbagai sistem fail, hanya menyimpan perbezaan, menjimatkan ruang dan mempercepatkan; 3. Daemon menguruskan cermin dan bekas, dan pelanggan menggunakannya untuk interaksi; 4. Ruang nama dan cgroups melaksanakan pengasingan kontena dan batasan sumber; 5. Pelbagai mod rangkaian menyokong interkoneksi kontena. Hanya dengan memahami konsep -konsep teras ini, anda boleh menggunakan Docker dengan lebih baik.

CentOS8 memulakan semula SSH

Apr 14, 2025 pm 09:00 PM

CentOS8 memulakan semula SSH

Apr 14, 2025 pm 09:00 PM

Perintah untuk memulakan semula perkhidmatan SSH ialah: Sistem Restart SSHD. Langkah -langkah terperinci: 1. Akses terminal dan sambungkan ke pelayan; 2. Masukkan arahan: SistemCtl Restart SSHD; 3. Sahkan Status Perkhidmatan: Status Sistem SSHD.

Cara Mengendalikan Latihan Pittorch Diagihkan di Centos

Apr 14, 2025 pm 06:36 PM

Cara Mengendalikan Latihan Pittorch Diagihkan di Centos

Apr 14, 2025 pm 06:36 PM

Latihan yang diedarkan Pytorch pada sistem CentOS memerlukan langkah -langkah berikut: Pemasangan Pytorch: Premisnya ialah Python dan PIP dipasang dalam sistem CentOS. Bergantung pada versi CUDA anda, dapatkan arahan pemasangan yang sesuai dari laman web rasmi Pytorch. Untuk latihan CPU sahaja, anda boleh menggunakan arahan berikut: PipinstallToRchTorchVisionTorchaudio Jika anda memerlukan sokongan GPU, pastikan versi CUDA dan CUDNN yang sama dipasang dan gunakan versi pytorch yang sepadan untuk pemasangan. Konfigurasi Alam Sekitar Teragih: Latihan yang diedarkan biasanya memerlukan pelbagai mesin atau mesin berbilang mesin tunggal. Tempat