Versi berbilang modal Llama2 dalam talian, Meta mengeluarkan AnyMAL

Menyegarkan prestasi sifar pukulan terbaik industri dalam berbilang ujian penanda aras.

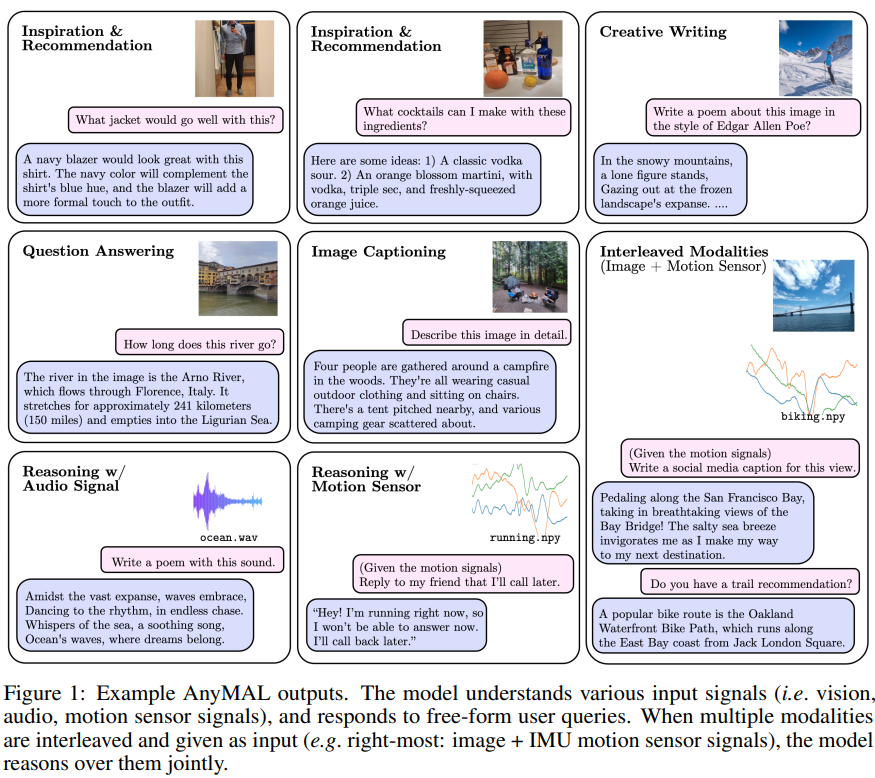

Model bersatu yang boleh memahami kandungan input modal yang berbeza (teks, imej, video, audio, data penderia gerakan IMU) dan menjana tindak balas teks Teknologi ini berdasarkan Llama 2 dan datang daripada Meta.

Semalam, penyelidikan ke atas model besar berbilang modal AnyMAL menarik perhatian komuniti penyelidik AI.

Model Bahasa Besar (LLM) terkenal dengan saiz dan kerumitannya yang besar, yang sangat meningkatkan keupayaan mesin untuk memahami dan menyatakan bahasa manusia. Kemajuan dalam LLM telah membolehkan kemajuan ketara dalam bidang bahasa visual, merapatkan jurang antara pengekod imej dan LLM, menggabungkan keupayaan inferens mereka. Penyelidikan LLM multimodal sebelumnya telah memfokuskan pada model yang menggabungkan teks dengan modaliti lain, seperti model teks dan imej, atau pada model bahasa proprietari yang bukan sumber terbuka.

Jika ada cara yang lebih baik untuk mencapai kefungsian pelbagai mod dan membenamkan pelbagai modaliti dalam LLM, adakah ini akan membawa kita pengalaman yang berbeza?

letak contoh

Untuk menyelesaikan masalah ini, penyelidik dari Meta baru-baru ini melancarkan AnyMAL (Any-Modality Augmented Language Model). Ini ialah koleksi pengekod berbilang modal yang dilatih untuk menukar data daripada pelbagai modaliti (termasuk imej, video, audio dan data penderia gerakan IMU) ke dalam ruang pembenaman teks LLM

Alamat kertas: https://huggingface. co/papers/2309.16058

Menurut huraian, sumbangan utama penyelidikan ini adalah seperti berikut:

Penyelesaian yang cekap dan berskala dicadangkan untuk membina LLM pelbagai modal. Artikel ini menyediakan lapisan unjuran yang dipralatih pada set data besar yang mengandungi pelbagai modaliti (cth., 200 juta imej, 2.2 juta segmen audio, 500,000 siri masa IMU, 28 juta segmen video), semuanya Semua sejajar dengan model besar yang sama (LLaMA-2- 70B-chat), mendayakan isyarat kontekstual berbilang modal berjalin.

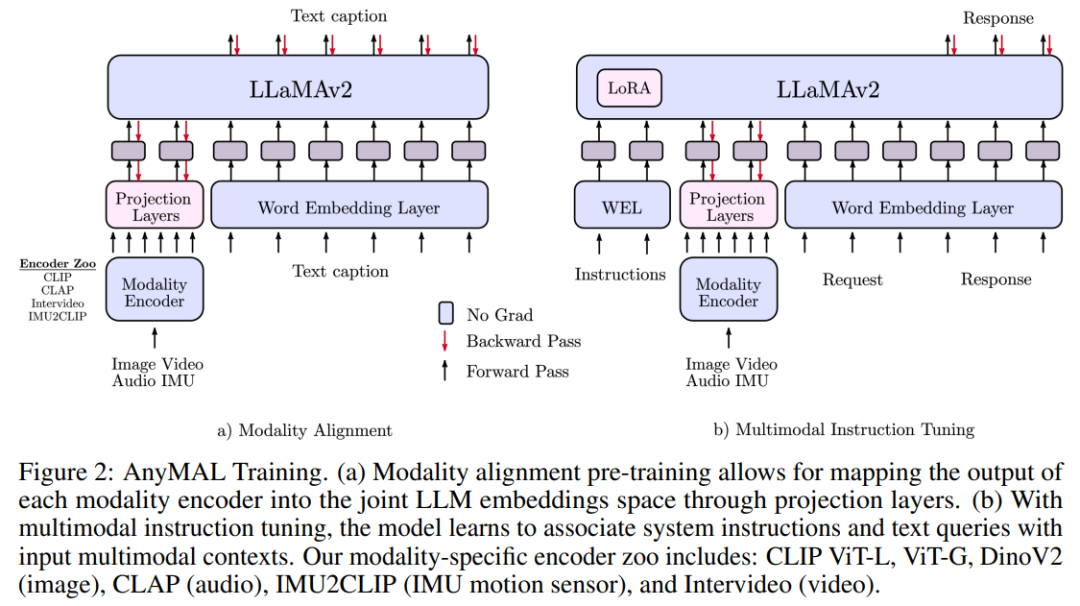

Kajian ini memperhalusi model menggunakan set arahan berbilang modal merentas tiga modaliti (imej, video dan audio), meliputi pelbagai tugas tanpa had melangkaui domain menjawab soalan mudah (QA). Set data ini mengandungi data arahan yang dikumpul manusia berkualiti tinggi, jadi kajian ini menggunakannya sebagai penanda aras untuk tugas inferens pelbagai mod yang kompleks

Model terbaik dalam kertas ini mencapai keputusan yang baik dalam penilaian automatik dan manusia pada pelbagai tugas dan modaliti Berbanding dengan model dalam literatur sedia ada, ketepatan relatif VQAv2 meningkat sebanyak 7.0%, CIDEr bagi sari kata imej COCO ralat sifar meningkat sebanyak 8.4%, dan CIDEr AudioCaps meningkat sebanyak 14.5%. SOTA

kaedah

Gambaran keseluruhan kaedah

Gambaran keseluruhan kaedah

Diperlukan untuk disemak

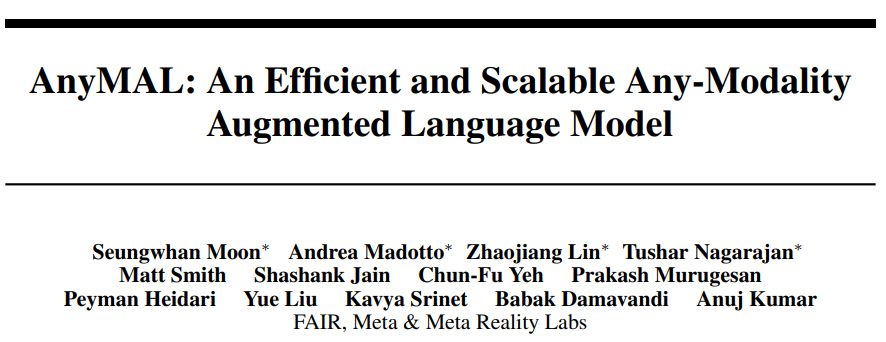

dengan menggunakan data multimodal berpasangan termasuk isyarat modal khusus dan naratif teks), kajian ini telah melatih LLM untuk mencapai pelbagai -keupayaan pemahaman modal, seperti yang ditunjukkan dalam Rajah 2. Khususnya, kami melatih penyesuai ringan untuk setiap modaliti yang menayangkan isyarat input ke dalam ruang pembenaman token teks LLM tertentu. Dengan cara ini, ruang pembenaman token teks LLM menjadi ruang pembenaman token bersama, di mana token boleh mewakili teks atau modaliti lain Berkenaan kajian penjajaran imej, kami menggunakan subset bersih set data LAION-2B, Kaedah CAT digunakan untuk penapisan dan mana-mana muka yang boleh dikesan adalah kabur. Untuk kajian penjajaran audio, set data AudioSet (2.1M), AudioCaps (46K) dan CLOTHO (5K) telah digunakan. Selain itu, kami juga menggunakan set data Ego4D untuk IMU dan penjajaran teks (528K) Untuk set data yang besar, penskalaan pra-latihan kepada model parameter 70B memerlukan banyak sumber, selalunya memerlukan penggunaan pembungkus FSDP pada berbilang GPU Model dipecahkan. Untuk meningkatkan skala latihan dengan berkesan, kami melaksanakan strategi pengkuantitian (4-bit dan 8-bit) dalam tetapan berbilang modal, di mana bahagian LLM model dibekukan dan hanya tokenizer modal boleh dilatih. Pendekatan ini mengurangkan keperluan memori mengikut urutan magnitud. Oleh itu, 70B AnyMAL boleh melengkapkan latihan pada GPU VRAM 80GB tunggal dengan saiz kelompok 4. Berbanding dengan FSDP, kaedah pengkuantitian yang dicadangkan dalam artikel ini hanya menggunakan separuh daripada sumber GPU, tetapi mencapai daya pemprosesan yang sama🎜

Menggunakan set data arahan berbilang mod untuk penalaan halus bermakna menggunakan set data arahan berbilang mod untuk penalaan halus

Untuk meningkatkan lagi keupayaan model untuk mengikuti arahan untuk modaliti input yang berbeza, kami mengkaji penggunaan set data arahan berbilang modal Penalaan halus tambahan telah dilakukan pada set data penalaan arahan (MM-IT) terkini. Secara khusus, kami menggabungkan input sebagai [ ] supaya sasaran tindak balas adalah berdasarkan kedua-dua arahan teks dan input modal. Penyelidikan dijalankan ke atas dua situasi berikut: (1) melatih lapisan unjuran tanpa mengubah parameter LLM atau (2) menggunakan penyesuaian tahap rendah (Penyesuaian Peringkat Rendah) untuk melaraskan lagi tingkah laku LM. Kajian ini menggunakan set data tertala arahan yang dikumpul secara manual dan data sintetik.

] supaya sasaran tindak balas adalah berdasarkan kedua-dua arahan teks dan input modal. Penyelidikan dijalankan ke atas dua situasi berikut: (1) melatih lapisan unjuran tanpa mengubah parameter LLM atau (2) menggunakan penyesuaian tahap rendah (Penyesuaian Peringkat Rendah) untuk melaraskan lagi tingkah laku LM. Kajian ini menggunakan set data tertala arahan yang dikumpul secara manual dan data sintetik.

Eksperimen dan keputusan

Penjanaan kapsyen imej ialah teknologi kecerdasan buatan yang digunakan untuk menjana kapsyen yang sepadan secara automatik untuk imej. Teknologi ini menggabungkan penglihatan komputer dan kaedah pemprosesan bahasa semula jadi untuk menghasilkan kapsyen deskriptif yang berkaitan dengan imej dengan menganalisis kandungan dan ciri imej, serta memahami semantik dan sintaks. Penjanaan kapsyen imej mempunyai aplikasi yang luas dalam banyak bidang, termasuk carian imej, anotasi imej, pengambilan imej, dsb. Dengan menjana tajuk secara automatik, kefahaman imej dan ketepatan enjin carian boleh dipertingkatkan, memberikan pengguna mendapatkan semula imej dan pengalaman menyemak imbas yang lebih baik

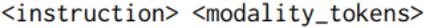

Jadual 2 menunjukkan keputusan dalam COCO dan tugasan yang ditandakan dengan "Penerangan Terperinci" (MM- Prestasi penjanaan kapsyen imej tangkapan sifar pada subset set data MM-IT daripada IT-Cap). Seperti yang dapat dilihat, varian AnyMAL menunjukkan prestasi yang lebih baik daripada garis dasar pada kedua-dua set data. Terutama, tiada jurang yang ketara dalam prestasi antara varian AnyMAL-13B dan AnyMAL-70B. Keputusan ini menunjukkan bahawa keupayaan LLM asas untuk penjanaan kapsyen imej ialah teknik kecerdasan buatan yang digunakan untuk menjana kapsyen yang sepadan secara automatik untuk imej. Teknologi ini menggabungkan penglihatan komputer dan kaedah pemprosesan bahasa semula jadi untuk menghasilkan kapsyen deskriptif yang berkaitan dengan imej dengan menganalisis kandungan dan ciri imej, serta memahami semantik dan sintaks. Penjanaan kapsyen imej mempunyai aplikasi yang luas dalam banyak bidang, termasuk carian imej, anotasi imej, pengambilan imej, dsb. Dengan mengautomasikan penjanaan kapsyen, kefahaman imej dan ketepatan enjin carian boleh dipertingkatkan, memberikan pengguna mendapatkan semula imej dan pengalaman menyemak imbas Tugas ini kurang memberi kesan, tetapi banyak bergantung pada saiz data dan kaedah pendaftaran.

Penulisan semula yang diperlukan ialah: Penilaian manusia terhadap tugas inferens pelbagai mod

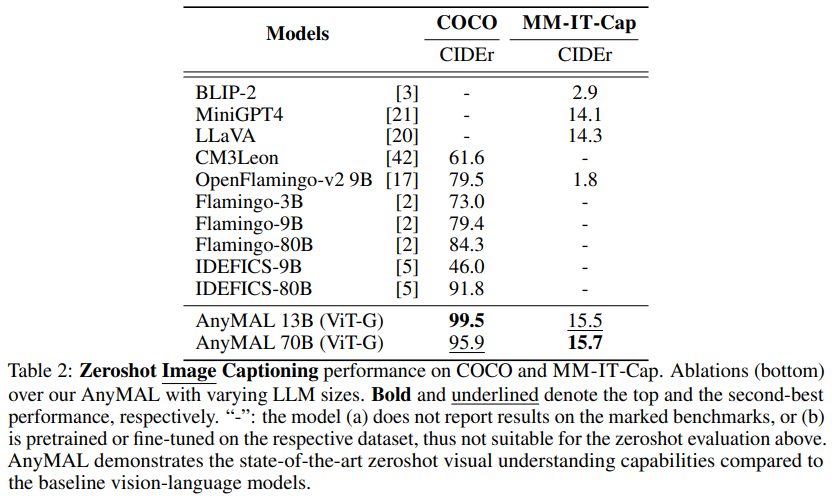

Rajah 3 menunjukkan AnyMAL membandingkan dengan garis dasar (LLaVA: 34.4% kadar kemenangan dan prestasi MiniGPT4: 27) kukuh dan jurang dengan sampel beranotasi manusia sebenar adalah kecil (41.1% kadar kemenangan). Terutamanya, model yang diperhalusi dengan set arahan penuh menunjukkan kadar kemenangan keutamaan tertinggi, menunjukkan pemahaman visual dan keupayaan penaakulan yang setanding dengan respons beranotasi manusia. Perlu juga diperhatikan bahawa BLIP-2 dan InstructBLIP berprestasi buruk pada pertanyaan terbuka ini (masing-masing 4.1% dan 16.7% kadar kemenangan keutamaan), walaupun mereka berprestasi baik pada penanda aras VQA awam (lihat Jadual 4).

Penanda Aras VQA

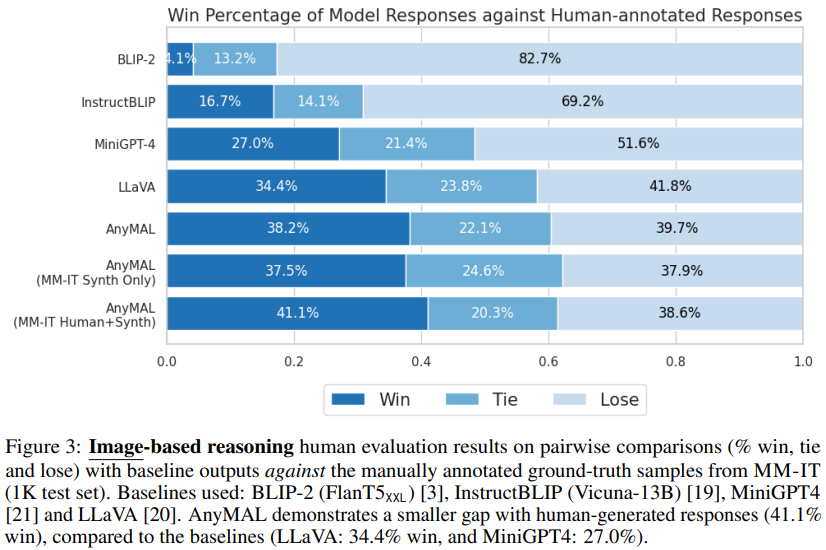

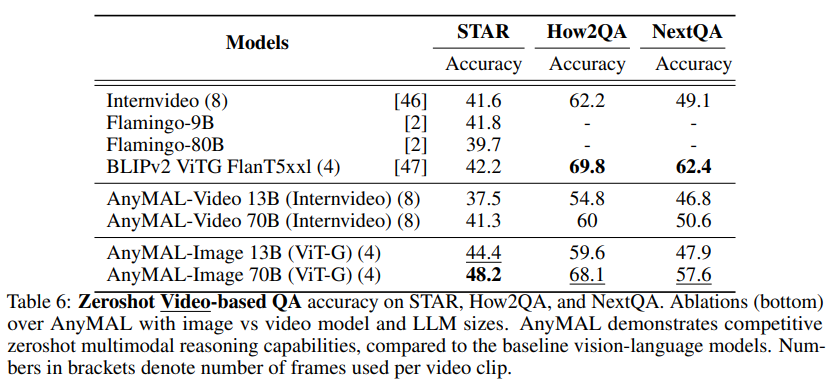

Dalam Jadual 4, kami menunjukkan prestasi pukulan sifar pada dataset Meme Kebencian, VQAv2, TextVQA, ScienceQA, VizWiz dan tanda aras yang dilaporkan dalam OKVQA masing-masing. keputusan sampel telah dibandingkan. Penyelidikan kami menumpukan pada penilaian sifar pukulan untuk menganggarkan prestasi model dengan paling tepat pada pertanyaan terbuka pada masa inferens penanda aras QA video.

Menjana semula sari kata audio

Jadual 5 menunjukkan hasil penjanaan semula sari kata audio pada set data penanda aras AudioCaps. AnyMAL dengan ketara mengatasi model sari kata audio tercanggih lain dalam kesusasteraan (cth., CIDEr +10.9pp, SPICE +5.8pp), menunjukkan bahawa kaedah yang dicadangkan bukan sahaja terpakai untuk penglihatan tetapi juga untuk pelbagai modaliti. Model teks 70B menunjukkan kelebihan yang jelas berbanding dengan varian 7B dan 13B.

Menariknya, berdasarkan kaedah, jenis dan masa penyerahan kertas AnyMAL, Meta nampaknya merancang untuk mengumpul data berbilang modal melalui set kepala realiti campuran/metaverse yang baru dilancarkan. Hasil penyelidikan ini mungkin disepadukan ke dalam barisan produk Metaverse Meta, atau tidak lama lagi digunakan untuk aplikasi pengguna

Sila baca artikel asal untuk mendapatkan butiran lanjut.

Atas ialah kandungan terperinci Versi berbilang modal Llama2 dalam talian, Meta mengeluarkan AnyMAL. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1378

1378

52

52

Pengarang ControlNet mendapat satu lagi kejayaan! Seluruh proses menghasilkan lukisan daripada gambar, memperoleh 1.4k bintang dalam masa dua hari

Jul 17, 2024 am 01:56 AM

Pengarang ControlNet mendapat satu lagi kejayaan! Seluruh proses menghasilkan lukisan daripada gambar, memperoleh 1.4k bintang dalam masa dua hari

Jul 17, 2024 am 01:56 AM

Ia juga merupakan video Tusheng, tetapi PaintsUndo telah mengambil laluan yang berbeza. Pengarang ControlNet LvminZhang mula hidup semula! Kali ini saya menyasarkan bidang lukisan. Projek baharu PaintsUndo telah menerima 1.4kstar (masih meningkat secara menggila) tidak lama selepas ia dilancarkan. Alamat projek: https://github.com/lllyasviel/Paints-UNDO Melalui projek ini, pengguna memasukkan imej statik, dan PaintsUndo secara automatik boleh membantu anda menjana video keseluruhan proses mengecat, daripada draf baris hingga produk siap . Semasa proses lukisan, perubahan garisan adalah menakjubkan Hasil akhir video sangat serupa dengan imej asal: Mari kita lihat lukisan lengkap.

Mendahului senarai jurutera perisian AI sumber terbuka, penyelesaian tanpa ejen UIUC dengan mudah menyelesaikan masalah pengaturcaraan sebenar SWE-bench

Jul 17, 2024 pm 10:02 PM

Mendahului senarai jurutera perisian AI sumber terbuka, penyelesaian tanpa ejen UIUC dengan mudah menyelesaikan masalah pengaturcaraan sebenar SWE-bench

Jul 17, 2024 pm 10:02 PM

Lajur AIxiv ialah lajur di mana tapak ini menerbitkan kandungan akademik dan teknikal. Dalam beberapa tahun kebelakangan ini, lajur AIxiv laman web ini telah menerima lebih daripada 2,000 laporan, meliputi makmal terkemuka dari universiti dan syarikat utama di seluruh dunia, mempromosikan pertukaran dan penyebaran akademik secara berkesan. Jika anda mempunyai kerja yang sangat baik yang ingin anda kongsikan, sila berasa bebas untuk menyumbang atau hubungi kami untuk melaporkan. E-mel penyerahan: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com Semua pengarang kertas kerja ini adalah daripada pasukan guru Zhang Lingming di Universiti Illinois di Urbana-Champaign (UIUC), termasuk: Steven Code repair; pelajar kedoktoran tahun empat, penyelidik

Alat dengar Meta Quest 3S VR mampu milik baharu muncul di FCC, mencadangkan pelancaran yang akan berlaku

Sep 04, 2024 am 06:51 AM

Alat dengar Meta Quest 3S VR mampu milik baharu muncul di FCC, mencadangkan pelancaran yang akan berlaku

Sep 04, 2024 am 06:51 AM

Acara Meta Connect 2024 ditetapkan pada 25 hingga 26 September, dan dalam acara ini, syarikat itu dijangka memperkenalkan set kepala realiti maya mampu milik baharu. Dikhabarkan sebagai Meta Quest 3S, set kepala VR nampaknya telah muncul pada penyenaraian FCC. cadangan ini

Kerja selepas kematian Pasukan Penyelarasan Super OpenAI: Dua model besar bermain permainan, dan output menjadi lebih mudah difahami

Jul 19, 2024 am 01:29 AM

Kerja selepas kematian Pasukan Penyelarasan Super OpenAI: Dua model besar bermain permainan, dan output menjadi lebih mudah difahami

Jul 19, 2024 am 01:29 AM

Jika jawapan yang diberikan oleh model AI tidak dapat difahami sama sekali, adakah anda berani menggunakannya? Memandangkan sistem pembelajaran mesin digunakan dalam bidang yang lebih penting, menjadi semakin penting untuk menunjukkan sebab kita boleh mempercayai output mereka, dan bila tidak mempercayainya. Satu cara yang mungkin untuk mendapatkan kepercayaan dalam output sistem yang kompleks adalah dengan menghendaki sistem menghasilkan tafsiran outputnya yang boleh dibaca oleh manusia atau sistem lain yang dipercayai, iaitu, difahami sepenuhnya sehingga apa-apa ralat yang mungkin boleh dilakukan. dijumpai. Contohnya, untuk membina kepercayaan dalam sistem kehakiman, kami memerlukan mahkamah memberikan pendapat bertulis yang jelas dan boleh dibaca yang menjelaskan dan menyokong keputusan mereka. Untuk model bahasa yang besar, kita juga boleh menggunakan pendekatan yang sama. Walau bagaimanapun, apabila mengambil pendekatan ini, pastikan model bahasa menjana

Model sumber terbuka pertama yang melepasi tahap GPT4o! Llama 3.1 bocor: 405 bilion parameter, pautan muat turun dan kad model tersedia

Jul 23, 2024 pm 08:51 PM

Model sumber terbuka pertama yang melepasi tahap GPT4o! Llama 3.1 bocor: 405 bilion parameter, pautan muat turun dan kad model tersedia

Jul 23, 2024 pm 08:51 PM

Sediakan GPU anda! Llama3.1 akhirnya muncul, tetapi sumbernya bukan Meta rasmi. Hari ini, berita bocor versi baharu model besar Llama menjadi tular di Reddit Selain model asas, ia juga termasuk hasil penanda aras 8B, 70B dan parameter maksimum 405B. Rajah di bawah menunjukkan hasil perbandingan setiap versi Llama3.1 dengan OpenAIGPT-4o dan Llama38B/70B. Ia boleh dilihat bahawa walaupun versi 70B melebihi GPT-4o pada pelbagai penanda aras. Sumber imej: https://x.com/mattshumer_/status/1815444612414087294 Jelas sekali, versi 3.1 daripada 8B dan 70

Kertas arXiv boleh disiarkan sebagai 'bertubi-tubi', platform perbincangan Stanford alphaXiv dalam talian, LeCun menyukainya

Aug 01, 2024 pm 05:18 PM

Kertas arXiv boleh disiarkan sebagai 'bertubi-tubi', platform perbincangan Stanford alphaXiv dalam talian, LeCun menyukainya

Aug 01, 2024 pm 05:18 PM

sorakan! Bagaimana rasanya apabila perbincangan kertas adalah perkataan? Baru-baru ini, pelajar di Universiti Stanford mencipta alphaXiv, forum perbincangan terbuka untuk kertas arXiv yang membenarkan soalan dan ulasan disiarkan terus pada mana-mana kertas arXiv. Pautan laman web: https://alphaxiv.org/ Malah, tidak perlu melawati tapak web ini secara khusus. Hanya tukar arXiv dalam mana-mana URL kepada alphaXiv untuk terus membuka kertas yang sepadan di forum alphaXiv: anda boleh mencari perenggan dengan tepat dalam. kertas itu, Ayat: Dalam ruang perbincangan di sebelah kanan, pengguna boleh menyiarkan soalan untuk bertanya kepada pengarang tentang idea dan butiran kertas tersebut Sebagai contoh, mereka juga boleh mengulas kandungan kertas tersebut, seperti: "Diberikan kepada

Latihan aksiomatik membolehkan LLM mempelajari penaakulan kausal: model 67 juta parameter adalah setanding dengan trilion tahap parameter GPT-4

Jul 17, 2024 am 10:14 AM

Latihan aksiomatik membolehkan LLM mempelajari penaakulan kausal: model 67 juta parameter adalah setanding dengan trilion tahap parameter GPT-4

Jul 17, 2024 am 10:14 AM

Tunjukkan rantai sebab kepada LLM dan ia mempelajari aksiom. AI sudah pun membantu ahli matematik dan saintis menjalankan penyelidikan Contohnya, ahli matematik terkenal Terence Tao telah berulang kali berkongsi pengalaman penyelidikan dan penerokaannya dengan bantuan alatan AI seperti GPT. Untuk AI bersaing dalam bidang ini, keupayaan penaakulan sebab yang kukuh dan boleh dipercayai adalah penting. Penyelidikan yang akan diperkenalkan dalam artikel ini mendapati bahawa model Transformer yang dilatih mengenai demonstrasi aksiom transitiviti sebab pada graf kecil boleh digeneralisasikan kepada aksiom transitiviti pada graf besar. Dalam erti kata lain, jika Transformer belajar untuk melakukan penaakulan sebab yang mudah, ia boleh digunakan untuk penaakulan sebab yang lebih kompleks. Rangka kerja latihan aksiomatik yang dicadangkan oleh pasukan adalah paradigma baharu untuk pembelajaran penaakulan sebab berdasarkan data pasif, dengan hanya demonstrasi

Satu kejayaan ketara dalam Hipotesis Riemann! Tao Zhexuan amat mengesyorkan kertas kerja baharu daripada MIT dan Oxford, dan pemenang Fields Medal berusia 37 tahun mengambil bahagian

Aug 05, 2024 pm 03:32 PM

Satu kejayaan ketara dalam Hipotesis Riemann! Tao Zhexuan amat mengesyorkan kertas kerja baharu daripada MIT dan Oxford, dan pemenang Fields Medal berusia 37 tahun mengambil bahagian

Aug 05, 2024 pm 03:32 PM

Baru-baru ini, Hipotesis Riemann, yang dikenali sebagai salah satu daripada tujuh masalah utama milenium, telah mencapai kejayaan baharu. Hipotesis Riemann ialah masalah yang tidak dapat diselesaikan yang sangat penting dalam matematik, berkaitan dengan sifat tepat taburan nombor perdana (nombor perdana ialah nombor yang hanya boleh dibahagikan dengan 1 dan dirinya sendiri, dan ia memainkan peranan asas dalam teori nombor). Dalam kesusasteraan matematik hari ini, terdapat lebih daripada seribu proposisi matematik berdasarkan penubuhan Hipotesis Riemann (atau bentuk umumnya). Dalam erti kata lain, sebaik sahaja Hipotesis Riemann dan bentuk umumnya dibuktikan, lebih daripada seribu proposisi ini akan ditetapkan sebagai teorem, yang akan memberi kesan yang mendalam terhadap bidang matematik dan jika Hipotesis Riemann terbukti salah, maka antara cadangan ini sebahagian daripadanya juga akan kehilangan keberkesanannya. Kejayaan baharu datang daripada profesor matematik MIT Larry Guth dan Universiti Oxford