Isu reka bentuk ganjaran dalam pembelajaran pengukuhan

Isu reka bentuk ganjaran dalam pembelajaran pengukuhan memerlukan contoh kod khusus

Pembelajaran pengukuhan ialah kaedah pembelajaran mesin yang matlamatnya adalah untuk mempelajari cara mengambil tindakan yang memaksimumkan ganjaran terkumpul melalui interaksi dengan persekitaran. Dalam pembelajaran peneguhan, ganjaran memainkan peranan penting Ia merupakan isyarat dalam proses pembelajaran ejen dan digunakan untuk membimbing tingkah lakunya. Walau bagaimanapun, reka bentuk ganjaran adalah masalah yang mencabar, dan reka bentuk ganjaran yang munasabah boleh mempengaruhi prestasi algoritma pembelajaran pengukuhan.

Dalam pembelajaran pengukuhan, ganjaran boleh dilihat sebagai jambatan komunikasi antara ejen dan persekitaran, yang boleh memberitahu ejen betapa baik atau buruknya tindakan semasa. Secara umumnya, ganjaran boleh dibahagikan kepada dua jenis: ganjaran jarang dan ganjaran padat. Ganjaran jarang merujuk kepada ganjaran yang diberikan pada hanya beberapa titik masa tertentu dalam tugasan, manakala ganjaran padat mempunyai isyarat ganjaran pada setiap titik masa. Ganjaran yang padat memudahkan ejen mempelajari strategi tindakan yang betul daripada ganjaran yang jarang kerana ia memberikan lebih banyak maklumat maklum balas. Walau bagaimanapun, ganjaran jarang adalah lebih biasa dalam tugas dunia sebenar, yang membawa cabaran kepada reka bentuk ganjaran.

Matlamat reka bentuk ganjaran adalah untuk memberikan ejen isyarat maklum balas yang paling tepat yang mungkin supaya ia dapat mempelajari strategi terbaik dengan cepat dan berkesan. Dalam kebanyakan kes, kami mahukan fungsi ganjaran yang memberikan ganjaran yang tinggi apabila ejen mencapai matlamat yang telah ditetapkan, dan ganjaran atau penalti yang rendah apabila ejen membuat keputusan yang salah. Walau bagaimanapun, mereka bentuk fungsi ganjaran yang munasabah bukanlah tugas yang mudah.

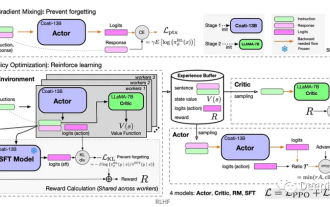

Untuk menyelesaikan masalah reka bentuk ganjaran, pendekatan biasa adalah menggunakan demonstrasi berasaskan pakar manusia untuk membimbing pembelajaran ejen. Dalam kes ini, pakar manusia memberikan ejen satu siri urutan tindakan sampel dan ganjaran mereka Ejen belajar daripada sampel ini untuk membiasakan diri dengan tugas itu dan secara beransur-ansur meningkatkan strateginya dalam interaksi seterusnya. Kaedah ini boleh menyelesaikan masalah reka bentuk ganjaran dengan berkesan, tetapi ia juga meningkatkan kos buruh, dan sampel pakar mungkin tidak betul sepenuhnya.

Pendekatan lain ialah menggunakan pembelajaran peneguhan songsang (Inverse Reinforcement Learning) untuk menyelesaikan masalah reka bentuk ganjaran. Pembelajaran peneguhan songsang ialah kaedah memperoleh fungsi ganjaran daripada tingkah laku yang diperhatikan. Ia menganggap bahawa ejen cuba memaksimumkan fungsi ganjaran yang berpotensi semasa proses pembelajaran Dengan memperoleh secara songsang fungsi ganjaran ini daripada tingkah laku yang diperhatikan, Ejen boleh disediakan dengan lebih isyarat ganjaran yang tepat. Idea teras pembelajaran peneguhan songsang adalah untuk mentafsir tingkah laku yang diperhatikan sebagai strategi optimum dan membimbing pembelajaran ejen dengan menyimpulkan fungsi ganjaran yang sepadan dengan strategi optimum ini.

Berikut ialah contoh kod mudah pembelajaran peneguhan songsang, menunjukkan cara membuat kesimpulan fungsi ganjaran daripada tingkah laku yang diperhatikan:

import numpy as np

def inverse_reinforcement_learning(expert_trajectories):

# 计算状态特征向量的均值

feature_mean = np.mean(expert_trajectories, axis=0)

# 构建状态特征矩阵

feature_matrix = np.zeros((len(expert_trajectories), len(feature_mean)))

for i in range(len(expert_trajectories)):

feature_matrix[i] = expert_trajectories[i] - feature_mean

# 使用最小二乘法求解奖励函数的权重向量

weights = np.linalg.lstsq(feature_matrix, np.ones((len(expert_trajectories),)))[0]

return weights

# 生成示例轨迹数据

expert_trajectories = np.array([[1, 1], [1, 2], [2, 1], [2, 2]])

# 使用逆强化学习得到奖励函数的权重向量

weights = inverse_reinforcement_learning(expert_trajectories)

print("奖励函数的权重向量:", weights)Kod di atas menggunakan kaedah kuasa dua terkecil untuk menyelesaikan vektor berat fungsi ganjaran boleh digunakan untuk mengira ganjaran mana-mana vektor ciri keadaan. Melalui pembelajaran peneguhan songsang, fungsi ganjaran yang munasabah boleh dipelajari daripada data sampel untuk membimbing proses pembelajaran ejen.

Ringkasnya, reka bentuk ganjaran merupakan isu penting dan mencabar dalam pembelajaran pengukuhan. Reka bentuk ganjaran yang munasabah boleh mempengaruhi prestasi algoritma pembelajaran pengukuhan. Dengan memanfaatkan kaedah seperti demonstrasi berasaskan pakar manusia atau pembelajaran peneguhan songsang, masalah reka bentuk ganjaran dapat diselesaikan dan ejen boleh diberikan isyarat ganjaran yang tepat untuk membimbing proses pembelajarannya.

Atas ialah kandungan terperinci Isu reka bentuk ganjaran dalam pembelajaran pengukuhan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

Isu reka bentuk fungsi ganjaran dalam pembelajaran pengukuhan

Oct 09, 2023 am 11:58 AM

Isu reka bentuk fungsi ganjaran dalam pembelajaran pengukuhan

Oct 09, 2023 am 11:58 AM

Isu reka bentuk fungsi ganjaran dalam pembelajaran peneguhan Pengenalan Pembelajaran peneguhan ialah kaedah yang mempelajari strategi optimum melalui interaksi antara ejen dan persekitaran. Dalam pembelajaran pengukuhan, reka bentuk fungsi ganjaran adalah penting untuk kesan pembelajaran ejen. Artikel ini akan meneroka isu reka bentuk fungsi ganjaran dalam pembelajaran pengukuhan dan memberikan contoh kod khusus. Peranan fungsi ganjaran dan fungsi ganjaran sasaran merupakan bahagian penting dalam pembelajaran peneguhan dan digunakan untuk menilai nilai ganjaran yang diperolehi oleh ejen dalam keadaan tertentu. Reka bentuknya membantu membimbing ejen untuk memaksimumkan keletihan jangka panjang dengan memilih tindakan yang optimum.

Teknologi pembelajaran pengukuhan mendalam dalam C++

Aug 21, 2023 pm 11:33 PM

Teknologi pembelajaran pengukuhan mendalam dalam C++

Aug 21, 2023 pm 11:33 PM

Teknologi pembelajaran pengukuhan mendalam ialah cabang kecerdasan buatan yang telah menarik banyak perhatian Ia telah memenangi pelbagai pertandingan antarabangsa dan juga digunakan secara meluas dalam pembantu peribadi, pemanduan autonomi, kecerdasan permainan dan bidang lain. Dalam proses merealisasikan pembelajaran pengukuhan mendalam, C++, sebagai bahasa pengaturcaraan yang cekap dan cemerlang, amat penting apabila sumber perkakasan adalah terhad. Pembelajaran peneguhan mendalam, seperti namanya, menggabungkan teknologi daripada dua bidang pembelajaran mendalam dan pembelajaran pengukuhan. Untuk memahami secara ringkas, pembelajaran mendalam merujuk kepada ciri pembelajaran daripada data dan membuat keputusan dengan membina rangkaian neural berbilang lapisan.

Pembelajaran pengukuhan Q-pembelajaran mendalam menggunakan simulasi lengan robot Panda-Gym

Oct 31, 2023 pm 05:57 PM

Pembelajaran pengukuhan Q-pembelajaran mendalam menggunakan simulasi lengan robot Panda-Gym

Oct 31, 2023 pm 05:57 PM

Pembelajaran pengukuhan (RL) ialah kaedah pembelajaran mesin yang membolehkan ejen mempelajari cara berkelakuan dalam persekitarannya melalui percubaan dan kesilapan. Ejen diberi ganjaran atau dihukum kerana mengambil tindakan yang membawa kepada hasil yang diingini. Dari masa ke masa, ejen belajar untuk mengambil tindakan yang memaksimumkan ganjaran yang dijangkakan. Ejen RL biasanya dilatih menggunakan proses keputusan Markov (MDP), rangka kerja matematik untuk memodelkan masalah keputusan berjujukan. MDP terdiri daripada empat bahagian: Nyatakan: satu set kemungkinan keadaan persekitaran. Tindakan: Satu set tindakan yang boleh diambil oleh ejen. Fungsi peralihan: Fungsi yang meramalkan kebarangkalian peralihan kepada keadaan baharu memandangkan keadaan dan tindakan semasa. Fungsi ganjaran: Fungsi yang memberikan ganjaran kepada ejen untuk setiap penukaran. Matlamat ejen adalah untuk mempelajari fungsi polisi,

Selesaikan masalah 'ralat: definisi semula kelas 'Nama Kelas'' yang muncul dalam kod C++

Aug 25, 2023 pm 06:01 PM

Selesaikan masalah 'ralat: definisi semula kelas 'Nama Kelas'' yang muncul dalam kod C++

Aug 25, 2023 pm 06:01 PM

Selesaikan masalah "error:redefinitionofclass'ClassName'" dalam kod C++ Dalam pengaturcaraan C++, kita sering menghadapi pelbagai ralat kompilasi. Salah satu ralat biasa ialah "error:redefinitionofclass 'ClassName'" (ralat definisi semula kelas 'ClassName'). Ralat ini biasanya berlaku apabila kelas yang sama ditakrifkan beberapa kali. Artikel ini akan

Bagaimana untuk menyelesaikan masalah yang jQuery tidak dapat memperoleh nilai elemen bentuk

Feb 19, 2024 pm 02:01 PM

Bagaimana untuk menyelesaikan masalah yang jQuery tidak dapat memperoleh nilai elemen bentuk

Feb 19, 2024 pm 02:01 PM

Untuk menyelesaikan masalah yang jQuery.val() tidak boleh digunakan, contoh kod khusus diperlukan Untuk pembangun bahagian hadapan, menggunakan jQuery ialah salah satu operasi biasa. Antaranya, menggunakan kaedah .val() untuk mendapatkan atau menetapkan nilai elemen borang adalah operasi yang sangat biasa. Walau bagaimanapun, dalam beberapa kes tertentu, masalah tidak dapat menggunakan kaedah .val() mungkin timbul. Artikel ini akan memperkenalkan beberapa situasi dan penyelesaian biasa, serta memberikan contoh kod khusus. Penerangan Masalah Apabila menggunakan jQuery untuk membangunkan halaman hadapan, kadangkala anda akan menghadapi

Ajar anda cara mendiagnosis masalah iPhone biasa

Dec 03, 2023 am 08:15 AM

Ajar anda cara mendiagnosis masalah iPhone biasa

Dec 03, 2023 am 08:15 AM

Dikenali dengan prestasi yang berkuasa dan ciri serba boleh, iPhone tidak terlepas daripada cegukan atau kesukaran teknikal sekali-sekala, ciri biasa di kalangan peranti elektronik yang kompleks. Mengalami masalah iPhone boleh mengecewakan, tetapi biasanya penggera tidak diperlukan. Dalam panduan komprehensif ini, kami menyasarkan untuk menyahmistifikasi beberapa cabaran yang paling biasa dihadapi yang berkaitan dengan penggunaan iPhone. Pendekatan langkah demi langkah kami direka untuk membantu anda menyelesaikan isu lazim ini, menyediakan penyelesaian praktikal dan petua penyelesaian masalah untuk mengembalikan peralatan anda dalam keadaan berfungsi terbaik. Sama ada anda menghadapi masalah atau isu yang lebih kompleks, artikel ini boleh membantu anda menyelesaikannya dengan berkesan. Petua Penyelesaian Masalah Umum Sebelum menyelidiki langkah penyelesaian masalah khusus, berikut adalah beberapa yang berguna

Belajar memasang papan litar dalam masa 20 minit! Rangka kerja SERL sumber terbuka mempunyai kadar kejayaan kawalan ketepatan 100% dan tiga kali lebih pantas daripada manusia

Feb 21, 2024 pm 03:31 PM

Belajar memasang papan litar dalam masa 20 minit! Rangka kerja SERL sumber terbuka mempunyai kadar kejayaan kawalan ketepatan 100% dan tiga kali lebih pantas daripada manusia

Feb 21, 2024 pm 03:31 PM

Kini, robot boleh mempelajari tugas kawalan kilang ketepatan. Dalam tahun-tahun kebelakangan ini, kemajuan ketara telah dicapai dalam bidang teknologi pembelajaran pengukuhan robot, seperti berjalan berkaki empat, menggenggam, manipulasi ketangkasan, dan lain-lain, tetapi kebanyakannya terhad kepada peringkat demonstrasi makmal. Menggunakan teknologi pembelajaran pengukuhan robot secara meluas kepada persekitaran pengeluaran sebenar masih menghadapi banyak cabaran, yang pada tahap tertentu mengehadkan skop aplikasinya dalam senario sebenar. Dalam proses aplikasi praktikal teknologi pembelajaran pengukuhan, adalah perlu untuk mengatasi pelbagai masalah kompleks termasuk penetapan mekanisme ganjaran, penetapan semula persekitaran, peningkatan kecekapan sampel, dan jaminan keselamatan tindakan. Pakar industri menekankan bahawa menyelesaikan banyak masalah dalam pelaksanaan sebenar teknologi pembelajaran tetulang adalah sama pentingnya dengan inovasi berterusan algoritma itu sendiri. Menghadapi cabaran ini, penyelidik dari Universiti California, Berkeley, Universiti Stanford, Universiti Washington, dan

Masalah penilaian kesan pengelompokan dalam algoritma pengelompokan

Oct 10, 2023 pm 01:12 PM

Masalah penilaian kesan pengelompokan dalam algoritma pengelompokan

Oct 10, 2023 pm 01:12 PM

Masalah penilaian kesan pengelompokan dalam algoritma pengelompokan memerlukan contoh kod khusus Pengelompokan ialah kaedah pembelajaran tanpa pengawasan yang mengelompokkan sampel yang serupa ke dalam satu kategori dengan mengelompokkan data. Dalam algoritma pengelompokan, cara menilai kesan pengelompokan adalah isu penting. Artikel ini akan memperkenalkan beberapa penunjuk penilaian kesan pengelompokan yang biasa digunakan dan memberikan contoh kod yang sepadan. 1. Indeks penilaian kesan pengelompokan Pekali Siluet Pekali siluet menilai kesan pengelompokan dengan mengira kehampiran sampel dan tahap pemisahan daripada kelompok lain.