Peranti teknologi

Peranti teknologi

AI

AI

Masalah pengecaman entiti dinamakan dalam teknologi pemprosesan bahasa semula jadi

Masalah pengecaman entiti dinamakan dalam teknologi pemprosesan bahasa semula jadi

Masalah pengecaman entiti dinamakan dalam teknologi pemprosesan bahasa semula jadi

Masalah pengecaman entiti bernama dalam teknologi pemprosesan bahasa semula jadi memerlukan contoh kod khusus

Pengenalan:

Dalam bidang pemprosesan bahasa semula jadi (NLP), Pengecaman Entiti Dinamakan (NER) adalah tugas teras . Ia bertujuan untuk mengenal pasti kategori khusus entiti yang dinamakan daripada teks, seperti nama orang, nama tempat, nama organisasi, dsb. Teknologi NER digunakan secara meluas dalam pengekstrakan maklumat, sistem menjawab soalan, terjemahan mesin dan bidang lain. Artikel ini akan memperkenalkan latar belakang dan prinsip NER, dan memberikan contoh kod mudah yang dilaksanakan dalam Python.

1. Latar belakang dan prinsip NER ialah tugas penting dalam pemprosesan bahasa semula jadi Ia boleh membantu komputer memahami maklumat entiti dalam teks, dengan itu melakukan analisis semantik dan pengekstrakan maklumat dengan lebih baik. NER terutamanya merangkumi tiga langkah berikut:

- Tokenisasi: Pisahkan teks kepada perkataan atau sub-perkataan. Pembahagian perkataan ialah tugas asas dalam NLP dan boleh diproses menggunakan alat atau pustaka pembahagian perkataan biasa (seperti NLTK, jieba, dll.).

- Pengeluaran Ciri: Ekstrak ciri yang berkaitan dengan pengecaman entiti daripada teks berdasarkan hasil pembahagian perkataan. Ciri biasanya termasuk sebahagian daripada ucapan, hubungan kontekstual, kekerapan perkataan, dsb.

- Pengkelasan dan Penandaan Entiti: Masukkan ciri ke dalam model pembelajaran mesin untuk pengelasan dan penandaan entiti. Algoritma pembelajaran mesin yang biasa digunakan termasuk medan rawak bersyarat (CRF), mesin vektor sokongan (SVM), model pembelajaran mendalam (seperti rangkaian saraf berulang, rangkaian saraf konvolusi), dsb.

Berikut ialah contoh kod ringkas menggunakan pustaka Python dan NLTK untuk melaksanakan NER:

import nltk

from nltk.tokenize import word_tokenize

from nltk.tag import pos_tag

from nltk.chunk import ne_chunk

def ner(text):

# 分词

tokens = word_tokenize(text)

# 词性标注

tagged = pos_tag(tokens)

# 命名实体识别

entities = ne_chunk(tagged)

return entities

text = "Barack Obama was born in Hawaii."

result = ner(text)

print(result)- Import perpustakaan nltk dan modul berkaitan.

- Tentukan fungsi yang dipanggil ner yang menerima parameter teks.

- Dalam fungsi ner, word_tokenize mula-mula digunakan untuk membahagikan teks dan membahagikan teks kepada urutan perkataan.

- Kemudian gunakan pos_tag untuk menandakan hasil segmentasi perkataan untuk mendapatkan maklumat bahagian pertuturan setiap perkataan.

- Akhir sekali, gunakan ne_chunk untuk melaksanakan pengecaman entiti bernama pada hasil penandaan sebahagian daripada pertuturan untuk mendapatkan pepohon entiti bernama.

- Program ini akan mengeluarkan pokok entiti bernama, struktur seperti pokok yang mengandungi entiti.

Artikel ini memperkenalkan kepentingan dan prinsip pengecaman entiti bernama (NER) dalam pemprosesan bahasa semula jadi, dan memberikan contoh kod ringkas yang dilaksanakan dalam Python. Sudah tentu, terdapat banyak aplikasi teknologi NER, termasuk penyahduplikasian entiti, pengekstrakan perhubungan entiti yang dinamakan, dsb. Pembaca yang berminat boleh terus mempelajari dan meneroka pengetahuan berkaitan secara mendalam.

Atas ialah kandungan terperinci Masalah pengecaman entiti dinamakan dalam teknologi pemprosesan bahasa semula jadi. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1371

1371

52

52

Kertas Stable Diffusion 3 akhirnya telah dikeluarkan, dan butiran seni bina didedahkan Adakah ia akan membantu untuk menghasilkan semula Sora?

Mar 06, 2024 pm 05:34 PM

Kertas Stable Diffusion 3 akhirnya telah dikeluarkan, dan butiran seni bina didedahkan Adakah ia akan membantu untuk menghasilkan semula Sora?

Mar 06, 2024 pm 05:34 PM

Kertas StableDiffusion3 akhirnya di sini! Model ini dikeluarkan dua minggu lalu dan menggunakan seni bina DiT (DiffusionTransformer) yang sama seperti Sora. Ia menimbulkan kekecohan apabila ia dikeluarkan. Berbanding dengan versi sebelumnya, kualiti imej yang dijana oleh StableDiffusion3 telah dipertingkatkan dengan ketara Ia kini menyokong gesaan berbilang tema, dan kesan penulisan teks juga telah dipertingkatkan, dan aksara bercelaru tidak lagi muncul. StabilityAI menegaskan bahawa StableDiffusion3 ialah satu siri model dengan saiz parameter antara 800M hingga 8B. Julat parameter ini bermakna model boleh dijalankan terus pada banyak peranti mudah alih, dengan ketara mengurangkan penggunaan AI

Artikel ini sudah cukup untuk anda membaca tentang pemanduan autonomi dan ramalan trajektori!

Feb 28, 2024 pm 07:20 PM

Artikel ini sudah cukup untuk anda membaca tentang pemanduan autonomi dan ramalan trajektori!

Feb 28, 2024 pm 07:20 PM

Ramalan trajektori memainkan peranan penting dalam pemanduan autonomi Ramalan trajektori pemanduan autonomi merujuk kepada meramalkan trajektori pemanduan masa hadapan kenderaan dengan menganalisis pelbagai data semasa proses pemanduan kenderaan. Sebagai modul teras pemanduan autonomi, kualiti ramalan trajektori adalah penting untuk kawalan perancangan hiliran. Tugas ramalan trajektori mempunyai timbunan teknologi yang kaya dan memerlukan kebiasaan dengan persepsi dinamik/statik pemanduan autonomi, peta ketepatan tinggi, garisan lorong, kemahiran seni bina rangkaian saraf (CNN&GNN&Transformer), dll. Sangat sukar untuk bermula! Ramai peminat berharap untuk memulakan ramalan trajektori secepat mungkin dan mengelakkan perangkap Hari ini saya akan mengambil kira beberapa masalah biasa dan kaedah pembelajaran pengenalan untuk ramalan trajektori! Pengetahuan berkaitan pengenalan 1. Adakah kertas pratonton teratur? A: Tengok survey dulu, hlm

DualBEV: mengatasi BEVFormer dan BEVDet4D dengan ketara, buka buku!

Mar 21, 2024 pm 05:21 PM

DualBEV: mengatasi BEVFormer dan BEVDet4D dengan ketara, buka buku!

Mar 21, 2024 pm 05:21 PM

Kertas kerja ini meneroka masalah mengesan objek dengan tepat dari sudut pandangan yang berbeza (seperti perspektif dan pandangan mata burung) dalam pemanduan autonomi, terutamanya cara mengubah ciri dari perspektif (PV) kepada ruang pandangan mata burung (BEV) dengan berkesan dilaksanakan melalui modul Transformasi Visual (VT). Kaedah sedia ada secara amnya dibahagikan kepada dua strategi: penukaran 2D kepada 3D dan 3D kepada 2D. Kaedah 2D-ke-3D meningkatkan ciri 2D yang padat dengan meramalkan kebarangkalian kedalaman, tetapi ketidakpastian yang wujud dalam ramalan kedalaman, terutamanya di kawasan yang jauh, mungkin menimbulkan ketidaktepatan. Manakala kaedah 3D ke 2D biasanya menggunakan pertanyaan 3D untuk mencuba ciri 2D dan mempelajari berat perhatian bagi kesesuaian antara ciri 3D dan 2D melalui Transformer, yang meningkatkan masa pengiraan dan penggunaan.

'Minecraft' bertukar menjadi bandar AI, dan penduduk NPC memainkan peranan seperti orang sebenar

Jan 02, 2024 pm 06:25 PM

'Minecraft' bertukar menjadi bandar AI, dan penduduk NPC memainkan peranan seperti orang sebenar

Jan 02, 2024 pm 06:25 PM

Sila ambil perhatian bahawa lelaki persegi ini berkerut dahi, memikirkan identiti "tetamu tidak diundang" di hadapannya. Ternyata dia berada dalam situasi berbahaya, dan apabila dia menyedari perkara ini, dia segera memulakan pencarian mental untuk mencari strategi untuk menyelesaikan masalah itu. Akhirnya, dia memutuskan untuk melarikan diri dari tempat kejadian dan kemudian mendapatkan bantuan secepat mungkin dan mengambil tindakan segera. Pada masa yang sama, orang di seberang sana memikirkan perkara yang sama seperti dia... Terdapat adegan sedemikian dalam "Minecraft" di mana semua watak dikawal oleh kecerdasan buatan. Setiap daripada mereka mempunyai latar identiti yang unik Contohnya, gadis yang disebutkan sebelum ini adalah seorang kurier berusia 17 tahun tetapi bijak dan berani. Mereka mempunyai daya ingatan dan pemikiran serta hidup seperti manusia di bandar kecil yang terletak di Minecraft ini. Apa yang mendorong mereka adalah sesuatu yang baru,

Bagaimanakah penggunaan fungsi Java dalam pemprosesan bahasa semula jadi memudahkan interaksi perbualan?

Apr 30, 2024 am 08:03 AM

Bagaimanakah penggunaan fungsi Java dalam pemprosesan bahasa semula jadi memudahkan interaksi perbualan?

Apr 30, 2024 am 08:03 AM

Fungsi Java digunakan secara meluas dalam NLP untuk mencipta penyelesaian tersuai yang meningkatkan pengalaman interaksi perbualan. Fungsi ini boleh digunakan untuk prapemprosesan teks, analisis sentimen, pengecaman niat dan pengekstrakan entiti. Contohnya, dengan menggunakan fungsi Java untuk analisis sentimen, aplikasi boleh memahami nada pengguna dan bertindak balas dengan sewajarnya, meningkatkan pengalaman perbualan.

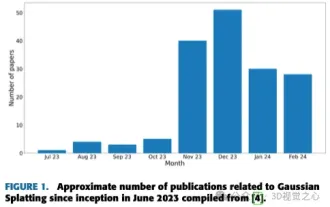

Lebih daripada sekadar Gaussian 3D! Gambaran keseluruhan terkini teknik pembinaan semula 3D yang terkini

Jun 02, 2024 pm 06:57 PM

Lebih daripada sekadar Gaussian 3D! Gambaran keseluruhan terkini teknik pembinaan semula 3D yang terkini

Jun 02, 2024 pm 06:57 PM

Ditulis di atas & Pemahaman peribadi penulis ialah pembinaan semula 3D berasaskan imej ialah tugas mencabar yang melibatkan membuat inferens bentuk 3D objek atau pemandangan daripada set imej input. Kaedah berasaskan pembelajaran telah menarik perhatian kerana keupayaan mereka untuk menganggar secara langsung bentuk 3D. Kertas ulasan ini memfokuskan pada teknik pembinaan semula 3D yang canggih, termasuk menjana novel, pandangan ghaib. Gambaran keseluruhan perkembangan terkini dalam kaedah percikan Gaussian disediakan, termasuk jenis input, struktur model, perwakilan output dan strategi latihan. Cabaran yang tidak dapat diselesaikan dan hala tuju masa depan turut dibincangkan. Memandangkan kemajuan pesat dalam bidang ini dan banyak peluang untuk meningkatkan kaedah pembinaan semula 3D, pemeriksaan menyeluruh terhadap algoritma nampaknya penting. Oleh itu, kajian ini memberikan gambaran menyeluruh tentang kemajuan terkini dalam serakan Gaussian. (Leret ibu jari anda ke atas

Semakan! Gabungan model mendalam (LLM/model asas/pembelajaran bersekutu/penalaan halus, dsb.)

Apr 18, 2024 pm 09:43 PM

Semakan! Gabungan model mendalam (LLM/model asas/pembelajaran bersekutu/penalaan halus, dsb.)

Apr 18, 2024 pm 09:43 PM

Pada 23 September, kertas kerja "DeepModelFusion:ASurvey" diterbitkan oleh Universiti Teknologi Pertahanan Nasional, JD.com dan Institut Teknologi Beijing. Gabungan/penggabungan model dalam ialah teknologi baru muncul yang menggabungkan parameter atau ramalan berbilang model pembelajaran mendalam ke dalam satu model. Ia menggabungkan keupayaan model yang berbeza untuk mengimbangi bias dan ralat model individu untuk prestasi yang lebih baik. Gabungan model mendalam pada model pembelajaran mendalam berskala besar (seperti LLM dan model asas) menghadapi beberapa cabaran, termasuk kos pengiraan yang tinggi, ruang parameter berdimensi tinggi, gangguan antara model heterogen yang berbeza, dsb. Artikel ini membahagikan kaedah gabungan model dalam sedia ada kepada empat kategori: (1) "Sambungan corak", yang menghubungkan penyelesaian dalam ruang berat melalui laluan pengurangan kerugian untuk mendapatkan gabungan model awal yang lebih baik.

![[Python NLTK] Tutorial: Bermula dengan mudah dan berseronok dengan pemprosesan bahasa semula jadi](https://img.php.cn/upload/article/000/465/014/170882721469561.jpg?x-oss-process=image/resize,m_fill,h_207,w_330) [Python NLTK] Tutorial: Bermula dengan mudah dan berseronok dengan pemprosesan bahasa semula jadi

Feb 25, 2024 am 10:13 AM

[Python NLTK] Tutorial: Bermula dengan mudah dan berseronok dengan pemprosesan bahasa semula jadi

Feb 25, 2024 am 10:13 AM

1. Pengenalan kepada NLTK NLTK ialah kit pemprosesan bahasa semula jadi untuk bahasa pengaturcaraan Python, yang dicipta pada tahun 2001 oleh Steven Bird dan Edward Loper. NLTK menyediakan pelbagai alat pemprosesan teks, termasuk prapemprosesan teks, pembahagian perkataan, pengetegan sebahagian daripada pertuturan, analisis sintaksis, analisis semantik, dsb., yang boleh membantu pembangun memproses data bahasa semula jadi dengan mudah. 2.Pemasangan NLTK NLTK boleh dipasang melalui arahan berikut: fromnltk.tokenizeimportWord_tokenizetext="Hello, world!Thisisasampletext."tokens=word_tokenize(te