Isu reka bentuk fungsi ganjaran dalam pembelajaran pengukuhan

Isu reka bentuk fungsi ganjaran dalam pembelajaran pengukuhan

Pengenalan

Pembelajaran pengukuhan ialah kaedah pembelajaran melalui interaksi antara agen dan persekitaran. Kaedah untuk mempelajari dasar yang optimum. Dalam pembelajaran pengukuhan, reka bentuk fungsi ganjaran adalah penting untuk kesan pembelajaran ejen. Artikel ini akan meneroka isu reka bentuk fungsi ganjaran dalam pembelajaran pengukuhan dan memberikan contoh kod khusus.

- Peranan dan matlamat fungsi ganjaran

Fungsi ganjaran adalah bahagian penting dalam pembelajaran pengukuhan dan digunakan untuk menilai nilai ganjaran yang diperolehi oleh ejen dalam keadaan tertentu . Reka bentuknya membantu membimbing ejen untuk memaksimumkan ganjaran terkumpul jangka panjang dengan memilih tindakan yang optimum.

Fungsi ganjaran yang baik harus mempunyai dua matlamat berikut:

(1) Menyediakan maklumat yang mencukupi untuk membolehkan ejen mempelajari strategi optimum; Bimbing ejen untuk mengelakkan tingkah laku yang tidak berkesan dan berbahaya melalui maklum balas ganjaran yang sesuai.

- Cabaran dalam reka bentuk fungsi ganjaran

- Reka bentuk fungsi ganjaran mungkin menghadapi cabaran berikut:

(1) Sparsity: Dalam sesetengah kes, isyarat ganjaran persekitaran Mungkin jarang menyebabkan proses pembelajaran menjadi lambat atau tidak stabil.

(2) Mengelirukan: Isyarat ganjaran yang tidak betul atau tidak mencukupi boleh menyebabkan ejen mempelajari strategi yang salah.

(3) Dimensi tinggi: Dalam persekitaran yang kompleks dengan bilangan keadaan dan tindakan yang banyak, ia menjadi lebih sukar untuk mereka bentuk fungsi ganjaran.

(4) Konflik matlamat: Matlamat yang berbeza boleh menyebabkan konflik dalam reka bentuk fungsi ganjaran, seperti keseimbangan antara matlamat jangka pendek dan jangka panjang.

Kaedah untuk reka bentuk fungsi ganjaran - Untuk mengatasi cabaran dalam reka bentuk fungsi ganjaran, kaedah berikut boleh digunakan:

- Contoh kod khusus

- Berikut ialah contoh kod menggunakan rangka kerja pembelajaran tetulang mendalam TensorFlow dan Keras, menunjukkan cara fungsi ganjaran direka bentuk:

#🎜🎜 #import numpy as np from tensorflow import keras # 定义强化学习智能体的奖励函数 def reward_function(state, action): # 根据当前状态和动作计算奖励值 reward = 0 # 添加奖励和惩罚条件 if state == 0 and action == 0: reward += 1 elif state == 1 and action == 1: reward -= 1 return reward # 定义强化学习智能体的神经网络模型 def create_model(): model = keras.Sequential([ keras.layers.Dense(64, activation='relu', input_shape=(2,)), keras.layers.Dense(64, activation='relu'), keras.layers.Dense(1) ]) model.compile(optimizer='adam', loss='mean_squared_error') return model # 训练智能体 def train_agent(): model = create_model() # 智能体的训练过程 for episode in range(num_episodes): state = initial_state # 智能体根据当前策略选择动作 action = model.predict(state) # 获得当前状态下的奖励值 reward = reward_function(state, action) # 更新模型的权重 model.fit(state, reward)Salin selepas log masukDalam kod di atas, kami mereka bentuk fungsi ganjaran dengan mentakrifkan fungsi ganjaran_fungsi, dan mengira nilai ganjaran berdasarkan keadaan semasa dan tindakan semasa melatih ejen. Pada masa yang sama, kami menggunakan fungsi create_model untuk mencipta model rangkaian saraf untuk melatih ejen, dan menggunakan fungsi model.predict untuk memilih tindakan berdasarkan strategi semasa.

Kesimpulan

Reka bentuk fungsi ganjaran dalam pembelajaran pengukuhan adalah isu penting dan mencabar. Fungsi ganjaran yang direka dengan betul boleh membimbing ejen untuk mempelajari strategi optimum dengan berkesan. Dengan membincangkan peranan dan matlamat fungsi ganjaran, cabaran reka bentuk dan contoh kod khusus, artikel ini berharap dapat memberikan pembaca beberapa rujukan dan inspirasi untuk reka bentuk fungsi ganjaran dalam pembelajaran pengukuhan.Atas ialah kandungan terperinci Isu reka bentuk fungsi ganjaran dalam pembelajaran pengukuhan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

Isu reka bentuk fungsi ganjaran dalam pembelajaran pengukuhan

Oct 09, 2023 am 11:58 AM

Isu reka bentuk fungsi ganjaran dalam pembelajaran pengukuhan

Oct 09, 2023 am 11:58 AM

Isu reka bentuk fungsi ganjaran dalam pembelajaran peneguhan Pengenalan Pembelajaran peneguhan ialah kaedah yang mempelajari strategi optimum melalui interaksi antara ejen dan persekitaran. Dalam pembelajaran pengukuhan, reka bentuk fungsi ganjaran adalah penting untuk kesan pembelajaran ejen. Artikel ini akan meneroka isu reka bentuk fungsi ganjaran dalam pembelajaran pengukuhan dan memberikan contoh kod khusus. Peranan fungsi ganjaran dan fungsi ganjaran sasaran merupakan bahagian penting dalam pembelajaran peneguhan dan digunakan untuk menilai nilai ganjaran yang diperolehi oleh ejen dalam keadaan tertentu. Reka bentuknya membantu membimbing ejen untuk memaksimumkan keletihan jangka panjang dengan memilih tindakan yang optimum.

Pembelajaran pengukuhan Q-pembelajaran mendalam menggunakan simulasi lengan robot Panda-Gym

Oct 31, 2023 pm 05:57 PM

Pembelajaran pengukuhan Q-pembelajaran mendalam menggunakan simulasi lengan robot Panda-Gym

Oct 31, 2023 pm 05:57 PM

Pembelajaran pengukuhan (RL) ialah kaedah pembelajaran mesin yang membolehkan ejen mempelajari cara berkelakuan dalam persekitarannya melalui percubaan dan kesilapan. Ejen diberi ganjaran atau dihukum kerana mengambil tindakan yang membawa kepada hasil yang diingini. Dari masa ke masa, ejen belajar untuk mengambil tindakan yang memaksimumkan ganjaran yang dijangkakan. Ejen RL biasanya dilatih menggunakan proses keputusan Markov (MDP), rangka kerja matematik untuk memodelkan masalah keputusan berjujukan. MDP terdiri daripada empat bahagian: Nyatakan: satu set kemungkinan keadaan persekitaran. Tindakan: Satu set tindakan yang boleh diambil oleh ejen. Fungsi peralihan: Fungsi yang meramalkan kebarangkalian peralihan kepada keadaan baharu memandangkan keadaan dan tindakan semasa. Fungsi ganjaran: Fungsi yang memberikan ganjaran kepada ejen untuk setiap penukaran. Matlamat ejen adalah untuk mempelajari fungsi polisi,

Teknologi pembelajaran pengukuhan mendalam dalam C++

Aug 21, 2023 pm 11:33 PM

Teknologi pembelajaran pengukuhan mendalam dalam C++

Aug 21, 2023 pm 11:33 PM

Teknologi pembelajaran pengukuhan mendalam ialah cabang kecerdasan buatan yang telah menarik banyak perhatian Ia telah memenangi pelbagai pertandingan antarabangsa dan juga digunakan secara meluas dalam pembantu peribadi, pemanduan autonomi, kecerdasan permainan dan bidang lain. Dalam proses merealisasikan pembelajaran pengukuhan mendalam, C++, sebagai bahasa pengaturcaraan yang cekap dan cemerlang, amat penting apabila sumber perkakasan adalah terhad. Pembelajaran peneguhan mendalam, seperti namanya, menggabungkan teknologi daripada dua bidang pembelajaran mendalam dan pembelajaran pengukuhan. Untuk memahami secara ringkas, pembelajaran mendalam merujuk kepada ciri pembelajaran daripada data dan membuat keputusan dengan membina rangkaian neural berbilang lapisan.

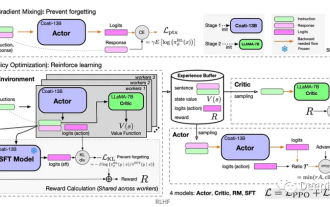

Satu lagi revolusi dalam pembelajaran pengukuhan! DeepMind mencadangkan 'penyulingan algoritma': Transformer pembelajaran tetulang pra-latihan yang boleh diterokai

Apr 12, 2023 pm 06:58 PM

Satu lagi revolusi dalam pembelajaran pengukuhan! DeepMind mencadangkan 'penyulingan algoritma': Transformer pembelajaran tetulang pra-latihan yang boleh diterokai

Apr 12, 2023 pm 06:58 PM

Dalam tugas pemodelan jujukan semasa, Transformer boleh dikatakan sebagai seni bina rangkaian saraf yang paling berkuasa, dan model Transformer yang telah terlatih boleh menggunakan gesaan sebagai syarat atau pembelajaran dalam konteks untuk menyesuaikan diri dengan tugas hiliran yang berbeza. Keupayaan generalisasi model Transformer pra-latihan berskala besar telah disahkan dalam pelbagai bidang, seperti pelengkapan teks, pemahaman bahasa, penjanaan imej, dsb. Sejak tahun lepas, terdapat kerja yang relevan membuktikan bahawa dengan menganggap pembelajaran pengukuhan luar talian (RL luar talian) sebagai masalah ramalan jujukan, model itu boleh mempelajari dasar daripada data luar talian. Tetapi pendekatan semasa sama ada mempelajari dasar daripada data yang tidak mengandungi pembelajaran

Bagaimanakah cara menggunakan bahasa Go untuk menjalankan penyelidikan pembelajaran peneguhan mendalam?

Jun 10, 2023 pm 02:15 PM

Bagaimanakah cara menggunakan bahasa Go untuk menjalankan penyelidikan pembelajaran peneguhan mendalam?

Jun 10, 2023 pm 02:15 PM

Pembelajaran Peneguhan Dalam (DeepReinforcementLearning) ialah teknologi canggih yang menggabungkan pembelajaran mendalam dan pembelajaran peneguhan Ia digunakan secara meluas dalam pengecaman pertuturan, pengecaman imej, pemprosesan bahasa semula jadi dan bidang lain. Sebagai bahasa pengaturcaraan yang pantas, cekap dan boleh dipercayai, bahasa Go boleh memberikan bantuan untuk penyelidikan pembelajaran pengukuhan yang mendalam. Artikel ini akan memperkenalkan cara menggunakan bahasa Go untuk menjalankan penyelidikan pembelajaran peneguhan mendalam. 1. Pasang bahasa Go dan perpustakaan berkaitan dan mula menggunakan bahasa Go untuk pembelajaran pengukuhan yang mendalam.

Mengawal lengan robot bercantum dua menggunakan algoritma pembelajaran pengukuhan DDPG Actor-Critic

May 12, 2023 pm 09:55 PM

Mengawal lengan robot bercantum dua menggunakan algoritma pembelajaran pengukuhan DDPG Actor-Critic

May 12, 2023 pm 09:55 PM

Dalam artikel ini, kami akan memperkenalkan ejen pintar latihan untuk mengawal lengan robot dwi-sendi dalam persekitaran Reacher, program simulasi berasaskan Unity yang dibangunkan menggunakan kit alat UnityML-Agents. Matlamat kami adalah untuk mencapai kedudukan sasaran dengan ketepatan yang tinggi, jadi di sini kami boleh menggunakan algoritma DeepDeterministicPolicyGradient (DDPG) terkini yang direka untuk keadaan dan ruang tindakan berterusan. Aplikasi Dunia Nyata Senjata robot memainkan peranan penting dalam pembuatan, kemudahan pengeluaran, penerokaan angkasa lepas dan operasi mencari dan menyelamat. Adalah sangat penting untuk mengawal lengan robot dengan ketepatan dan fleksibiliti yang tinggi. Dengan menggunakan teknik pembelajaran pengukuhan, sistem robotik ini boleh didayakan untuk belajar dan menyesuaikan tingkah laku mereka dalam masa nyata.

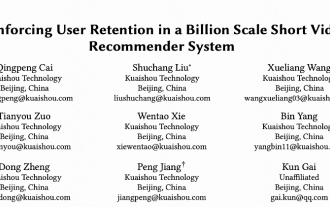

Bagaimana untuk menggunakan pembelajaran pengukuhan untuk meningkatkan pengekalan pengguna Kuaishou?

May 07, 2023 pm 06:31 PM

Bagaimana untuk menggunakan pembelajaran pengukuhan untuk meningkatkan pengekalan pengguna Kuaishou?

May 07, 2023 pm 06:31 PM

Matlamat teras sistem pengesyoran video pendek adalah untuk memacu pertumbuhan DAU dengan meningkatkan pengekalan pengguna. Oleh itu, pengekalan ialah salah satu petunjuk pengoptimuman perniagaan teras bagi setiap APP. Walau bagaimanapun, pengekalan ialah maklum balas jangka panjang selepas berbilang interaksi antara pengguna dan sistem, dan sukar untuk menguraikannya menjadi satu item atau senarai tunggal Oleh itu, adalah sukar untuk mengoptimumkan pengekalan secara langsung menggunakan cara tradisional dan senarai-. model bijak. Kaedah pembelajaran tetulang (RL) mengoptimumkan ganjaran jangka panjang dengan berinteraksi dengan persekitaran, dan sesuai untuk mengoptimumkan pengekalan pengguna secara langsung. Kerja ini memodelkan masalah pengoptimuman pengekalan sebagai proses keputusan Markov (MDP) dengan butiran permintaan ufuk tak terhingga Setiap kali pengguna meminta sistem pengesyoran untuk memutuskan tindakan, ia digunakan untuk mengagregat berbilang anggaran maklum balas jangka pendek yang berbeza (tempoh tontonan.

Belajar memasang papan litar dalam masa 20 minit! Rangka kerja SERL sumber terbuka mempunyai kadar kejayaan kawalan ketepatan 100% dan tiga kali lebih pantas daripada manusia

Feb 21, 2024 pm 03:31 PM

Belajar memasang papan litar dalam masa 20 minit! Rangka kerja SERL sumber terbuka mempunyai kadar kejayaan kawalan ketepatan 100% dan tiga kali lebih pantas daripada manusia

Feb 21, 2024 pm 03:31 PM

Kini, robot boleh mempelajari tugas kawalan kilang ketepatan. Dalam tahun-tahun kebelakangan ini, kemajuan ketara telah dicapai dalam bidang teknologi pembelajaran pengukuhan robot, seperti berjalan berkaki empat, menggenggam, manipulasi ketangkasan, dan lain-lain, tetapi kebanyakannya terhad kepada peringkat demonstrasi makmal. Menggunakan teknologi pembelajaran pengukuhan robot secara meluas kepada persekitaran pengeluaran sebenar masih menghadapi banyak cabaran, yang pada tahap tertentu mengehadkan skop aplikasinya dalam senario sebenar. Dalam proses aplikasi praktikal teknologi pembelajaran pengukuhan, adalah perlu untuk mengatasi pelbagai masalah kompleks termasuk penetapan mekanisme ganjaran, penetapan semula persekitaran, peningkatan kecekapan sampel, dan jaminan keselamatan tindakan. Pakar industri menekankan bahawa menyelesaikan banyak masalah dalam pelaksanaan sebenar teknologi pembelajaran tetulang adalah sama pentingnya dengan inovasi berterusan algoritma itu sendiri. Menghadapi cabaran ini, penyelidik dari Universiti California, Berkeley, Universiti Stanford, Universiti Washington, dan