Peranti teknologi

Peranti teknologi

AI

AI

Tajuk baharu: ADAPT: Penerokaan awal kebolehjelasan pemanduan autonomi hujung-ke-hujung

Tajuk baharu: ADAPT: Penerokaan awal kebolehjelasan pemanduan autonomi hujung-ke-hujung

Tajuk baharu: ADAPT: Penerokaan awal kebolehjelasan pemanduan autonomi hujung-ke-hujung

Artikel ini dicetak semula dengan kebenaran akaun awam Autonomous Driving Heart Sila hubungi sumber untuk mencetak semula. . kerana kebolehtafsiran yang rendah, latihan sukar untuk disatukan, dsb., sesetengah sarjana dalam bidang ini telah mula secara beransur-ansur mengalihkan perhatian mereka kepada kebolehtafsiran hujung ke hujung Hari ini saya akan berkongsi dengan anda karya terkini mengenai kebolehtafsiran hujung ke hujung. ADAPT. Kaedah ini adalah berdasarkan seni bina Transformer dan menggunakan pelbagai tugas Kaedah latihan bersama mengeluarkan penerangan tindakan kenderaan dan penaakulan untuk setiap keputusan hujung ke hujung. Beberapa pendapat penulis tentang ADAPT adalah seperti berikut:

Berikut adalah ramalan menggunakan ciri 2D video Berkemungkinan kesannya akan menjadi lebih baik selepas menukar ciri 2D kepada ciri bev mungkin lebih baik apabila digabungkan dengan LLM , contohnya, bahagian Penjanaan Teks digantikan dengan LLM.

Karya semasa menggunakan video sejarah sebagai input, dan tindakan yang diramalkan serta penerangannya juga mungkin lebih bermakna jika ada diubah untuk meramalkan tindakan masa depan dan sebab tindakan itu .Token

yang diperolehi dengan token imej adalah terlalu banyak, dan mungkin terdapat banyak maklumat yang tidak berguna. Mungkin anda boleh mencuba Token-Learner.- Apakah titik permulaan?

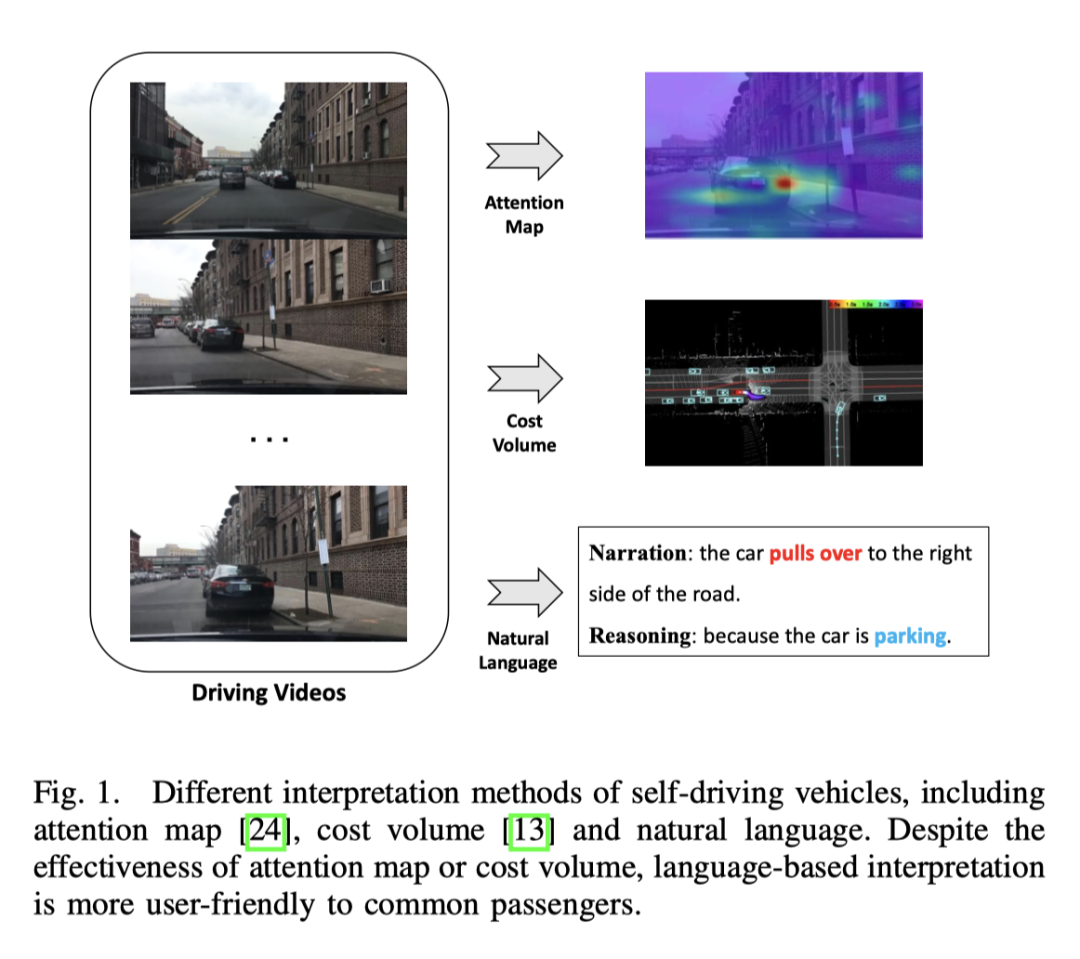

- Pemanduan autonomi hujung ke hujung mempunyai potensi besar dalam industri pengangkutan, dan penyelidikan dalam bidang ini sedang hangat. Contohnya, UniAD, kertas terbaik CVPR2023, melakukan pemanduan automatik hujung ke hujung. Walau bagaimanapun, kekurangan ketelusan dan kebolehjelasan proses membuat keputusan automatik akan menghalang pembangunannya Lagipun, keselamatan adalah keutamaan pertama untuk kenderaan sebenar di jalan raya. Terdapat beberapa percubaan awal untuk menggunakan peta perhatian atau volum kos untuk meningkatkan kebolehtafsiran model, tetapi kaedah ini sukar difahami. Jadi titik permulaan kerja ini adalah untuk mencari cara yang mudah difahami untuk menerangkan pembuatan keputusan. Gambar di bawah adalah perbandingan beberapa kaedah Jelas sekali ia lebih mudah difahami dalam perkataan.

Apakah kelebihan ADAPT?

Mampu mengeluarkan huraian tindakan kenderaan dan alasan untuk setiap keputusan hujung ke hujung

Kaedah ini berdasarkan struktur rangkaian transformer dan melakukan latihan bersama melalui kaedah pelbagai tugas

Untuk mengesahkan keberkesanan sistem dalam senario sebenar, sistem yang boleh digunakan telah diwujudkan untuk memasukkan video asal dan mengeluarkan penerangan dan alasan tindakan secara nyata masa. ;

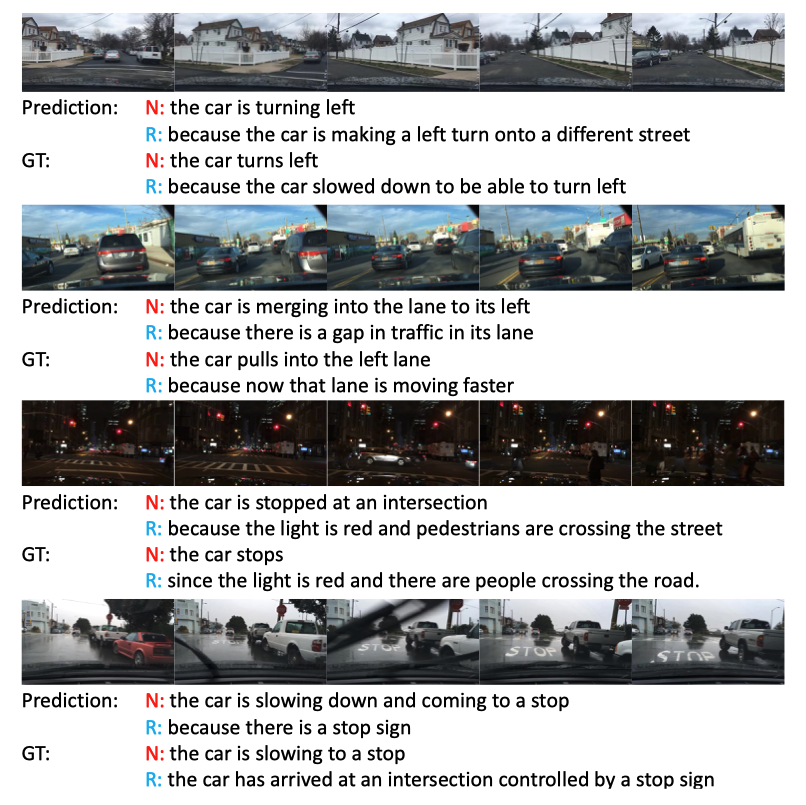

- Paparan kesan

- Kesannya masih sangat baik, terutama adegan malam gelap ketiga, lampu isyarat diperhatikan.

Kemajuan semasa dalam bidang

Kapsyen Video

Matlamat utama penerangan video adalah untuk menerangkan objek dan hubungannya dengan video tertentu dalam bahasa semula jadi. Kerja-kerja penyelidikan awal menjana ayat dengan struktur sintaksis tertentu dengan mengisi elemen yang dikenal pasti dalam templat tetap, yang tidak fleksibel dan tidak mempunyai kekayaan.

Untuk menghasilkan ayat semula jadi dengan struktur sintaksis yang fleksibel, beberapa kaedah menggunakan teknik pembelajaran urutan. Secara khusus, kaedah ini menggunakan pengekod video untuk mengekstrak ciri dan penyahkod bahasa untuk mempelajari penjajaran teks visual. Untuk menjadikan huraian lebih kaya, kaedah ini juga menggunakan perwakilan peringkat objek untuk mendapatkan ciri interaksi sedar objek terperinci dalam videoWalaupun seni bina sedia ada telah mencapai hasil tertentu dalam arah kapsyen video umum, ia tidak boleh digunakan secara langsung pada perwakilan tindakan, kerana hanya memindahkan penerangan video kepada perwakilan tindakan pemanduan autonomi akan kehilangan beberapa maklumat penting, seperti kelajuan kenderaan, dsb., yang penting untuk tugas pemanduan autonomi. Cara menggunakan maklumat pelbagai mod ini dengan berkesan untuk menjana ayat masih diterokai. PaLM-E berfungsi dengan baik dalam ayat berbilang modal.

Pemandu autonomi hujung-ke-hujung

Pemacuan autonomi berasaskan pembelajaran ialah bidang penyelidikan yang aktif. UniAD kertas terbaik CVPR2023 baru-baru ini, termasuk FusionAD seterusnya, dan karya Wayve berdasarkan model Dunia MILE semuanya berfungsi ke arah ini. Format output termasuk titik trajektori, seperti UniAD, dan tindakan kenderaan secara langsung, seperti MILE.

Selain itu, beberapa kaedah memodelkan tingkah laku masa hadapan peserta trafik seperti kenderaan, penunggang basikal atau pejalan kaki untuk meramalkan titik laluan kenderaan, manakala kaedah lain meramalkan isyarat kawalan kenderaan secara langsung berdasarkan input sensor, serupa dengan subtugas ramalan isyarat kawalan dalam ini kerja

Kebolehtafsiran pemanduan autonomi

Dalam bidang pemanduan autonomi, kebanyakan kaedah kebolehtafsiran adalah berdasarkan penglihatan, dan ada yang berdasarkan kerja LiDAR. Sesetengah kaedah menggunakan peta perhatian untuk menapis kawasan imej yang tidak penting, menjadikan gelagat kenderaan autonomi kelihatan munasabah dan boleh dijelaskan. Walau bagaimanapun, peta perhatian mungkin mengandungi beberapa kawasan yang kurang penting. Terdapat juga kaedah yang menggunakan peta lidar dan berketepatan tinggi sebagai input, meramalkan kotak sempadan peserta trafik lain, dan menggunakan ontologi untuk menerangkan proses penaakulan membuat keputusan. Selain itu, terdapat cara untuk membina peta dalam talian melalui pembahagian untuk mengurangkan pergantungan pada peta HD. Walaupun kaedah berasaskan penglihatan atau lidar boleh memberikan hasil yang baik, kekurangan penjelasan lisan menjadikan keseluruhan sistem kelihatan rumit dan sukar untuk difahami. Satu kajian meneroka kemungkinan tafsiran teks untuk kenderaan autonomi buat kali pertama, dengan mengekstrak ciri video di luar talian untuk meramal isyarat kawalan dan melaksanakan tugas penerangan video

Berbilang tugas dalam pemanduan autonomi pembelajaran

Rangka kerja hujung ke hujung ini menggunakan pembelajaran berbilang tugas untuk bersama-sama melatih model menggunakan dua tugas penjanaan teks dan isyarat kawalan ramalan. Pembelajaran pelbagai tugas digunakan secara meluas dalam pemanduan autonomi. Oleh kerana penggunaan data yang lebih baik dan ciri yang dikongsi, latihan bersama tugas yang berbeza meningkatkan prestasi setiap tugasan Oleh itu, dalam kerja ini, latihan bersama dua tugas ramalan isyarat kawalan dan penjanaan teks digunakan.

kaedah ADAPT

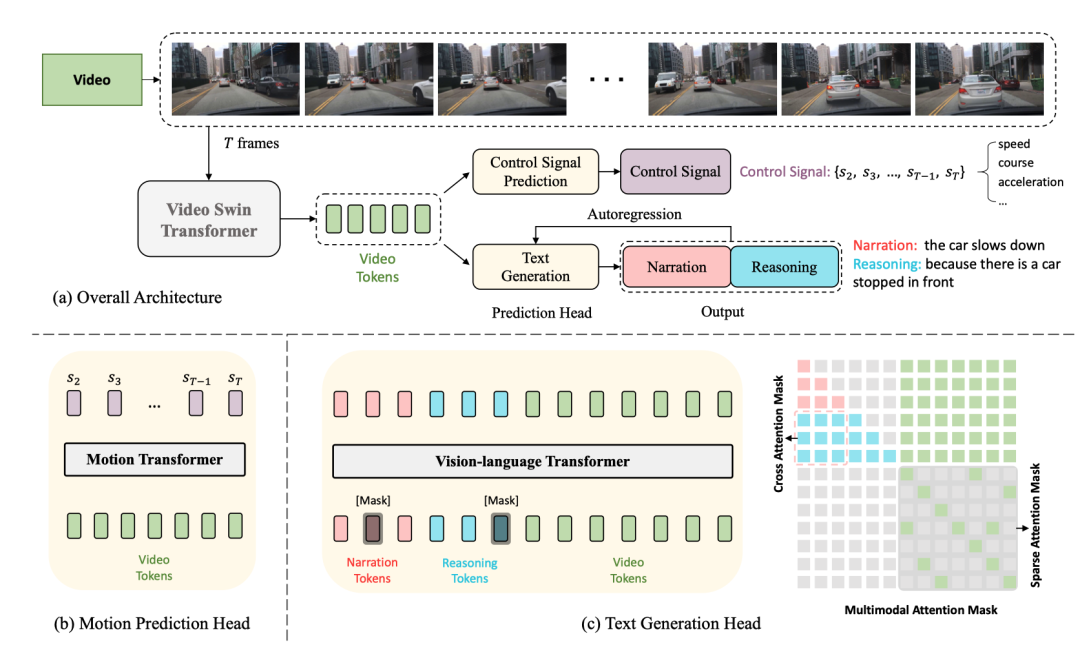

Berikut ialah gambar rajah struktur rangkaian:

#🎜#🎜##🎜#🎜##🎜 #🎜 🎜#Keseluruhan struktur dibahagikan kepada dua tugas:

Driving Caption Generation (DCG): video input, output dua ayat, ayat pertama menerangkan aksi kereta, ayat kedua Huraikan alasan untuk mengambil tindakan ini, seperti "Kereta itu memecut, kerana lampu isyarat bertukar hijau." isyarat kawalan, seperti kelajuan , arah, pecutan.

- Antaranya, dua tugas DCG dan CSP berkongsi Pengekod Video, tetapi menggunakan kepala ramalan yang berbeza untuk menghasilkan output akhir yang berbeza.

- Untuk tugas DCG, pengekod pengubah bahasa penglihatan digunakan untuk menjana dua ayat bahasa semula jadi.

Pengekod Video

#🎜#🎜##🎜 di sini Video Swin Transformer digunakan untuk menukar bingkai video input kepada token ciri video. Input桢gambar, bentuknya

, saiz ciri yang keluar ialah#🎜🎜 inilah #🎜 🎜#

ialah dimensi saluran 🎜#Ciri di atas ditandakan untuk mendapatkan token video. 🎜🎜# , dan kemudian dilaraskan oleh MLP Dimensi diselaraskan dengan pembenaman token teks, dan kemudian token teks dan token video disalurkan kepada pengekod pengubah bahasa penglihatan bersama-sama untuk menjana penerangan dan penaakulan tindakan. Kepala Ramalan Isyarat Kawalan

dan input

video sepadan dengan isyarat kawalan #🎜 🎜🎜#, Output kepala CSP ialah, di mana setiap isyarat kawalan tidak semestinya satu dimensi, tetapi boleh berbilang dimensi, seperti termasuk kelajuan, pecutan, arah, dll. pada masa yang sama. Pendekatan di sini adalah untuk menandakan ciri video dan menjana satu siri isyarat keluaran melalui pengubah gerakan Fungsi kehilangan adalah MSE,

Sepatutnya. ambil perhatian bahawa , bingkai pertama tidak disertakan di sini kerana bingkai pertama memberikan terlalu sedikit maklumat dinamikLatihan Bersama

Dalam bingkai ini, kerana daripada pengekod video yang dikongsi, sebenarnya diandaikan bahawa kedua-dua tugas CSP dan DCG adalah sejajar pada tahap perwakilan video. Titik permulaan ialah perihalan tindakan dan isyarat kawalan ialah ungkapan berbeza bagi tindakan kenderaan berbutir halus, dan penjelasan penaakulan tindakan tertumpu terutamanya pada persekitaran pemanduan yang mempengaruhi tindakan kenderaan. Menggunakan latihan bersama untuk latihan

Perlu diingat bahawa walaupun ia adalah tempat latihan bersama, semasa inferens , tetapi boleh dilaksanakan secara bebas Tugasan CSP mudah difahami Hanya masukkan video secara terus mengikut carta alir dan keluarkan isyarat kawalan Untuk tugasan DCG, teruskan input video dan huraian dan penaakulan masa berdasarkan kaedah autoregresif Penjanaan perkataan bermula dari [CLS] dan berakhir dengan [SEP] atau mencapai ambang panjang.

Reka bentuk eksperimen dan perbandingan

Dataset

Set data yang digunakan ialah BDD-X ini mengandungi 7000 video berpasangan dan isyarat kawalan. Setiap video berdurasi kira-kira 40 saat, saiz imej ialah , dan kekerapannya ialah FPS Setiap video mempunyai 1 hingga 5 gelagat kenderaan, seperti memecut, membelok ke kanan dan bergabung. Semua tindakan ini dianotasi dengan teks, termasuk naratif tindakan (cth., "Kereta berhenti") dan penaakulan (cth., "Kerana lampu isyarat merah"). Terdapat kira-kira 29,000 pasangan anotasi tingkah laku secara keseluruhan.

Butiran pelaksanaan khusus

- video swin transformer telah dilatih terlebih dahulu pada Kinetics-600

- pengubah bahasa penglihatan dan motion transformer dimulakan secara rawak

- Tiada latihan tetap, jadi parameter swin tetap ke hujung Saiz bingkai video input

- diubah saiz dan dipotong, dan input akhir kepada rangkaian ialah 224x224

- Untuk penerangan dan penaakulan, pembenaman WordPiece [75] digunakan dan bukannya keseluruhan perkataan, (mis., "berhenti" ialah dipotong kepada "berhenti" dan "#s"), panjang maksimum setiap ayat ialah 15

- Semasa latihan, pemodelan bahasa bertopeng akan secara rawak menutup 50% daripada token, dan token setiap topeng mempunyai kebarangkalian 80% menjadi [MASK]. terdapat 10% kebarangkalian bahawa satu perkataan akan dipilih secara rawak, dan baki 10% kebarangkalian kekal tidak berubah.

- Pengoptimum AdamW digunakan, dan dalam 10% pertama langkah latihan, terdapat mekanisme memanaskan badan

- Ia mengambil masa kira-kira 13 jam untuk berlatih dengan 4 GPU V100

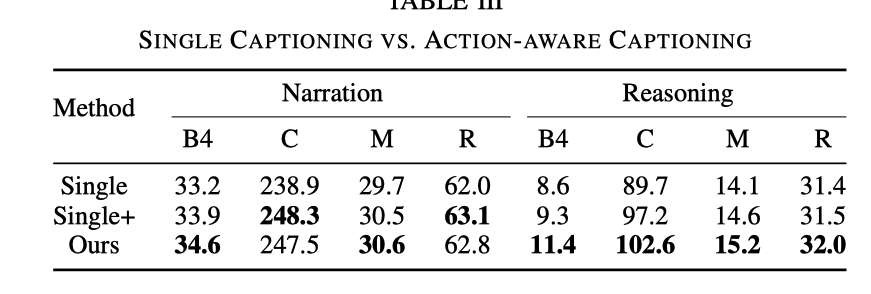

Impak latihan bersama

Tiga eksperimen dibandingkan di sini untuk menggambarkan keberkesanan latihan bersama tugasan masih belum wujud, tetapi apabila memasukkan modul DCG, selain tag video, tag isyarat kawalan juga perlu dimasukkan

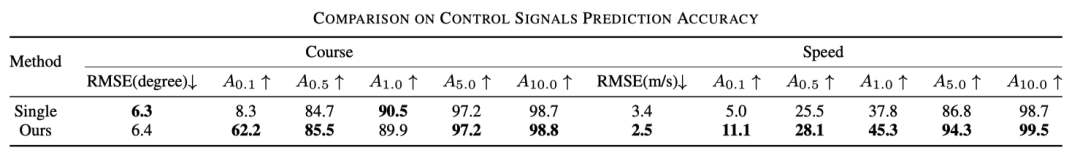

Perbandingan kesan adalah seperti berikut

Berbanding dengan tugas DCG sahaja, Penaakulan ADAPT kesannya jauh lebih baik. Walaupun kesannya bertambah baik apabila terdapat input isyarat kawalan, ia masih tidak sebaik kesan penambahan tugasan CSP. Selepas menambah tugasan CSP, keupayaan untuk mewakili dan memahami video adalah lebih kuatSelain itu, jadual di bawah juga menunjukkan bahawa kesan latihan bersama terhadap CSP juga bertambah baik.

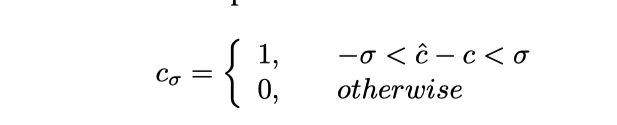

boleh difahami sebagai ketepatan, khususnya ia akan Isyarat kawalan yang diramalkan dipotong, dan formulanya adalah seperti berikut

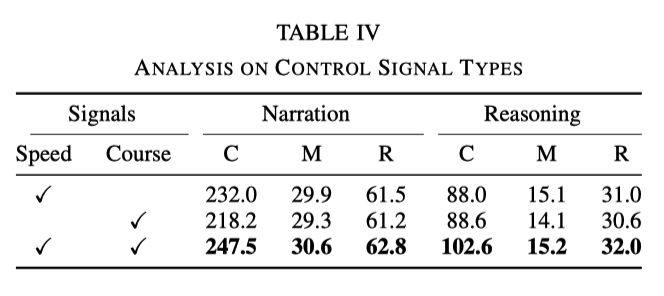

Pengaruh pelbagai jenis isyarat kawalan

Dalam eksperimen, isyarat asas yang digunakan ialah kelajuan dan tajuk. Walau bagaimanapun, eksperimen mendapati bahawa apabila hanya satu daripada isyarat digunakan, kesannya tidak sebaik menggunakan kedua-dua isyarat pada masa yang sama Data khusus ditunjukkan dalam jadual berikut:

Ini menunjukkan bahawa kedua-dua isyarat. kepantasan dan hala tuju boleh membantu rangkaian Perihalan tindakan pembelajaran yang lebih baik dan penaakulan

Interaksi antara huraian tindakan dan penaakulan

Berbanding dengan tugasan penerangan umum, penjanaan tugas huraian memandu ialah dua ayat iaitu huraian tindakan dan penaakulan. Ia boleh didapati daripada jadual berikut:

Berbanding dengan tugasan penerangan umum, penjanaan tugas huraian memandu ialah dua ayat iaitu huraian tindakan dan penaakulan. Ia boleh didapati daripada jadual berikut:

Garis 2 dan 3 pertukaran inferens Susunan huraian dan huraian juga akan menjadi tidak teratur, yang menunjukkan bahawa penaakulan bergantung pada huraian

Membandingkan tiga baris seterusnya, mengeluarkan hanya penerangan dan hanya mengeluarkan penaakulan tidak sebaik mengeluarkan kedua-duanya; Kesan Kadar Pensampelan Diperlukan Kandungan yang ditulis semula ialah: Pautan asal: https://mp.weixin.qq.com/s/MSTyr4ksh0TOqTdQ2WnSeQAtas ialah kandungan terperinci Tajuk baharu: ADAPT: Penerokaan awal kebolehjelasan pemanduan autonomi hujung-ke-hujung. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1378

1378

52

52

Mengapakah Gaussian Splatting begitu popular dalam pemanduan autonomi sehingga NeRF mula ditinggalkan?

Jan 17, 2024 pm 02:57 PM

Mengapakah Gaussian Splatting begitu popular dalam pemanduan autonomi sehingga NeRF mula ditinggalkan?

Jan 17, 2024 pm 02:57 PM

Ditulis di atas & pemahaman peribadi pengarang Gaussiansplatting tiga dimensi (3DGS) ialah teknologi transformatif yang telah muncul dalam bidang medan sinaran eksplisit dan grafik komputer dalam beberapa tahun kebelakangan ini. Kaedah inovatif ini dicirikan oleh penggunaan berjuta-juta Gaussians 3D, yang sangat berbeza daripada kaedah medan sinaran saraf (NeRF), yang terutamanya menggunakan model berasaskan koordinat tersirat untuk memetakan koordinat spatial kepada nilai piksel. Dengan perwakilan adegan yang eksplisit dan algoritma pemaparan yang boleh dibezakan, 3DGS bukan sahaja menjamin keupayaan pemaparan masa nyata, tetapi juga memperkenalkan tahap kawalan dan pengeditan adegan yang tidak pernah berlaku sebelum ini. Ini meletakkan 3DGS sebagai penukar permainan yang berpotensi untuk pembinaan semula dan perwakilan 3D generasi akan datang. Untuk tujuan ini, kami menyediakan gambaran keseluruhan sistematik tentang perkembangan dan kebimbangan terkini dalam bidang 3DGS buat kali pertama.

Bagaimana untuk menyelesaikan masalah ekor panjang dalam senario pemanduan autonomi?

Jun 02, 2024 pm 02:44 PM

Bagaimana untuk menyelesaikan masalah ekor panjang dalam senario pemanduan autonomi?

Jun 02, 2024 pm 02:44 PM

Semalam semasa temu bual, saya telah ditanya sama ada saya telah membuat sebarang soalan berkaitan ekor panjang, jadi saya fikir saya akan memberikan ringkasan ringkas. Masalah ekor panjang pemanduan autonomi merujuk kepada kes tepi dalam kenderaan autonomi, iaitu, kemungkinan senario dengan kebarangkalian yang rendah untuk berlaku. Masalah ekor panjang yang dirasakan adalah salah satu sebab utama yang kini mengehadkan domain reka bentuk pengendalian kenderaan autonomi pintar satu kenderaan. Seni bina asas dan kebanyakan isu teknikal pemanduan autonomi telah diselesaikan, dan baki 5% masalah ekor panjang secara beransur-ansur menjadi kunci untuk menyekat pembangunan pemanduan autonomi. Masalah ini termasuk pelbagai senario yang berpecah-belah, situasi yang melampau dan tingkah laku manusia yang tidak dapat diramalkan. "Ekor panjang" senario tepi dalam pemanduan autonomi merujuk kepada kes tepi dalam kenderaan autonomi (AVs) kes Edge adalah senario yang mungkin dengan kebarangkalian yang rendah untuk berlaku. kejadian yang jarang berlaku ini

Pilih kamera atau lidar? Kajian terbaru tentang mencapai pengesanan objek 3D yang mantap

Jan 26, 2024 am 11:18 AM

Pilih kamera atau lidar? Kajian terbaru tentang mencapai pengesanan objek 3D yang mantap

Jan 26, 2024 am 11:18 AM

0. Ditulis di hadapan&& Pemahaman peribadi bahawa sistem pemanduan autonomi bergantung pada persepsi lanjutan, membuat keputusan dan teknologi kawalan, dengan menggunakan pelbagai penderia (seperti kamera, lidar, radar, dll.) untuk melihat persekitaran sekeliling dan menggunakan algoritma dan model untuk analisis masa nyata dan membuat keputusan. Ini membolehkan kenderaan mengenali papan tanda jalan, mengesan dan menjejaki kenderaan lain, meramalkan tingkah laku pejalan kaki, dsb., dengan itu selamat beroperasi dan menyesuaikan diri dengan persekitaran trafik yang kompleks. Teknologi ini kini menarik perhatian meluas dan dianggap sebagai kawasan pembangunan penting dalam pengangkutan masa depan satu. Tetapi apa yang menyukarkan pemanduan autonomi ialah memikirkan cara membuat kereta itu memahami perkara yang berlaku di sekelilingnya. Ini memerlukan algoritma pengesanan objek tiga dimensi dalam sistem pemanduan autonomi boleh melihat dan menerangkan dengan tepat objek dalam persekitaran sekeliling, termasuk lokasinya,

Kertas Stable Diffusion 3 akhirnya telah dikeluarkan, dan butiran seni bina didedahkan Adakah ia akan membantu untuk menghasilkan semula Sora?

Mar 06, 2024 pm 05:34 PM

Kertas Stable Diffusion 3 akhirnya telah dikeluarkan, dan butiran seni bina didedahkan Adakah ia akan membantu untuk menghasilkan semula Sora?

Mar 06, 2024 pm 05:34 PM

Kertas StableDiffusion3 akhirnya di sini! Model ini dikeluarkan dua minggu lalu dan menggunakan seni bina DiT (DiffusionTransformer) yang sama seperti Sora. Ia menimbulkan kekecohan apabila ia dikeluarkan. Berbanding dengan versi sebelumnya, kualiti imej yang dijana oleh StableDiffusion3 telah dipertingkatkan dengan ketara Ia kini menyokong gesaan berbilang tema, dan kesan penulisan teks juga telah dipertingkatkan, dan aksara bercelaru tidak lagi muncul. StabilityAI menegaskan bahawa StableDiffusion3 ialah satu siri model dengan saiz parameter antara 800M hingga 8B. Julat parameter ini bermakna model boleh dijalankan terus pada banyak peranti mudah alih, dengan ketara mengurangkan penggunaan AI

Artikel ini sudah cukup untuk anda membaca tentang pemanduan autonomi dan ramalan trajektori!

Feb 28, 2024 pm 07:20 PM

Artikel ini sudah cukup untuk anda membaca tentang pemanduan autonomi dan ramalan trajektori!

Feb 28, 2024 pm 07:20 PM

Ramalan trajektori memainkan peranan penting dalam pemanduan autonomi Ramalan trajektori pemanduan autonomi merujuk kepada meramalkan trajektori pemanduan masa hadapan kenderaan dengan menganalisis pelbagai data semasa proses pemanduan kenderaan. Sebagai modul teras pemanduan autonomi, kualiti ramalan trajektori adalah penting untuk kawalan perancangan hiliran. Tugas ramalan trajektori mempunyai timbunan teknologi yang kaya dan memerlukan kebiasaan dengan persepsi dinamik/statik pemanduan autonomi, peta ketepatan tinggi, garisan lorong, kemahiran seni bina rangkaian saraf (CNN&GNN&Transformer), dll. Sangat sukar untuk bermula! Ramai peminat berharap untuk memulakan ramalan trajektori secepat mungkin dan mengelakkan perangkap Hari ini saya akan mengambil kira beberapa masalah biasa dan kaedah pembelajaran pengenalan untuk ramalan trajektori! Pengetahuan berkaitan pengenalan 1. Adakah kertas pratonton teratur? A: Tengok survey dulu, hlm

SIMPL: Penanda aras ramalan gerakan berbilang ejen yang mudah dan cekap untuk pemanduan autonomi

Feb 20, 2024 am 11:48 AM

SIMPL: Penanda aras ramalan gerakan berbilang ejen yang mudah dan cekap untuk pemanduan autonomi

Feb 20, 2024 am 11:48 AM

Tajuk asal: SIMPL: ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving Paper pautan: https://arxiv.org/pdf/2402.02519.pdf Pautan kod: https://github.com/HKUST-Aerial-Robotics/SIMPL Unit pengarang: Universiti Sains Hong Kong dan Teknologi Idea Kertas DJI: Kertas kerja ini mencadangkan garis dasar ramalan pergerakan (SIMPL) yang mudah dan cekap untuk kenderaan autonomi. Berbanding dengan agen-sen tradisional

SOTA terbaharu nuScenes |. SparseAD: Pertanyaan jarang membantu pemanduan autonomi hujung ke hujung yang cekap!

Apr 17, 2024 pm 06:22 PM

SOTA terbaharu nuScenes |. SparseAD: Pertanyaan jarang membantu pemanduan autonomi hujung ke hujung yang cekap!

Apr 17, 2024 pm 06:22 PM

Ditulis di hadapan & titik permulaan Paradigma hujung ke hujung menggunakan rangka kerja bersatu untuk mencapai pelbagai tugas dalam sistem pemanduan autonomi. Walaupun kesederhanaan dan kejelasan paradigma ini, prestasi kaedah pemanduan autonomi hujung ke hujung pada subtugas masih jauh ketinggalan berbanding kaedah tugasan tunggal. Pada masa yang sama, ciri pandangan mata burung (BEV) padat yang digunakan secara meluas dalam kaedah hujung ke hujung sebelum ini menyukarkan untuk membuat skala kepada lebih banyak modaliti atau tugasan. Paradigma pemanduan autonomi hujung ke hujung (SparseAD) tertumpu carian jarang dicadangkan di sini, di mana carian jarang mewakili sepenuhnya keseluruhan senario pemanduan, termasuk ruang, masa dan tugas, tanpa sebarang perwakilan BEV yang padat. Khususnya, seni bina jarang bersatu direka bentuk untuk kesedaran tugas termasuk pengesanan, penjejakan dan pemetaan dalam talian. Di samping itu, berat

FisheyeDetNet: algoritma pengesanan sasaran pertama berdasarkan kamera fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: algoritma pengesanan sasaran pertama berdasarkan kamera fisheye

Apr 26, 2024 am 11:37 AM

Pengesanan objek ialah masalah yang agak matang dalam sistem pemanduan autonomi, antaranya pengesanan pejalan kaki adalah salah satu algoritma terawal untuk digunakan. Penyelidikan yang sangat komprehensif telah dijalankan dalam kebanyakan kertas kerja. Walau bagaimanapun, persepsi jarak menggunakan kamera fisheye untuk pandangan sekeliling agak kurang dikaji. Disebabkan herotan jejari yang besar, perwakilan kotak sempadan standard sukar dilaksanakan dalam kamera fisheye. Untuk mengurangkan perihalan di atas, kami meneroka kotak sempadan lanjutan, elips dan reka bentuk poligon am ke dalam perwakilan kutub/sudut dan mentakrifkan metrik mIOU pembahagian contoh untuk menganalisis perwakilan ini. Model fisheyeDetNet yang dicadangkan dengan bentuk poligon mengatasi model lain dan pada masa yang sama mencapai 49.5% mAP pada set data kamera fisheye Valeo untuk pemanduan autonomi