Dalam era kuasa pengkomputeran adalah raja, bolehkah GPU anda menjalankan model besar (LLM) dengan lancar?

Ramai orang mengalami kesukaran untuk memberikan jawapan yang tepat kepada soalan ini dan tidak tahu cara mengira memori GPU. Kerana melihat LLM yang boleh dikendalikan oleh GPU tidak semudah melihat saiz model, model boleh mengambil banyak memori semasa inferens (cache KV), cth. llama-2-7b mempunyai panjang jujukan 1000 dan memerlukan 1GB ingatan tambahan. Bukan itu sahaja, semasa latihan model, cache KV, pengaktifan dan kuantisasi akan menduduki banyak memori.

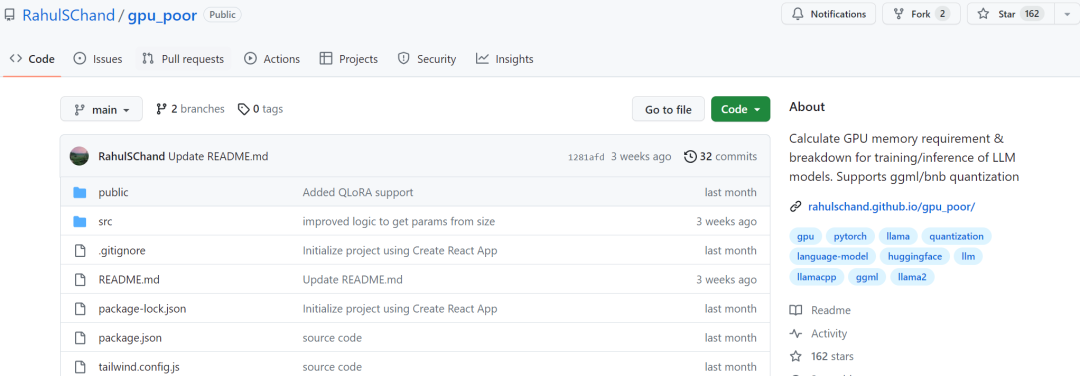

Kami tidak boleh tidak tertanya-tanya sama ada kami boleh mengetahui penggunaan memori di atas lebih awal. Dalam beberapa hari kebelakangan ini, projek baharu telah muncul di GitHub, yang boleh membantu anda mengira jumlah memori GPU yang diperlukan semasa latihan atau inferens LLM Bukan itu sahaja, dengan bantuan projek ini, anda juga boleh mengetahui pengedaran memori terperinci dan kaedah penilaian, panjang konteks maksimum diproses dan isu lain untuk membantu pengguna memilih konfigurasi GPU yang sesuai dengan mereka.

Alamat projek: https://github.com/RahulSChand/gpu_poor

Bukan itu sahaja, projek ini juga interaktif, seperti yang ditunjukkan di bawah, ia boleh mengira memori GPU yang diperlukan untuk menjalankan LLM , semudah mengisi tempat kosong, pengguna hanya perlu memasukkan beberapa parameter yang diperlukan, dan akhirnya klik butang biru, dan jawapan akan keluar. . pengarang Rahul Shiv Chand berkata bahawa terdapat sebab berikut:

Berapa panjang konteks maksimum yang boleh dikendalikan oleh GPU;

Apakah jenis Kaedah penalaan halus manakah yang lebih sesuai untuk anda? Penuh? Atau QLoRA?

Apakah kumpulan maksimum yang boleh digunakan semasa penalaan halus?

Walau bagaimanapun, pengarang projek menyatakan bahawa keputusan akhir mungkin berbeza-beza bergantung pada model pengguna, data input, versi CUDA, alat kuantifikasi, dll. Dalam percubaan, penulis cuba mengambil kira faktor-faktor ini dan memastikan keputusan akhir berada dalam lingkungan 500MB. Jadual di bawah adalah tempat pengarang menyemak silang penggunaan memori model 3b, 7b dan 13b yang disediakan di tapak web berbanding dengan apa yang penulis perolehi pada GPU RTX 4090 dan 2060. Semua nilai berada dalam 500MB. .

Atas ialah kandungan terperinci Bolehkah GPU anda menjalankan model besar seperti Llama 2? Cubalah dengan projek sumber terbuka ini. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Bagaimana untuk mengikat data dalam senarai lungsur

Bagaimana untuk mengikat data dalam senarai lungsur

Perbezaan antara vue3.0 dan 2.0

Perbezaan antara vue3.0 dan 2.0

Kaedah crawler Python untuk mendapatkan data

Kaedah crawler Python untuk mendapatkan data

penyahpepijatan node.js

penyahpepijatan node.js

Penggunaan typedef dalam bahasa c

Penggunaan typedef dalam bahasa c

Apa yang berlaku apabila 4g menjadi 2g?

Apa yang berlaku apabila 4g menjadi 2g?

Mengapa Amazon tidak boleh dibuka

Mengapa Amazon tidak boleh dibuka

konsol.readline

konsol.readline

Penyelesaian tamat masa permintaan pelayan

Penyelesaian tamat masa permintaan pelayan