Peranti teknologi

Peranti teknologi

AI

AI

Transformer dilawati semula: penyongsangan lebih berkesan, SOTA baharu untuk ramalan dunia sebenar muncul

Transformer dilawati semula: penyongsangan lebih berkesan, SOTA baharu untuk ramalan dunia sebenar muncul

Transformer dilawati semula: penyongsangan lebih berkesan, SOTA baharu untuk ramalan dunia sebenar muncul

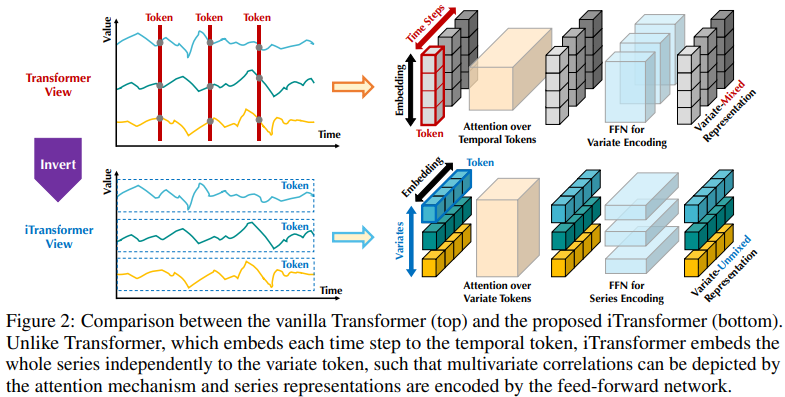

Dalam peramalan siri masa, Transformer telah menunjukkan keupayaan hebatnya untuk menerangkan kebergantungan dan mengekstrak perwakilan berbilang peringkat. Walau bagaimanapun, beberapa penyelidik telah mempersoalkan keberkesanan peramal berasaskan Transformer. Peramal sedemikian biasanya membenamkan berbilang pembolehubah cap masa yang sama ke dalam saluran yang tidak dapat dibezakan dan menumpukan pada cap masa ini untuk menangkap kebergantungan temporal. Para penyelidik mendapati bahawa lapisan linear mudah yang menganggap hubungan berangka dan bukannya hubungan semantik mengatasi Transformer kompleks dalam kedua-dua prestasi dan kecekapan. Pada masa yang sama, kepentingan memastikan kebebasan pembolehubah dan mengeksploitasi maklumat bersama telah mendapat perhatian yang semakin meningkat daripada penyelidikan terkini. Kajian ini secara eksplisit memodelkan korelasi multivariate untuk mencapai ramalan yang tepat. Walau bagaimanapun, masih sukar untuk mencapai matlamat ini tanpa menjejaskan seni bina Transformer biasa

Memandangkan kontroversi yang disebabkan oleh peramal berasaskan Transformer, penyelidik memikirkan mengapa Transformer digunakan dalam ramalan siri masa Prestasinya tidak sehebat model linear dalam banyak bidang lain, tetapi ia mendominasi dalam banyak bidang lain

Baru-baru ini, kertas kerja baharu dari Universiti Tsinghua mencadangkan perspektif yang berbeza - prestasi Transformer tidak wujud, tetapi disebabkan oleh Disebabkan oleh penggunaan skema yang tidak betul untuk data siri masa.

Pautan ke kertas itu ialah: https://arxiv.org/pdf/2310.06625.pdf

Struktur sedia ada bagi peramal berasaskan Transformer mungkin tidak sesuai untuk ramalan siri masa berbilang variasi. Bahagian kiri Rajah 2 menunjukkan bahawa titik pada langkah yang sama mewakili makna fizikal yang berbeza, tetapi keputusan pengukuran tidak konsisten. Titik ini dibenamkan ke dalam token, dan korelasi multivariat diabaikan. Tambahan pula, dalam dunia nyata, langkah masa individu jarang dilabelkan dengan maklumat yang berguna kerana salah penjajaran medan penerimaan tempatan dan cap masa pada titik masa berbilang variasi. Di samping itu, walaupun variasi jujukan dipengaruhi dengan ketara oleh susunan jujukan, mekanisme perhatian varian dalam dimensi temporal belum diterima pakai sepenuhnya. Oleh itu, keupayaan Transformer untuk menangkap perwakilan jujukan asas dan menerangkan korelasi multivariate menjadi lemah, mengehadkan keupayaan dan keupayaan generalisasi pada data siri masa yang berbeza

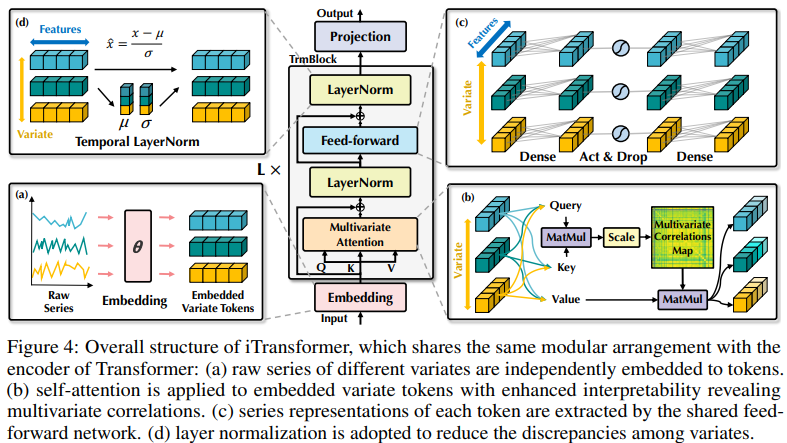

Berkenaan menukar berbilang pembolehubah pada setiap langkah masa Untuk menunjukkan ketidakrasionalan pembenaman token (masa), penyelidik bermula dari perspektif terbalik siri masa dan membenamkan keseluruhan siri masa setiap pembolehubah ke dalam token (pembolehubah) secara bebas Ini adalah kes tampalan yang melampau untuk mengembangkan medan penerimaan tempatan. Melalui penyongsangan, token terbenam mengagregatkan perwakilan global bagi jujukan, yang boleh menjadi lebih berpusatkan pembolehubah dan lebih baik menggunakan mekanisme perhatian untuk perkaitan berbilang pembolehubah. Pada masa yang sama, rangkaian suapan ke hadapan dengan mahir boleh mempelajari perwakilan umum pembolehubah berbeza yang dikodkan oleh sebarang jujukan lihat kembali dan menyahkodnya untuk meramal jujukan masa hadapan.

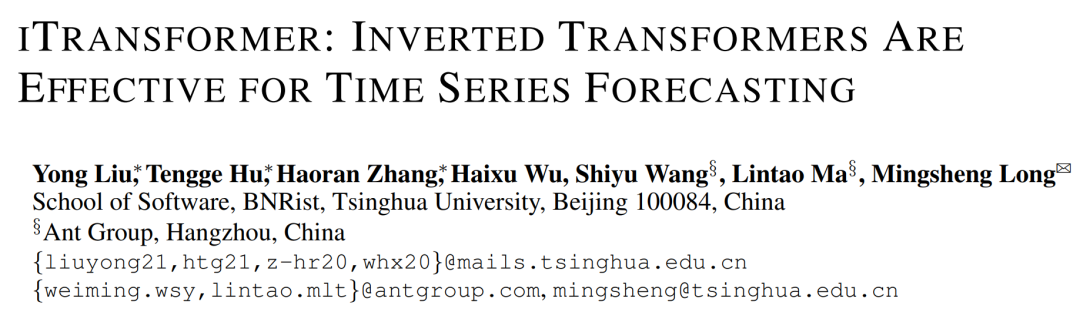

Para penyelidik menegaskan bahawa untuk ramalan siri masa, Transformer tidak sah, tetapi penggunaannya tidak sesuai. Dalam makalah ini, penyelidik mengkaji semula struktur Transformer dan mengesyorkan iTransformer sebagai tonggak asas ramalan siri masa. Mereka membenamkan setiap siri masa sebagai token pembolehubah, menggunakan mekanisme perhatian korelasi berbilang pembolehubah dan menggunakan rangkaian suapan ke hadapan untuk mengekod jujukan. Keputusan eksperimen menunjukkan bahawa iTransformer yang dicadangkan mencapai tahap terkini dalam penanda aras ramalan sebenar Rajah 1 dan secara tidak dijangka menyelesaikan masalah yang dihadapi oleh peramal berasaskan Transformer

Kesimpulannya, kertas ini. sumbangan adalah seperti berikut:

- Pengkaji membuat refleksi tentang seni bina Transformer dan mendapati bahawa keupayaan komponen Transformer asli dalam siri masa belum dibangunkan sepenuhnya.

- ITransformer yang dicadangkan dalam artikel ini menganggap siri masa bebas sebagai token, menangkap korelasi berbilang pembolehubah melalui perhatian kendiri dan menggunakan modul rangkaian normalisasi lapisan dan suapan untuk mempelajari jujukan perwakilan global yang lebih baik untuk ramalan siri masa.

- Melalui percubaan, iTransformer mencapai SOTA pada penanda aras ramalan dunia sebenar. Para penyelidik menganalisis modul penyongsangan dan pilihan seni bina, menunjukkan arah untuk penambahbaikan masa depan peramal berasaskan Transformer.

iTransformer

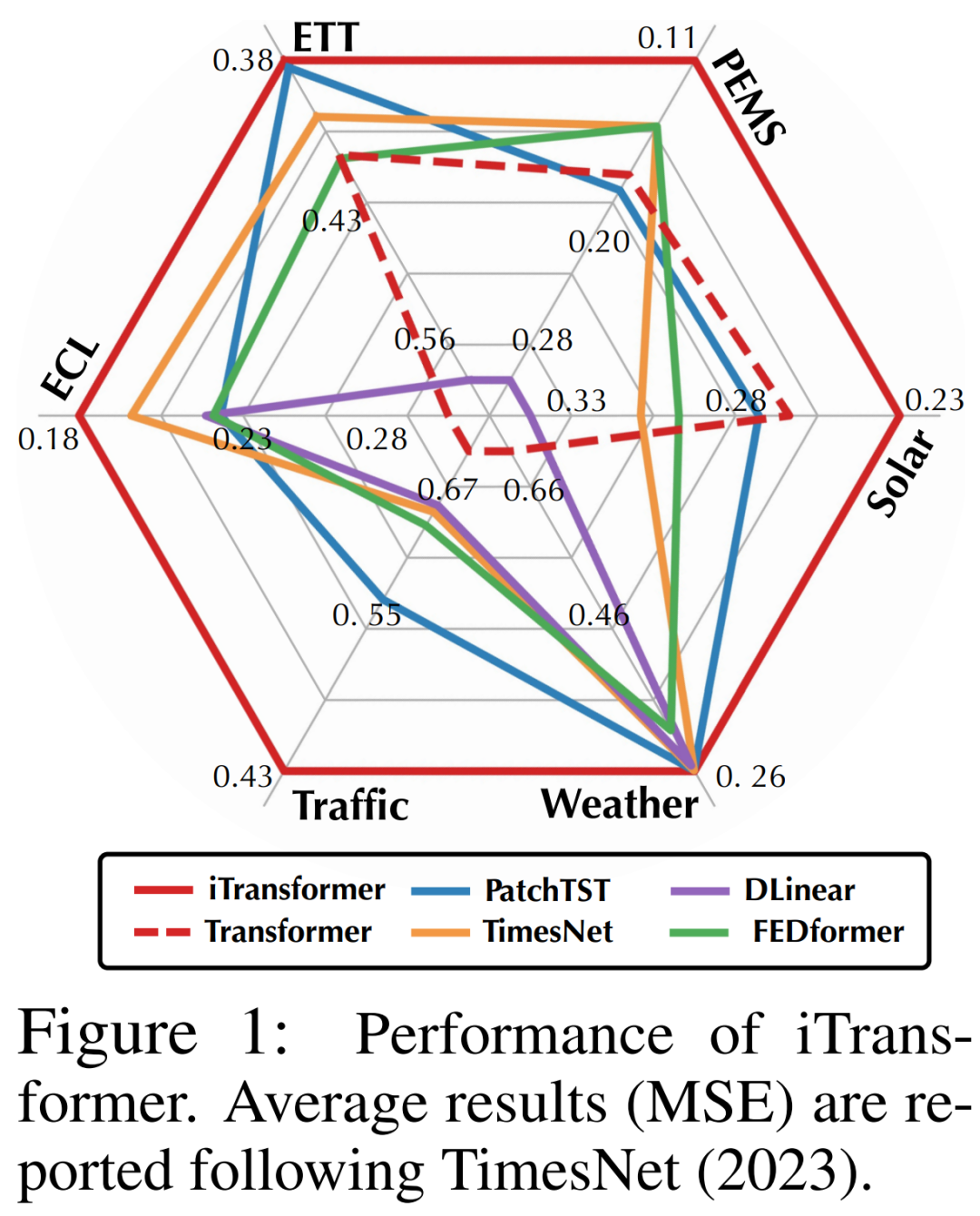

Dalam peramalan siri masa multivariate, diberi pemerhatian sejarah:

Menggunakan langkah masa T dan pembolehubah N, penyelidik meramalkan langkah masa S pada masa hadapan:  . Untuk kemudahan, nyatakan sebagai

. Untuk kemudahan, nyatakan sebagai  ialah pembolehubah multivariat yang direkodkan serentak pada langkah masa t, dan

ialah pembolehubah multivariat yang direkodkan serentak pada langkah masa t, dan  ialah keseluruhan siri masa yang diindeks oleh n untuk setiap pembolehubah. Perlu diingat bahawa dalam dunia sebenar, disebabkan kependaman sistem monitor dan set data yang tidak teratur,

ialah keseluruhan siri masa yang diindeks oleh n untuk setiap pembolehubah. Perlu diingat bahawa dalam dunia sebenar, disebabkan kependaman sistem monitor dan set data yang tidak teratur,  mungkin tidak mengandungi titik masa dengan cap masa yang sama. Elemen

mungkin tidak mengandungi titik masa dengan cap masa yang sama. Elemen

boleh berbeza antara satu sama lain dalam pengukuran fizikal dan taburan statistik, dan pembolehubah

boleh berbeza antara satu sama lain dalam pengukuran fizikal dan taburan statistik, dan pembolehubah  sering berkongsi data ini.

sering berkongsi data ini.

Varian Transformer yang dilengkapi dengan seni bina yang dicadangkan dalam artikel ini, dipanggil iTransformer, pada asasnya tidak mengemukakan keperluan yang lebih khusus untuk varian Transformer, kecuali mekanisme perhatian harus sesuai untuk pemodelan korelasi multivariate. Oleh itu, satu set mekanisme perhatian yang berkesan boleh berfungsi sebagai pemalam untuk mengurangkan kerumitan perkaitan apabila bilangan pembolehubah meningkat.

iTransformer ditunjukkan dalam gambar keempat, menggunakan seni bina pengekod Transformer yang lebih ringkas, yang termasuk pembenaman, unjuran dan blok Transformer

Eksperimen dan keputusan Transformer yang komprehensif

telah menggunakan iResearcher yang komprehensiftelah dijalankan dalam pelbagai aplikasi ramalan siri masa, mengesahkan fleksibiliti rangka kerja, dan seterusnya mengkaji kesan penyongsangan tanggungjawab komponen Transformer untuk dimensi siri masa tertentu

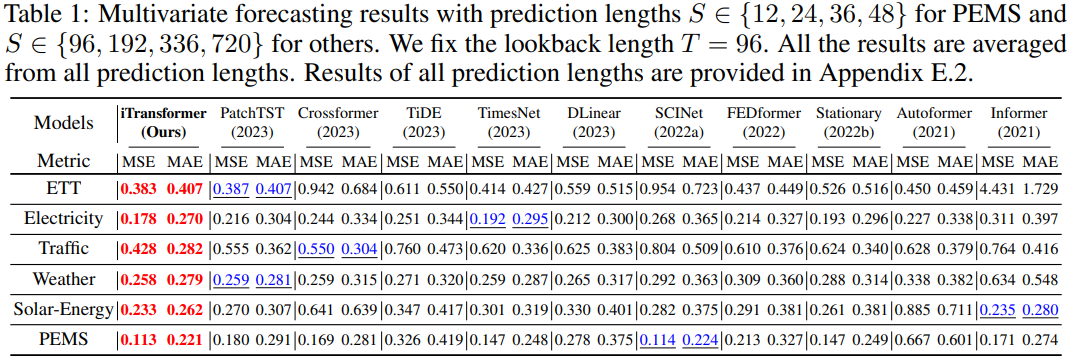

Para penyelidik secara meluas memasukkan 6 data kehidupan sebenar dalam eksperimen Set data dunia, termasuk ETT, cuaca, elektrik, set data trafik, set data tenaga suria dan set data PEMS. Untuk maklumat set data terperinci, sila rujuk teks asal

Kandungan yang ditulis semula ialah: Keputusan ramalan

ditunjukkan dalam Jadual 1, dengan merah menunjukkan optimum dan garis bawah menunjukkan optimum. Semakin rendah MSE/MAE, kandungan yang ditulis semula ialah: semakin tepat hasil ramalan. iTransformer yang dicadangkan dalam artikel ini mencapai prestasi SOTA. Komponen Transformer asli mampu memodelkan masa dan korelasi multivariat, dan seni bina songsang yang dicadangkan boleh menyelesaikan senario ramalan siri masa dunia sebenar dengan berkesan.

Apa yang perlu ditulis semula ialah: Kesejagatan iTransformer

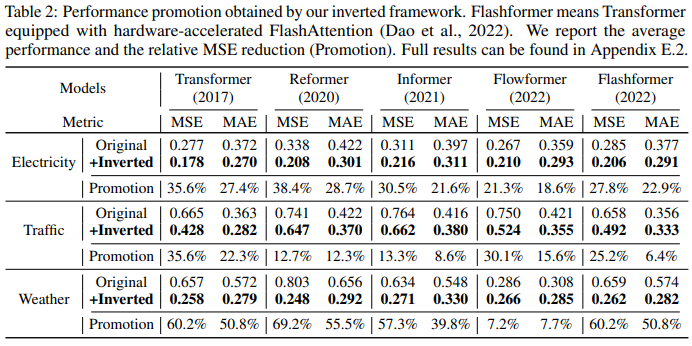

Penyelidik yang menggunakan rangka kerja ini pada Transformer dan varian sekundernya selalunya untuk menilai masalah kompleks iTransformer ini. -mekanisme perhatian, termasuk Reformer, Informer, Flowformer dan FlashAttention. Para penyelidik juga mendapati bahawa hanya menyongsangkan perspektif boleh meningkatkan prestasi peramal berasaskan Transformer, meningkatkan kecekapan, membuat generalisasi kepada pembolehubah yang tidak kelihatan dan menggunakan lebih baik data pemerhatian sejarah

Jadual 2 menunjukkan Transformers dan iTransformers Evaluate yang sepadan. Perlu diingat bahawa rangka kerja itu terus menambah baik pelbagai Transformer. Secara keseluruhan, Transformers bertambah baik dengan purata 38.9%, Reformers dengan purata 36.1%, Informers dengan purata 28.5%, Flowformers dengan purata 16.8%, dan Flashformers dengan purata 32.2%.

🎜Faktor lain ialah iTransformer boleh digunakan secara meluas dalam peramal berasaskan Transformer, kerana ia mengguna pakai struktur terbalik mekanisme perhatian dalam dimensi pembolehubah, memperkenalkan perhatian yang cekap dengan kerumitan linear, dan secara asasnya menyelesaikan isu Kecekapan disebabkan oleh 6 pembolehubah. Masalah ini biasa berlaku dalam aplikasi dunia nyata, tetapi boleh memakan sumber untuk Channel Independent

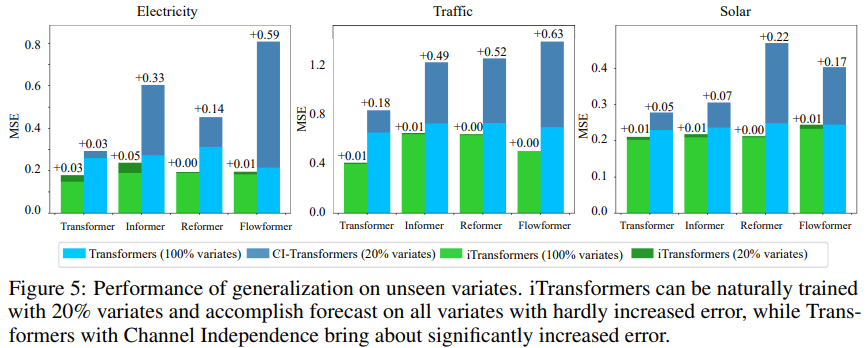

Untuk menguji hipotesis, penyelidik membandingkan iTransformer dengan strategi generalisasi lain: Channel Independent memaksa Gunakan Transformer dikongsi untuk mempelajari corak untuk semua varian. Seperti yang ditunjukkan dalam Rajah 5, ralat generalisasi Channel Independent (CI-Transformers) boleh meningkat dengan ketara, manakala peningkatan dalam ralat ramalan iTransformer adalah jauh lebih kecil.

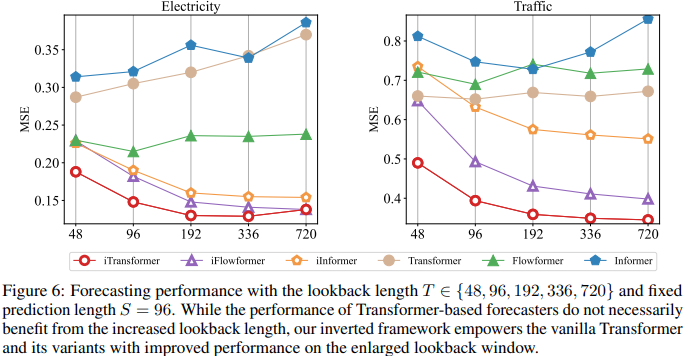

Memandangkan tanggungjawab perhatian dan rangkaian suapan disongsangkan, prestasi Transformers dan iTransformer apabila panjang lihat kembali dinilai dalam Rajah 6. Ia mengesahkan rasionaliti memanfaatkan MLP dalam dimensi temporal, iaitu Transformers boleh mendapat manfaat daripada tetingkap lihat belakang yang dilanjutkan, menghasilkan ramalan yang lebih tepat.

Analisis Model

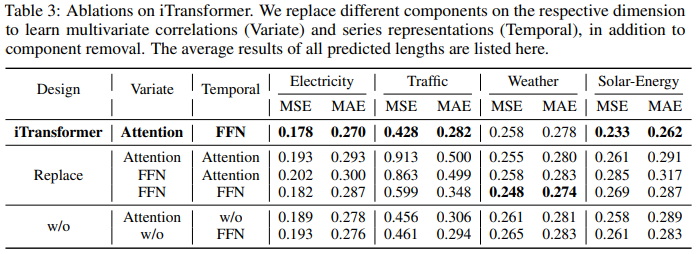

Untuk mengesahkan rasional komponen Transformer, para penyelidik menjalankan eksperimen ablasi terperinci, termasuk eksperimen penggantian komponen (Ganti) dan penyingkiran komponen (w.w). Jadual 3 menyenaraikan keputusan eksperimen.

Untuk butiran lanjut, sila rujuk artikel asal.

Atas ialah kandungan terperinci Transformer dilawati semula: penyongsangan lebih berkesan, SOTA baharu untuk ramalan dunia sebenar muncul. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1376

1376

52

52

Geospatial Laravel: Pengoptimuman peta interaktif dan sejumlah besar data

Apr 08, 2025 pm 12:24 PM

Geospatial Laravel: Pengoptimuman peta interaktif dan sejumlah besar data

Apr 08, 2025 pm 12:24 PM

Cecair memproses 7 juta rekod dan membuat peta interaktif dengan teknologi geospatial. Artikel ini meneroka cara memproses lebih dari 7 juta rekod menggunakan Laravel dan MySQL dan mengubahnya menjadi visualisasi peta interaktif. Keperluan Projek Cabaran Awal: Ekstrak Wawasan berharga menggunakan 7 juta rekod dalam pangkalan data MySQL. Ramai orang mula -mula mempertimbangkan bahasa pengaturcaraan, tetapi mengabaikan pangkalan data itu sendiri: Bolehkah ia memenuhi keperluan? Adakah penghijrahan data atau pelarasan struktur diperlukan? Bolehkah MySQL menahan beban data yang besar? Analisis awal: Penapis utama dan sifat perlu dikenalpasti. Selepas analisis, didapati bahawa hanya beberapa atribut yang berkaitan dengan penyelesaiannya. Kami mengesahkan kemungkinan penapis dan menetapkan beberapa sekatan untuk mengoptimumkan carian. Carian Peta Berdasarkan Bandar

Cara menetapkan masa tamat vue axios

Apr 07, 2025 pm 10:03 PM

Cara menetapkan masa tamat vue axios

Apr 07, 2025 pm 10:03 PM

Untuk menetapkan masa untuk Vue Axios, kita boleh membuat contoh Axios dan menentukan pilihan masa tamat: dalam tetapan global: vue.prototype. $ Axios = axios.create ({timeout: 5000}); Dalam satu permintaan: ini. $ axios.get ('/api/pengguna', {timeout: 10000}).

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Terdapat banyak sebab mengapa permulaan MySQL gagal, dan ia boleh didiagnosis dengan memeriksa log ralat. Penyebab umum termasuk konflik pelabuhan (periksa penghunian pelabuhan dan ubah suai konfigurasi), isu kebenaran (periksa keizinan pengguna yang menjalankan perkhidmatan), ralat fail konfigurasi (periksa tetapan parameter), rasuah direktori data (memulihkan data atau membina semula ruang meja), isu ruang jadual InnoDB (semak fail ibdata1) Apabila menyelesaikan masalah, anda harus menganalisisnya berdasarkan log ralat, cari punca utama masalah, dan mengembangkan tabiat sandaran data secara teratur untuk mencegah dan menyelesaikan masalah.

Cara Menggunakan MySQL Selepas Pemasangan

Apr 08, 2025 am 11:48 AM

Cara Menggunakan MySQL Selepas Pemasangan

Apr 08, 2025 am 11:48 AM

Artikel ini memperkenalkan operasi pangkalan data MySQL. Pertama, anda perlu memasang klien MySQL, seperti MySqlworkbench atau Command Line Client. 1. Gunakan perintah MySQL-Uroot-P untuk menyambung ke pelayan dan log masuk dengan kata laluan akaun root; 2. Gunakan CreateTatabase untuk membuat pangkalan data, dan gunakan Pilih pangkalan data; 3. Gunakan createtable untuk membuat jadual, menentukan medan dan jenis data; 4. Gunakan InsertInto untuk memasukkan data, data pertanyaan, kemas kini data dengan kemas kini, dan padam data dengan padam. Hanya dengan menguasai langkah -langkah ini, belajar menangani masalah biasa dan mengoptimumkan prestasi pangkalan data anda boleh menggunakan MySQL dengan cekap.

Jurutera Backend Senior Remote (Platform) memerlukan kalangan

Apr 08, 2025 pm 12:27 PM

Jurutera Backend Senior Remote (Platform) memerlukan kalangan

Apr 08, 2025 pm 12:27 PM

Jurutera Backend Senior Remote Company Kekosongan Syarikat: Lokasi Lokasi: Jauh Pejabat Jauh Jenis: Gaji sepenuh masa: $ 130,000- $ 140,000 Penerangan Pekerjaan Mengambil bahagian dalam penyelidikan dan pembangunan aplikasi mudah alih Circle dan ciri-ciri berkaitan API awam yang meliputi keseluruhan kitaran hayat pembangunan perisian. Tanggungjawab utama kerja pembangunan secara bebas berdasarkan rubyonrails dan bekerjasama dengan pasukan react/redux/relay front-end. Membina fungsi teras dan penambahbaikan untuk aplikasi web dan bekerjasama rapat dengan pereka dan kepimpinan sepanjang proses reka bentuk berfungsi. Menggalakkan proses pembangunan positif dan mengutamakan kelajuan lelaran. Memerlukan lebih daripada 6 tahun backend aplikasi web kompleks

Bolehkah mysql kembali json

Apr 08, 2025 pm 03:09 PM

Bolehkah mysql kembali json

Apr 08, 2025 pm 03:09 PM

MySQL boleh mengembalikan data JSON. Fungsi JSON_EXTRACT mengekstrak nilai medan. Untuk pertanyaan yang kompleks, pertimbangkan untuk menggunakan klausa WHERE untuk menapis data JSON, tetapi perhatikan kesan prestasinya. Sokongan MySQL untuk JSON sentiasa meningkat, dan disyorkan untuk memberi perhatian kepada versi dan ciri terkini.

Memahami sifat asid: tiang pangkalan data yang boleh dipercayai

Apr 08, 2025 pm 06:33 PM

Memahami sifat asid: tiang pangkalan data yang boleh dipercayai

Apr 08, 2025 pm 06:33 PM

Penjelasan terperinci mengenai atribut asid asid pangkalan data adalah satu set peraturan untuk memastikan kebolehpercayaan dan konsistensi urus niaga pangkalan data. Mereka menentukan bagaimana sistem pangkalan data mengendalikan urus niaga, dan memastikan integriti dan ketepatan data walaupun dalam hal kemalangan sistem, gangguan kuasa, atau pelbagai pengguna akses serentak. Gambaran keseluruhan atribut asid Atomicity: Transaksi dianggap sebagai unit yang tidak dapat dipisahkan. Mana -mana bahagian gagal, keseluruhan transaksi dilancarkan kembali, dan pangkalan data tidak mengekalkan sebarang perubahan. Sebagai contoh, jika pemindahan bank ditolak dari satu akaun tetapi tidak meningkat kepada yang lain, keseluruhan operasi dibatalkan. Begintransaction; UpdateAcCountSsetBalance = Balance-100Wh

Kunci utama MySQL boleh menjadi batal

Apr 08, 2025 pm 03:03 PM

Kunci utama MySQL boleh menjadi batal

Apr 08, 2025 pm 03:03 PM

Kunci utama MySQL tidak boleh kosong kerana kunci utama adalah atribut utama yang secara unik mengenal pasti setiap baris dalam pangkalan data. Jika kunci utama boleh kosong, rekod tidak dapat dikenal pasti secara unik, yang akan membawa kepada kekeliruan data. Apabila menggunakan lajur integer sendiri atau UUIDs sebagai kunci utama, anda harus mempertimbangkan faktor-faktor seperti kecekapan dan penghunian ruang dan memilih penyelesaian yang sesuai.