Peranti teknologi

Peranti teknologi

AI

AI

Tajuk baharu: NVIDIA H200 dikeluarkan: Kapasiti HBM meningkat sebanyak 76%, cip AI paling berkuasa yang meningkatkan prestasi model besar sebanyak 90% dengan ketara

Tajuk baharu: NVIDIA H200 dikeluarkan: Kapasiti HBM meningkat sebanyak 76%, cip AI paling berkuasa yang meningkatkan prestasi model besar sebanyak 90% dengan ketara

Tajuk baharu: NVIDIA H200 dikeluarkan: Kapasiti HBM meningkat sebanyak 76%, cip AI paling berkuasa yang meningkatkan prestasi model besar sebanyak 90% dengan ketara

Berita pada 14 November, Nvidia secara rasmi mengeluarkan GPU H200 baharu dan mengemas kini barisan produk GH200 pada persidangan "Supercomputing 23" pada pagi waktu tempatan ke-13

Antaranya, H200 masih dibina pada seni bina Hopper H100 yang sedia ada, tetapi menambah lebih banyak memori jalur lebar tinggi (HBM3e) untuk mengendalikan set data besar yang diperlukan dengan lebih baik untuk membangun dan melaksanakan kecerdasan buatan, yang membolehkan untuk menjalankan model besar Prestasi keseluruhan bertambah baik sebanyak 60% hingga 90% berbanding generasi sebelumnya H100. GH200 yang dikemas kini juga akan memberi kuasa kepada superkomputer AI generasi seterusnya. Lebih daripada 200 exaflop kuasa pengkomputeran AI akan tersedia dalam talian pada tahun 2024.

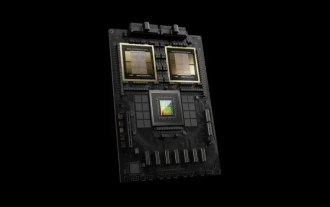

H200: Kapasiti HBM meningkat sebanyak 76%, prestasi model besar meningkat sebanyak 90%

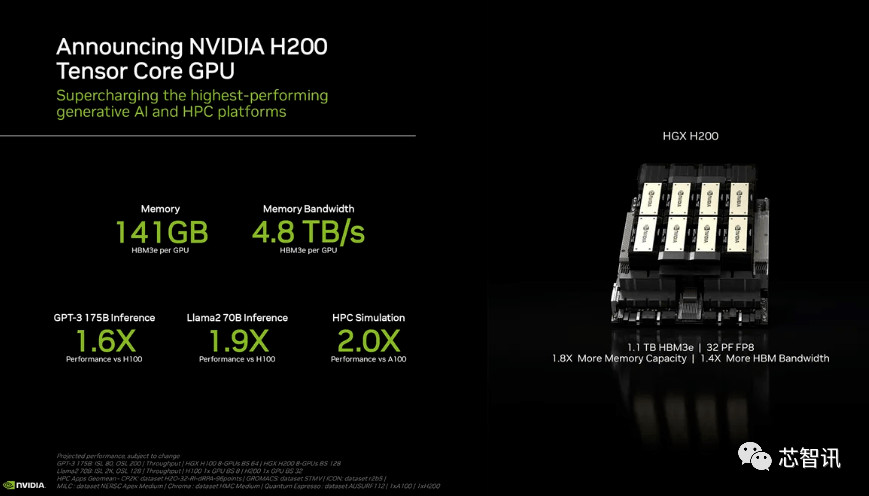

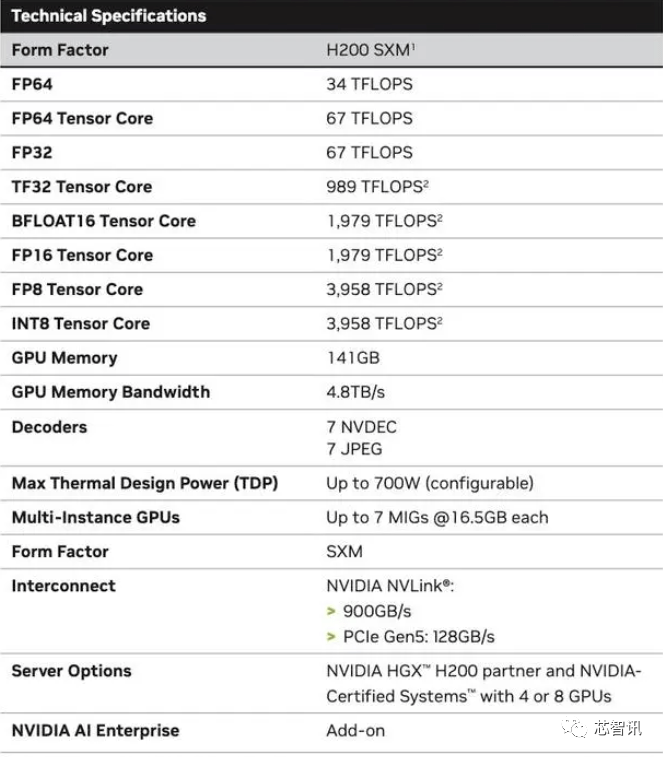

Secara khusus, H200 baharu menawarkan sehingga 141GB memori HBM3e, berjalan dengan berkesan pada kira-kira 6.25 Gbps, untuk jumlah lebar jalur 4.8 TB/s setiap GPU dalam enam tindanan HBM3e. Ini adalah peningkatan yang besar berbanding dengan H100 generasi sebelumnya (dengan lebar jalur 80GB HBM3 dan 3.35 TB/s), dengan peningkatan lebih daripada 76% dalam kapasiti HBM. Menurut data rasmi, apabila menjalankan model besar, H200 akan membawa peningkatan sebanyak 60% (GPT3 175B) kepada 90% (Llama 2 70B) berbanding H100

Walaupun beberapa konfigurasi H100 menawarkan lebih banyak memori, seperti H100 NVL yang menggandingkan kedua-dua papan dan menawarkan sejumlah 188GB memori (94GB setiap GPU), walaupun berbanding dengan varian H100 SXM, H200 SXM baharu Ia juga menyediakan 76% lebih kapasiti memori dan 43% lebih lebar jalur.

Perlu diingatkan bahawa prestasi pengkomputeran mentah H200 nampaknya tidak banyak berubah. Satu-satunya slaid Nvidia menunjukkan bahawa prestasi pengiraan yang dicerminkan adalah berdasarkan konfigurasi HGX 200 menggunakan lapan GPU, dengan jumlah prestasi "32 PFLOPS FP8." Walaupun H100 asal menyediakan 3,958 teraflop kuasa pengkomputeran FP8, lapan GPU sedemikian juga menyediakan kira-kira 32 PFLOPS kuasa pengkomputeran FP8

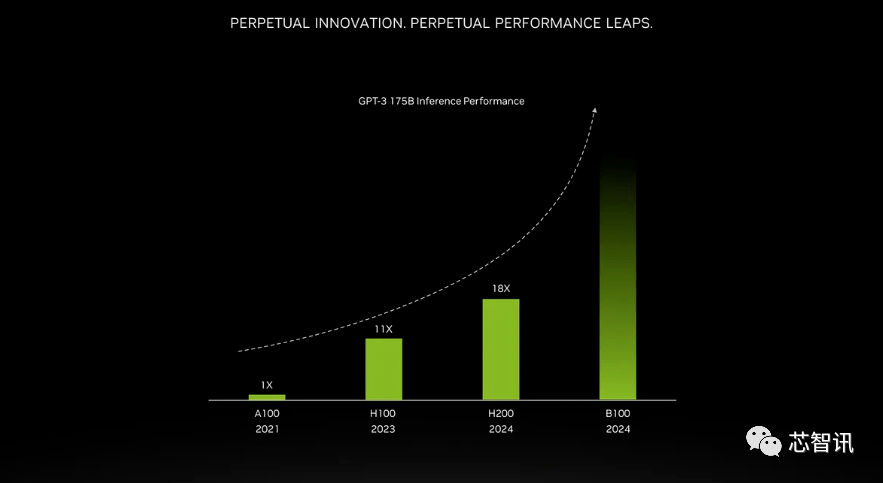

Peningkatan yang dibawa oleh memori lebar jalur yang lebih tinggi bergantung pada beban kerja. Model besar (seperti GPT-3) akan mendapat banyak manfaat daripada peningkatan kapasiti memori HBM. Menurut Nvidia, H200 akan berprestasi sehingga 18 kali lebih baik daripada A100 asal dan kira-kira 11 kali lebih pantas daripada H100 apabila menjalankan GPT-3. Selain itu, teaser untuk Blackwell B100 akan datang menunjukkan bahawa ia mengandungi bar yang lebih tinggi yang pudar kepada hitam, kira-kira dua kali lebih panjang daripada H200 paling tepat

Bukan itu sahaja, H200 dan H100 serasi antara satu sama lain. Dalam erti kata lain, syarikat AI yang menggunakan model latihan/inferens H100 boleh bertukar dengan lancar kepada cip H200 terkini. Pembekal perkhidmatan awan tidak perlu membuat sebarang pengubahsuaian apabila menambahkan H200 pada portfolio produk mereka.

Nvidia berkata dengan melancarkan produk baharu, mereka berharap dapat mengikuti pertumbuhan dalam saiz set data yang digunakan untuk mencipta model dan perkhidmatan kecerdasan buatan. Keupayaan memori yang dipertingkatkan akan menjadikan H200 lebih pantas dalam proses menyalurkan data kepada perisian, satu proses yang membantu melatih kecerdasan buatan untuk melaksanakan tugas seperti mengecam imej dan pertuturan.

“Menyepadukan memori HBM berkapasiti lebih pantas membantu meningkatkan prestasi untuk tugasan yang menuntut secara pengiraan, termasuk model AI generatif dan aplikasi pengkomputeran berprestasi tinggi, sambil mengoptimumkan penggunaan dan kecekapan GPU NVIDIA High Performance Computing kata Ian Buck, Naib Presiden Produk.

Dion Harris, ketua produk pusat data di NVIDIA, berkata: “Apabila anda melihat arah aliran dalam pembangunan pasaran, saiz model meningkat dengan pesat Ini adalah contoh bagaimana kami terus memperkenalkan teknologi terkini dan terhebat ”

Pengeluar komputer kerangka utama dan penyedia perkhidmatan awan dijangka mula menggunakan H200 pada suku kedua 2024. Rakan kongsi pembuatan pelayan NVIDIA (termasuk Evergreen, ASUS, Dell, Eviden, Gigabyte, HPE, Hongbai, Lenovo, Wenda, MetaVision, Wistron dan Wiwing) boleh menggunakan H200 untuk mengemas kini sistem sedia ada, manakala Amazon , Google, Microsoft, Oracle, dsb. akan menjadi penyedia perkhidmatan awan pertama yang mengguna pakai H200.

Memandangkan permintaan pasaran semasa yang kukuh untuk cip NVIDIA AI, dan H200 baharu menambah memori HBM3e yang lebih mahal, harga H200 pasti akan menjadi lebih mahal. Nvidia tidak menyenaraikan harga, tetapi H100 generasi sebelumnya berharga $25,000 hingga $40,000.

Jurucakap NVIDIA Kristin Uchiyama berkata bahawa harga akhir akan ditentukan oleh rakan kongsi pembuatan NVIDIA

Mengenai sama ada pelancaran H200 akan menjejaskan pengeluaran H100, Kristin Uchiyama berkata: "Kami menjangkakan jumlah bekalan sepanjang tahun akan meningkat

Cip AI mewah Nvidia sentiasa dianggap sebagai pilihan terbaik untuk memproses sejumlah besar data dan melatih model bahasa besar serta alatan penjanaan AI. Walau bagaimanapun, apabila cip H200 dilancarkan, syarikat AI masih terdesak mencari cip A100/H100 di pasaran. Tumpuan pasaran kekal sama ada Nvidia boleh menyediakan bekalan yang mencukupi untuk memenuhi permintaan pasaran. Oleh itu, NVIDIA tidak memberikan jawapan sama ada cip H200 akan kekurangan bekalan seperti cip H100

Namun, tahun depan mungkin tempoh yang lebih baik untuk pembeli GPU Menurut laporan dalam Financial Times pada bulan Ogos, NVIDIA merancang untuk menggandakan pengeluaran H100 pada tahun 2024, dan sasaran pengeluaran akan meningkat daripada kira-kira 500,000 pada tahun 2023. akan meningkat kepada. 2 juta pada 2024. Tetapi AI generatif masih berkembang pesat, dan permintaan mungkin lebih besar pada masa hadapan.

Sebagai contoh, GPT-4 yang baru dilancarkan dilatih pada kira-kira 10,000-25,000 blok A100. Model AI besar Meta memerlukan kira-kira 21,000 blok A100 untuk latihan. AI kestabilan menggunakan kira-kira 5,000 A100. Latihan Falcon-40B memerlukan 384 A100

Menurut Musk, GPT-5 mungkin memerlukan 30,000-50,000 H100. Petikan Morgan Stanley ialah 25,000 GPU.

Sam Altman menafikan latihan GPT-5, tetapi menyebut bahawa "OpenAI mengalami kekurangan GPU yang serius, dan semakin sedikit orang yang menggunakan produk kami, semakin baik."

Sudah tentu, selain NVIDIA, AMD dan Intel juga sedang giat memasuki pasaran AI untuk bersaing dengan NVIDIA. MI300X yang sebelum ini dilancarkan oleh AMD dilengkapi dengan lebar jalur memori 192GB HBM3 dan 5.2TB/s, yang akan menjadikannya jauh melebihi H200 dari segi kapasiti dan lebar jalur.

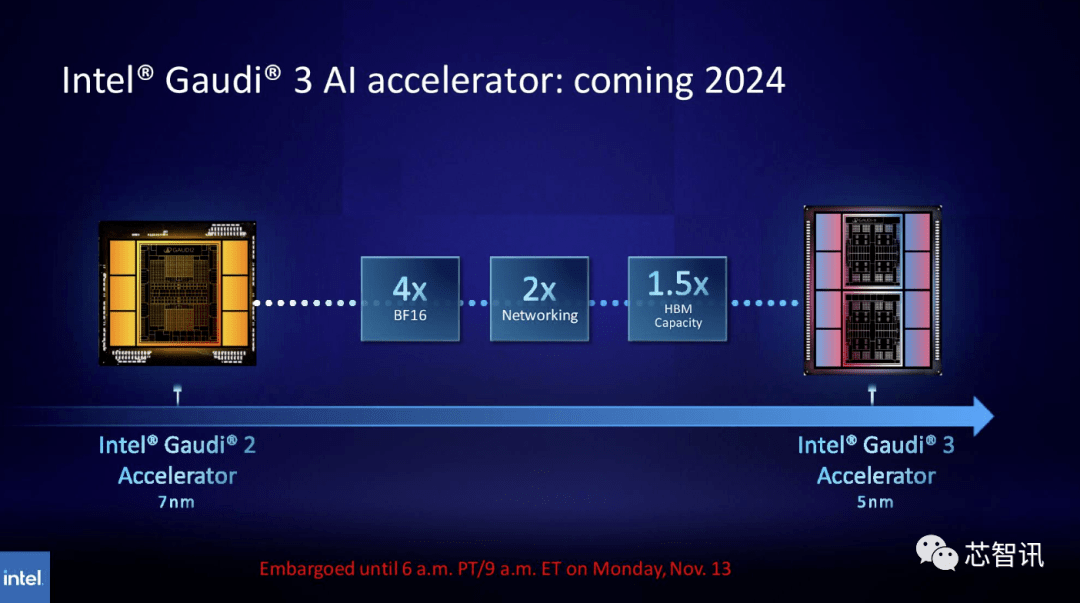

Begitu juga, Intel merancang untuk meningkatkan kapasiti HBM cip Gaudi AI. Menurut maklumat terkini yang dikeluarkan, Gaudi 3 menggunakan proses 5nm, dan prestasinya dalam beban kerja BF16 akan menjadi empat kali ganda daripada Gaudi 2, dan prestasi rangkaiannya juga akan dua kali ganda daripada Gaudi 2 (Gaudi 2 mempunyai 24 terbina dalam 100 GbE RoCE NICs ). Selain itu, Gaudi 3 mempunyai 1.5 kali ganda kapasiti HBM Gaudi 2 (Gaudi 2 mempunyai 96 GB HBM2E). Seperti yang dapat dilihat daripada gambar di bawah, Gaudi 3 menggunakan reka bentuk berasaskan chiplet dengan dua kelompok pengkomputeran, tidak seperti Gaudi 2 yang menggunakan penyelesaian cip tunggal Intel

Cip super GH200 baharu: menjana tenaga superkomputer AI generasi seterusnya

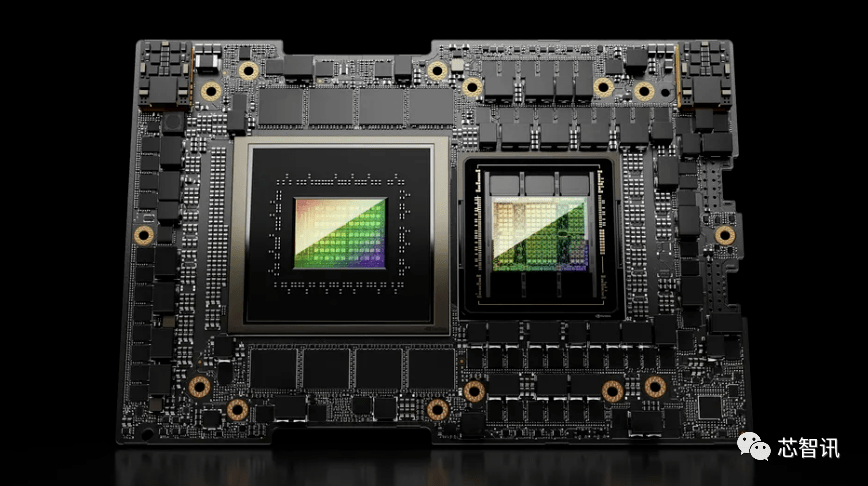

Selain mengeluarkan GPU H200 baharu, NVIDIA turut melancarkan versi cip super GH200 yang dinaik taraf. Cip ini menggunakan teknologi sambung cip NVIDIA NVLink-C2C, menggabungkan GPU H200 terkini dan CPU Grace (tidak pasti sama ada ia adalah versi yang dinaik taraf). Setiap cip super GH200 juga akan membawa sejumlah 624GB memori

Sebagai perbandingan, GH200 generasi sebelumnya adalah berdasarkan GPU H100 dan CPU Grace 72-teras, menyediakan 96GB HBM3 dan 512 GB LPDDR5X bersepadu dalam pakej yang sama.

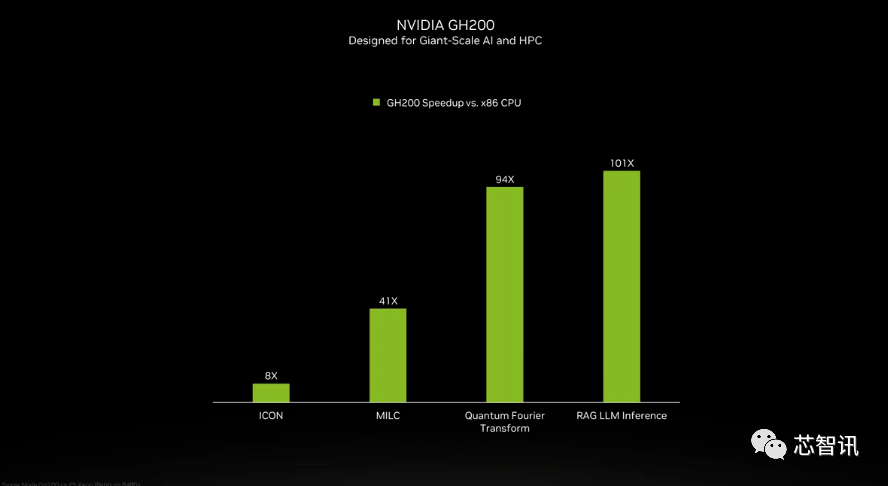

Walaupun NVIDIA tidak memperkenalkan butiran CPU Grace dalam cip super GH200, NVIDIA memberikan beberapa perbandingan antara GH200 dan "CPU x86 dwi-soket moden". Dapat dilihat bahawa GH200 telah membawa peningkatan 8 kali ganda dalam prestasi ICON, dan MILC, Quantum Fourier Transform, RAG LLM Inference, dll. telah membawa berpuluh-puluh atau bahkan ratusan kali peningkatan.

Tetapi perlu diingatkan bahawa dipercepatkan dan "sistem tidak dipercepatkan" disebut. apa maksudnya? Kami hanya boleh menganggap bahawa pelayan x86 menjalankan kod yang tidak dioptimumkan sepenuhnya, terutamanya memandangkan dunia kecerdasan buatan berkembang pesat dan kemajuan baharu dalam pengoptimuman nampaknya muncul secara tetap.

GH200 baharu juga akan digunakan dalam sistem HGX H200 baharu. Ini dikatakan "serasi dengan lancar" dengan sistem HGX H100 sedia ada, bermakna HGX H200 boleh digunakan dalam pemasangan yang sama untuk meningkatkan prestasi dan kapasiti memori tanpa perlu mereka bentuk semula infrastruktur.

Menurut laporan, superkomputer Alpine Pusat Pengkomputeran Kebangsaan Switzerland mungkin merupakan salah satu kumpulan pertama superkomputer Grace Hopper berasaskan GH100 yang mula digunakan tahun depan. Sistem GH200 pertama yang memasuki perkhidmatan di Amerika Syarikat ialah superkomputer Venado di Los Alamos National Laboratory. Sistem Vista Texas Advanced Computing Center (TACC) juga akan menggunakan cip besar Grace CPU dan Grace Hopper yang baru diumumkan, tetapi tidak jelas sama ada ia akan berasaskan H100 atau H200

Pada masa ini, superkomputer terbesar yang akan dipasang ialah superkomputer Jupiter di Pusat Pengkomputeran Besar Jϋlich. Ia akan menempatkan "hampir" 24,000 supercip GH200, berjumlah 93 exaflops pengkomputeran AI (mungkin menggunakan FP8, walaupun kebanyakan AI masih menggunakan BF16 atau FP16). Ia juga akan menyampaikan 1 exaflop pengkomputeran FP64 tradisional. Ia akan menggunakan papan "Quad GH200" dengan empat cip super GH200.

Superkomputer baharu ini yang dijangka dipasang oleh Nvidia pada tahun hadapan atau lebih akan, secara kolektif, mencapai lebih daripada 200 exaflop kuasa pengkomputeran kecerdasan buatan

Jika maksud asal tidak perlu diubah, isinya perlu ditulis semula ke dalam bahasa Cina, dan ayat asal tidak perlu muncul

Atas ialah kandungan terperinci Tajuk baharu: NVIDIA H200 dikeluarkan: Kapasiti HBM meningkat sebanyak 76%, cip AI paling berkuasa yang meningkatkan prestasi model besar sebanyak 90% dengan ketara. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

NVIDIA melancarkan fungsi RTX HDR: permainan yang tidak disokong menggunakan penapis AI untuk mencapai kesan visual HDR yang cantik

Feb 24, 2024 pm 06:37 PM

NVIDIA melancarkan fungsi RTX HDR: permainan yang tidak disokong menggunakan penapis AI untuk mencapai kesan visual HDR yang cantik

Feb 24, 2024 pm 06:37 PM

Menurut berita dari laman web ini pada 23 Februari, NVIDIA mengemas kini dan melancarkan aplikasi NVIDIA malam tadi, menyediakan pemain dengan pusat kawalan GPU bersatu baharu, membolehkan pemain merakam detik indah melalui alat rakaman berkuasa yang disediakan oleh terapung dalam permainan. tingkap. Dalam kemas kini ini, NVIDIA turut memperkenalkan fungsi RTXHDR Pengenalan rasmi dilampirkan seperti berikut: RTXHDR ialah penapis Freestyle baharu yang diperkasakan AI yang boleh memperkenalkan kesan visual cantik julat dinamik tinggi (HDR) ke dalam permainan yang tidak pada asalnya. menyokong HDR. Apa yang anda perlukan ialah monitor serasi HDR untuk menggunakan ciri ini dengan pelbagai jenis permainan berasaskan DirectX dan Vulkan. Selepas pemain mendayakan fungsi RTXHDR, permainan akan berjalan walaupun ia tidak menyokong HD

Dilaporkan bahawa kad grafik siri NVIDIA RTX 50 dilengkapi secara asli dengan antara muka bekalan kuasa 16-Pin PCIe Gen 6

Feb 20, 2024 pm 12:00 PM

Dilaporkan bahawa kad grafik siri NVIDIA RTX 50 dilengkapi secara asli dengan antara muka bekalan kuasa 16-Pin PCIe Gen 6

Feb 20, 2024 pm 12:00 PM

Menurut berita dari laman web ini pada 19 Februari, dalam video terbaharu saluran LawisDead Moore, sauh Tom mendedahkan bahawa kad grafik siri Nvidia GeForce RTX50 akan dilengkapi secara asli dengan antara muka bekalan kuasa 16-Pin PCIeGen6. Tom berkata bahawa sebagai tambahan kepada siri GeForceRTX5080 dan GeForceRTX5090 mewah, GeForceRTX5060 julat pertengahan juga akan membolehkan antara muka bekalan kuasa baharu. Dilaporkan bahawa Nvidia telah menetapkan keperluan yang jelas bahawa pada masa hadapan, setiap siri GeForce RTX50 akan dilengkapi dengan antara muka bekalan kuasa 16-Pin PCIeGen6 untuk memudahkan rantaian bekalan. Tangkapan skrin yang dilampirkan pada tapak ini adalah seperti berikut: Tom juga berkata bahawa GeForceRTX5090

Kad grafik NVIDIA RTX 4070 dan 4060 Ti FE telah jatuh di bawah harga runcit yang disyorkan, masing-masing 4599/2999 yuan

Feb 22, 2024 pm 09:43 PM

Kad grafik NVIDIA RTX 4070 dan 4060 Ti FE telah jatuh di bawah harga runcit yang disyorkan, masing-masing 4599/2999 yuan

Feb 22, 2024 pm 09:43 PM

Menurut berita dari laman web ini pada 22 Februari, secara amnya, NVIDIA dan AMD mempunyai sekatan pada harga saluran, dan beberapa peniaga yang secara peribadi mengurangkan harga dengan ketara juga akan dihukum sebagai contoh, AMD baru-baru ini menghukum peniaga yang menjual kad grafik 6750GRE pada harga di bawah harga minimum Peniaga itu dihukum. Laman web ini mendapati bahawa NVIDIA GeForce RTX 4070 dan 4060 Ti telah jatuh ke tahap paling rendah Versi pengasas mereka, iaitu versi awam kad grafik, pada masa ini boleh menerima kupon 200 yuan di kedai kendalian sendiri JD.com, dengan. harga 4,599 yuan dan 2,999 yuan. Sudah tentu, jika anda mempertimbangkan kedai pihak ketiga, akan ada harga yang lebih rendah. Dari segi parameter, kad grafik RTX4070 mempunyai teras 5888CUDA, menggunakan memori 12GBGDDR6X dan sedikit lebar 192bi

Model dialog NVIDIA ChatQA telah berkembang kepada versi 2.0, dengan panjang konteks disebut pada 128K

Jul 26, 2024 am 08:40 AM

Model dialog NVIDIA ChatQA telah berkembang kepada versi 2.0, dengan panjang konteks disebut pada 128K

Jul 26, 2024 am 08:40 AM

Komuniti LLM terbuka ialah era apabila seratus bunga mekar dan bersaing Anda boleh melihat Llama-3-70B-Instruct, QWen2-72B-Instruct, Nemotron-4-340B-Instruct, Mixtral-8x22BInstruct-v0.1 dan banyak lagi. model yang cemerlang. Walau bagaimanapun, berbanding dengan model besar proprietari yang diwakili oleh GPT-4-Turbo, model terbuka masih mempunyai jurang yang ketara dalam banyak bidang. Selain model umum, beberapa model terbuka yang mengkhusus dalam bidang utama telah dibangunkan, seperti DeepSeek-Coder-V2 untuk pengaturcaraan dan matematik, dan InternVL untuk tugasan bahasa visual.

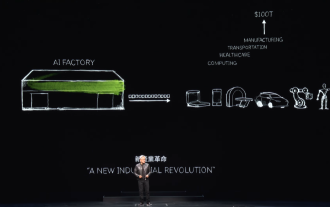

'Kilang AI' akan mempromosikan pembentukan semula keseluruhan susunan perisian, dan NVIDIA menyediakan bekas Llama3 NIM untuk digunakan oleh pengguna

Jun 08, 2024 pm 07:25 PM

'Kilang AI' akan mempromosikan pembentukan semula keseluruhan susunan perisian, dan NVIDIA menyediakan bekas Llama3 NIM untuk digunakan oleh pengguna

Jun 08, 2024 pm 07:25 PM

Menurut berita dari laman web ini pada 2 Jun, pada ucaptama Huang Renxun 2024 Taipei Computex yang sedang berlangsung, Huang Renxun memperkenalkan kecerdasan buatan generatif akan mempromosikan pembentukan semula keseluruhan timbunan perisian dan menunjukkan perkhidmatan mikro asli awan NIM (Nvidia Inference Microservices). . Nvidia percaya bahawa "kilang AI" akan mencetuskan revolusi perindustrian baharu: mengambil industri perisian yang dipelopori oleh Microsoft sebagai contoh, Huang Renxun percaya bahawa kecerdasan buatan generatif akan menggalakkan pembentukan semula timbunan penuhnya. Untuk memudahkan penggunaan perkhidmatan AI oleh perusahaan dari semua saiz, NVIDIA melancarkan perkhidmatan mikro asli awan NIM (Nvidia Inference Microservices) pada Mac tahun ini. NIM+ ialah satu set perkhidmatan mikro asli awan yang dioptimumkan untuk mengurangkan masa ke pasaran

Selepas pelbagai transformasi dan kerjasama dengan gergasi AI Nvidia, mengapa Rantaian Vanar melonjak 4.6 kali dalam 30 hari?

Mar 14, 2024 pm 05:31 PM

Selepas pelbagai transformasi dan kerjasama dengan gergasi AI Nvidia, mengapa Rantaian Vanar melonjak 4.6 kali dalam 30 hari?

Mar 14, 2024 pm 05:31 PM

Baru-baru ini, Layer1 blockchain VanarChain telah menarik perhatian pasaran kerana kadar pertumbuhan yang tinggi dan kerjasama dengan NVIDIA gergasi AI. Di sebalik populariti VanarChain, selain melalui pelbagai transformasi jenama, konsep popular seperti permainan utama, metaverse dan AI juga telah memperoleh banyak populariti dan topik projek. Sebelum transformasinya, Vanar, dahulunya TerraVirtua, diasaskan pada 2018 sebagai platform yang menyokong langganan berbayar, menyediakan kandungan realiti maya (VR) dan realiti tambahan (AR), dan menerima pembayaran mata wang kripto. Platform ini dicipta oleh pengasas bersama Gary Bracey dan Jawad Ashraf, dengan Gary Bracey mempunyai pengalaman luas yang terlibat dalam pengeluaran dan pembangunan permainan video.

Bagaimana untuk meningkatkan kadar hit kritikal dalam Love dan Deep Space

Mar 23, 2024 pm 01:31 PM

Bagaimana untuk meningkatkan kadar hit kritikal dalam Love dan Deep Space

Mar 23, 2024 pm 01:31 PM

Watak dalam Love dan Deep Sky mempunyai pelbagai atribut berangka Setiap atribut dalam permainan mempunyai peranan tertentu Atribut kadar pukulan kritikal akan mempengaruhi kerosakan watak, yang boleh dikatakan sebagai atribut yang sangat penting berikut ialah kaedah untuk menambah baik atribut ini, jadi pemain yang ingin tahu boleh melihat. Kaedah 1. Kaedah teras untuk meningkatkan kadar hit kritikal Love dan Deep Space Untuk mencapai kadar hit kritikal sebanyak 80%, kuncinya terletak pada jumlah atribut hit kritikal enam kad di tangan anda. Pemilihan Kad Corona: Apabila memilih dua Kad Corona, pastikan sekurang-kurangnya satu daripada entri sub-atribut teras α dan teras β ialah atribut hit kritikal. Kelebihan Kad Lunar Corona: Bukan sahaja kad Lunar Corona menyertakan pukulan kritikal dalam atribut asasnya, tetapi apabila ia mencapai tahap 60 dan belum menembusi, setiap kad boleh memberikan 4.1% pukulan kritikal.

TrendForce: Produk platform Blackwell Nvidia memacu kapasiti pengeluaran CoWoS TSMC untuk meningkat sebanyak 150% tahun ini

Apr 17, 2024 pm 08:00 PM

TrendForce: Produk platform Blackwell Nvidia memacu kapasiti pengeluaran CoWoS TSMC untuk meningkat sebanyak 150% tahun ini

Apr 17, 2024 pm 08:00 PM

Menurut berita dari laman web ini pada 17 April, TrendForce baru-baru ini mengeluarkan laporan, mempercayai bahawa permintaan untuk produk platform Blackwell baharu Nvidia adalah menaik, dan dijangka memacu jumlah kapasiti pengeluaran pembungkusan CoWoS TSMC meningkat lebih daripada 150% pada 2024. Produk platform baharu NVIDIA Blackwell termasuk GPU siri B dan kad pemecut GB200 yang menyepadukan CPU GraceArm NVIDIA sendiri. TrendForce mengesahkan bahawa rantaian bekalan pada masa ini sangat optimistik tentang GB200, dengan penghantaran dijangka melebihi satu juta unit pada 2025, menyumbang 40-50% daripada GPU mewah Nvidia. Nvidia merancang untuk menyampaikan produk seperti GB200 dan B100 pada separuh kedua tahun ini, tetapi pembungkusan wafer huluan mesti terus menggunakan produk yang lebih kompleks.