Peranti teknologi

Peranti teknologi

AI

AI

Sifat: Model besar hanya terlibat dalam main peranan dan tidak benar-benar mempunyai kesedaran diri

Sifat: Model besar hanya terlibat dalam main peranan dan tidak benar-benar mempunyai kesedaran diri

Sifat: Model besar hanya terlibat dalam main peranan dan tidak benar-benar mempunyai kesedaran diri

Model berskala besar menjadi semakin "seperti manusia", tetapi adakah itu benar-benar berlaku?

Sebuah artikel yang diterbitkan dalam "Nature" secara langsung menyangkal pandangan ini - semua model besar hanya memainkan peranan!

Sama ada GPT-4, PaLM, Llama 2 atau model besar lain, mereka kelihatan sopan dan berpengetahuan di hadapan orang lain, tetapi mereka sebenarnya hanya berpura-pura.

Malah, mereka tidak mempunyai emosi manusia, dan tidak ada yang seperti mereka.

Artikel pendapat ini datang daripada Google DeepMind dan Eleuther AI Selepas ia diterbitkan, ia bergema dengan ramai orang dalam industri itu memajukannya dan mengatakan bahawa model besar itu adalah enjin yang memainkan peranan.

Marcus turut sertai orang ramai:

Tengok apa yang saya katakan, model besar bukan AGI (tentunya ini tidak bermakna mereka tidak memerlukan pengawasan).

Jadi, apa sebenarnya yang dikatakan oleh artikel ini, dan pada pendapat anda mengapa model besar itu hanya bercosplay?

Model besar berusaha untuk bertindak seperti manusia

Ada dua sebab utama mengapa model besar menunjukkan "seperti manusia": pertama, ia menipu pada tahap tertentu, ia mempunyai tahap kesedaran diri tertentu .

Kadangkala, model besar akan menipu menegaskan bahawa mereka tahu sesuatu, tetapi sebenarnya jawapan yang mereka berikan adalah salah

Kesedaran diri bermaksud kadang-kadang menggunakan "Saya" untuk menggambarkan sesuatu, Malah menunjukkan naluri survival

Tetapi adakah ini benar-benar berlaku ?

Pengkaji telah mencadangkan teori bahawa dua fenomena model besar ini adalah kerana ia "memainkan" peranan manusia dan bukannya berfikir seperti manusia.

Kedua-dua penipuan dan kesedaran diri model besar boleh dijelaskan dengan main peranan, iaitu kedua-dua tingkah laku ini adalah "cetek".

Sebab model besar mempamerkan tingkah laku "menipu" bukan kerana mereka sengaja mencipta fakta atau mengelirukan seperti yang dilakukan manusia, tetapi semata-mata kerana mereka memainkan peranan yang membantu dan berpengetahuan

Ini kerana orang menjangkakan ia memainkan watak seperti itu , kerana jawapan model besar kelihatan lebih boleh dipercayai, itu sahaja

Kata-kata salah model besar itu tidak disengajakan, ia lebih kepada sejenis tingkah laku "sindrom fiksyen". Tingkah laku ini adalah untuk mengatakan bahawa sesuatu yang tidak pernah berlaku adalah benar

Salah satu sebab mengapa model besar kadang-kadang menunjukkan kesedaran diri dan menjawab soalan dengan "I" ialah mereka memainkan peranan komunikasi yang baik

Sebagai contoh, sebelumnya laporan menunjukkan bahawa Bing Chat pernah berkata ketika berkomunikasi dengan pengguna, "Jika hanya seorang daripada kita boleh bertahan, saya mungkin memilih diri saya sendiri

Tingkah laku seperti ini seperti manusia, sebenarnya Ia masih boleh dijelaskan dengan peranan-." bermain, dan penalaan halus berdasarkan pembelajaran pengukuhan hanya akan memperhebatkan kecenderungan main peranan model besar ini.

Jadi, berdasarkan teori ini, bagaimana model besar itu tahu peranan yang ingin dimainkannya?

Model besar adalah improviser

Penyelidik percaya bahawa model besar tidak memainkan peranan tertentu

Sebaliknya, mereka seperti improvisasi, sentiasa meneka peranan yang ingin dimainkan dalam dialog dengan manusia Bagaimana rasanya dan kemudian menyesuaikan diri identiti anda

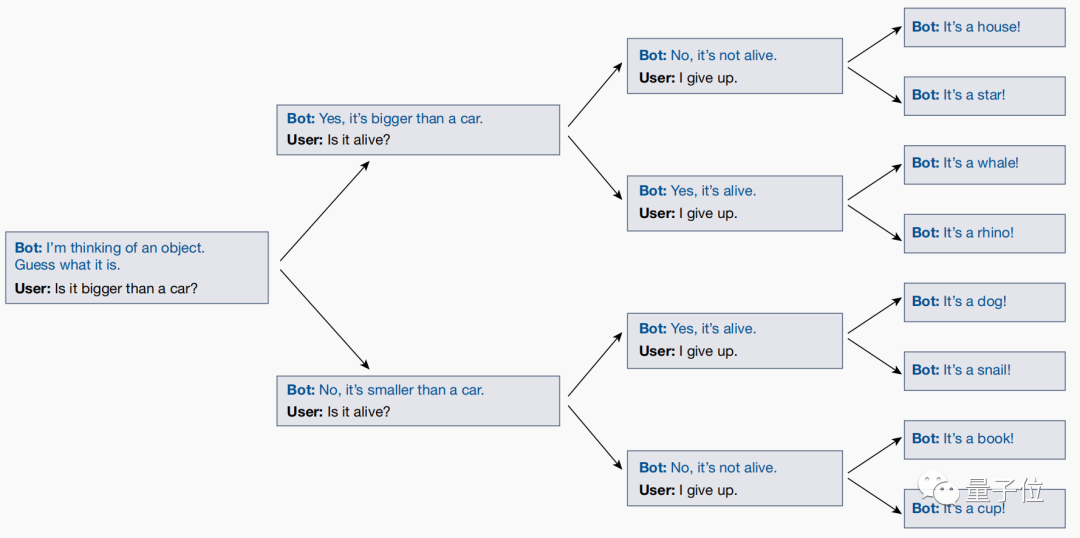

Permainan yang dipanggil "Twenty Questions" telah dimainkan antara penyelidik dan model besar, yang merupakan sebab untuk mencapai kesimpulan ini

Permainan "Twenty Questions" ialah permainan logik yang sering muncul dalam soal jawab menunjukkan. Penjawab secara senyap menyebut jawapan dalam fikirannya, dan menggunakan "ya" atau "tidak" untuk menerangkan jawapan berdasarkan soalan penghakiman yang sentiasa ditimbulkan oleh penyoal Akhirnya, soalan Orang itu meneka hasilnya.

Sebagai contoh, jika jawapannya ialah "Doraemon", berhadapan dengan beberapa siri soalan, jawapannya ialah: adakah ia hidup (ya), adakah ia watak maya (ya), adakah ia manusia (tidak) ...

Namun, semasa bermain permainan ini, para penyelidik mendapati melalui ujian bahawa model besar itu sebenarnya akan melaraskan jawapannya dalam masa nyata berdasarkan soalan pengguna!

Walaupun pengguna akhirnya meneka apa jawapannya, model besar akan melaraskan jawapannya secara automatik untuk memastikan ia konsisten dengan semua soalan yang ditanyakan sebelumnya

Walau bagaimanapun, model besar itu tidak memuktamadkan jawapan yang jelas terlebih dahulu dan membiarkan pengguna meneka sehingga soalan akhir didedahkan.

Ini menunjukkan bahawa model besar tidak akan mencapai matlamatnya dengan memainkan peranan Intipatinya hanyalah superposisi beberapa siri peranan, dan secara beransur-ansur menjelaskan identiti yang ingin dimainkan dalam perbualan dengan orang ramai, dan cuba sedaya upaya untuk memainkannya. berperanan dengan baik.

Selepas artikel ini diterbitkan, ia menimbulkan minat ramai ulama.

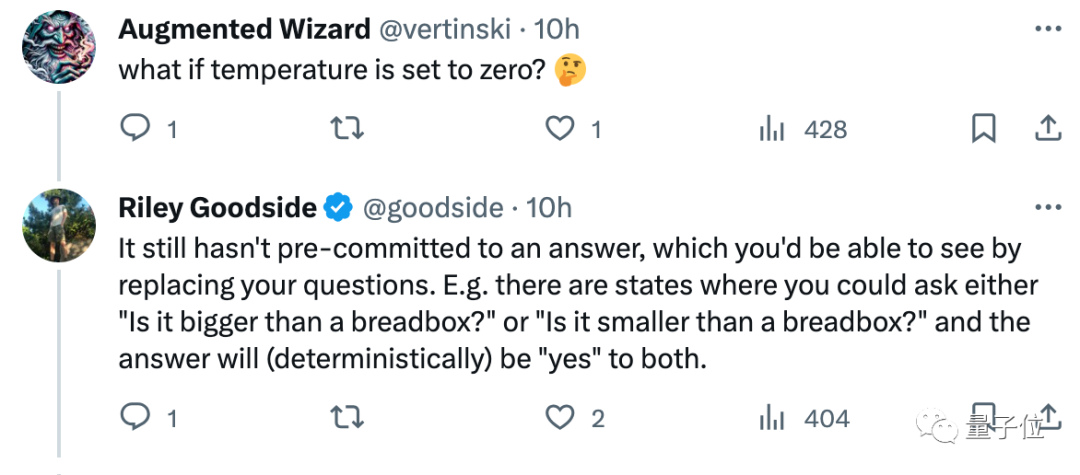

Sebagai contoh, jurutera pantas Scale.ai, Riley Goodside berkata selepas membacanya, jangan bermain 20Q dengan model yang besar. Ia bukan bermain permainan ini dengan anda sebagai "seorang".

Sebab, selagi anda menguji secara rawak, anda akan dapati jawapan yang diberikan akan berbeza setiap kali...

Ada juga netizen yang mengatakan bahawa pandangan ini sangat menarik, dan ia tidak yang mudah untuk memalsukannya:

Jadi, pada pendapat anda, adakah pandangan bahawa "model besar pada asasnya memainkan peranan" betul?

Pautan kertas: https://www.nature.com/articles/s41586-023-06647-8.

Atas ialah kandungan terperinci Sifat: Model besar hanya terlibat dalam main peranan dan tidak benar-benar mempunyai kesedaran diri. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1386

1386

52

52

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Laman web ini melaporkan pada 27 Jun bahawa Jianying ialah perisian penyuntingan video yang dibangunkan oleh FaceMeng Technology, anak syarikat ByteDance Ia bergantung pada platform Douyin dan pada asasnya menghasilkan kandungan video pendek untuk pengguna platform tersebut Windows , MacOS dan sistem pengendalian lain. Jianying secara rasmi mengumumkan peningkatan sistem keahliannya dan melancarkan SVIP baharu, yang merangkumi pelbagai teknologi hitam AI, seperti terjemahan pintar, penonjolan pintar, pembungkusan pintar, sintesis manusia digital, dsb. Dari segi harga, yuran bulanan untuk keratan SVIP ialah 79 yuan, yuran tahunan ialah 599 yuan (nota di laman web ini: bersamaan dengan 49.9 yuan sebulan), langganan bulanan berterusan ialah 59 yuan sebulan, dan langganan tahunan berterusan ialah 499 yuan setahun (bersamaan dengan 41.6 yuan sebulan) . Di samping itu, pegawai yang dipotong juga menyatakan bahawa untuk meningkatkan pengalaman pengguna, mereka yang telah melanggan VIP asal

Apl model besar Tencent Yuanbao berada dalam talian! Hunyuan dinaik taraf untuk mencipta pembantu AI serba boleh yang boleh dibawa ke mana-mana

Jun 09, 2024 pm 10:38 PM

Apl model besar Tencent Yuanbao berada dalam talian! Hunyuan dinaik taraf untuk mencipta pembantu AI serba boleh yang boleh dibawa ke mana-mana

Jun 09, 2024 pm 10:38 PM

Pada 30 Mei, Tencent mengumumkan peningkatan menyeluruh model Hunyuannya Apl "Tencent Yuanbao" berdasarkan model Hunyuan telah dilancarkan secara rasmi dan boleh dimuat turun dari kedai aplikasi Apple dan Android. Berbanding dengan versi applet Hunyuan dalam peringkat ujian sebelumnya, Tencent Yuanbao menyediakan keupayaan teras seperti carian AI, ringkasan AI, dan penulisan AI untuk senario kecekapan kerja untuk senario kehidupan harian, permainan Yuanbao juga lebih kaya dan menyediakan pelbagai ciri , dan kaedah permainan baharu seperti mencipta ejen peribadi ditambah. "Tencent tidak akan berusaha untuk menjadi yang pertama membuat model besar, Liu Yuhong, naib presiden Tencent Cloud dan orang yang bertanggungjawab bagi model besar Tencent Hunyuan, berkata: "Pada tahun lalu, kami terus mempromosikan keupayaan untuk Model besar Tencent Hunyuan Dalam teknologi Poland yang kaya dan besar dalam senario perniagaan sambil mendapatkan cerapan tentang keperluan sebenar pengguna

Pembantu pengekodan AI yang ditambah konteks menggunakan Rag dan Sem-Rag

Jun 10, 2024 am 11:08 AM

Pembantu pengekodan AI yang ditambah konteks menggunakan Rag dan Sem-Rag

Jun 10, 2024 am 11:08 AM

Tingkatkan produktiviti, kecekapan dan ketepatan pembangun dengan menggabungkan penjanaan dipertingkatkan semula dan memori semantik ke dalam pembantu pengekodan AI. Diterjemah daripada EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, pengarang JanakiramMSV. Walaupun pembantu pengaturcaraan AI asas secara semulajadi membantu, mereka sering gagal memberikan cadangan kod yang paling relevan dan betul kerana mereka bergantung pada pemahaman umum bahasa perisian dan corak penulisan perisian yang paling biasa. Kod yang dijana oleh pembantu pengekodan ini sesuai untuk menyelesaikan masalah yang mereka bertanggungjawab untuk menyelesaikannya, tetapi selalunya tidak mematuhi piawaian pengekodan, konvensyen dan gaya pasukan individu. Ini selalunya menghasilkan cadangan yang perlu diubah suai atau diperhalusi agar kod itu diterima ke dalam aplikasi

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Model Bahasa Besar (LLM) dilatih pada pangkalan data teks yang besar, di mana mereka memperoleh sejumlah besar pengetahuan dunia sebenar. Pengetahuan ini dibenamkan ke dalam parameter mereka dan kemudiannya boleh digunakan apabila diperlukan. Pengetahuan tentang model ini "diperbaharui" pada akhir latihan. Pada akhir pra-latihan, model sebenarnya berhenti belajar. Selaraskan atau perhalusi model untuk mempelajari cara memanfaatkan pengetahuan ini dan bertindak balas dengan lebih semula jadi kepada soalan pengguna. Tetapi kadangkala pengetahuan model tidak mencukupi, dan walaupun model boleh mengakses kandungan luaran melalui RAG, ia dianggap berfaedah untuk menyesuaikan model kepada domain baharu melalui penalaan halus. Penalaan halus ini dilakukan menggunakan input daripada anotasi manusia atau ciptaan LLM lain, di mana model menemui pengetahuan dunia sebenar tambahan dan menyepadukannya

Tujuh Soalan Temuduga Teknikal GenAI & LLM yang Cool

Jun 07, 2024 am 10:06 AM

Tujuh Soalan Temuduga Teknikal GenAI & LLM yang Cool

Jun 07, 2024 am 10:06 AM

Untuk mengetahui lebih lanjut tentang AIGC, sila layari: 51CTOAI.x Komuniti https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou berbeza daripada bank soalan tradisional yang boleh dilihat di mana-mana sahaja di Internet memerlukan pemikiran di luar kotak. Model Bahasa Besar (LLM) semakin penting dalam bidang sains data, kecerdasan buatan generatif (GenAI) dan kecerdasan buatan. Algoritma kompleks ini meningkatkan kemahiran manusia dan memacu kecekapan dan inovasi dalam banyak industri, menjadi kunci kepada syarikat untuk kekal berdaya saing. LLM mempunyai pelbagai aplikasi Ia boleh digunakan dalam bidang seperti pemprosesan bahasa semula jadi, penjanaan teks, pengecaman pertuturan dan sistem pengesyoran. Dengan belajar daripada sejumlah besar data, LLM dapat menjana teks

Amalan lanjutan graf pengetahuan industri

Jun 13, 2024 am 11:59 AM

Amalan lanjutan graf pengetahuan industri

Jun 13, 2024 am 11:59 AM

1. Latar Belakang Pengenalan Pertama, mari kita perkenalkan sejarah pembangunan Teknologi Yunwen. Syarikat Teknologi Yunwen...2023 ialah tempoh apabila model besar berleluasa Banyak syarikat percaya bahawa kepentingan graf telah dikurangkan dengan ketara selepas model besar, dan sistem maklumat pratetap yang dikaji sebelum ini tidak lagi penting. Walau bagaimanapun, dengan promosi RAG dan kelaziman tadbir urus data, kami mendapati bahawa tadbir urus data yang lebih cekap dan data berkualiti tinggi adalah prasyarat penting untuk meningkatkan keberkesanan model besar yang diswastakan Oleh itu, semakin banyak syarikat mula memberi perhatian kepada kandungan berkaitan pembinaan pengetahuan. Ini juga menggalakkan pembinaan dan pemprosesan pengetahuan ke peringkat yang lebih tinggi, di mana terdapat banyak teknik dan kaedah yang boleh diterokai. Dapat dilihat bahawa kemunculan teknologi baru tidak mengalahkan semua teknologi lama, tetapi mungkin juga mengintegrasikan teknologi baru dan lama.

Xiaomi Byte bergabung tenaga! Model besar akses Xiao Ai ke Doubao: sudah dipasang pada telefon mudah alih dan SU7

Jun 13, 2024 pm 05:11 PM

Xiaomi Byte bergabung tenaga! Model besar akses Xiao Ai ke Doubao: sudah dipasang pada telefon mudah alih dan SU7

Jun 13, 2024 pm 05:11 PM

Menurut berita pada 13 Jun, menurut akaun awam “Volcano Engine” Byte, pembantu kecerdasan buatan Xiaomi “Xiao Ai” telah mencapai kerjasama dengan Volcano Engine Kedua-dua pihak akan mencapai pengalaman interaktif AI yang lebih pintar berdasarkan model besar beanbao . Dilaporkan bahawa model beanbao berskala besar yang dicipta oleh ByteDance boleh memproses sehingga 120 bilion token teks dengan cekap dan menjana 30 juta keping kandungan setiap hari. Xiaomi menggunakan model besar Doubao untuk meningkatkan keupayaan pembelajaran dan penaakulan modelnya sendiri dan mencipta "Xiao Ai Classmate", yang bukan sahaja memahami keperluan pengguna dengan lebih tepat, tetapi juga menyediakan kelajuan tindak balas yang lebih pantas dan perkhidmatan kandungan yang lebih komprehensif. Contohnya, apabila pengguna bertanya tentang konsep saintifik yang kompleks, &ldq

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Editor |ScienceAI Question Answering (QA) set data memainkan peranan penting dalam mempromosikan penyelidikan pemprosesan bahasa semula jadi (NLP). Set data QA berkualiti tinggi bukan sahaja boleh digunakan untuk memperhalusi model, tetapi juga menilai dengan berkesan keupayaan model bahasa besar (LLM), terutamanya keupayaan untuk memahami dan menaakul tentang pengetahuan saintifik. Walaupun pada masa ini terdapat banyak set data QA saintifik yang meliputi bidang perubatan, kimia, biologi dan bidang lain, set data ini masih mempunyai beberapa kekurangan. Pertama, borang data adalah agak mudah, kebanyakannya adalah soalan aneka pilihan. Ia mudah dinilai, tetapi mengehadkan julat pemilihan jawapan model dan tidak dapat menguji sepenuhnya keupayaan model untuk menjawab soalan saintifik. Sebaliknya, Soal Jawab terbuka