Peranti teknologi

Peranti teknologi

AI

AI

'Subjek Tiga' yang menarik perhatian global: Messi, Iron Man dan wanita dua dimensi boleh mengendalikannya dengan mudah

'Subjek Tiga' yang menarik perhatian global: Messi, Iron Man dan wanita dua dimensi boleh mengendalikannya dengan mudah

'Subjek Tiga' yang menarik perhatian global: Messi, Iron Man dan wanita dua dimensi boleh mengendalikannya dengan mudah

Sejak kebelakangan ini, anda mungkin pernah mendengar lebih kurang "Subjek 3", yang melibatkan lambaian tangan, kaki separuh selangkangan dan muzik berirama yang sepadan ini telah ditiru oleh seluruh Internet.

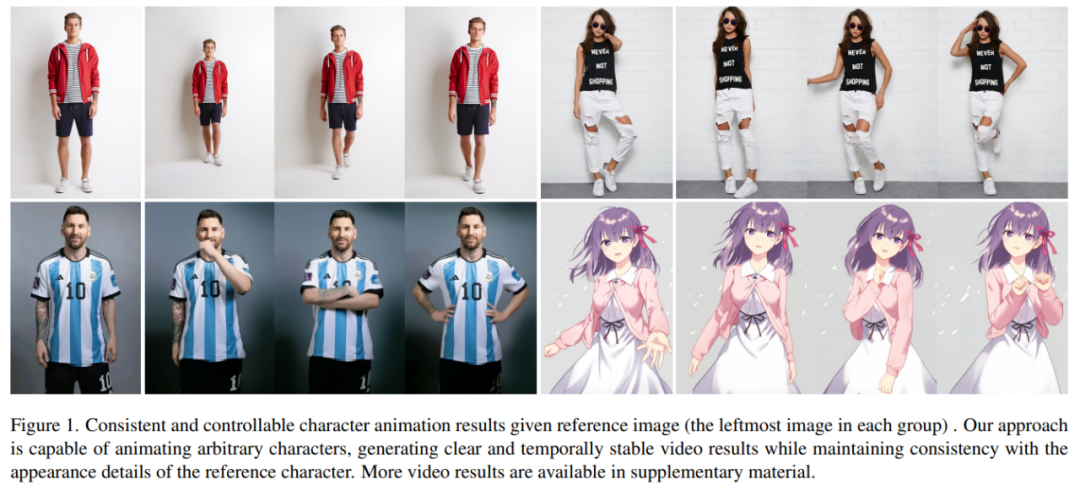

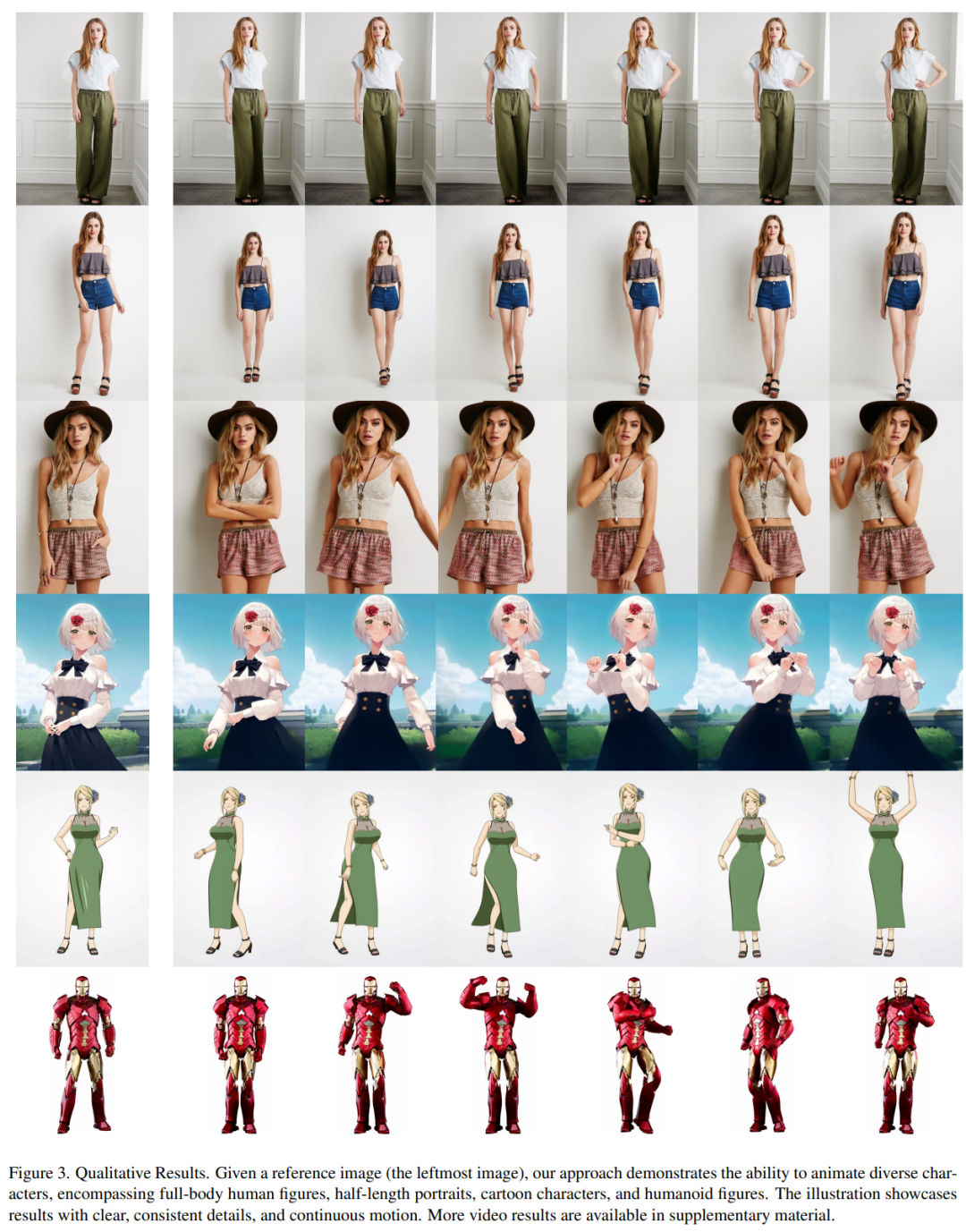

Apakah yang akan berlaku jika tarian serupa dihasilkan oleh AI? Seperti yang ditunjukkan dalam gambar di bawah, kedua-dua orang moden dan orang kertas melakukan pergerakan seragam. Apa yang anda mungkin tidak meneka ialah ini adalah video tarian yang dihasilkan berdasarkan gambar.

Pergerakan watak menjadi lebih sukar, dan video yang dihasilkan juga sangat lancar (paling kanan):

Mudah untuk membuat Messi dan Iron Man bergerak:

Terdapat juga pelbagai gadis anime.

Bagaimana kesan ini dicapai? Mari teruskan membaca

Animasi watak ialah proses menukar imej watak asli kepada video realistik dalam urutan pose yang diingini. Tugas ini mempunyai banyak bidang aplikasi yang berpotensi, seperti peruncitan dalam talian, video hiburan, penciptaan seni dan watak maya, dsb. penyelesaian kaedah pemindahan pose. Walau bagaimanapun, imej atau video yang dijana masih mempunyai beberapa masalah, seperti herotan setempat, butiran kabur, ketidakkonsistenan semantik dan ketidakstabilan temporal, yang menghalang penggunaan kaedah ini

Penyelidik Ali mencadangkan kaedah yang dipanggil kaedah Animate Anybody's menukar imej watak ke dalam video animasi yang mengikut urutan pose yang dikehendaki. Kajian ini menggunakan reka bentuk rangkaian Stable Diffusion dan pemberat pra-latihan, dan mengubah suai denoising UNet untuk menyesuaikan diri dengan input berbilang bingkai

- Alamat projek: https://humanaigc.github.io/animate-anyone/

- Untuk mengekalkan penampilan yang konsisten, kajian itu memperkenalkan ReferenceNet Rangkaian ini menggunakan struktur UNet simetri dan bertujuan untuk menangkap butiran spatial imej rujukan. Dalam setiap lapisan blok UNet yang sepadan, kajian ini menggunakan mekanisme perhatian spatial untuk menyepadukan ciri ReferenceNet ke dalam UNet yang memusnahkan. Seni bina ini membolehkan model mempelajari secara menyeluruh hubungan dengan imej rujukan dalam ruang ciri yang konsisten

Untuk memastikan kebolehkawalan pose, kajian ini mereka bentuk panduan pose ringan untuk mengawal pose dengan berkesan. Isyarat disepadukan ke dalam proses denoising. Untuk mencapai kestabilan temporal, kertas kerja ini memperkenalkan lapisan temporal untuk memodelkan hubungan antara berbilang bingkai, dengan itu mengekalkan butiran resolusi tinggi kualiti visual sambil mensimulasikan proses gerakan temporal yang berterusan dan lancar.

Animate Anybody telah dilatih pada set data dalaman bagi klip video 5K aksara, seperti yang ditunjukkan dalam Rajah 1, menunjukkan hasil animasi untuk pelbagai watak. Berbanding dengan kaedah sebelum ini, kaedah dalam artikel ini mempunyai beberapa kelebihan yang jelas:

- Pertama sekali, ia mengekalkan konsistensi spatial dan temporal penampilan watak dalam video dengan berkesan.

- Kedua, video definisi tinggi yang dihasilkannya tidak akan menghadapi masalah seperti kegelisahan masa atau kelipan.

- Ketiga, ia mampu menghidupkan mana-mana imej watak ke dalam video tanpa dihadkan oleh medan tertentu.

Kertas ini dinilai berdasarkan dua tanda aras sintesis video manusia tertentu (Set Data Video Fesyen UBC dan Set Data TikTok). Keputusan menunjukkan bahawa Animate Anybody mencapai keputusan SOTA. Selain itu, kajian itu membandingkan kaedah Animasikan Sesiapa sahaja dengan kaedah imej-ke-video umum yang dilatih pada data berskala besar, menunjukkan bahawa Animasikan Sesiapa sahaja menunjukkan keupayaan unggul dalam animasi watak.

Animate sesiapa sahaja perbandingan dengan kaedah lain:

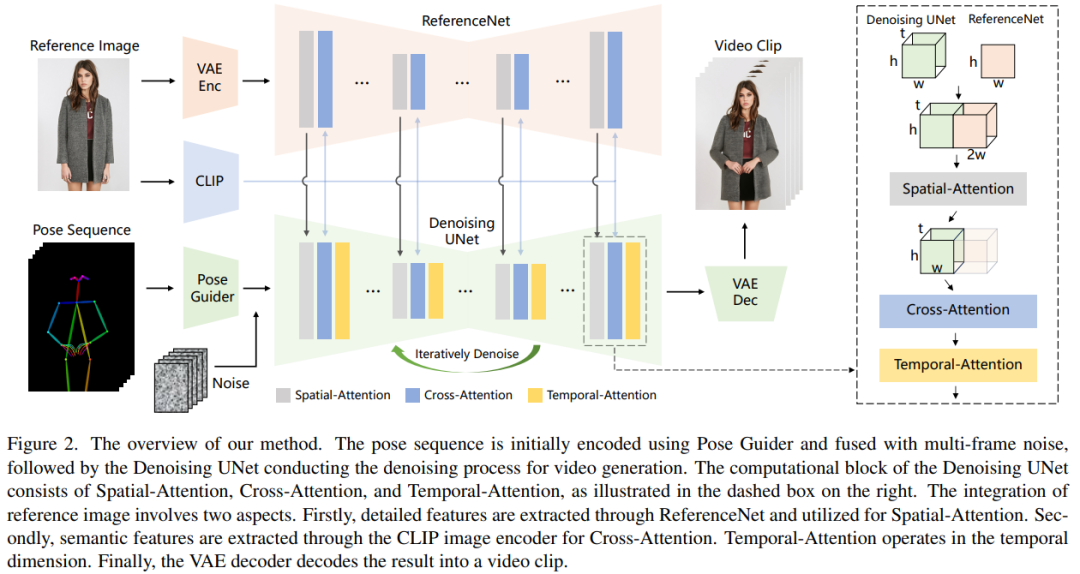

Keterangan ke kaedah

Kaedah pemprosesan artikel ini ditunjukkan dalam Rajah 2. Input asal rangkaian terdiri daripada hingar berbilang bingkai . Untuk mencapai kesan denoising, penyelidik menggunakan konfigurasi berdasarkan reka bentuk SD, menggunakan rangka kerja dan unit blok yang sama, dan mewarisi pemberat latihan daripada SD. Secara khusus, kaedah ini merangkumi tiga bahagian utama, iaitu:

- ReferenceNet, yang mengekodkan ciri-ciri penampilan watak dalam imej rujukan

- Pose Guider (panduan postur), yang mengekod isyarat kawalan tindakan untuk mencapai kebolehkawalan; Pergerakan watak;

- Lapisan temporal (lapisan temporal), pengekodan hubungan temporal untuk memastikan kesinambungan tindakan watak. . Oleh itu, ReferenceNet mewarisi pemberat SD asal yang serupa dengan UNet yang mengecil, dan setiap kemas kini berat dilakukan secara berasingan. Para penyelidik menerangkan cara untuk mengintegrasikan ciri daripada ReferenceNet ke dalam menafikan UNet.

ReferenceNet direka dengan dua kelebihan. Pertama, ReferenceNet boleh memanfaatkan keupayaan pemodelan ciri imej pra-latihan SD mentah untuk menghasilkan ciri yang dimulakan dengan baik. Kedua, memandangkan ReferenceNet dan denoising UNet pada asasnya mempunyai struktur rangkaian yang sama dan berkongsi berat permulaan, denoising UNet boleh secara selektif mempelajari ciri yang dikaitkan dalam ruang ciri yang sama daripada ReferenceNet. . , 128, serupa dengan pengekod bersyarat dalam [56], digunakan untuk menjajarkan imej pose dengan resolusi yang sama seperti bunyi asas. Imej pose yang diproses ditambah pada hingar terpendam dan kemudian dimasukkan ke UNet denosing untuk diproses. Panduan pose dimulakan dengan pemberat Gaussian dan menggunakan lilitan sifar dalam lapisan pemetaan akhir

Lapisan sementara

Reka bentuk lapisan temporal diilhamkan oleh AnimateDiff. Untuk peta ciri x∈R^b×t×h×w×c, penyelidik mula-mula mengubah bentuknya menjadi x∈R^(b×h×w)×t×c, dan kemudian melakukan perhatian temporal, iaitu sepanjang Perhatian diri dalam dimensi t. Ciri-ciri lapisan temporal digabungkan ke dalam ciri asal melalui sambungan sisa Reka bentuk ini konsisten dengan kaedah latihan dua peringkat di bawah. Lapisan sementara digunakan secara eksklusif dalam blok Res-Trans untuk menafikan UNet.

Strategi latihan

Proses latihan terbahagi kepada dua peringkat.

Kandungan yang ditulis semula: Pada peringkat pertama latihan, satu bingkai video digunakan untuk latihan. Dalam model UNet denoising, penyelidik mengecualikan sementara lapisan temporal dan mengambil bunyi bingkai tunggal sebagai input. Pada masa yang sama, rangkaian rujukan dan panduan sikap juga dilatih. Imej rujukan dipilih secara rawak daripada keseluruhan klip video. Mereka menggunakan pemberat yang telah dilatih untuk memulakan model UNet dan ReferenceNet yang mengecil. Panduan pose dimulakan dengan pemberat Gaussian, kecuali untuk lapisan unjuran akhir, yang menggunakan lilitan sifar. Berat pengekod dan penyahkod VAE dan pengekod imej CLIP kekal tidak berubah. Matlamat pengoptimuman peringkat ini adalah untuk menjana imej animasi berkualiti tinggi berdasarkan imej rujukan dan pose sasaran

Pada peringkat kedua, penyelidik memperkenalkan lapisan temporal ke dalam model yang dilatih sebelum ini dan menggunakan AnimateDiff untuk pra-Memulakan yang terlatih berat. Input kepada model terdiri daripada klip video 24 bingkai. Pada peringkat ini, hanya lapisan temporal dilatih, manakala berat bahagian lain rangkaian ditetapkan.

Eksperimen dan keputusan

Hasil kualitatif: Seperti yang ditunjukkan dalam Rajah 3, kaedah ini boleh menghasilkan animasi mana-mana watak, termasuk potret seluruh badan, potret separuh panjang, watak kartun dan watak humanoid. Kaedah ini mampu menghasilkan butiran manusia definisi tinggi dan realistik. Ia mengekalkan ketekalan temporal dengan imej rujukan dan mempamerkan kesinambungan temporal dari bingkai ke bingkai walaupun dalam kehadiran gerakan besar.

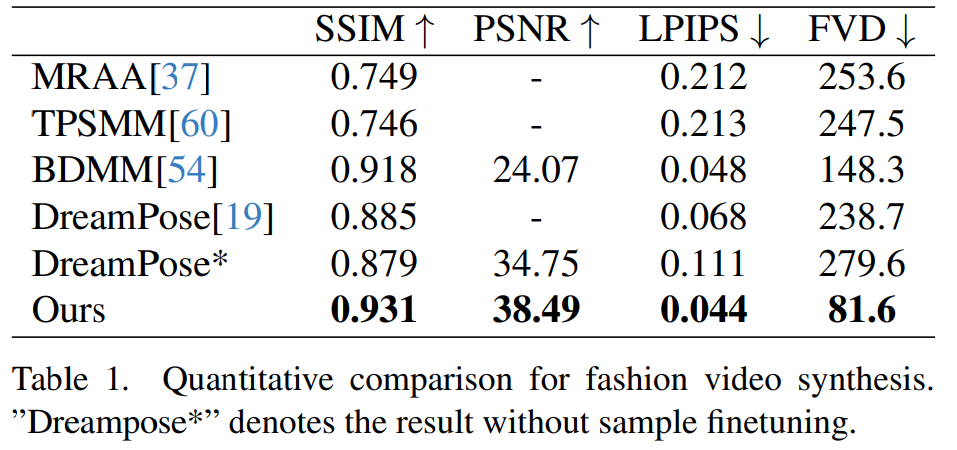

Sintesis video fesyen. Matlamat sintesis video fesyen adalah untuk mengubah foto fesyen menjadi video animasi realistik menggunakan urutan pose terdorong. Percubaan dijalankan pada Set Data Video Fesyen UBC, yang terdiri daripada 500 video latihan dan 100 video ujian, setiap satu mengandungi kira-kira 350 bingkai. Perbandingan kuantitatif ditunjukkan dalam Jadual 1. Ia boleh didapati dalam keputusan bahawa kaedah dalam kertas ini adalah lebih baik daripada kaedah lain, terutamanya dalam penunjuk pengukuran video, menunjukkan petunjuk yang jelas.

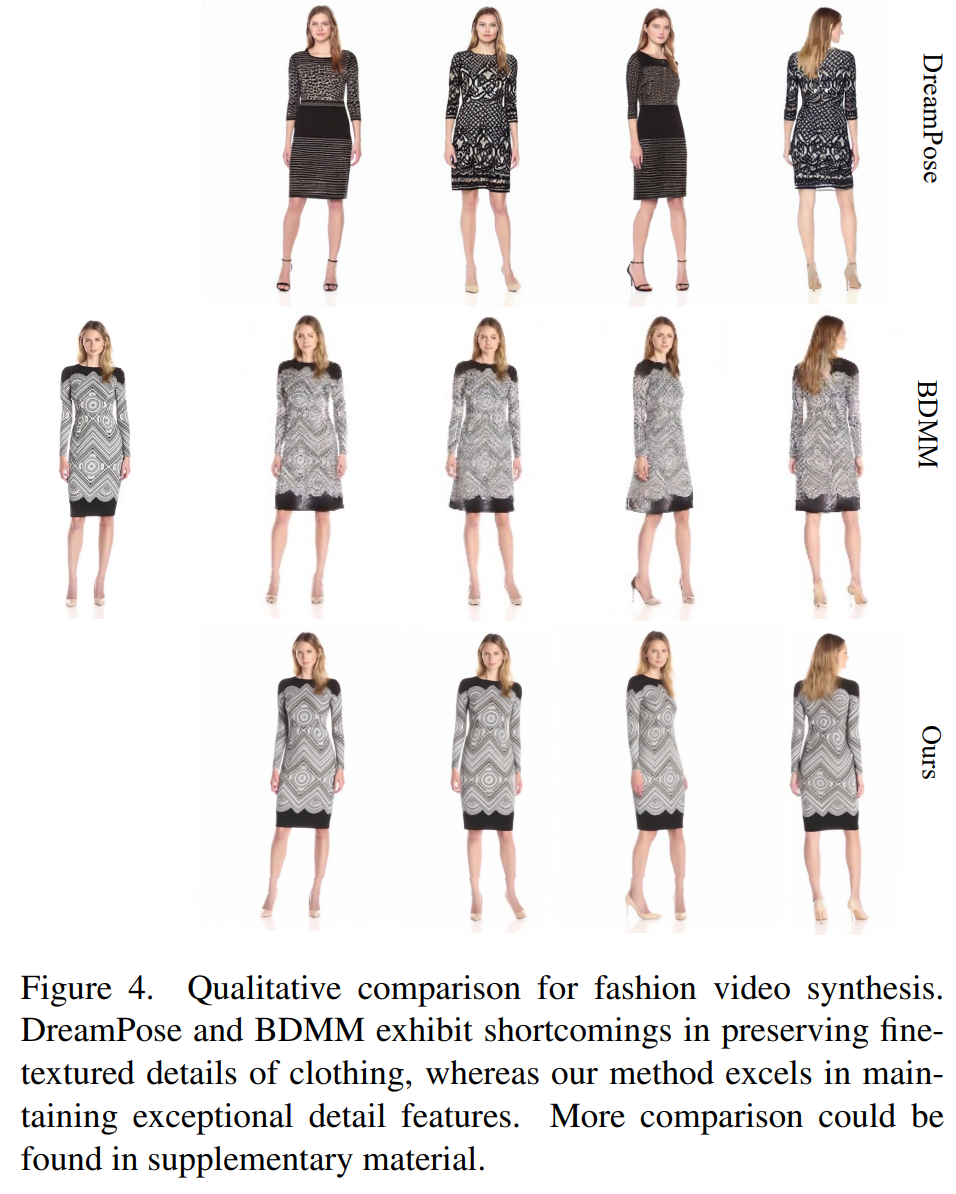

Perbandingan kualitatif ditunjukkan dalam Rajah 4. Untuk perbandingan yang adil, para penyelidik menggunakan kod sumber terbuka DreamPose untuk mendapatkan hasil tanpa penalaan halus sampel. Dalam bidang video fesyen, keperluan untuk butiran pakaian adalah sangat ketat. Walau bagaimanapun, video yang dijana oleh DreamPose dan BDMM gagal mengekalkan konsistensi dalam butiran pakaian dan mempamerkan ralat ketara dalam warna dan elemen struktur halus. Sebaliknya, hasil yang dihasilkan oleh kaedah ini dapat mengekalkan konsistensi butiran pakaian dengan lebih berkesan.

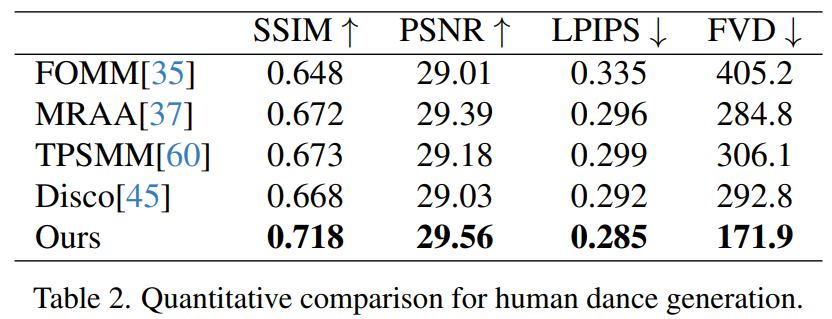

Generasi tarian manusia ialah kajian yang matlamatnya adalah untuk menjana tarian manusia dengan menghidupkan imej adegan tarian yang realistik. Para penyelidik menggunakan set data TikTok, yang merangkumi 340 video latihan dan 100 video ujian. Mereka melakukan perbandingan kuantitatif menggunakan set ujian yang sama, yang termasuk 10 video gaya TikTok, mengikut kaedah pembahagian dataset DisCo. Dari Jadual 2 dapat dilihat bahawa kaedah dalam kertas kerja ini mencapai hasil yang terbaik. Untuk meningkatkan keupayaan generalisasi model, DisCo menggabungkan pra-latihan atribut manusia dan menggunakan sebilangan besar pasangan imej untuk pra-melatih model. Sebaliknya, penyelidik lain hanya melatih set data TikTok, tetapi hasilnya masih lebih baik daripada DisCo

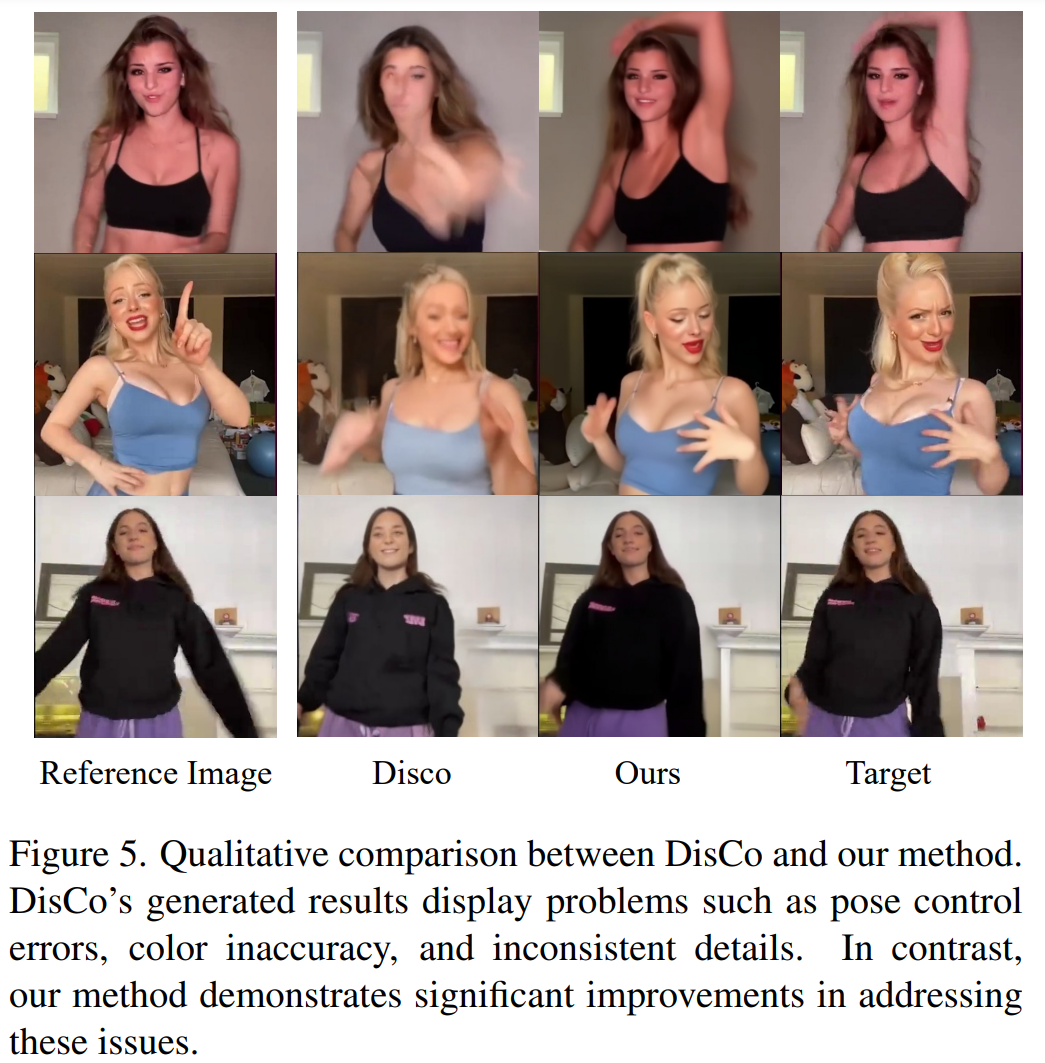

Perbandingan kualitatif dengan DisCo ditunjukkan dalam Rajah 5. Memandangkan kerumitan tempat kejadian, pendekatan DisCo memerlukan penggunaan tambahan SAM untuk menjana topeng latar depan manusia. Sebaliknya, kaedah kami menunjukkan bahawa walaupun tanpa pembelajaran topeng manusia yang eksplisit, model ini boleh memahami hubungan latar depan-latar belakang daripada gerakan subjek tanpa pembahagian manusia sebelumnya. Tambahan pula, dalam urutan tarian yang kompleks, model ini cemerlang dalam mengekalkan kesinambungan visual sepanjang aksi dan menunjukkan kemantapan yang lebih besar dalam mengendalikan penampilan watak yang berbeza.

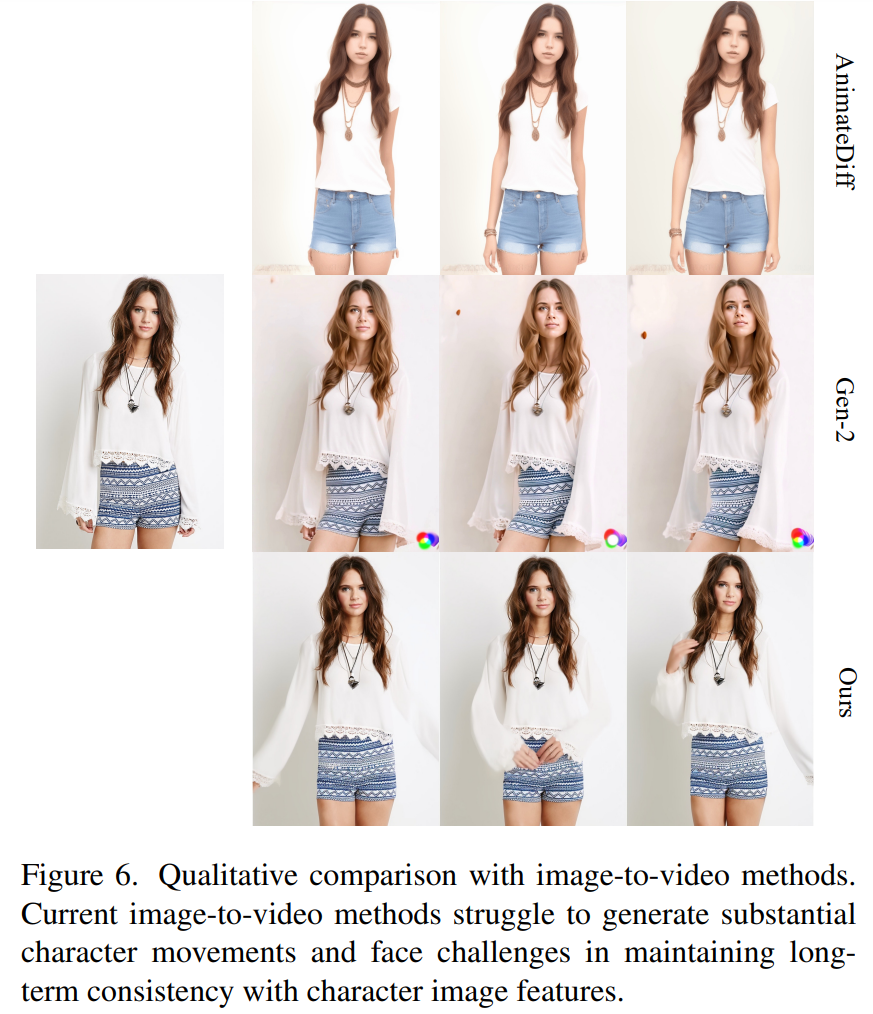

Imej - Pendekatan universal untuk video. Pada masa ini, banyak kajian telah mencadangkan model penyebaran video dengan keupayaan penjanaan yang kukuh berdasarkan data latihan berskala besar. Para penyelidik memilih dua kaedah imej-video yang paling terkenal dan paling berkesan untuk perbandingan: AnimateDiff dan Gen2. Oleh kerana kedua-dua kaedah ini tidak melakukan kawalan pose, para penyelidik hanya membandingkan keupayaan mereka untuk mengekalkan kesetiaan penampilan imej rujukan. Seperti yang ditunjukkan dalam Rajah 6, pendekatan imej-ke-video semasa menghadapi cabaran dalam menghasilkan sejumlah besar tindakan watak dan perjuangan untuk mengekalkan konsistensi penampilan jangka panjang merentas video, sekali gus menghalang sokongan berkesan untuk animasi watak yang konsisten.

Sila semak kertas asal untuk maklumat lanjut

Atas ialah kandungan terperinci 'Subjek Tiga' yang menarik perhatian global: Messi, Iron Man dan wanita dua dimensi boleh mengendalikannya dengan mudah. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1386

1386

52

52

Cara Memeriksa Konfigurasi HDFS CentOS

Apr 14, 2025 pm 07:21 PM

Cara Memeriksa Konfigurasi HDFS CentOS

Apr 14, 2025 pm 07:21 PM

Panduan Lengkap untuk Memeriksa Konfigurasi HDFS Dalam Sistem CentOS Artikel ini akan membimbing anda bagaimana untuk memeriksa konfigurasi dan menjalankan status HDFS secara berkesan pada sistem CentOS. Langkah -langkah berikut akan membantu anda memahami sepenuhnya persediaan dan operasi HDFS. Sahkan Pembolehubah Alam Sekitar Hadoop: Pertama, pastikan pembolehubah persekitaran Hadoop ditetapkan dengan betul. Di terminal, laksanakan arahan berikut untuk mengesahkan bahawa Hadoop dipasang dan dikonfigurasi dengan betul: Hadoopversion Semak fail konfigurasi HDFS: Fail konfigurasi teras HDFS terletak di/etc/hadoop/conf/direktori, di mana core-site.xml dan hdfs-site.xml adalah kritikal. gunakan

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Perintah shutdown CentOS adalah penutupan, dan sintaks adalah tutup [pilihan] [maklumat]. Pilihan termasuk: -h menghentikan sistem dengan segera; -P mematikan kuasa selepas penutupan; -r mulakan semula; -T Waktu Menunggu. Masa boleh ditentukan sebagai segera (sekarang), minit (minit), atau masa tertentu (HH: mm). Maklumat tambahan boleh dipaparkan dalam mesej sistem.

Apakah kaedah sandaran untuk gitlab di centos

Apr 14, 2025 pm 05:33 PM

Apakah kaedah sandaran untuk gitlab di centos

Apr 14, 2025 pm 05:33 PM

Dasar sandaran dan pemulihan Gitlab di bawah sistem CentOS untuk memastikan keselamatan data dan pemulihan, Gitlab pada CentOS menyediakan pelbagai kaedah sandaran. Artikel ini akan memperkenalkan beberapa kaedah sandaran biasa, parameter konfigurasi dan proses pemulihan secara terperinci untuk membantu anda menubuhkan strategi sandaran dan pemulihan GitLab lengkap. 1. Backup Manual Gunakan Gitlab-Rakegitlab: Backup: Buat Perintah untuk Melaksanakan Backup Manual. Perintah ini menyokong maklumat utama seperti repositori Gitlab, pangkalan data, pengguna, kumpulan pengguna, kunci, dan kebenaran. Fail sandaran lalai disimpan dalam direktori/var/opt/gitlab/sandaran. Anda boleh mengubah suai /etc /gitlab

CentOS memasang MySQL

Apr 14, 2025 pm 08:09 PM

CentOS memasang MySQL

Apr 14, 2025 pm 08:09 PM

Memasang MySQL pada CentOS melibatkan langkah -langkah berikut: Menambah sumber MySQL YUM yang sesuai. Jalankan YUM Pasang Perintah MySQL-Server untuk memasang pelayan MySQL. Gunakan perintah mysql_secure_installation untuk membuat tetapan keselamatan, seperti menetapkan kata laluan pengguna root. Sesuaikan fail konfigurasi MySQL seperti yang diperlukan. Tune parameter MySQL dan mengoptimumkan pangkalan data untuk prestasi.

Cara Melihat Log Gitlab Di Bawah Centos

Apr 14, 2025 pm 06:18 PM

Cara Melihat Log Gitlab Di Bawah Centos

Apr 14, 2025 pm 06:18 PM

Panduan Lengkap untuk Melihat Log Gitlab Di bawah Sistem CentOS Artikel ini akan membimbing anda bagaimana untuk melihat pelbagai log Gitlab dalam sistem CentOS, termasuk log utama, log pengecualian, dan log lain yang berkaitan. Sila ambil perhatian bahawa laluan fail log mungkin berbeza -beza bergantung pada versi GitLab dan kaedah pemasangan. Jika laluan berikut tidak wujud, sila semak fail Direktori Pemasangan dan Konfigurasi GitLab. 1. Lihat log Gitlab utama Gunakan arahan berikut untuk melihat fail log utama aplikasi GitLabRails: Perintah: Sudocat/var/Log/Gitlab/Gitlab-Rails/Production.log Perintah ini akan memaparkan produk

Cara Mengendalikan Latihan Pittorch Diagihkan di Centos

Apr 14, 2025 pm 06:36 PM

Cara Mengendalikan Latihan Pittorch Diagihkan di Centos

Apr 14, 2025 pm 06:36 PM

Latihan yang diedarkan Pytorch pada sistem CentOS memerlukan langkah -langkah berikut: Pemasangan Pytorch: Premisnya ialah Python dan PIP dipasang dalam sistem CentOS. Bergantung pada versi CUDA anda, dapatkan arahan pemasangan yang sesuai dari laman web rasmi Pytorch. Untuk latihan CPU sahaja, anda boleh menggunakan arahan berikut: PipinstallToRchTorchVisionTorchaudio Jika anda memerlukan sokongan GPU, pastikan versi CUDA dan CUDNN yang sama dipasang dan gunakan versi pytorch yang sepadan untuk pemasangan. Konfigurasi Alam Sekitar Teragih: Latihan yang diedarkan biasanya memerlukan pelbagai mesin atau mesin berbilang mesin tunggal. Tempat

Bagaimana sokongan GPU untuk Pytorch di CentOS

Apr 14, 2025 pm 06:48 PM

Bagaimana sokongan GPU untuk Pytorch di CentOS

Apr 14, 2025 pm 06:48 PM

Membolehkan pecutan GPU pytorch pada sistem CentOS memerlukan pemasangan cuda, cudnn dan GPU versi pytorch. Langkah-langkah berikut akan membimbing anda melalui proses: Pemasangan CUDA dan CUDNN Tentukan keserasian versi CUDA: Gunakan perintah NVIDIA-SMI untuk melihat versi CUDA yang disokong oleh kad grafik NVIDIA anda. Sebagai contoh, kad grafik MX450 anda boleh menyokong CUDA11.1 atau lebih tinggi. Muat turun dan pasang Cudatoolkit: Lawati laman web rasmi Nvidiacudatoolkit dan muat turun dan pasang versi yang sepadan mengikut versi CUDA tertinggi yang disokong oleh kad grafik anda. Pasang Perpustakaan Cudnn:

Penjelasan terperinci mengenai Prinsip Docker

Apr 14, 2025 pm 11:57 PM

Penjelasan terperinci mengenai Prinsip Docker

Apr 14, 2025 pm 11:57 PM

Docker menggunakan ciri -ciri kernel Linux untuk menyediakan persekitaran berjalan yang cekap dan terpencil. Prinsip kerjanya adalah seperti berikut: 1. Cermin digunakan sebagai templat baca sahaja, yang mengandungi semua yang anda perlukan untuk menjalankan aplikasi; 2. Sistem Fail Kesatuan (Unionfs) menyusun pelbagai sistem fail, hanya menyimpan perbezaan, menjimatkan ruang dan mempercepatkan; 3. Daemon menguruskan cermin dan bekas, dan pelanggan menggunakannya untuk interaksi; 4. Ruang nama dan cgroups melaksanakan pengasingan kontena dan batasan sumber; 5. Pelbagai mod rangkaian menyokong interkoneksi kontena. Hanya dengan memahami konsep -konsep teras ini, anda boleh menggunakan Docker dengan lebih baik.