Peranti teknologi

Peranti teknologi

AI

AI

UC Berkeley berjaya membangunkan model penaakulan visual umum yang besar, dan tiga sarjana kanan bergabung tenaga untuk mengambil bahagian dalam penyelidikan

UC Berkeley berjaya membangunkan model penaakulan visual umum yang besar, dan tiga sarjana kanan bergabung tenaga untuk mengambil bahagian dalam penyelidikan

UC Berkeley berjaya membangunkan model penaakulan visual umum yang besar, dan tiga sarjana kanan bergabung tenaga untuk mengambil bahagian dalam penyelidikan

Sejauh mana anda boleh pergi dengan model visual (piksel) sahaja? Kertas kerja baharu daripada UC Berkeley dan Universiti Johns Hopkins meneroka masalah ini dan menunjukkan potensi model penglihatan besar (LVM) pada pelbagai tugas CV.

Sejak kebelakangan ini, model bahasa besar (LLM) seperti GPT dan LLaMA telah menjadi popular di seluruh dunia.

Membina Model Penglihatan Besar (LVM) adalah masalah yang amat membimbangkan. Apa yang kita perlukan untuk mencapainya? Idea yang disediakan oleh model bahasa visual seperti

LLaVA menarik dan patut diterokai, tetapi mengikut undang-undang alam haiwan, kita sudah tahu bahawa keupayaan visual dan keupayaan bahasa tidak berkaitan. Sebagai contoh, banyak eksperimen telah menunjukkan bahawa dunia visual primata bukan manusia sangat serupa dengan manusia, walaupun sistem bahasa mereka "sama" dengan manusia.

Sebuah kertas kerja baru-baru ini membincangkan jawapan kepada soalan lain, iaitu sejauh mana kita boleh pergi dengan piksel sahaja. Kertas kerja itu ditulis oleh penyelidik dari Universiti California, Berkeley dan Universiti Johns Hopkins

Pautan kertas: https://arxiv.org/abs/2312.00785

Laman utama projek: https://yutongbaii .com/lvm.html

Ciri-ciri utama LLM yang penyelidik cuba contohi dalam LVM: 1) Mengikut skala pertumbuhan data Untuk mengembangkan perniagaan, kita perlu mencari peluang pasaran baharu. Kami merancang untuk mengembangkan lagi barisan produk kami untuk memenuhi permintaan yang semakin meningkat. Pada masa yang sama, kami akan mengukuhkan strategi pemasaran dan meningkatkan kesedaran jenama. Dengan mengambil bahagian secara aktif dalam pameran industri dan aktiviti promosi, kami akan berusaha untuk membangunkan lebih banyak kumpulan pelanggan. Kami percaya bahawa melalui usaha ini kami boleh mencapai kejayaan yang lebih besar dan mencapai pertumbuhan yang berterusan, 2) Menentukan tugas secara fleksibel melalui gesaan (pembelajaran kontekstual).

Mereka menetapkan tiga komponen utama, iaitu data, seni bina dan fungsi kehilangan.

Dari segi data, penyelidik ingin memanfaatkan kepelbagaian ketara dalam data visual. Bermula dengan hanya imej mentah dan video yang tidak bernotasi, dan kemudian memanfaatkan pelbagai sumber data visual beranotasi yang dihasilkan sejak beberapa dekad yang lalu (termasuk pembahagian semantik, pembinaan semula kedalaman, titik utama, objek 3D berbilang paparan, dsb.). Mereka mentakrifkan format biasa - "ayat visual" - untuk mewakili anotasi berbeza ini tanpa memerlukan sebarang pengetahuan meta melebihi piksel. Jumlah saiz set latihan ialah 1.64 bilion imej/bingkai.

Dari segi seni bina, penyelidik menggunakan seni bina transformer yang besar (3 bilion parameter) untuk melatih data visual yang diwakili sebagai jujukan token, dan menggunakan tokenizer yang dipelajari untuk memetakan setiap imej kepada 256 vektor kuantiti rentetan token.

Dari segi fungsi kehilangan, penyelidik mendapat inspirasi daripada komuniti bahasa semula jadi, iaitu, pemodelan token topeng telah "memberi laluan" untuk menyusun kaedah ramalan autoregresif. Setelah imej, video dan imej beranotasi semuanya boleh diwakili sebagai jujukan, model terlatih boleh meminimumkan kehilangan entropi silang apabila meramalkan token seterusnya.

Melalui reka bentuk yang sangat mudah ini, penyelidik menunjukkan tingkah laku yang perlu diberi perhatian berikut:

Apabila saiz model dan saiz data meningkat, model secara automatik akan menunjukkan yang sesuai Untuk mengembangkan perniagaan, kita perlu mencari peluang pasaran baharu. Kami merancang untuk mengembangkan lagi barisan produk kami untuk memenuhi permintaan yang semakin meningkat. Pada masa yang sama, kami akan mengukuhkan strategi pemasaran dan meningkatkan kesedaran jenama. Dengan mengambil bahagian secara aktif dalam pameran industri dan aktiviti promosi, kami akan berusaha untuk membangunkan lebih banyak kumpulan pelanggan. Kami percaya bahawa dengan usaha ini kami boleh mencapai kejayaan yang lebih besar dan mencapai tingkah laku pertumbuhan yang berterusan

Banyak tugas visual yang berbeza kini boleh diselesaikan dengan mereka bentuk gesaan yang sesuai pada masa ujian. Walaupun bukan hasil prestasi tinggi seperti model terlatih khas, hakikat bahawa model penglihatan tunggal boleh menyelesaikan begitu banyak tugas adalah sangat menggalakkan

Sejumlah besar data tanpa pengawasan mengenai pelbagai tugas penglihatan Prestasi telah membantu dengan ketara;

Apabila memproses data luar pengedaran dan melaksanakan tugas baharu, terdapat tanda-tanda keupayaan penaakulan visual umum, tetapi kajian lanjut masih diperlukan

Pengarang bersama kertas kerja, John Hope Yutong Bai, seorang pelajar kedoktoran CS tahun empat di Kings College dan pelajar PhD yang melawat di Berkeley, menulis tweet untuk mempromosikan kerja mereka.

Sumber imej asal datang daripada akaun Twitter: https://twitter.com/YutongBAI1002/status/1731512110247473608

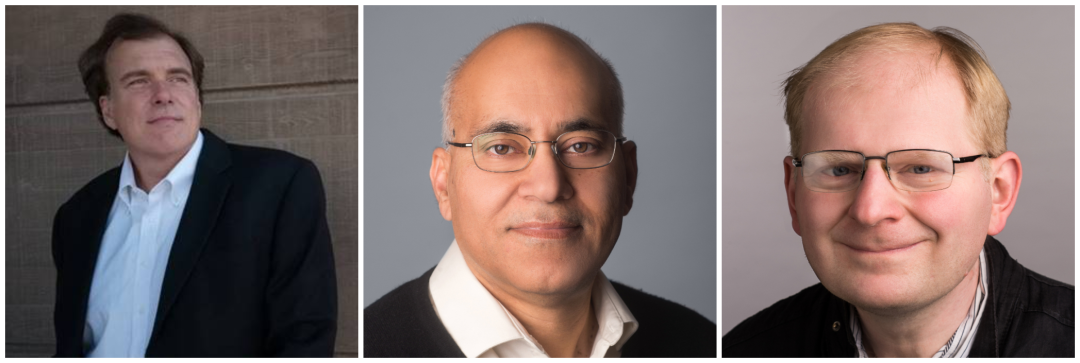

Antara tiga orang sarjana yang terakhir adalah penulis bidang. daripada CV di UC Berkeley . Profesor Trevor Darrell ialah pengarah bersama pengasas BAIR, Makmal Penyelidikan Kecerdasan Buatan Berkeley, Profesor Jitendra Malik memenangi Anugerah Perintis Komputer IEEE 2019, dan Profesor Alexei A. Efros amat terkenal dengan penyelidikan jiran terdekat.

Dari kiri ke kanan ialah Trevor Darrell, Jitendra Malik, Alexei A. Efros.

Pengenalan kaedah

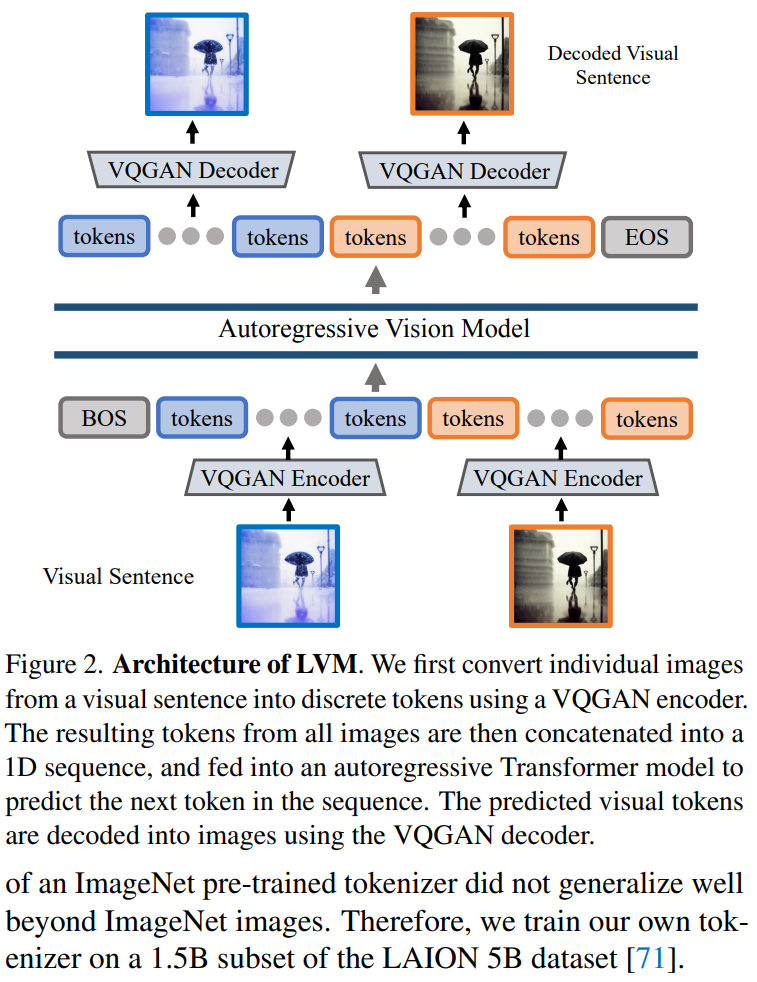

Artikel menggunakan pendekatan dua peringkat: 1) melatih tokenizer visual yang besar (beroperasi pada satu imej), yang mampu menukar setiap imej kepada satu siri token visual; ayat visual Model pengubah autoregresif, setiap ayat diwakili sebagai satu siri token. Kaedah ini ditunjukkan dalam Rajah 2

Tokenisasi Imej

Untuk menggunakan model Transformer pada imej, operasi biasa termasuk: membahagikan imej kepada tampalan dan menganggapnya sebagai jujukan A tokenizer, seperti VQVAE atau VQGAN, mengagregatkan ciri imej ke dalam grid token diskret. Artikel ini menggunakan kaedah yang terakhir, menggunakan model VQGAN untuk menjana token semantik.

Rangka kerja LVM termasuk mekanisme pengekodan dan penyahkodan dan juga mempunyai lapisan pengkuantitian, di mana pengekod dan penyahkod dibina dengan lapisan konvolusi. Pengekod dilengkapi dengan berbilang modul pensampelan rendah untuk mengecilkan dimensi ruang input, manakala penyahkod dilengkapi dengan satu siri modul pensampelan naik yang setara untuk memulihkan imej kepada saiz asalnya. Untuk imej tertentu, tokenizer VQGAN menghasilkan 256 token diskret.

Seni bina VQGAN dalam kertas ini mengguna pakai butiran pelaksanaan yang dicadangkan oleh Chang et al dan mengikut persediaan mereka. Secara khusus, faktor pensampelan rendah ialah f=16 dan saiz buku kod ialah 8192. Ini bermakna untuk imej bersaiz 256×256, tokenizer VQGAN akan menjana 16×16=256 token, dan setiap token boleh mengambil 8192 nilai yang berbeza. Di samping itu, artikel ini melatih tokenizer pada subset 1.5B set data LAION 5B

Pemodelan urutan ayat visual

Selepas menggunakan VQGAN untuk menukar imej kepada token diskret, artikel ini menggunakan token diskret dalam berbilang imej Gabungkan menjadi satu -urutan dimensi dan menganggap ayat visual sebagai urutan bersatu. Yang penting, tiada ayat visual diproses khas - iaitu, tiada token khas digunakan untuk menunjukkan tugas atau format tertentu.

Fungsi ayat visual adalah untuk memformat data visual yang berbeza ke dalam struktur jujukan imej bersatu

Butiran pelaksanaan. Selepas menandakan setiap imej dalam ayat visual menjadi 256 token, kertas ini menggabungkannya untuk membentuk urutan token 1D. Pada jujukan token visual, model Transformer dalam artikel ini sebenarnya sama dengan model bahasa autoregresif, jadi mereka menggunakan seni bina Transformer LLaMA.

Kandungan ini menggunakan panjang konteks sebanyak 4096 token, serupa dengan model bahasa. Tambahkan token [BOS] (permulaan ayat) pada permulaan setiap ayat visual dan token [EOS] (akhir ayat) pada akhir, dan gunakan penyambungan urutan semasa latihan untuk meningkatkan kecekapan

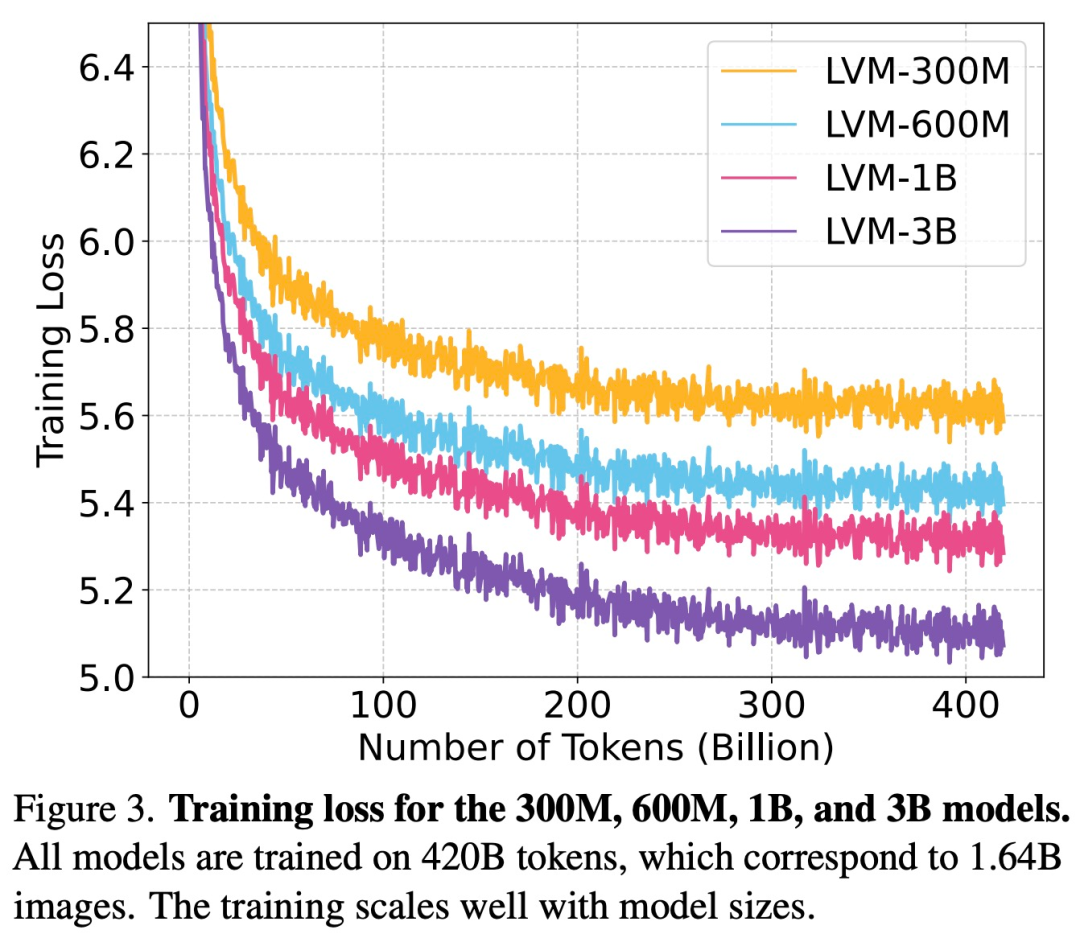

Artikel ini berprestasi baik pada keseluruhan dataset UVDv1 (4200 100 juta token), sejumlah 4 model dengan nombor parameter berbeza telah dilatih: 300 juta, 600 juta, 1 bilion dan 3 bilion.

Hasil eksperimen perlu ditulis semula

Kajian menjalankan eksperimen untuk menilai model Untuk mengembangkan perniagaan, kita perlu mencari peluang pasaran baharu. Kami merancang untuk mengembangkan lagi barisan produk kami untuk memenuhi permintaan yang semakin meningkat. Pada masa yang sama, kami akan mengukuhkan strategi pemasaran dan meningkatkan kesedaran jenama. Dengan mengambil bahagian secara aktif dalam pameran industri dan aktiviti promosi, kami akan berusaha untuk membangunkan lebih banyak kumpulan pelanggan. Kami percaya bahawa melalui usaha ini kami boleh mencapai kejayaan yang lebih besar dan mencapai pertumbuhan berterusan dalam keupayaan dan keupayaan kami untuk memahami dan menjawab pelbagai tugas.

Untuk mengembangkan perniagaan kita, kita perlu mencari peluang pasaran baharu. Kami merancang untuk mengembangkan lagi barisan produk kami untuk memenuhi permintaan yang semakin meningkat. Pada masa yang sama, kami akan mengukuhkan strategi pemasaran dan meningkatkan kesedaran jenama. Dengan mengambil bahagian secara aktif dalam pameran industri dan aktiviti promosi, kami akan berusaha untuk membangunkan lebih banyak kumpulan pelanggan. Kami percaya bahawa melalui usaha ini, kami boleh mencapai pencapaian yang lebih besar dan mencapai pertumbuhan yang mampan

Seperti yang ditunjukkan dalam Rajah 3, kajian pertama kali meneliti kehilangan latihan LVM dengan saiz yang berbeza

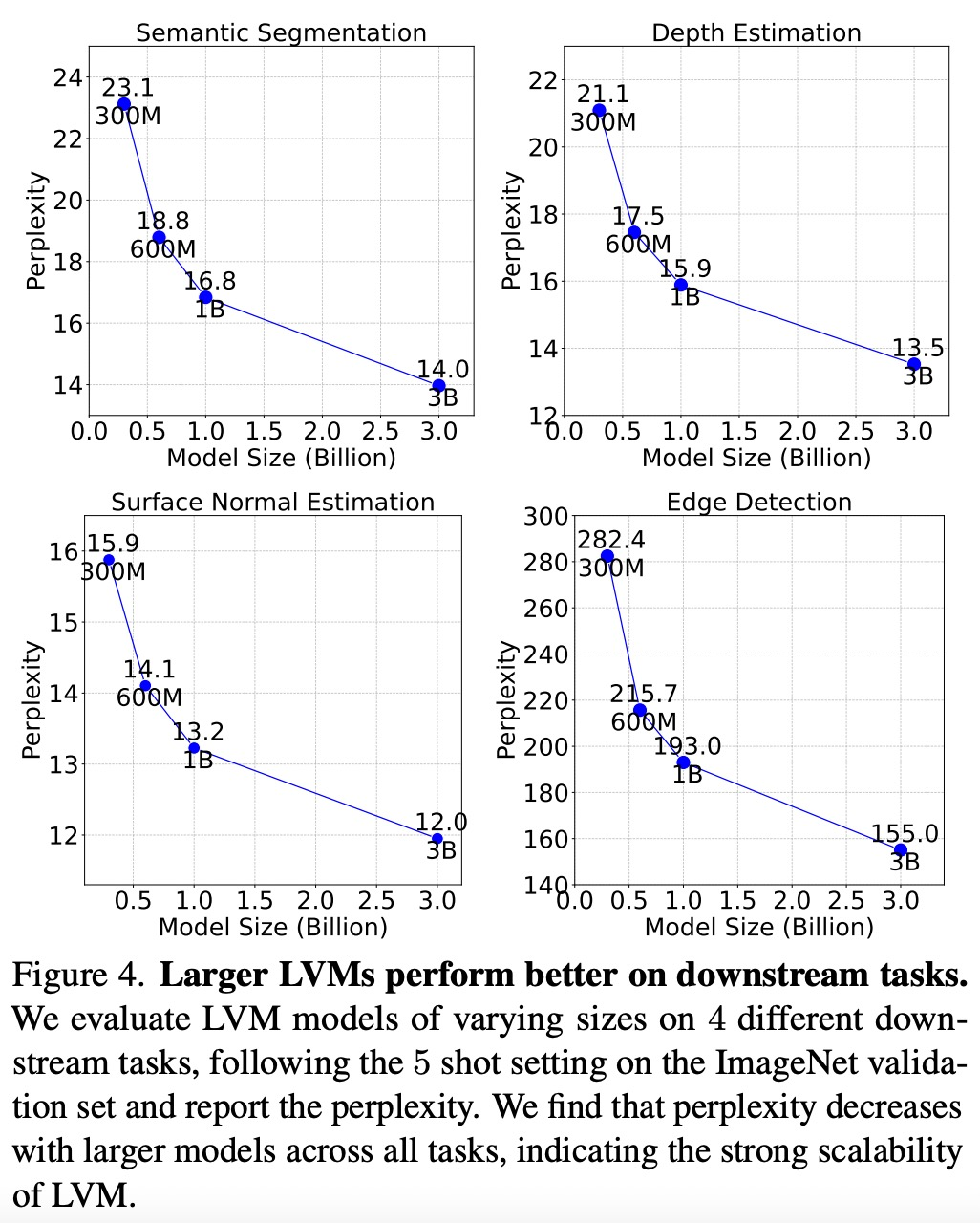

Seperti yang ditunjukkan dalam Rajah 4 di bawah menunjukkan bahawa model yang lebih besar mempunyai kerumitan yang lebih rendah merentas semua tugas, menunjukkan bahawa prestasi keseluruhan model boleh dipindahkan ke pelbagai tugas hiliran.

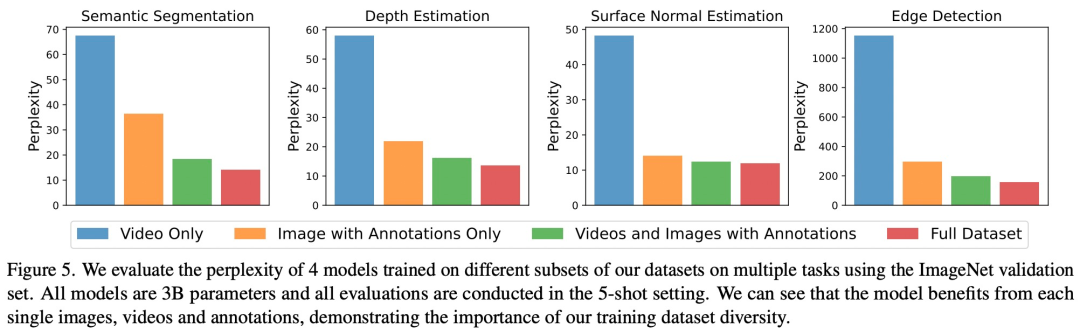

Seperti yang ditunjukkan dalam Rajah 5, setiap komponen data mempunyai kesan penting ke atas tugas hiliran. LVM bukan sahaja mendapat manfaat daripada data yang lebih besar, tetapi juga bertambah baik dengan kepelbagaian set data

Menulis semula kandungan tanpa mengubah makna asal memerlukan penulisan semula bahasa kepada bahasa Cina. Ayat asal sepatutnya muncul

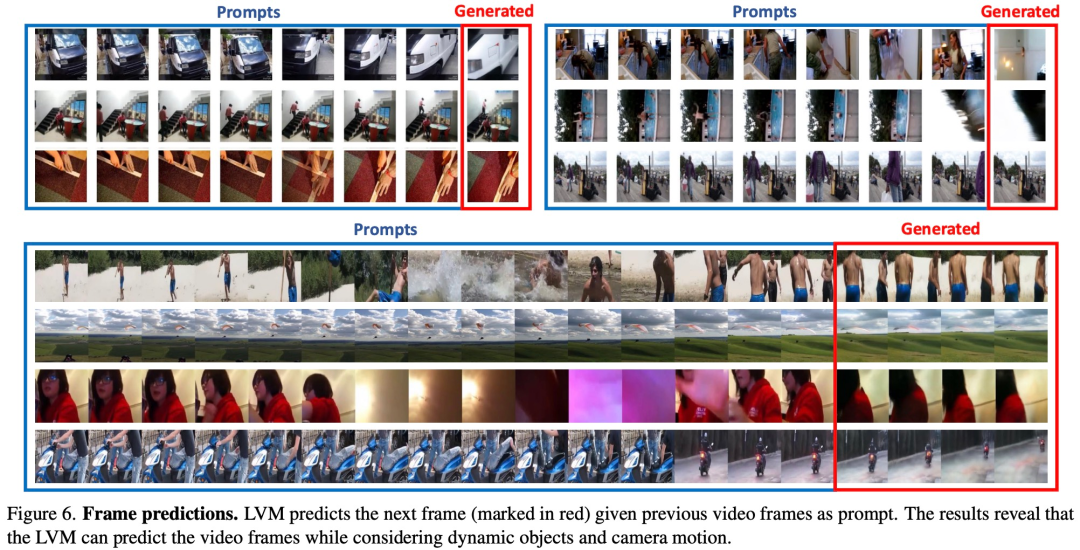

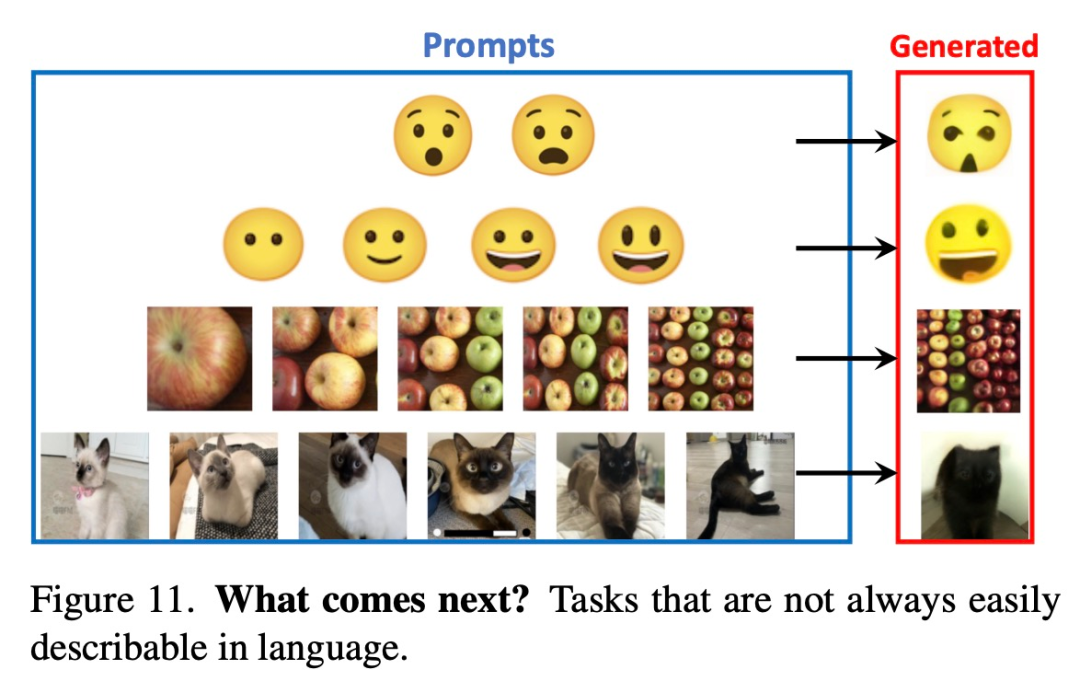

Untuk menguji keupayaan LVM memahami pelbagai gesaan, kajian ini mula-mula menjalankan eksperimen penilaian pada LVM pada tugas penaakulan urutan. Antaranya, prompt adalah sangat mudah: sediakan model dengan urutan 7 imej dan minta ia meramalkan imej seterusnya Keputusan eksperimen perlu ditulis semula seperti yang ditunjukkan dalam Rajah 6 di bawah:

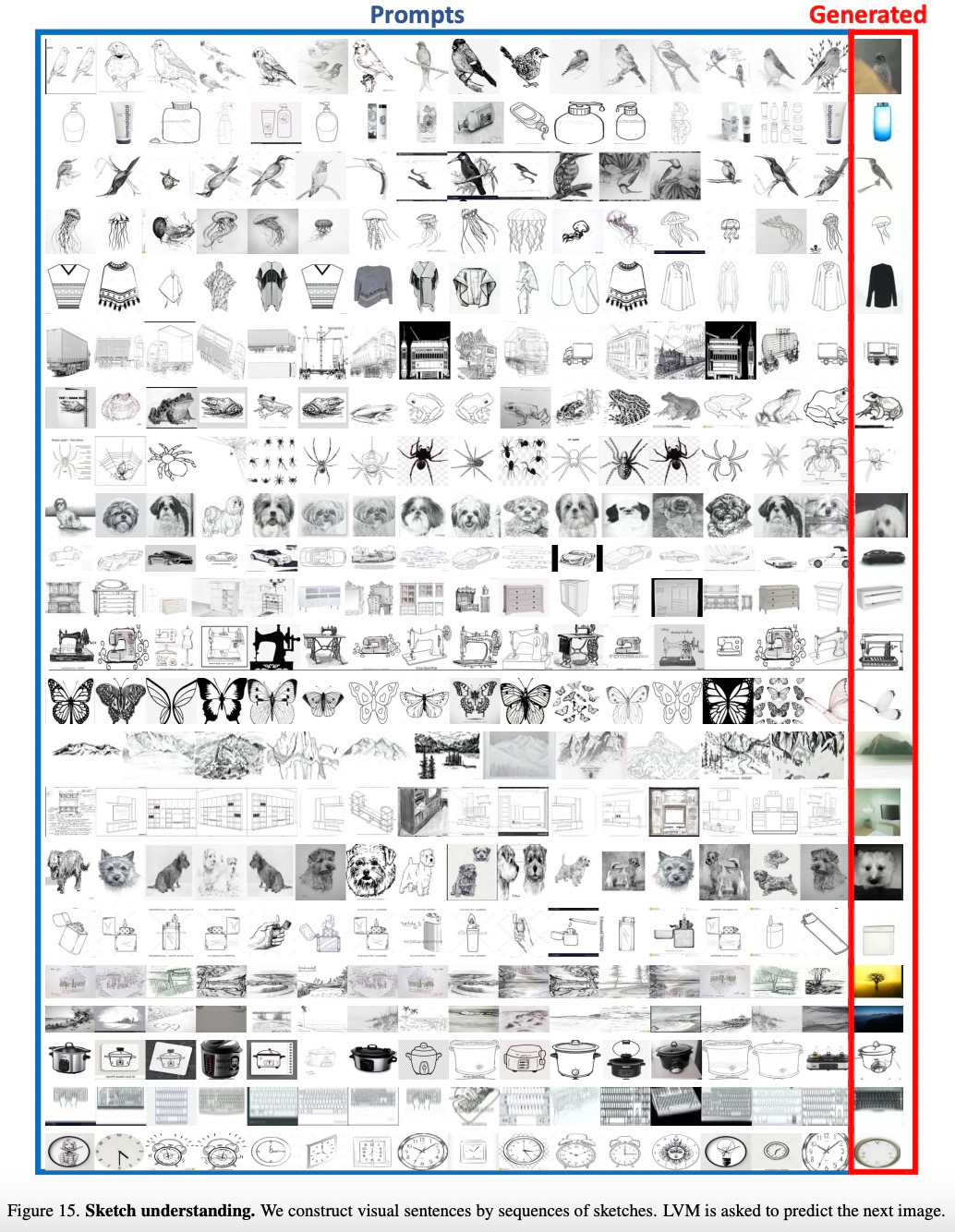

Kajian ini juga akan memberi. senarai item dalam kategori Anggap ia sebagai urutan dan biarkan LVM meramalkan imej dari kategori yang sama Keputusan percubaan perlu ditulis semula seperti yang ditunjukkan dalam Rajah 15 di bawah:

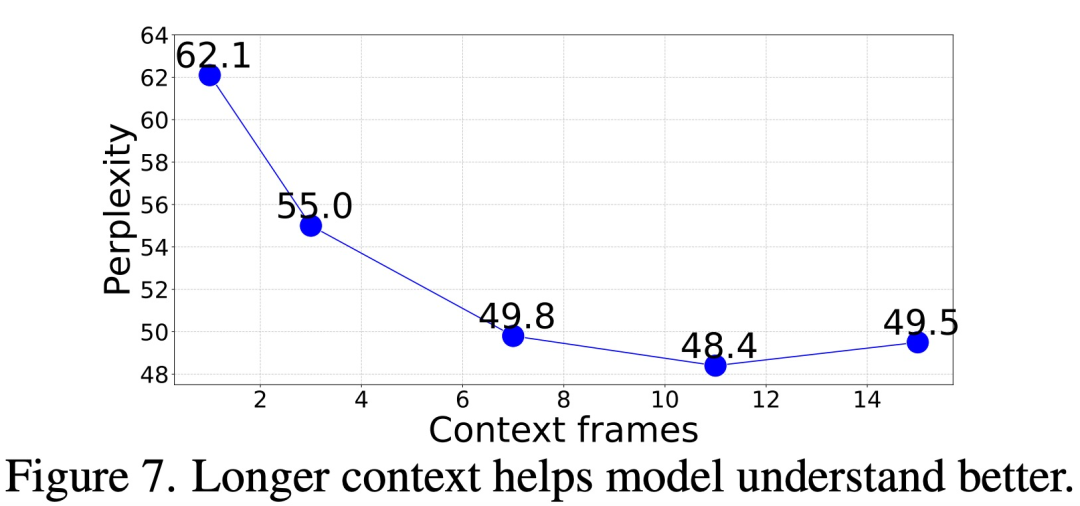

Jadi, berapa banyak konteks yang diperlukan untuk tepat. ramalkan bingkai seterusnya?

Dalam kajian ini, kami menilai kebingungan penjanaan bingkai model kami dengan memberikan gesaan kontekstual dengan panjang yang berbeza (1 hingga 15 bingkai). Keputusan menunjukkan bahawa kebingungan beransur-ansur bertambah baik apabila bilangan bingkai meningkat. Data khusus ditunjukkan dalam Rajah 7 di bawah. Kebingungan bertambah baik dengan ketara daripada bingkai 1 kepada bingkai 11, dan kemudian menjadi stabil (62.1 → 48.4)

Analogy Prompt

Kajian tahap lanjutan LVM ini juga menguji tahap lanjutan kuasa, dengan menilai struktur gesaan yang lebih kompleks seperti gesaan analogi

Rajah 8 di bawah menunjukkan hasil kualitatif Prompt Analogi untuk beberapa tugas:

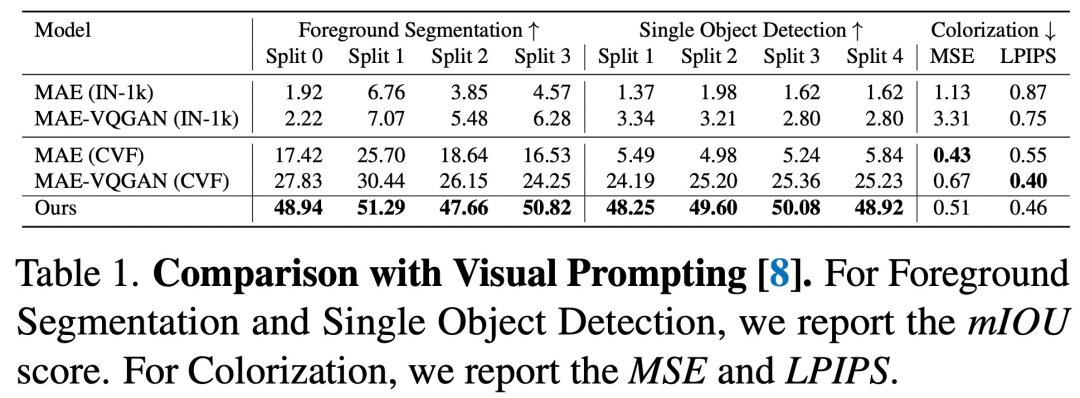

Berdasarkan perbandingan dengan gesaan visual, dapat dilihat bahawa urutan LVM berprestasi lebih baik dalam hampir Semua tugasan lebih baik daripada kaedah sebelumnya

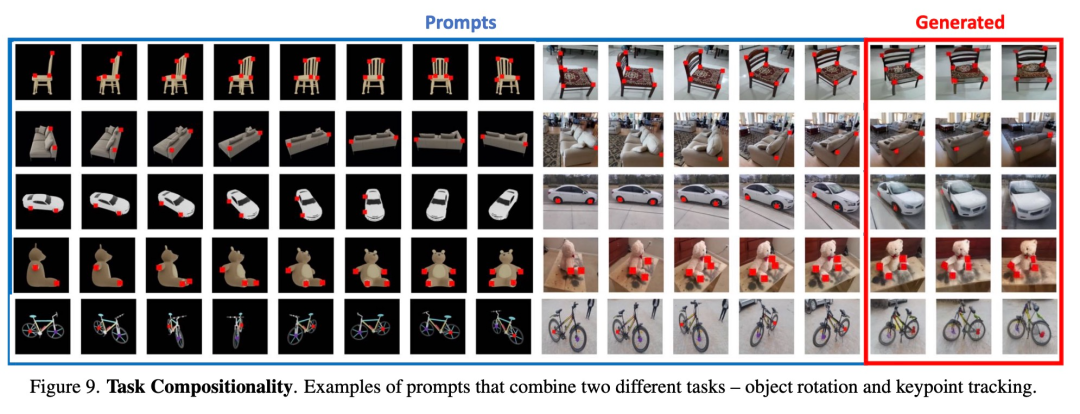

Tugas sintetik. Rajah 9 menunjukkan hasil penggabungan berbilang tugas menggunakan satu gesaan

Gesaan lain

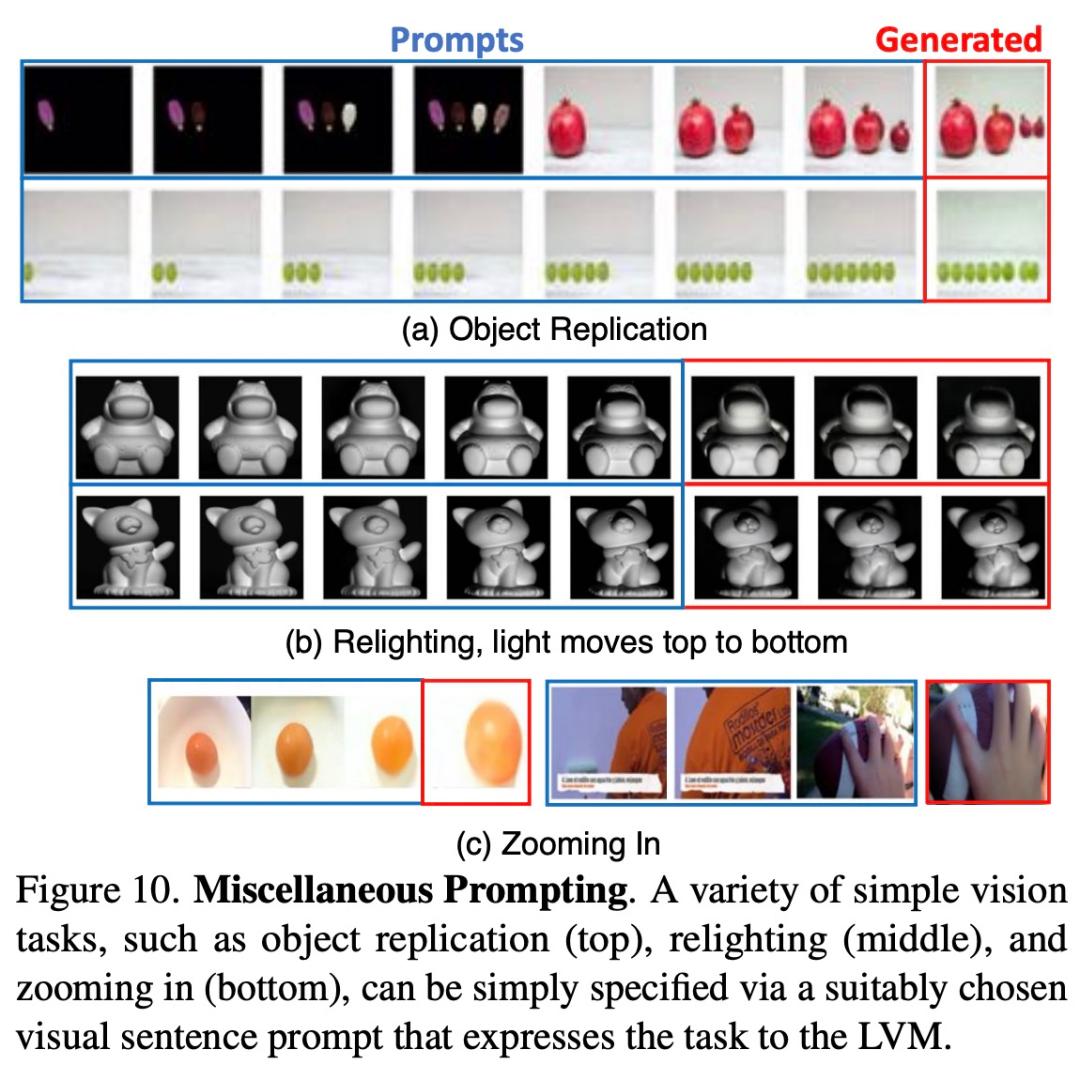

Para penyelidik cuba memerhati penskalaan model dengan memberinya pelbagai gesaan yang tidak pernah dilihatnya sebelum ini. kita perlu mencari peluang pasaran baharu. Kami merancang untuk mengembangkan lagi barisan produk kami untuk memenuhi permintaan yang semakin meningkat. Pada masa yang sama, kami akan mengukuhkan strategi pemasaran dan meningkatkan kesedaran jenama. Dengan mengambil bahagian secara aktif dalam pameran industri dan aktiviti promosi, kami akan berusaha untuk membangunkan lebih banyak kumpulan pelanggan. Kami percaya bahawa melalui usaha ini, kami boleh mencapai kejayaan yang lebih besar dan mencapai pertumbuhan yang berterusan. Rajah 10 di bawah menunjukkan beberapa gesaan sedemikian berfungsi dengan baik.

Rajah 11 di bawah menunjukkan beberapa gesaan yang sukar untuk diterangkan dengan perkataan akhirnya mungkin mengatasi LLM dalam tugasan ini.

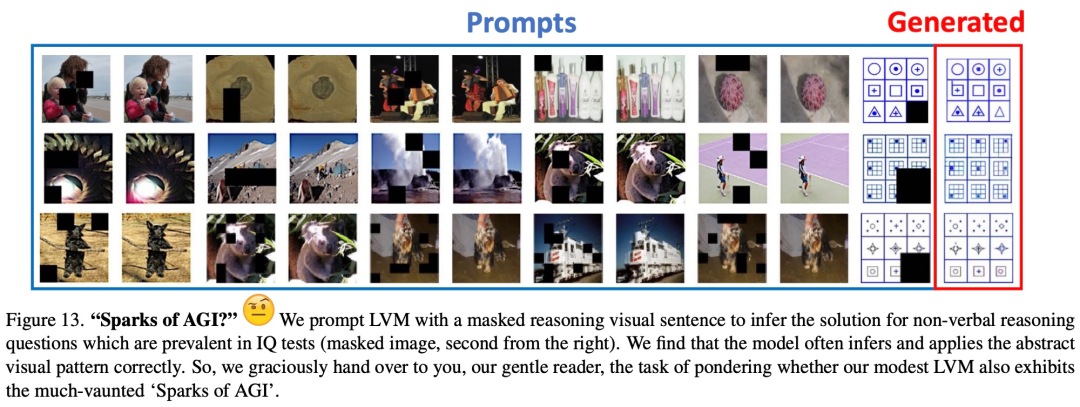

Rajah 13 menunjukkan keputusan kualitatif awal pada masalah penaakulan visual tipikal dalam ujian IQ manusia bukan lisan

Baca artikel asal untuk butiran lanjut.

Atas ialah kandungan terperinci UC Berkeley berjaya membangunkan model penaakulan visual umum yang besar, dan tiga sarjana kanan bergabung tenaga untuk mengambil bahagian dalam penyelidikan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1382

1382

52

52

Menerobos sempadan pengesanan kecacatan tradisional, 'Spektrum Kecacatan' mencapai ketepatan ultra tinggi dan pengesanan kecacatan industri semantik yang kaya buat kali pertama.

Jul 26, 2024 pm 05:38 PM

Menerobos sempadan pengesanan kecacatan tradisional, 'Spektrum Kecacatan' mencapai ketepatan ultra tinggi dan pengesanan kecacatan industri semantik yang kaya buat kali pertama.

Jul 26, 2024 pm 05:38 PM

Dalam pembuatan moden, pengesanan kecacatan yang tepat bukan sahaja kunci untuk memastikan kualiti produk, tetapi juga teras untuk meningkatkan kecekapan pengeluaran. Walau bagaimanapun, set data pengesanan kecacatan sedia ada selalunya tidak mempunyai ketepatan dan kekayaan semantik yang diperlukan untuk aplikasi praktikal, menyebabkan model tidak dapat mengenal pasti kategori atau lokasi kecacatan tertentu. Untuk menyelesaikan masalah ini, pasukan penyelidik terkemuka yang terdiri daripada Universiti Sains dan Teknologi Hong Kong Guangzhou dan Teknologi Simou telah membangunkan set data "DefectSpectrum" secara inovatif, yang menyediakan anotasi berskala besar yang kaya dengan semantik bagi kecacatan industri. Seperti yang ditunjukkan dalam Jadual 1, berbanding set data industri lain, set data "DefectSpectrum" menyediakan anotasi kecacatan yang paling banyak (5438 sampel kecacatan) dan klasifikasi kecacatan yang paling terperinci (125 kategori kecacatan

Model dialog NVIDIA ChatQA telah berkembang kepada versi 2.0, dengan panjang konteks disebut pada 128K

Jul 26, 2024 am 08:40 AM

Model dialog NVIDIA ChatQA telah berkembang kepada versi 2.0, dengan panjang konteks disebut pada 128K

Jul 26, 2024 am 08:40 AM

Komuniti LLM terbuka ialah era apabila seratus bunga mekar dan bersaing Anda boleh melihat Llama-3-70B-Instruct, QWen2-72B-Instruct, Nemotron-4-340B-Instruct, Mixtral-8x22BInstruct-v0.1 dan banyak lagi. model yang cemerlang. Walau bagaimanapun, berbanding dengan model besar proprietari yang diwakili oleh GPT-4-Turbo, model terbuka masih mempunyai jurang yang ketara dalam banyak bidang. Selain model umum, beberapa model terbuka yang mengkhusus dalam bidang utama telah dibangunkan, seperti DeepSeek-Coder-V2 untuk pengaturcaraan dan matematik, dan InternVL untuk tugasan bahasa visual.

Latihan dengan berjuta-juta data kristal untuk menyelesaikan masalah fasa kristalografi, kaedah pembelajaran mendalam PhAI diterbitkan dalam Sains

Aug 08, 2024 pm 09:22 PM

Latihan dengan berjuta-juta data kristal untuk menyelesaikan masalah fasa kristalografi, kaedah pembelajaran mendalam PhAI diterbitkan dalam Sains

Aug 08, 2024 pm 09:22 PM

Editor |KX Sehingga hari ini, perincian dan ketepatan struktur yang ditentukan oleh kristalografi, daripada logam ringkas kepada protein membran yang besar, tidak dapat ditandingi oleh mana-mana kaedah lain. Walau bagaimanapun, cabaran terbesar, yang dipanggil masalah fasa, kekal mendapatkan maklumat fasa daripada amplitud yang ditentukan secara eksperimen. Penyelidik di Universiti Copenhagen di Denmark telah membangunkan kaedah pembelajaran mendalam yang dipanggil PhAI untuk menyelesaikan masalah fasa kristal Rangkaian saraf pembelajaran mendalam yang dilatih menggunakan berjuta-juta struktur kristal tiruan dan data pembelauan sintetik yang sepadan boleh menghasilkan peta ketumpatan elektron yang tepat. Kajian menunjukkan bahawa kaedah penyelesaian struktur ab initio berasaskan pembelajaran mendalam ini boleh menyelesaikan masalah fasa pada resolusi hanya 2 Angstrom, yang bersamaan dengan hanya 10% hingga 20% daripada data yang tersedia pada resolusi atom, manakala Pengiraan ab initio tradisional

Google AI memenangi pingat perak IMO Mathematical Olympiad, model penaakulan matematik AlphaProof telah dilancarkan dan pembelajaran pengukuhan kembali

Jul 26, 2024 pm 02:40 PM

Google AI memenangi pingat perak IMO Mathematical Olympiad, model penaakulan matematik AlphaProof telah dilancarkan dan pembelajaran pengukuhan kembali

Jul 26, 2024 pm 02:40 PM

Bagi AI, Olimpik Matematik tidak lagi menjadi masalah. Pada hari Khamis, kecerdasan buatan Google DeepMind menyelesaikan satu kejayaan: menggunakan AI untuk menyelesaikan soalan sebenar IMO Olimpik Matematik Antarabangsa tahun ini, dan ia hanya selangkah lagi untuk memenangi pingat emas. Pertandingan IMO yang baru berakhir minggu lalu mempunyai enam soalan melibatkan algebra, kombinatorik, geometri dan teori nombor. Sistem AI hibrid yang dicadangkan oleh Google mendapat empat soalan dengan betul dan memperoleh 28 mata, mencapai tahap pingat perak. Awal bulan ini, profesor UCLA, Terence Tao baru sahaja mempromosikan Olimpik Matematik AI (Anugerah Kemajuan AIMO) dengan hadiah berjuta-juta dolar Tanpa diduga, tahap penyelesaian masalah AI telah meningkat ke tahap ini sebelum Julai. Lakukan soalan secara serentak pada IMO Perkara yang paling sukar untuk dilakukan dengan betul ialah IMO, yang mempunyai sejarah terpanjang, skala terbesar dan paling negatif

Pandangan alam semula jadi: Ujian kecerdasan buatan dalam perubatan berada dalam keadaan huru-hara Apa yang perlu dilakukan?

Aug 22, 2024 pm 04:37 PM

Pandangan alam semula jadi: Ujian kecerdasan buatan dalam perubatan berada dalam keadaan huru-hara Apa yang perlu dilakukan?

Aug 22, 2024 pm 04:37 PM

Editor |. ScienceAI Berdasarkan data klinikal yang terhad, beratus-ratus algoritma perubatan telah diluluskan. Para saintis sedang membahaskan siapa yang harus menguji alat dan cara terbaik untuk melakukannya. Devin Singh menyaksikan seorang pesakit kanak-kanak di bilik kecemasan mengalami serangan jantung semasa menunggu rawatan untuk masa yang lama, yang mendorongnya untuk meneroka aplikasi AI untuk memendekkan masa menunggu. Menggunakan data triage daripada bilik kecemasan SickKids, Singh dan rakan sekerja membina satu siri model AI untuk menyediakan potensi diagnosis dan mengesyorkan ujian. Satu kajian menunjukkan bahawa model ini boleh mempercepatkan lawatan doktor sebanyak 22.3%, mempercepatkan pemprosesan keputusan hampir 3 jam bagi setiap pesakit yang memerlukan ujian perubatan. Walau bagaimanapun, kejayaan algoritma kecerdasan buatan dalam penyelidikan hanya mengesahkan perkara ini

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Editor |ScienceAI Question Answering (QA) set data memainkan peranan penting dalam mempromosikan penyelidikan pemprosesan bahasa semula jadi (NLP). Set data QA berkualiti tinggi bukan sahaja boleh digunakan untuk memperhalusi model, tetapi juga menilai dengan berkesan keupayaan model bahasa besar (LLM), terutamanya keupayaan untuk memahami dan menaakul tentang pengetahuan saintifik. Walaupun pada masa ini terdapat banyak set data QA saintifik yang meliputi bidang perubatan, kimia, biologi dan bidang lain, set data ini masih mempunyai beberapa kekurangan. Pertama, borang data adalah agak mudah, kebanyakannya adalah soalan aneka pilihan. Ia mudah dinilai, tetapi mengehadkan julat pemilihan jawapan model dan tidak dapat menguji sepenuhnya keupayaan model untuk menjawab soalan saintifik. Sebaliknya, Soal Jawab terbuka

PRO |. Mengapa model besar berdasarkan MoE lebih patut diberi perhatian?

Aug 07, 2024 pm 07:08 PM

PRO |. Mengapa model besar berdasarkan MoE lebih patut diberi perhatian?

Aug 07, 2024 pm 07:08 PM

Pada tahun 2023, hampir setiap bidang AI berkembang pada kelajuan yang tidak pernah berlaku sebelum ini. Pada masa yang sama, AI sentiasa menolak sempadan teknologi trek utama seperti kecerdasan yang terkandung dan pemanduan autonomi. Di bawah trend berbilang modal, adakah status Transformer sebagai seni bina arus perdana model besar AI akan digoncang? Mengapakah penerokaan model besar berdasarkan seni bina MoE (Campuran Pakar) menjadi trend baharu dalam industri? Bolehkah Model Penglihatan Besar (LVM) menjadi satu kejayaan baharu dalam penglihatan umum? ...Daripada surat berita ahli PRO 2023 laman web ini yang dikeluarkan dalam tempoh enam bulan lalu, kami telah memilih 10 tafsiran khas yang menyediakan analisis mendalam tentang aliran teknologi dan perubahan industri dalam bidang di atas untuk membantu anda mencapai matlamat anda dalam bidang baharu. tahun. Tafsiran ini datang dari Week50 2023

Mengenal pasti molekul terbaik secara automatik dan mengurangkan kos sintesis MIT membangunkan rangka kerja algoritma pembuatan keputusan reka bentuk molekul

Jun 22, 2024 am 06:43 AM

Mengenal pasti molekul terbaik secara automatik dan mengurangkan kos sintesis MIT membangunkan rangka kerja algoritma pembuatan keputusan reka bentuk molekul

Jun 22, 2024 am 06:43 AM

Editor |. Penggunaan Ziluo AI dalam memperkemas penemuan dadah semakin meletup. Skrin berbilion molekul calon untuk mereka yang mungkin mempunyai sifat yang diperlukan untuk membangunkan ubat baharu. Terdapat begitu banyak pembolehubah untuk dipertimbangkan, daripada harga material kepada risiko kesilapan, sehingga menimbang kos mensintesis molekul calon terbaik bukanlah tugas yang mudah, walaupun saintis menggunakan AI. Di sini, penyelidik MIT membangunkan SPARROW, rangka kerja algoritma membuat keputusan kuantitatif, untuk mengenal pasti calon molekul terbaik secara automatik, dengan itu meminimumkan kos sintesis sambil memaksimumkan kemungkinan calon mempunyai sifat yang diingini. Algoritma juga menentukan bahan dan langkah eksperimen yang diperlukan untuk mensintesis molekul ini. SPARROW mengambil kira kos mensintesis sekumpulan molekul sekaligus, memandangkan berbilang molekul calon selalunya tersedia