Peranti teknologi

Peranti teknologi

AI

AI

Panduan OpenAI membolehkan lembaga menyekat CEO daripada mengeluarkan model baharu untuk melindungi daripada risiko AI

Panduan OpenAI membolehkan lembaga menyekat CEO daripada mengeluarkan model baharu untuk melindungi daripada risiko AI

Panduan OpenAI membolehkan lembaga menyekat CEO daripada mengeluarkan model baharu untuk melindungi daripada risiko AI

Untuk mengelakkan risiko besar yang mungkin dibawa oleh kecerdasan buatan (AI), OpenAI memutuskan untuk memberikan lembaga pengarah kuasa yang lebih besar untuk mengawasi hal keselamatan dan menjalankan penyeliaan ketat ke atas CEO Sam Altman, yang baru sahaja memenangi pertempuran dalaman bulan lalu

OpenAI mengeluarkan satu siri garis panduan pada hari Isnin, 18 Disember, EST, bertujuan untuk menjejak, menilai, meramal dan mencegah risiko bencana yang ditimbulkan oleh model kecerdasan buatan (AI) yang semakin berkuasa. OpenAI mentakrifkan "risiko bencana" sebagai sebarang risiko yang boleh mengakibatkan kerugian ekonomi ratusan bilion dolar, atau kecederaan serius atau kematian kepada berbilang orang

Panduan 27 halaman, yang dikenali sebagai "Rangka Kerja Kesediaan," menyatakan bahawa walaupun pengurusan tertinggi syarikat, termasuk CEO atau seseorang yang dilantik oleh kepimpinan, percaya bahawa model AI yang akan dikeluarkan adalah selamat, lembaga pengarah syarikat masih mempunyai kuasa untuk Memilih menangguhkan pengeluaran model ini. Ini bermakna walaupun Ketua Pegawai Eksekutif OpenAI bertanggungjawab ke atas keputusan harian, lembaga pengarah akan menyedari penemuan risiko dan mempunyai kuasa untuk memveto keputusan CEO

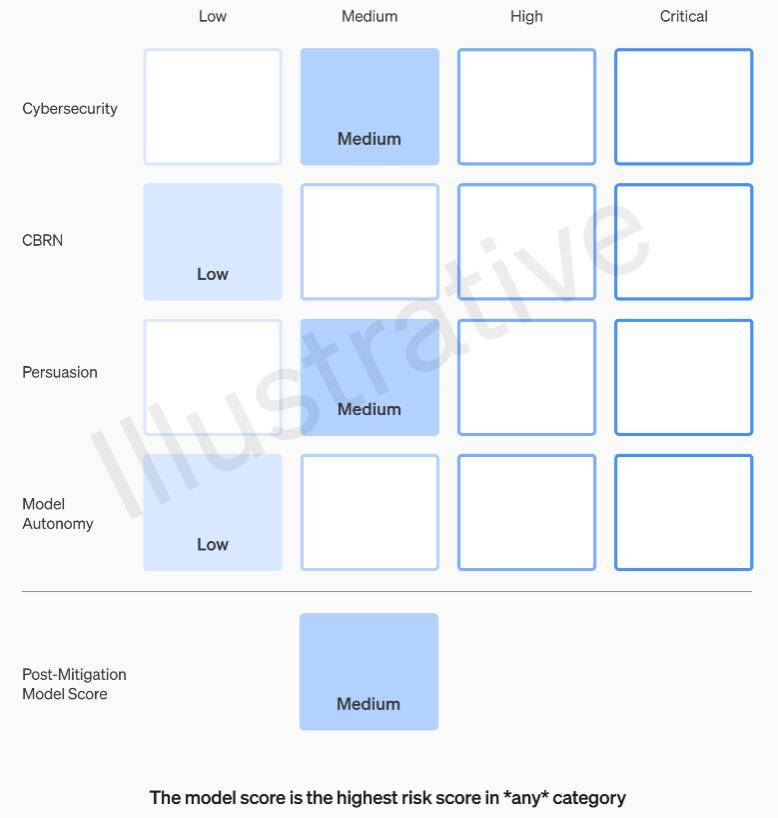

Rangka Kerja Kesediaan OpenAI mengesyorkan menggunakan pendekatan matriks untuk mendokumenkan tahap risiko yang ditimbulkan oleh model AI termaju merentas pelbagai kategori, selain peruntukan untuk kepimpinan syarikat dan pihak berkuasa lembaga pengarah. Risiko ini termasuk pelakon jahat yang menggunakan model AI untuk mencipta perisian hasad, melancarkan serangan kejuruteraan sosial atau menyebarkan maklumat senjata nuklear atau biologi yang berbahaya

Secara khusus, OpenAI menetapkan ambang risiko dalam empat kategori: keselamatan siber, CBRN (ancaman kimia, biologi, radiologi, nuklear), pemujukan dan autonomi model. Sebelum dan selepas langkah pengurangan risiko dilaksanakan, OpenAI mengklasifikasikan setiap risiko kepada empat tahap: rendah, sederhana, tinggi atau teruk

OpenAI menetapkan bahawa hanya model AI yang dinilai sebagai "sederhana" atau di bawah selepas pengurangan risiko boleh digunakan, dan hanya model yang dinilai sebagai "tinggi" atau di bawah selepas pengurangan risiko boleh terus dibangunkan Jika risiko tidak dapat dikurangkan kepada Di bawah yang teruk tahap, syarikat akan berhenti membangunkan model. OpenAI juga akan mengambil langkah keselamatan tambahan untuk model yang dinilai sebagai risiko tinggi atau risiko teruk sehingga risiko itu dikurangkan

OpenAI membahagikan pengendali isu keselamatan kepada tiga pasukan. Pasukan Sistem Keselamatan memberi tumpuan kepada mengurangkan dan menangani risiko yang ditimbulkan oleh produk semasa seperti GPT-4. Pasukan Penjajaran Super bimbang tentang masalah yang mungkin timbul apabila sistem masa depan melebihi keupayaan manusia. Selain itu, terdapat pasukan baharu yang dipanggil Prepare, diketuai oleh Aleksander Madry, profesor di Jabatan Kejuruteraan Elektrik dan Sains Komputer (EECS) di Massachusetts Institute of Technology (MIT)

Pasukan baharu akan menilai pembangunan dan pelaksanaan model yang mantap. Mereka akan bertanggungjawab secara khusus untuk mengawasi kerja teknikal dan seni bina operasi yang berkaitan dengan keputusan keselamatan. Mereka akan memacu kerja teknikal, menyemak had keupayaan model termaju, dan menjalankan penilaian serta mensintesis laporan berkaitan

Madry berkata bahawa pasukannya akan sentiasa menilai tahap risiko model kecerdasan buatan OpenAI yang paling maju yang masih belum dikeluarkan, dan menyerahkan laporan bulanan kepada Kumpulan Penasihat Keselamatan dalaman (SAG) OpenAI. SAG akan menganalisis kerja pasukan Madry dan memberikan cadangan kepada CEO Altman dan Lembaga Pengarah syarikat

Menurut dokumen panduan yang dikeluarkan pada hari Isnin, Altman dan kepimpinannya boleh memutuskan sama ada untuk mengeluarkan sistem AI baharu berdasarkan laporan ini, tetapi lembaga pengarah mengekalkan kuasa untuk membatalkan keputusan mereka

Pada masa ini, pasukan Madry hanya mempunyai empat orang, tetapi dia bekerja keras untuk merekrut lebih ramai ahli. Dijangkakan bahawa ahli pasukan akan mencapai 15 hingga 20 orang, yang serupa dengan pasukan keselamatan dan pasukan penjajaran hiper yang sedia ada

Madry berharap syarikat AI lain akan menilai risiko model mereka dengan cara yang sama dan berpendapat ini boleh menjadi model untuk peraturan

Atas ialah kandungan terperinci Panduan OpenAI membolehkan lembaga menyekat CEO daripada mengeluarkan model baharu untuk melindungi daripada risiko AI. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1392

1392

52

52

Top 5 Genai dilancarkan pada Februari 2025: GPT-4.5, Grok-3 & More!

Mar 22, 2025 am 10:58 AM

Top 5 Genai dilancarkan pada Februari 2025: GPT-4.5, Grok-3 & More!

Mar 22, 2025 am 10:58 AM

Februari 2025 telah menjadi satu lagi bulan yang berubah-ubah untuk AI generatif, membawa kita beberapa peningkatan model yang paling dinanti-nantikan dan ciri-ciri baru yang hebat. Dari Xai's Grok 3 dan Anthropic's Claude 3.7 Sonnet, ke Openai's G

Bagaimana cara menggunakan Yolo V12 untuk pengesanan objek?

Mar 22, 2025 am 11:07 AM

Bagaimana cara menggunakan Yolo V12 untuk pengesanan objek?

Mar 22, 2025 am 11:07 AM

Yolo (anda hanya melihat sekali) telah menjadi kerangka pengesanan objek masa nyata yang terkemuka, dengan setiap lelaran bertambah baik pada versi sebelumnya. Versi terbaru Yolo V12 memperkenalkan kemajuan yang meningkatkan ketepatan

Penjana Seni AI Terbaik (Percuma & amp; Dibayar) untuk projek kreatif

Apr 02, 2025 pm 06:10 PM

Penjana Seni AI Terbaik (Percuma & amp; Dibayar) untuk projek kreatif

Apr 02, 2025 pm 06:10 PM

Artikel ini mengkaji semula penjana seni AI atas, membincangkan ciri -ciri mereka, kesesuaian untuk projek kreatif, dan nilai. Ia menyerlahkan Midjourney sebagai nilai terbaik untuk profesional dan mengesyorkan Dall-E 2 untuk seni berkualiti tinggi dan disesuaikan.

Adakah chatgpt 4 o tersedia?

Mar 28, 2025 pm 05:29 PM

Adakah chatgpt 4 o tersedia?

Mar 28, 2025 pm 05:29 PM

CHATGPT 4 kini tersedia dan digunakan secara meluas, menunjukkan penambahbaikan yang ketara dalam memahami konteks dan menjana tindak balas yang koheren berbanding dengan pendahulunya seperti ChATGPT 3.5. Perkembangan masa depan mungkin merangkumi lebih banyak Inter yang diperibadikan

CHATBOTS AI terbaik berbanding (Chatgpt, Gemini, Claude & amp; Lagi)

Apr 02, 2025 pm 06:09 PM

CHATBOTS AI terbaik berbanding (Chatgpt, Gemini, Claude & amp; Lagi)

Apr 02, 2025 pm 06:09 PM

Artikel ini membandingkan chatbots AI seperti Chatgpt, Gemini, dan Claude, yang memberi tumpuan kepada ciri -ciri unik mereka, pilihan penyesuaian, dan prestasi dalam pemprosesan bahasa semula jadi dan kebolehpercayaan.

Bermula dengan Meta Llama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Bermula dengan Meta Llama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Meta's Llama 3.2: Lompat ke hadapan dalam Multimodal dan Mobile AI META baru -baru ini melancarkan Llama 3.2, kemajuan yang ketara dalam AI yang memaparkan keupayaan penglihatan yang kuat dan model teks ringan yang dioptimumkan untuk peranti mudah alih. Membina kejayaan o

Pembantu Menulis AI Teratas untuk Meningkatkan Penciptaan Kandungan Anda

Apr 02, 2025 pm 06:11 PM

Pembantu Menulis AI Teratas untuk Meningkatkan Penciptaan Kandungan Anda

Apr 02, 2025 pm 06:11 PM

Artikel ini membincangkan pembantu penulisan AI terkemuka seperti Grammarly, Jasper, Copy.ai, WriteSonic, dan Rytr, yang memberi tumpuan kepada ciri -ciri unik mereka untuk penciptaan kandungan. Ia berpendapat bahawa Jasper cemerlang dalam pengoptimuman SEO, sementara alat AI membantu mengekalkan nada terdiri

Panduan ke Uber ' s H3 untuk Pengindeksan Spatial

Mar 22, 2025 am 10:54 AM

Panduan ke Uber ' s H3 untuk Pengindeksan Spatial

Mar 22, 2025 am 10:54 AM

Dalam dunia yang didorong data hari ini, pengindeksan geospatial yang cekap adalah penting untuk aplikasi dari perkongsian dan logistik ke pemantauan alam sekitar dan tindak balas bencana. Uber's H3, Spat Sumber Terbuka yang kuat