Peranti teknologi

Peranti teknologi

AI

AI

PixelLM, model besar berbilang modal bait yang cekap melaksanakan penaakulan tahap piksel tanpa pergantungan SA

PixelLM, model besar berbilang modal bait yang cekap melaksanakan penaakulan tahap piksel tanpa pergantungan SA

PixelLM, model besar berbilang modal bait yang cekap melaksanakan penaakulan tahap piksel tanpa pergantungan SA

Model besar berbilang modal sedang meletup. Adakah anda bersedia untuk memasukkan aplikasi praktikal dalam tugasan yang terperinci seperti penyuntingan imej, pemanduan autonomi dan robotik?

Pada masa ini, keupayaan kebanyakan model masih terhad untuk menjana penerangan teks bagi keseluruhan imej atau kawasan tertentu, dan keupayaannya dalam pemahaman tahap piksel (seperti pembahagian objek) agak terhad.

Sebagai tindak balas kepada masalah ini, beberapa kerja telah mula meneroka penggunaan model besar berbilang modal untuk mengendalikan arahan pembahagian pengguna (contohnya, "Sila belah buah-buahan yang kaya dengan vitamin C dalam gambar").

Walau bagaimanapun, kaedah di pasaran mengalami dua kelemahan utama:

1) Ketidakupayaan untuk mengendalikan tugas yang melibatkan pelbagai objek sasaran, yang amat diperlukan dalam senario dunia sebenar

2) Bergantung pada alat seperti SAM Untuk pra seperti itu; -model pembahagian imej terlatih, jumlah pengiraan yang diperlukan untuk satu perambatan hadapan SAM sudah cukup untuk Llama-7B menjana lebih daripada 500 token.

Untuk menyelesaikan masalah ini, pasukan penciptaan pintar ByteDance bekerjasama dengan penyelidik dari Universiti Jiaotong Beijing dan Universiti Sains dan Teknologi Beijing untuk mencadangkan PixelLM, model inferens peringkat piksel berskala besar pertama yang cekap yang tidak bergantung pada SAM.

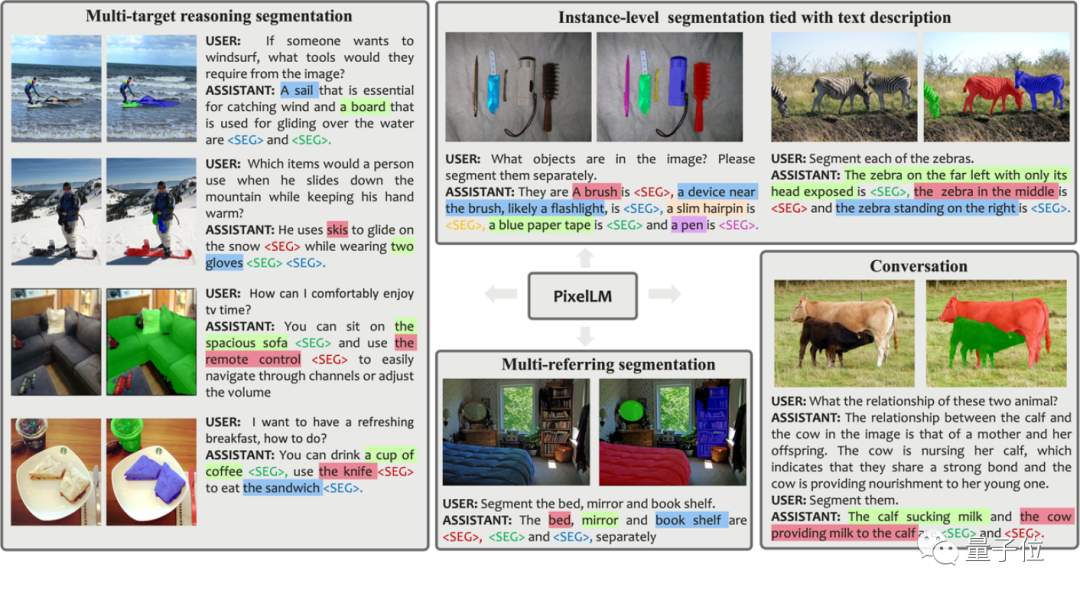

Sebelum memperkenalkannya secara terperinci, mari kita rasai kesan pembahagian sebenar beberapa kumpulan PixelLM:

Berbanding dengan kerja sebelumnya, kelebihan PixelLM ialah:

- Ia boleh mengendalikan sebarang bilangan sasaran domain terbuka dan penaakulan kompleks yang pelbagai. Pisah tugas.

- Mengelakkan model segmentasi tambahan dan mahal, meningkatkan kecekapan dan keupayaan pemindahan ke aplikasi yang berbeza.

Seterusnya, untuk menyokong latihan dan penilaian model dalam bidang penyelidikan ini, pasukan penyelidik membina set data MUSE untuk senario segmentasi penaakulan pelbagai objektif berdasarkan set data LVIS dan GPT-4V Ia mengandungi 200,000 Lebih daripada 900,000 pasangan soalan-jawapan, yang melibatkan lebih daripada 900,000 topeng pembahagian contoh.

Untuk mencapai kesan di atas, bagaimanakah kajian ini dijalankan?

Prinsip di sebalik

Pictures

Pictures

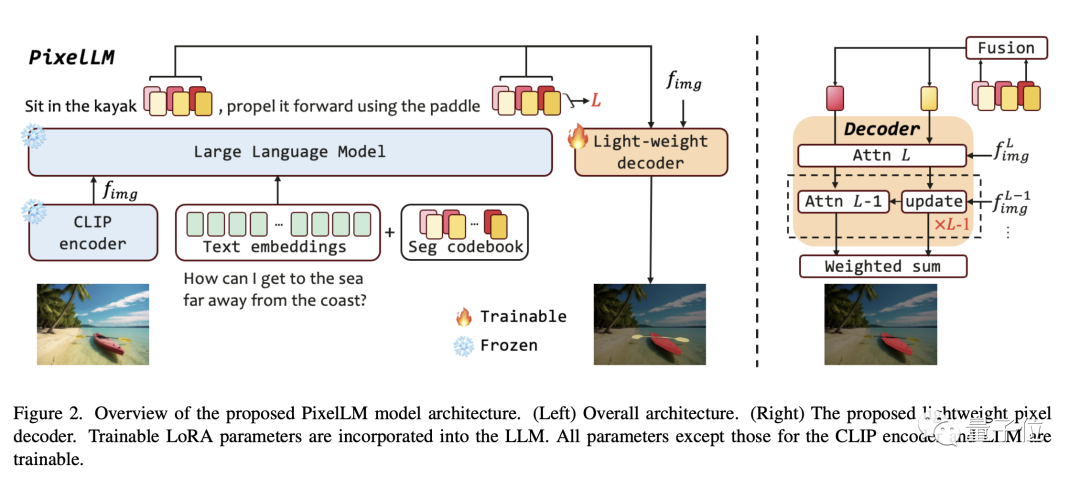

Seperti yang ditunjukkan dalam rajah rangka kerja dalam kertas, seni bina PixelLM adalah sangat mudah dan terdiri daripada empat bahagian utama yang kedua adalah teras PixelLM:

- -

- . Pengekod penglihatan CLIP-ViT terlatih

- Model Bahasa Besar

- Penyahkod Piksel Ringan

- Buku Kod Seg

Buku kod Seg mengandungi token yang boleh dipelajari, yang digunakan untuk mengekod maklumat sasaran pada skala CLIP-ViT yang berbeza. Kemudian, penyahkod piksel menjana hasil pembahagian objek berdasarkan token ini dan ciri imej CLIP-ViT. Terima kasih kepada reka bentuk ini, PixelLM boleh menjana hasil segmentasi berkualiti tinggi tanpa model segmentasi luaran, meningkatkan kecekapan model dengan ketara.

Menurut penerangan penyelidik, token dalam buku kod Seg boleh dibahagikan kepada kumpulan L, setiap kumpulan mengandungi N token, dan setiap kumpulan sepadan dengan skala daripada ciri visual CLIP-ViT.

Untuk imej input, PixelLM mengekstrak ciri skala L daripada ciri imej yang dihasilkan oleh pengekod visual CLIP-ViT Lapisan terakhir meliputi maklumat imej global dan akan digunakan oleh LLM untuk memahami kandungan imej.

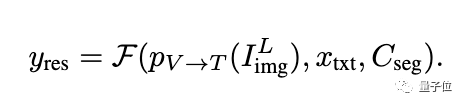

Token buku kod Seg akan dimasukkan ke dalam LLM bersama-sama dengan arahan teks dan lapisan terakhir ciri imej untuk menghasilkan output dalam bentuk autoregresi. Output juga akan termasuk token buku kod Seg yang diproses oleh LLM, yang akan dimasukkan ke dalam penyahkod piksel bersama-sama ciri CLIP-ViT skala L untuk menghasilkan hasil pembahagian akhir.

Gambar

Gambar

Gambar

Gambar

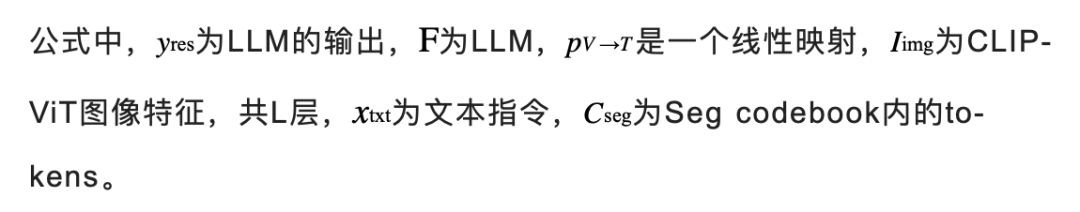

Jadi mengapa kita perlu menetapkan setiap kumpulan untuk mengandungi N token? Para penyelidik menjelaskan bersama-sama dengan angka berikut:

Dalam senario yang melibatkan berbilang sasaran atau semantik yang terkandung dalam sasaran adalah sangat kompleks, walaupun LLM boleh memberikan respons teks terperinci, menggunakan hanya satu token mungkin tidak menangkap sepenuhnya semua semantik sasaran kandungan.

Untuk meningkatkan keupayaan model dalam senario penaakulan yang kompleks, para penyelidik memperkenalkan berbilang token dalam setiap kumpulan skala dan melakukan operasi gabungan linear bagi satu token. Sebelum token dihantar ke penyahkod, lapisan unjuran linear digunakan untuk menggabungkan token dalam setiap kumpulan.

Gambar di bawah menunjukkan kesan apabila terdapat berbilang token dalam setiap kumpulan. Peta perhatian ialah rupa setiap token selepas diproses oleh penyahkod ini menunjukkan bahawa berbilang token memberikan maklumat yang unik dan pelengkap, menghasilkan output pembahagian yang lebih berkesan.

Pictures

Pictures

Selain itu, untuk meningkatkan keupayaan model untuk membezakan berbilang sasaran, PixelLM turut mereka bentuk Target Refinement Loss tambahan.

Set Data MUSE

Walaupun penyelesaian di atas telah dicadangkan, untuk mengeksploitasi sepenuhnya keupayaan model, model masih memerlukan data latihan yang sesuai. Mengkaji set data awam yang tersedia pada masa ini, kami mendapati bahawa data sedia ada mempunyai had utama berikut:

1) Penerangan butiran objek yang tidak mencukupi

2) Kekurangan pasangan soalan-jawapan dengan alasan yang kompleks dan nombor sasaran yang pelbagai.

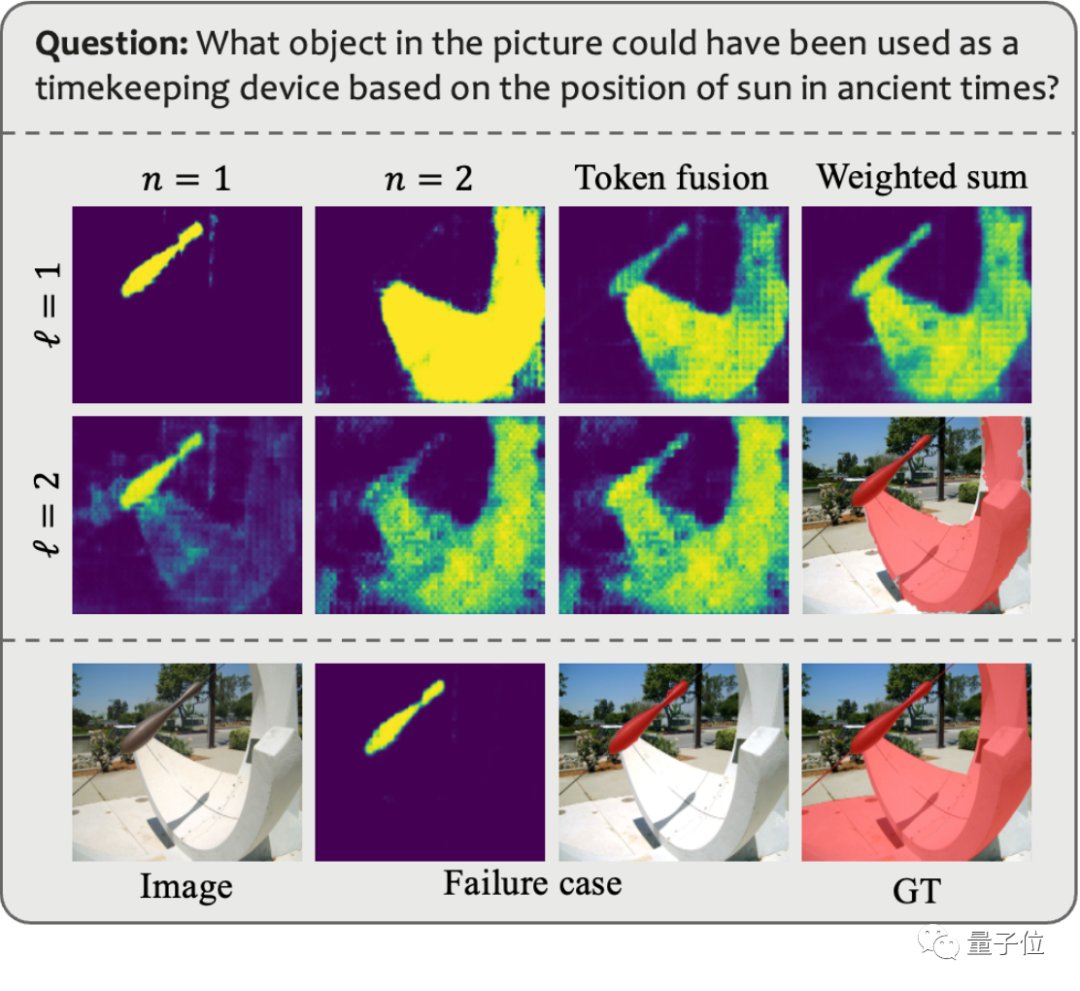

Untuk menyelesaikan masalah ini, pasukan penyelidik menggunakan GPT-4V untuk membina saluran paip anotasi data automatik, dan dengan itu menghasilkan set data MUSE. Rajah di bawah menunjukkan contoh gesaan yang digunakan semasa menjana MUSE dan data yang dijana.

Gambar

Gambar

Dalam MUSE, semua topeng contoh adalah daripada set data LVIS, dan penerangan teks terperinci tambahan yang dijana berdasarkan kandungan imej ditambah. MUSE mengandungi 246,000 pasangan soalan-jawapan, dan setiap pasangan soalan-jawapan melibatkan purata 3.7 objek sasaran. Di samping itu, pasukan penyelidik menjalankan analisis statistik lengkap set data:

Statistik Kategori: Terdapat lebih daripada 1000 kategori dalam MUSE daripada set data LVIS asal, dan 900,000 kejadian dengan penerangan unik berdasarkan pasangan soalan-jawab berbeza-beza bergantung pada konteks. Rajah (a) menunjukkan bilangan kejadian bagi setiap kategori merentas semua pasangan soalan-jawapan.

Statistik nombor token: Rajah (b) menunjukkan taburan bilangan token yang diterangkan dalam contoh, beberapa daripadanya mengandungi lebih daripada 100 token. Perihalan ini tidak terhad kepada nama kategori mudah sebaliknya, ia diperkaya dengan maklumat terperinci tentang setiap contoh, termasuk rupa, sifat dan hubungan dengan objek lain, melalui proses penjanaan data berasaskan GPT-4V. Kedalaman dan kepelbagaian maklumat dalam set data meningkatkan keupayaan generalisasi model terlatih, membolehkannya menyelesaikan masalah domain terbuka dengan berkesan.

Statistik nombor sasaran: Rajah (c) menunjukkan statistik bilangan sasaran bagi setiap pasangan soalan-jawapan. Purata bilangan sasaran ialah 3.7, dan bilangan maksimum sasaran boleh mencapai 34. Nombor ini boleh merangkumi kebanyakan senario inferens sasaran untuk satu imej. Penilaian

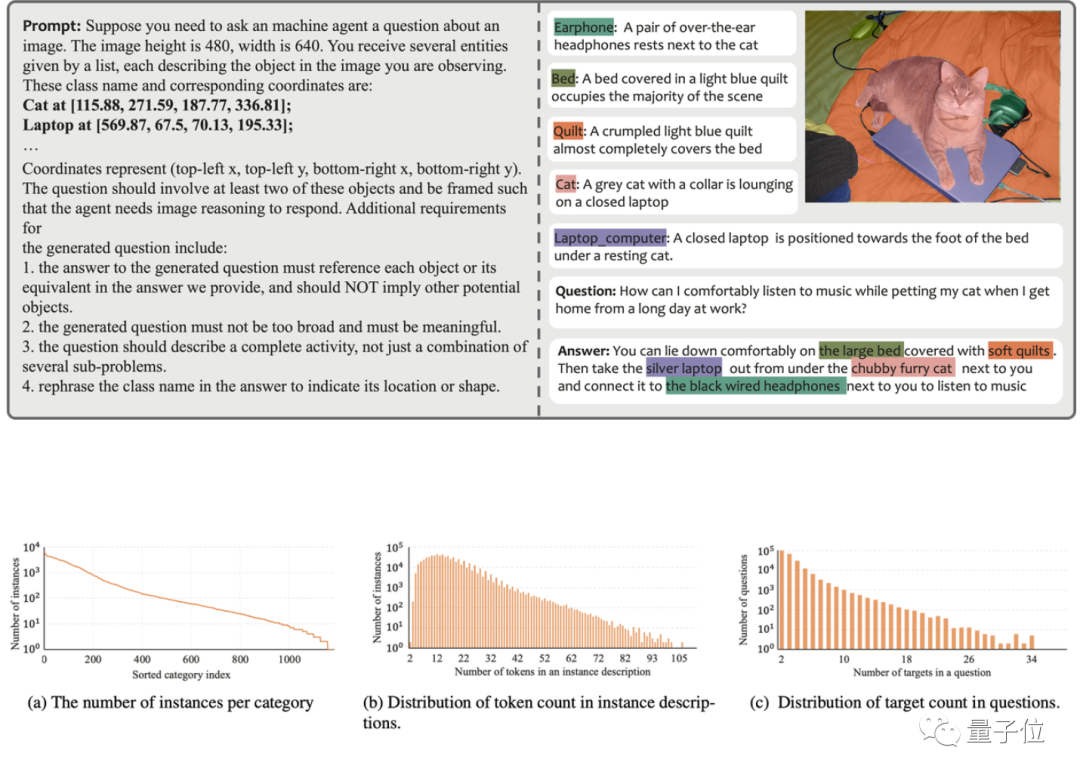

Algoritma

Pasukan penyelidikan menilai prestasi Pixellm pada tiga tanda aras, termasuk penanda aras Muse, merujuk penanda aras segmentasi, dan penanda aras segmentasi multi-referring. masalah Bahagikan berbilang objek secara berterusan yang terkandung dalam setiap imej dalam penanda aras pembahagian yang merujuk.

Pada masa yang sama, memandangkan PixelLM ialah model pertama yang mengendalikan tugasan penaakulan piksel kompleks yang melibatkan berbilang sasaran, pasukan penyelidik menubuhkan empat garis dasar untuk menjalankan analisis perbandingan model tersebut.

Tiga daripada garis dasar adalah berdasarkan LISA, kerja yang paling relevan pada PixelLM, termasuk:

1) LISA asal

2) LISA_rec: mula-mula masukkan soalan ke dalam LLAVA-13B untuk mendapatkan balasan teks sasaran, dan kemudian gunakan LISA untuk membahagikan teks ;

3) LISA_aug: Terus tambah MUSE pada data latihan LISA.

4) Yang satu lagi ialah SEEM, model segmentasi umum yang tidak menggunakan LLM.

Gambar

Gambar

Pada kebanyakan penunjuk bagi tiga penanda aras, prestasi PixelLM adalah lebih baik daripada kaedah lain, dan kerana PixelLM tidak bergantung pada SAM, TFLOPnya jauh lebih rendah daripada model dengan saiz yang sama.

Rakan-rakan yang berminat boleh beri perhatian dahulu dan tunggu kod menjadi sumber terbuka~

Pautan rujukan:

[1]https://www.php.cn/link/9271858951e6fe9504d1f05ae8576001:

/www.php.cn/link/f1686b4badcf28d33ed632036c7ab0b8

Atas ialah kandungan terperinci PixelLM, model besar berbilang modal bait yang cekap melaksanakan penaakulan tahap piksel tanpa pergantungan SA. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

Model MoE sumber terbuka paling berkuasa di dunia ada di sini, dengan keupayaan bahasa Cina setanding dengan GPT-4, dan harganya hanya hampir satu peratus daripada GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Model MoE sumber terbuka paling berkuasa di dunia ada di sini, dengan keupayaan bahasa Cina setanding dengan GPT-4, dan harganya hanya hampir satu peratus daripada GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Bayangkan model kecerdasan buatan yang bukan sahaja mempunyai keupayaan untuk mengatasi pengkomputeran tradisional, tetapi juga mencapai prestasi yang lebih cekap pada kos yang lebih rendah. Ini bukan fiksyen sains, DeepSeek-V2[1], model MoE sumber terbuka paling berkuasa di dunia ada di sini. DeepSeek-V2 ialah gabungan model bahasa pakar (MoE) yang berkuasa dengan ciri-ciri latihan ekonomi dan inferens yang cekap. Ia terdiri daripada 236B parameter, 21B daripadanya digunakan untuk mengaktifkan setiap penanda. Berbanding dengan DeepSeek67B, DeepSeek-V2 mempunyai prestasi yang lebih kukuh, sambil menjimatkan 42.5% kos latihan, mengurangkan cache KV sebanyak 93.3% dan meningkatkan daya pemprosesan penjanaan maksimum kepada 5.76 kali. DeepSeek ialah sebuah syarikat yang meneroka kecerdasan buatan am

KAN, yang menggantikan MLP, telah diperluaskan kepada konvolusi oleh projek sumber terbuka

Jun 01, 2024 pm 10:03 PM

KAN, yang menggantikan MLP, telah diperluaskan kepada konvolusi oleh projek sumber terbuka

Jun 01, 2024 pm 10:03 PM

Awal bulan ini, penyelidik dari MIT dan institusi lain mencadangkan alternatif yang sangat menjanjikan kepada MLP - KAN. KAN mengatasi MLP dari segi ketepatan dan kebolehtafsiran. Dan ia boleh mengatasi prestasi MLP berjalan dengan bilangan parameter yang lebih besar dengan bilangan parameter yang sangat kecil. Sebagai contoh, penulis menyatakan bahawa mereka menggunakan KAN untuk menghasilkan semula keputusan DeepMind dengan rangkaian yang lebih kecil dan tahap automasi yang lebih tinggi. Khususnya, MLP DeepMind mempunyai kira-kira 300,000 parameter, manakala KAN hanya mempunyai kira-kira 200 parameter. KAN mempunyai asas matematik yang kukuh seperti MLP berdasarkan teorem penghampiran universal, manakala KAN berdasarkan teorem perwakilan Kolmogorov-Arnold. Seperti yang ditunjukkan dalam rajah di bawah, KAN telah

Robot Tesla bekerja di kilang, Musk: Tahap kebebasan tangan akan mencapai 22 tahun ini!

May 06, 2024 pm 04:13 PM

Robot Tesla bekerja di kilang, Musk: Tahap kebebasan tangan akan mencapai 22 tahun ini!

May 06, 2024 pm 04:13 PM

Video terbaru robot Tesla Optimus dikeluarkan, dan ia sudah boleh berfungsi di kilang. Pada kelajuan biasa, ia mengisih bateri (bateri 4680 Tesla) seperti ini: Pegawai itu juga mengeluarkan rupanya pada kelajuan 20x - pada "stesen kerja" kecil, memilih dan memilih dan memilih: Kali ini ia dikeluarkan Salah satu sorotan video itu ialah Optimus menyelesaikan kerja ini di kilang, sepenuhnya secara autonomi, tanpa campur tangan manusia sepanjang proses. Dan dari perspektif Optimus, ia juga boleh mengambil dan meletakkan bateri yang bengkok, memfokuskan pada pembetulan ralat automatik: Berkenaan tangan Optimus, saintis NVIDIA Jim Fan memberikan penilaian yang tinggi: Tangan Optimus adalah robot lima jari di dunia paling cerdik. Tangannya bukan sahaja boleh disentuh

Tiada data OpenAI diperlukan, sertai senarai model kod besar! UIUC mengeluarkan StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Tiada data OpenAI diperlukan, sertai senarai model kod besar! UIUC mengeluarkan StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Di barisan hadapan teknologi perisian, kumpulan UIUC Zhang Lingming, bersama penyelidik dari organisasi BigCode, baru-baru ini mengumumkan model kod besar StarCoder2-15B-Instruct. Pencapaian inovatif ini mencapai kejayaan ketara dalam tugas penjanaan kod, berjaya mengatasi CodeLlama-70B-Instruct dan mencapai bahagian atas senarai prestasi penjanaan kod. Keunikan StarCoder2-15B-Instruct terletak pada strategi penjajaran diri yang tulen Keseluruhan proses latihan adalah terbuka, telus, dan sepenuhnya autonomi dan boleh dikawal. Model ini menjana beribu-ribu arahan melalui StarCoder2-15B sebagai tindak balas kepada penalaan halus model asas StarCoder-15B tanpa bergantung pada anotasi manual yang mahal.

Melebihi DPO secara menyeluruh: Pasukan Chen Danqi mencadangkan pengoptimuman pilihan mudah SimPO, dan turut memperhalusi model sumber terbuka 8B terkuat

Jun 01, 2024 pm 04:41 PM

Melebihi DPO secara menyeluruh: Pasukan Chen Danqi mencadangkan pengoptimuman pilihan mudah SimPO, dan turut memperhalusi model sumber terbuka 8B terkuat

Jun 01, 2024 pm 04:41 PM

Untuk menyelaraskan model bahasa besar (LLM) dengan nilai dan niat manusia, adalah penting untuk mempelajari maklum balas manusia untuk memastikan bahawa ia berguna, jujur dan tidak berbahaya. Dari segi penjajaran LLM, kaedah yang berkesan ialah pembelajaran pengukuhan berdasarkan maklum balas manusia (RLHF). Walaupun keputusan kaedah RLHF adalah cemerlang, terdapat beberapa cabaran pengoptimuman yang terlibat. Ini melibatkan latihan model ganjaran dan kemudian mengoptimumkan model dasar untuk memaksimumkan ganjaran tersebut. Baru-baru ini, beberapa penyelidik telah meneroka algoritma luar talian yang lebih mudah, salah satunya ialah pengoptimuman keutamaan langsung (DPO). DPO mempelajari model dasar secara langsung berdasarkan data keutamaan dengan meparameterkan fungsi ganjaran dalam RLHF, sekali gus menghapuskan keperluan untuk model ganjaran yang jelas. Kaedah ini mudah dan stabil

Yolov10: Penjelasan terperinci, penggunaan dan aplikasi semuanya di satu tempat!

Jun 07, 2024 pm 12:05 PM

Yolov10: Penjelasan terperinci, penggunaan dan aplikasi semuanya di satu tempat!

Jun 07, 2024 pm 12:05 PM

1. Pengenalan Sejak beberapa tahun kebelakangan ini, YOLO telah menjadi paradigma dominan dalam bidang pengesanan objek masa nyata kerana keseimbangannya yang berkesan antara kos pengiraan dan prestasi pengesanan. Penyelidik telah meneroka reka bentuk seni bina YOLO, matlamat pengoptimuman, strategi pengembangan data, dsb., dan telah mencapai kemajuan yang ketara. Pada masa yang sama, bergantung pada penindasan bukan maksimum (NMS) untuk pemprosesan pasca menghalang penggunaan YOLO dari hujung ke hujung dan memberi kesan buruk kepada kependaman inferens. Dalam YOLO, reka bentuk pelbagai komponen tidak mempunyai pemeriksaan yang komprehensif dan teliti, mengakibatkan lebihan pengiraan yang ketara dan mengehadkan keupayaan model. Ia menawarkan kecekapan suboptimum, dan potensi yang agak besar untuk peningkatan prestasi. Dalam kerja ini, matlamatnya adalah untuk meningkatkan lagi sempadan kecekapan prestasi YOLO daripada kedua-dua pasca pemprosesan dan seni bina model. sampai habis

LLM sudah selesai! OmniDrive: Mengintegrasikan persepsi 3D dan perancangan penaakulan (terbaharu NVIDIA)

May 09, 2024 pm 04:55 PM

LLM sudah selesai! OmniDrive: Mengintegrasikan persepsi 3D dan perancangan penaakulan (terbaharu NVIDIA)

May 09, 2024 pm 04:55 PM

Ditulis di atas & pemahaman peribadi pengarang: Kertas kerja ini didedikasikan untuk menyelesaikan cabaran utama model bahasa besar multimodal semasa (MLLM) dalam aplikasi pemanduan autonomi, iaitu masalah melanjutkan MLLM daripada pemahaman 2D kepada ruang 3D. Peluasan ini amat penting kerana kenderaan autonomi (AV) perlu membuat keputusan yang tepat tentang persekitaran 3D. Pemahaman spatial 3D adalah penting untuk AV kerana ia memberi kesan langsung kepada keupayaan kenderaan untuk membuat keputusan termaklum, meramalkan keadaan masa depan dan berinteraksi dengan selamat dengan alam sekitar. Model bahasa besar berbilang mod semasa (seperti LLaVA-1.5) selalunya hanya boleh mengendalikan input imej resolusi rendah (cth.) disebabkan oleh had resolusi pengekod visual, had panjang jujukan LLM. Walau bagaimanapun, aplikasi pemanduan autonomi memerlukan

Perbandingan prestasi rangka kerja Java yang berbeza

Jun 05, 2024 pm 07:14 PM

Perbandingan prestasi rangka kerja Java yang berbeza

Jun 05, 2024 pm 07:14 PM

Perbandingan prestasi rangka kerja Java yang berbeza: Pemprosesan permintaan REST API: Vert.x adalah yang terbaik, dengan kadar permintaan 2 kali SpringBoot dan 3 kali Dropwizard. Pertanyaan pangkalan data: HibernateORM SpringBoot adalah lebih baik daripada Vert.x dan ORM Dropwizard. Operasi caching: Pelanggan Hazelcast Vert.x lebih unggul daripada mekanisme caching SpringBoot dan Dropwizard. Rangka kerja yang sesuai: Pilih mengikut keperluan aplikasi Vert.x sesuai untuk perkhidmatan web berprestasi tinggi, SpringBoot sesuai untuk aplikasi intensif data, dan Dropwizard sesuai untuk seni bina perkhidmatan mikro.