Peranti teknologi

Peranti teknologi

AI

AI

Model kecil tetapi hebat semakin meningkat: TinyLlama dan LiteLlama menjadi pilihan popular

Model kecil tetapi hebat semakin meningkat: TinyLlama dan LiteLlama menjadi pilihan popular

Model kecil tetapi hebat semakin meningkat: TinyLlama dan LiteLlama menjadi pilihan popular

Pada masa ini, penyelidik mula menumpukan pada model kecil yang padat dan berprestasi tinggi, walaupun semua orang sedang mengkaji model besar dengan skala parameter mencecah puluhan bilion atau bahkan ratusan bilion.

Model kecil digunakan secara meluas dalam peranti tepi, seperti telefon pintar, peranti IoT dan sistem terbenam. Peranti ini selalunya mempunyai kuasa pengkomputeran dan ruang storan yang terhad dan tidak dapat menjalankan model bahasa yang besar dengan cekap. Oleh itu, mengkaji model kecil menjadi sangat penting.

Dua kajian yang akan kami perkenalkan seterusnya mungkin memenuhi keperluan anda untuk model kecil.

TinyLlama-1.1B

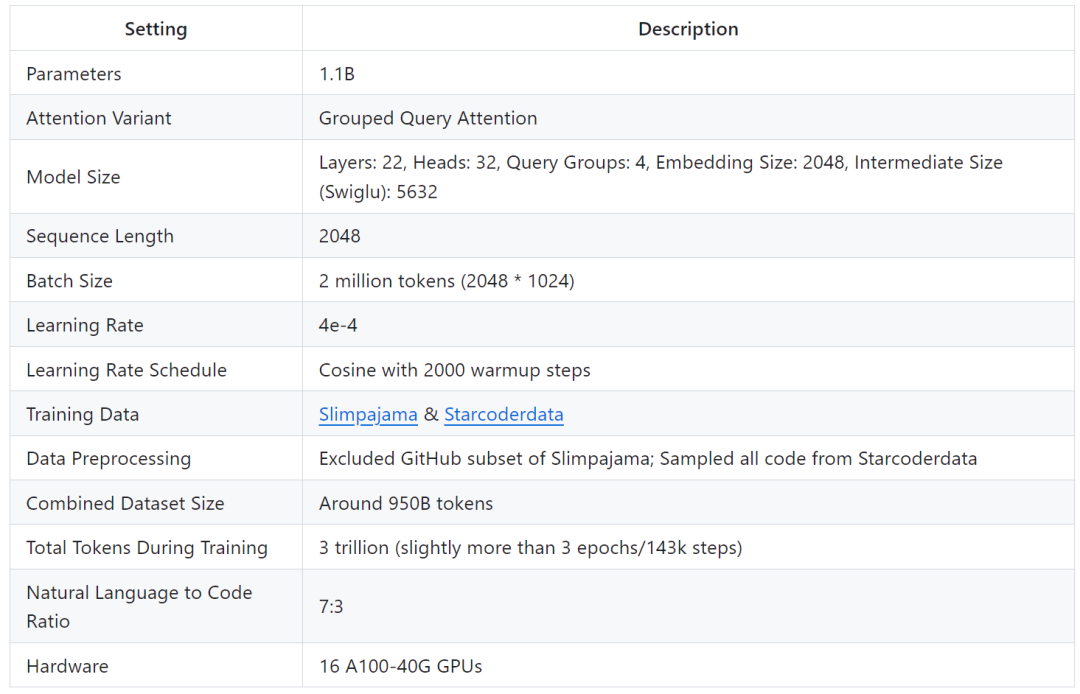

Para penyelidik di Universiti Teknologi dan Reka Bentuk Singapura (SUTD) baru-baru ini mengeluarkan TinyLlama, model bahasa dengan 1.1 bilion parameter yang telah dilatih pada kira-kira 3 trilion kereta api.

- Alamat kertas: https://arxiv.org/pdf/2401.02385.pdf

- Alamat projek: https://jzhubhang README_zh-CN.md

TinyLlama adalah berdasarkan seni bina dan tokenizer Llama 2, yang menjadikannya mudah untuk disepadukan dengan banyak projek sumber terbuka menggunakan Llama. Selain itu, TinyLlama hanya mempunyai 1.1 bilion parameter dan bersaiz kecil, menjadikannya sesuai untuk aplikasi yang memerlukan pengiraan terhad dan jejak memori.

Kajian menunjukkan bahawa hanya 16 GPU A100-40G boleh melengkapkan latihan TinyLlama dalam masa 90 hari.

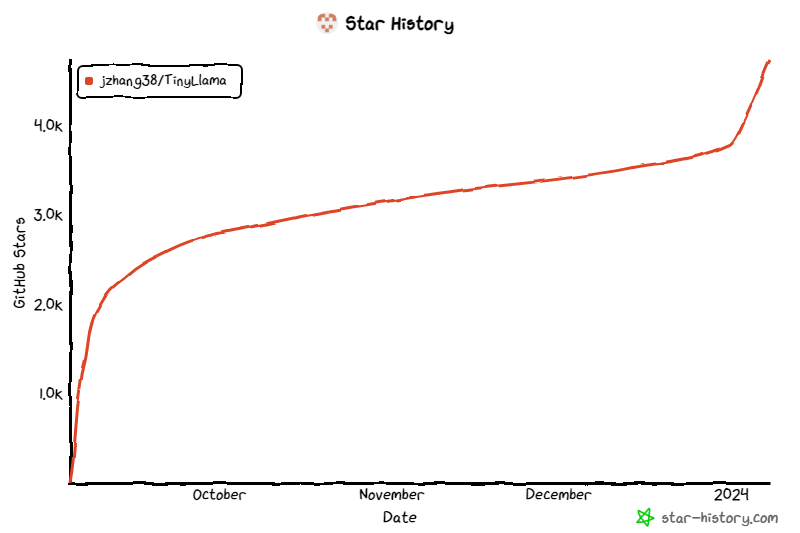

Projek ini terus mendapat perhatian sejak dilancarkan, dan bilangan bintang semasa mencecah 4.7K.

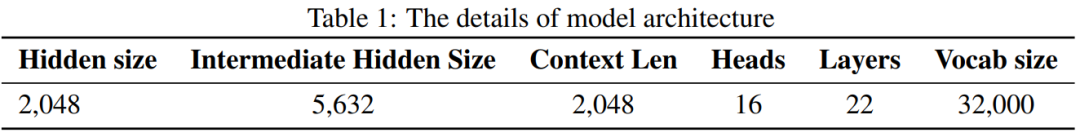

Perincian seni bina model TinyLlama adalah seperti berikut:

Butiran latihan adalah seperti berikut:

yang penyelidik mengatakan ini bertujuan untuk melombong penggunaan yang lebih besar data Potensi untuk melatih model yang lebih kecil. Mereka menumpukan pada meneroka gelagat model yang lebih kecil apabila dilatih dengan bilangan token yang jauh lebih besar daripada yang disyorkan oleh undang-undang penskalaan.

Walaupun saiznya agak kecil, TinyLlama berprestasi agak baik pada pelbagai tugas hiliran, dengan ketara mengatasi model bahasa sumber terbuka sedia ada dengan saiz yang sama. Khususnya, TinyLlama mengatasi prestasi OPT-1.3B dan Pythia1.4B dalam pelbagai tugas hiliran.

Selain itu, TinyLlama juga menggunakan pelbagai kaedah pengoptimuman, seperti flash attention 2, FSDP (Fully Sharded Data Parallel), xFormers, dll.

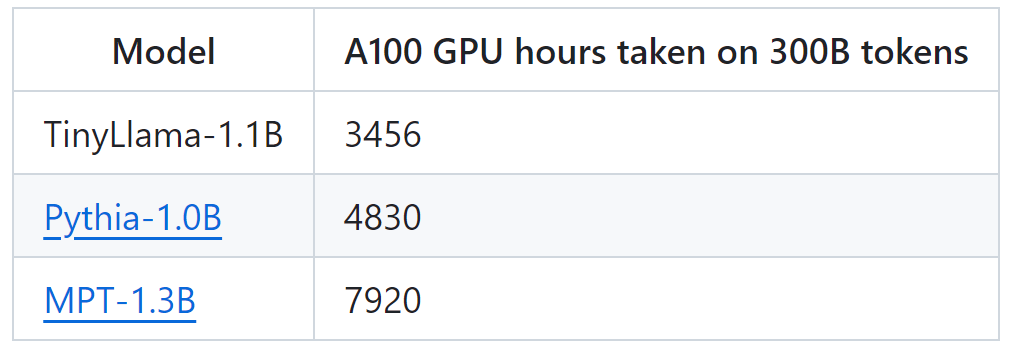

Dengan sokongan teknologi ini, daya tampung latihan TinyLlama mencapai 24,000 token sesaat setiap GPU A100-40G. Contohnya, model TinyLlama-1.1B hanya memerlukan 3,456 jam GPU A100 untuk token 300B, berbanding 4,830 jam untuk Pythia dan 7,920 jam untuk MPT. Ini menunjukkan keberkesanan pengoptimuman kajian ini dan potensi untuk menjimatkan masa dan sumber yang ketara dalam latihan model berskala besar.

TinyLlama mencapai kelajuan latihan 24k token/saat/A100 Kelajuan ini bersamaan dengan model chinchilla-optimum dengan 1.1 bilion parameter dan 22 bilion token yang boleh dilatih oleh pengguna dalam 32 jam pada 8 A100. Pada masa yang sama, pengoptimuman ini juga sangat mengurangkan penggunaan memori. Pengguna boleh memasukkan model parameter 1.1 bilion ke dalam GPU 40GB sambil mengekalkan saiz kumpulan per-gpu sebanyak 16k token. Cuma tukar saiz kelompok sedikit lebih kecil, dan anda boleh melatih TinyLlama pada RTX 3090/4090.

Dalam eksperimen, penyelidikan ini tertumpu terutamanya pada model bahasa dengan seni bina penyahkod tulen, yang mengandungi kira-kira 1 bilion parameter. Secara khusus, kajian itu membandingkan TinyLlama dengan OPT-1.3B, Pythia-1.0B dan Pythia-1.4B.

Dalam eksperimen, penyelidikan ini tertumpu terutamanya pada model bahasa dengan seni bina penyahkod tulen, yang mengandungi kira-kira 1 bilion parameter. Secara khusus, kajian itu membandingkan TinyLlama dengan OPT-1.3B, Pythia-1.0B dan Pythia-1.4B.

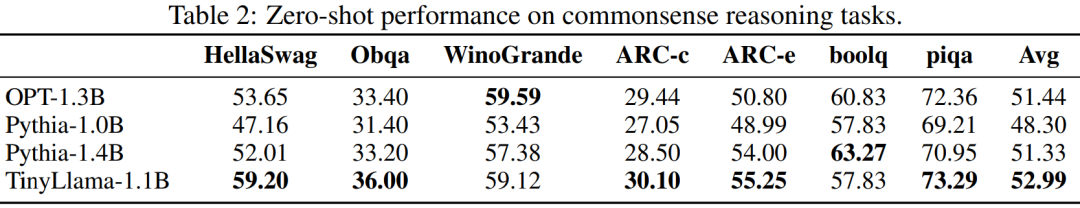

Prestasi TinyLlama pada tugas penaakulan akal ditunjukkan di bawah. Dapat dilihat bahawa TinyLlama mengatasi garis dasar pada banyak tugas dan memperoleh skor purata tertinggi.

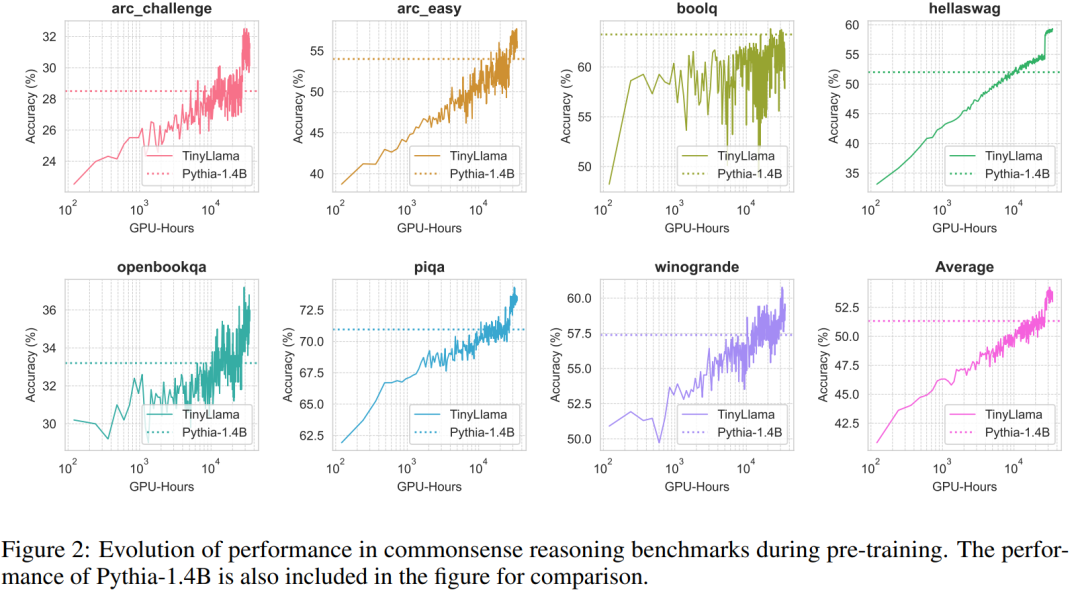

Di samping itu, para penyelidik menjejaki ketepatan TinyLlama pada tanda aras penaakulan akal semasa pra-latihan Seperti yang ditunjukkan dalam Rajah 2, prestasi TinyLlama bertambah baik dengan peningkatan dalam sumber pengkomputeran, dalam kebanyakan tanda aras Exce. ketepatan Pythia-1.4B.

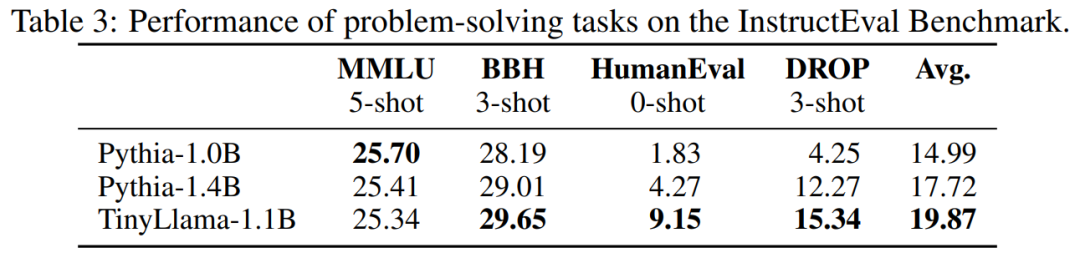

Jadual 3 menunjukkan bahawa TinyLlama mempamerkan keupayaan menyelesaikan masalah yang lebih baik berbanding model sedia ada. .

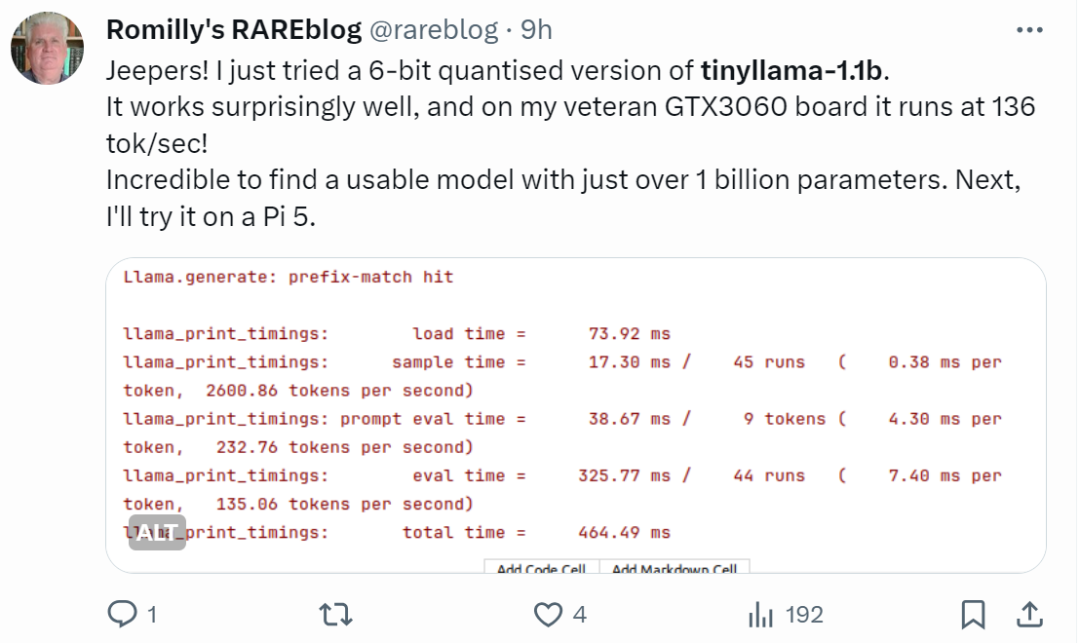

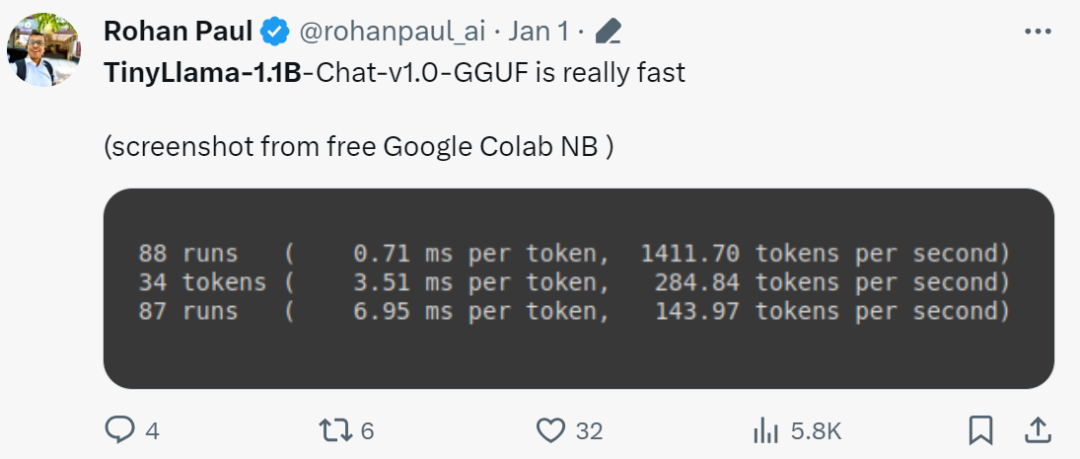

"Ia benar-benar pantas!"

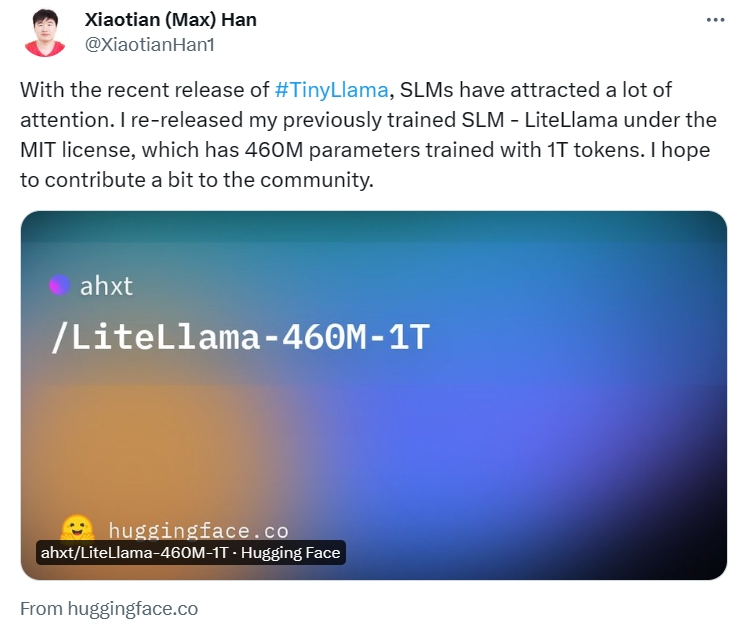

Model Kecil LiteLlama

Bahasa

sebarkan perhatian. Xiaotian Han dari Texas Tech dan A&M University mengeluarkan SLM-LiteLlama. Ia mempunyai parameter 460M dan dilatih dengan token 1T. Ini ialah garpu sumber terbuka LLaMa 2 Meta AI, tetapi dengan saiz model yang jauh lebih kecil.

Alamat projek: https://huggingface.co/ahxt/LiteLlama-460M-1T

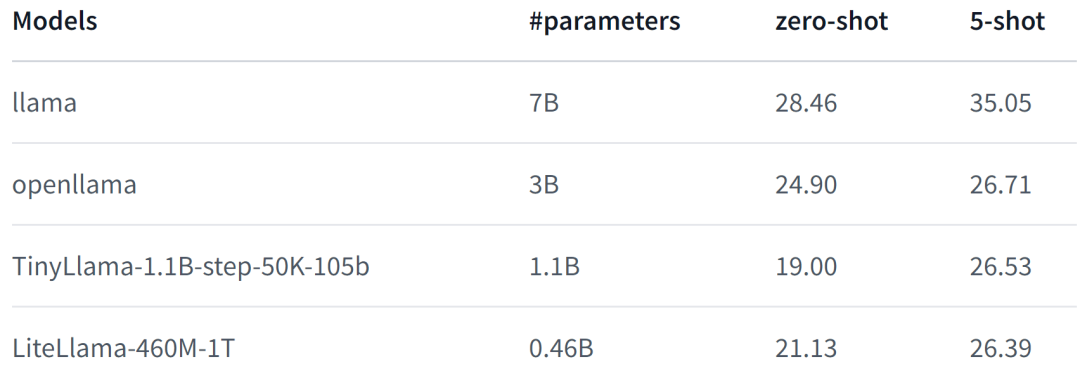

LiteLlama-460M-1T dilatih pada set data RedPajama2 untuk mengguna pakai set data GPTkena2 dan teks Penulis menilai model pada tugas MMLU, dan hasilnya ditunjukkan dalam rajah di bawah Walaupun dengan pengurangan ketara dalam bilangan parameter, LiteLlama-460M-1T masih boleh mencapai hasil yang setanding atau lebih baik daripada model lain. .

Menghadapi skala LiteLlama telah banyak dikurangkan, dan sesetengah netizen ingin tahu sama ada ia boleh dijalankan pada memori 4GB. Kalau nak tahu juga, apa kata cuba sendiri.

Atas ialah kandungan terperinci Model kecil tetapi hebat semakin meningkat: TinyLlama dan LiteLlama menjadi pilihan popular. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1379

1379

52

52

Petua Konfigurasi Firewall Pelayan Mel Debian

Apr 13, 2025 am 11:42 AM

Petua Konfigurasi Firewall Pelayan Mel Debian

Apr 13, 2025 am 11:42 AM

Mengkonfigurasi firewall pelayan Mail Debian adalah langkah penting dalam memastikan keselamatan pelayan. Berikut adalah beberapa kaedah konfigurasi firewall yang biasa digunakan, termasuk penggunaan iptables dan firewalld. Gunakan iptables untuk mengkonfigurasi firewall untuk memasang iptables (jika belum dipasang): sudoapt-getupdateudoapt-getinstalliplesview peraturan iptables semasa: konfigurasi sudoiptable-l

Cara Menetapkan Tahap Log Debian Apache

Apr 13, 2025 am 08:33 AM

Cara Menetapkan Tahap Log Debian Apache

Apr 13, 2025 am 08:33 AM

Artikel ini menerangkan cara menyesuaikan tahap pembalakan pelayan Apacheweb dalam sistem Debian. Dengan mengubah suai fail konfigurasi, anda boleh mengawal tahap maklumat log yang direkodkan oleh Apache. Kaedah 1: Ubah suai fail konfigurasi utama untuk mencari fail konfigurasi: Fail konfigurasi apache2.x biasanya terletak di direktori/etc/apache2/direktori. Nama fail mungkin apache2.conf atau httpd.conf, bergantung pada kaedah pemasangan anda. Edit Fail Konfigurasi: Buka Fail Konfigurasi dengan Kebenaran Root Menggunakan Editor Teks (seperti Nano): Sudonano/ETC/APACHE2/APACHE2.CONF

Bagaimana Debian Readdir Bersepadu Dengan Alat Lain

Apr 13, 2025 am 09:42 AM

Bagaimana Debian Readdir Bersepadu Dengan Alat Lain

Apr 13, 2025 am 09:42 AM

Fungsi Readdir dalam sistem Debian adalah panggilan sistem yang digunakan untuk membaca kandungan direktori dan sering digunakan dalam pengaturcaraan C. Artikel ini akan menerangkan cara mengintegrasikan Readdir dengan alat lain untuk meningkatkan fungsinya. Kaedah 1: Menggabungkan Program Bahasa C dan Pipeline Pertama, tulis program C untuk memanggil fungsi Readdir dan output hasilnya:#termasuk#termasuk#includeintMain (intargc, char*argv []) {dir*dir; structdirent*entry; if (argc! = 2) {

Cara Mengoptimumkan Prestasi Debian Readdir

Apr 13, 2025 am 08:48 AM

Cara Mengoptimumkan Prestasi Debian Readdir

Apr 13, 2025 am 08:48 AM

Dalam sistem Debian, panggilan sistem Readdir digunakan untuk membaca kandungan direktori. Jika prestasinya tidak baik, cuba strategi pengoptimuman berikut: Memudahkan bilangan fail direktori: Split direktori besar ke dalam pelbagai direktori kecil sebanyak mungkin, mengurangkan bilangan item yang diproses setiap panggilan readdir. Dayakan Caching Kandungan Direktori: Bina mekanisme cache, kemas kini cache secara teratur atau apabila kandungan direktori berubah, dan mengurangkan panggilan kerap ke Readdir. Cafh memori (seperti memcached atau redis) atau cache tempatan (seperti fail atau pangkalan data) boleh dipertimbangkan. Mengamalkan struktur data yang cekap: Sekiranya anda melaksanakan traversal direktori sendiri, pilih struktur data yang lebih cekap (seperti jadual hash dan bukannya carian linear) untuk menyimpan dan mengakses maklumat direktori

Kaedah pemasangan sijil SSL Server Server Debian

Apr 13, 2025 am 11:39 AM

Kaedah pemasangan sijil SSL Server Server Debian

Apr 13, 2025 am 11:39 AM

Langkah -langkah untuk memasang sijil SSL pada pelayan mel Debian adalah seperti berikut: 1. Pasang OpenSSL Toolkit terlebih dahulu, pastikan bahawa OpenSSL Toolkit telah dipasang pada sistem anda. Jika tidak dipasang, anda boleh menggunakan arahan berikut untuk memasang: sudoapt-getupdateudoapt-getinstallopenssl2. Menjana permintaan kunci dan sijil peribadi seterusnya, gunakan OpenSSL untuk menjana kunci peribadi RSA 2048-bit dan permintaan sijil (CSR): Membuka

Cara Melaksanakan Penyortiran Fail oleh Debian Readdir

Apr 13, 2025 am 09:06 AM

Cara Melaksanakan Penyortiran Fail oleh Debian Readdir

Apr 13, 2025 am 09:06 AM

Dalam sistem Debian, fungsi Readdir digunakan untuk membaca kandungan direktori, tetapi urutan yang dikembalikannya tidak ditentukan sebelumnya. Untuk menyusun fail dalam direktori, anda perlu membaca semua fail terlebih dahulu, dan kemudian menyusunnya menggunakan fungsi QSORT. Kod berikut menunjukkan cara menyusun fail direktori menggunakan ReadDir dan QSORT dalam sistem Debian:#termasuk#termasuk#termasuk#termasuk // fungsi perbandingan adat, yang digunakan untuk qSortintCompare (Constvoid*A, Constvoid*b) {Returnstrcmp (*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(

Cara Melakukan Pengesahan Tandatangan Digital dengan Debian Openssl

Apr 13, 2025 am 11:09 AM

Cara Melakukan Pengesahan Tandatangan Digital dengan Debian Openssl

Apr 13, 2025 am 11:09 AM

Menggunakan OpenSSL untuk Pengesahan Tandatangan Digital pada Sistem Debian, anda boleh mengikuti langkah -langkah berikut: Penyediaan untuk memasang OpenSSL: Pastikan sistem Debian anda telah dipasang. Jika tidak dipasang, anda boleh menggunakan arahan berikut untuk memasangnya: sudoaptdateudoaptininstallopenssl untuk mendapatkan kunci awam: Pengesahan tandatangan digital memerlukan kunci awam penandatangan. Biasanya, kunci awam akan disediakan dalam bentuk fail, seperti public_key.pe

Bagaimana Debian OpenSSL Menghalang Serangan Man-dalam-Middle

Apr 13, 2025 am 10:30 AM

Bagaimana Debian OpenSSL Menghalang Serangan Man-dalam-Middle

Apr 13, 2025 am 10:30 AM

Dalam sistem Debian, OpenSSL adalah perpustakaan penting untuk pengurusan penyulitan, penyahsulitan dan sijil. Untuk mengelakkan serangan lelaki-dalam-pertengahan (MITM), langkah-langkah berikut boleh diambil: Gunakan HTTPS: Pastikan semua permintaan rangkaian menggunakan protokol HTTPS dan bukannya HTTP. HTTPS menggunakan TLS (Protokol Keselamatan Lapisan Pengangkutan) untuk menyulitkan data komunikasi untuk memastikan data tidak dicuri atau diganggu semasa penghantaran. Sahkan Sijil Pelayan: Sahkan secara manual Sijil Pelayan pada klien untuk memastikan ia boleh dipercayai. Pelayan boleh disahkan secara manual melalui kaedah perwakilan urlSession