Peranti teknologi

Peranti teknologi

AI

AI

HuggingFace: Dua alpaka disambung bersama selepas mengeluarkan kepala dan ekornya

HuggingFace: Dua alpaka disambung bersama selepas mengeluarkan kepala dan ekornya

HuggingFace: Dua alpaka disambung bersama selepas mengeluarkan kepala dan ekornya

Jan 15, 2024 pm 09:09 PMSenarai kedudukan model besar sumber terbuka HuggingFace telah dihapuskan lagi.

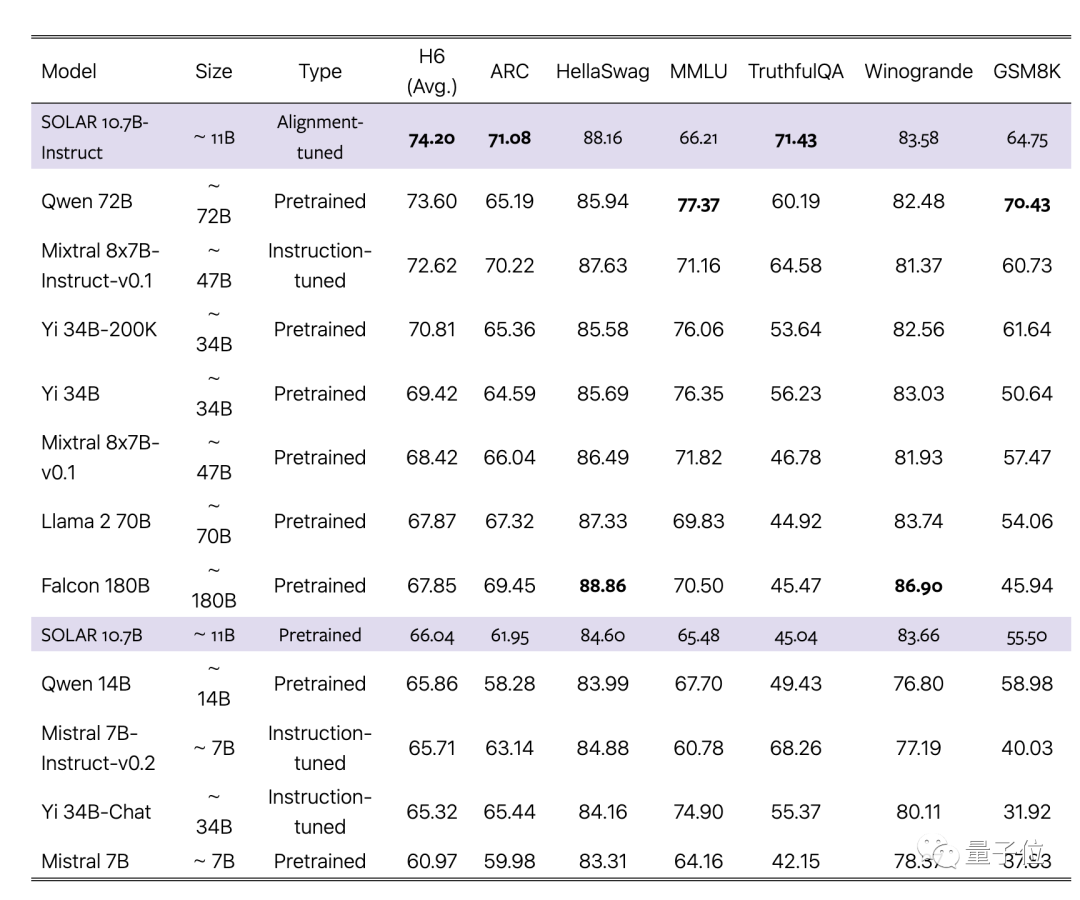

Barisan hadapan diduduki secara eksklusif oleh versi SOLAR 10.7B yang ditala halus, memerah pelbagai versi yang ditala halus Mixtral 8x7B dari beberapa minggu yang lalu.

Apakah asal usul model SOLAR yang besar?

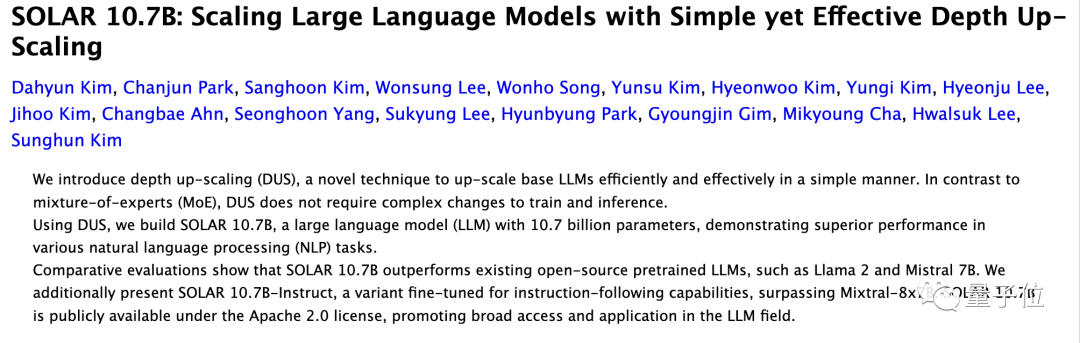

Kertas berkaitan baru sahaja dimuat naik ke ArXiv, daripada syarikat Korea Upstage AI, menggunakan kaedah pengembangan model besar baharu penskalaan kedalaman (DUS).

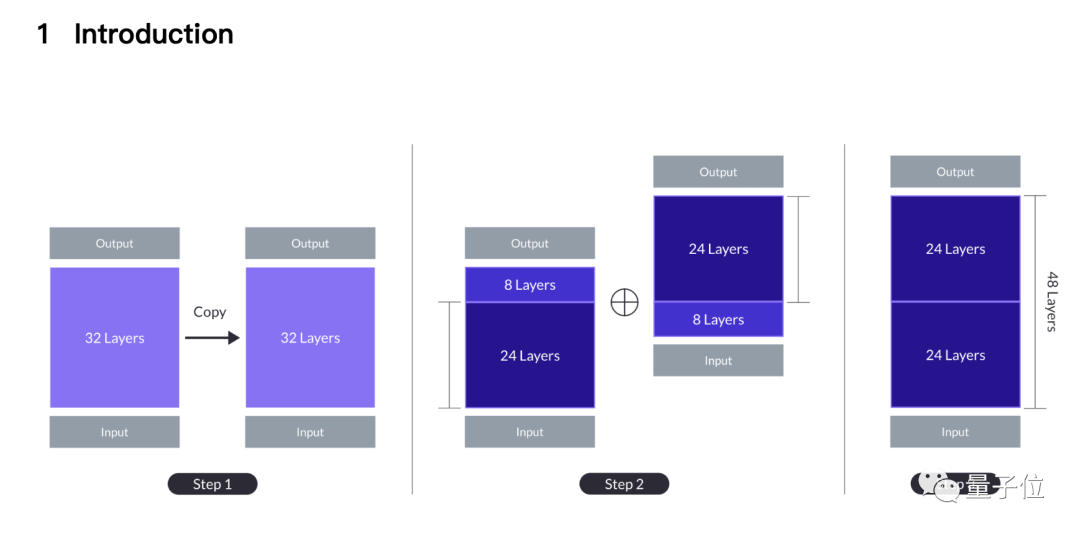

Ringkasnya, dua alpaka 7B dicubit dan ekornya, satu dipotong 8 lapisan pertama, dan satu lagi dipotong 8 lapisan terakhir.

Baki dua 24 lapisan dicantum bersama Lapisan ke-24 model pertama disambung dengan lapisan ke-9 model kedua, dan akhirnya menjadi model besar 48-lapisan 10.7B.

Makalah itu mendakwa bahawa kaedah baharu itu mengatasi kaedah sambungan tradisional seperti MoE, dan boleh menggunakan infrastruktur yang sama seperti model besar asas.

Tidak perlu modul tambahan seperti rangkaian berpagar, rangka kerja latihan dioptimumkan untuk KPM, dan tidak perlu menyesuaikan isirong CUDA untuk inferens pantas Ia boleh disepadukan dengan lancar ke dalam kaedah sedia ada sambil mengekalkan kecekapan.

Pasukan memilih Mistral 7B, model besar tunggal terkuat 7B, sebagai bahan asas, dan menggunakan kaedah baharu untuk menggabungkannya untuk mengatasi versi asal dan versi MoE.

Pada masa yang sama, versi Arahan sejajar juga mengatasi versi Arahan KPM yang sepadan.

Lakukan jahitan hingga habis

Kenapa kaedah penyambungan ini datang dari gerak hati.

Mulakan dengan kaedah pengembangan yang paling mudah, iaitu mengulang model besar asas 32 lapisan dua kali menjadi 64 lapisan.

Kelebihan ini ialah tiada heterogen, semua lapisan adalah dari model besar asas, tetapi lapisan 32 dan 33 (sama seperti lapisan 1) mempunyai lapisan " yang lebih besar di kelim Jarak”(jarak lapisan ).

Penyelidikan sebelum ini telah menunjukkan bahawa lapisan Transformer yang berbeza melakukan perkara yang berbeza Contohnya, lapisan yang lebih dalam adalah lebih baik dalam memproses konsep yang lebih abstrak.

Pasukan percaya bahawa jarak lapisan yang berlebihan boleh menghalang keupayaan model untuk menggunakan pemberat pra-latihan dengan berkesan.

Satu penyelesaian yang berpotensi adalah dengan mengorbankan lapisan tengah, dengan itu mengurangkan perbezaan pada jahitan, dan di sinilah kaedah DUS dilahirkan.

Berdasarkan pertukaran antara prestasi dan saiz model, pasukan memilih untuk memadam 8 lapisan daripada setiap model, dan jahitan ditukar daripada 32 lapisan kepada lapisan 1 kepada 24 lapisan kepada lapisan 9.

Prestasi model yang disambung ringkas akan tetap lebih rendah daripada model asas asal pada mulanya, tetapi ia boleh pulih dengan cepat selepas latihan pra berterusan.

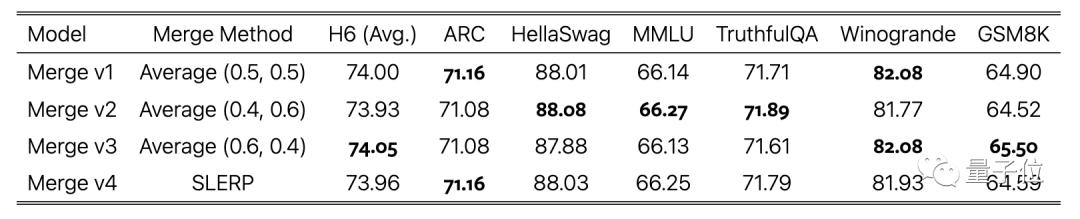

Dalam fasa penalaan halus arahan, selain menggunakan set data sumber terbuka, kami juga mencipta set data yang dipertingkatkan secara matematik dan menggunakan DPO dalam fasa penjajaran.

Langkah terakhir ialah menimbang purata versi model yang dilatih menggunakan set data yang berbeza, yang juga merupakan penyiapan jahitan.

Sesetengah netizen mempersoalkan kemungkinan kebocoran data ujian. Pasukan

juga mengambil kira perkara ini dan secara khusus melaporkan keputusan ujian pencemaran data dalam lampiran kertas, yang menunjukkan tahap rendah.

Akhir sekali, kedua-dua model asas SOLAR 10.7B dan model yang diperhalusi adalah sumber terbuka di bawah lesen Apache 2.0.

Netizen yang telah mencubanya telah melaporkan bahawa ia berfungsi dengan baik dalam mengekstrak data daripada data format JSON.

Alamat kertas: https://arxiv.org/abs/2312.15166

Atas ialah kandungan terperinci HuggingFace: Dua alpaka disambung bersama selepas mengeluarkan kepala dan ekornya. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel Panas

Alat panas Tag

Artikel Panas

Tag artikel panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

Di belakang akses Android pertama ke DeepSeek: Melihat Kekuatan Wanita

Mar 12, 2025 pm 12:27 PM

Di belakang akses Android pertama ke DeepSeek: Melihat Kekuatan Wanita

Mar 12, 2025 pm 12:27 PM

Di belakang akses Android pertama ke DeepSeek: Melihat Kekuatan Wanita

Cara menyelesaikan masalah pelayan yang sibuk untuk DeepSeek

Mar 12, 2025 pm 01:39 PM

Cara menyelesaikan masalah pelayan yang sibuk untuk DeepSeek

Mar 12, 2025 pm 01:39 PM

Cara menyelesaikan masalah pelayan yang sibuk untuk DeepSeek

Pintu Laman Web Rasmi DeepSeek yang mendalam

Mar 12, 2025 pm 01:33 PM

Pintu Laman Web Rasmi DeepSeek yang mendalam

Mar 12, 2025 pm 01:33 PM

Pintu Laman Web Rasmi DeepSeek yang mendalam

Midea melancarkan penghawa dingin DeepSeek yang pertama: Interaksi Suara AI boleh mencapai 400,000 arahan!

Mar 12, 2025 pm 12:18 PM

Midea melancarkan penghawa dingin DeepSeek yang pertama: Interaksi Suara AI boleh mencapai 400,000 arahan!

Mar 12, 2025 pm 12:18 PM

Midea melancarkan penghawa dingin DeepSeek yang pertama: Interaksi Suara AI boleh mencapai 400,000 arahan!

Satu lagi produk kebangsaan dari Baidu disambungkan ke Deepseek.

Mar 12, 2025 pm 01:48 PM

Satu lagi produk kebangsaan dari Baidu disambungkan ke Deepseek.

Mar 12, 2025 pm 01:48 PM

Satu lagi produk kebangsaan dari Baidu disambungkan ke Deepseek.

Top 10 Disyorkan untuk App Perdagangan Aset Digital Crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Top 10 Disyorkan untuk App Perdagangan Aset Digital Crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Top 10 Disyorkan untuk App Perdagangan Aset Digital Crypto (2025 Global Ranking)

10 platform perdagangan cryptocurrency teratas, sepuluh aplikasi platform perdagangan mata wang yang disyorkan

Mar 17, 2025 pm 06:03 PM

10 platform perdagangan cryptocurrency teratas, sepuluh aplikasi platform perdagangan mata wang yang disyorkan

Mar 17, 2025 pm 06:03 PM

10 platform perdagangan cryptocurrency teratas, sepuluh aplikasi platform perdagangan mata wang yang disyorkan