Google baru-baru ini melancarkan set data latihan model yang dipanggil TpuGraphs, yang digunakan terutamanya untuk mengoptimumkan penyusun dan meningkatkan keupayaan pembelajaran mendalam kecerdasan buatan

▲ Sumber imej Google Blog (sama di bawah)

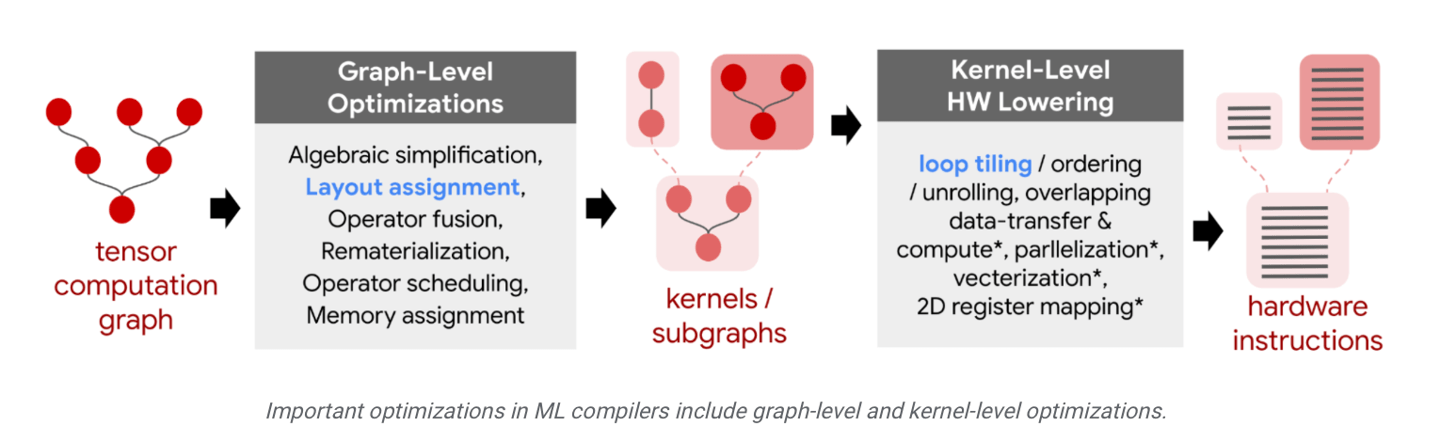

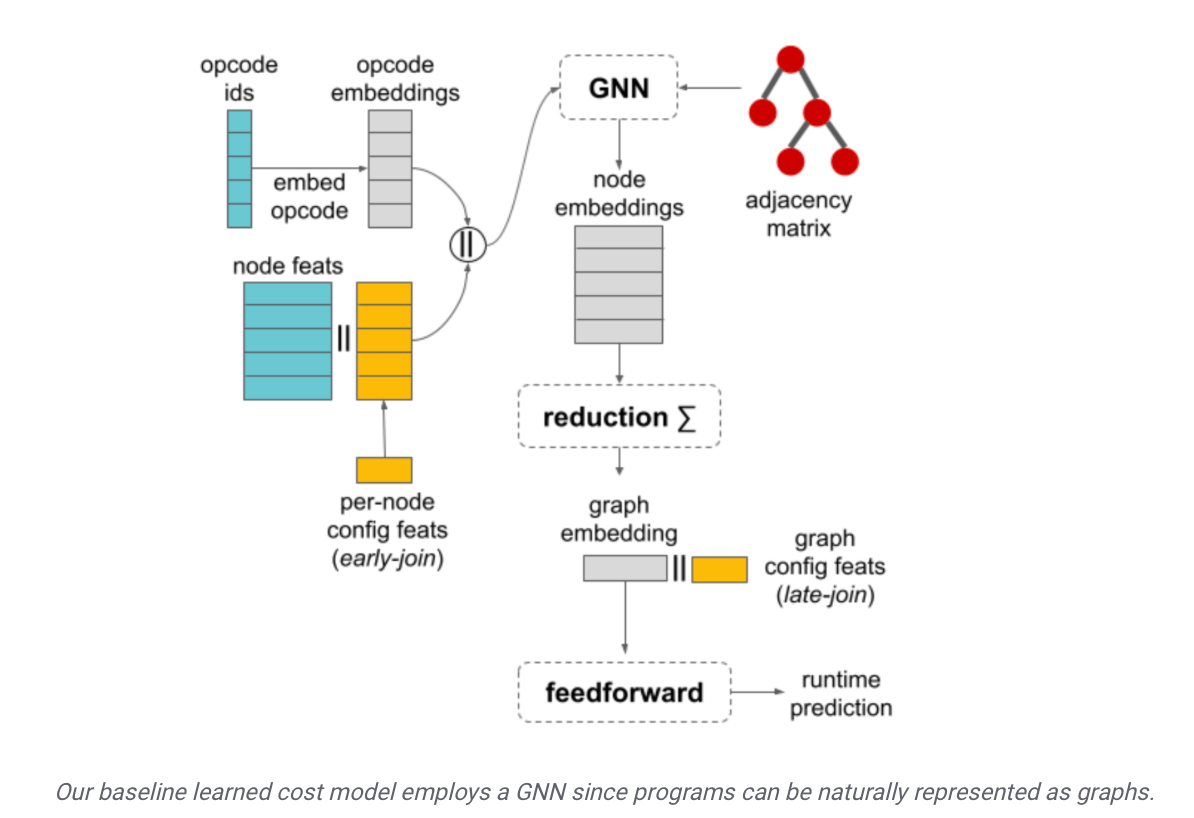

Google menegaskan bahawa sistem pembelajaran mendalam AI semasa biasanya menggunakan TensorFlow, JAX, PyTorch dan rangka kerja lain untuk latihan. Rangka kerja ini terutamanya mengoptimumkan model melalui heuristik pengkompil asas. Mengaplikasikan "model kos pembelajaran" dalam pengkompil yang berkaitan boleh meningkatkan prestasi pengkompil dan meningkatkan keupayaan pembelajaran mendalam bagi model keluaran akhir

Set data TpuGraphs yang dilancarkan oleh Google telah diketahui oleh IT House bahawa ia adalah "model kos pembelajaran". Set data ini terutamanya mengandungi pelbagai program pembelajaran dalam sumber terbuka, meliputi pelbagai seni bina model popular, seperti ResNet, EfficientNet, Mask R-CNN dan Transformer, dll.

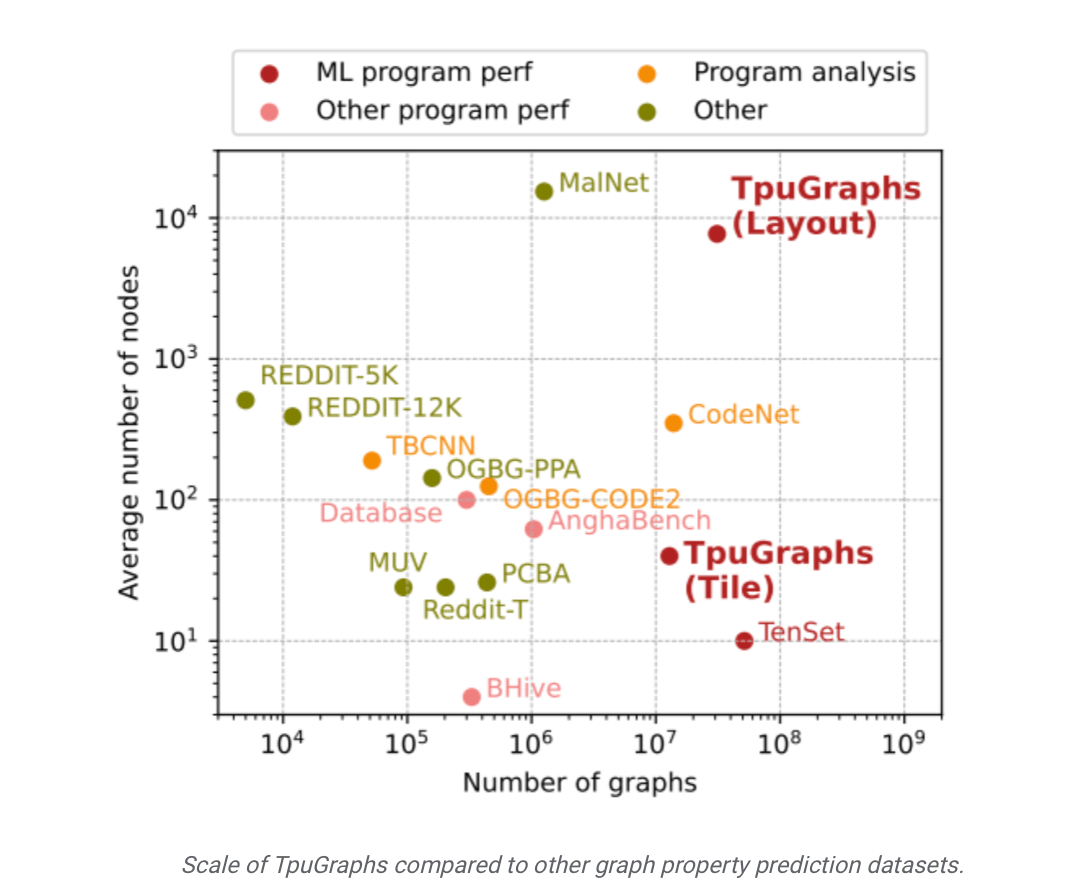

Google mendakwa bahawa berbanding pesaing industri, set data TpuGraphs Google adalah 770 kali lebih besar dari segi "purata saiz graf" dan 25 kali lebih besar dari segi "bilangan graf". Google mendakwa bahawa menggunakan set data TpuGraphs boleh menyelesaikan masalah "skala", "kecekapan" dan "kualiti" model keluaran akhir dengan berkesan

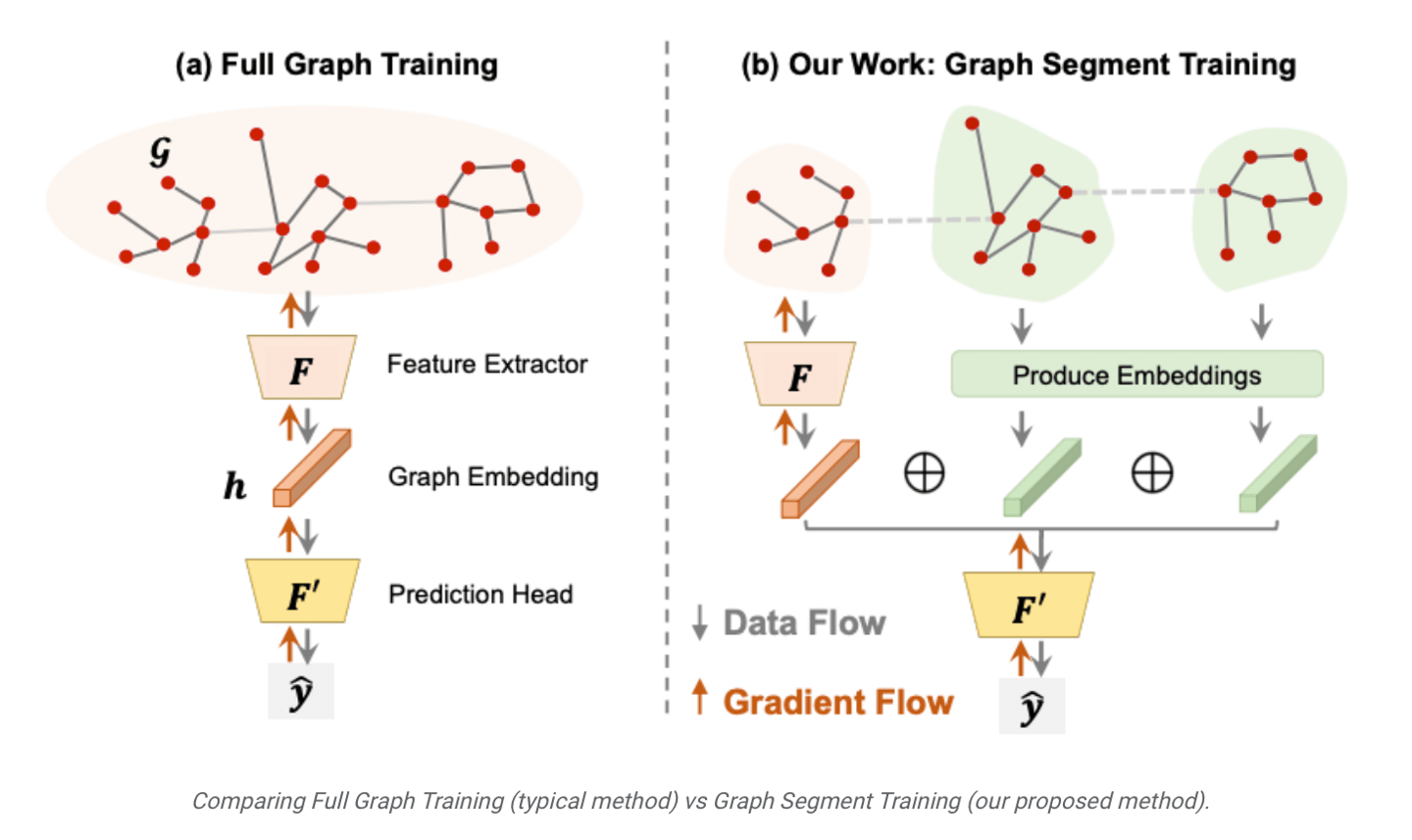

Selain itu, Google juga telah melancarkan kaedah latihan model yang dipanggil GST (Graph Segment Training), yang membolehkan latihan rangkaian saraf graf besar pada peranti dengan memori terhad. Dikatakan kaedah ini boleh memendekkan "masa latihan hujung ke hujung" model sebanyak tiga kali ganda dan berkesan meningkatkan kecekapan latihan model

Atas ialah kandungan terperinci Google melancarkan set data latihan TpuGraphs untuk meningkatkan keupayaan pembelajaran mendalam model AI. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!