Lightning Attention-2 ialah mekanisme perhatian linear baharu yang menjadikan kos latihan dan inferens bagi jujukan panjang konsisten dengan panjang jujukan 1K.

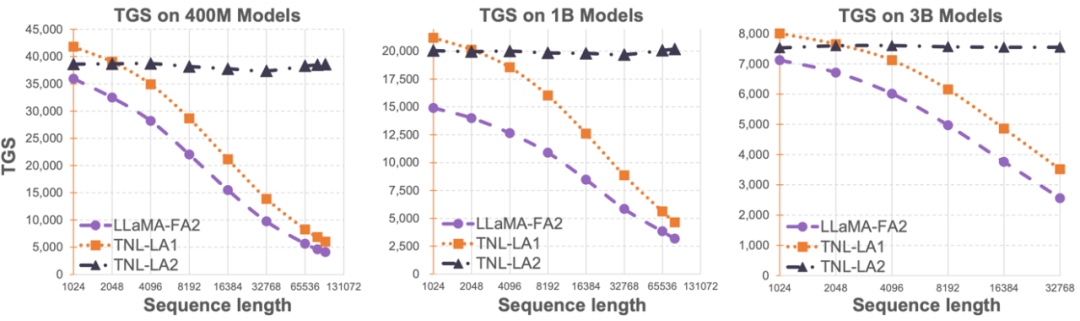

Penghadan panjang jujukan model bahasa besar telah menyekat penggunaannya dalam bidang kecerdasan buatan, seperti dialog berbilang pusingan, pemahaman teks panjang, pemprosesan dan penjanaan data berbilang modal, dsb. Sebab asas untuk had ini ialah seni bina Transformer yang digunakan dalam model bahasa besar semasa mempunyai kerumitan pengiraan kuadratik berbanding dengan panjang jujukan. Ini bermakna apabila panjang jujukan bertambah, sumber pengkomputeran yang diperlukan meningkat secara eksponen. Cara memproses urutan panjang dengan cekap sentiasa menjadi salah satu cabaran model bahasa yang besar. Kaedah sebelumnya cenderung memfokuskan pada cara menyesuaikan model bahasa besar kepada urutan yang lebih panjang dalam peringkat inferens. Sebagai contoh, Alibi atau kaedah pengekodan kedudukan relatif yang serupa boleh digunakan untuk menyesuaikan model kepada panjang jujukan input yang berbeza, atau kaedah pengekodan kedudukan relatif yang serupa seperti RoPE boleh digunakan untuk melakukan perbezaan, dan latihan lanjut boleh dilakukan pada model yang mempunyai latihan yang telah selesai. Penalaan halus jangka pendek dilakukan untuk mencapai tujuan untuk menguatkan panjang jujukan. Kaedah ini hanya membenarkan model besar mempunyai keupayaan pemodelan jujukan panjang tertentu, tetapi latihan sebenar dan overhed inferens tidak dikurangkan. Pasukan OpenNLPLab cuba menyelesaikan masalah urutan panjang model bahasa besar sekali dan untuk semua. Mereka mencadangkan dan sumber terbuka Lightning Attention-2, mekanisme perhatian linear baharu yang menjadikan kos latihan dan inferens bagi jujukan panjang konsisten dengan panjang jujukan 1K. Sebelum menghadapi kesesakan ingatan, meningkatkan panjang jujukan selama-lamanya tidak akan memberi kesan negatif pada kelajuan latihan model. Ini membolehkan pra-latihan panjang tanpa had. Pada masa yang sama, kos inferens teks yang sangat panjang juga konsisten dengan atau bahkan kurang daripada kos Token 1K, yang akan mengurangkan kos inferens model bahasa besar semasa. Seperti yang ditunjukkan dalam rajah di bawah, di bawah saiz model 400M, 1B dan 3B, apabila panjang jujukan meningkat, kelajuan latihan LLaMA yang disokong oleh FlashAttention2 mula berkurangan dengan cepat, tetapi kelajuan TansNormerLLM yang disokong oleh Lightning Attention-2 telah hampir tiada perubahan.  Gambar 1

Gambar 1

- Kertas: Lightning Attention-2: Makan Tengahari Percuma untuk Mengendalikan Panjang Urutan Tanpa Had dalam Model Bahasa Besar

- Alamat kertas: https://arxiv.org/pdf/2401.04658.pdf

alamat sumber:Open https ://github.com/OpenNLPLab/lightning-attention

Lightning Attention-2 Pengenalan

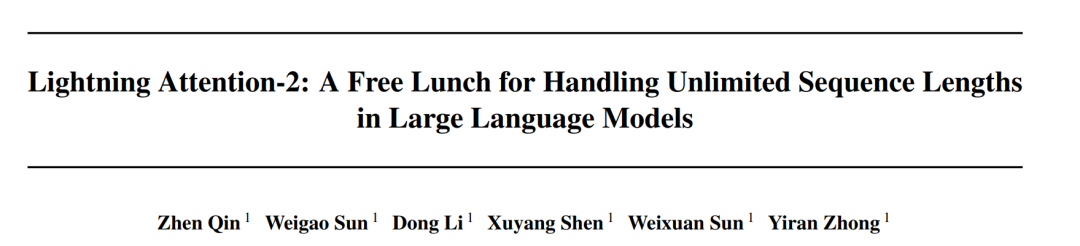

Mengekalkan kelajuan pra-latihan yang konsisten, yang berbeza dari segi kelajuan yang besar pada setiap model ia berbunyi seperti Misi yang mustahil. Malah, ini boleh dicapai jika kerumitan pengiraan mekanisme perhatian kekal linear berkenaan dengan panjang jujukan. Sejak kemunculan perhatian linear [https://arxiv.org/abs/2006.16236] pada tahun 2020, penyelidik telah berusaha keras untuk menjadikan kecekapan sebenar perhatian linear konsisten dengan kerumitan pengiraan linear teorinya. Sebelum 2023, kebanyakan bekerja pada perhatian linear tertumpu pada menjajarkan ketepatannya dengan Transformers. Akhirnya pada pertengahan 2023, mekanisme perhatian linear yang dipertingkatkan [https://arxiv.org/abs/2307.14995] boleh diselaraskan dengan seni bina Transformer yang canggih dalam ketepatan. Walau bagaimanapun, helah pengiraan "daraban kiri kepada pendaraban kanan" yang paling kritikal (ditunjukkan dalam rajah di bawah) yang mengubah kerumitan pengiraan kepada linear dalam perhatian linear (seperti yang ditunjukkan dalam rajah di bawah) adalah lebih perlahan daripada algoritma pendaraban kiri langsung dalam sebenar. pelaksanaan. Sebabnya ialah pelaksanaan pendaraban kanan memerlukan penggunaan penjumlahan kumulatif (cumsum) yang mengandungi sejumlah besar operasi gelung Bilangan besar operasi IO menjadikan kecekapan pendaraban kanan jauh lebih rendah daripada pendaraban kiri.

Untuk lebih memahami idea Lightning Attention-2, mari kita semak semula formula pengiraan softmax tradisional (Q^soft T)⊙ M_) V, dengan Q, K, V, M, O masing-masing adalah pertanyaan, kunci, nilai, topeng dan matriks keluaran M di sini ialah matriks semua-1 segi tiga yang lebih rendah dalam tugasan sehala (seperti GPT). . Dalam dua hala Ia boleh diabaikan dalam tugasan (seperti Bert), iaitu, tiada matriks topeng untuk tugasan dua hala.

Pengarang meringkaskan idea keseluruhan Lightning Attention-2 ke dalam tiga perkara berikut untuk penjelasan:

1 Salah satu idea teras Linear Attention adalah untuk mengeluarkan operator softmax yang mahal secara komputasi, membuat Perhatian Formula pengiraan boleh ditulis sebagai O=((QK^T)⊙M_) V. Walau bagaimanapun, disebabkan kewujudan matriks topeng M dalam tugasan sehala, borang ini masih boleh melakukan pengiraan pendaraban kiri sahaja, jadi kerumitan O (N) tidak dapat diperolehi. Tetapi untuk tugas dua hala, kerana tiada matriks topeng, formula pengiraan Perhatian Linear boleh dipermudahkan lagi kepada O=(QK^T) V. Kehalusan Perhatian Linear ialah dengan hanya menggunakan hukum bersekutu pendaraban matriks, formula pengiraannya boleh diubah lagi menjadi: O=Q (K^T V Borang pengiraan ini dipanggil pendaraban betul, dan bekas yang sepadan ialah Ambil kiri. Daripada Rajah 2, kita secara intuitif dapat memahami bahawa Perhatian Linear boleh mencapai kerumitan O (N) yang menarik dalam tugasan dua arah!

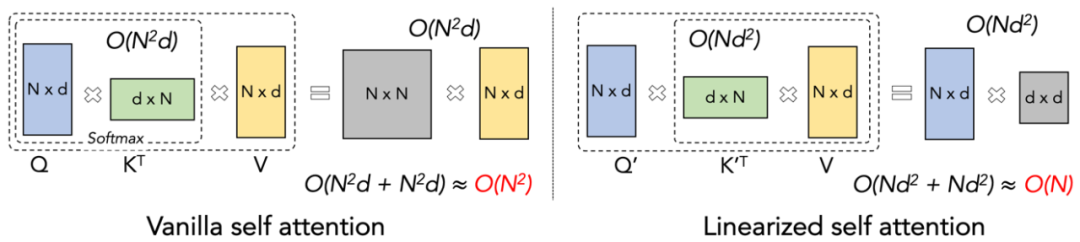

2 Namun, memandangkan model GPT penyahkod sahaja secara beransur-ansur menjadi standard de facto untuk LLM, cara menggunakan ciri pendaraban Linear Attention yang betul untuk mempercepatkan tugasan sehala telah menjadi masalah mendesak untuk diselesaikan. Untuk menyelesaikan masalah ini, penulis artikel ini mencadangkan untuk menggunakan idea "bahagi dan menakluki" untuk membahagikan pengiraan matriks perhatian kepada dua bentuk: matriks pepenjuru dan matriks bukan pepenjuru, dan menggunakan kaedah yang berbeza. cara untuk mengira mereka. Seperti yang ditunjukkan dalam Rajah 3, Linear Attention-2 menggunakan idea Tiling yang biasa digunakan dalam medan komputer untuk membahagikan matriks Q, K, dan V kepada bilangan blok yang sama. Antaranya, pengiraan bongkah itu sendiri (intra-blok) masih mengekalkan kaedah pengiraan pendaraban kiri kerana kewujudan matriks topeng, dengan kerumitan O (N^2 manakala pengiraan bongkah (antara-); blok) tidak mempunyai matriks topeng Dengan kewujudan , anda boleh menggunakan kaedah pengiraan pendaraban yang betul untuk menikmati kerumitan O (N). Selepas kedua-duanya dikira secara berasingan, ia boleh ditambah terus untuk mendapatkan output Perhatian Linear Oi sepadan dengan blok ke-i. Pada masa yang sama, keadaan KV terkumpul melalui cumsum untuk digunakan dalam pengiraan blok seterusnya. Dengan cara ini, kerumitan algoritma bagi keseluruhan Lightning Attention-2 ialah O (N^2) untuk intra-blok dan O (N) untuk Trade-off antara blok. Cara untuk mendapatkan pertukaran yang lebih baik ditentukan oleh saiz blok Tiling.

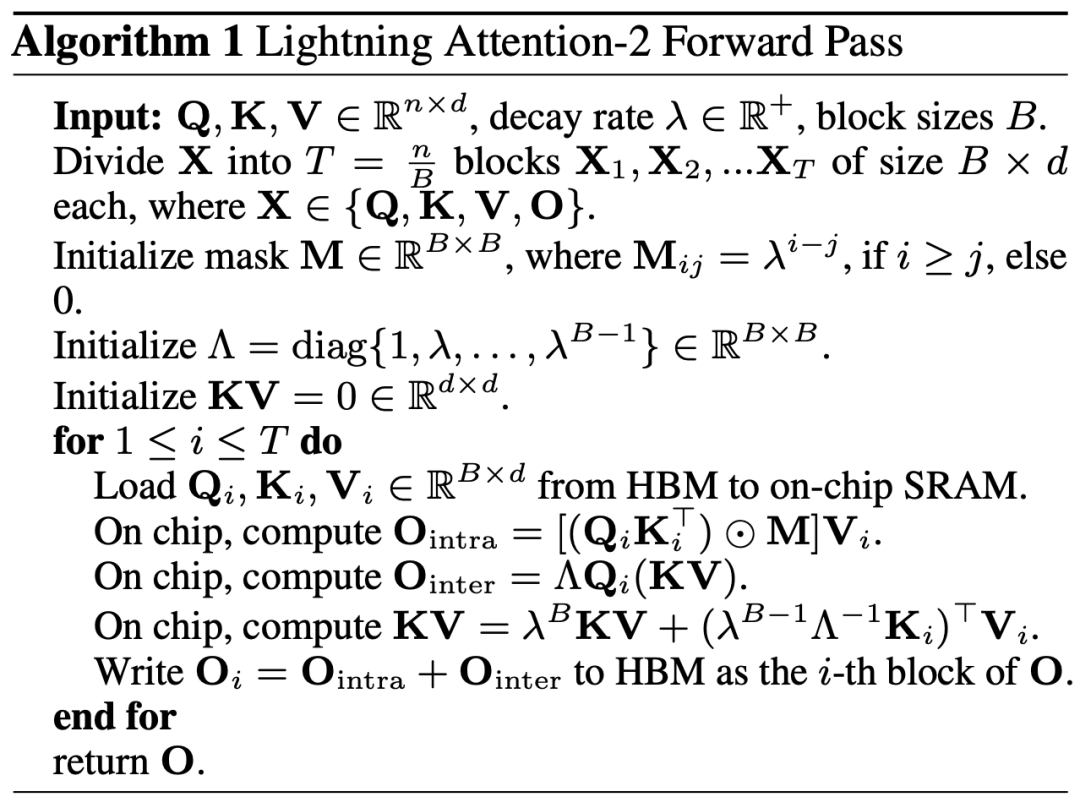

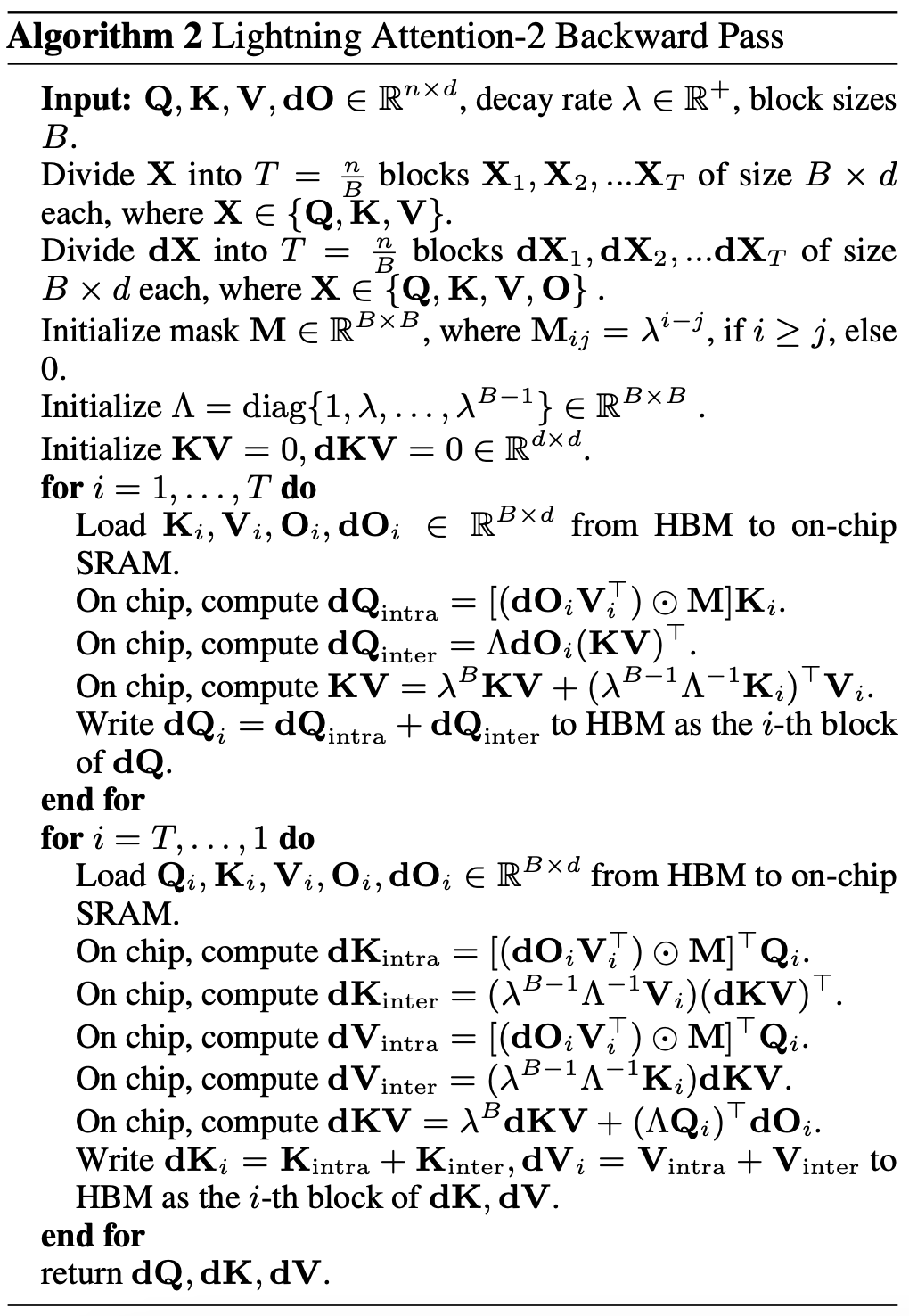

3 Pembaca yang berhati-hati akan mendapati bahawa proses di atas hanyalah bahagian algoritma Lightning Attention-2 Sebab mengapa ia dinamakan Lightning adalah kerana penulis mempertimbangkan sepenuhnya kecekapan proses algoritma dalam pelaksanaan perkakasan GPU. proses. Diilhamkan oleh siri kerja FlashAttention, apabila benar-benar melakukan pengiraan pada GPU, pengarang mengalihkan tensor Q_i, K_i, V_i split daripada HBM yang lebih perlahan dengan kapasiti yang lebih besar di dalam GPU kepada SRAM yang lebih pantas dengan kapasiti yang lebih kecil sistem, dengan itu mengurangkan sejumlah besar overhed IO memori.Selepas blok melengkapkan pengiraan Perhatian Linear, hasil keluarannya O_i akan dialihkan kembali ke HBM. Ulangi proses ini sehingga semua blok telah diproses. Pembaca yang ingin mengetahui butiran lanjut boleh membaca Algoritma 1 dan Algoritma 2 dengan teliti dalam artikel ini, serta proses terbitan terperinci dalam kertas. Kedua-dua Algoritma dan proses derivasi membezakan antara proses hadapan dan belakang Lightning Attention-2, yang boleh membantu pembaca memahami dengan lebih mendalam.

Rajah 3

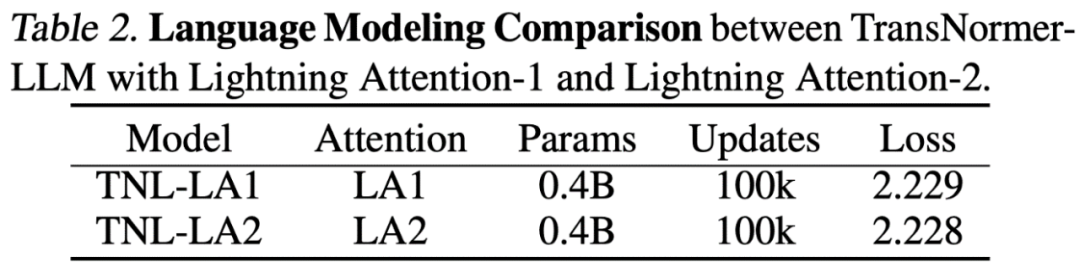

Perbandingan ketepatan Lightning Attention-2 0M) model parameter -2 dengan Kilat Perbezaan ketepatan Perhatian-1, seperti yang ditunjukkan dalam rajah di bawah, adalah hampir sama.

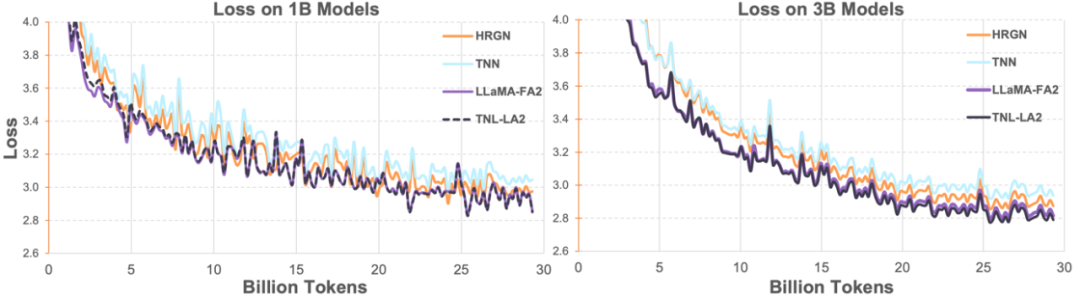

Kemudian penyelidik membandingkan TransNormerLLM (TNL-LA2) yang disokong oleh Lightning Attention-2 dengan rangkaian seni bina bukan Transformer lanjutan lain dan LLaMA yang disokong oleh FlashAttention2 pada 1B dan 3B di bawah korpus yang sama. Seperti yang ditunjukkan dalam rajah di bawah, TNL-LA2 dan LLaMA mengekalkan arah aliran yang sama, dan prestasi kerugian adalah lebih baik. Percubaan ini menunjukkan bahawa Lightning Attention-2 mempunyai prestasi ketepatan yang tidak kalah dengan seni bina Transformer terkini dalam pemodelan bahasa.

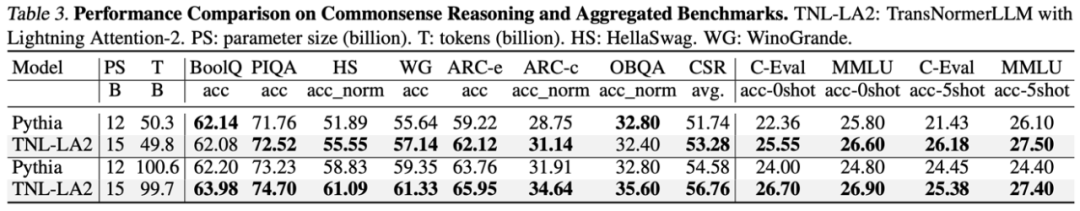

Dalam tugas model bahasa yang besar, penyelidik membandingkan keputusan TNL-LA2 15B dan Pythia pada penanda aras biasa untuk model besar dengan saiz yang serupa. Seperti yang ditunjukkan dalam jadual di bawah, di bawah syarat memakan token yang sama, TNL-LA2 adalah lebih tinggi sedikit daripada model Pythia berdasarkan perhatian Softmax dalam penaakulan akal dan keupayaan komprehensif pelbagai pilihan.

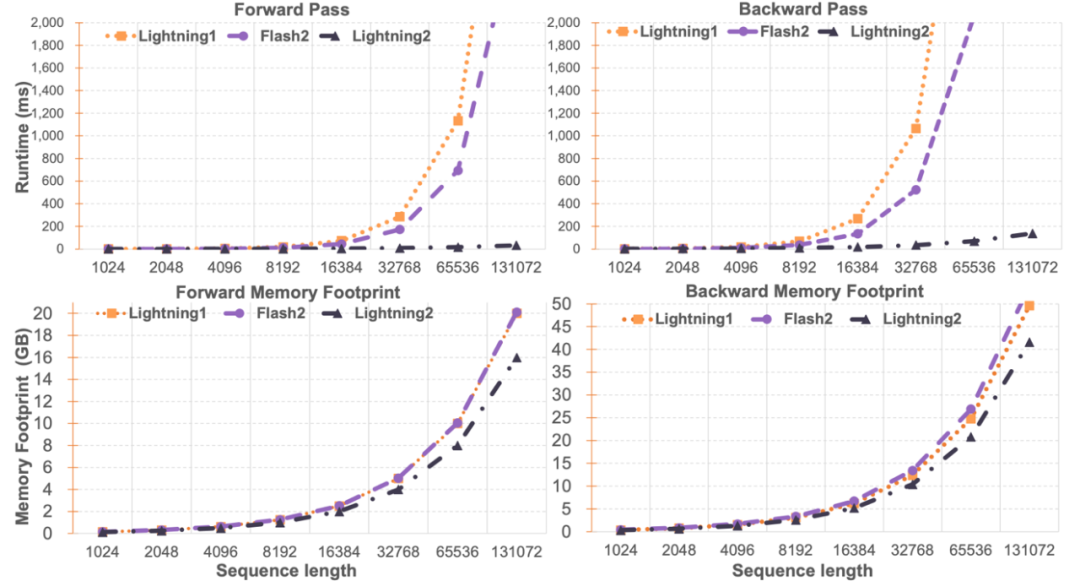

Perbandingan kelajuan Lightning Attention-2Para penyelidik membandingkan kelajuan modul tunggal dan penggunaan memori Lightning Attention-2 dan FlashAttention2. Seperti yang ditunjukkan dalam rajah di bawah, berbanding Lightning Attention-1 dan FlashAttention2, Lightning Attention-2 menunjukkan peningkatan linear yang ketat dalam kelajuan berbanding dengan panjang jujukan. Dari segi penggunaan memori, ketiga-tiga menunjukkan arah aliran yang sama, tetapi Lightning Attention-2 mempunyai jejak memori yang lebih kecil. Sebabnya ialah penggunaan memori FlashAttention2 dan Lightning Attention-1 juga lebih kurang linear.

Pengarang mendapati bahawa artikel ini tertumpu terutamanya pada menyelesaikan kelajuan latihan rangkaian perhatian linear, dan mencapai kelajuan latihan yang serupa dengan urutan 1K untuk urutan panjang dalam sebarang panjang. Dari segi kelajuan penaakulan, tidak banyak pengenalan. Ini adalah kerana perhatian linear boleh ditukar tanpa rugi kepada mod RNN semasa inferens, dengan itu mencapai kesan yang sama, iaitu, kelajuan membuat kesimpulan satu token adalah malar. Untuk Transformer, kelajuan inferens token semasa adalah berkaitan dengan bilangan token sebelumnya.

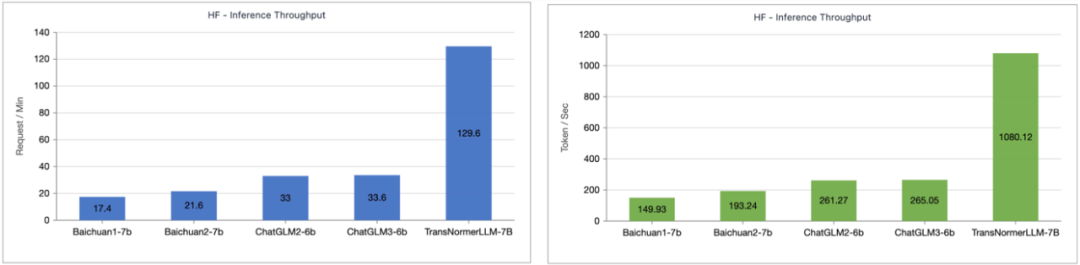

Pengarang menguji perbandingan kelajuan inferens antara TransNormerLLM-7B yang disokong oleh Lightning Attention-1 dan model 7B biasa. Seperti yang ditunjukkan dalam rajah di bawah, di bawah anggaran saiz parameter, kelajuan pemprosesan Lightning Attention-1 ialah 4 kali ganda daripada Baichuan dan lebih daripada 3.5 kali ganda daripada ChatGLM, menunjukkan kelebihan kelajuan inferens yang sangat baik.

🎜

Lightning Attention-2 mewakili kemajuan besar dalam mekanisme perhatian linear, menjadikannya pengganti sempurna untuk perhatian Softmax tradisional dari segi ketepatan dan kelajuan, dan menyediakan sokongan untuk model yang semakin besar dalam masa hadapan. Menyediakan keupayaan untuk skala yang mampan dan menyediakan laluan untuk mengendalikan urutan yang tidak terhingga dengan kecekapan yang lebih tinggi. Pasukan OpenNLPLab akan mengkaji algoritma selari berjujukan berdasarkan mekanisme perhatian linear pada masa hadapan untuk menyelesaikan masalah halangan memori yang dihadapi pada masa ini. Atas ialah kandungan terperinci Perhatian Kilat-2: Mekanisme perhatian generasi baharu yang mencapai panjang jujukan tidak terhingga, kos kuasa pengkomputeran berterusan dan ketepatan pemodelan yang lebih tinggi. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Gambar 1

Gambar 1

Platform dagangan mata wang digital

Platform dagangan mata wang digital

Apakah yang dimaksudkan dengan menulis dalam python?

Apakah yang dimaksudkan dengan menulis dalam python?

Pengenalan kepada fail konfigurasi php

Pengenalan kepada fail konfigurasi php

Apakah format png

Apakah format png

Adakah perlu untuk menaik taraf windows 11?

Adakah perlu untuk menaik taraf windows 11?

pangkalan data oracle menjalankan kaedah sql

pangkalan data oracle menjalankan kaedah sql

Bagaimana untuk menyelesaikan 404 tidak dijumpai

Bagaimana untuk menyelesaikan 404 tidak dijumpai

Harga pasaran Ethereum hari ini

Harga pasaran Ethereum hari ini