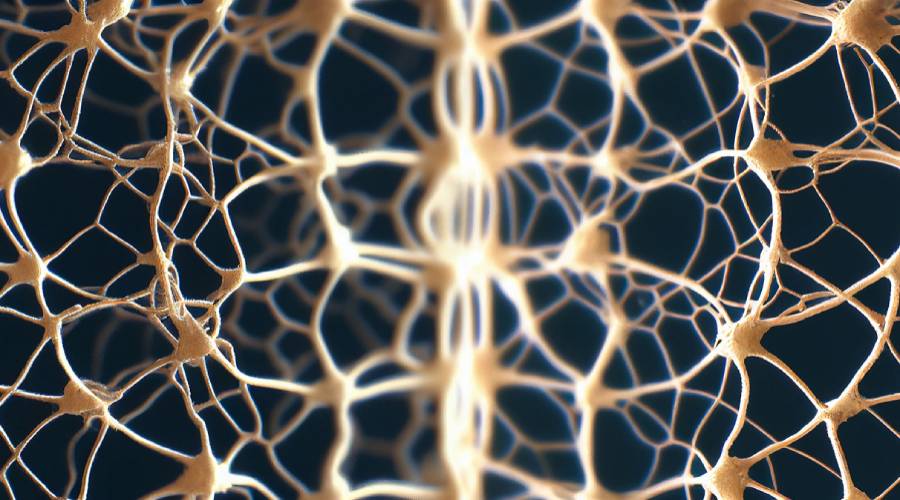

Keupayaan untuk mentafsir rangkaian saraf

Kebolehjelasan rangkaian saraf (Explainable Artificial Intelligence, XAI) merujuk kepada keupayaan membuat keputusan untuk menerangkan model pembelajaran mesin atau sistem kecerdasan buatan. Dalam aplikasi praktikal, kita perlu memahami mengapa model membuat keputusan tertentu supaya kita boleh memahami dan mempercayai output model. Model pembelajaran mesin tradisional, seperti pepohon keputusan dan regresi linear, mempunyai kebolehtafsiran yang baik. Walau bagaimanapun, proses membuat keputusan model pembelajaran mendalam, seperti rangkaian saraf, selalunya sukar untuk dijelaskan kerana strukturnya yang kompleks dan ciri kotak hitam. Ini kerana rangkaian saraf belajar daripada sejumlah besar data untuk mengekstrak ciri dan corak yang selalunya di luar kemampuan kognitif kita. Oleh itu, meningkatkan kebolehtafsiran rangkaian saraf telah menjadi bidang penyelidikan yang sangat penting. Pada masa ini, penyelidik telah mencadangkan banyak kaedah untuk menerangkan proses membuat keputusan rangkaian saraf, seperti analisis kepentingan ciri, peta haba pengaktifan, dan penjanaan sampel lawan. Kaedah ini boleh membantu kami memahami proses membuat keputusan rangkaian saraf dan meningkatkan kepercayaan terhadap model.

Untuk menyelesaikan masalah ini, penyelidik telah mencadangkan satu siri kaedah, termasuk visualisasi, sampel lawan, analisis kepentingan ciri, dll., untuk menerangkan proses membuat keputusan rangkaian saraf. Teknologi visualisasi ialah kaedah yang biasa digunakan yang boleh memaparkan nod utama dan sambungan rangkaian saraf dengan cara yang intuitif, membantu orang ramai memahami proses membuat keputusan model. Melalui kaedah sampel musuh yang membuat gangguan kecil kepada data input, keputusan ramalan rangkaian saraf boleh diubah, dengan itu mendedahkan kelemahan dan kelemahan model. Analisis kepentingan ciri boleh menerangkan proses membuat keputusan rangkaian saraf dengan mengira sumbangan setiap ciri input dalam model. Penggunaan gabungan kaedah ini boleh meningkatkan pemahaman proses membuat keputusan rangkaian saraf dan membantu mengoptimumkan dan meningkatkan lagi prestasi model.

Kebolehjelasan rangkaian saraf adalah penting untuk mencapai kecerdasan buatan yang boleh dipercayai dan boleh diterima. Ia membantu orang ramai memahami dan mempercayai proses membuat keputusan model pembelajaran mesin dan dengan itu menggunakan teknologi ini dengan lebih baik.

Kaedah Kebolehtafsiran Rangkaian Neural

Kaedah untuk kebolehtafsiran rangkaian saraf termasuk yang berikut:

Kaedah visualisasi: Tunjukkan proses membuat keputusan model dengan menggambarkan nod dan sambungan utama dalam rangkaian saraf. Contohnya, gunakan peta haba untuk mewakili aktiviti setiap neuron dalam rangkaian saraf, atau gunakan peta topologi rangkaian untuk mewakili perhubungan hierarki dalam rangkaian saraf.

Kaedah sampel adversarial ialah satu cara untuk menukar keputusan ramalan rangkaian saraf dengan membuat gangguan kecil kepada data input untuk mendedahkan kelemahan dan kelemahan model. Salah satu kaedah yang biasa digunakan ialah FGSM (Kaedah Tanda Kecerunan Pantas), yang boleh menjana sampel lawan untuk mengubah keputusan ramalan rangkaian saraf. Dengan cara ini, penyelidik boleh menemui kelemahan model dalam menghadapi gangguan tertentu dan dengan itu meningkatkan keteguhan model. Kaedah sampel adversarial mempunyai nilai aplikasi yang penting dalam bidang keselamatan dan penyelidikan keteguhan model.

Kaedah analisis kepentingan ciri bertujuan untuk menerangkan proses membuat keputusan rangkaian saraf dengan mengira sumbangan setiap ciri input dalam model. Kaedah biasa ialah menggunakan LIME (Penjelasan Model-Agnostik Boleh Ditafsir Tempatan), yang boleh mengira kesan setiap ciri input pada hasil ramalan model. Kaedah LIME boleh menjana model tempatan yang boleh ditafsir, dengan itu membantu kami memahami proses membuat keputusan rangkaian saraf. Dengan menganalisis kepentingan ciri, kita boleh memahami ciri yang memainkan peranan penting dalam ramalan model, dengan itu mengoptimumkan prestasi model atau meningkatkan kuasa penjelasan model.

Reka bentuk model yang lebih boleh ditafsir, seperti model berasaskan peraturan atau pepohon keputusan, yang boleh menggantikan rangkaian saraf untuk ramalan dan penjelasan.

Kaedah visualisasi data ialah teknologi yang membantu orang ramai memahami proses membuat keputusan rangkaian saraf dengan menggambarkan pengedaran, ciri statistik dan maklumat lain data latihan dan data ujian. Antaranya, kaedah t-SNE boleh memetakan data berdimensi tinggi pada satah dua dimensi untuk memaparkan pengedaran data secara intuitif. Melalui kaedah visualisasi ini, orang ramai boleh mempunyai pemahaman yang lebih jelas tentang prinsip kerja dan asas membuat keputusan rangkaian saraf, dengan itu meningkatkan pemahaman dan kepercayaan mereka.

Kaedah tafsiran rangkaian saraf berkembang pesat, dan lebih banyak teknologi akan muncul pada masa hadapan untuk membantu memahami dan menerapkannya.

Situasi semasa kebolehtafsiran rangkaian neural di dalam dan di luar negara

Kebolehtafsiran rangkaian saraf merupakan salah satu titik panas penyelidikan semasa dalam bidang kecerdasan buatan Ramai penyelidik di dalam dan luar negara telah melabur dalam penyelidikan dalam bidang ini. Berikut ialah status semasa kebolehtafsiran rangkaian saraf di dalam dan luar negara:

Di luar negara:

Kumpulan Kerja Kebolehtafsiran Pembelajaran Mendalam (Kumpulan Kerja Kebolehtafsiran): Kumpulan kerja kebolehtafsiran pembelajaran mendalam yang ditubuhkan oleh OpenAI, Google Brain dan syarikat lain, bertujuan untuk Mengkaji masalah kebolehtafsiran model pembelajaran mendalam.

Pembelajaran Mesin Boleh Diterangkan: Ia adalah bidang penyelidikan antara disiplin yang terdiri daripada penyelidik pembelajaran mesin antarabangsa, yang bertujuan untuk meningkatkan kebolehjelasan dan kebolehpercayaan model pembelajaran mesin.

LIME (Local Interpretable Model-Agnostic Explanations): Ia adalah kaedah kebolehtafsiran berdasarkan model tempatan yang boleh menerangkan proses membuat keputusan bagi mana-mana model pembelajaran mesin.

Dalam Negeri:

Institut Automasi, Akademi Sains China: Pasukan penyelidik institut itu telah menjalankan satu siri kajian tentang kebolehtafsiran rangkaian saraf, termasuk pembelajaran mendalam boleh ditafsir, pembelajaran pengukuhan boleh ditafsir, dsb.

Jabatan Sains dan Teknologi Komputer, Universiti Tsinghua: Pasukan penyelidik jabatan ini telah menjalankan satu siri penyelidikan tentang kebolehtafsiran rangkaian saraf, termasuk pembelajaran mendalam boleh tafsir, pembelajaran tetulang boleh tafsir, dsb.

Universiti Pos dan Telekomunikasi Beijing: Pasukan penyelidik sekolah telah menjalankan satu siri kajian tentang kebolehtafsiran rangkaian saraf, termasuk kaedah kebolehtafsiran berdasarkan kaedah visualisasi dan kaedah kebolehtafsiran berdasarkan sampel lawan.

Atas ialah kandungan terperinci Keupayaan untuk mentafsir rangkaian saraf. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1378

1378

52

52

Terokai konsep, perbezaan, kebaikan dan keburukan RNN, LSTM dan GRU

Jan 22, 2024 pm 07:51 PM

Terokai konsep, perbezaan, kebaikan dan keburukan RNN, LSTM dan GRU

Jan 22, 2024 pm 07:51 PM

Dalam data siri masa, terdapat kebergantungan antara pemerhatian, jadi ia tidak bebas antara satu sama lain. Walau bagaimanapun, rangkaian saraf tradisional menganggap setiap pemerhatian sebagai bebas, yang mengehadkan keupayaan model untuk memodelkan data siri masa. Untuk menyelesaikan masalah ini, Rangkaian Neural Berulang (RNN) telah diperkenalkan, yang memperkenalkan konsep ingatan untuk menangkap ciri dinamik data siri masa dengan mewujudkan kebergantungan antara titik data dalam rangkaian. Melalui sambungan berulang, RNN boleh menghantar maklumat sebelumnya ke dalam pemerhatian semasa untuk meramalkan nilai masa hadapan dengan lebih baik. Ini menjadikan RNN alat yang berkuasa untuk tugasan yang melibatkan data siri masa. Tetapi bagaimanakah RNN mencapai ingatan seperti ini? RNN merealisasikan ingatan melalui gelung maklum balas dalam rangkaian saraf Ini adalah perbezaan antara RNN dan rangkaian saraf tradisional.

Mengira operan titik terapung (FLOPS) untuk rangkaian saraf

Jan 22, 2024 pm 07:21 PM

Mengira operan titik terapung (FLOPS) untuk rangkaian saraf

Jan 22, 2024 pm 07:21 PM

FLOPS ialah salah satu piawaian untuk penilaian prestasi komputer, digunakan untuk mengukur bilangan operasi titik terapung sesaat. Dalam rangkaian saraf, FLOPS sering digunakan untuk menilai kerumitan pengiraan model dan penggunaan sumber pengkomputeran. Ia adalah penunjuk penting yang digunakan untuk mengukur kuasa pengkomputeran dan kecekapan komputer. Rangkaian saraf ialah model kompleks yang terdiri daripada berbilang lapisan neuron yang digunakan untuk tugas seperti klasifikasi data, regresi dan pengelompokan. Latihan dan inferens rangkaian saraf memerlukan sejumlah besar pendaraban matriks, konvolusi dan operasi pengiraan lain, jadi kerumitan pengiraan adalah sangat tinggi. FLOPS (FloatingPointOperationsperSecond) boleh digunakan untuk mengukur kerumitan pengiraan rangkaian saraf untuk menilai kecekapan penggunaan sumber pengiraan model. FLOP

Kajian kes menggunakan model LSTM dwiarah untuk pengelasan teks

Jan 24, 2024 am 10:36 AM

Kajian kes menggunakan model LSTM dwiarah untuk pengelasan teks

Jan 24, 2024 am 10:36 AM

Model LSTM dwiarah ialah rangkaian saraf yang digunakan untuk pengelasan teks. Berikut ialah contoh mudah yang menunjukkan cara menggunakan LSTM dwiarah untuk tugasan pengelasan teks. Pertama, kita perlu mengimport perpustakaan dan modul yang diperlukan: importosimportnumpyasnpfromkeras.preprocessing.textimportTokenizerfromkeras.preprocessing.sequenceimportpad_sequencesfromkeras.modelsimportSequentialfromkeras.layersimportDense,Em

Definisi dan analisis struktur rangkaian neural kabur

Jan 22, 2024 pm 09:09 PM

Definisi dan analisis struktur rangkaian neural kabur

Jan 22, 2024 pm 09:09 PM

Rangkaian saraf kabur ialah model hibrid yang menggabungkan logik kabur dan rangkaian saraf untuk menyelesaikan masalah kabur atau tidak pasti yang sukar dikendalikan dengan rangkaian saraf tradisional. Reka bentuknya diilhamkan oleh kekaburan dan ketidakpastian dalam kognisi manusia, jadi ia digunakan secara meluas dalam sistem kawalan, pengecaman corak, perlombongan data dan bidang lain. Seni bina asas rangkaian neural kabur terdiri daripada subsistem kabur dan subsistem saraf. Subsistem kabur menggunakan logik kabur untuk memproses data input dan menukarnya kepada set kabur untuk menyatakan kekaburan dan ketidakpastian data input. Subsistem saraf menggunakan rangkaian saraf untuk memproses set kabur untuk tugasan seperti pengelasan, regresi atau pengelompokan. Interaksi antara subsistem kabur dan subsistem saraf menjadikan rangkaian neural kabur mempunyai keupayaan pemprosesan yang lebih berkuasa dan boleh

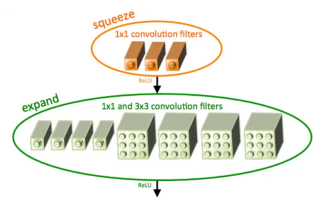

Pengenalan kepada SqueezeNet dan ciri-cirinya

Jan 22, 2024 pm 07:15 PM

Pengenalan kepada SqueezeNet dan ciri-cirinya

Jan 22, 2024 pm 07:15 PM

SqueezeNet ialah algoritma kecil dan tepat yang memberikan keseimbangan yang baik antara ketepatan tinggi dan kerumitan rendah, menjadikannya sesuai untuk sistem mudah alih dan terbenam dengan sumber terhad. Pada 2016, penyelidik dari DeepScale, University of California, Berkeley, dan Stanford University mencadangkan SqueezeNet, rangkaian neural convolutional (CNN) yang padat dan cekap. Dalam beberapa tahun kebelakangan ini, penyelidik telah membuat beberapa penambahbaikan pada SqueezeNet, termasuk SqueezeNetv1.1 dan SqueezeNetv2.0. Penambahbaikan dalam kedua-dua versi bukan sahaja meningkatkan ketepatan tetapi juga mengurangkan kos pengiraan. Ketepatan SqueezeNetv1.1 pada dataset ImageNet

Penghapusan imej menggunakan rangkaian saraf konvolusi

Jan 23, 2024 pm 11:48 PM

Penghapusan imej menggunakan rangkaian saraf konvolusi

Jan 23, 2024 pm 11:48 PM

Rangkaian neural konvolusi berfungsi dengan baik dalam tugasan menghilangkan imej. Ia menggunakan penapis yang dipelajari untuk menapis bunyi dan dengan itu memulihkan imej asal. Artikel ini memperkenalkan secara terperinci kaedah denoising imej berdasarkan rangkaian neural convolutional. 1. Gambaran Keseluruhan Rangkaian Neural Konvolusi Rangkaian saraf konvolusi ialah algoritma pembelajaran mendalam yang menggunakan gabungan berbilang lapisan konvolusi, lapisan gabungan dan lapisan bersambung sepenuhnya untuk mempelajari dan mengelaskan ciri imej. Dalam lapisan konvolusi, ciri tempatan imej diekstrak melalui operasi konvolusi, dengan itu menangkap korelasi spatial dalam imej. Lapisan pengumpulan mengurangkan jumlah pengiraan dengan mengurangkan dimensi ciri dan mengekalkan ciri utama. Lapisan bersambung sepenuhnya bertanggungjawab untuk memetakan ciri dan label yang dipelajari untuk melaksanakan pengelasan imej atau tugas lain. Reka bentuk struktur rangkaian ini menjadikan rangkaian neural konvolusi berguna dalam pemprosesan dan pengecaman imej.

Langkah-langkah untuk menulis rangkaian neural mudah menggunakan Rust

Jan 23, 2024 am 10:45 AM

Langkah-langkah untuk menulis rangkaian neural mudah menggunakan Rust

Jan 23, 2024 am 10:45 AM

Rust ialah bahasa pengaturcaraan peringkat sistem yang memfokuskan pada keselamatan, prestasi dan keselarasan. Ia bertujuan untuk menyediakan bahasa pengaturcaraan yang selamat dan boleh dipercayai yang sesuai untuk senario seperti sistem pengendalian, aplikasi rangkaian dan sistem terbenam. Keselamatan Rust datang terutamanya dari dua aspek: sistem pemilikan dan pemeriksa pinjaman. Sistem pemilikan membolehkan pengkompil menyemak kod untuk ralat memori pada masa penyusunan, dengan itu mengelakkan isu keselamatan memori biasa. Dengan memaksa menyemak pemindahan pemilikan berubah pada masa penyusunan, Rust memastikan sumber memori diurus dan dikeluarkan dengan betul. Penyemak pinjaman menganalisis kitaran hayat pembolehubah untuk memastikan pembolehubah yang sama tidak akan diakses oleh berbilang rangkaian pada masa yang sama, sekali gus mengelakkan isu keselamatan bersamaan yang biasa. Dengan menggabungkan kedua-dua mekanisme ini, Rust dapat menyediakan

Rangkaian Neural Berkembar: Analisis Prinsip dan Aplikasi

Jan 24, 2024 pm 04:18 PM

Rangkaian Neural Berkembar: Analisis Prinsip dan Aplikasi

Jan 24, 2024 pm 04:18 PM

Rangkaian Neural Siam ialah struktur rangkaian saraf tiruan yang unik. Ia terdiri daripada dua rangkaian neural yang sama yang berkongsi parameter dan berat yang sama. Pada masa yang sama, kedua-dua rangkaian juga berkongsi data input yang sama. Reka bentuk ini diilhamkan oleh kembar, kerana kedua-dua rangkaian saraf adalah sama dari segi struktur. Prinsip rangkaian saraf Siam adalah untuk menyelesaikan tugas tertentu, seperti padanan imej, padanan teks dan pengecaman muka, dengan membandingkan persamaan atau jarak antara dua data input. Semasa latihan, rangkaian cuba untuk memetakan data yang serupa ke wilayah bersebelahan dan data yang tidak serupa ke wilayah yang jauh. Dengan cara ini, rangkaian boleh belajar cara mengklasifikasikan atau memadankan data yang berbeza dan mencapai yang sepadan