Peranti teknologi

Peranti teknologi

AI

AI

MoE dan Mamba bekerjasama untuk menskalakan model ruang negeri kepada berbilion parameter

MoE dan Mamba bekerjasama untuk menskalakan model ruang negeri kepada berbilion parameter

MoE dan Mamba bekerjasama untuk menskalakan model ruang negeri kepada berbilion parameter

Model Angkasa Negeri (SSM) adalah teknologi yang telah menarik perhatian ramai dan dianggap sebagai alternatif kepada Transformer. Berbanding dengan Transformer, SSM boleh mencapai penaakulan masa linear apabila memproses tugas konteks yang panjang, dan mempunyai latihan selari dan prestasi cemerlang. Khususnya, Mamba, yang berasaskan SSM terpilih dan reka bentuk peka perkakasan, telah menunjukkan prestasi cemerlang dan telah menjadi salah satu alternatif yang berkuasa kepada seni bina Transformer berasaskan perhatian.

Baru-baru ini, penyelidik juga meneroka menggabungkan SSM dan Mamba dengan kaedah lain untuk mencipta seni bina yang lebih berkuasa. Contohnya, Machine Heart pernah melaporkan bahawa "Mamba boleh menggantikan Transformer, tetapi ia juga boleh digunakan dalam kombinasi."

Baru-baru ini, pasukan penyelidik Poland mendapati bahawa jika SSM digabungkan dengan sistem pakar hibrid (MoE/Campuran Pakar), SSM boleh dijangka mencapai pengembangan berskala besar. MoE ialah teknologi yang biasa digunakan untuk memanjangkan Transformer Sebagai contoh, model Mixtral baru-baru ini menggunakan teknologi ini. Hasil penyelidikan yang diberikan oleh pasukan penyelidik Poland ini ialah MoE-Mamba, model yang menggabungkan Mamba dan lapisan pakar hibrid.

Alamat kertas: https://arxiv.org/pdf/2401.04081.pdf

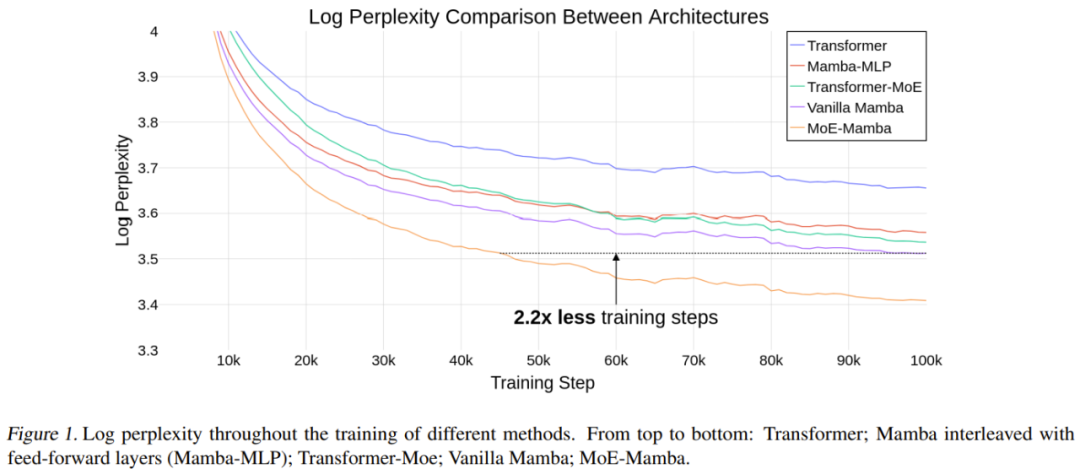

Pasukan menjalankan demonstrasi eksperimen dan keputusan menunjukkan bahawa berbanding dengan Mamba, MoE-Mamba memerlukan 2.2 kali lebih sedikit langkah latihan dengan keperluan prestasi yang sama, menunjukkan prestasi kaedah baharu berbanding potensi kelebihan Transformer dan Transformer-MoE. Keputusan awal ini juga menunjukkan arah penyelidikan yang menjanjikan: SSM mungkin boleh berskala kepada berpuluh bilion parameter.

Penyelidikan Berkaitan

Model Angkasa Negeri

Model Angkasa Negeri (SSM) ialah sejenis seni bina yang digunakan untuk pemodelan jujukan. Idea untuk model ini berasal dari bidang sibernetik dan boleh dilihat sebagai gabungan RNN dan CNN. Walaupun mereka mempunyai kelebihan yang besar, mereka juga mempunyai beberapa masalah yang menghalang mereka daripada menjadi seni bina yang dominan untuk tugas pemodelan bahasa. Walau bagaimanapun, penemuan penyelidikan baru-baru ini telah membolehkan SSM mendalam menskalakan kepada berbilion-bilion parameter sambil mengekalkan kecekapan pengiraan dan prestasi yang kukuh.

Mamba

Mamba ialah model yang dibina pada SSM, yang boleh mencapai kelajuan inferens masa linear (untuk panjang konteks), dan ia juga mencapai proses latihan yang cekap melalui reka bentuk yang menyedari perkakasan. Mamba menggunakan pendekatan imbasan selari cekap kerja yang mengurangkan kesan jujukan gelung, manakala operasi GPU yang digabungkan menghapuskan keperluan untuk melaksanakan keadaan lanjutan. Keadaan pertengahan yang diperlukan untuk perambatan belakang tidak disimpan tetapi dikira semula semasa hantaran ke belakang, dengan itu mengurangkan keperluan memori. Kelebihan Mamba berbanding mekanisme perhatian amat ketara dalam peringkat inferens kerana ia bukan sahaja mengurangkan kerumitan pengiraan, tetapi juga penggunaan memori tidak bergantung pada panjang konteks.

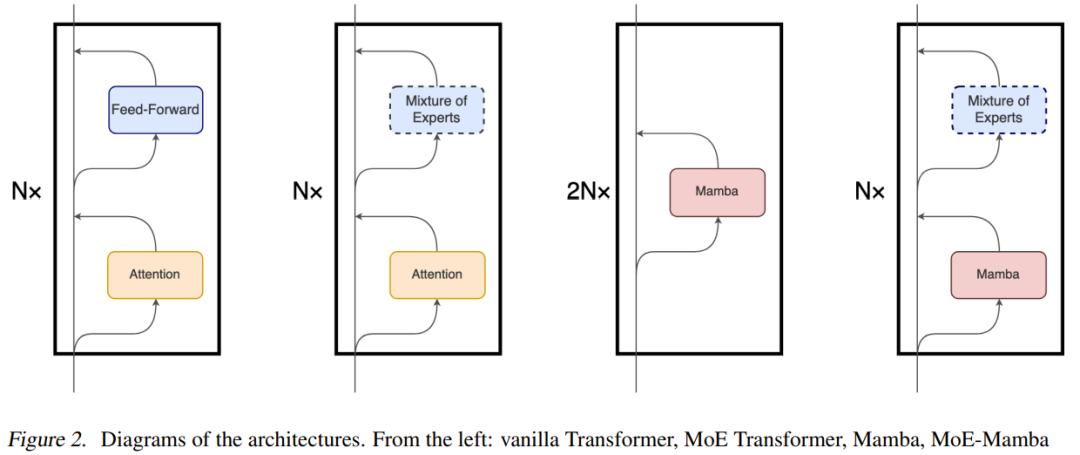

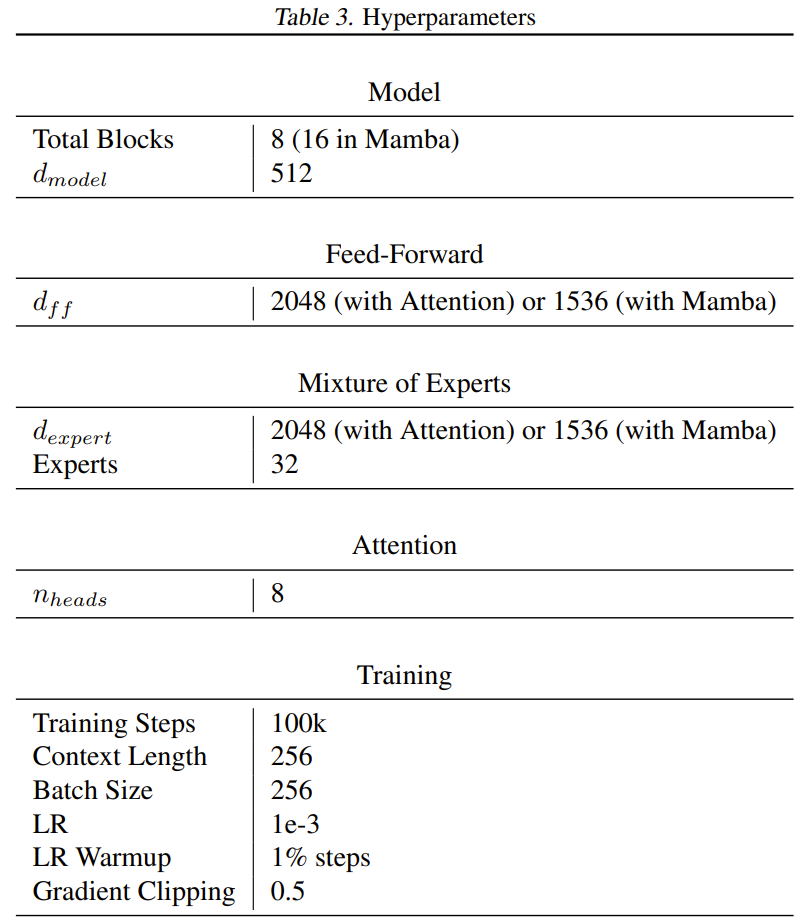

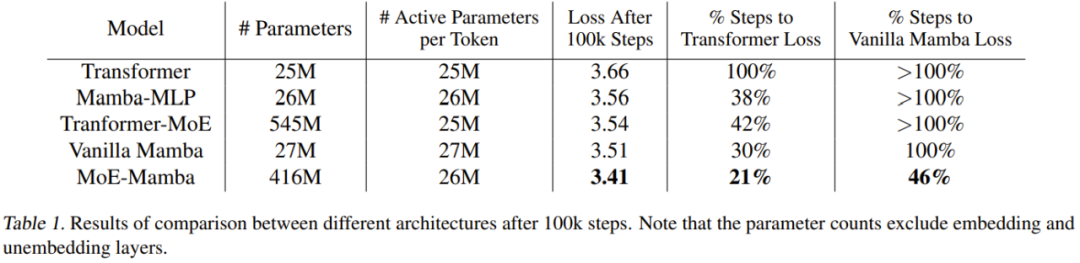

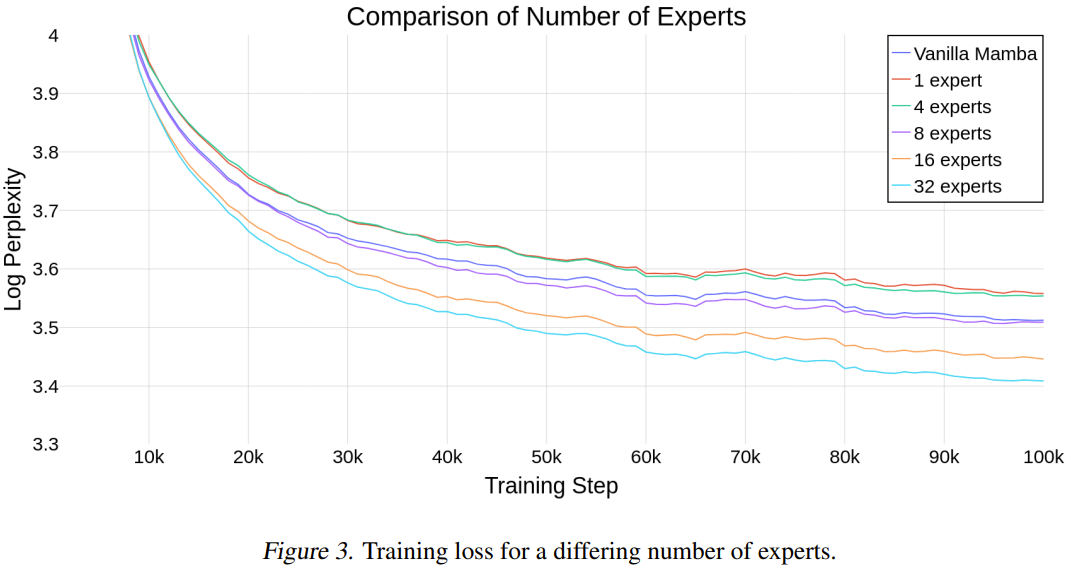

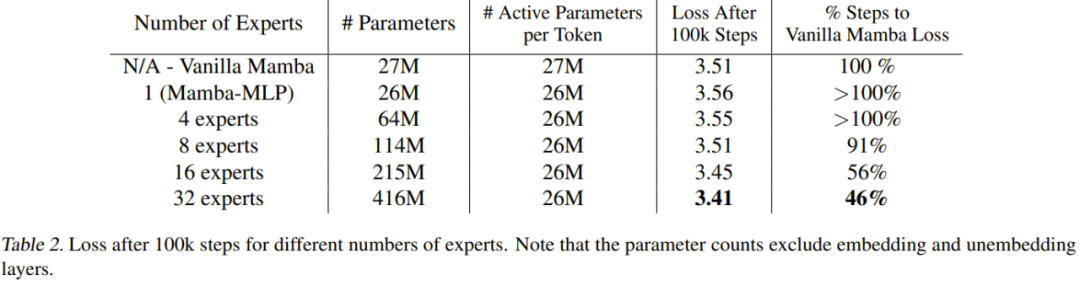

Mamba boleh menyelesaikan pertukaran asas antara kecekapan dan keberkesanan model jujukan, yang menyerlahkan kepentingan pemampatan keadaan. Model yang cekap mesti memerlukan keadaan kecil, dan keadaan yang diperlukan oleh model yang berkesan harus mengandungi semua maklumat utama konteks. Tidak seperti SSM lain yang memerlukan invarian temporal dan input, Mamba memperkenalkan mekanisme pemilihan yang mengawal cara maklumat disebarkan sepanjang dimensi jujukan. Pilihan reka bentuk ini diilhamkan oleh pemahaman intuitif tentang tugas sintesis kelas pertama seperti replikasi terpilih dan aruhan, yang membolehkan model membezakan dan mengekalkan maklumat kritikal sambil menapis maklumat yang tidak berkaitan. Penyelidikan mendapati bahawa Mamba mempunyai keupayaan untuk menggunakan konteks yang lebih panjang dengan cekap (sehingga token 1M), dan apabila panjang konteks bertambah, kebingungan pra-latihan juga akan bertambah baik. Model Mamba terdiri daripada blok Mamba bertindan dan telah mencapai hasil yang sangat baik dalam pelbagai bidang seperti NLP, genomik, audio, dll. Prestasinya setanding dan mengatasi model Transformer sedia ada. Oleh itu, Mamba telah menjadi model calon yang kukuh untuk model tulang belakang pemodelan jujukan umum Sila rujuk "Lima kali pemprosesan, prestasi menyeluruh mengelilingi Transformer: Seni bina baharu Mamba meletupkan bulatan AI". Pakar Campuran Teknik Pakar Campuran (KPM) boleh meningkatkan bilangan parameter model tanpa menjejaskan FLOP yang diperlukan untuk inferens dan latihan model. MoE pertama kali dicadangkan oleh Jacobs et al pada tahun 1991 dan mula digunakan untuk tugasan NLP pada tahun 2017 oleh Shazeer et al. MoE mempunyai kelebihan: pengaktifan sangat jarang - untuk setiap token yang diproses, hanya sebahagian kecil daripada parameter model digunakan. Disebabkan keperluan pengiraannya, lapisan hadapan dalam Transformer telah menjadi sasaran standard untuk beberapa teknik KPM. Komuniti penyelidik telah mencadangkan pelbagai kaedah untuk menyelesaikan masalah teras KPM, iaitu proses pemberian token kepada pakar, juga dikenali sebagai proses routing. Pada masa ini terdapat dua algoritma penghalaan asas: Pilihan Token dan Pilihan Pakar. Yang pertama adalah untuk menghalakan setiap token ke bilangan (K) pakar tertentu, manakala yang terakhir adalah untuk menghalakan setiap token ke bilangan pakar yang tetap. Fedus et al mencadangkan Suis dalam kertas 2022 "Tukar transformer: Menskalakan kepada trilion model parameter dengan kesederhanaan yang mudah dan cekap", yang merupakan seni bina Pilihan Token yang mengarahkan setiap token kepada pakar tunggal ( K=1), dan mereka menggunakan kaedah ini untuk berjaya mengembangkan saiz parameter Transformer kepada 1.6 trilion. Pasukan di Poland ini juga menggunakan reka bentuk MoE ini dalam eksperimen mereka. Baru-baru ini, KPM juga telah mula memasuki komuniti sumber terbuka, seperti OpenMoE. Alamat projek: https://github.com/XueFuzhao/OpenMoE Adalah wajar dinyatakan bahawa sumber terbuka Mistral Mixtral 8×7B mempunyai prestasi yang setanding dengan LLaMa 2 70B, sementara memerlukan inferens pengiraan hanya kira-kira satu perenam daripada yang terakhir. Walaupun mekanisme asas utama Mamba agak berbeza daripada mekanisme perhatian yang digunakan dalam Transformer, Mamba mengekalkan struktur peringkat tinggi berasaskan modul model Transformer. Menggunakan paradigma ini, satu atau lebih lapisan modul yang sama disusun di atas satu sama lain, dan output setiap lapisan ditambah kepada aliran baki, lihat Rajah 2. Nilai akhir aliran baki ini kemudiannya digunakan untuk meramalkan token seterusnya untuk tugas pemodelan bahasa. MoE-Mamba mengambil kesempatan daripada keserasian kedua-dua seni bina ini. Seperti yang ditunjukkan dalam Rajah 2, dalam MoE-Mamba, setiap lapisan Mamba selang digantikan oleh lapisan suapan MoE berasaskan Suis. Walau bagaimanapun, pasukan juga menyedari bahawa reka bentuk ini agak serupa dengan reka bentuk "Mamba: Pemodelan jujukan masa linear dengan ruang keadaan terpilih" secara bergantian menyusun lapisan Mamba dan lapisan suapan, tetapi hasilnya Model ini sedikit lebih rendah daripada Mamba yang ringkas. Reka bentuk ini dilambangkan sebagai Mamba-MLP dalam Rajah 1. MoE-Mamba memisahkan pemprosesan tanpa syarat bagi setiap token yang dilakukan oleh lapisan Mamba dan pemprosesan bersyarat yang dilakukan oleh lapisan MoE dengan cekap boleh menyepadukan keseluruhan konteks jujukan ke dalam perwakilan dalaman, manakala pemprosesan bersyarat; Pemprosesan boleh menggunakan pakar yang paling berkaitan untuk setiap token. Idea pemprosesan bersyarat dan tanpa syarat berselang-seli ini telah digunakan dalam beberapa model berasaskan MoE, tetapi ia biasanya bergantian lapisan asas dan suapan MoE. Persediaan latihan Pasukan membandingkan 5 persediaan berbeza: Transformer Asas, Mamba, Mamba-MLP, KPM dan MoE-Mamba. Dalam kebanyakan Transformer, lapisan suapan hadapan mengandungi parameter 8dm², manakala kertas Mamba menjadikan Mamba lebih kecil (kira-kira 6dm²), supaya bilangan parameter dua lapisan Mamba adalah sama dengan satu lapisan suapan dan satu lapisan perhatian Ia kelihatan hampir yang sama. Untuk mendapatkan kira-kira bilangan parameter aktif yang sama bagi setiap token dalam Mamba dan model baharu, pasukan mengurangkan saiz setiap lapisan hadapan pakar kepada 6dm². Kecuali untuk lapisan benam dan menyahbenam, semua model menggunakan kira-kira 26 juta parameter bagi setiap token. Proses latihan menggunakan 6.5 bilion token dan bilangan langkah latihan ialah 100k. Set data yang digunakan untuk latihan ialah set data Bahasa Inggeris C4, dan tugasnya adalah untuk meramalkan token seterusnya. Teks ditandakan menggunakan tokenizer GPT2. Jadual 3 memberikan senarai lengkap hiperparameter. Keputusan Jadual 1 memberikan keputusan latihan. MoE-Mamba menunjukkan prestasi yang lebih baik daripada model Mamba biasa. Adalah diperhatikan bahawa MoE-Mamba mencapai tahap keputusan yang sama seperti Mamba biasa dalam hanya 46% daripada langkah latihan. Memandangkan kadar pembelajaran diselaraskan untuk Mamba biasa, boleh dijangkakan bahawa jika proses latihan dioptimumkan untuk MoE-Mamba, MoE-Mamba akan berprestasi lebih baik. Untuk menilai sama ada skala Mamba serta bilangan pakar bertambah, penyelidik membandingkan model menggunakan bilangan pakar yang berbeza. Rajah 3 menunjukkan langkah latihan semasa menggunakan bilangan pakar yang berbeza. Jadual 2 memberikan keputusan selepas 100k langkah. Keputusan ini menunjukkan bahawa kaedah yang baru dicadangkan berskala baik dengan bilangan pakar. Jika bilangan pakar adalah 8 atau lebih, prestasi akhir model baharu adalah lebih baik daripada Mamba biasa. Memandangkan Mamba-MLP lebih teruk daripada Mamba biasa, boleh dijangkakan MoE-Mamba yang menggunakan sebilangan kecil pakar akan berprestasi lebih teruk daripada Mamba. Kaedah baharu itu memberikan hasil terbaik apabila bilangan pakar ialah 32 orang. Seni Bina Model

Keputusan utama

Kajian Ablasi

Atas ialah kandungan terperinci MoE dan Mamba bekerjasama untuk menskalakan model ruang negeri kepada berbilion parameter. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1375

1375

52

52

Sumber terbuka! Di luar ZoeDepth! DepthFM: Anggaran kedalaman monokular yang cepat dan tepat!

Apr 03, 2024 pm 12:04 PM

Sumber terbuka! Di luar ZoeDepth! DepthFM: Anggaran kedalaman monokular yang cepat dan tepat!

Apr 03, 2024 pm 12:04 PM

0. Apakah fungsi artikel ini? Kami mencadangkan DepthFM: model anggaran kedalaman monokular generatif yang serba boleh dan pantas. Sebagai tambahan kepada tugas anggaran kedalaman tradisional, DepthFM juga menunjukkan keupayaan terkini dalam tugas hiliran seperti mengecat kedalaman. DepthFM cekap dan boleh mensintesis peta kedalaman dalam beberapa langkah inferens. Mari kita baca karya ini bersama-sama ~ 1. Tajuk maklumat kertas: DepthFM: FastMonocularDepthEstimationwithFlowMatching Pengarang: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Model MoE sumber terbuka paling berkuasa di dunia ada di sini, dengan keupayaan bahasa Cina setanding dengan GPT-4, dan harganya hanya hampir satu peratus daripada GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Model MoE sumber terbuka paling berkuasa di dunia ada di sini, dengan keupayaan bahasa Cina setanding dengan GPT-4, dan harganya hanya hampir satu peratus daripada GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Bayangkan model kecerdasan buatan yang bukan sahaja mempunyai keupayaan untuk mengatasi pengkomputeran tradisional, tetapi juga mencapai prestasi yang lebih cekap pada kos yang lebih rendah. Ini bukan fiksyen sains, DeepSeek-V2[1], model MoE sumber terbuka paling berkuasa di dunia ada di sini. DeepSeek-V2 ialah gabungan model bahasa pakar (MoE) yang berkuasa dengan ciri-ciri latihan ekonomi dan inferens yang cekap. Ia terdiri daripada 236B parameter, 21B daripadanya digunakan untuk mengaktifkan setiap penanda. Berbanding dengan DeepSeek67B, DeepSeek-V2 mempunyai prestasi yang lebih kukuh, sambil menjimatkan 42.5% kos latihan, mengurangkan cache KV sebanyak 93.3% dan meningkatkan daya pemprosesan penjanaan maksimum kepada 5.76 kali. DeepSeek ialah sebuah syarikat yang meneroka kecerdasan buatan am

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas secara rasmi memasuki era robot elektrik! Semalam, Atlas hidraulik hanya "menangis" menarik diri daripada peringkat sejarah Hari ini, Boston Dynamics mengumumkan bahawa Atlas elektrik sedang berfungsi. Nampaknya dalam bidang robot humanoid komersial, Boston Dynamics berazam untuk bersaing dengan Tesla. Selepas video baharu itu dikeluarkan, ia telah pun ditonton oleh lebih sejuta orang dalam masa sepuluh jam sahaja. Orang lama pergi dan peranan baru muncul. Ini adalah keperluan sejarah. Tidak dinafikan bahawa tahun ini adalah tahun letupan robot humanoid. Netizen mengulas: Kemajuan robot telah menjadikan majlis pembukaan tahun ini kelihatan seperti manusia, dan tahap kebebasan adalah jauh lebih besar daripada manusia Tetapi adakah ini benar-benar bukan filem seram? Pada permulaan video, Atlas berbaring dengan tenang di atas tanah, seolah-olah terlentang. Apa yang berikut adalah rahang-jatuh

KAN, yang menggantikan MLP, telah diperluaskan kepada konvolusi oleh projek sumber terbuka

Jun 01, 2024 pm 10:03 PM

KAN, yang menggantikan MLP, telah diperluaskan kepada konvolusi oleh projek sumber terbuka

Jun 01, 2024 pm 10:03 PM

Awal bulan ini, penyelidik dari MIT dan institusi lain mencadangkan alternatif yang sangat menjanjikan kepada MLP - KAN. KAN mengatasi MLP dari segi ketepatan dan kebolehtafsiran. Dan ia boleh mengatasi prestasi MLP berjalan dengan bilangan parameter yang lebih besar dengan bilangan parameter yang sangat kecil. Sebagai contoh, penulis menyatakan bahawa mereka menggunakan KAN untuk menghasilkan semula keputusan DeepMind dengan rangkaian yang lebih kecil dan tahap automasi yang lebih tinggi. Khususnya, MLP DeepMind mempunyai kira-kira 300,000 parameter, manakala KAN hanya mempunyai kira-kira 200 parameter. KAN mempunyai asas matematik yang kukuh seperti MLP berdasarkan teorem penghampiran universal, manakala KAN berdasarkan teorem perwakilan Kolmogorov-Arnold. Seperti yang ditunjukkan dalam rajah di bawah, KAN telah

Apr 09, 2024 am 11:52 AM

Apr 09, 2024 am 11:52 AM

AI memang mengubah matematik. Baru-baru ini, Tao Zhexuan, yang telah mengambil perhatian terhadap isu ini, telah memajukan keluaran terbaru "Buletin Persatuan Matematik Amerika" (Buletin Persatuan Matematik Amerika). Memfokuskan pada topik "Adakah mesin akan mengubah matematik?", ramai ahli matematik menyatakan pendapat mereka Seluruh proses itu penuh dengan percikan api, tegar dan menarik. Penulis mempunyai barisan yang kuat, termasuk pemenang Fields Medal Akshay Venkatesh, ahli matematik China Zheng Lejun, saintis komputer NYU Ernest Davis dan ramai lagi sarjana terkenal dalam industri. Dunia AI telah berubah secara mendadak Anda tahu, banyak artikel ini telah dihantar setahun yang lalu.

Kelajuan Internet Data Selular Perlahan pada iPhone: Pembetulan

May 03, 2024 pm 09:01 PM

Kelajuan Internet Data Selular Perlahan pada iPhone: Pembetulan

May 03, 2024 pm 09:01 PM

Menghadapi ketinggalan, sambungan data mudah alih perlahan pada iPhone? Biasanya, kekuatan internet selular pada telefon anda bergantung pada beberapa faktor seperti rantau, jenis rangkaian selular, jenis perayauan, dsb. Terdapat beberapa perkara yang boleh anda lakukan untuk mendapatkan sambungan Internet selular yang lebih pantas dan boleh dipercayai. Betulkan 1 – Paksa Mulakan Semula iPhone Kadangkala, paksa memulakan semula peranti anda hanya menetapkan semula banyak perkara, termasuk sambungan selular. Langkah 1 – Hanya tekan kekunci naikkan kelantangan sekali dan lepaskan. Seterusnya, tekan kekunci Turun Kelantangan dan lepaskannya semula. Langkah 2 - Bahagian seterusnya proses adalah untuk menahan butang di sebelah kanan. Biarkan iPhone selesai dimulakan semula. Dayakan data selular dan semak kelajuan rangkaian. Semak semula Betulkan 2 – Tukar mod data Walaupun 5G menawarkan kelajuan rangkaian yang lebih baik, ia berfungsi lebih baik apabila isyarat lemah

Daya hidup kecerdasan super membangkitkan! Tetapi dengan kedatangan AI yang mengemas kini sendiri, ibu tidak perlu lagi bimbang tentang kesesakan data

Apr 29, 2024 pm 06:55 PM

Daya hidup kecerdasan super membangkitkan! Tetapi dengan kedatangan AI yang mengemas kini sendiri, ibu tidak perlu lagi bimbang tentang kesesakan data

Apr 29, 2024 pm 06:55 PM

Saya menangis hingga mati. Dunia sedang membina model besar. Data di Internet tidak mencukupi. Model latihan kelihatan seperti "The Hunger Games", dan penyelidik AI di seluruh dunia bimbang tentang cara memberi makan data ini kepada pemakan yang rakus. Masalah ini amat ketara dalam tugas berbilang modal. Pada masa mereka mengalami kerugian, pasukan pemula dari Jabatan Universiti Renmin China menggunakan model baharu mereka sendiri untuk menjadi yang pertama di China untuk menjadikan "suapan data yang dijana model itu sendiri" menjadi kenyataan. Selain itu, ia merupakan pendekatan serampang dua mata dari segi pemahaman dan sisi penjanaan Kedua-dua pihak boleh menjana data baharu berbilang modal yang berkualiti tinggi dan memberikan maklum balas data kepada model itu sendiri. Apakah model? Awaker 1.0, model berbilang modal besar yang baru sahaja muncul di Forum Zhongguancun. Siapa pasukan itu? Enjin Sophon. Diasaskan oleh Gao Yizhao, pelajar kedoktoran di Sekolah Kecerdasan Buatan Hillhouse Universiti Renmin.

Tentera Udara A.S. mempamerkan jet pejuang AI pertamanya dengan profil tinggi! Menteri secara peribadi menjalankan pandu uji tanpa campur tangan semasa keseluruhan proses, dan 100,000 baris kod telah diuji selama 21 kali.

May 07, 2024 pm 05:00 PM

Tentera Udara A.S. mempamerkan jet pejuang AI pertamanya dengan profil tinggi! Menteri secara peribadi menjalankan pandu uji tanpa campur tangan semasa keseluruhan proses, dan 100,000 baris kod telah diuji selama 21 kali.

May 07, 2024 pm 05:00 PM

Baru-baru ini, bulatan tentera telah terharu dengan berita: jet pejuang tentera AS kini boleh melengkapkan pertempuran udara automatik sepenuhnya menggunakan AI. Ya, baru-baru ini, jet pejuang AI tentera AS telah didedahkan buat pertama kali, mendedahkan misterinya. Nama penuh pesawat pejuang ini ialah Variable Stability Simulator Test Aircraft (VISTA). Ia diterbangkan sendiri oleh Setiausaha Tentera Udara AS untuk mensimulasikan pertempuran udara satu lawan satu. Pada 2 Mei, Setiausaha Tentera Udara A.S. Frank Kendall berlepas menggunakan X-62AVISTA di Pangkalan Tentera Udara Edwards Ambil perhatian bahawa semasa penerbangan selama satu jam, semua tindakan penerbangan telah diselesaikan secara autonomi oleh AI! Kendall berkata - "Sejak beberapa dekad yang lalu, kami telah memikirkan tentang potensi tanpa had pertempuran udara-ke-udara autonomi, tetapi ia sentiasa kelihatan di luar jangkauan." Namun kini,