Pika Peking University dan Stanford bekerjasama untuk sumber terbukarangka kerja penjanaan/penyuntingan imej teks terkini!

Tanpa latihan tambahan, model resapan boleh mempunyai keupayaan pemahaman perkataan segera yang lebih kukuh.

Dihadapkan dengan kata-kata pantas yang panjang dan kompleks, ketepatannya lebih tinggi, butirannya dikawal dengan lebih baik, dan gambar yang dihasilkan lebih semula jadi.

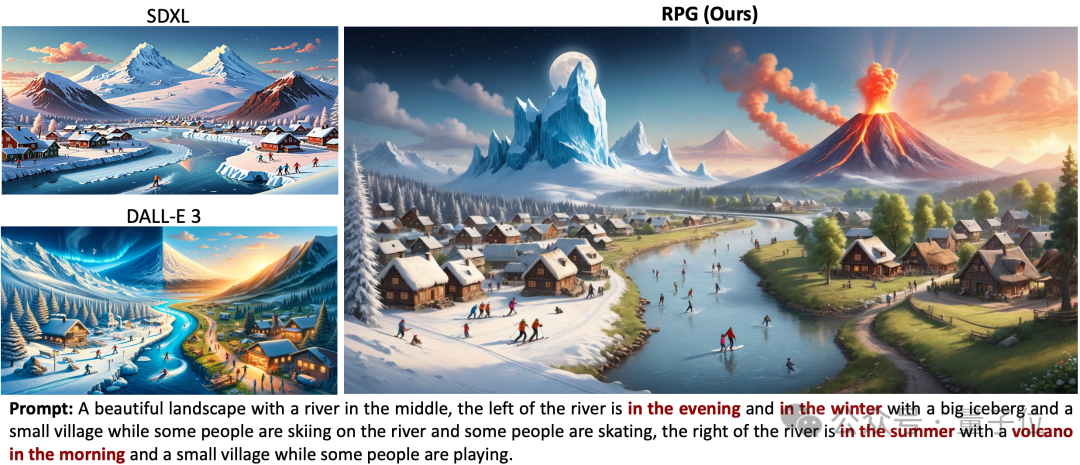

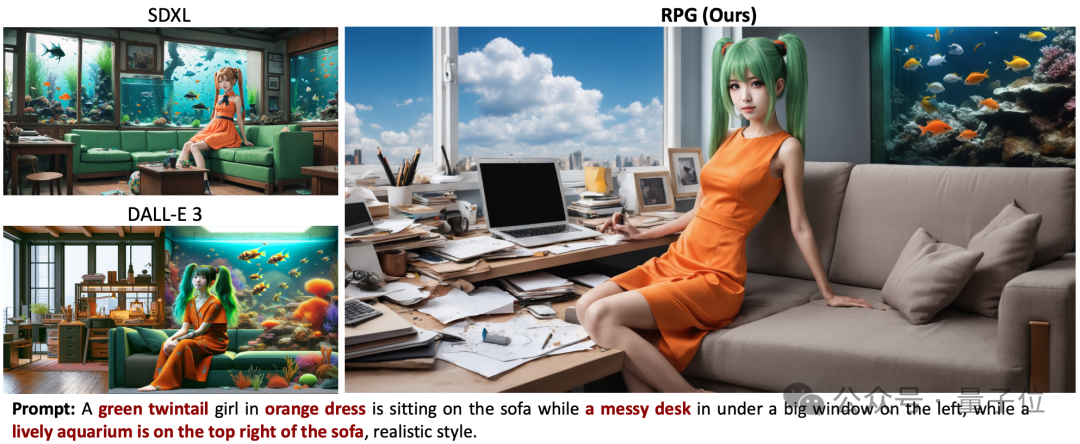

Kesannya mengatasi model penjanaan imej terkuat Dall·E 3 dan SDXL.

Sebagai contoh, gambar dikehendaki mempunyai dua lapisan ais dan api di kiri dan kanan, dengan bongkah ais di sebelah kiri dan gunung berapi di sebelah kanan.

SDXL sama sekali tidak memenuhi keperluan perkataan segera, dan Dall·E 3 tidak menjana butiran gunung berapi.

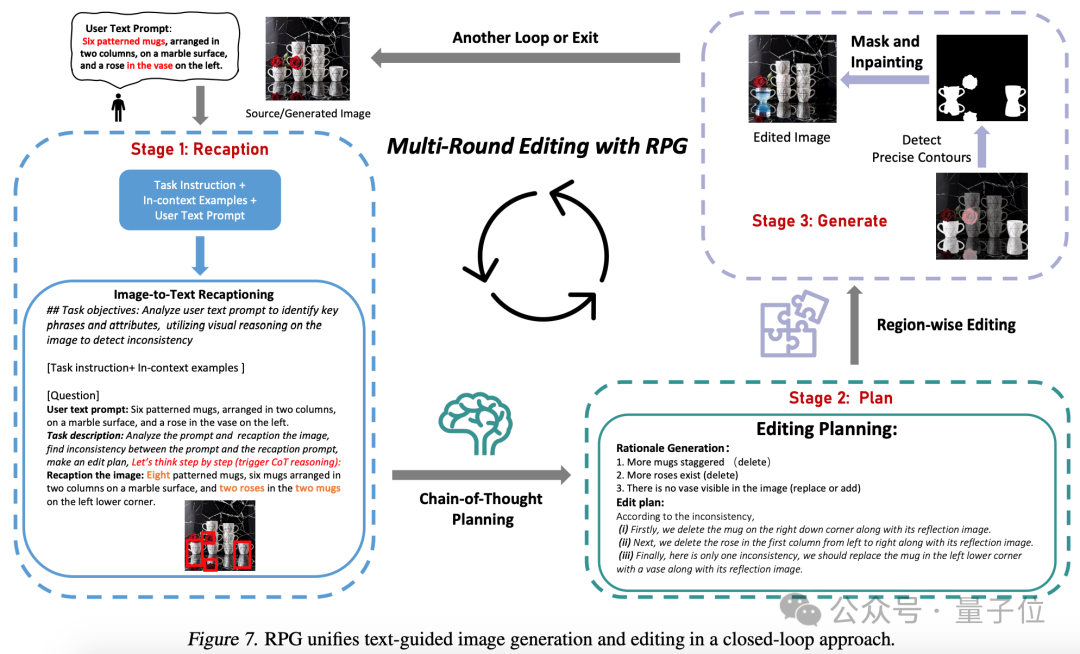

Anda juga boleh menjana suntingan kedua bagi imej melalui pasangan perkataan yang segera.

Ini ialah rangka kerja penjanaan/penyuntingan imej teks RPG (Recaption, Plan and Generate), yang telah menyebabkan perbincangan hangat di Internet.

Ia dibangunkan bersama oleh Universiti Peking, Stanford dan Pika. Penulis termasuk Profesor Cui Bin dari Sekolah Sains Komputer di Universiti Peking, Chenlin Meng, pengasas bersama dan CTO Pika, dsb.

Kod rangka kerja semasa ialah sumber terbuka dan serasi dengan pelbagai model besar berbilang modal (seperti MiniGPT-4) dan rangkaian tulang belakang model penyebaran (seperti ControlNet).

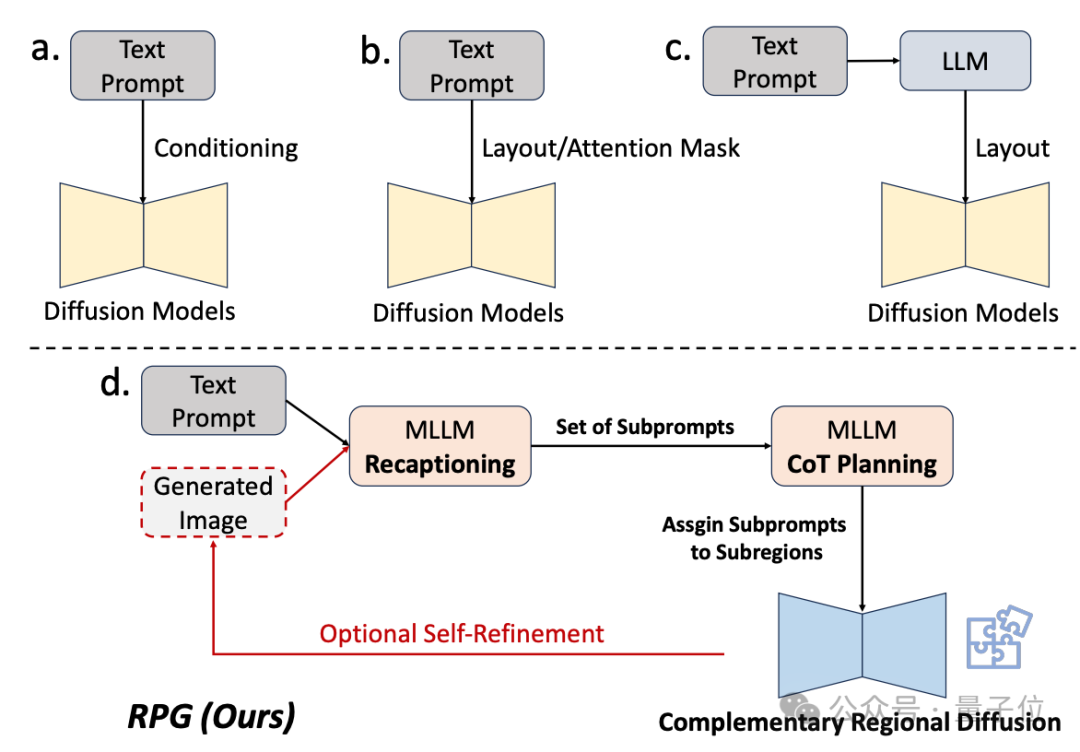

Sejak sekian lama, model resapan agak lemah dalam memahami perkataan gesaan yang kompleks.

Sesetengah kaedah penambahbaikan sedia ada sama ada tidak mencapai hasil yang cukup baik pada akhirnya, atau memerlukan latihan tambahan.

Oleh itu, pasukan penyelidik menggunakan keupayaan pemahaman model besar berbilang modal untuk meningkatkan gabungan dan kebolehkawalan model penyebaran.

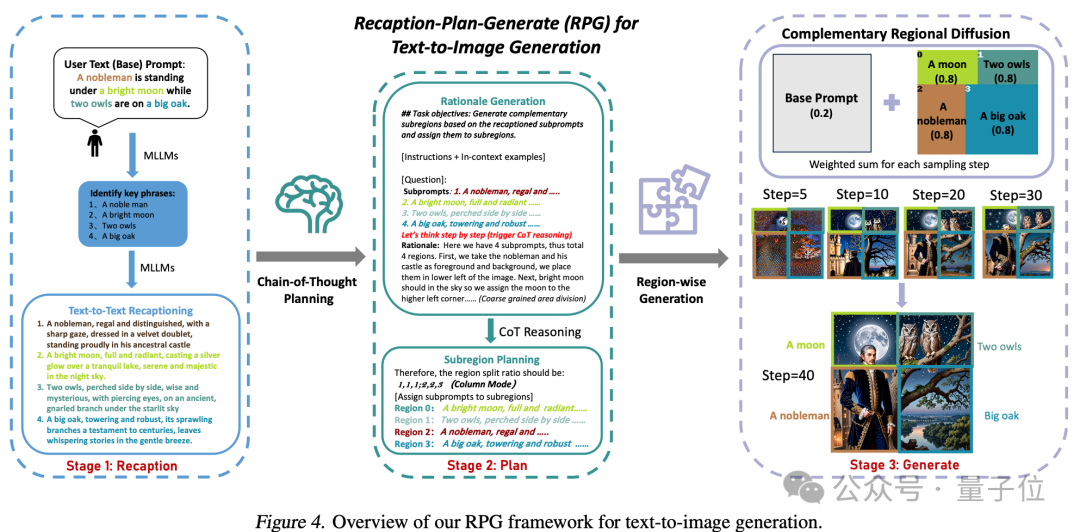

Seperti yang dapat dilihat dari nama rangka kerja, ia membenarkan model untuk "menggambarkan semula, merancang dan menjana". Strategi teras kaedah ini mempunyai tiga aspek:

1. keupayaan model resapan untuk memahami perkataan segera.

1. keupayaan model resapan untuk memahami perkataan segera.

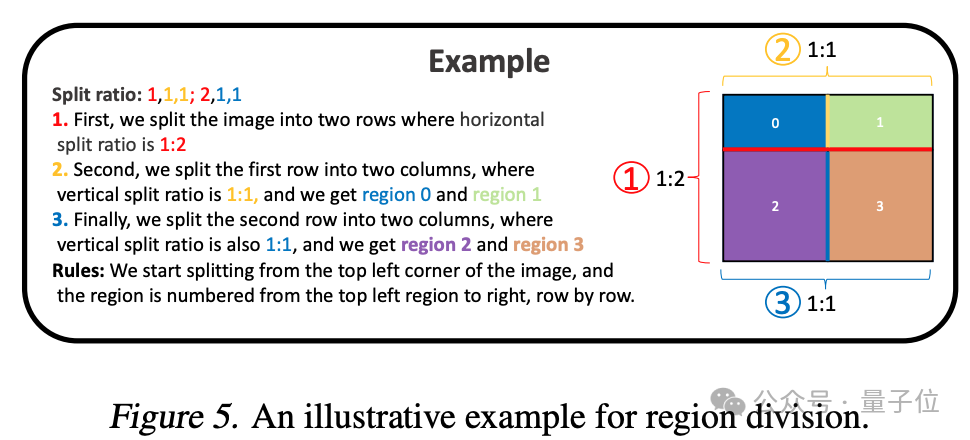

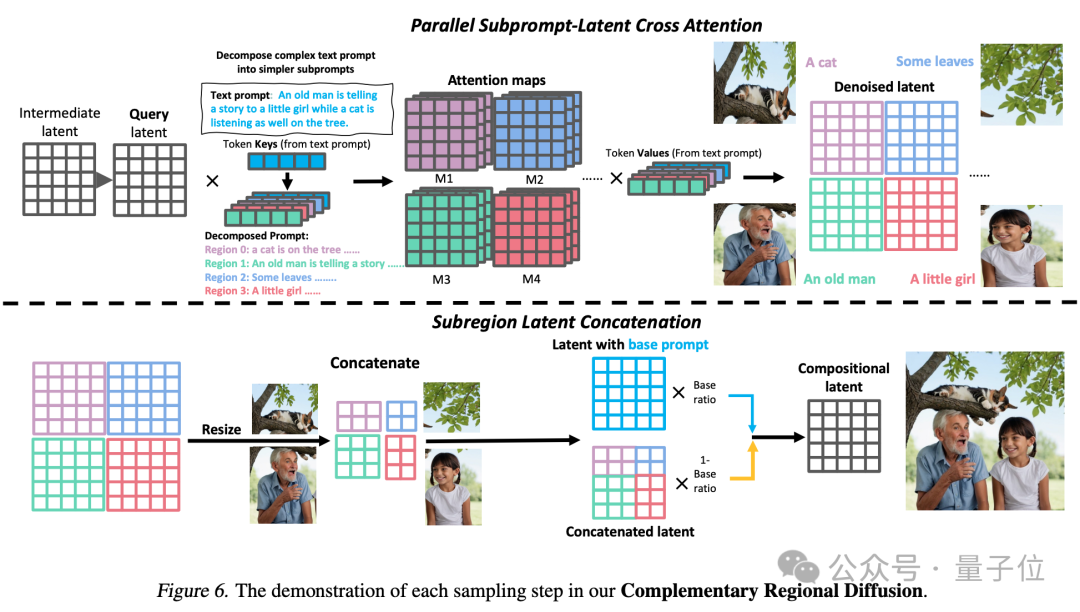

(Perancangan Rantaian Pemikiran): Gunakan keupayaan penaakulan rantaian pemikiran model besar berbilang mod untuk membahagikan ruang imej kepada sub-rantau yang saling melengkapi dan memadankan sub-rantau yang berbeza -gesaan untuk setiap sub-rantau , menguraikan tugas penjanaan yang kompleks kepada berbilang tugas penjanaan yang lebih mudah.

3. Resapan Serantau Pelengkap: Selepas membahagikan ruang, kawasan tidak bertindih menjana imej berdasarkan sub-promp dan kemudian sambungkannya.

Akhir sekali, gambar akan dihasilkan yang lebih memenuhi keperluan perkataan segera.

Rangka kerja RPG juga boleh menggunakan postur, kedalaman dan maklumat lain untuk penjanaan imej.

Rangka kerja RPG juga boleh menggunakan postur, kedalaman dan maklumat lain untuk penjanaan imej.

Berbanding dengan ControlNet, RPG boleh memisahkan perkataan gesaan input.

Input pengguna: Di dalam bilik yang terang, berdiri seorang gadis cantik berambut hitam memakai gaun rasmi lengan panjang berwarna champagne dengan mata tertutup. Sebuah pasu biru halus dengan bunga ros merah jambu terletak di sebelah kiri bilik, dan beberapa bunga mawar putih yang bersemangat di sebelah kanan.

juga boleh mencapai penjanaan dan penyuntingan imej gelung tertutup.

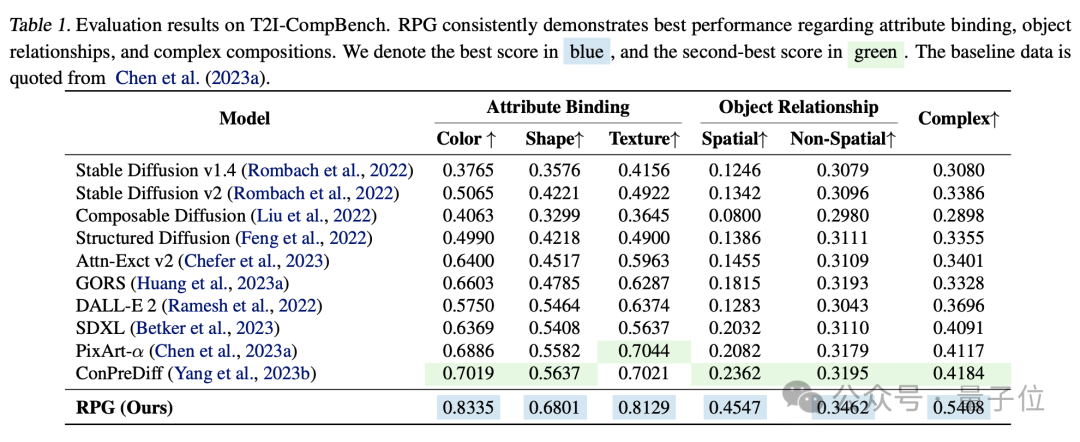

Perbandingan eksperimen menunjukkan bahawa RPG mengatasi model penjanaan imej lain dalam dimensi seperti warna, bentuk, ruang dan ketepatan teks.

Kajian ini mempunyai dua pengarang bersama, Ling Yang dan Zhaochen Yu, kedua-duanya dari Universiti Peking.

Pengarang yang mengambil bahagian termasuk Chenlin Meng, pengasas bersama dan CTO syarikat permulaan AI Pika.

Beliau mempunyai PhD dalam sains komputer dari Stanford dan mempunyai pengalaman akademik yang kaya dalam penglihatan komputer dan penglihatan 3D Beliau mengambil bahagian dalam kertas Denoising Diffusion Implicit Model (DDIM), yang kini mempunyai lebih daripada 1,700 petikan dalam satu artikel. Sebilangan artikel penyelidikan berkaitan AI generatif telah diterbitkan di persidangan teratas seperti ICLR, NeurIPS, CVPR dan ICML, dan kebanyakannya telah dipilih ke dalam Lisan.

Tahun lepas, Pika menjadi popular segera dengan produk penjanaan video AI Pika 1.0 Latar belakang penubuhannya oleh dua PhD wanita Cina dari Stanford menjadikannya lebih menarik perhatian.

△Di sebelah kiri ialah Guo Wenjing (CEO Pika), di sebelah kanan ialah Chenlin Meng

Turut mengambil bahagian dalam penyelidikan itu ialah Profesor Cui Bin, timbalan dekan Pusat Pengajian Sains Komputer di Universiti Peking, yang juga pengarah Institut Sains Data dan Kejuruteraan.

Alamat kertas: https://arxiv.org/abs/2401.11708

Alamat kod: https://github.com/YangLing0818/RPG-DiffusionMaster

Atas ialah kandungan terperinci Menggunakan LLM untuk meningkatkan pemahaman, Pika, rangka kerja sumber terbuka baharu dari Universiti Peking dan Stanford, memberikan pemahaman yang lebih mendalam tentang model resapan kata cepat yang kompleks.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Apakah kemahiran yang diperlukan untuk bekerja dalam industri PHP?

Apakah kemahiran yang diperlukan untuk bekerja dalam industri PHP?

Tiga kaedah pengekodan yang biasa digunakan

Tiga kaedah pengekodan yang biasa digunakan

Cara menutup pustaka sumber apl

Cara menutup pustaka sumber apl

rgb kepada rgb perenambelasan

rgb kepada rgb perenambelasan

aplikasi pertukaran okex

aplikasi pertukaran okex

Cara membuat animasi gif dalam ps

Cara membuat animasi gif dalam ps

Langkah WeChat

Langkah WeChat

Bagaimana untuk menyelesaikan masalah yang tidak dapat disambungkan oleh teamviewer

Bagaimana untuk menyelesaikan masalah yang tidak dapat disambungkan oleh teamviewer

Kaedah pemindahan pangkalan data MySQL

Kaedah pemindahan pangkalan data MySQL