Bagaimana untuk membina rangkaian saraf menggunakan TensorFlow

TensorFlow ialah rangka kerja pembelajaran mesin yang popular digunakan untuk melatih dan menggunakan pelbagai rangkaian saraf. Artikel ini membincangkan cara menggunakan TensorFlow untuk membina rangkaian saraf yang ringkas dan menyediakan kod sampel untuk memulakan anda.

Langkah pertama dalam membina rangkaian neural adalah untuk menentukan struktur rangkaian. Dalam TensorFlow, kita boleh menggunakan modul tf.keras untuk mentakrifkan lapisan rangkaian saraf. Contoh kod berikut mentakrifkan rangkaian neural suapan hadapan yang disambungkan sepenuhnya dengan dua lapisan tersembunyi dan lapisan keluaran: ```python import aliran tensor astf model = tf.keras.models.Sequential([ tf.keras.layers.Dense(unit=64, activation='relu', input_shape=(input_dim,)), tf.keras.layers.Dense(unit=32, activation='relu'), tf.keras.layers.Dense(units=output_dim, activation='softmax') ]) ``` Dalam kod di atas, kami menggunakan model `Sequential` untuk membina rangkaian saraf. Lapisan `Dense` mewakili lapisan yang bersambung sepenuhnya, menyatakan bilangan neuron (unit) dan fungsi pengaktifan (pengaktifan) setiap lapisan. Bentuk input lapisan tersembunyi pertama diberikan oleh `input_shape

import tensorflow as tf

model = tf.keras.Sequential([

tf.keras.layers.Dense(64, activation='relu', input_shape=(784,)),

tf.keras.layers.Dense(64, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])Dalam contoh ini, kami menggunakan model Sequential untuk menentukan rangkaian saraf kami. Ia adalah model susun ringkas di mana setiap lapisan dibina pada yang sebelumnya. Kami mentakrifkan tiga lapisan, lapisan pertama dan kedua kedua-duanya adalah lapisan bersambung sepenuhnya dengan 64 neuron, dan ia menggunakan fungsi pengaktifan ReLU. Bentuk lapisan input ialah (784,) kerana kami akan menggunakan set data digit tulisan tangan MNIST dan setiap imej dalam set data ini ialah 28x28 piksel, yang mengembang kepada 784 piksel. Lapisan terakhir ialah lapisan bersambung sepenuhnya dengan 10 neuron, yang menggunakan fungsi pengaktifan softmax dan digunakan untuk tugas pengelasan seperti klasifikasi digit dalam set data MNIST.

Kita perlu menyusun model dan menentukan pengoptimuman, fungsi kerugian dan metrik penilaian. Berikut ialah contoh:

model.compile(optimizer='adam',

loss='categorical_crossentropy',

metrics=['accuracy'])Dalam contoh ini, kami menggunakan pengoptimum Adam untuk melatih model kami menggunakan entropi silang sebagai fungsi kehilangan untuk masalah pengelasan berbilang kelas. Kami juga menyatakan ketepatan sebagai metrik penilaian untuk menjejak prestasi model semasa latihan dan penilaian.

Sekarang kita telah menentukan struktur dan konfigurasi latihan model, kita boleh membaca data dan mula melatih model. Kami akan menggunakan set data digit tulisan tangan MNIST sebagai contoh. Berikut ialah contoh kod:

from tensorflow.keras.datasets import mnist (train_images, train_labels), (test_images, test_labels) = mnist.load_data() train_images = train_images.reshape((60000, 784)) train_images = train_images.astype('float32') / 255 test_images = test_images.reshape((10000, 784)) test_images = test_images.astype('float32') / 255 train_labels = tf.keras.utils.to_categorical(train_labels) test_labels = tf.keras.utils.to_categorical(test_labels) model.fit(train_images, train_labels, epochs=5, batch_size=64)

Dalam contoh ini, kami memuatkan set data MNIST menggunakan fungsi mnist.load_data(). Kami kemudian meratakan latihan dan menguji imej kepada 784 piksel dan menskalakan nilai piksel menjadi antara 0 dan 1. Kami juga mengekod satu-panas label untuk menukarnya menjadi tugas pengelasan. Akhir sekali, kami menggunakan fungsi muat untuk melatih model kami, menggunakan imej latihan dan label, menentukan latihan untuk 5 zaman, menggunakan 64 sampel untuk setiap zaman.

Selepas latihan selesai, kita boleh menggunakan fungsi menilai untuk menilai prestasi model pada set ujian:

test_loss, test_acc = model.evaluate(test_images, test_labels) print('Test accuracy:', test_acc)

Dalam contoh ini, kita memanggil fungsi menilai dengan imej dan label ujian, dan mencetak keputusan untuk ditunjukkan prestasi model pada ketepatan set ujian pada set.

Ini adalah contoh mudah cara membina dan melatih rangkaian saraf menggunakan TensorFlow. Sudah tentu, dalam aplikasi sebenar, anda mungkin memerlukan struktur rangkaian yang lebih kompleks dan set data yang lebih kompleks. Walau bagaimanapun, contoh ini menyediakan titik permulaan yang baik untuk membantu anda memahami penggunaan asas TensorFlow.

Contoh kod lengkap adalah seperti berikut:

import tensorflow as tf

from tensorflow.keras.datasets import mnist

# Define the model architecture

model = tf.keras.Sequential([

tf.keras.layers.Dense(64, activation='relu', input_shape=(784,)),

tf.keras.layers.Dense(64, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# Compile the model

model.compile(optimizer='adam',

loss='categorical_crossentropy',

metrics=['accuracy'])

# Load the data

(train_images, train_labels), (test_images, test_labels) = mnist.load_data()

train_images = train_images.reshape((60000, 784))

train_images = train_images.astype('float32') / 255

test_images = test_images.reshape((10000, 784))

test_images = test_images.astype('float32') / 255

train_labels = tf.keras.utils.to_categorical(train_labels)

test_labels = tf.keras.utils.to_categorical(test_labels)

# Train the model

model.fit(train_images, train_labels, epochs=5, batch_size=64)

# Evaluate the model

test_loss, test_acc = model.evaluate(test_images, test_labels)

print('Test accuracy:', test_acc)Di atas ialah contoh kod untuk membina rangkaian saraf menggunakan TensorFlow, yang mentakrifkan rangkaian neural suapan ke hadapan bersambung sepenuhnya yang mengandungi dua lapisan tersembunyi dan satu lapisan keluaran, menggunakan MNIST data digit tulisan tangan Set dilatih dan diuji menggunakan pengoptimum Adam dan fungsi kehilangan entropi silang. Output akhir ialah ketepatan pada set ujian.

Atas ialah kandungan terperinci Bagaimana untuk membina rangkaian saraf menggunakan TensorFlow. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

Terokai konsep, perbezaan, kebaikan dan keburukan RNN, LSTM dan GRU

Jan 22, 2024 pm 07:51 PM

Terokai konsep, perbezaan, kebaikan dan keburukan RNN, LSTM dan GRU

Jan 22, 2024 pm 07:51 PM

Dalam data siri masa, terdapat kebergantungan antara pemerhatian, jadi ia tidak bebas antara satu sama lain. Walau bagaimanapun, rangkaian saraf tradisional menganggap setiap pemerhatian sebagai bebas, yang mengehadkan keupayaan model untuk memodelkan data siri masa. Untuk menyelesaikan masalah ini, Rangkaian Neural Berulang (RNN) telah diperkenalkan, yang memperkenalkan konsep ingatan untuk menangkap ciri dinamik data siri masa dengan mewujudkan kebergantungan antara titik data dalam rangkaian. Melalui sambungan berulang, RNN boleh menghantar maklumat sebelumnya ke dalam pemerhatian semasa untuk meramalkan nilai masa hadapan dengan lebih baik. Ini menjadikan RNN alat yang berkuasa untuk tugasan yang melibatkan data siri masa. Tetapi bagaimanakah RNN mencapai ingatan seperti ini? RNN merealisasikan ingatan melalui gelung maklum balas dalam rangkaian saraf Ini adalah perbezaan antara RNN dan rangkaian saraf tradisional.

Kajian kes menggunakan model LSTM dwiarah untuk pengelasan teks

Jan 24, 2024 am 10:36 AM

Kajian kes menggunakan model LSTM dwiarah untuk pengelasan teks

Jan 24, 2024 am 10:36 AM

Model LSTM dwiarah ialah rangkaian saraf yang digunakan untuk pengelasan teks. Berikut ialah contoh mudah yang menunjukkan cara menggunakan LSTM dwiarah untuk tugasan pengelasan teks. Pertama, kita perlu mengimport perpustakaan dan modul yang diperlukan: importosimportnumpyasnpfromkeras.preprocessing.textimportTokenizerfromkeras.preprocessing.sequenceimportpad_sequencesfromkeras.modelsimportSequentialfromkeras.layersimportDense,Em

Mengira operan titik terapung (FLOPS) untuk rangkaian saraf

Jan 22, 2024 pm 07:21 PM

Mengira operan titik terapung (FLOPS) untuk rangkaian saraf

Jan 22, 2024 pm 07:21 PM

FLOPS ialah salah satu piawaian untuk penilaian prestasi komputer, digunakan untuk mengukur bilangan operasi titik terapung sesaat. Dalam rangkaian saraf, FLOPS sering digunakan untuk menilai kerumitan pengiraan model dan penggunaan sumber pengkomputeran. Ia adalah penunjuk penting yang digunakan untuk mengukur kuasa pengkomputeran dan kecekapan komputer. Rangkaian saraf ialah model kompleks yang terdiri daripada berbilang lapisan neuron yang digunakan untuk tugas seperti klasifikasi data, regresi dan pengelompokan. Latihan dan inferens rangkaian saraf memerlukan sejumlah besar pendaraban matriks, konvolusi dan operasi pengiraan lain, jadi kerumitan pengiraan adalah sangat tinggi. FLOPS (FloatingPointOperationsperSecond) boleh digunakan untuk mengukur kerumitan pengiraan rangkaian saraf untuk menilai kecekapan penggunaan sumber pengiraan model. FLOP

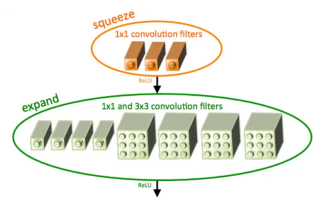

Pengenalan kepada SqueezeNet dan ciri-cirinya

Jan 22, 2024 pm 07:15 PM

Pengenalan kepada SqueezeNet dan ciri-cirinya

Jan 22, 2024 pm 07:15 PM

SqueezeNet ialah algoritma kecil dan tepat yang memberikan keseimbangan yang baik antara ketepatan tinggi dan kerumitan rendah, menjadikannya sesuai untuk sistem mudah alih dan terbenam dengan sumber terhad. Pada 2016, penyelidik dari DeepScale, University of California, Berkeley, dan Stanford University mencadangkan SqueezeNet, rangkaian neural convolutional (CNN) yang padat dan cekap. Dalam beberapa tahun kebelakangan ini, penyelidik telah membuat beberapa penambahbaikan pada SqueezeNet, termasuk SqueezeNetv1.1 dan SqueezeNetv2.0. Penambahbaikan dalam kedua-dua versi bukan sahaja meningkatkan ketepatan tetapi juga mengurangkan kos pengiraan. Ketepatan SqueezeNetv1.1 pada dataset ImageNet

Definisi dan analisis struktur rangkaian neural kabur

Jan 22, 2024 pm 09:09 PM

Definisi dan analisis struktur rangkaian neural kabur

Jan 22, 2024 pm 09:09 PM

Rangkaian saraf kabur ialah model hibrid yang menggabungkan logik kabur dan rangkaian saraf untuk menyelesaikan masalah kabur atau tidak pasti yang sukar dikendalikan dengan rangkaian saraf tradisional. Reka bentuknya diilhamkan oleh kekaburan dan ketidakpastian dalam kognisi manusia, jadi ia digunakan secara meluas dalam sistem kawalan, pengecaman corak, perlombongan data dan bidang lain. Seni bina asas rangkaian neural kabur terdiri daripada subsistem kabur dan subsistem saraf. Subsistem kabur menggunakan logik kabur untuk memproses data input dan menukarnya kepada set kabur untuk menyatakan kekaburan dan ketidakpastian data input. Subsistem saraf menggunakan rangkaian saraf untuk memproses set kabur untuk tugasan seperti pengelasan, regresi atau pengelompokan. Interaksi antara subsistem kabur dan subsistem saraf menjadikan rangkaian neural kabur mempunyai keupayaan pemprosesan yang lebih berkuasa dan boleh

Penghapusan imej menggunakan rangkaian saraf konvolusi

Jan 23, 2024 pm 11:48 PM

Penghapusan imej menggunakan rangkaian saraf konvolusi

Jan 23, 2024 pm 11:48 PM

Rangkaian neural konvolusi berfungsi dengan baik dalam tugasan menghilangkan imej. Ia menggunakan penapis yang dipelajari untuk menapis bunyi dan dengan itu memulihkan imej asal. Artikel ini memperkenalkan secara terperinci kaedah denoising imej berdasarkan rangkaian neural convolutional. 1. Gambaran Keseluruhan Rangkaian Neural Konvolusi Rangkaian saraf konvolusi ialah algoritma pembelajaran mendalam yang menggunakan gabungan berbilang lapisan konvolusi, lapisan gabungan dan lapisan bersambung sepenuhnya untuk mempelajari dan mengelaskan ciri imej. Dalam lapisan konvolusi, ciri tempatan imej diekstrak melalui operasi konvolusi, dengan itu menangkap korelasi spatial dalam imej. Lapisan pengumpulan mengurangkan jumlah pengiraan dengan mengurangkan dimensi ciri dan mengekalkan ciri utama. Lapisan bersambung sepenuhnya bertanggungjawab untuk memetakan ciri dan label yang dipelajari untuk melaksanakan pengelasan imej atau tugas lain. Reka bentuk struktur rangkaian ini menjadikan rangkaian neural konvolusi berguna dalam pemprosesan dan pengecaman imej.

Bandingkan persamaan, perbezaan dan hubungan antara lilitan diluaskan dan lilitan atrus

Jan 22, 2024 pm 10:27 PM

Bandingkan persamaan, perbezaan dan hubungan antara lilitan diluaskan dan lilitan atrus

Jan 22, 2024 pm 10:27 PM

Konvolusi diluaskan dan lilitan diluaskan adalah operasi yang biasa digunakan dalam rangkaian neural konvolusi Artikel ini akan memperkenalkan perbezaan dan hubungannya secara terperinci. 1. Konvolusi diluaskan Konvolusi diluaskan, juga dikenali sebagai lilitan diluaskan atau lilitan diluaskan, ialah operasi dalam rangkaian neural konvolusi. Ia adalah lanjutan berdasarkan operasi lilitan tradisional dan meningkatkan medan penerimaan kernel lilitan dengan memasukkan lubang dalam kernel lilitan. Dengan cara ini, rangkaian boleh menangkap lebih banyak ciri yang lebih luas. Konvolusi dilatasi digunakan secara meluas dalam bidang pemprosesan imej dan boleh meningkatkan prestasi rangkaian tanpa menambah bilangan parameter dan jumlah pengiraan. Dengan meluaskan medan penerimaan kernel lilitan, lilitan diluaskan boleh memproses maklumat global dalam imej dengan lebih baik, sekali gus meningkatkan kesan pengekstrakan ciri. Idea utama lilitan diluaskan adalah untuk memperkenalkan beberapa

rangkaian neural convolutional sebab

Jan 24, 2024 pm 12:42 PM

rangkaian neural convolutional sebab

Jan 24, 2024 pm 12:42 PM

Rangkaian neural convolutional kausal ialah rangkaian neural convolutional khas yang direka untuk masalah kausalitas dalam data siri masa. Berbanding dengan rangkaian neural convolutional konvensional, rangkaian neural convolutional kausal mempunyai kelebihan unik dalam mengekalkan hubungan kausal siri masa dan digunakan secara meluas dalam ramalan dan analisis data siri masa. Idea teras rangkaian neural convolutional kausal adalah untuk memperkenalkan kausalitas dalam operasi konvolusi. Rangkaian saraf konvolusional tradisional boleh melihat data secara serentak sebelum dan selepas titik masa semasa, tetapi dalam ramalan siri masa, ini mungkin membawa kepada masalah kebocoran maklumat. Kerana keputusan ramalan pada titik masa semasa akan dipengaruhi oleh data pada titik masa akan datang. Rangkaian saraf konvolusi penyebab menyelesaikan masalah ini Ia hanya dapat melihat titik masa semasa dan data sebelumnya, tetapi tidak dapat melihat data masa depan.