Java

Java

javaTutorial

javaTutorial

Penjelasan terperinci tentang parameter arahan permulaan Kafka dan cadangan pengoptimuman

Penjelasan terperinci tentang parameter arahan permulaan Kafka dan cadangan pengoptimuman

Penjelasan terperinci tentang parameter arahan permulaan Kafka dan cadangan pengoptimuman

. > ialah perintah permulaan Parameter, config.file ialah fail konfigurasi Kafka.

-port: Tentukan nombor port yang Kafka dengar. Nombor port lalai ialah 9092. -log.dirs: Tentukan direktori storan untuk fail log Kafka.

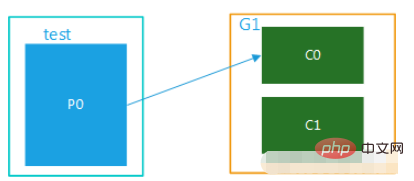

-zookeeper.connect: Tentukan alamat tempat Kafka bersambung ke ZooKeeper. -broker.id: Nyatakan ID broker Kafka. -num.partitions: Tentukan bilangan partition untuk setiap topik. -replication.factor: Menentukan bilangan replika setiap topik.

-min.insync.replicas: Menentukan bilangan minimum replika disegerakkan bagi setiap topik. options是启动命令的参数,config.file是Kafka配置文件。

常见的启动命令参数有:

-

-daemon: 以守护进程的方式启动Kafka。 -

-port: 指定Kafka监听的端口号。默认端口号为9092。 -

-log.dirs: 指定Kafka日志文件的存储目录。 -

-zookeeper.connect: 指定Kafka连接ZooKeeper的地址。 -

-broker.id: 指定Kafka代理的ID。 -

-num.partitions: 指定每个主题的分区数。 -

-replication.factor: 指定每个主题的副本数。 -

-min.insync.replicas: 指定每个主题的最小同步副本数。

2. 启动命令参数优化

为了提高Kafka的性能,我们可以对启动命令参数进行优化。

常见的优化参数有:

-

-num.io.threads: 指定Kafka处理IO请求的线程数。默认值为8。 -

-num.network.threads: 指定Kafka处理网络请求的线程数。默认值为8。 -

-num.replica.fetchers: 指定每个副本从领导者副本获取数据的线程数。默认值为1。 -

-num.replica.alter.log.dirs.threads: 指定更改副本日志文件存储目录的线程数。默认值为1。 -

-socket.send.buffer.bytes: 指定Kafka发送数据的套接字缓冲区大小。默认值为102400。 -

-socket.receive.buffer.bytes: 指定Kafka接收数据的套接字缓冲区大小。默认值为102400。 -

-log.segment.bytes: 指定Kafka日志分段的大小。默认值为1073741824。 -

-log.retention.hours: 指定Kafka日志保留的小时数。默认值为24。 -log.retention.minutes2. Pengoptimuman parameter arahan permulaan

Untuk meningkatkan prestasi Kafka, kami boleh mengoptimumkan parameter arahan permulaan.

Parameter pengoptimuman biasa ialah:

-

-num.io.threads: Tentukan bilangan utas yang digunakan oleh Kafka untuk memproses permintaan IO. Nilai lalai ialah 8.-num.network.threads: Tentukan bilangan utas yang digunakan oleh Kafka untuk memproses permintaan rangkaian. Nilai lalai ialah 8. -

-num.replica.fetchers: Menentukan bilangan urutan untuk setiap replika untuk mengambil data daripada replika ketua. Nilai lalai ialah 1. -

-num.replica.alter.log.dirs.threads: Tentukan bilangan utas untuk menukar direktori tempat fail log replika disimpan. Nilai lalai ialah 1. -

-socket.send.buffer.bytes: Menentukan saiz penimbal soket untuk Kafka menghantar data. Nilai lalai ialah 102400. -

-socket.receive.buffer.bytes: Menentukan saiz penimbal soket untuk Kafka menerima data. Nilai lalai ialah 102400. 🎜 -

-log.segment.bytes: Tentukan saiz segmen log Kafka. Nilai lalai ialah 1073741824. 🎜 -

-log.retention.hours: Tentukan bilangan jam untuk pengekalan log Kafka. Nilai lalai ialah 24. 🎜 -

-log.retention.minutes: Tentukan bilangan minit untuk pengekalan log Kafka. Nilai lalai ialah 0. 🎜🎜🎜🎜3. Contoh kod🎜🎜🎜Berikut ialah contoh mengoptimumkan parameter arahan permulaan Kafka: 🎜🎜🎜4. Apabila mengoptimumkan parameter, mereka perlu diselaraskan mengikut keadaan sebenar. 🎜kafka-server-start.sh [options] [config.file]

Salin selepas log masuk

Atas ialah kandungan terperinci Penjelasan terperinci tentang parameter arahan permulaan Kafka dan cadangan pengoptimuman. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1382

1382

52

52

Bagaimana untuk melaksanakan analisis saham masa nyata menggunakan PHP dan Kafka

Jun 28, 2023 am 10:04 AM

Bagaimana untuk melaksanakan analisis saham masa nyata menggunakan PHP dan Kafka

Jun 28, 2023 am 10:04 AM

Dengan perkembangan Internet dan teknologi, pelaburan digital telah menjadi topik yang semakin membimbangkan. Ramai pelabur terus meneroka dan mengkaji strategi pelaburan, dengan harapan memperoleh pulangan pelaburan yang lebih tinggi. Dalam perdagangan saham, analisis saham masa nyata adalah sangat penting untuk membuat keputusan, dan penggunaan baris gilir mesej masa nyata Kafka dan teknologi PHP adalah cara yang cekap dan praktikal. 1. Pengenalan kepada Kafka Kafka ialah sistem pemesejan terbitan dan langgan yang diedarkan tinggi yang dibangunkan oleh LinkedIn. Ciri-ciri utama Kafka ialah

Cara untuk menentukan berbilang topik secara dinamik dengan @KafkaListener dalam springboot+kafka

May 20, 2023 pm 08:58 PM

Cara untuk menentukan berbilang topik secara dinamik dengan @KafkaListener dalam springboot+kafka

May 20, 2023 pm 08:58 PM

Jelaskan bahawa projek ini ialah projek penyepaduan springboot+kafak, jadi ia menggunakan anotasi penggunaan @KafkaListener untuk kafak dalam springboot Pertama, konfigurasikan berbilang topik yang dipisahkan dengan koma dalam application.properties. Kaedah: Gunakan ungkapan SpEl Spring untuk mengkonfigurasi topik sebagai: @KafkaListener(topics="#{'${topics}'.split(',')}") untuk menjalankan program Kesan pencetakan konsol adalah seperti berikut

Bagaimana SpringBoot menyepadukan kelas alat konfigurasi Kafka

May 12, 2023 pm 09:58 PM

Bagaimana SpringBoot menyepadukan kelas alat konfigurasi Kafka

May 12, 2023 pm 09:58 PM

spring-kafka adalah berdasarkan integrasi versi java bagi kafkaclient dan spring Ia menyediakan KafkaTemplate, yang merangkumi pelbagai kaedah untuk operasi mudah Ia merangkum kafka-klien, dan tidak perlu mengimport klien untuk bergantung pada org. .springframework.kafkaspring-kafkaYML konfigurasi kafka:#bootstrap-servers:server1:9092,server2:9093#alamat pembangunan kafka,#producer configuration producer:#serialisasi dan kunci kelas penyahserilan disediakan oleh Kafka

Cara membina aplikasi pemprosesan data masa nyata menggunakan React dan Apache Kafka

Sep 27, 2023 pm 02:25 PM

Cara membina aplikasi pemprosesan data masa nyata menggunakan React dan Apache Kafka

Sep 27, 2023 pm 02:25 PM

Cara menggunakan React dan Apache Kafka untuk membina aplikasi pemprosesan data masa nyata Pengenalan: Dengan peningkatan data besar dan pemprosesan data masa nyata, membina aplikasi pemprosesan data masa nyata telah menjadi usaha ramai pembangun. Gabungan React, rangka kerja bahagian hadapan yang popular dan Apache Kafka, sistem pemesejan teragih berprestasi tinggi, boleh membantu kami membina aplikasi pemprosesan data masa nyata. Artikel ini akan memperkenalkan cara menggunakan React dan Apache Kafka untuk membina aplikasi pemprosesan data masa nyata, dan

Lima pilihan alat visualisasi untuk meneroka Kafka

Feb 01, 2024 am 08:03 AM

Lima pilihan alat visualisasi untuk meneroka Kafka

Feb 01, 2024 am 08:03 AM

Lima pilihan untuk alat visualisasi Kafka ApacheKafka ialah platform pemprosesan strim teragih yang mampu memproses sejumlah besar data masa nyata. Ia digunakan secara meluas untuk membina saluran paip data masa nyata, baris gilir mesej dan aplikasi dipacu peristiwa. Alat visualisasi Kafka boleh membantu pengguna memantau dan mengurus kelompok Kafka serta lebih memahami aliran data Kafka. Berikut ialah pengenalan kepada lima alat visualisasi Kafka yang popular: ConfluentControlCenterConfluent

Analisis perbandingan alat visualisasi kafka: Bagaimana untuk memilih alat yang paling sesuai?

Jan 05, 2024 pm 12:15 PM

Analisis perbandingan alat visualisasi kafka: Bagaimana untuk memilih alat yang paling sesuai?

Jan 05, 2024 pm 12:15 PM

Bagaimana untuk memilih alat visualisasi Kafka yang betul? Analisis perbandingan lima alat Pengenalan: Kafka ialah sistem baris gilir mesej teragih berprestasi tinggi dan tinggi yang digunakan secara meluas dalam bidang data besar. Dengan populariti Kafka, semakin banyak perusahaan dan pembangun memerlukan alat visual untuk memantau dan mengurus kelompok Kafka dengan mudah. Artikel ini akan memperkenalkan lima alat visualisasi Kafka yang biasa digunakan dan membandingkan ciri serta fungsinya untuk membantu pembaca memilih alat yang sesuai dengan keperluan mereka. 1. KafkaManager

Contoh kod untuk projek springboot untuk mengkonfigurasi berbilang kafka

May 14, 2023 pm 12:28 PM

Contoh kod untuk projek springboot untuk mengkonfigurasi berbilang kafka

May 14, 2023 pm 12:28 PM

1.spring-kafkaorg.springframework.kafkaspring-kafka1.3.5.RELEASE2. Maklumat berkaitan fail konfigurasi kafka.bootstrap-servers=localhost:9092kafka.consumer.group.id=20230321#Bilangan utas yang boleh digunakan secara serentak (biasanya dengan bilangan partition )kafka.consumer.concurrency=10kafka.consumer.enable.auto.commit=falsekafka.boo

Amalan go-zero dan Kafka+Avro: membina sistem pemprosesan data interaktif berprestasi tinggi

Jun 23, 2023 am 09:04 AM

Amalan go-zero dan Kafka+Avro: membina sistem pemprosesan data interaktif berprestasi tinggi

Jun 23, 2023 am 09:04 AM

Dalam tahun-tahun kebelakangan ini, dengan peningkatan data besar dan komuniti sumber terbuka yang aktif, semakin banyak perusahaan telah mula mencari sistem pemprosesan data interaktif berprestasi tinggi untuk memenuhi keperluan data yang semakin meningkat. Dalam gelombang peningkatan teknologi ini, go-zero dan Kafka+Avro sedang diberi perhatian dan diterima pakai oleh semakin banyak perusahaan. go-zero ialah rangka kerja mikroperkhidmatan yang dibangunkan berdasarkan bahasa Golang Ia mempunyai ciri-ciri prestasi tinggi, kemudahan penggunaan, pengembangan mudah dan penyelenggaraan yang mudah. Ia direka untuk membantu perusahaan membina sistem aplikasi perkhidmatan mikro yang cekap. pertumbuhannya yang pesat