Peranti teknologi

Peranti teknologi

AI

AI

Kertas tanpa nama menghasilkan idea yang mengejutkan! Ini sebenarnya boleh dilakukan untuk meningkatkan keupayaan teks panjang model besar

Kertas tanpa nama menghasilkan idea yang mengejutkan! Ini sebenarnya boleh dilakukan untuk meningkatkan keupayaan teks panjang model besar

Kertas tanpa nama menghasilkan idea yang mengejutkan! Ini sebenarnya boleh dilakukan untuk meningkatkan keupayaan teks panjang model besar

Dalam mempertingkatkan keupayaan teks panjang bagi model besar, adakah anda memikirkan ekstrapolasi panjang atau pengembangan tetingkap konteks?

Tidak, ini menggunakan terlalu banyak sumber perkakasan.

Mari kita lihat penyelesaian baharu yang hebat:

pada asasnya berbeza daripada cache KV yang digunakan oleh kaedah seperti ekstrapolasi panjang Ia menggunakan parameter model untuk menyimpan sejumlah besar maklumat konteks. .

Kaedah khusus adalah untuk membina modul Lora sementara, supaya hanya akan "strim kemas kini" semasa proses penjanaan teks panjang, iaitu, ia akan terus menggunakan kandungan yang dijana sebelum ini sebagai input untuk berfungsi sebagai data latihan, dengan itu memastikan Pengetahuan disimpan dalam parameter model.

Kemudian setelah inferens selesai, buang untuk memastikan tiada kesan jangka panjang pada parameter model.

Kaedah ini membolehkan kami menyimpan maklumat konteks seberapa banyak yang kami mahu tanpa mengembangkan tetingkap konteks Simpan seberapa banyak yang anda mahu.

Percubaan telah membuktikan bahawa kaedah ini:

- boleh meningkatkan kualiti tugasan teks panjang model dengan ketara, mencapai pengurangan 29.6% dalam kebingungan dan peningkatan 53.2% dalam kualiti terjemahan teks panjang (skor BIRU) ;

- juga boleh Serasi dengan dan meningkatkan kebanyakan kaedah penjanaan teks panjang sedia ada.

- Perkara yang paling penting ialah ia dapat mengurangkan kos pengkomputeran.

Sambil memastikan sedikit peningkatan dalam kualiti penjanaan (kebingungan dikurangkan sebanyak 3.8%), FLOP yang diperlukan untuk inferens dikurangkan sebanyak 70.5% dan kelewatan dikurangkan sebanyak 51.5%!

Untuk situasi khusus, mari buka kertas dan lihat.

Buat modul Lora sementara dan buang selepas digunakan

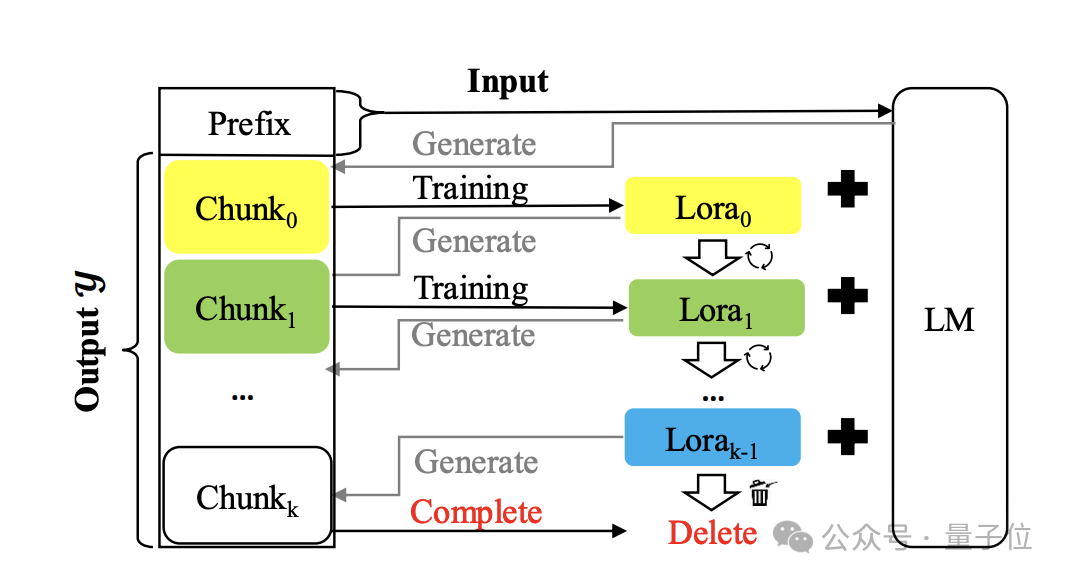

Kaedahnya dipanggil Temp-Lora Gambar rajah seni bina adalah seperti berikut:

Intinya adalah untuk menggunakan teks yang dihasilkan secara beransur-ansur. berlatih dengan cara autoregresif Modul Lora Sementara.

Modul ini sangat mudah disesuaikan dan boleh dilaraskan secara berterusan, jadi ia boleh mempunyai pemahaman mendalam tentang konteks jarak yang berbeza.

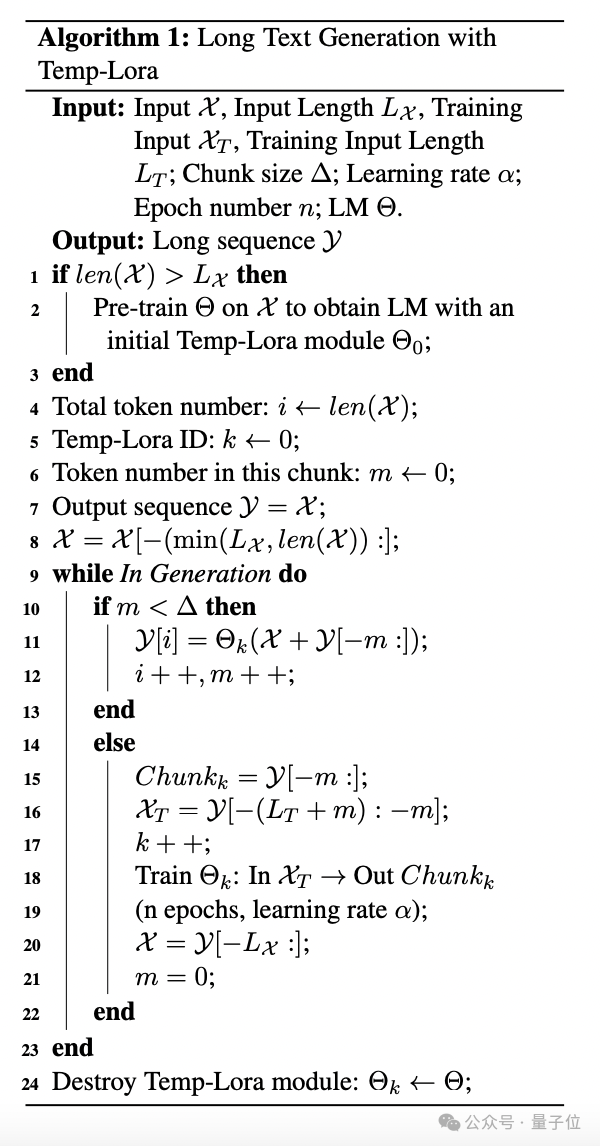

Algoritma khusus adalah seperti berikut:

Semasa proses penjanaan, token dijana blok demi blok. Setiap kali blok dijana, token Lx terbaharu digunakan sebagai input X untuk menjana token seterusnya.

Setelah bilangan token yang dijana mencapai saiz blok yang dipratentukan Δ, mulakan latihan modul Temp-Lora menggunakan blok terkini, dan kemudian mulakan generasi blok seterusnya.

Dalam percubaan, pengarang menetapkan Δ+Lx kepada W untuk menggunakan sepenuhnya saiz tetingkap konteks model.

Untuk latihan modul Temp-Lora, pembelajaran untuk menjana blok baharu tanpa sebarang syarat mungkin tidak membentuk sasaran latihan yang berkesan dan membawa kepada overfitting yang serius.

Untuk menyelesaikan masalah ini, penulis memasukkan tag LT di hadapan setiap blok ke dalam proses latihan, menggunakannya sebagai input dan blok sebagai output.

Akhir sekali, penulis juga mencadangkan strategi yang dipanggil Cache Reuse (Cache Reuse) untuk mencapai inferens yang lebih cekap.

Secara umumnya, selepas mengemas kini modul Temp-Loramo dalam rangka kerja standard, kita perlu mengira semula keadaan KV dengan parameter yang dikemas kini.

Sebagai alternatif, gunakan semula keadaan KV tembolok sedia ada semasa menggunakan model yang dikemas kini untuk penjanaan teks seterusnya.

Secara khusus, kami menggunakan modul Temp-Lora terkini untuk mengira semula keadaan KV hanya apabila model menjana panjang maksimum (saiz tetingkap konteks W).

Kaedah penggunaan semula cache sebegini boleh mempercepatkan penjanaan tanpa menjejaskan kualiti penjanaan dengan ketara.

Itu sahaja pengenalan kepada kaedah Temp-Lora Mari kita lihat ujian di bawah.

Semakin panjang teks, semakin baik kesannya

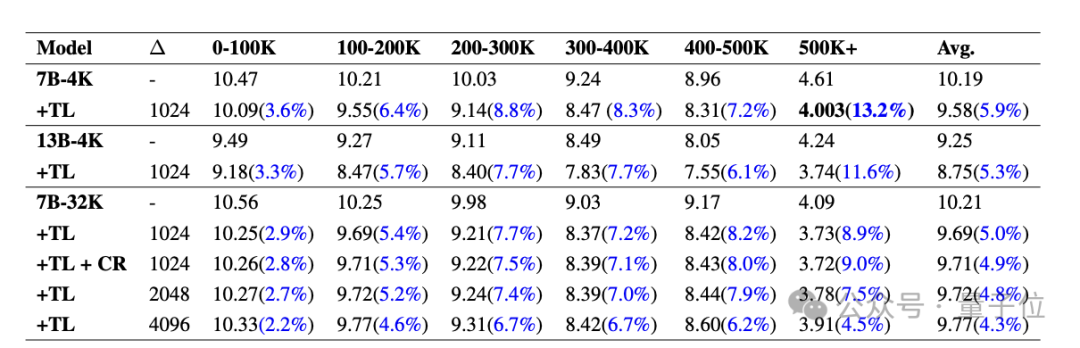

Pengarang menilai rangka kerja Temp-Lora pada model Llama2-7B-4K, Llama2-13B-4K, Llama2-7B-32K dan Yi-Chat-6B dan merangkumi kedua-dua model ini jenis tugasan teks panjang ialah penjanaan dan terjemahan.

Set data ujian ialah subset penanda aras pemodelan bahasa teks panjang PG19, yang mana 40 buku dipilih secara rawak.

Yang lain ialah subset sampel rawak set data Guofeng daripada WMT 2023, yang mengandungi 20 novel dalam talian Cina yang diterjemahkan ke dalam bahasa Inggeris oleh profesional.

Mula-mula mari kita lihat keputusan pada PG19.

Jadual di bawah menunjukkan PPL (kebingungan, mencerminkan ketidakpastian model untuk input yang diberikan, lebih rendah lebih baik) perbandingan pelbagai model pada PG19 dengan dan tanpa modul Temp-Lora. Bahagikan setiap dokumen kepada segmen daripada 0-100K hingga 500K+token.

Adalah dapat dilihat bahawa PPL semua model menurun dengan ketara selepas Temp-Lora, dan apabila klip menjadi lebih panjang dan lebih panjang, kesan Temp-Lora lebih jelas (1-100K hanya menurun sebanyak 3.6%, 500K+ menurun sebanyak 13.2%) .

Oleh itu, kita boleh membuat kesimpulan ringkas: Semakin banyak teks, semakin kuat keperluan untuk menggunakan Temp-Lora.

Selain itu, kita dapati bahawa melaraskan saiz blok dari 1024 kepada 2048 dan 4096 menghasilkan sedikit peningkatan dalam PPL.

Ini tidak menghairankan, lagipun, modul Temp-Lora dilatih pada data blok sebelumnya.

Data ini terutamanya memberitahu kita bahawa pilihan saiz blok ialah pertukaran utama antara kualiti penjanaan dan kecekapan pengiraan (analisis lanjut boleh didapati dalam kertas) .

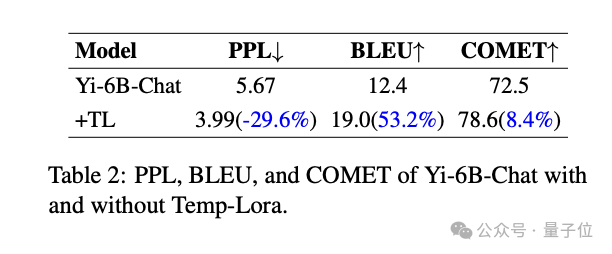

Akhir sekali, kami juga dapati bahawa penggunaan semula cache tidak akan menyebabkan kehilangan prestasi. Penulis berkata: Ini berita yang sangat menggalakkan.Berikut ialah keputusan pada dataset Guofeng.

Adalah dapat dilihat bahawa Temp-Lora juga mempunyai kesan yang signifikan terhadap tugas terjemahan sastera teks panjang. Peningkatan ketara dalam semua metrik berbanding model asas: -29.6% pengurangan dalam PPL, +53.2% peningkatan dalam skor BLEU(persamaan teks terjemahan mesin dengan terjemahan rujukan berkualiti tinggi), +53.2% peningkatan dalam skor COMET ( Juga penunjuk kualiti) meningkat sebanyak +8.4%.

Akhir sekali, terdapat penerokaan kecekapan dan kualiti pengiraan.

Akhir sekali, terdapat penerokaan kecekapan dan kualiti pengiraan.

Pengarang mendapati melalui eksperimen bahawa menggunakan konfigurasi

paling "ekonomi" Temp-Lora (Δ=2K, W=4K) boleh mengurangkan PPL sebanyak 3.8% sambil menjimatkan 70.5% daripada FLOP dan 51.5% kelewatan Sebaliknya, jika kita mengabaikan sepenuhnya kos pengiraan dan menggunakan konfigurasi

yang paling "mewah" (Δ=1K dan W=24K), kita juga boleh mencapai pengurangan PPL sebanyak 5.0% dan tambahan 17 % peningkatan FLOP dan kependaman 19.6%. Cadangan Penggunaan

Untuk meringkaskan keputusan di atas, penulis juga memberikan tiga cadangan untuk aplikasi praktikal Temp-Lora:

1 Untuk aplikasi yang memerlukan penjanaan teks panjang tahap tertinggi, integrasikan Temp tanpa mengubah sebarang parameter. -Lora boleh ditambah kepada model sedia ada untuk meningkatkan prestasi dengan ketara pada kos yang agak sederhana.

2 Untuk aplikasi yang menghargai kependaman minimum atau penggunaan memori, kos pengiraan boleh dikurangkan dengan ketara dengan mengurangkan panjang input dan maklumat kontekstual yang disimpan dalam Temp-Lora.

Dalam tetapan ini, kita boleh menggunakan saiz tetingkap pendek tetap

(seperti 2K atau 4K)untuk mengendalikan teks panjang yang hampir tak terhingga (500K+ dalam eksperimen pengarang) . 3 Akhir sekali, sila ambil perhatian bahawa dalam senario yang tidak mengandungi sejumlah besar teks, seperti apabila konteks dalam pra-latihan lebih kecil daripada saiz tetingkap model, Temp-Lora tidak berguna.

Penulis adalah daripada organisasi sulit

Perlu disebut bahawa untuk mencipta kaedah yang mudah dan inovatif, penulis tidak meninggalkan banyak maklumat sumber:

Nama organisasi ditandatangani terus sebagai "Organisasi Setiausaha", dan nama ketiga-tiga penulis hanyalah nama keluarga Lengkap.

Tetapi jika dilihat dari maklumat e-mel, ia mungkin dari sekolah seperti City University of Hong Kong dan Hong Kong Chinese Language School.

Tetapi jika dilihat dari maklumat e-mel, ia mungkin dari sekolah seperti City University of Hong Kong dan Hong Kong Chinese Language School.

Akhir sekali, apa pendapat anda tentang kaedah ini?

Kertas:Atas ialah kandungan terperinci Kertas tanpa nama menghasilkan idea yang mengejutkan! Ini sebenarnya boleh dilakukan untuk meningkatkan keupayaan teks panjang model besar. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

Sumber terbuka! Di luar ZoeDepth! DepthFM: Anggaran kedalaman monokular yang cepat dan tepat!

Apr 03, 2024 pm 12:04 PM

Sumber terbuka! Di luar ZoeDepth! DepthFM: Anggaran kedalaman monokular yang cepat dan tepat!

Apr 03, 2024 pm 12:04 PM

0. Apakah fungsi artikel ini? Kami mencadangkan DepthFM: model anggaran kedalaman monokular generatif yang serba boleh dan pantas. Sebagai tambahan kepada tugas anggaran kedalaman tradisional, DepthFM juga menunjukkan keupayaan terkini dalam tugas hiliran seperti mengecat kedalaman. DepthFM cekap dan boleh mensintesis peta kedalaman dalam beberapa langkah inferens. Mari kita baca karya ini bersama-sama ~ 1. Tajuk maklumat kertas: DepthFM: FastMonocularDepthEstimationwithFlowMatching Pengarang: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Model MoE sumber terbuka paling berkuasa di dunia ada di sini, dengan keupayaan bahasa Cina setanding dengan GPT-4, dan harganya hanya hampir satu peratus daripada GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Model MoE sumber terbuka paling berkuasa di dunia ada di sini, dengan keupayaan bahasa Cina setanding dengan GPT-4, dan harganya hanya hampir satu peratus daripada GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Bayangkan model kecerdasan buatan yang bukan sahaja mempunyai keupayaan untuk mengatasi pengkomputeran tradisional, tetapi juga mencapai prestasi yang lebih cekap pada kos yang lebih rendah. Ini bukan fiksyen sains, DeepSeek-V2[1], model MoE sumber terbuka paling berkuasa di dunia ada di sini. DeepSeek-V2 ialah gabungan model bahasa pakar (MoE) yang berkuasa dengan ciri-ciri latihan ekonomi dan inferens yang cekap. Ia terdiri daripada 236B parameter, 21B daripadanya digunakan untuk mengaktifkan setiap penanda. Berbanding dengan DeepSeek67B, DeepSeek-V2 mempunyai prestasi yang lebih kukuh, sambil menjimatkan 42.5% kos latihan, mengurangkan cache KV sebanyak 93.3% dan meningkatkan daya pemprosesan penjanaan maksimum kepada 5.76 kali. DeepSeek ialah sebuah syarikat yang meneroka kecerdasan buatan am

Apr 09, 2024 am 11:52 AM

Apr 09, 2024 am 11:52 AM

AI memang mengubah matematik. Baru-baru ini, Tao Zhexuan, yang telah mengambil perhatian terhadap isu ini, telah memajukan keluaran terbaru "Buletin Persatuan Matematik Amerika" (Buletin Persatuan Matematik Amerika). Memfokuskan pada topik "Adakah mesin akan mengubah matematik?", ramai ahli matematik menyatakan pendapat mereka Seluruh proses itu penuh dengan percikan api, tegar dan menarik. Penulis mempunyai barisan yang kuat, termasuk pemenang Fields Medal Akshay Venkatesh, ahli matematik China Zheng Lejun, saintis komputer NYU Ernest Davis dan ramai lagi sarjana terkenal dalam industri. Dunia AI telah berubah secara mendadak Anda tahu, banyak artikel ini telah dihantar setahun yang lalu.

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas secara rasmi memasuki era robot elektrik! Semalam, Atlas hidraulik hanya "menangis" menarik diri daripada peringkat sejarah Hari ini, Boston Dynamics mengumumkan bahawa Atlas elektrik sedang berfungsi. Nampaknya dalam bidang robot humanoid komersial, Boston Dynamics berazam untuk bersaing dengan Tesla. Selepas video baharu itu dikeluarkan, ia telah pun ditonton oleh lebih sejuta orang dalam masa sepuluh jam sahaja. Orang lama pergi dan peranan baru muncul. Ini adalah keperluan sejarah. Tidak dinafikan bahawa tahun ini adalah tahun letupan robot humanoid. Netizen mengulas: Kemajuan robot telah menjadikan majlis pembukaan tahun ini kelihatan seperti manusia, dan tahap kebebasan adalah jauh lebih besar daripada manusia Tetapi adakah ini benar-benar bukan filem seram? Pada permulaan video, Atlas berbaring dengan tenang di atas tanah, seolah-olah terlentang. Apa yang berikut adalah rahang-jatuh

KAN, yang menggantikan MLP, telah diperluaskan kepada konvolusi oleh projek sumber terbuka

Jun 01, 2024 pm 10:03 PM

KAN, yang menggantikan MLP, telah diperluaskan kepada konvolusi oleh projek sumber terbuka

Jun 01, 2024 pm 10:03 PM

Awal bulan ini, penyelidik dari MIT dan institusi lain mencadangkan alternatif yang sangat menjanjikan kepada MLP - KAN. KAN mengatasi MLP dari segi ketepatan dan kebolehtafsiran. Dan ia boleh mengatasi prestasi MLP berjalan dengan bilangan parameter yang lebih besar dengan bilangan parameter yang sangat kecil. Sebagai contoh, penulis menyatakan bahawa mereka menggunakan KAN untuk menghasilkan semula keputusan DeepMind dengan rangkaian yang lebih kecil dan tahap automasi yang lebih tinggi. Khususnya, MLP DeepMind mempunyai kira-kira 300,000 parameter, manakala KAN hanya mempunyai kira-kira 200 parameter. KAN mempunyai asas matematik yang kukuh seperti MLP berdasarkan teorem penghampiran universal, manakala KAN berdasarkan teorem perwakilan Kolmogorov-Arnold. Seperti yang ditunjukkan dalam rajah di bawah, KAN telah

FisheyeDetNet: algoritma pengesanan sasaran pertama berdasarkan kamera fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: algoritma pengesanan sasaran pertama berdasarkan kamera fisheye

Apr 26, 2024 am 11:37 AM

Pengesanan objek ialah masalah yang agak matang dalam sistem pemanduan autonomi, antaranya pengesanan pejalan kaki adalah salah satu algoritma terawal untuk digunakan. Penyelidikan yang sangat komprehensif telah dijalankan dalam kebanyakan kertas kerja. Walau bagaimanapun, persepsi jarak menggunakan kamera fisheye untuk pandangan sekeliling agak kurang dikaji. Disebabkan herotan jejari yang besar, perwakilan kotak sempadan standard sukar dilaksanakan dalam kamera fisheye. Untuk mengurangkan perihalan di atas, kami meneroka kotak sempadan lanjutan, elips dan reka bentuk poligon am ke dalam perwakilan kutub/sudut dan mentakrifkan metrik mIOU pembahagian contoh untuk menganalisis perwakilan ini. Model fisheyeDetNet yang dicadangkan dengan bentuk poligon mengatasi model lain dan pada masa yang sama mencapai 49.5% mAP pada set data kamera fisheye Valeo untuk pemanduan autonomi

Daya hidup kecerdasan super membangkitkan! Tetapi dengan kedatangan AI yang mengemas kini sendiri, ibu tidak perlu lagi bimbang tentang kesesakan data

Apr 29, 2024 pm 06:55 PM

Daya hidup kecerdasan super membangkitkan! Tetapi dengan kedatangan AI yang mengemas kini sendiri, ibu tidak perlu lagi bimbang tentang kesesakan data

Apr 29, 2024 pm 06:55 PM

Saya menangis hingga mati. Dunia sedang membina model besar. Data di Internet tidak mencukupi. Model latihan kelihatan seperti "The Hunger Games", dan penyelidik AI di seluruh dunia bimbang tentang cara memberi makan data ini kepada pemakan yang rakus. Masalah ini amat ketara dalam tugas berbilang modal. Pada masa mereka mengalami kerugian, pasukan pemula dari Jabatan Universiti Renmin China menggunakan model baharu mereka sendiri untuk menjadi yang pertama di China untuk menjadikan "suapan data yang dijana model itu sendiri" menjadi kenyataan. Selain itu, ia merupakan pendekatan serampang dua mata dari segi pemahaman dan sisi penjanaan Kedua-dua pihak boleh menjana data baharu berbilang modal yang berkualiti tinggi dan memberikan maklum balas data kepada model itu sendiri. Apakah model? Awaker 1.0, model berbilang modal besar yang baru sahaja muncul di Forum Zhongguancun. Siapa pasukan itu? Enjin Sophon. Diasaskan oleh Gao Yizhao, pelajar kedoktoran di Sekolah Kecerdasan Buatan Hillhouse Universiti Renmin.

Robot Tesla bekerja di kilang, Musk: Tahap kebebasan tangan akan mencapai 22 tahun ini!

May 06, 2024 pm 04:13 PM

Robot Tesla bekerja di kilang, Musk: Tahap kebebasan tangan akan mencapai 22 tahun ini!

May 06, 2024 pm 04:13 PM

Video terbaru robot Tesla Optimus dikeluarkan, dan ia sudah boleh berfungsi di kilang. Pada kelajuan biasa, ia mengisih bateri (bateri 4680 Tesla) seperti ini: Pegawai itu juga mengeluarkan rupanya pada kelajuan 20x - pada "stesen kerja" kecil, memilih dan memilih dan memilih: Kali ini ia dikeluarkan Salah satu sorotan video itu ialah Optimus menyelesaikan kerja ini di kilang, sepenuhnya secara autonomi, tanpa campur tangan manusia sepanjang proses. Dan dari perspektif Optimus, ia juga boleh mengambil dan meletakkan bateri yang bengkok, memfokuskan pada pembetulan ralat automatik: Berkenaan tangan Optimus, saintis NVIDIA Jim Fan memberikan penilaian yang tinggi: Tangan Optimus adalah robot lima jari di dunia paling cerdik. Tangannya bukan sahaja boleh disentuh