Peranti teknologi

Peranti teknologi

AI

AI

Tiga kertas menyelesaikan masalah 'Pengoptimuman dan Penilaian Segmentasi Semantik'! Leuven/Tsinghua/Oxford dan lain-lain bersama-sama mencadangkan kaedah baharu

Tiga kertas menyelesaikan masalah 'Pengoptimuman dan Penilaian Segmentasi Semantik'! Leuven/Tsinghua/Oxford dan lain-lain bersama-sama mencadangkan kaedah baharu

Tiga kertas menyelesaikan masalah 'Pengoptimuman dan Penilaian Segmentasi Semantik'! Leuven/Tsinghua/Oxford dan lain-lain bersama-sama mencadangkan kaedah baharu

Fungsi kehilangan yang biasa digunakan untuk mengoptimumkan model segmentasi semantik termasuk kehilangan Soft Jaccard, kehilangan Soft Dice dan kehilangan Soft Tversky. Walau bagaimanapun, fungsi kehilangan ini tidak serasi dengan label lembut dan oleh itu tidak dapat menyokong beberapa teknik latihan penting seperti pelicinan label, penyulingan pengetahuan, pembelajaran separa penyeliaan dan berbilang annotator. Teknik latihan ini sangat penting untuk meningkatkan prestasi dan keteguhan model segmentasi semantik, jadi kajian lanjut dan pengoptimuman fungsi kehilangan diperlukan untuk menyokong aplikasi teknik latihan ini.

Sebaliknya, penunjuk penilaian segmentasi semantik yang biasa digunakan termasuk mAcc dan mIoU. Walau bagaimanapun, penunjuk ini mempunyai keutamaan untuk objek yang lebih besar, yang memberi kesan serius kepada penilaian prestasi keselamatan model.

Untuk menyelesaikan masalah ini, penyelidik di Universiti Leuven dan Tsinghua mula-mula mencadangkan kerugian JDT. Kehilangan JDT ialah penalaan halus bagi fungsi kehilangan asal, yang merangkumi kerugian Jaccard Metric, Dice Semimetric loss dan Compatible Tversky loss. Kehilangan JDT adalah bersamaan dengan fungsi kehilangan asal apabila berurusan dengan label keras, dan juga terpakai sepenuhnya untuk label lembut. Peningkatan ini menjadikan latihan model lebih tepat dan stabil.

Penyelidik berjaya menggunakan kehilangan JDT dalam empat senario penting: pelicinan label, penyulingan pengetahuan, pembelajaran separa penyeliaan dan berbilang annotator. Aplikasi ini menunjukkan kuasa kehilangan JDT untuk meningkatkan ketepatan dan penentukuran model.

Gambar

Gambar

Pautan kertas: https://arxiv.org/pdf/2302.05666.pdf

Pictures

Pictures

:v/pdf 03.16296 .pdf

Selain itu, penyelidik juga mencadangkan penunjuk penilaian yang terperinci. Metrik penilaian yang terperinci ini kurang berat sebelah terhadap objek bersaiz besar, memberikan maklumat statistik yang lebih kaya dan boleh memberikan cerapan berharga untuk pengauditan model dan set data.

Dan, para penyelidik menjalankan kajian penanda aras yang meluas yang menekankan keperluan untuk tidak mengasaskan penilaian pada satu metrik dan menemui peranan penting struktur rangkaian saraf dan kehilangan JDT dalam mengoptimumkan metrik yang terperinci.

Gambar

Gambar

Pautan kertas: https://arxiv.org/pdf/2310.19252.pdf

Pautan kod: https://github.com/zifuwanggg/Function

LossesLosses

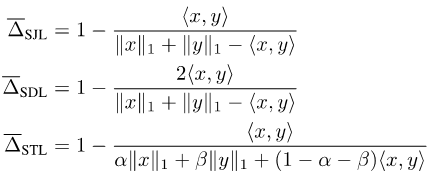

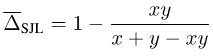

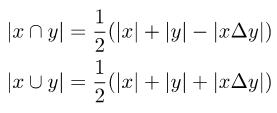

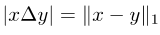

JDTMemandangkan Jaccard Index dan Dice Score ditakrifkan pada set, ia tidak boleh dibezakan. Untuk menjadikannya boleh dibezakan, pada masa ini terdapat dua pendekatan biasa: satu ialah menggunakan hubungan antara set dan modul Lp bagi vektor yang sepadan, seperti kehilangan Soft Jaccard (SJL), kehilangan Dadu Lembut (SDL) dan Tversky Lembut. kerugian (STL). Mereka menulis saiz set sebagai modul L1 bagi vektor yang sepadan, dan menulis persilangan dua set sebagai hasil dalam dua vektor yang sepadan. Yang lain ialah menggunakan sifat submodular Indeks Jaccard untuk melakukan pengembangan Lovasz pada fungsi yang ditetapkan, seperti kehilangan Lovasz-Softmax (LSL).

Gambar

Gambar

picture

picture

Gambar

Gambar

Gambar

Gambar

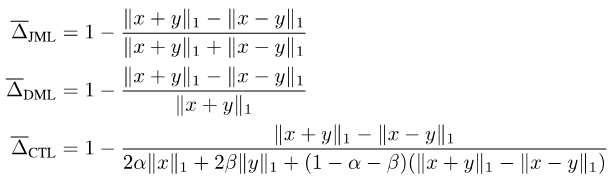

Menyatukan perkara di atas, kami mencadangkan kerugian JDT. Ia adalah varian SJL, Jaccard Metric loss (JML), varian SDL, Dice Semimetric loss (DML) dan varian STL, Compatible Tversky loss (CTL).

Gambar

Gambar

Sifat kehilangan JDT

Kami membuktikan kerugian JDT mempunyai sifat berikut.

Sifat 1: JML ialah metrik dan DML ialah semimetrik.

Harta 2: Apabila y ialah label keras, JML bersamaan dengan SJL, DML bersamaan dengan SDL dan CTL bersamaan dengan STL.

Sifat 3: Apabila y ialah label lembut, JML, DML dan CTL semuanya serasi dengan label lembut, iaitu x = y ó f(x, y) = 0.

Disebabkan Harta 1, mereka juga dipanggil kerugian Jaccard Metric dan Dice Semimetric loss. Harta 2 menunjukkan bahawa dalam senario umum di mana hanya label keras digunakan untuk latihan, kehilangan JDT boleh digunakan terus untuk menggantikan fungsi kehilangan sedia ada tanpa menyebabkan sebarang perubahan.

Cara menggunakan kehilangan JDT

Kami telah menjalankan banyak eksperimen dan merumuskan beberapa langkah berjaga-jaga untuk menggunakan kehilangan JDT.

Nota 1: Pilih fungsi kerugian yang sepadan berdasarkan indeks penilaian. Jika indeks penilaian ialah Indeks Jaccard, maka JML hendaklah dipilih jika indeks penilaian ialah Skor Dadu, maka DML hendaklah dipilih jika anda ingin memberikan pemberat yang berbeza kepada positif palsu dan negatif palsu, maka CTL harus dipilih; Kedua, apabila mengoptimumkan petunjuk penilaian yang terperinci, kerugian JDT juga harus diubah dengan sewajarnya.

Nota 2: Gabungkan kehilangan JDT dan fungsi kehilangan tahap piksel (seperti kehilangan Cross Entropy, Kehilangan Fokus). Artikel ini mendapati bahawa 0.25CE + 0.75JDT pada umumnya adalah pilihan yang baik.

Nota 3: Sebaik-baiknya gunakan zaman yang lebih pendek untuk latihan. Selepas menambah kerugian JDT, ia secara amnya hanya memerlukan separuh tempoh latihan kehilangan Cross Entropy.

Nota 4: Apabila melaksanakan latihan teragih pada berbilang GPU, jika tiada komunikasi tambahan antara GPU, kehilangan JDT akan tersalah mengoptimumkan metrik penilaian halus, mengakibatkan prestasi lemah pada mIoU tradisional.

Nota 5: Apabila latihan pada set data dengan ketidakseimbangan kategori melampau, sila ambil perhatian bahawa kerugian JDL dikira secara berasingan pada setiap kategori dan kemudian dipuratakan, yang mungkin menjadikan latihan tidak stabil.

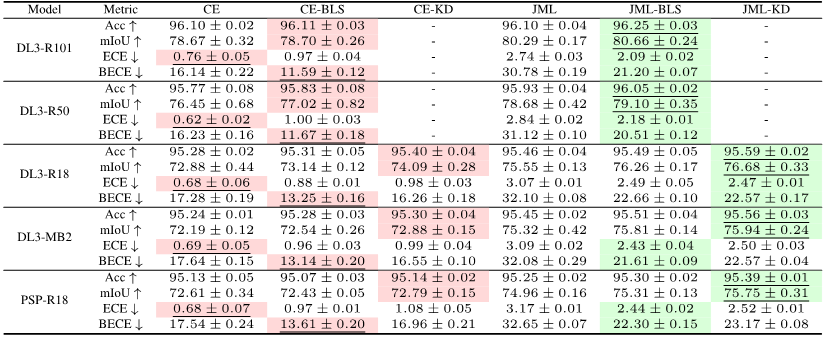

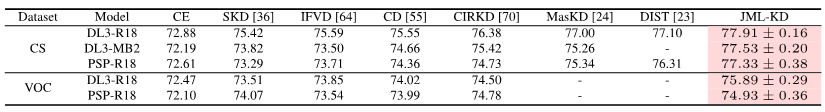

Hasil eksperimen

Eksperimen telah membuktikan bahawa, berbanding garis dasar kehilangan Cross Entropy, menambah kehilangan JDT boleh meningkatkan ketepatan model dengan berkesan apabila berlatih dengan label keras. Ketepatan dan penentukuran model boleh dipertingkatkan lagi dengan memperkenalkan label lembut.

Gambar

Gambar

Hanya menambah istilah kehilangan JDT semasa latihan, artikel ini telah mencapai SOTA dalam penyulingan pengetahuan, pembelajaran separa penyeliaan dan multi-annotator dalam segmentasi semantik. .

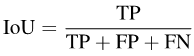

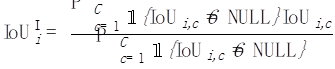

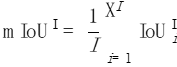

Segmentasi semantik ialah tugas pengelasan tahap piksel, jadi setiap ketepatan Pixel: piksel keseluruhan- ketepatan bijak (Acc). Walau bagaimanapun, kerana Acc memihak kepada kategori majoriti, PASCAL VOC 2007 mengguna pakai indeks penilaian yang mengira ketepatan piksel bagi setiap kategori secara berasingan dan kemudian puratanya: min ketepatan mengikut piksel (mAcc).

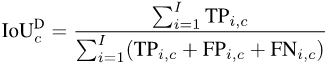

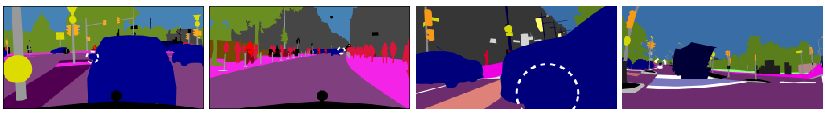

Tetapi memandangkan mAcc tidak menganggap positif palsu, sejak PASCAL VOC 2008, purata persimpangan dan nisbah kesatuan (per-dataset mIoU, mIoUD) telah digunakan sebagai indeks penilaian. PASCAL VOC ialah set data pertama yang memperkenalkan tugas pembahagian semantik, dan penunjuk penilaian yang digunakan digunakan secara meluas dalam pelbagai set data berikutnya.

Tetapi memandangkan mAcc tidak menganggap positif palsu, sejak PASCAL VOC 2008, purata persimpangan dan nisbah kesatuan (per-dataset mIoU, mIoUD) telah digunakan sebagai indeks penilaian. PASCAL VOC ialah set data pertama yang memperkenalkan tugas pembahagian semantik, dan penunjuk penilaian yang digunakan digunakan secara meluas dalam pelbagai set data berikutnya.

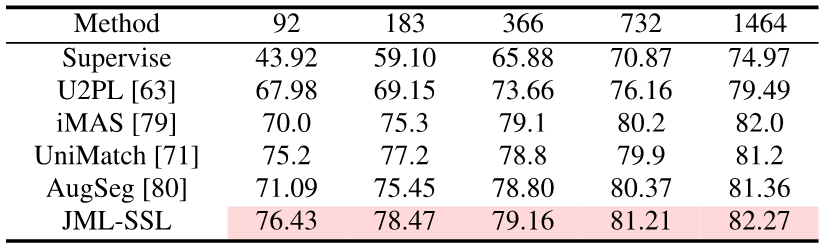

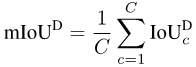

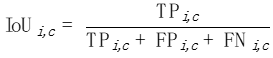

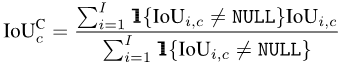

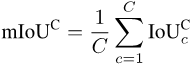

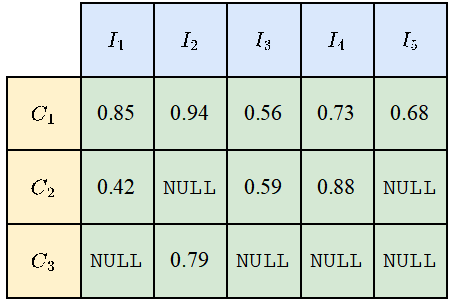

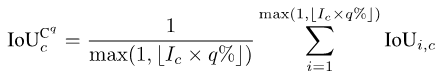

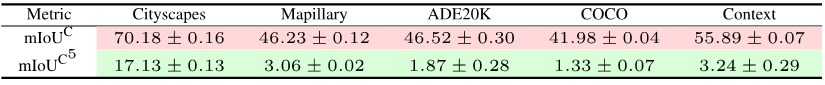

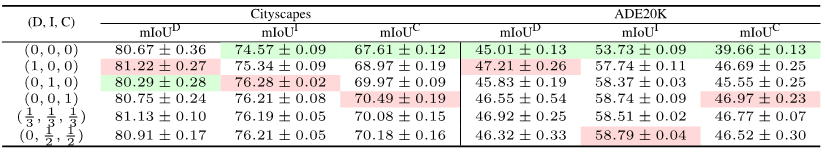

Untuk mengira mIoUD, kita perlu mengira positif benar (TP) dan positif palsu (FP) semua foto I dalam keseluruhan set data untuk setiap kategori c. FN): Selepas mempunyai nilai berangka untuk setiap kategori, kami purata mengikut kategori, sekali gus menghapuskan keutamaan untuk kategori majoriti: Gambar Untuk setiap kategori c, kami mula-mula mengisih nilai IoU bagi semua foto yang telah dipaparkan (dengan mengandaikan terdapat Ic foto sedemikian) dalam tertib menaik. Seterusnya, kita tetapkan q menjadi nombor kecil, seperti 1 atau 5. Kemudian, kami hanya menggunakan Ic * q% atas foto yang diisih untuk mengira nilai akhir: Selepas mempunyai nilai setiap kelas c, kita boleh mengisih mengikut kategori seperti sebelum ini Purata ini untuk mendapatkan metrik kes terburuk mIoUC. Kami melatih 15 model pada 12 set data dan menemui fenomena berikut. Fenomena 1: Tiada model boleh mencapai hasil terbaik pada semua penunjuk penilaian. Setiap indeks penilaian mempunyai fokus yang berbeza, jadi kita perlu mempertimbangkan beberapa indeks penilaian pada masa yang sama untuk menjalankan penilaian yang komprehensif. Fenomena 2: Terdapat beberapa foto dalam beberapa set data yang menyebabkan hampir semua model mencapai nilai IoU yang sangat rendah. Ini sebahagiannya kerana foto itu sendiri sangat mencabar, seperti beberapa objek yang sangat kecil dan kontras yang kuat antara terang dan gelap, dan sebahagiannya kerana terdapat masalah dengan label foto ini. Oleh itu, metrik penilaian yang terperinci boleh membantu kami menjalankan audit model (mencari senario di mana model melakukan kesilapan) dan audit set data (mencari label yang salah). Fenomena 3: Struktur rangkaian saraf memainkan peranan penting dalam mengoptimumkan petunjuk penilaian yang terperinci. Di satu pihak, peningkatan dalam bidang penerimaan yang dibawa oleh struktur seperti ASPP (diguna pakai oleh DeepLabV3 dan DeepLabV3+) boleh membantu model mengenali objek bersaiz besar, dengan itu meningkatkan nilai mIoUD secara berkesan, sebaliknya, jurang antara pengekod dan penyahkod Sambungan panjang (diguna pakai oleh UNet dan DeepLabV3+) membolehkan model mengenali objek bersaiz kecil, dengan itu meningkatkan nilai penunjuk penilaian yang terperinci. Fenomena 4: Nilai penunjuk kes terburuk jauh lebih rendah daripada nilai penunjuk purata yang sepadan. Jadual berikut menunjukkan mIoUC dan nilai penunjuk kes terburuk yang sepadan DeepLabV3-ResNet101 pada berbilang set data. Soalan yang patut dipertimbangkan pada masa hadapan ialah, bagaimanakah kita harus mereka bentuk struktur rangkaian saraf dan kaedah pengoptimuman untuk meningkatkan prestasi model di bawah penunjuk kes terburuk? Fenomena 5: Fungsi kehilangan memainkan peranan penting dalam mengoptimumkan petunjuk penilaian yang terperinci. Berbanding dengan penanda aras kehilangan Cross Entropy, seperti yang ditunjukkan dalam (0, 0, 0) dalam jadual berikut, apabila penunjuk penilaian menjadi halus, menggunakan fungsi kehilangan sepadan boleh meningkatkan prestasi model pada butiran halus. penunjuk penilaian. Sebagai contoh, pada ADE20K, perbezaan dalam kehilangan mIoUC antara JML dan Cross Entropy akan lebih besar daripada 7%. . Kedua, kerugian JDT hanya digunakan dalam ruang label, tetapi kami percaya ia boleh digunakan untuk meminimumkan jarak antara mana-mana dua vektor dalam ruang ciri, seperti menggantikan modul Lp dan jarak kosinus.

Gambar

Gambar Gambar

Gambar

Akhir sekali, kami purata nilai semua foto:

Akhir sekali, kami purata nilai semua foto:

Bagi sesetengah senario aplikasi yang memfokuskan keselamatan, kami selalunya lebih mementingkan kes-kes yang paling teruk dalam segmen kualiti. keupayaan untuk mengira penunjuk kes terburuk yang sepadan. Mari kita ambil mIoUC sebagai contoh Kaedah yang serupa juga boleh mengira penunjuk kes terburuk yang sepadan bagi mIoUI.

Bagi sesetengah senario aplikasi yang memfokuskan keselamatan, kami selalunya lebih mementingkan kes-kes yang paling teruk dalam segmen kualiti. keupayaan untuk mengira penunjuk kes terburuk yang sepadan. Mari kita ambil mIoUC sebagai contoh Kaedah yang serupa juga boleh mengira penunjuk kes terburuk yang sepadan bagi mIoUI.  Gambar

GambarHasil eksperimen

Gambar

Gambar

Atas ialah kandungan terperinci Tiga kertas menyelesaikan masalah 'Pengoptimuman dan Penilaian Segmentasi Semantik'! Leuven/Tsinghua/Oxford dan lain-lain bersama-sama mencadangkan kaedah baharu. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1375

1375

52

52

Penunjuk MoE sumber terbuka domestik meletup: keupayaan tahap GPT-4, harga API hanya satu peratus

May 07, 2024 pm 05:34 PM

Penunjuk MoE sumber terbuka domestik meletup: keupayaan tahap GPT-4, harga API hanya satu peratus

May 07, 2024 pm 05:34 PM

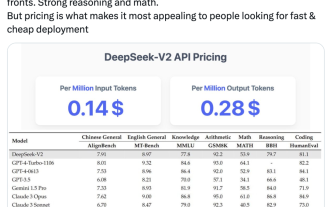

Model MoE sumber terbuka domestik berskala besar terbaharu telah menjadi popular selepas kemunculannya. Prestasi DeepSeek-V2 mencapai tahap GPT-4, tetapi ia adalah sumber terbuka, percuma untuk kegunaan komersial, dan harga API hanya satu peratus daripada GPT-4-Turbo. Oleh itu, sebaik sahaja dikeluarkan, ia segera mencetuskan banyak perbincangan. Berdasarkan petunjuk prestasi yang diterbitkan, keupayaan Cina komprehensif DeepSeekV2 mengatasi kebanyakan model sumber terbuka Pada masa yang sama, model sumber tertutup seperti GPT-4Turbo dan Wenkuai 4.0 juga berada dalam eselon pertama. Keupayaan bahasa Inggeris yang komprehensif juga berada dalam eselon pertama yang sama seperti LLaMA3-70B, dan mengatasi Mixtral8x22B, yang juga merupakan KPM. Ia juga menunjukkan prestasi yang baik dalam pengetahuan, matematik, penaakulan, pengaturcaraan, dll. Dan menyokong konteks 128K. Bayangkan ini

Sepuluh penjelasan fungsi kehilangan yang biasa digunakan dan pelaksanaan kod Python

Apr 13, 2023 am 09:37 AM

Sepuluh penjelasan fungsi kehilangan yang biasa digunakan dan pelaksanaan kod Python

Apr 13, 2023 am 09:37 AM

Apakah fungsi kerugian? Fungsi kehilangan ialah algoritma yang mengukur sejauh mana model sesuai dengan data. Fungsi kerugian ialah satu cara untuk mengukur perbezaan antara ukuran sebenar dan nilai ramalan. Semakin tinggi nilai fungsi kerugian, semakin tidak tepat ramalannya, dan semakin rendah nilai fungsi kerugian, semakin dekat ramalan dengan nilai sebenar. Fungsi kehilangan dikira untuk setiap pemerhatian individu (titik data). Fungsi yang meratakan nilai semua fungsi kerugian dipanggil fungsi kos Pemahaman yang lebih mudah ialah fungsi kehilangan adalah untuk satu sampel, manakala fungsi kos adalah untuk semua sampel. Fungsi dan metrik kehilangan Sesetengah fungsi kehilangan juga boleh digunakan sebagai metrik penilaian. Tetapi fungsi dan metrik kerugian mempunyai tujuan yang berbeza. Walaupun

Segmentasi semantik dan teknologi pengesanan konsep video dan aplikasi dalam pemahaman kandungan video yang dilaksanakan di Java

Jun 18, 2023 pm 07:51 PM

Segmentasi semantik dan teknologi pengesanan konsep video dan aplikasi dalam pemahaman kandungan video yang dilaksanakan di Java

Jun 18, 2023 pm 07:51 PM

Dalam era video digital hari ini, teknologi pemahaman kandungan video memainkan peranan penting dalam pelbagai bidang, seperti pengesyoran video, carian video, anotasi video automatik, dsb. Antaranya, segmentasi semantik dan teknologi pengesanan konsep video adalah dua aspek utama pemahaman kandungan video. Artikel ini akan bermula dari perspektif pelaksanaan Java dan memperkenalkan konsep asas segmentasi semantik dan teknologi pengesanan konsep video serta nilainya dalam aplikasi praktikal. 1. Teknologi segmentasi semantik Teknologi segmentasi semantik merupakan hala tuju penyelidikan yang penting dalam bidang penglihatan komputer Tujuannya adalah untuk melakukan analisis tahap piksel bagi imej atau video.

Fungsi kehilangan yang biasa digunakan dan contoh pelaksanaan Python

Apr 26, 2023 pm 01:40 PM

Fungsi kehilangan yang biasa digunakan dan contoh pelaksanaan Python

Apr 26, 2023 pm 01:40 PM

Apakah fungsi kerugian? Fungsi kehilangan ialah algoritma yang mengukur sejauh mana model sesuai dengan data. Fungsi kerugian ialah satu cara untuk mengukur perbezaan antara ukuran sebenar dan nilai ramalan. Semakin tinggi nilai fungsi kerugian, semakin tidak tepat ramalannya, dan semakin rendah nilai fungsi kerugian, semakin dekat ramalan dengan nilai sebenar. Fungsi kehilangan dikira untuk setiap pemerhatian individu (titik data). Fungsi yang meratakan nilai semua fungsi kerugian dipanggil fungsi kos Pemahaman yang lebih mudah ialah fungsi kehilangan adalah untuk satu sampel, dan fungsi kos adalah untuk semua sampel. Fungsi dan metrik kehilangan Sesetengah fungsi kehilangan juga boleh digunakan sebagai metrik penilaian. Tetapi fungsi dan metrik kerugian mempunyai tujuan yang berbeza. Walaupun ukuran

Isu ketepatan tahap piksel dalam pembahagian semantik

Oct 09, 2023 am 08:13 AM

Isu ketepatan tahap piksel dalam pembahagian semantik

Oct 09, 2023 am 08:13 AM

Segmentasi semantik ialah tugas penting dalam bidang penglihatan komputer yang bertujuan untuk menetapkan setiap piksel dalam imej kepada kategori semantik tertentu. Dalam pembahagian semantik, ketepatan tahap piksel ialah penunjuk penting, yang mengukur sama ada klasifikasi model bagi setiap piksel adalah tepat. Walau bagaimanapun, dalam aplikasi praktikal, kita sering menghadapi masalah ketepatan yang rendah. Artikel ini membincangkan isu ketepatan tahap piksel dalam pembahagian semantik dan menyediakan beberapa contoh kod konkrit. Pertama, kita perlu memahami prinsip asas segmentasi semantik. Model pembahagian semantik yang biasa digunakan termasuk FCN

Daripada Metrik kepada Amalan: Cara Meningkatkan Kod PHP dengan Mengukur Metrik Perisian dengan PHPDepend

Sep 15, 2023 am 09:33 AM

Daripada Metrik kepada Amalan: Cara Meningkatkan Kod PHP dengan Mengukur Metrik Perisian dengan PHPDepend

Sep 15, 2023 am 09:33 AM

Daripada Metrik kepada Amalan: Cara Menggunakan PHPDepend untuk Mengukur Metrik Perisian untuk Meningkatkan Kod PHP Pengenalan: Dalam proses pembangunan perisian, penilaian kualiti kod adalah penting. Dengan mengukur pelbagai metrik perisian, kami boleh lebih memahami kualiti dan prestasi kod, dan kemudian mengambil langkah yang sesuai untuk menambah baik kod. Artikel ini akan memperkenalkan cara menggunakan alat PHPDepend untuk mengukur pelbagai penunjuk kod PHP dan menggunakan contoh kod khusus untuk menunjukkan cara menambah baik kod berdasarkan hasil pengukuran. Pengukuran Metrik untuk PHP CodePHPDep

Adakah pasaran altcoin akan mengalami 'lantunan semula'? Ia cukup untuk memberi perhatian kepada tiga penunjuk ini

Jun 03, 2024 pm 05:15 PM

Adakah pasaran altcoin akan mengalami 'lantunan semula'? Ia cukup untuk memberi perhatian kepada tiga penunjuk ini

Jun 03, 2024 pm 05:15 PM

Pedagang mata wang kripto yang memantau dengan teliti tiga penunjuk teknikal mengatakan bahawa pasaran altcoin kini berada dalam "fasa yang luar biasa" dan tidak lama lagi mungkin memasuki "fasa rali letupan" jika sejarah berulang. Penganalisis mata wang kripto, MikybullCrypto memberitahu 66,600X pengikut mereka dalam satu jawatan pada 11 Mei: “Kapital pasaran Altcoin kini berada pada tahap yang luar biasa, dan dari segi sejarah, rali yang meletup telah menyusuli Fasa ini adalah apabila walaupun terdapat tanda-tanda pasaran yang positif, pelabur tetap ragu-ragu, kerana tercermin dalam penurunan besar 24 mata dalam Indeks Ketakutan dan Ketamakan Kripto sepanjang 30 hari yang lalu. Pada masa ini&ldq

Penjelasan mendalam tentang sistem penunjuk operasi teknologi

Jun 08, 2023 pm 06:43 PM

Penjelasan mendalam tentang sistem penunjuk operasi teknologi

Jun 08, 2023 pm 06:43 PM

Pengenalan Apabila merujuk kepada penunjuk operasi teknologi, setiap orang teknologi boleh menamakan beberapa, seperti volum transaksi, masa tindak balas, kadar tindak balas, kadar kejayaan, dsb. Metrik ini adalah penilaian kuantitatif kerja dalam bidang operasi. Walau bagaimanapun, untuk menilai tahap keseluruhan operasi teknologi, adalah perlu untuk mewujudkan sistem penunjuk untuk operasi teknologi, mendapatkan maklumat keseluruhan, dan kemudian menggunakan maklumat ini untuk memacu pembangunan operasi dan mencapai matlamat organisasi. Matlamat dan Kedudukan Pembinaan Bank G telah mewujudkan sistem indeks kebolehcerap operasi teknologi untuk menyediakan pengurus rangka kerja analisis pengurusan operasi berbilang dimensi dan diperhalusi, dan menggunakan ini sebagai titik permulaan untuk meningkatkan keupayaan pengurusan operasi pusat, tahap membuat keputusan dan perkhidmatan. kualiti. Pembinaan sistem penunjuk mengikut empat prinsip iaitu boleh diukur, boleh dibandingkan, berorientasikan tindakan dan boleh disesuaikan dengan pelbagai senario, memfokuskan pada senario perniagaan sebenar.