Model baharu pasukan setanding dengan Gemini Pro dan GPT-3.5 dalam pelbagai penanda aras.

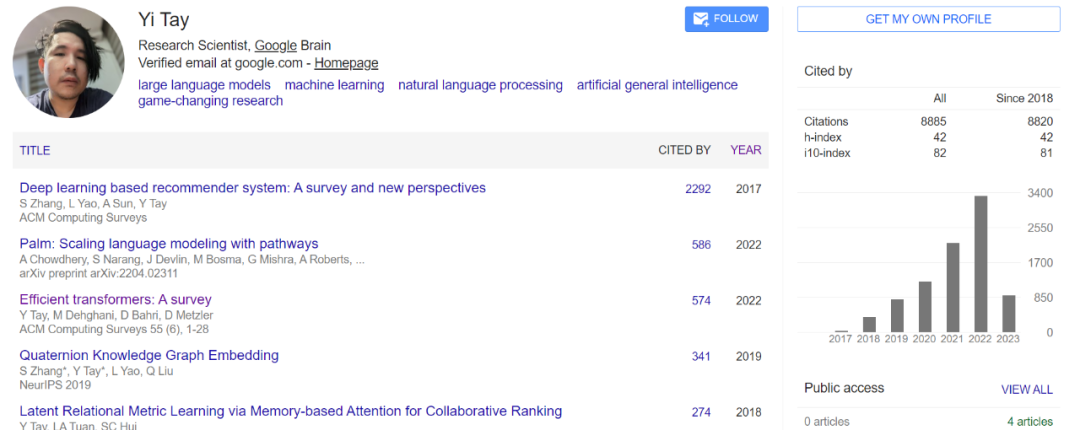

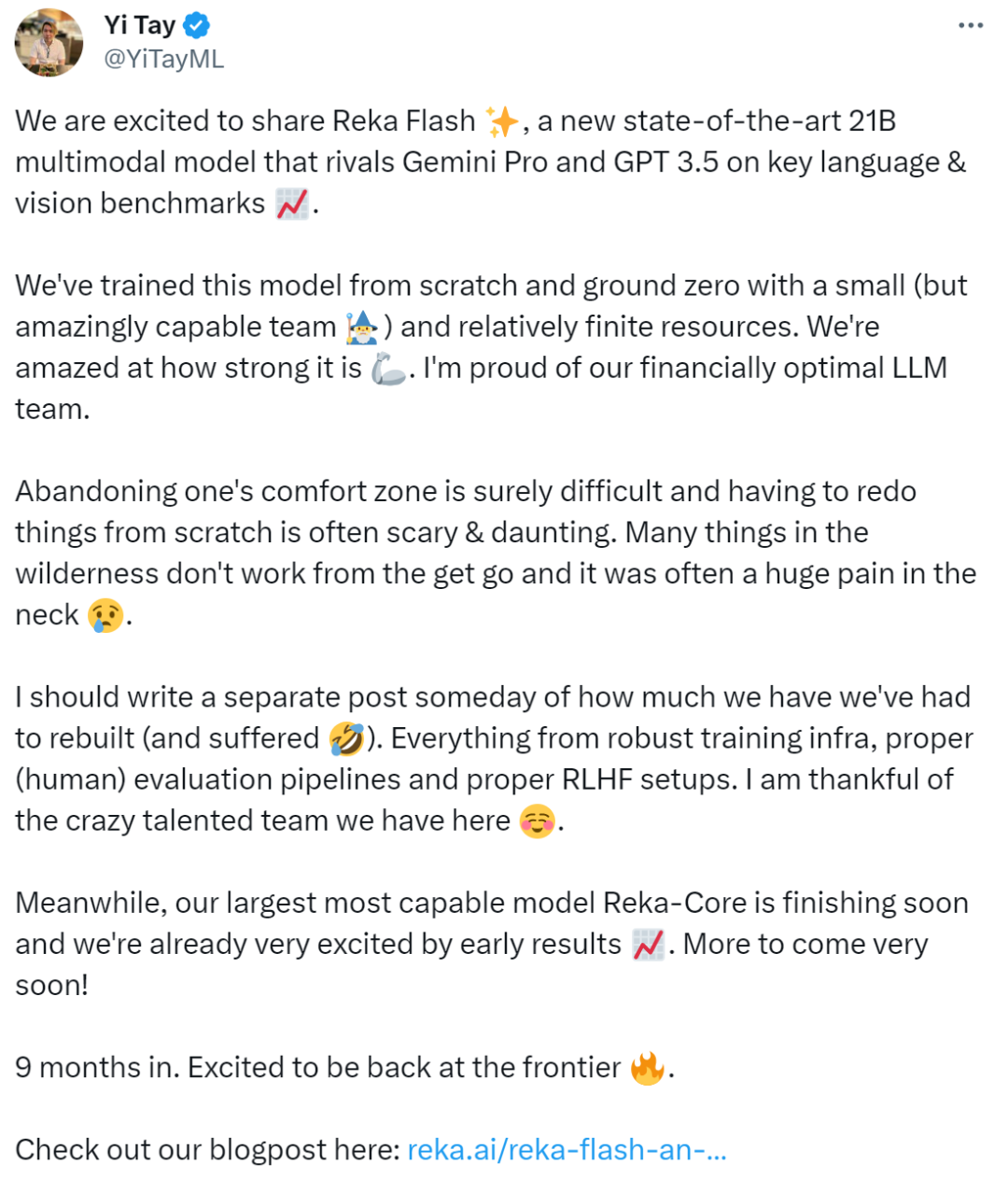

Jika anda sering membaca kertas mengenai model AI yang besar, Yi Tay mesti nama yang biasa. Sebagai bekas saintis penyelidikan kanan di Google Brain, Yi Tay telah menyumbang kepada banyak model bahasa berskala besar dan model berbilang modal yang terkenal, termasuk PaLM, UL2, Flan-U-PaLM, LaMDA/Bard, ViT-22B, PaLI , MUM, dsb. Menurut statistik profil Yi Tay, selama lebih 3 tahun bekerja di Google Brain, dia telah mengambil bahagian dalam menulis sejumlah kira-kira 45 kertas kerja, dan merupakan pengarang bersama 16 daripadanya. Kertas kerja yang dikarang termasuk UL2, U-PaLM, DSI, Synthesizer, Charformer dan Arena Jarak Jauh, dsb. Seperti kebanyakan pengarang Transformer yang meninggalkan Google untuk memulakan perniagaan mereka sendiri, Yi Tay mengumumkan pemergiannya daripada Google pada Mac tahun lalu dan mengasaskan sebuah syarikat bernama Reka Yi Tay berkhidmat sebagai ketua saintis syarikat, yang memfokuskan kepada perniagaan besar -model bahasa berskala. Semakin masa berlalu, Yi Tay baru sahaja mengumumkan bahawa mereka telah mengeluarkan model baharu: "Saya gembira untuk berkongsi dengan anda Reka Flash, mod berbilang 21B baharu dengan prestasi SOTA Model dinamik yang setanding dengan Gemini Pro dan GPT 3.5 pada tanda aras bahasa dan visual Kami melatih model ini dari awal dengan sumber yang agak terhad... Sementara itu, model kami yang terbesar dan paling berkuasa, Reka- Core juga akan siap maju ke kerja kami yang seterusnya. model, dan Reka Flash bersaing dengan Gemini Pro dan GPT-3.5 pada pelbagai penanda aras bahasa dan penglihatan. Selain itu, pasukan Reka turut mencadangkan varian model yang lebih padat, Reka Edge, yang mempunyai parameter yang lebih sedikit, hanya 7B, dan lebih cekap, membolehkannya beroperasi di bawah kekangan sumber (cth., pada peranti, Ia boleh juga dijalankan dalam senario tempatan).

Perlu dinyatakan bahawa kedua-dua model ini dalam peringkat ujian awam, dan pembaca yang berminat boleh pergi dan mencubanya.

Alamat percubaan: https://chat.reka.ai/auth/login

Pada masa yang sama, pasukan Reka mengumumkan bahawa model Reka Core terbesar dan paling berkuasa mereka akan tersedia kepada orang ramai dalam minggu-minggu akan datang.

Mengenai isu sumber terbuka, pasukan itu berkata ia masih dalam pertimbangan. Penilaian: Bahasa

Tanda aras penilaian termasuk MMLU (menjawab soalan berasaskan pengetahuan), GSM8K (penaakulan dan matematik)peringkat Google dan HumanEval (GPQA) menjawab soalan). Hasilnya menunjukkan Reka Flash mencapai keputusan yang sangat baik dalam penanda aras ini: mengatasi Gemini Pro pada MMLU dan GPQA, dan mencapai keputusan kompetitif pada GSM8K dan HumanEval. Tambahan pula, dalam penilaian ini, Reka Flash dengan ketara mengatasi banyak model yang lebih besar (cth., Llama 2 70B, Grok-1, GPT-3.5). Penilaian: Penaakulan Pelbagai Bahasa

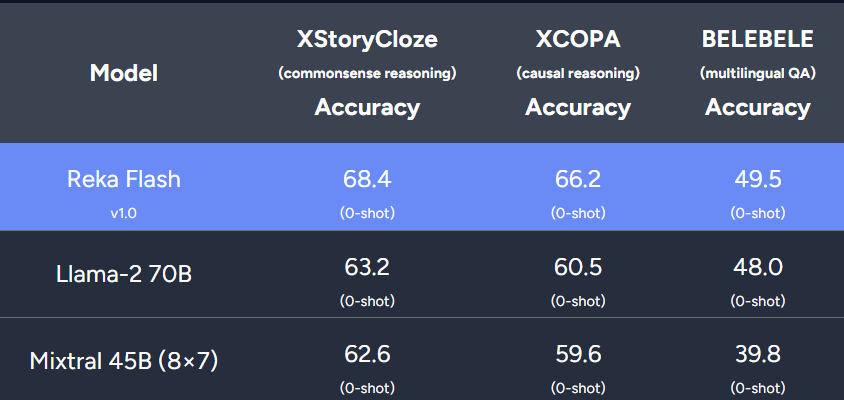

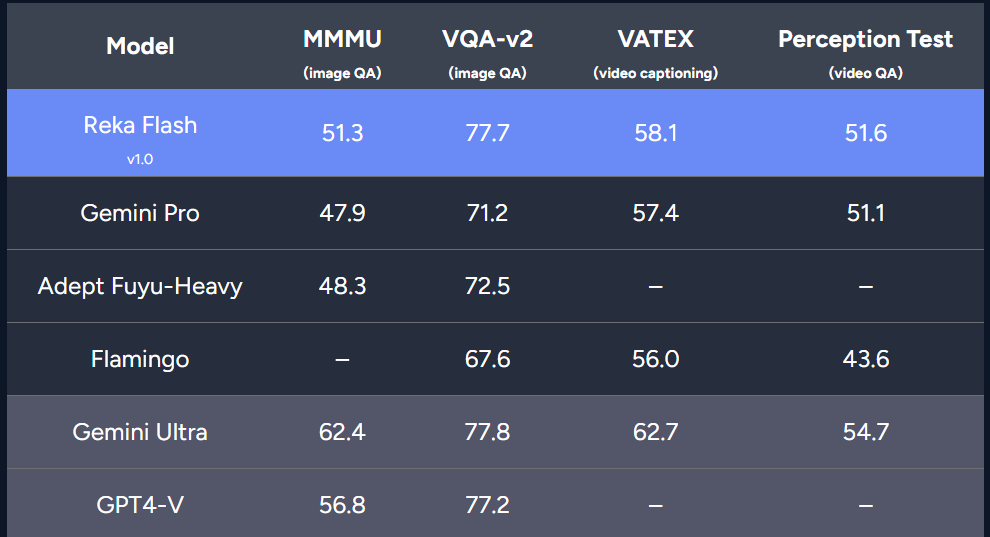

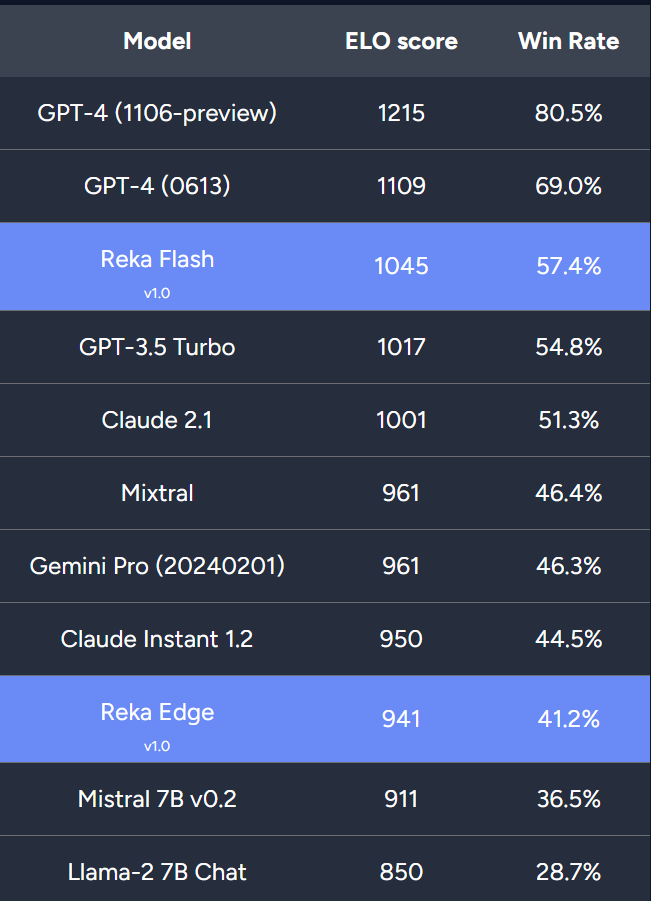

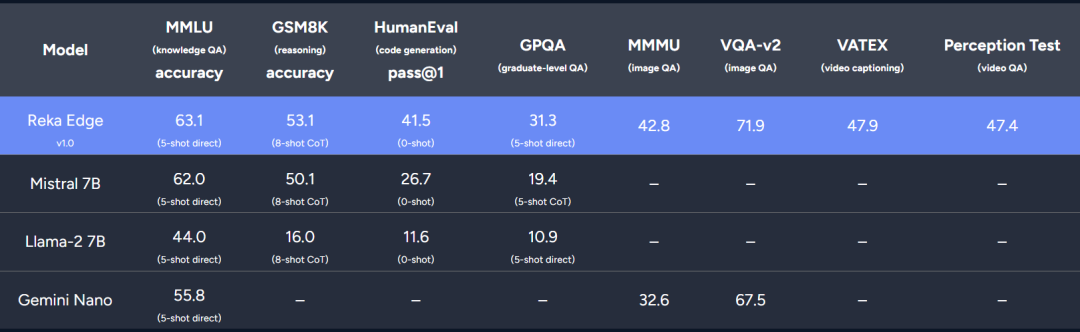

Teks Reka Flash dalam lebih 32 bahasa (termasuk Bahasa Inggeris, Jerman, Cina, Jepun, Perancis, Korea, Sepanyol, Itali, Arab terlatih dan banyak lagi) pada Reka Flash, jadi Reka Flash boleh dianggap sebagai model berbilang bahasa yang berkuasa. Para penyelidik membandingkan prestasi model yang berbeza pada penanda aras berbilang bahasa, termasuk penaakulan akal berbilang bahasa, penaakulan sebab dan jawapan soalan. Keputusan menunjukkan Reka Flash mengatasi prestasi Llama-2 70B dan Mixtral dalam semua tugasan ini.Penilaian: Visi dan Video Di samping itu, kajian juga menilai Reka Flash pada tanda aras pelbagai mod, termasuk menjawab soalan visual (MMMU, VQA-v2), sari kata video (VATEX ) dan video soal jawab (Ujian Persepsi). Keputusan menunjukkan Reka Flash bersaing dengan Gemini Pro dalam keempat-empat penanda aras. Kajian ini juga menjalankan beberapa siri penilaian manusia untuk menilai model sembang berasaskan Reka Flash. Para penyelidik mempertimbangkan dua tetapan, 1) model sembang teks sahaja dan 2) model sembang berbilang modal. Semasa penilaian mereka mengira skor ELO dan kadar kemenangan keseluruhan mengikut kaedah Askell et al. Sembang teks biasa: Penyelidik menanda aras model terkemuka seperti GPT-4, Claude 2.1 dan Gemini Pro (versi API). Selain itu, pengkaji turut membandingkan prestasi model sembang Reka Edge, Mistral 7B dan Llama 2 7B. Hasil penilaian manusia menunjukkan Reka Flash mencapai keputusan kompetitif, mengatasi prestasi GPT-3.5 Turbo, Claude, Mixtral dan Gemini Pro. Reka Edge mendahului dua model 7B yang lain, menghampiri prestasi Claude Instant 1.2. Kajian ini juga menguji Reka Flash dengan model bahasa multimodal seperti GPT4-V, Gemini Pro, Llava-1.6, IDEFICS 80b Compare. Keputusan menunjukkan Reka Flash mengatasi semua model kecuali GPT4-V. Reka Edge juga mencapai kedudukan yang baik, mengatasi Llava 1.6 7B berasaskan Mistral 7B dan menghampiri prestasi Gemini Pro. Model Reka Edge dengan parameter 7B Reka Edge ialah model 7B yang lebih padat yang direka untuk penggunaan di premis dan aplikasi sensitif kependaman. Mengenai tugas penilaian bahasa, kajian melaporkan perbandingan dengan model bersaiz serupa (iaitu, Mistral 7B dan Llama-2 7B). Keputusan menunjukkan Reka Edge mengatasi Llama 2 7B dan Mistral 7B pada penanda aras bahasa standard. Pasukan Reka berkata mereka menyasarkan untuk membina model bahasa berbilang mod yang paling maju, dan dengan keluaran Reka Flash dan Reka Edge, pencapaian awal dalam pelan hala tuju AI mereka telah dicapai. Semua orang boleh menantikan penyelidikan seterusnya. Pautan rujukan: https://reka.ai/reka-flash-an-efficient-and-capable-multimodal-language-model/Atas ialah kandungan terperinci 16 artikel dalam tiga tahun, bekas saintis penyelidikan Google Yi Tay secara rasmi mengumumkan model baharu, 21B setanding dengan Gemini Pro, GPT-3.5. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Penyelesaian ralat 3004 tidak diketahui

Penyelesaian ralat 3004 tidak diketahui

Bagaimana untuk menyemak memori video Win11

Bagaimana untuk menyemak memori video Win11

Bagaimana untuk mengulas kod dalam html

Bagaimana untuk mengulas kod dalam html

Bagaimana untuk mengimport telefon lama ke telefon baru dari telefon bimbit Huawei

Bagaimana untuk mengimport telefon lama ke telefon baru dari telefon bimbit Huawei

Perintah biasa OGG

Perintah biasa OGG

Pemacu kad bunyi komputer riba HP

Pemacu kad bunyi komputer riba HP

perkataan kepada ppt

perkataan kepada ppt

Cara menggunakan kumpulan mengikut

Cara menggunakan kumpulan mengikut