Peranti teknologi

Peranti teknologi

AI

AI

Butiran teknikal gugusan Byte Wanka didedahkan: Latihan GPT-3 selesai dalam 2 hari, dan penggunaan kuasa pengkomputeran melebihi NVIDIA Megatron-LM

Butiran teknikal gugusan Byte Wanka didedahkan: Latihan GPT-3 selesai dalam 2 hari, dan penggunaan kuasa pengkomputeran melebihi NVIDIA Megatron-LM

Butiran teknikal gugusan Byte Wanka didedahkan: Latihan GPT-3 selesai dalam 2 hari, dan penggunaan kuasa pengkomputeran melebihi NVIDIA Megatron-LM

Apabila analisis teknikal Sora berlaku, kepentingan infrastruktur AI menjadi semakin menonjol.

Sebuah kertas baru dari Byte dan Universiti Peking menarik perhatian pada masa ini:

Artikel itu mendedahkan bahawa Wanka cluster yang dibina oleh Byte boleh melengkapkan model skala GPT-3 (175B) dalam 1.75 hari ) )

.

Secara khusus, Byte mencadangkan sistem pengeluaran yang dipanggil MegaScale

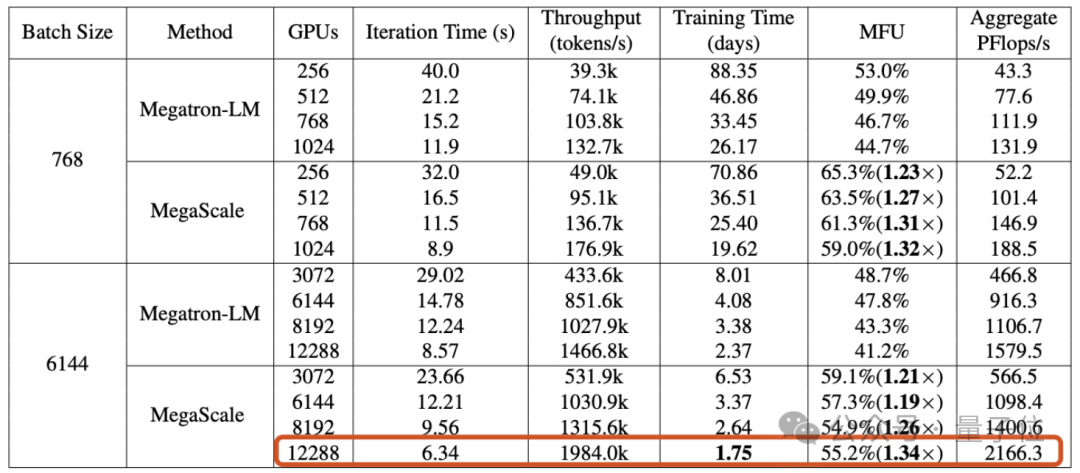

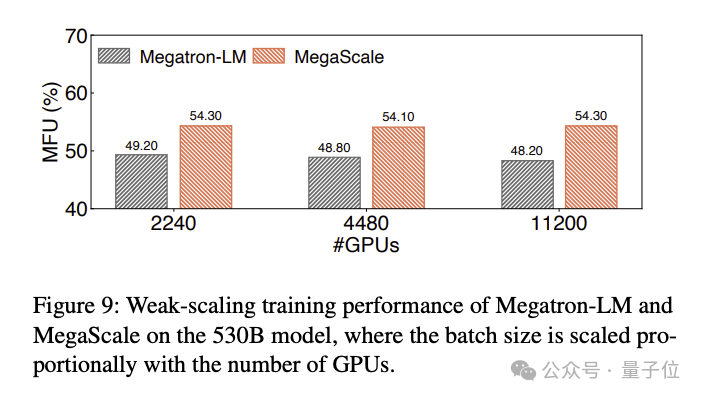

, yang bertujuan untuk menyelesaikan cabaran kecekapan dan kestabilan yang dihadapi semasa melatih model besar pada kelompok Wanka.Apabila melatih model bahasa besar 175 bilion parameter pada 12288 GPU, MegaScale mencapai penggunaan kuasa pengkomputeran sebanyak 55.2% (MFU)

, iaitu 1.34 kali ganda berbanding NVIDIA Megatron-LM.Makalah itu juga mendedahkan bahawa setakat September 2023, Byte telah menubuhkan GPU seni bina Ampere (A100/A800) gugusan dengan lebih daripada 10,000 kad, dan kini sedang membina seni bina Hopper berskala besar (H100/H800)

gugusan . Sesuai untuk sistem pengeluaran kluster WankaDalam era model besar, kepentingan GPU tidak lagi memerlukan perincian.Tetapi latihan model besar tidak boleh dimulakan terus apabila bilangan kad penuh - apabila skala kluster GPU mencapai tahap "10,000", bagaimana untuk mencapai latihan yang cekap dan stabil adalah satu cabaran tersendiri masalah kejuruteraan.

Cabaran pertama: kecekapan.

Melatih model bahasa yang besar bukanlah tugas selari yang mudah. Ia memerlukan pengedaran model antara berbilang GPU, dan GPU ini memerlukan komunikasi yang kerap untuk memajukan proses latihan secara bersama. Selain komunikasi, faktor seperti pengoptimuman operator, prapemprosesan data dan penggunaan memori GPU semuanya mempunyai kesan ke atas penggunaan kuasa pengkomputeran (MFU) , penunjuk yang mengukur kecekapan latihan.

MFU ialah nisbah daya pemprosesan sebenar kepada daya pemprosesan maksimum teori.

Cabaran kedua: kestabilan.

Kami tahu bahawa latihan model bahasa yang besar selalunya mengambil masa yang sangat lama, yang juga bermakna kegagalan dan kelewatan semasa proses latihan adalah perkara biasa.

Kos kegagalan adalah tinggi, jadi cara memendekkan masa pemulihan kegagalan menjadi sangat penting.

Untuk menangani cabaran ini, penyelidik ByteDance membina MegaScale dan telah mengerahkannya ke pusat data Byte untuk menyokong latihan pelbagai model besar.

MegaScale dipertingkatkan berdasarkan NVIDIA Megatron-LM.

Penambahbaikan khusus termasuk reka bentuk bersama algoritma dan komponen sistem, pengoptimuman pertindihan komunikasi dan pengkomputeran, pengoptimuman operator, pengoptimuman saluran paip data dan penalaan prestasi rangkaian, dsb.:

- Pengoptimuman Algoritma: Penyelidik memperkenalkan blok Transformer selari, mekanisme perhatian tingkap gelongsor (SWA) dan pengoptimum LAMB ke dalam seni bina model untuk meningkatkan kecekapan latihan tanpa mengorbankan penumpuan model.

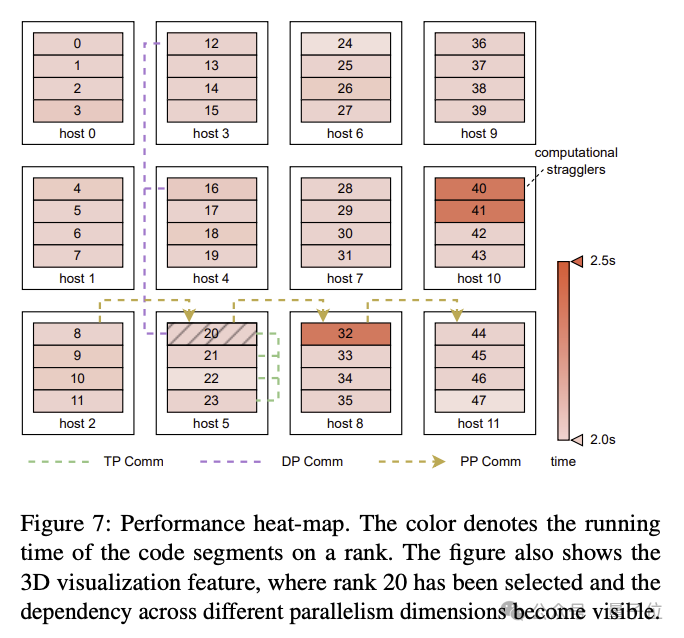

- Pertindihan komunikasi: Berdasarkan analisis khusus bagi operasi setiap unit pengkomputeran dalam selari 3D (keselarian data, keselarian saluran paip, keselarian tensor) , penyelidik mereka strategi operasi teknikal yang tidak kritikal untuk mengurangkan operasi teknikal secara berkesan laluan Kelewatan yang disebabkan memendekkan masa lelaran setiap pusingan dalam latihan model.

- Operator Cekap: Pengendali GEMM telah dioptimumkan, dan operasi seperti LayerNorm dan GeLU telah disepadukan untuk mengurangkan overhed pelancaran berbilang teras dan mengoptimumkan corak akses memori.

- Pengoptimuman saluran paip data: Optimumkan prapemprosesan dan pemuatan data dan kurangkan masa melahu GPU melalui prapemprosesan data tak segerak dan penghapusan pemuat data berlebihan.

- Pengamatan kumpulan komunikasi kolektif: Mengoptimumkan proses pemulaan rangka kerja komunikasi berbilang kad NVIDIA NCCL dalam latihan yang diedarkan. Tanpa pengoptimuman, masa permulaan kluster 2048-GPU ialah 1047 saat, yang boleh dikurangkan kepada kurang daripada 5 saat selepas pengoptimuman; masa permulaan kluster GPU Wanka boleh dikurangkan kepada kurang daripada 30 saat.

- Penalaan Prestasi Rangkaian: Menganalisis trafik antara mesin dalam keselarian 3D, dan mereka bentuk penyelesaian teknikal untuk meningkatkan prestasi rangkaian, termasuk reka bentuk topologi rangkaian, pengurangan konflik cincang ECMP, kawalan kesesakan dan tetapan tamat masa penghantaran semula.

- Toleransi Kesalahan: Dalam kelompok Wanka, kegagalan perisian dan perkakasan tidak dapat dielakkan. Para penyelidik mereka bentuk rangka kerja latihan untuk mencapai pengecaman kerosakan automatik dan pemulihan pantas. Khususnya, ia termasuk membangunkan alat diagnostik untuk memantau komponen dan acara sistem, mengoptimumkan proses latihan penjimatan frekuensi tinggi pusat pemeriksaan, dsb.

Kertas tersebut menyebut bahawa MegaScale secara automatik boleh mengesan dan membaiki lebih daripada 90% kegagalan perisian dan perkakasan.

Hasil eksperimen menunjukkan bahawa apabila MegaScale melatih model bahasa besar 175B pada 12288 GPU, ia mencapai 55.2% MFU, iaitu 1.34 kali penggunaan kuasa pengkomputeran Megatrion-LM.

Hasil perbandingan MFU untuk melatih model bahasa besar 530B adalah seperti berikut:

One More Thing

Sama seperti kertas teknikal ini mencetuskan perbincangan, berita baharu keluar tentang produk Sora berasaskan bait:

Screenshot Alat video AInya yang serupa dengan Sora telah melancarkan ujian beta jemputan sahaja.

Nampaknya asas telah diletakkan, jadi adakah anda menantikan produk model besar Byte?

Alamat kertas: https://arxiv.org/abs/2402.15627

Atas ialah kandungan terperinci Butiran teknikal gugusan Byte Wanka didedahkan: Latihan GPT-3 selesai dalam 2 hari, dan penggunaan kuasa pengkomputeran melebihi NVIDIA Megatron-LM. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1378

1378

52

52

Cara Melaksanakan Penyortiran Fail oleh Debian Readdir

Apr 13, 2025 am 09:06 AM

Cara Melaksanakan Penyortiran Fail oleh Debian Readdir

Apr 13, 2025 am 09:06 AM

Dalam sistem Debian, fungsi Readdir digunakan untuk membaca kandungan direktori, tetapi urutan yang dikembalikannya tidak ditentukan sebelumnya. Untuk menyusun fail dalam direktori, anda perlu membaca semua fail terlebih dahulu, dan kemudian menyusunnya menggunakan fungsi QSORT. Kod berikut menunjukkan cara menyusun fail direktori menggunakan ReadDir dan QSORT dalam sistem Debian:#termasuk#termasuk#termasuk#termasuk // fungsi perbandingan adat, yang digunakan untuk qSortintCompare (Constvoid*A, Constvoid*b) {Returnstrcmp (*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(

Cara Mengoptimumkan Prestasi Debian Readdir

Apr 13, 2025 am 08:48 AM

Cara Mengoptimumkan Prestasi Debian Readdir

Apr 13, 2025 am 08:48 AM

Dalam sistem Debian, panggilan sistem Readdir digunakan untuk membaca kandungan direktori. Jika prestasinya tidak baik, cuba strategi pengoptimuman berikut: Memudahkan bilangan fail direktori: Split direktori besar ke dalam pelbagai direktori kecil sebanyak mungkin, mengurangkan bilangan item yang diproses setiap panggilan readdir. Dayakan Caching Kandungan Direktori: Bina mekanisme cache, kemas kini cache secara teratur atau apabila kandungan direktori berubah, dan mengurangkan panggilan kerap ke Readdir. Cafh memori (seperti memcached atau redis) atau cache tempatan (seperti fail atau pangkalan data) boleh dipertimbangkan. Mengamalkan struktur data yang cekap: Sekiranya anda melaksanakan traversal direktori sendiri, pilih struktur data yang lebih cekap (seperti jadual hash dan bukannya carian linear) untuk menyimpan dan mengakses maklumat direktori

Bagaimana Debian OpenSSL Menghalang Serangan Man-dalam-Middle

Apr 13, 2025 am 10:30 AM

Bagaimana Debian OpenSSL Menghalang Serangan Man-dalam-Middle

Apr 13, 2025 am 10:30 AM

Dalam sistem Debian, OpenSSL adalah perpustakaan penting untuk pengurusan penyulitan, penyahsulitan dan sijil. Untuk mengelakkan serangan lelaki-dalam-pertengahan (MITM), langkah-langkah berikut boleh diambil: Gunakan HTTPS: Pastikan semua permintaan rangkaian menggunakan protokol HTTPS dan bukannya HTTP. HTTPS menggunakan TLS (Protokol Keselamatan Lapisan Pengangkutan) untuk menyulitkan data komunikasi untuk memastikan data tidak dicuri atau diganggu semasa penghantaran. Sahkan Sijil Pelayan: Sahkan secara manual Sijil Pelayan pada klien untuk memastikan ia boleh dipercayai. Pelayan boleh disahkan secara manual melalui kaedah perwakilan urlSession

Cara Menetapkan Tahap Log Debian Apache

Apr 13, 2025 am 08:33 AM

Cara Menetapkan Tahap Log Debian Apache

Apr 13, 2025 am 08:33 AM

Artikel ini menerangkan cara menyesuaikan tahap pembalakan pelayan Apacheweb dalam sistem Debian. Dengan mengubah suai fail konfigurasi, anda boleh mengawal tahap maklumat log yang direkodkan oleh Apache. Kaedah 1: Ubah suai fail konfigurasi utama untuk mencari fail konfigurasi: Fail konfigurasi apache2.x biasanya terletak di direktori/etc/apache2/direktori. Nama fail mungkin apache2.conf atau httpd.conf, bergantung pada kaedah pemasangan anda. Edit Fail Konfigurasi: Buka Fail Konfigurasi dengan Kebenaran Root Menggunakan Editor Teks (seperti Nano): Sudonano/ETC/APACHE2/APACHE2.CONF

Bagaimana Debian Readdir Bersepadu Dengan Alat Lain

Apr 13, 2025 am 09:42 AM

Bagaimana Debian Readdir Bersepadu Dengan Alat Lain

Apr 13, 2025 am 09:42 AM

Fungsi Readdir dalam sistem Debian adalah panggilan sistem yang digunakan untuk membaca kandungan direktori dan sering digunakan dalam pengaturcaraan C. Artikel ini akan menerangkan cara mengintegrasikan Readdir dengan alat lain untuk meningkatkan fungsinya. Kaedah 1: Menggabungkan Program Bahasa C dan Pipeline Pertama, tulis program C untuk memanggil fungsi Readdir dan output hasilnya:#termasuk#termasuk#includeintMain (intargc, char*argv []) {dir*dir; structdirent*entry; if (argc! = 2) {

Cara Belajar Debian Syslog

Apr 13, 2025 am 11:51 AM

Cara Belajar Debian Syslog

Apr 13, 2025 am 11:51 AM

Panduan ini akan membimbing anda untuk belajar cara menggunakan syslog dalam sistem Debian. SYSLOG adalah perkhidmatan utama dalam sistem Linux untuk sistem pembalakan dan mesej log aplikasi. Ia membantu pentadbir memantau dan menganalisis aktiviti sistem untuk mengenal pasti dan menyelesaikan masalah dengan cepat. 1. Pengetahuan asas syslog Fungsi teras syslog termasuk: mengumpul dan menguruskan mesej log secara terpusat; menyokong pelbagai format output log dan lokasi sasaran (seperti fail atau rangkaian); Menyediakan fungsi tontonan log dan penapisan masa nyata. 2. Pasang dan konfigurasikan syslog (menggunakan rsyslog) Sistem Debian menggunakan rsyslog secara lalai. Anda boleh memasangnya dengan arahan berikut: sudoaptupdatesud

Kaedah pemasangan sijil SSL Server Server Debian

Apr 13, 2025 am 11:39 AM

Kaedah pemasangan sijil SSL Server Server Debian

Apr 13, 2025 am 11:39 AM

Langkah -langkah untuk memasang sijil SSL pada pelayan mel Debian adalah seperti berikut: 1. Pasang OpenSSL Toolkit terlebih dahulu, pastikan bahawa OpenSSL Toolkit telah dipasang pada sistem anda. Jika tidak dipasang, anda boleh menggunakan arahan berikut untuk memasang: sudoapt-getupdateudoapt-getinstallopenssl2. Menjana permintaan kunci dan sijil peribadi seterusnya, gunakan OpenSSL untuk menjana kunci peribadi RSA 2048-bit dan permintaan sijil (CSR): Membuka

Petua Konfigurasi Firewall Pelayan Mel Debian

Apr 13, 2025 am 11:42 AM

Petua Konfigurasi Firewall Pelayan Mel Debian

Apr 13, 2025 am 11:42 AM

Mengkonfigurasi firewall pelayan Mail Debian adalah langkah penting dalam memastikan keselamatan pelayan. Berikut adalah beberapa kaedah konfigurasi firewall yang biasa digunakan, termasuk penggunaan iptables dan firewalld. Gunakan iptables untuk mengkonfigurasi firewall untuk memasang iptables (jika belum dipasang): sudoapt-getupdateudoapt-getinstalliplesview peraturan iptables semasa: konfigurasi sudoiptable-l