Peranti teknologi

Peranti teknologi

industri IT

industri IT

Pustaka pecutan NPU sumber terbuka Intel, pemproses Core Ultra AI PC boleh menjalankan model bahasa besar yang ringan

Pustaka pecutan NPU sumber terbuka Intel, pemproses Core Ultra AI PC boleh menjalankan model bahasa besar yang ringan

Pustaka pecutan NPU sumber terbuka Intel, pemproses Core Ultra AI PC boleh menjalankan model bahasa besar yang ringan

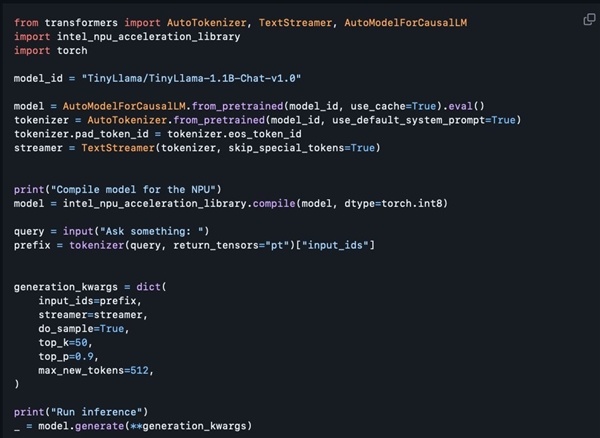

Menurut berita pada 4 Mac, Intel baru-baru ini mengeluarkan pustaka pecutan NPUnya di GitHub Langkah ini membolehkan PC AI yang dilengkapi dengan pemproses Teras Ultra untuk menjalankan model bahasa berskala besar ringan seperti TinyLlama dan Gemma-2b.

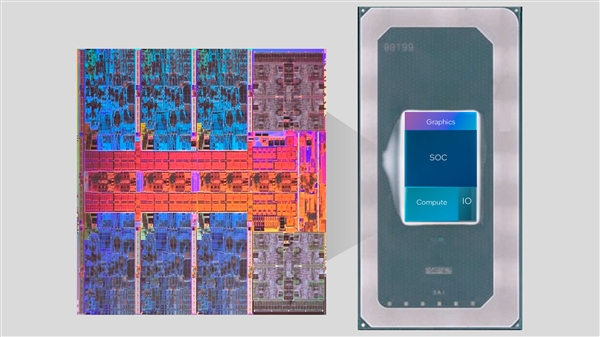

Siri Core Ultra menyepadukan enjin AI NPU buat kali pertama Enjin ini boleh mengendalikan beberapa tugas inferens AI yang ringan dan berfungsi bersama-sama dengan CPU dan GPU untuk memenuhi keperluan pelbagai aplikasi AI.

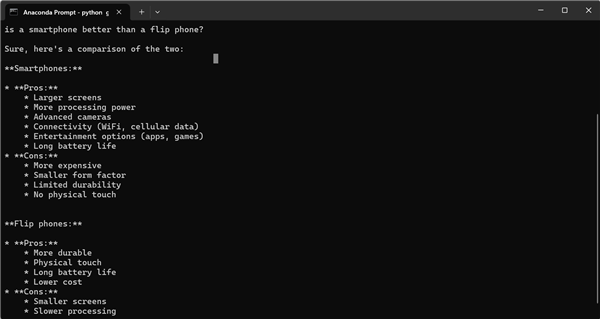

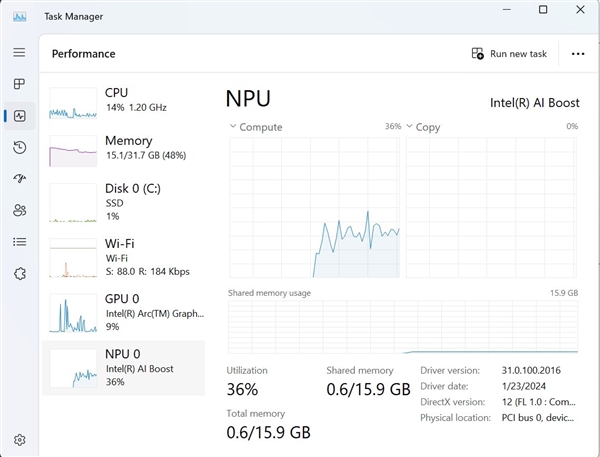

Difahamkan walaupun perpustakaan pecutan NPU yang dikeluarkan kali ini disediakan terutamanya untuk pembangun, pengguna yang mempunyai pengalaman pengaturcaraan tertentu juga boleh mencuba menggunakannya. Tony Mongkolsmai, seorang arkitek perisian di Intel, menunjukkan cara menjalankan chatbot AI berdasarkan model besar TinyLlama parameter 1.1 bilion pada komputer riba MSI Monarch 14 AI Evo, yang boleh menjalankan perbualan mudah. Pada masa yang sama, Pengurus Tugas Windows juga menunjukkan panggilan yang sah kepada NPU.

Walau bagaimanapun, perpustakaan pecutan NPU sumber terbuka semasa masih mempunyai beberapa kekurangan dalam fungsi Ia menyokong pengkuantitian 8-bit dan ketepatan FP16, tetapi belum lagi menyokong fungsi lanjutan seperti pengkuantitian 4-bit, ketepatan BF16 dan NPU. /GPU pengkomputeran hibrid , dan dokumentasi teknikal yang berkaitan masih belum disediakan. Walau bagaimanapun, Intel telah berjanji untuk mengembangkan fungsinya secara beransur-ansur pada masa hadapan, yang dijangka menggandakan fungsi sedia ada, yang sudah pasti akan membawa lebih banyak kemudahan dan kemungkinan kepada pembangun AI.

Atas ialah kandungan terperinci Pustaka pecutan NPU sumber terbuka Intel, pemproses Core Ultra AI PC boleh menjalankan model bahasa besar yang ringan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1378

1378

52

52

Kebocoran mendedahkan spesifikasi utama Intel Arrow Lake-U, -H, -HX dan -S

Jun 15, 2024 pm 09:49 PM

Kebocoran mendedahkan spesifikasi utama Intel Arrow Lake-U, -H, -HX dan -S

Jun 15, 2024 pm 09:49 PM

IntelArrowLake dijangka akan dibebaskan pada seni bina pemproses yang sama sebagai LunarLake, yang bermaksud bahawa teras prestasi LionCoveIntel yang baru akan digabungkan dengan teras kecekapan Skymonte yang ekonomi.

Beelink EQi12 dilancarkan sebagai PC mini yang lebih berkuasa daripada EQ12

Aug 21, 2024 pm 08:37 PM

Beelink EQi12 dilancarkan sebagai PC mini yang lebih berkuasa daripada EQ12

Aug 21, 2024 pm 08:37 PM

Beelink telah melancarkan PC mini baharu, EQi12. Ia adalah versi EQ12 yang dinaik taraf yang diperkenalkan oleh jenama itu tahun lepas, yang disertakan dengan Intel N100. Komputer yang lebih baharu boleh dilengkapi sehingga Intel Core i7 12650H, salah satu cip yang lebih tinggi

Apakah Intel TXT?

Jun 11, 2023 pm 06:57 PM

Apakah Intel TXT?

Jun 11, 2023 pm 06:57 PM

IntelTXT ialah teknologi keselamatan berbantukan perkakasan yang dilancarkan oleh Intel Ia boleh memastikan integriti dan keselamatan pelayan semasa permulaan dengan mewujudkan ruang yang dilindungi antara CPU dan BIOS. Nama penuh TXT ialah TrustedExecutionTechnology, iaitu Trusted Execution Technology. Ringkasnya, TXT ialah teknologi keselamatan yang menyediakan perlindungan peringkat perkakasan untuk memastikan pelayan tidak diubah suai oleh program berniat jahat atau perisian yang tidak dibenarkan apabila ia dimulakan. yang ini

LG memperkenalkan komputer riba Intel Lunar Lake yang paling nipis dan ringan dengan penyegaran semula LG Gram 16 Pro

Sep 10, 2024 am 06:44 AM

LG memperkenalkan komputer riba Intel Lunar Lake yang paling nipis dan ringan dengan penyegaran semula LG Gram 16 Pro

Sep 10, 2024 am 06:44 AM

LG sudah menawarkan Gram 16 Pro dengan pemproses Intel Meteor Lake (sekira $1,699.99 di Amazon). Walau bagaimanapun, syarikat itu telah memutuskan untuk menukar seni bina Tasik Meteor Intel untuk Tasik Lunar, yang dipamerkan Intel pada IFA 2024 di Berlin minggu lepas. Th

Pustaka pecutan NPU sumber terbuka Intel, pemproses Core Ultra AI PC boleh menjalankan model bahasa besar yang ringan

Mar 05, 2024 am 11:13 AM

Pustaka pecutan NPU sumber terbuka Intel, pemproses Core Ultra AI PC boleh menjalankan model bahasa besar yang ringan

Mar 05, 2024 am 11:13 AM

Menurut berita pada 4 Mac, Intel baru-baru ini mengeluarkan perpustakaan pecutan NPUnya di GitHub Langkah ini membolehkan AIPC dilengkapi dengan pemproses Teras Ultra untuk menjalankan model bahasa berskala besar ringan dengan lebih lancar seperti TinyLlama dan Gemma-2b. Siri Core Ultra menyepadukan enjin NPUAI buat kali pertama Enjin ini boleh mengendalikan beberapa tugas inferens AI yang ringan dan bekerjasama dengan CPU dan GPU untuk memenuhi keperluan pelbagai aplikasi AI. Difahamkan bahawa walaupun perpustakaan pecutan NPU yang dikeluarkan kali ini disediakan terutamanya untuk pembangun, pengguna yang mempunyai pengalaman pengaturcaraan tertentu juga boleh mencuba menggunakannya. Arkitek perisian Intel Tony Mongkolsmai menunjukkan cara untuk

Yoga Slim 7i Aura Edition: Lenovo mengurangkan Samsung dengan keluaran komputer riba Intel Lunar Lake yang ringan baharu

Sep 11, 2024 am 06:41 AM

Yoga Slim 7i Aura Edition: Lenovo mengurangkan Samsung dengan keluaran komputer riba Intel Lunar Lake yang ringan baharu

Sep 11, 2024 am 06:41 AM

Lenovo kini telah mengeluarkan Edisi Aura Yoga Slim 7i, kurang daripada seminggu selepas pada mulanya mempersembahkan komputer riba berasaskan Tasik Intel Lunar. Sila ambil perhatian bahawa walaupun syarikat itu mendedahkan banyak butiran tentang komputer riba semasa IFA 2024 di Berlin, ia memilih

Arc Battlemage: Bocoran membayangkan tiga GPU untuk kad grafik permainan generasi seterusnya Intel

Jul 02, 2024 am 09:44 AM

Arc Battlemage: Bocoran membayangkan tiga GPU untuk kad grafik permainan generasi seterusnya Intel

Jul 02, 2024 am 09:44 AM

Seni bina GPU generasi seterusnya Intel dijangka dilancarkan pada bulan September sebagai sebahagian daripada Tasik Lunar Intel. Seperti Arc Alchemist iGPU dari Meteor Lake, iGPU mempunyai sehingga 8 teras Xe, tetapi seni bina baharu dijangka mencapai prestasi 50% lebih tinggi

IFA 2024 | Lenovo ThinkPad X1 Carbon Gen 13 Aura Edition: ThinkPad Tasik Lunar pertama Lenovo hampir sama ringannya dengan X1 Nano

Sep 06, 2024 am 06:50 AM

IFA 2024 | Lenovo ThinkPad X1 Carbon Gen 13 Aura Edition: ThinkPad Tasik Lunar pertama Lenovo hampir sama ringannya dengan X1 Nano

Sep 06, 2024 am 06:50 AM

Tiga belas dikenali sebagai kekurangan yang teruk. Takhayul bukanlah satu kebaikan dalam perniagaan teknologi sekalipun. Bagi Lenovo, generasi ke-13 komputer riba premium itu nampaknya pasti akan berjaya seperti dua belas pendahulunya. Di IFA, pengeluar PC terbesar